为什么你开了多卡,训练反而更慢?

为什么你开了多卡,训练反而更慢?

在模型规模不断增大的今天,多机多卡几乎是每个团队都会走到的一步。

但在真实训练中,很多团队会遇到一个反直觉的现象:卡是加了,训练却没有明显变快,甚至在某些阶段还变慢了。

在多个主流训练框架和工程实践中,都能看到类似反馈:当GPU 数量从 4 卡扩展到 8 卡、16 卡后,吞吐提升远低于预期。

这并不是多机多卡“没用”,而是算力在扩展之后,用法发生了变化。

在讨论“快不快”之前,先说清楚什么是多机多卡训练

在单机单卡训练中,模型、数据和计算过程都集中在一张GPU 上完成,逻辑非常简单:一张卡,从头算到尾。

当模型规模和训练需求上来之后,单卡往往会遇到两个瓶颈:

- 显存不够,模型放不下

- 训练时间过长,实验周期无法接受

多机多卡训练,本质上就是为了解决这两个问题。在多机多卡训练中,训练任务会被“拆开”来执行:

- 模型或参数被拆分,分布在多张GPU 上

- 数据被并行处理,每张卡负责一部分计算

- 中间结果需要在GPU 之间同步,以保证训练一致性

这意味着,GPU 不再只是“算模型”,而是同时在做三件事:

- 1.计算模型

- 2.与其他GPU 交换信息

- 3.等待同步完成后进入下一步

也正因为如此,多机多卡训练的核心挑战,从“有没有算力”,变成了算力是如何被拆分、协同和调度的。

理解这一点,才能解释为什么—— 卡是加了,但速度不一定线性提升。

为什么一上多机多卡,训练反而变慢了?

在单机单卡阶段,GPU 几乎只做一件事:算模型。

但进入多机多卡后,算力会被拆分为三部分:

- 模型计算

- 参数同步

- 跨卡/ 跨机通信

在真实训练中,很多团队会发现一个变化:通信和同步的时间占比,从个位数提升到30% 甚至更高。尤其在以下场景中,这种问题会被放大:

- batch size 较小

- 模型参数规模较大

- GPU 数量增长快于模型计算量

这时,即使GPU 看起来“都在跑”,新增算力也可能被大量消耗在“等同步”上。

一个真实的多机多卡训练复盘场景 :

在一个典型的大模型训练项目中,团队做过这样一次对比测试:

- 配置A:单机 4 卡

- 配置B:双机 8 卡

模型规模和batch 设置保持不变测试结果却非常反直觉:8 卡配置下,单 step 时间明显变长整体吞吐提升不足30%GPU 利用率看起来正常,但训练总时长反而拉长复盘后发现,问题并不在算力规模本身,而在于:参数同步频率显著增加跨机通信延迟被放大新增算力大量消耗在“等待同步”上卡是加了,但有效算力并没有等比例增加。

显存问题解决了,但算力压力并没有消失

很多团队上多机多卡的直接原因是:“单机显存不够了。”

通过参数切分、状态分散等方式,显存占用确实可以明显下降,这是多机多卡训练必须解决的一步。

但在实际工程中,常见的反馈是:

- 单step 时间变长

- 吞吐提升有限

- 训练总时长拉长

原因在于:显存被“拆散”后,数据在 GPU 之间的流动成本被显著放大。

这本质上是一种工程上的权衡:用更多算力资源,换取更大的可训练模型规模。

多机多卡要“变快”,前提条件是什么?

在工程实践中,有一个非常明确的结论:多机多卡并不会自动带来线性加速。

真正能看到明显加速的场景,通常具备几个特征:

- 单step 计算时间足够长

- 通信时间在总时间中占比可控

- 算力规模的增长,与训练负载是“匹配”的

当训练规模没有同步放大时,过早上多机多卡,反而会稀释算力效率。

多机多卡什么时候真的能带来加速?

在工程实践中,有一个很清晰的共识:

不是“能不能上多机多卡”,而是“现在是不是上多机多卡的时机”。

多机多卡通常在以下条件下,才能真正体现加速价值:

- 单step 计算足够重: 模型计算时间远大于通信时间

- batch 或模型规模随: 算力同步放大算力不是“空加”,而是被新的训练负载吃掉

- GPU 互联延迟可控: 通信不会成为主瓶颈

在这些条件下,新增GPU 才能更多用于计算本身,而不是被同步和等待消耗。

多机多卡不是“万能加速器”,但在合适阶段,它是不可替代的。

哪些方向,能让多机多卡真正发挥价值?

从主流训练框架和大量工程实践来看,多机多卡真正“跑起来”,通常依赖以下几类能力:

- 高速、稳定的GPU 互联能力: 在多机训练中,通信延迟往往比计算能力更早成为瓶颈。

- 更细粒度的算力调度与并行策略: 让不同GPU 在不同阶段承担不同角色,而不是所有算力同时等待同步。

- 对训练阶段的算力感知能力: 清楚哪些阶段是“算力高峰”,哪些地方的优化能直接影响训练成本。

这些能力,往往决定了:多出来的GPU,究竟是在加速训练,还是在放大成本。

多机多卡不是问题,问题是“算力是否被用对了”

在训练规模扩大后,团队面临的核心问题会发生转移:从“能不能跑”变成“跑得是否高效、是否可控”

现实中,很多训练任务并不是因为模型失败,而是因为:算力效率不可预测,成本无法提前评估。

写在最后

多机多卡训练并不是“速度的保证”,而是一种对算力使用能力的放大器。

当算力使用方式成熟时,它会成为真正的加速器;当算力使用方式不清晰时,它也会放大每一次低效和浪费。

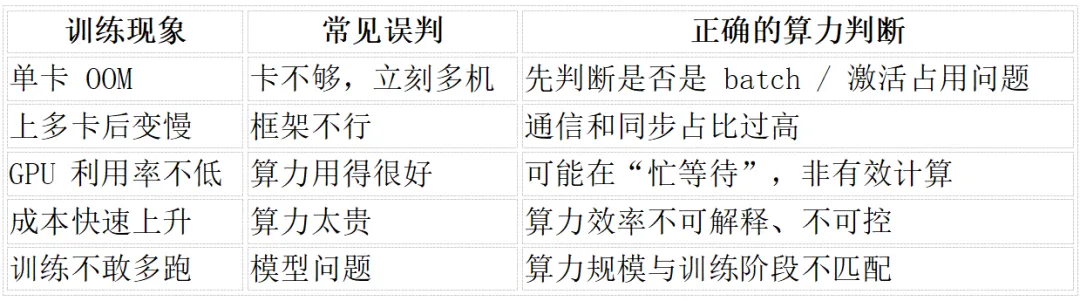

【算力决策对照表】

多机多卡训练:什么时候该上?什么时候要谨慎?

真正成熟的多机多卡训练,一定是“算得清、跑得稳、扩得开”。

【广告时间】

如果你恰好需要GPU云服务,不妨试试Lab4AI大模型实验室——低延迟互联让跨卡通信不再拖后腿,从单卡实验到多卡训练都能灵活扩展,调度也挺聪明,算力基本不浪费。

训模型、跑推理、调工程,用下来的感受就三个字:稳、快、省。

感兴趣的话,欢迎来问~

浙公网安备 33010602011771号

浙公网安备 33010602011771号