Extreme Learning Machine

作者:凯鲁嘎吉 - 博客园 http://www.cnblogs.com/kailugaji/

更新:只做科普,别做学术。

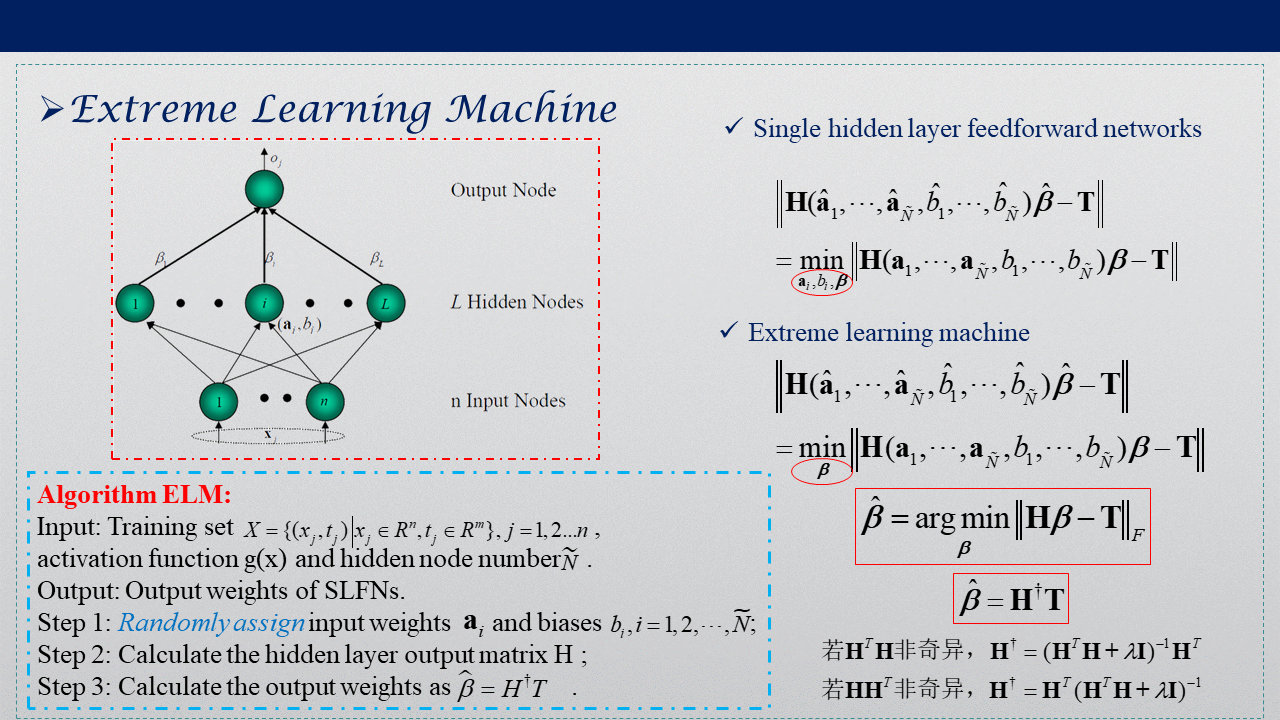

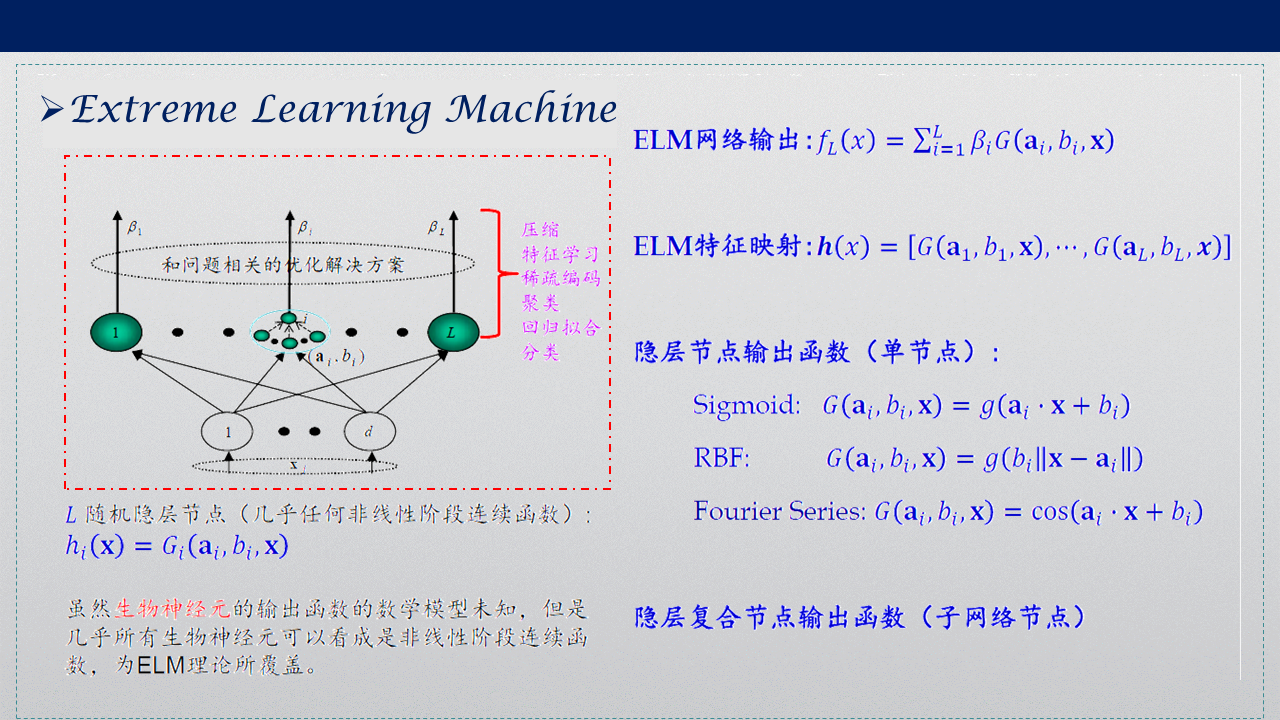

1. ELM

2004年南洋理工大学黄广斌提出了ELM算法。极限学习机(ELM Extreme Learning Machine)是一种快速的的单隐层前馈神经网络(SLFN)训练算法。

该算法的特点是在网络参数的确定过程中,隐层节点参数(a,b)随机选取,在训练过程中无需调节,只需要设置隐含层神经元的个数,便可以获得唯一的最优解;而网络的外权(即输出权值)是通过最小化平方损失函数得到的最小二乘解(最终化归成求解一个矩阵的 Moore-Penrose 广义逆问题).这样网络参数的确定过程中无需任何迭代步骤,从而大大降低了网络参数的调节时间。与传统的训练方法相比,该方法具有学习速度快、泛化性能好等优点。

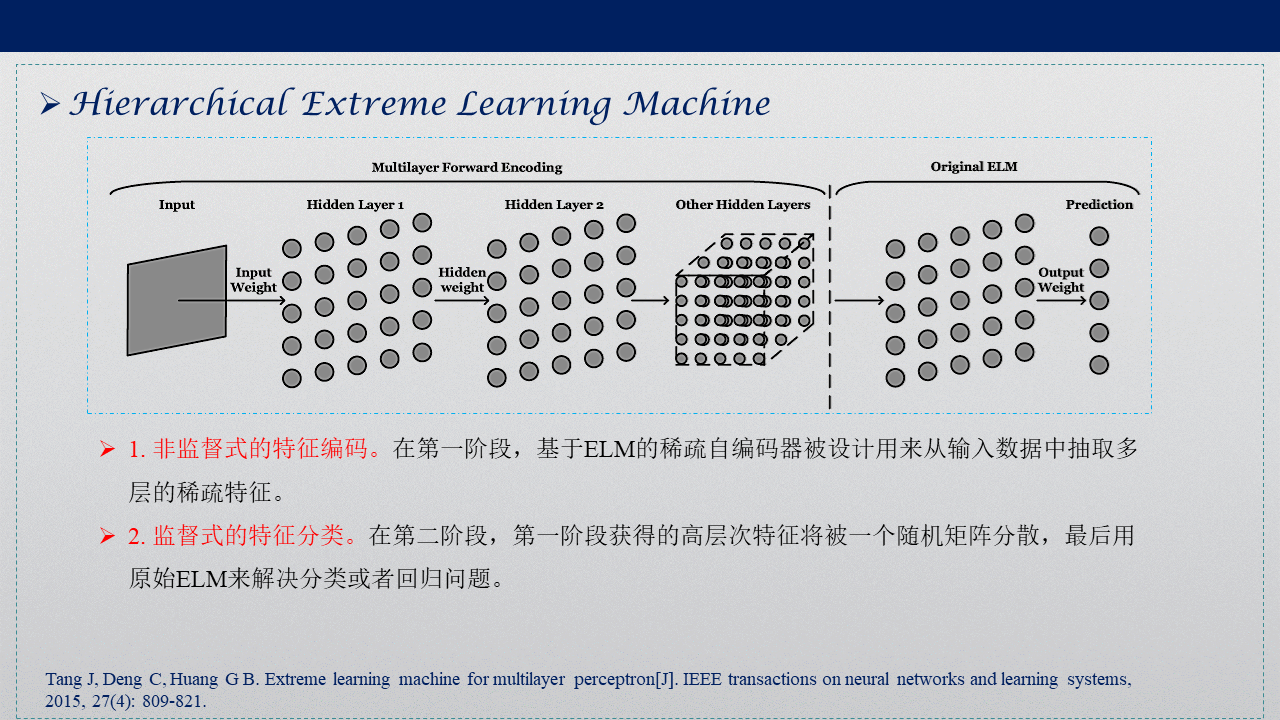

2. H-ELM

Hierarchical Extreme Learning Machine (H-ELM)是2015年提出的一个ELM的改进算法。分为两个阶段:

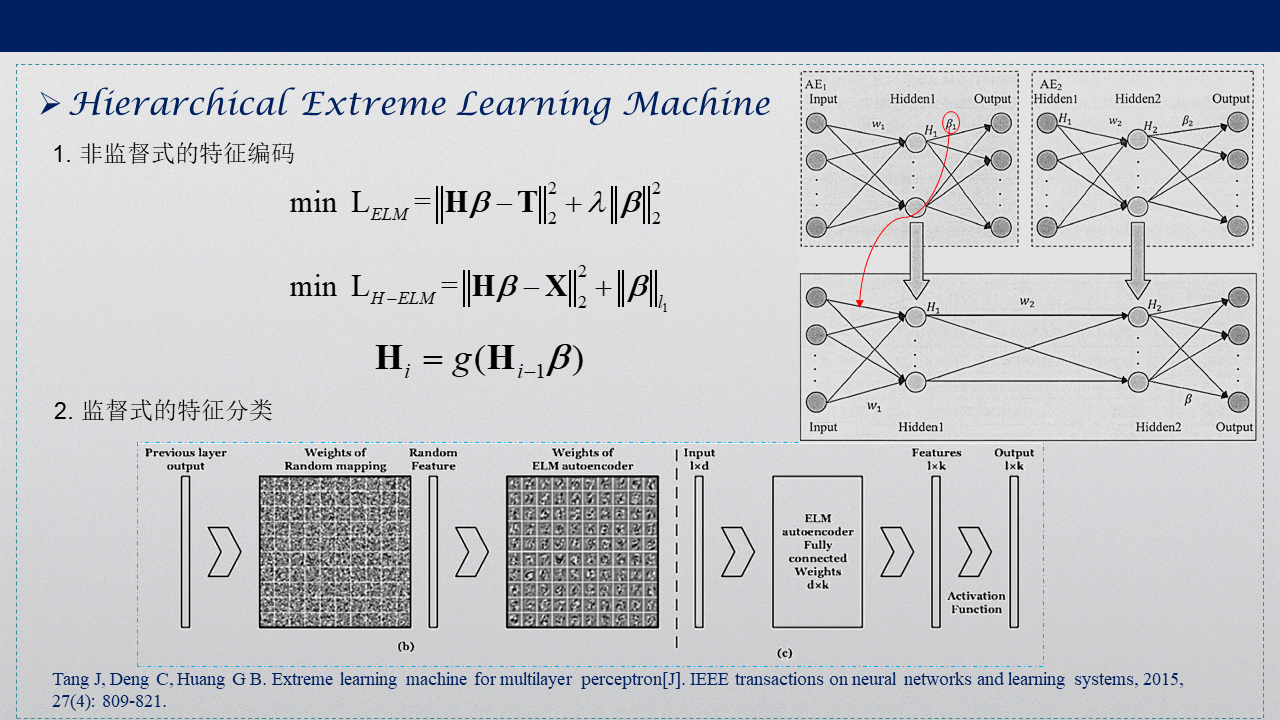

1. 非监督式的特征编码。在第一阶段,基于ELM的稀疏自编码器被设计用来从输入数据中抽取多层的稀疏特征。通过逐层自编码获得每层的权重矩阵,权重确定后,无需微调。

2. 监督式的特征分类。在第二阶段,第一阶段获得的高层次特征(维度可能比原始数据大)将被一个随机矩阵打散,将打散后的数据作为原始ELM的输入,最后用原始ELM来解决分类或者回归问题。

与ELM的区别在于自编码阶段,权重矩阵的惩罚项用的是L1范数,参数的更新公式用Fast Iterative Shrinkage-thresholding (FISTA)求解,而ELM的权重惩罚项用的L2范数,用岭回归求解。

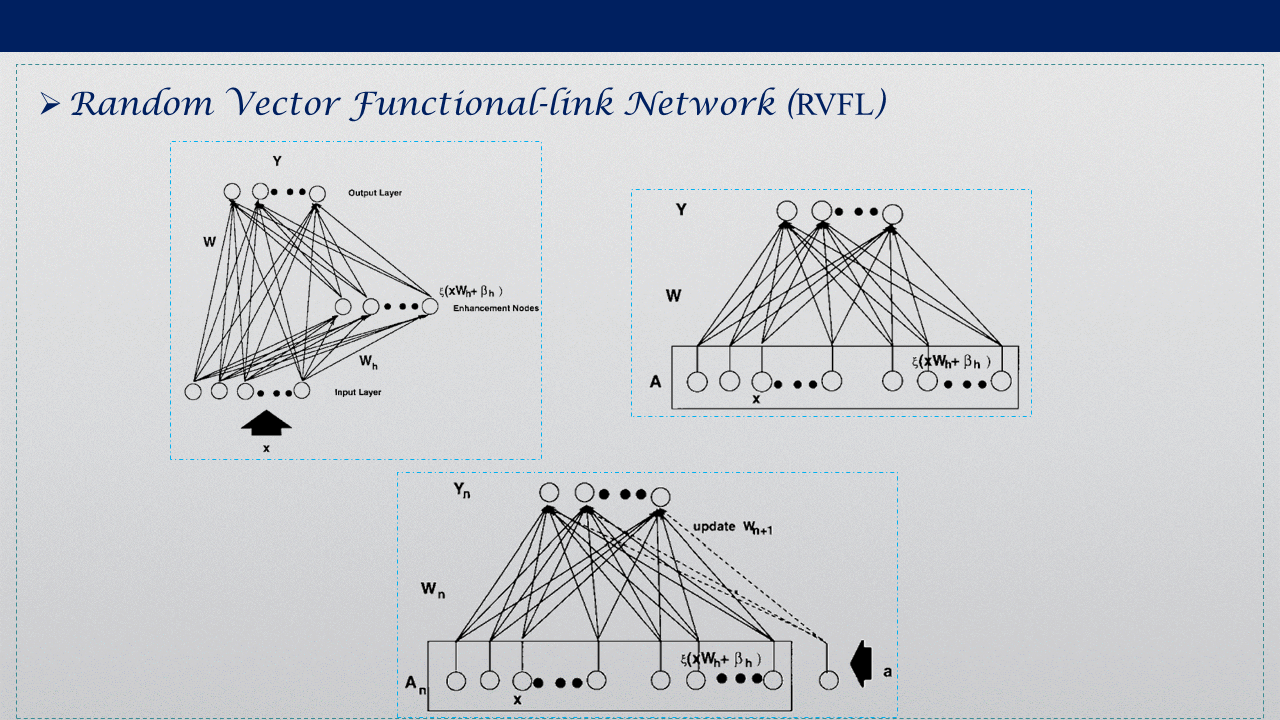

3. RVFL

Random Vector Functional-link Network (RVFL)算法是1994年提出的算法,与ELM相比,它增加了从输入层到输出层的连接权重。输入层到隐层的权重与隐层的偏置还是随机赋权,只有输入层到输出层与隐层到输出层的权重需要用最小二乘法或者其他方法求解。

4. 参考

[1] ELM官方网址:Extreme Learning Machines

[2] Huang G B, Zhu Q Y, Siew C K. Extreme learning machine: theory and applications[J]. Neurocomputing, 2006, 70(1-3): 489-501.

[4] 论战Yann LeCun:谁能解释极限学习机(ELM)牛X在哪里?

[5] Tang J, Deng C, Huang G B. Extreme learning machine for multilayer perceptron[J]. IEEE transactions on neural networks and learning systems, 2015, 27(4): 809-821.

[6] Pao Y H, Park G H, Sobajic D J. Learning and generalization characteristics of the random vector functional-link net[J]. Neurocomputing, 1994, 6(2): 163-180.

[7] 伪逆总结 - CSDN

[8] 对ELM的质疑:Extreme Learning Machine: Duplicates Others' Papers from 1988-2007

[9] 王常飞. 融合分层极限学习机算法研究[D]. 湘潭大学, 2018.

浙公网安备 33010602011771号

浙公网安备 33010602011771号