Batch Normalization

Batch Normalization

论文地址:https://arxiv.org/pdf/1502.03167.pdf

概念解释

Batch Normalization 就是批归一化,就是对数据做标准化处理。

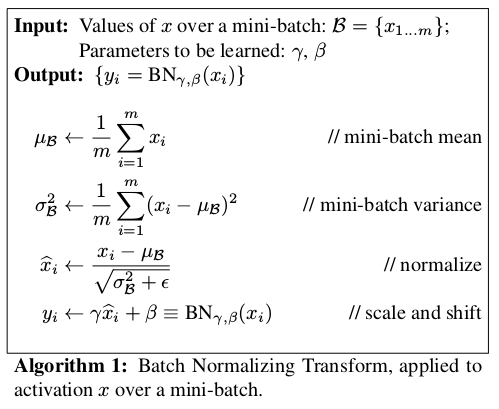

上图表示的意思是:

求每一个批次特征变量的均值和方差,再对之进行标准化。

Internal Covariate Shift

深度神经网络涉及到很多层的叠加,而每一层的参数更新会导致上层的输入数据分布发生变化,通过层层叠加,高层的输入分布变化会非常剧烈,这就使得高层需要不断去重新适应底层的参数更新。为了训好模型,我们需要非常谨慎地去设定学习率、初始化权重、以及尽可能细致的参数更新策略。

ICS会导致的问题:

每个神经元的输入数据不再是“独立同分布”。

- 上层参数需要不断适应新的输入数据分布,降低学习速度。

- 下层输入的变化可能趋向于变大或者变小,导致上层落入饱和区,使得学习过早停止。

- 每层的更新都会影响到其它层,因此每层的参数更新策略需要尽可能的谨慎

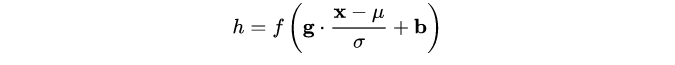

在将\(X_i\)送给神经元之前,先对其做平移和伸缩变换, 将\(X_i\)的分布规范化成在固定区间范围的标准分布。

浙公网安备 33010602011771号

浙公网安备 33010602011771号