虚拟机Linux环境配置hadoop

需要准备的资源:VMware Workstation Pro-17.6.4,ubuntu-24.04.3,hadoop-3.2.4

进入linux,打开终端准备进行配置。

一、安装jdk8(旧版兼容性好)

sudo apt update

sudo apt install openjdk-8-jdk -y

二、配置java

(1)检验java是否安装完成

java -version

javac -version

(2)配置JAVA_HOME

1.打开环境变量配置文件

nano ~/.bashrc

2.在文件末尾补充

Java环境变量

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64

export PATH=$JAVA_HOME/bin:$PATH

3.保存并退出(按Ctrl+O→回车→Ctrl+X),然后执行以下命令让配置立即生效

source ~/.bashrc

4.验证JAVA_HOME是否生效

echo $JAVA_HOME

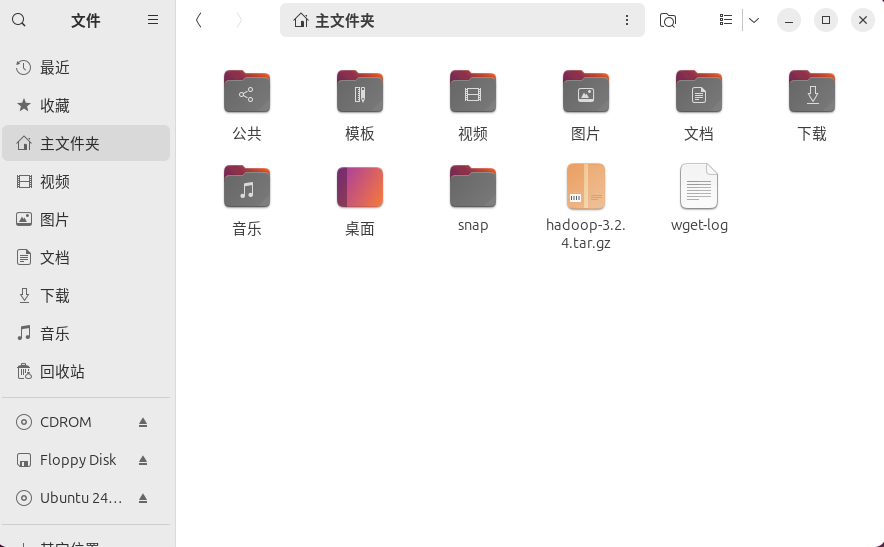

三、将hadoop文件下载到linux环境中

四、解压hadoop安装包

(1)打开终端,进入主文件夹:

cd ~

(2)创建 Hadoop 安装目录并解压:

sudo mkdir -p /usr/local/hadoop

sudo tar -zxvf hadoop-3.2.4.tar.gz -C /usr/local/hadoop --strip-components 1

(3)给当前用户赋予 Hadoop 目录的权限(避免后续操作权限报错)

sudo chown -R $USER:$USER /usr/local/hadoop

五、配置hadoop环境变量

(1)打开配置文件

nano ~/.bashrc

(2)在文件末尾粘贴以下内容

Hadoop环境变量

export HADOOP_HOME=/usr/local/hadoop

export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

export HADOOP_MAPRED_HOME=$HADOOP_HOME

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export YARN_HOME=$HADOOP_HOME

(3)保存并退出(按Ctrl+O→回车→Ctrl+X),然后让配置立即生效

source ~/.bashrc

六、配置hadoop核心文件

(1)进入hadoop配置目录

cd /usr/local/hadoop/etc/hadoop

(2)配置hadoop-env.sh

1.编辑hadoop-env.sh:

nano hadoop-env.sh

2.找到# export JAVA_HOME=这一行,替换为你的 Java 路径:

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64 # 替换成你实际的Java路径

(3)配置core-site.xml

编辑core-site.xml,在

(4)配置hdfs-site.xml(设置 HDFS 副本数)

编辑hdfs-site.xml,在

(5)配置yarn-site.xml(设置 YARN 资源管理)

编辑yarn-site.xml,在

(6) 配置mapred-site.xml(关联 MapReduce 和 YARN)

编辑mapred-site.xml,在

(7)设置 SSH 免密登录(Hadoop 依赖)

1.生成 SSH 密钥(一路回车默认即可):

ssh-keygen -t rsa

2.将公钥添加到授权列表:

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

3.赋予授权文件权限:

chmod 600 ~/.ssh/authorized_keys

4.测试免密登录(首次需输入yes确认):

ssh localhost

七、初始化 HDFS 并启动 Hadoop

(1)初始化 HDFS(仅首次执行,重复执行会清空数据):

hdfs namenode -format

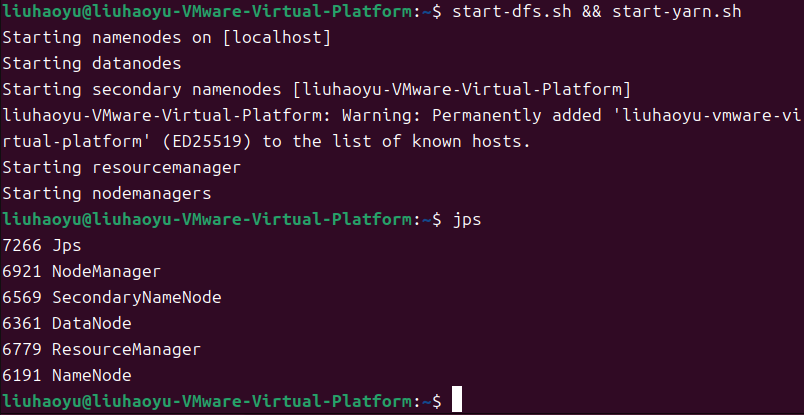

(2)启动 HDFS 和 YARN 服务:

start-dfs.sh

start-yarn.sh

(3)验证 Hadoop 是否启动成功:

jps

(4)

(若出现以下进程,说明启动成功:

NameNode

DataNode

ResourceManager

NodeManager

SecondaryNameNode)

浙公网安备 33010602011771号

浙公网安备 33010602011771号