大数据Hadoop学习五

Apache Hive分布式SQL计算平台

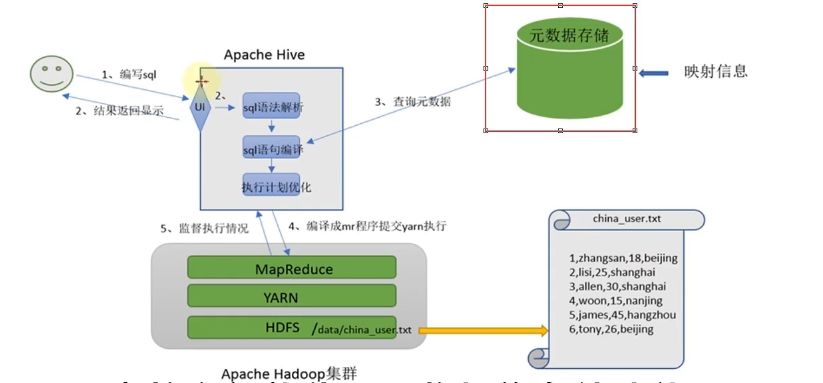

主要功能就是将SQL语句翻译成MapReduce程序运行

基于Hive为用户提供分布式SQL计算的能力,写的是SQL、执行的是MapReduce

Apache Hive概述

分布式SQL计算

对数据进行统计分析,SQL是目前最为方便的编程工具

前面学习的MapReduce支持程序开发(java\python),但是不支持SQL开发

使用Hadoop MapReduce直接处理数据所面临的问题

使用Hive方便简单

人员学习成本太高需要掌握java、Python等编程语言

MapReduce实现复杂查询逻辑开发难度太大

使用Hive处理数据的好处

操作接口采用类SQL语法,提供快速开发的能力(简单、容易上手)

底层执行MapReduce,可以完成分布式海量数据的SQL处理

小结

1.什么是分布式SQL计算?

以分布式的形式,执行SQL语句,进行数据统计分析。

2.Apache Hive是做什么的?

很简单,将SQL语句翻译成MapReduce程序,从而提供用户分布式SQL

计算的能力。

传统MapReduce开发:写MR代码->得到结果

使用Hive开发:写SQL->得到结果

底层都是MR在运行,但是使用层面上更加简单了。

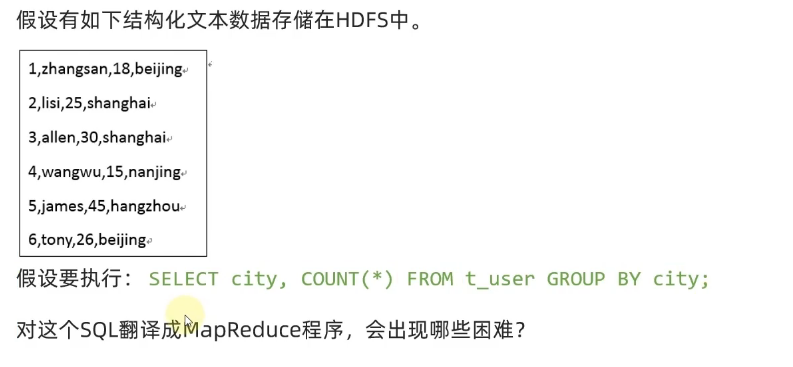

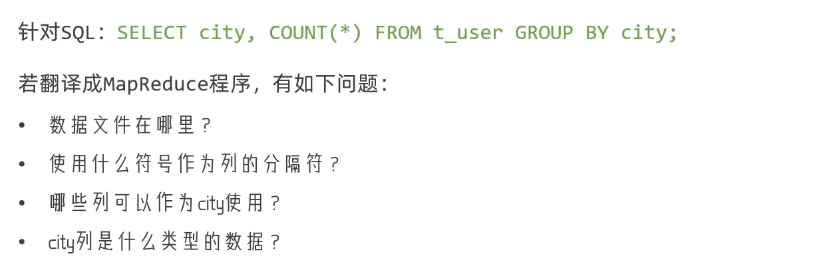

模拟实现Hive功能

元数据管理

所以,我们可以总结出来第一个点,

即构建分布式SQL计算,需要拥有:

·元数据管理功能,即:

·数据位置

·数据结构

等对数据进行描述

进行记录

解析器

解决元数据管理后还要完成SQL到MapReduce转换的功能

我们称呼它为:SQL解析器,期待它能做到:

SQL分析

SQL到MapReduce程序的转换

提交MapReduce程序运行并收集执行结果

基础架构

Hive架构

两大主要组件就是SQL解析器以及元数据存储

基础架构图

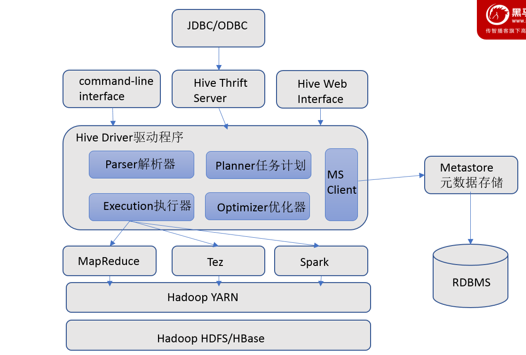

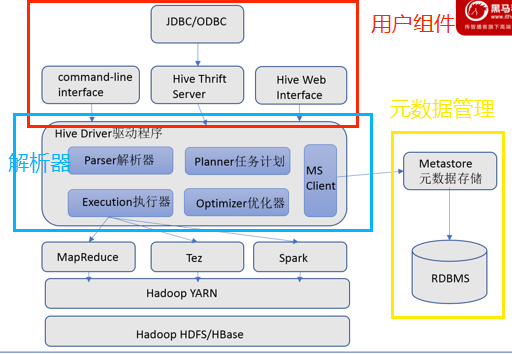

Hive组件

元数据存储

通常是存储在关系数据库如mysql./derby中。Hive中的元数据包括表的名字,表的列和分区及其属性,表的属性(是否为外部表等),表的数据所在目录等。

-Hive提供了Metastore服务进程提供元数据管理功能

上图中的Metastore和RDBMS就涉及到元数据管理功能

Driver驱动程序,包括语法解析器、计划编译器、优化器、执行器

完成HQL查询语句从词法分析、语法分析、编译、优化以及查询计划的生成。

生成的查询计划存储在HDFS中,并在随后有执行引擎调用执行。

这部分内容不是具体的服务进程,而是封装在Hive依赖的Jar文件即Java代码中。

Hive Driver驱动程序负责完成这部分工作,这个就是我们在前面所说的SQL解析器。

用户接口(上图中最上面的部分前两块)

包括CLI、JDBC/ODBC、WebGUI。其中,CLI(command line interface)为shell命令行;Hive中的Thrift服务器允

外部客户端通过网络与Hive进行交互,类似于DBC或ODBC协议。WebGUl是通过浏览器访问Hive。

-Hive提供了Hive Shell、ThriftServer等服务进程向用户提供操作接口

小结

Hive组件就是分为三部分

元数据管理,称之为Metastore服务

SQL解析器(Driver驱动程序),完成SQL解析、执行优化、代码提交等功能

用户接口:提供用户和Hive交互的功能

Hive部署

VMware虚拟机部署

Hive是单机工具,只需要部署在1台服务器即可。

Hive虽然是单机的,但是它可以提交分布式运行的MapReduce程序运行。

规划

需要准备一台服务器供Hive使用,同时Hive需要使用元数据服务,也就是需要提供一个关系型数据库,我们也选择一台服务器安装关系型数据库即可

| 服务 | 机器 |

|---|---|

| Hive本体 | 部署在node1 |

| 元数据服务所需的关系型数据库(MySQL) | 部署在node1 |

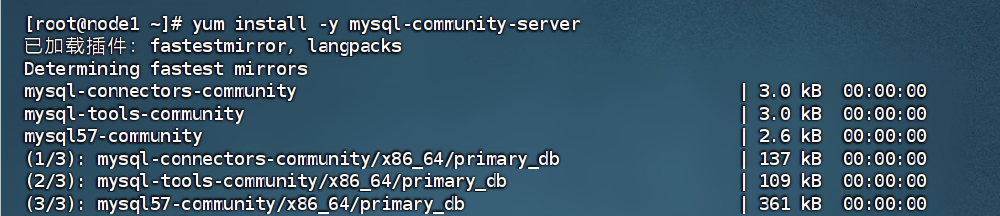

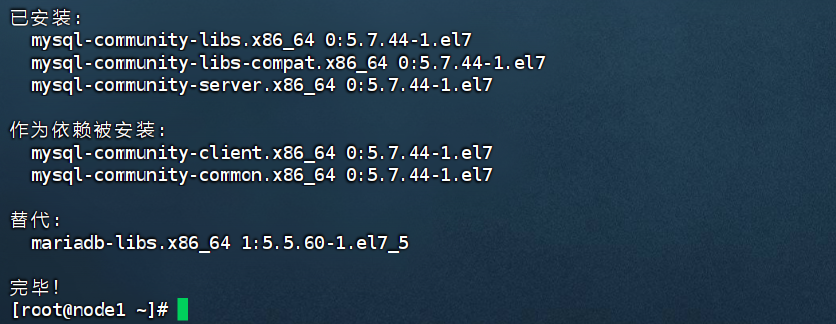

步骤一、安装MySQL数据库

在node1节点使用yum在线安装MySQL5.7版本

#更新密钥

rpm --import https://repo.mysql.com/RPM-GPG-KEY-mysql-2022

#安装MySQL yum库

rpm -Uvh http://repo.mysql.com//mysql57-community-release-el7-7.noarch.rpm

#yum安装MySQL

yum install -y mysql-community-server

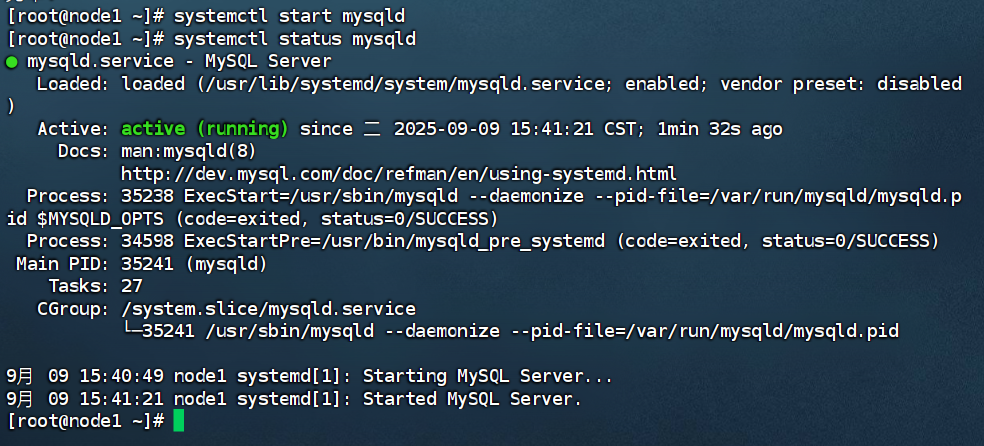

#启动MySQL设置开机启动

systemctl start mysqld

systemctl enable mysqld

#检查MySQL服务状态

systemctl status mysqld

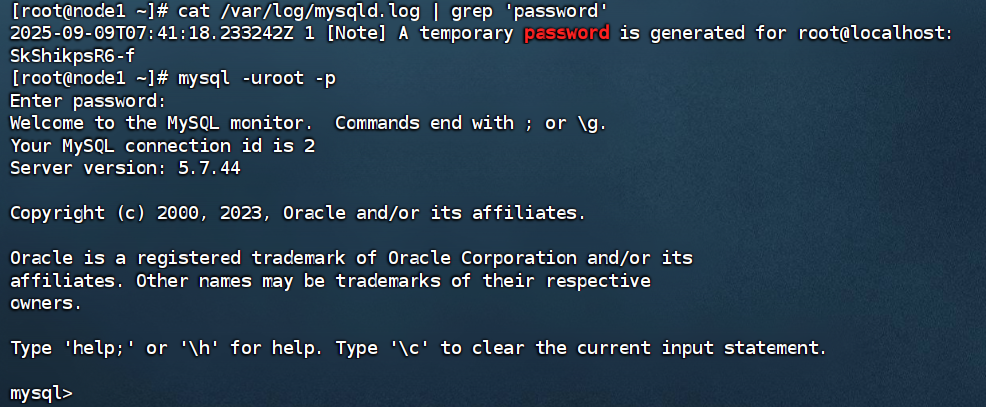

#第一次启动mysql,会在日志文件中生成root用户的一个随机密码,使用下面的命令查看该密码

cat /var/log/mysqld.log | grep 'password'

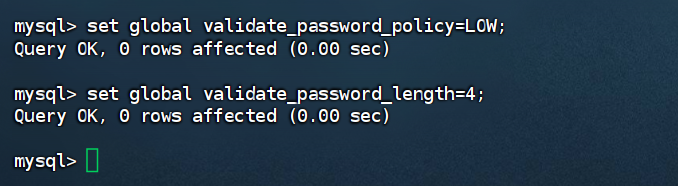

#如果你想设置简单密码,需要降低MySQL的密码安全级别

set global validate_password_policy=LOW;

#然后就可以使用简单密码了

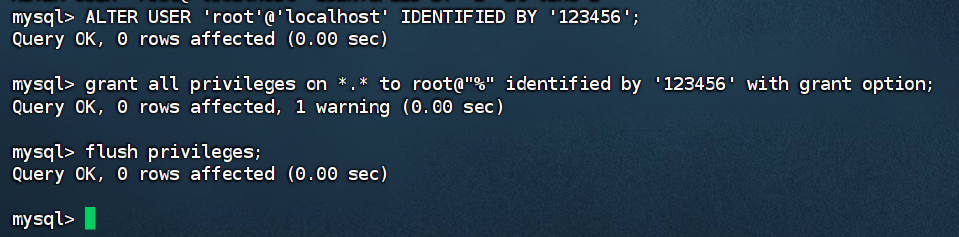

ALTER USER 'root'@'localhost' IDENTIFIED BY '123456';

grant all privileges on *.* to root@"%" identified by '123456' with grant option;

flush privileges;

查看临时密码:(然后登录mysql)

SkShikpsR6-f

进入后修改密码权限

完成密码的修改(接着刷新权限)

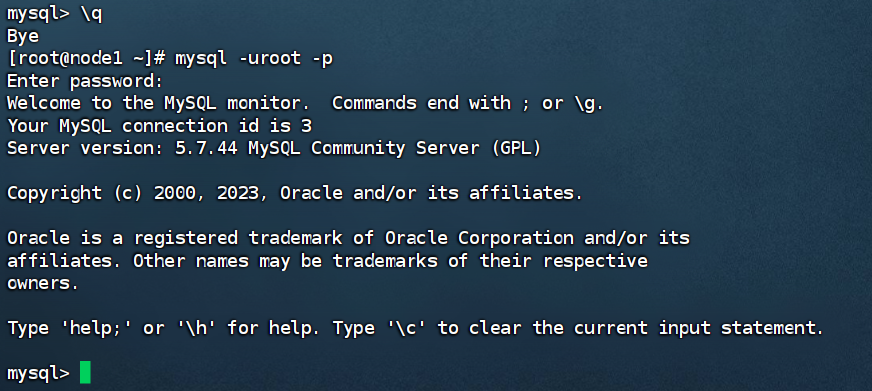

输入/q退出当前的mysql,然后使用新设置的简单密码完成登录

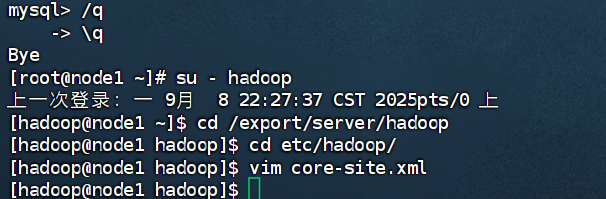

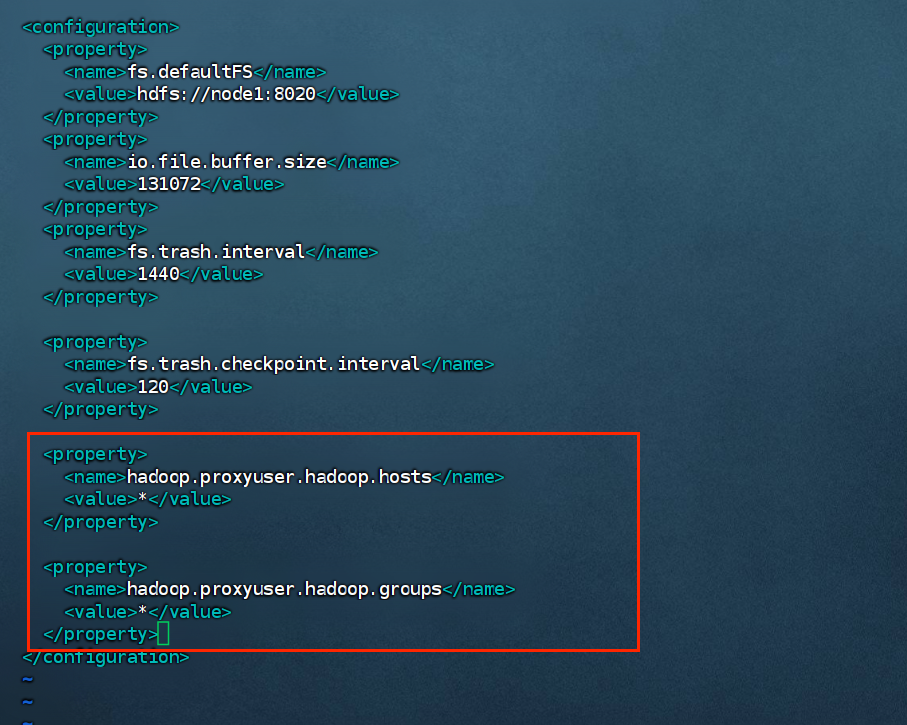

步骤二、配置Hadoop

Hive的运行依赖于Hadoop(HDFS、MapReduce、YARN都依赖)

同时涉及到HDFS文件系统的访问,所以需要配置Hadoop的代理用户

即设置hadoop用户允许代理(模拟)其它用户

配置如下内容在Hadoop的core-site.xml中,并分发到其它节点,且重启HDFS集群

<property>

<name>hadoop.proxyuser.hadoop.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.hadoop.groups</name>

<value>*</value>

</property>

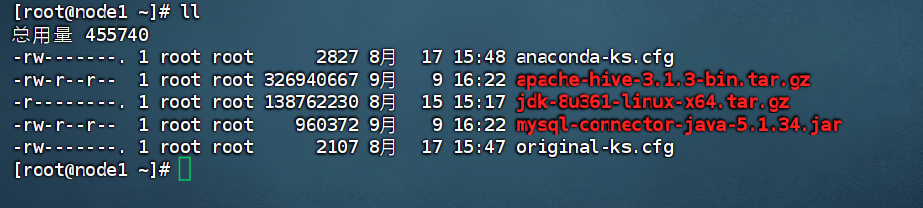

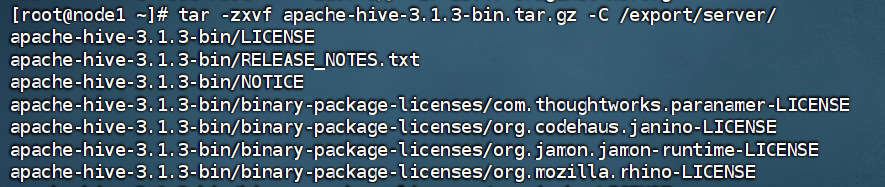

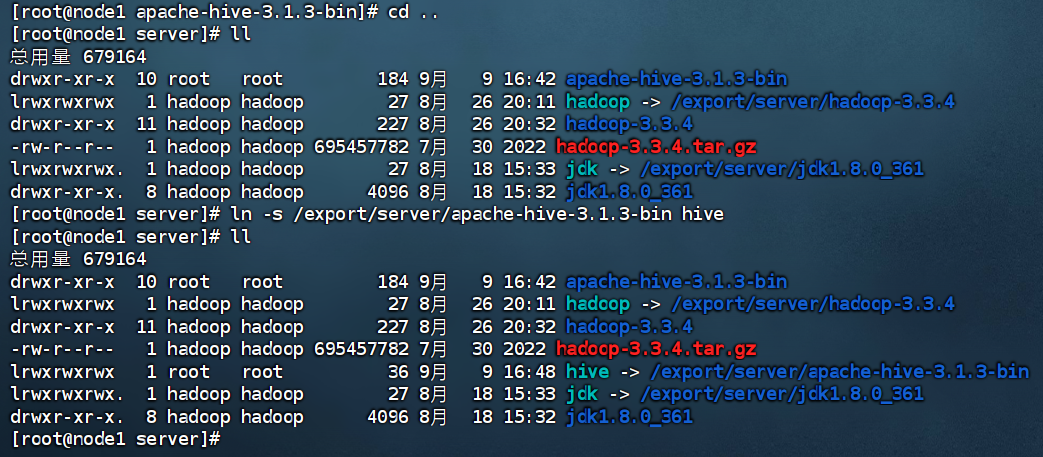

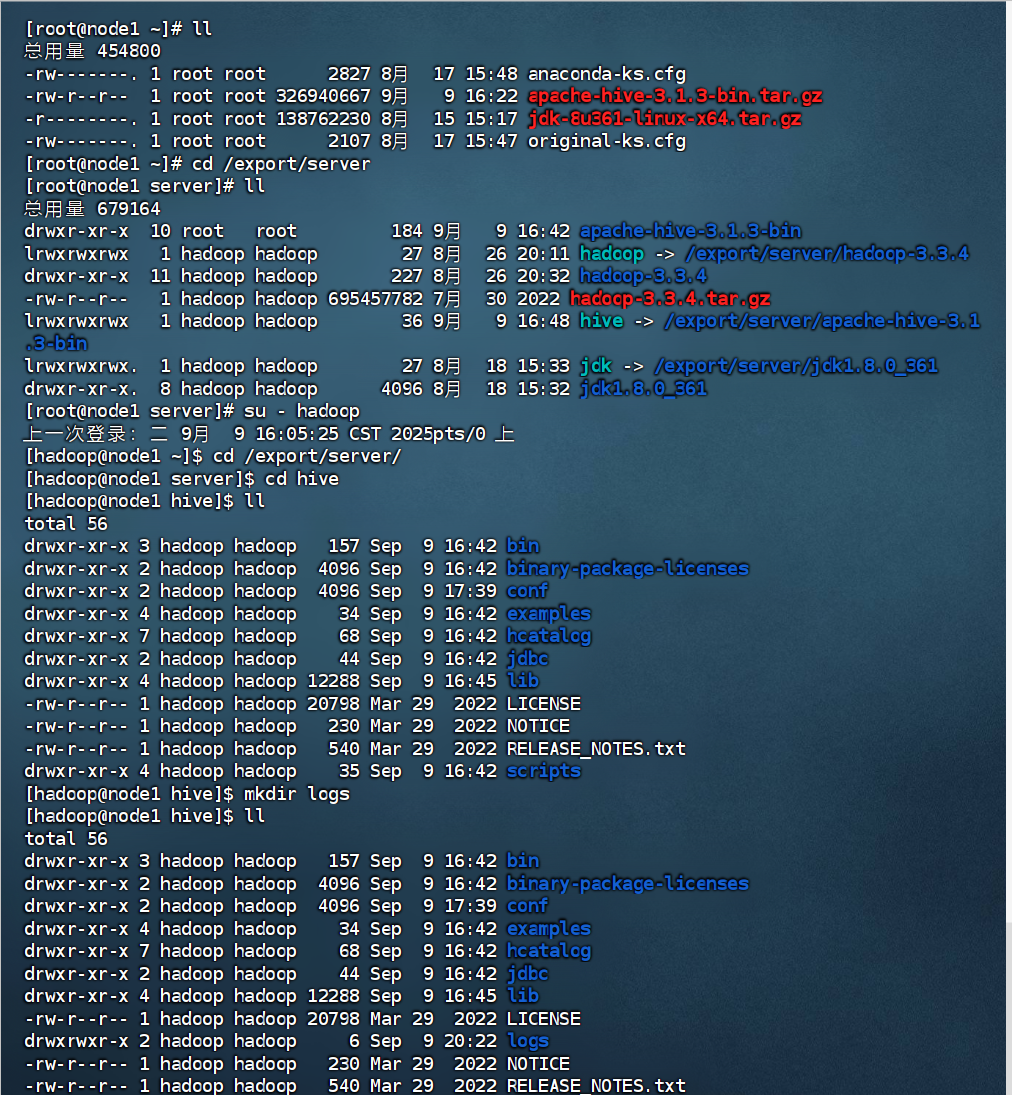

步骤三、下载解压Hive

切换到nadoop用户

su hadoop

下载Hive安装包:

http://archive.apache.org/dist/hive/hive-3.1.3/apache-hive-3.1.3-bin.tar.gz

解压到node1服务器的:/export/server/内

tar -zxvf apache-hive-3.1.3-bin.tar.gz -C /export/server/

设置软连接

ln -s /export/server/apache-hive-3.1.3-bin /export/server/hive

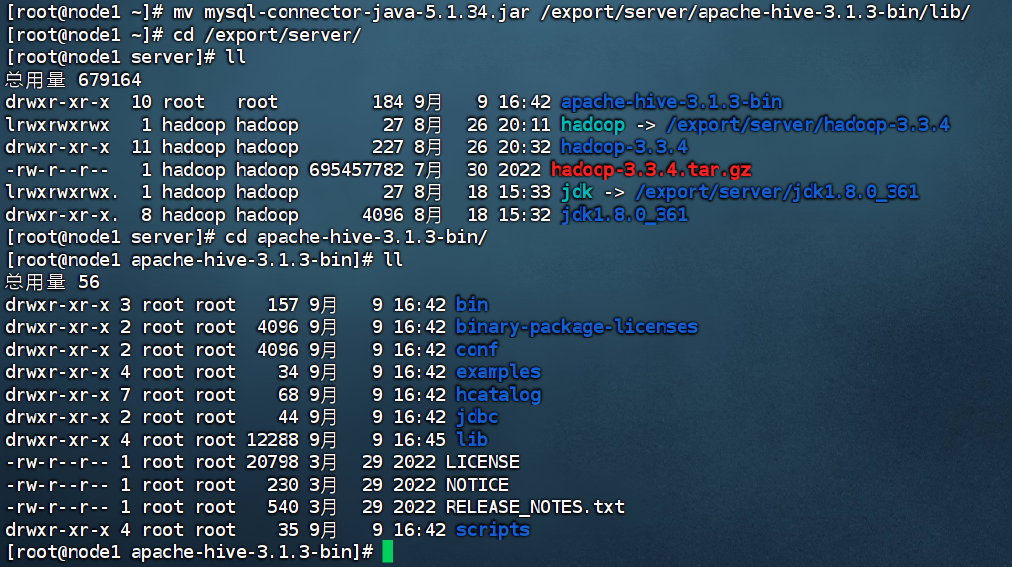

步骤四、提供MySQL Driver包

下载MySQL驱动包:

https://repo1.maven.org/maven2/mysql/mysql-connector-java/5.1.34/mysql-connector-java-

5.1.34.jar

将下载好的驱动iar包,放入:Hive安装文件夹的ib目录内

mv mysql-connector-java-5.1.34.jar /export/server/hive/lib/

上传完成Hive安装包和Mysql jar包

解压:

移动

设置软链接

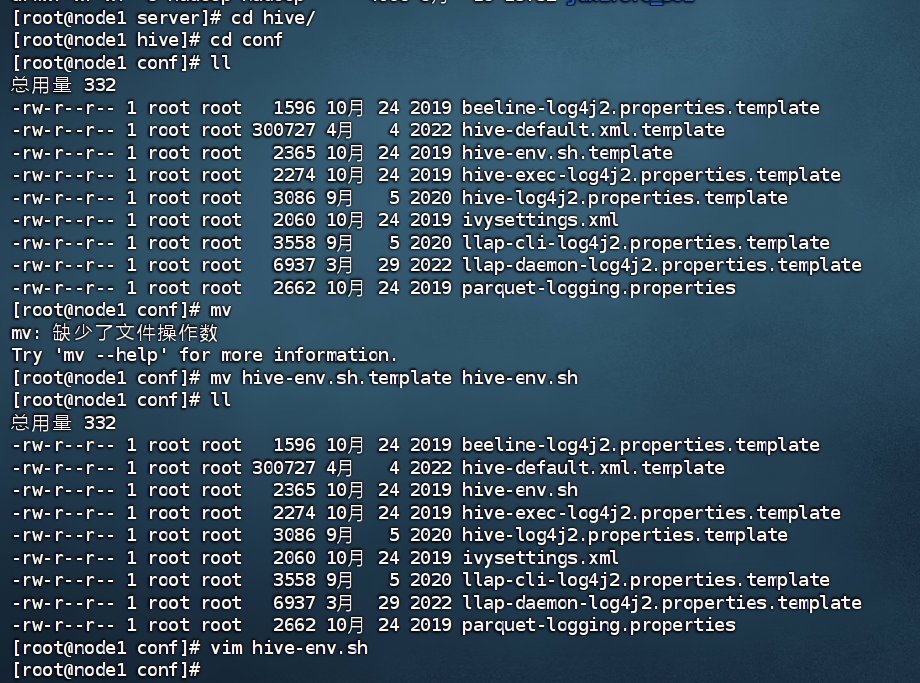

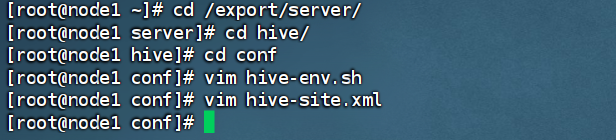

步骤五、配置Hive

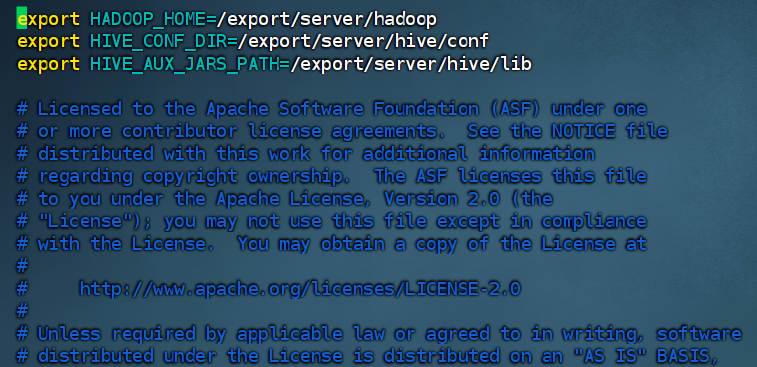

在Hive的conf目录内,新建hive-env.sh文件,填入以下环境变量内容:

export HADOOP_HOME=/export/server/hadoop

export HIVE_CONF_DIR=/export/server/hive/conf

export HIVE_AUX_JARS_PATH=/export/server/hive/lib

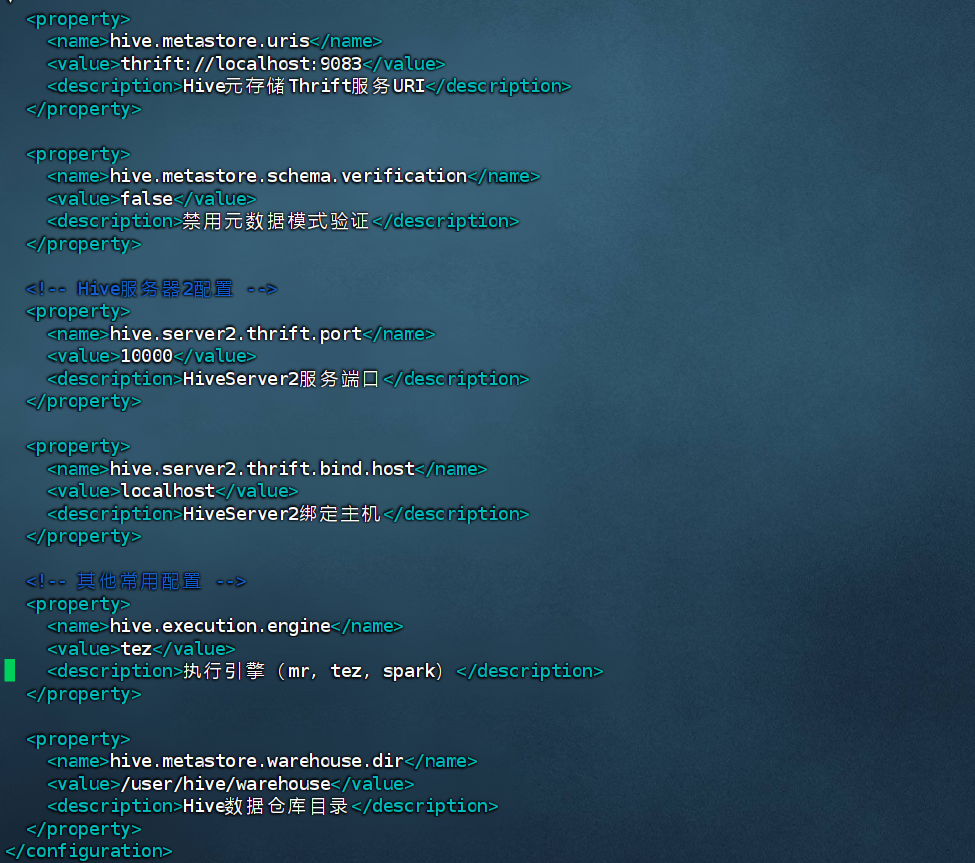

在Hive的conf目录内,新建hive-site.xml文件,填入下面的内容

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://localhost:3306/hive_metastore?createDatabaseIfNotExist=true</value>

<description>JDBC连接字符串用于元数据存储</description>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

<description>MySQL JDBC驱动类</description>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

<description>数据库用户名</description>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>123456</value>

<description>数据库密码</description>

</property>

<!-- Hive元存储服务配置 -->

<property>

<name>hive.metastore.uris</name>

<value>thrift://localhost:9083</value>

<description>Hive元存储Thrift服务URI</description>

</property>

<property>

<name>hive.metastore.schema.verification</name>

<value>false</value>

<description>禁用元数据模式验证</description>

</property>

<!-- Hive服务器2配置 -->

<property>

<name>hive.server2.thrift.port</name>

<value>10000</value>

<description>HiveServer2服务端口</description>

</property>

<property>

<name>hive.server2.thrift.bind.host</name>

<value>localhost</value>

<description>HiveServer2绑定主机</description>

</property>

<!-- 其他常用配置 -->

<property>

<name>hive.execution.engine</name>

<value>mr</value>

<description>执行引擎(mr, tez, spark)</description>

</property>

<property>

<name>hive.metastore.warehouse.dir</name>

<value>/user/hive/warehouse</value>

<description>Hive数据仓库目录</description>

</property>

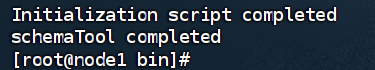

步骤六、初始化元数据库

到此,Hive的配置已经完成,现在在启动Hive前,需要先初始化Hive所需的元数据库。

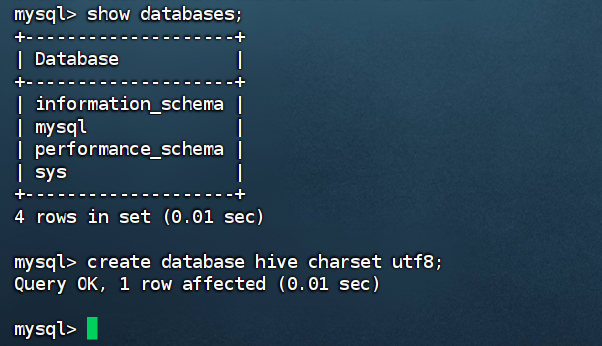

在MySQL中新建数据库:hive

CREATE DATABASE hive CHARSET UTF8;

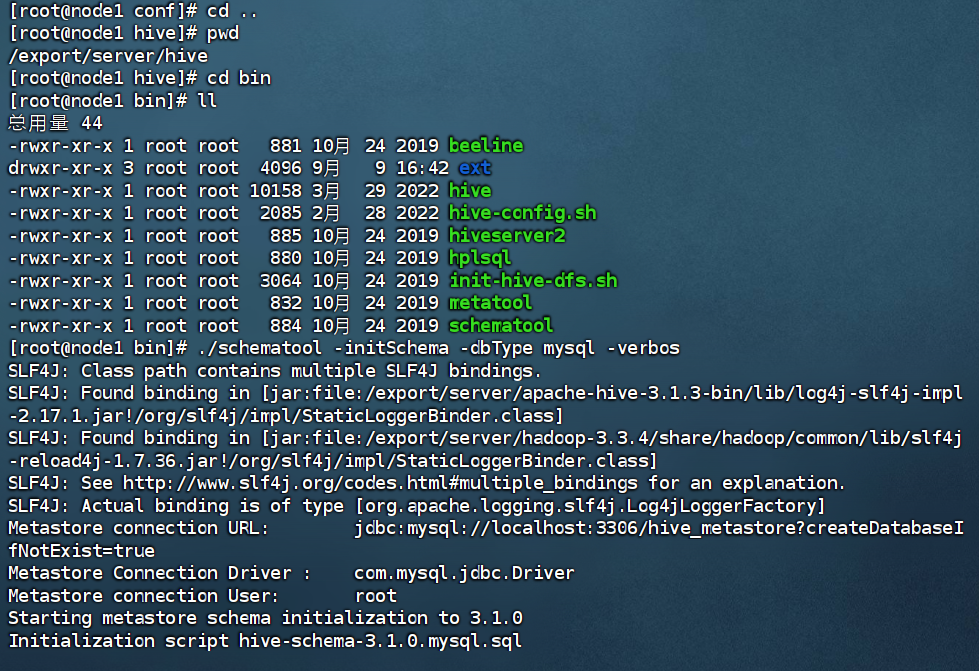

执行元数据库初始化命令:

cd /export/server/hive

bin/schematool -initSchema -dbType mysql -verbos

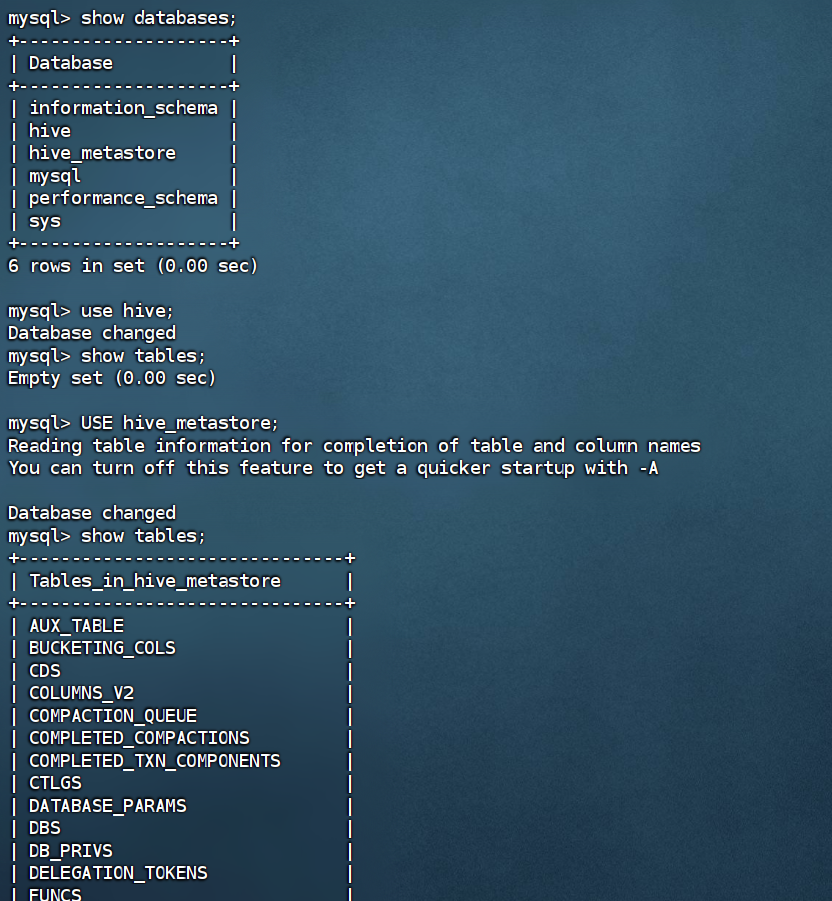

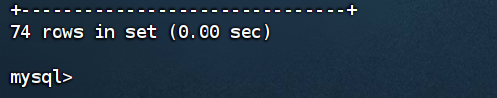

初始化成功后,会在MySQL的hive库中新建74张元数据管理的表。

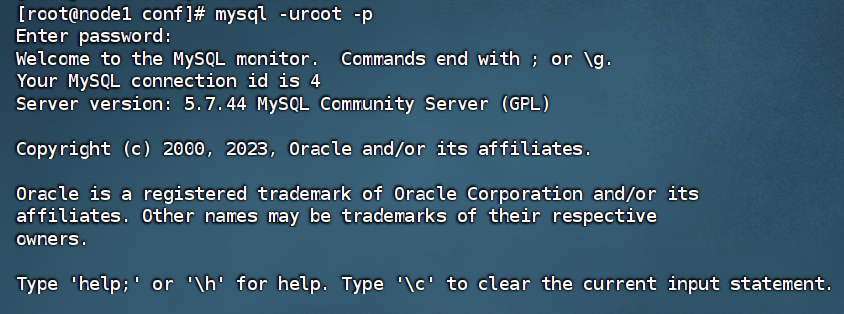

进入mysql

创建数据库

初始化mysql

初始化完成后登录mysql查看数据

一共74条

需要注意的就是

hive数据库 vs hive_metastore数据库

hive_metastore:这是Hive的元数据数据库,存储了所有表结构、分区、列信息等元数据

hive:这是一个空的数据库,Hive会自动创建它作为默认数据库,但里面没有系统表

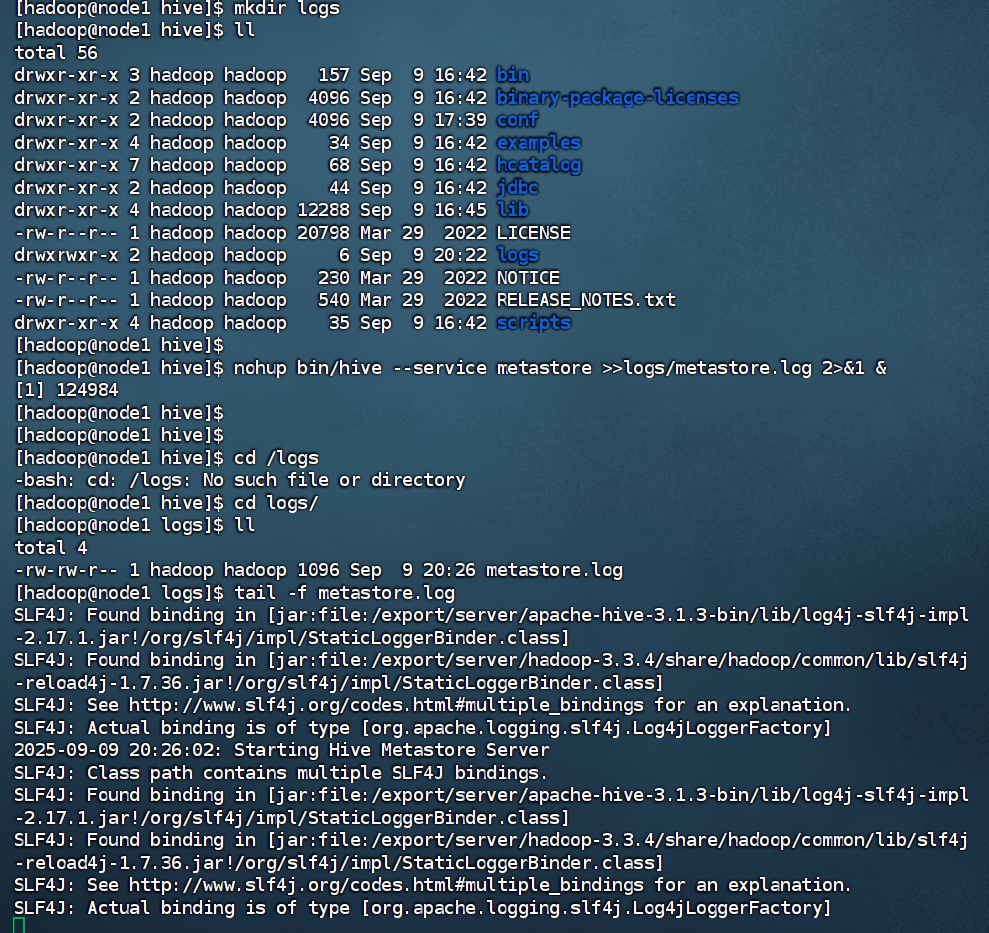

步骤七、启动Hive(使用Hadoop用户)

确保Hive文件夹所属为hadoop用户

创建一个hive的日志文件夹:

mkdir /export/server/hive/logs

启动元数据管理服务(必须启动,否则无法工作)

前台启动:bin/hive --service metastore

后台启动:nohup bin/hive --service metastore>>logs/metastore.log2>&1&

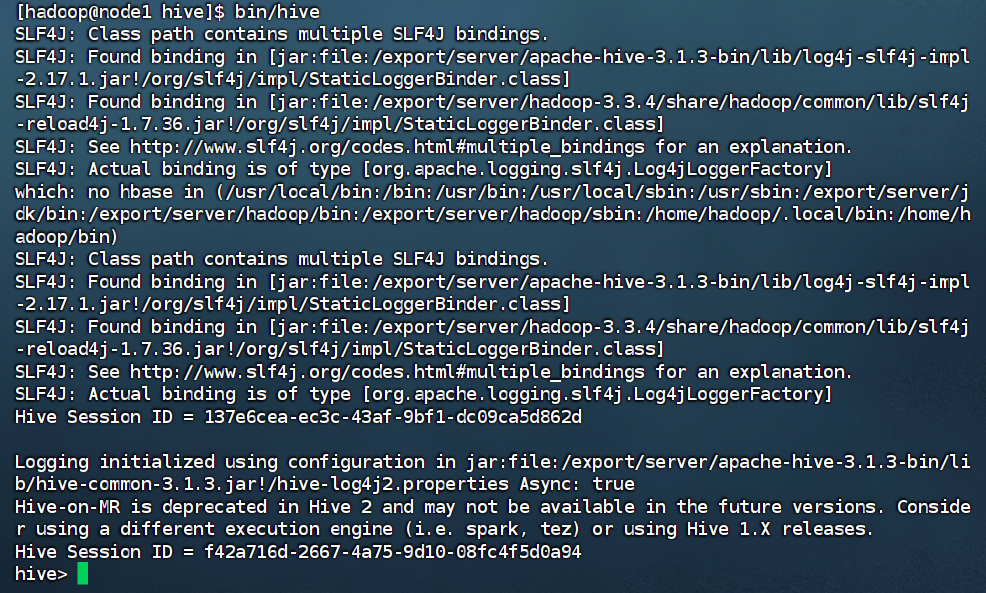

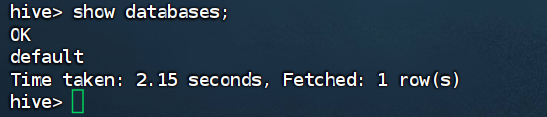

启动客户端,二选一(当前先选择Hive Shell方式)

Hive Shel1方式(可以直接写SQL):bin/hive

Hive ThriftServer方式(不可直接写SQL,需要外部客户端链接使用);bin/hive --service hiveserver2

启动时,不要忘记启动dfs和yarn否则不能运行成功

浙公网安备 33010602011771号

浙公网安备 33010602011771号