博弈智能:交互建模、智能求解与未来展望

博弈智能融合博弈论、人工智能与多智能体系统,致力于研究多个智能体在复杂环境中如何进行交互与策略优化。这里回顾其理论基础,包括马尔可夫决策过程、博弈模型与策略学习方法,划分合作博弈、对抗博弈与混合博弈三类典型范式,系统梳理其建模与求解技术。进一步探讨了当前研究热点如数据驱动策略学习、不完美信息处理与深度博弈强化学习的应用,最后展望博弈智能面临的挑战与未来发展方向。

1. 引言

随着人工智能(Artificial Intelligence, AI)的快速发展和行为数据的大规模生成,越来越多的研究者开始关注如何让多个智能体(Agent)在复杂环境中进行有效互动与博弈。这类交互不仅包括明确的合作与对抗,也涵盖了混合策略、信息不完全等不确定因素,使得传统单智能体学习方法面临瓶颈。在这种背景下,“博弈智能”(Game Intelligence)作为博弈论与人工智能融合的新型研究范式应运而生。博弈智能不仅关注个体在博弈环境中的最优策略选择,更强调在复杂多变的系统中,通过智能建模、博弈推演和机器学习等方法,使多个智能体能够实现交互协同、策略演化与智能决策。

1.1 研究背景:从博弈论到智能博弈

博弈论自冯·诺依曼与摩根斯特恩的《博弈论与经济行为》问世以来,已成为研究个体之间策略互动的核心工具。其在经济学、军事、政治和计算机科学中广泛应用。然而,经典博弈论更多建立在理性完备与策略已知的前提上,难以应对真实世界中的动态、非完美信息以及策略学习等问题。随着AI、机器学习、数据挖掘等技术的成熟,博弈论开始与强化学习、多智能体系统等领域深度融合,形成了博弈智能的研究框架。尤其是在AlphaGo、OpenAI Five 等基于深度博弈强化学习的成功应用之后,博弈智能的理论价值与实践潜力被极大凸显。

1.2 数据驱动与交互智能的崛起

在当今复杂系统中,数据驱动与交互智能的迅速崛起推动了博弈智能的发展。随着互联网、移动设备与物联网的普及,来自电商点击流、金融交易记录、社交网络互动以及智能设备行为的数据持续积累。这些数据不仅体量庞大,而且具有高频、高维与动态变化等显著特征,使得对个体行为的建模逐渐从传统的“假设驱动”范式转向“数据驱动”模式。在这一背景下,博弈智能的研究重点逐步从静态建模走向动态学习,智能体不再仅依赖于人为设定的规则或先验模型,而是通过深度学习、模仿学习、自监督学习等AI方法从数据中提取行为规律与战略模式,进而实现对环境的理解与对对手行为的预测。

1.3 博弈智能的定义与核心问题

博弈智能指的是在包含多个交互智能体的复杂系统中,借助博弈论的理论框架、机器学习算法与行为数据分析方法,建立起系统的策略决策机制,从而实现对多智能体交互博弈的动态建模、策略学习与最优响应生成。其核心问题包括:如何建立智能体之间的策略空间与支付结构模型;如何在不完美信息或部分可观测条件下实现策略的优化学习;如何将博弈均衡理论(如纳什均衡、混合策略均衡等)与深度强化学习、元学习等AI算法结合,找到系统的最优解或稳态解;以及在多智能体长期交互过程中,如何实现学习算法的收敛性、智能体之间的协同合作或策略对抗。这些问题构成了博弈智能研究的基本范畴,也是推动AI与经济、社会系统深度融合的关键所在。

2. 博弈智能的理论基础

博弈智能的理论基础建立在博弈论、强化学习和多智能体系统的交叉整合之上。为理解博弈智能系统如何建模和求解,需首先掌握以下核心支撑理论:

2.1 单智能体决策建模:马尔可夫决策过程(MDP)

马尔可夫决策过程(Markov Decision Process, MDP)是描述单一智能体在确定性或随机性环境中进行序列决策的基本数学框架。一个标准的 MDP 通常表示为五元组 \((S, A, P, R, \gamma)\),其中:

- \(S\):状态空间,表示环境的所有可能状态;

- \(A\):动作空间,表示智能体在每个状态下可采取的行动集合;

- \(P(s'|s,a)\):状态转移概率,表示智能体在状态 (s) 下采取动作 (a) 后转移到状态 (s') 的概率;

- \(R(s,a)\):奖励函数,定义智能体采取某动作的即时收益;

- \(\gamma\in[0,1]\):折扣因子,衡量未来奖励的重要程度。

MDP 的求解目标是找到一个策略函数\(\pi(a|s)\),使得在该策略下,累积预期收益最大。常用的求解方法包括值迭代(Value Iteration)、策略迭代(Policy Iteration)以及基于近似函数的深度强化学习方法(如 DQN, A3C 等)。

2.2 多智能体决策建模:博弈论基本模型

当系统中存在多个智能体相互影响时,单智能体的 MDP 模型显得不再充分。此时,需借助博弈论中的建模工具来刻画智能体间的互动关系。常见的博弈建模形式包括:

- 正常形式博弈(Normal-form Game):适用于一次性静态博弈,建模为策略集合与收益矩阵;

- 扩展形式博弈(Extensive-form Game):适用于多阶段、具有顺序性的信息博弈,采用决策树方式建模;

- 重复博弈(Repeated Game):建模智能体间长期互动过程,强调历史策略演化与信任机制;

- 贝叶斯博弈(Bayesian Game):处理信息不完全的博弈场景,通过类型空间建模信念差异;

- 马尔可夫博弈(Markov Game):即多智能体MDP,刻画多个决策者在状态转移中的交互。

在上述模型中,不同的建模假设对后续的求解算法有直接影响。例如,扩展形式博弈可以使用逆向归纳法(backward induction)求解,而贝叶斯博弈中则需要结合概率推理进行策略更新。

2.3 策略学习与求解:从强化学习到博弈学习

在已知博弈结构与奖励模型的前提下,传统博弈论往往采用 Nash 均衡、演化稳定策略等理论手段进行分析与求解。但在博弈智能框架中,智能体通常面临未知对手策略、部分可观测状态等不确定条件,需借助学习算法完成策略优化。

强化学习(Reinforcement Learning, RL)

强化学习强调通过与环境交互获得反馈,逐步优化行为策略。在多智能体场景下,可扩展为:

- 独立强化学习(Independent Q-learning):每个智能体独立建模其他智能体为环境;

- 集中式训练,分布式执行(CTDE):例如 MADDPG、COMA,在训练阶段共享全局信息;

- 对抗性RL(Adversarial RL):例如 Minimax-Q,用于处理零和对抗环境。

博弈学习(Game Learning)

博弈学习强调通过反复互动获取博弈结构或对手策略。典型方法包括:

- 模仿学习(Imitation Learning):从专家轨迹中学习策略,如 GAIL;

- 策略梯度博弈(Policy Gradient Game):如 LOLA、Fictitious Self-Play;

- 无模型博弈学习(Model-Free Learning):不依赖状态转移建模,基于试错学习;

- 经验对手建模(Opponent Modeling):动态估计并预测对手策略变化。

3. 博弈智能的三大范式与建模分析

本节围绕当前多智能体系统中的三类典型博弈范式——合作博弈、对抗博弈与混合博弈展开系统分析,涵盖其建模方法、策略求解、关键技术及实际应用案例,是理解和构建博弈智能系统的核心。

3.1 合作博弈智能(Cooperative Game Intelligence)

3.1.1 合作博弈建模与核心概念

合作博弈(Cooperative Game)关注的是多个智能体为了共同利益而形成联盟或协作机制的情形。博弈以特征函数为基础,定义任意联盟所能获得的总收益。在该框架下,关键问题在于如何进行公平、稳定且激励相容的收益分配。

- 特征函数(Characteristic Function):定义每一个智能体子集(即联盟)所能获得的最大收益。

- 核心(Core):表示在所有联盟都不愿意退出的前提下,可能的收益分配集合。若分配在核心内,则无人有动力离开当前联盟。

- Shapley值:根据边际贡献对每个智能体进行分配,是一种公平性极强的分配机制。

同时,为了描述更为复杂的合作结构,如部分联盟稳定、不同智能体间的通信约束,还需引入联盟结构与稳定性分析的概念,确保系统在策略层面实现动态平衡。

3.1.2 智能求解方法

在复杂系统中,合作行为的实现依赖于智能体间的协调机制与学习算法。目前主流方法包括:

- 分布式强化学习与通信机制:智能体在独立学习的基础上,通过有限通信实现策略一致。

- 联盟形成算法(Coalition Formation):基于代价-收益函数,智能体自主组建联盟,迭代更新形成稳定联盟划分。

- 合作强化学习(Cooperative MARL):多智能体在共享环境下协同学习策略,常用算法有QMIX、COMA等,通过集中训练、分布执行实现合作优化。

3.1.3 应用案例分析

- 多机器人任务协作:在搜索与救援、仓储物流中,多个机器人需协作完成目标任务,通过分布式策略学习协同路径规划与任务分配。

- 车联网资源共享:在车路协同中,车辆可作为智能体形成联盟共享通信带宽或路况信息,提高系统效率。

- 云计算中的任务分配:多个计算节点通过合作策略,实现任务调度与资源优化,提高整体吞吐率与公平性。

3.2 对抗博弈智能(Adversarial Game Intelligence)

3.2.1 对抗博弈模型基础

对抗博弈强调智能体间存在竞争关系,通常目标收益相互矛盾,典型情形包括安全攻防、市场竞争、博弈AI对弈等。

- 零和博弈:一个智能体收益增加意味着另一个损失增加。求解目标通常是最小化对手最大收益(Minimax策略)。

- 非零和博弈:对抗与合作共存,双方均可通过协调实现局部双赢。

- 纳什均衡(Nash Equilibrium):在该策略组合下,任意一方都无法通过单边策略改变获得更大利益。

- Stackelberg博弈:引入领导者-跟随者角色,通过先后决策建模策略依赖关系。

3.2.2 智能策略求解

对抗情形下,智能体需不断适应对手行为、预测其反应并调整自身策略。常用的AI求解方法包括:

- 深度强化学习+对抗策略:如DQN结合Minimax回合估值,学习最优对策策略。

- Policy Gradient在对抗环境下的应用:通过策略梯度优化智能体行为分布,可用于连续动作空间下的博弈建模。

- 生成对抗模仿学习(GAIL):在无明确博弈模型情形下,通过模仿专家行为训练策略函数,并引入生成对抗机制提升鲁棒性。

3.2.3 应用案例分析

- 安全博弈与入侵检测:在信息系统安全中,博弈模型可用于建模攻击者与防御者行为,通过强化学习实现动态响应机制。

- 智能博弈AI(如AlphaZero):将深度神经网络与MCTS搜索结合,训练出超越人类水平的博弈智能体。

- 策略博弈与市场竞争模拟:在多厂商动态定价、供应链博弈中,通过对抗建模优化价格与投放策略,预测市场反应。

3.3 混合博弈智能(Hybrid Game Intelligence)

3.3.1 混合博弈定义与分类

混合博弈介于合作与对抗之间,既存在联合行为需求,又面临潜在利益冲突。这类博弈更贴近现实多智能体系统中的复杂情境。

- 合作-对抗混合结构(Mixed-Motive Game):智能体之间局部合作、全局竞争,策略需平衡个体最优与整体协调。

- 复杂非对称博弈建模:考虑不同角色、信息权重、资源能力等,构建非均衡多智能体行为模型。

3.3.2 多样化智能体建模

在实际系统中,智能体通常存在异质性或层级结构,对应建模方式包括:

- 异质智能体系统:针对能力、目标、观测空间不同的智能体,分别设计策略学习模块,并协调其间的互动机制。

- 层级博弈与多阶段动态博弈:系统行为分阶段展开,某些智能体拥有先行权或策略先验,需结合动态博弈建模优化策略路径。

3.3.3 混合博弈中的关键技术

构建混合博弈智能需引入跨学科技术手段,包括:

- 博弈网络(Graph Games):通过图结构表达智能体间关系,可建模邻接性、依赖性与动态演化关系。

- 多智能体信任机制建模:引入信任函数评价合作意愿,在博弈过程中动态调整互动强度与信任程度。

- 策略自适应演化学习(Evolutionary Game Learning):结合演化博弈论,引导智能体策略集随时间演进,形成稳定行为模式。

3.3.4 应用案例分析

- 社交网络中的舆论博弈:在用户传播行为中,意见影响力、信息可信度构成典型混合博弈关系,博弈网络可模拟舆论演化。

- 电力交易中的协商博弈:多个电力生产商既竞争市场份额,又需合作维持电网稳定,通过混合策略提升整体收益。

- 金融市场中的合作对冲机制:投资机构在对冲风险时需博弈组合策略、交易时机与对手行为,实现多目标最优控制。

这三类博弈范式构成博弈智能系统的理论基石,分别适配于合作优化、对抗博弈与复杂多智能体交互等多样化情境。通过结合博弈理论与人工智能算法,研究者能更精准地刻画交互行为,设计高效策略,推动AI系统从孤立智能向交互智能的跃升。

4. 博弈智能的求解理论

现代博弈论在智能体交互决策中起到核心作用,尤其在人工智能、多智能体系统等复杂环境中,对博弈解的计算与逼近策略成为研究重点。以下从均衡算法、多智能体强化学习机制、典型博弈模型求解,以及多目标博弈扩展四方面展开讨论。

4.1 均衡解的算法

尽管博弈论中纳什均衡、Stackelberg 均衡等核心均衡概念在理论上定义明确,但实际应用中面临高维度、非线性、离散性等复杂挑战,特别是在大规模多智能体系统中。为此,研究者发展出多种博弈均衡求解算法,主要包括如下几类:

(1)混合策略均衡的线性规划法

对于二人零和博弈,其纳什混合策略均衡可以通过线性规划求解。基本思想为:

- 假设 payoff 矩阵为 \(A\);

- 玩家一希望最大化其最小收益(minimax);

- 令 \(x \in \Delta_m\) 为玩家一的策略向量,\(y \in \Delta_n\) 为玩家二的策略向量;

- 则问题转化为如下 saddle-point 求解:

该问题可重构为一个线性规划问题,利用对偶定理获得最优混合策略。

(2)支持集枚举法(Support Enumeration)

适用于小规模有限博弈的混合策略求解。基本流程如下:

- 枚举所有可能的支持集组合(即混合策略中非零概率的动作集合);

- 对每个支持集构建线性方程组,解出概率分布;

- 检查是否满足纳什均衡条件(如互为最优响应);

该方法计算复杂度高,但在小规模问题中可实现精确求解,常用于教学或理论验证。

(3)Lemke–Howson 算法

该算法是求解二人非零和博弈混合纳什均衡的经典方法,属于路径跟踪类算法(pivoting method)。其基本思想为:

- 利用补性约束(complementarity conditions)构造一个线性补性问题(LCP);

- 从人工初始策略出发,沿着约束边界路径迭代逼近均衡点;

- 收敛至某个满足所有约束的均衡解;

尽管数学解释性强,但该方法不适用于多智能体博弈,其在博弈参与者超过两人时面临计算复杂度指数爆炸问题。

(4)近似均衡(Approximate Equilibrium)

在高维策略空间下,精确求解纳什均衡通常不可行或计算代价极高。此时引入\(\epsilon\)-Nash均衡的近似概念:

即任何玩家改变策略所能获得的收益提升不超过 \(\epsilon\)。此类解可通过数值优化、模拟、强化学习等方法高效获得,广泛应用于大规模系统与工程博弈。

4.2 多智能体强化学习中的博弈求解机制

强化学习技术的发展为解决复杂博弈问题提供了全新范式。相比传统博弈算法依赖明确的 payoff 结构,多智能体强化学习(Multi-Agent RL)采用经验驱动、自学习、对抗演化的方式逼近均衡策略,适应性强且适合现实环境。

(1)MADDPG:Multi-Agent Deep Deterministic Policy Gradient

适用于连续动作空间下的多智能体协作或博弈。其机制如下:

- 每个智能体基于自身的观察构建局部策略;

- 同时引入一个中心化的价值函数(centralized critic)进行全局学习;

- 采用 DDPG 架构进行策略更新;

该方法能够有效应对动作空间维度高、策略间相互耦合的问题,广泛用于合作型或部分对抗型场景。

(2)自博弈机制(Self-Play / Fictitious Play)

自博弈类方法通过与自身历史策略或近似策略的不断对抗,实现策略演化。例如:

- Fictitious Play:每个智能体观察对方历史策略频率,更新自身最优响应;

- AlphaZero:引入蒙特卡洛树搜索(MCTS)与神经网络逼近博弈值,提升策略训练效率;

该类方法可逐步逼近纳什均衡,已在围棋、国际象棋、德州扑克等高复杂度环境中获得突破。

(3)演化博弈强化学习

借鉴生物演化思想,将策略看作“个体”种群,通过自然选择方式演化策略。基本机制:

- 每一代博弈结果作为适应度评估;

- 高适应度策略得以“复制”并“交叉变异”生成新策略;

- 弱策略被淘汰;

该方法适合无需精确博弈建模的复杂动态系统,强调策略多样性与长期适应性。

(4)博弈强化学习中的稳定性分析

借助演化动力学理论对学习过程中的策略演化路径与稳定性进行分析:

- 复制动态(Replicator Dynamics):策略占比随适应度调整;

- 最优反应动态(Best Response Dynamics):策略总是更新为当前最优响应;

- Lyapunov 稳定性分析:用于判定策略演化系统是否最终稳定收敛到某一固定点(均衡解);

该部分连接了博弈智能与控制理论,为构建稳定可靠的智能体系统提供理论保障。

4.3 示例模型与求解过程:Stackelberg 博弈中的无人巡逻(扩展)

为进一步展示博弈求解理论的实际应用,本文以 Stackelberg 安全博弈为例,分析其在无人机巡逻防御系统中的建模与求解机制。

(1)攻击概率的非线性建模

假设攻击者并不能完全观测防御策略,仅以概率 \(q_i\) 探测到某目标 \(t_i\) 的巡逻频次 \(x_i\),则攻击成功的概率为:

此处的指数型函数体现边际防御收益递减性:频率越高,防御效果越好,但提升空间逐渐减少。

(2)多资源协同巡逻策略

若系统中存在多个无人机,每个无人机 \(j\) 有独立的行动能力与资源约束,则整体策略空间扩展为:

- 各无人机策略联合构成协同联合策略空间;

- 引入调度约束与资源共享约束;

- 考虑空间与时间上的覆盖协调性;

该设置提升了模型复杂度,但更接近现实场景中的多机协作需求。

(3)组合优化建模:混合整数非线性规划(MINLP)

上述非线性成功概率与协同策略约束可构成 MINLP 问题,其目标函数为防守效用期望最大化,变量包括:

- 连续变量:目标巡逻频次;

- 离散变量:无人机巡逻路径选择;

常用求解工具包括 Gurobi、SCIP 等具备非线性与整数规划能力的商业优化器。

(4)对抗强化学习求解机制

为替代精确建模,可将攻击者作为强化学习环境,防守方训练策略网络 \(\pi_\theta(s)\):

- 输入:当前巡逻状态 \(s\)(如时间段、目标位置);

- 输出:分布式策略(如无人机调度概率);

- 优化:使用 PPO(Proximal Policy Optimization)等策略优化算法;

该方法适合高维、动态、非结构化的博弈系统。

(5)近似 Stackelberg 解生成器

构建一个神经网络映射模型近似 Stackelberg 均衡解,即:

- 输入:攻击者可能策略组合;

- 输出:防守方最优响应策略分布;

- 训练方法:可用逆向强化学习、策略梯度或双层优化网络实现;

该方式可将复杂的博弈求解过程转化为一次前向推理,适用于实时决策场景。

4.4 多目标扩展场景

在实际巡逻任务中,防守效用并非唯一目标。其他目标如:

- 能源消耗;

- 巡逻路径安全性;

- 可操作性与实时性;

都需纳入整体优化考虑。这类问题转化为多目标 Stackelberg 博弈(Multi-Objective Stackelberg Game):

常用求解机制包括:

- 帕累托前沿近似方法:如非支配排序遗传算法 II(NSGA-II);

- 加权目标融合机制:将多个目标加权合并为一个综合目标函数,权重通过多准则决策理论(MCDA)确定;

该类方法实现了现实博弈系统中的目标权衡、决策透明性与策略可控性,提升了实用性与工程价值。

4.5 Stackelberg博弈中的无人巡逻示例与Python实现

🎯 示例背景

设有三个重要目标区域:

- \(t_1\):电站

- \(t_2\):水库

- \(t_3\):通信塔

无人机每天需在这三处巡逻,并决定各个目标的巡逻概率。

攻击者可以观察这些巡逻策略,并选择一个目标进行攻击。

🧮 参数设定

目标的参数如下表所示:

| 目标 \(t_i\) | 攻击成功收益 \(R_A(t_i)\) | 被发现损失 \(L_A(t_i)\) | 防守方价值 \(V_D(t_i)\) |

|---|---|---|---|

| 电站 \(t_1\) | 10 | -20 | 15 |

| 水库 \(t_2\) | 8 | -15 | 12 |

| 通信塔 \(t_3\) | 6 | -10 | 10 |

我们简化设定如下:

- 无人机对目标 \(t_i\) 的巡逻概率为 \(x_i\);

- 被巡逻即意味着攻击失败概率为 \(x_i\);

- 被攻击成功的概率为 \(1 - x_i\)。

🎮 Stackelberg博弈求解思路

- 攻击者后动:根据防守方策略选择攻击目标;

- 防守方先动:设计一个最优的巡逻概率向量 \(\mathbf{x} = (x_1, x_2, x_3)\) 来最大化自身效用;

- 攻击者理性响应:选择期望收益最大的攻击目标;

- 求解Stackelberg均衡:防守方在考虑攻击者最优响应的基础上优化自身策略。

✅ Python实现代码

import cvxpy as cp

import numpy as np

# 目标数量

n = 3

# 参数设置

R_A = np.array([10, 8, 6]) # 攻击成功的收益

L_A = np.array([-20, -15, -10])# 被发现的损失

V_D = np.array([15, 12, 10]) # 防守方收益

# 存储每个假设攻击目标下的解

defender_utilities = []

optimal_strategies = []

# 遍历假设攻击者选择每个目标作为最优响应

for target in range(n):

x = cp.Variable(n) # 巡逻概率向量

constraints = [cp.sum(x) == 1, x >= 0]

for j in range(n):

if j != target:

# 约束:攻击者偏好攻击 target

UA_i = x[target]*L_A[target] + (1 - x[target])*R_A[target]

UA_j = x[j]*L_A[j] + (1 - x[j])*R_A[j]

constraints.append(UA_i >= UA_j)

# 防守方期望效用

U_D = V_D @ x

problem = cp.Problem(cp.Maximize(U_D), constraints)

problem.solve()

if problem.status == 'optimal':

defender_utilities.append(U_D.value)

optimal_strategies.append(x.value)

# 选出最优策略

best_index = np.argmax(defender_utilities)

best_strategy = optimal_strategies[best_index]

# 输出结果

print("最优巡逻策略(目标1, 2, 3 对应巡逻概率):")

print(np.round(best_strategy, 3))

print("对应防守方效用:", round(defender_utilities[best_index], 2))

print("攻击者最可能攻击目标:t{}".format(best_index + 1))

最优巡逻策略(目标1, 2, 3 对应巡逻概率):

[ 1. 0. -0.]

对应防守方效用: 15.0

攻击者最可能攻击目标:t2

4.6 小结启示

博弈智能的求解理论已经由经典解空间计算,逐步向深度优化–博弈对抗–演化学习融合的复杂体系演进。当前的挑战主要集中在:

- 均衡求解的计算复杂性与逼近误差;

- 多目标博弈中的优劣权衡机制;

- 不完美信息与策略可解释性的平衡;

- 动态环境中的连续策略更新机制。

面向未来,需进一步构建更具解释力、泛化性强、适用于现实场景的博弈智能求解系统,推动该领域在智能交通、机器人协作、网络防御等方向的深入应用。

5. 博弈智能的研究挑战与发展趋势

博弈智能作为AI决策推理的重要分支,正逐步迈入理论与实践双重深化阶段。然而,当前博弈智能研究仍面临诸多挑战,涵盖建模复杂性、算法收敛性、策略泛化性与环境动态性等多个层面。与此同时,一系列新兴技术手段正在推动博弈智能实现从“可解问题”向“泛化能力强、适应性高”的智能体系统演进。

5.1 当前存在的关键挑战

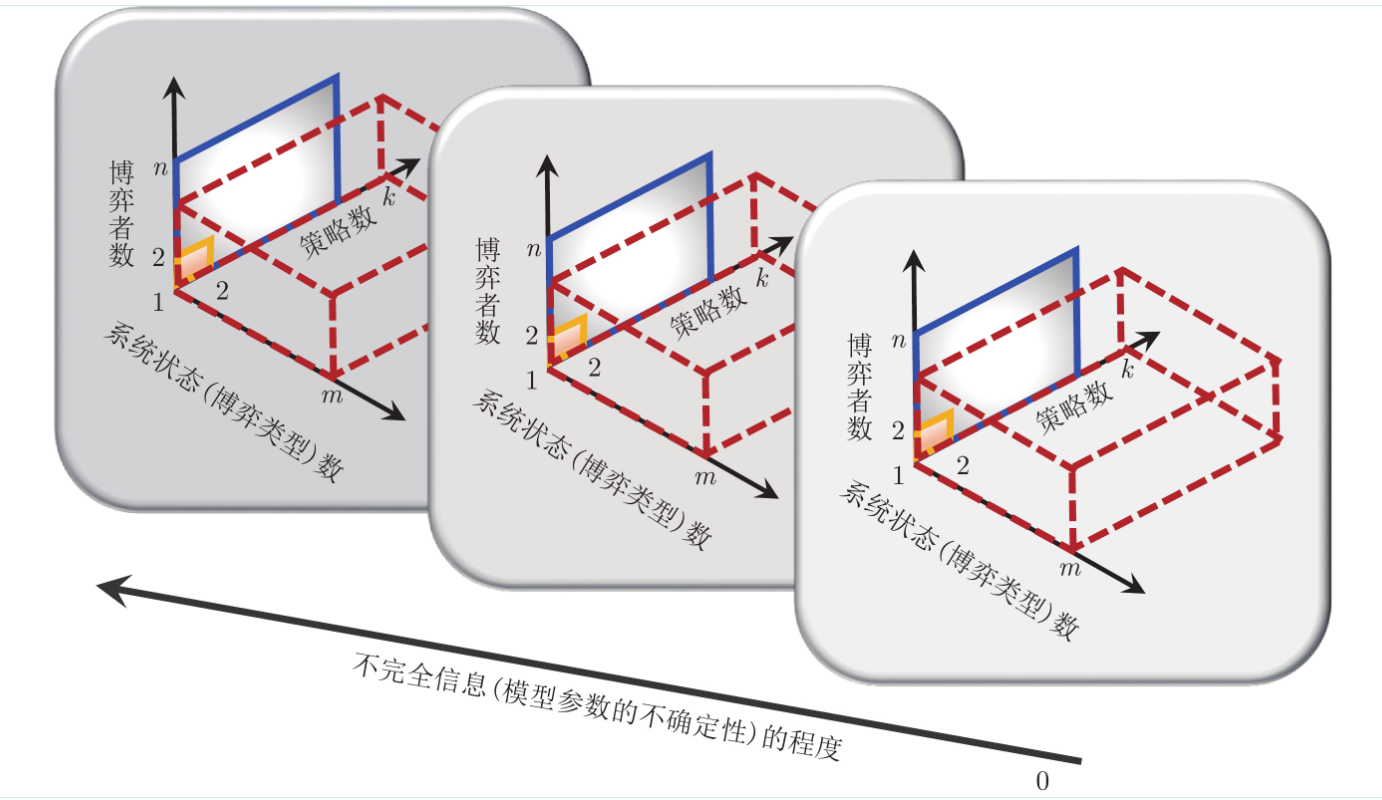

高维状态空间与策略空间爆炸。在多智能体博弈系统中,参与智能体的数量一旦增多,其整体状态空间与策略组合空间将呈指数级膨胀。例如,若每个智能体有\(n\) 种策略,\(m\)个智能体将产生 \(n^m\) 种策略组合。这一爆炸性的增长不仅导致计算开销极高,也使得传统的强化学习、Q-learning 等方法难以处理如此庞大的策略空间。此外,状态的高维复杂性也增加了策略估计和环境建模的难度,影响学习稳定性与收敛速度。

不完美信息环境下的策略稳定性。现实世界的博弈场景往往伴随着信息不完备或部分可观测的特性,例如网络入侵防御中的攻击者身份隐藏、金融市场中的隐性交易行为。这类博弈场景使得智能体难以获取完整状态,策略学习需依赖推测、估计与历史轨迹。在此情况下,即便存在最优策略,也往往难以学习或收敛到稳定解。此外,不完美信息还可能导致非理性行为的传播,破坏博弈的均衡结构和学习收敛性。

策略迁移与泛化能力不足。博弈智能的一项重要应用价值在于其能跨多个任务或环境完成策略迁移。然而,目前多数模型仍然依赖特定环境训练,缺乏泛化机制。当环境或博弈结构稍有变化,如参与智能体数量变动、支付函数变化或观测机制不同,原有策略便可能失效。尽管领域自适应、迁移学习、元学习等方法正在尝试解决该问题,但如何实现跨环境的稳健策略迁移仍是当前研究的重要难题。

多智能体非协同学习的收敛问题。在多智能体强化学习(Multi-Agent Reinforcement Learning, MARL)中,每个智能体在学习过程中都将其他智能体视为环境的一部分,而其他智能体的行为策略也在不断变化。这种“环境非定常性”使得策略更新过程极易震荡,甚至陷入永不收敛的循环。特别是在对抗博弈或零和博弈中,不同智能体目标相悖,更难实现系统性稳定收敛。此外,策略之间存在相互依赖,若缺乏有效的协同机制或通信通道,则可能出现资源浪费、任务冲突等现象,严重削弱系统效能。

5.2 关键技术趋势

在应对上述挑战的过程中,多个前沿交叉技术正逐步渗透入博弈智能系统,推动其迈向更高层次的智能协同、对抗与适应。

博弈与图神经网络(GNN)的结合。在多智能体交互结构复杂、关系动态变化的博弈场景中,图神经网络(Graph Neural Network, GNN)为建模提供了天然的结构性表达手段。GNN能够刻画智能体之间的博弈连接、资源依赖或影响力传播,适用于如社交网络、电力市场、交通系统等图结构环境。将GNN与博弈学习算法融合,可实现基于图结构的策略传播建模、局部影响计算和异质关系挖掘。例如,博弈图结构下的“邻接策略传播机制”能有效提升策略收敛速度,并增强策略的可解释性。

博弈强化学习与因果推理融合。传统博弈学习通常基于相关性进行策略估计,忽视了策略行为与结果之间的因果结构。而因果推理方法(如Do-Calculus、结构因果模型)可辅助智能体理解行动与博弈收益之间的因果关系,从而提升策略的鲁棒性与泛化能力。通过将因果推理嵌入博弈强化学习框架,智能体可在不完美信息下识别干预效果,进而优化行动策略。此外,因果推理还可解释策略失败的根因,有助于故障检测与系统调优。

博弈智能与大语言模型结合的可能性。以ChatGPT、GPT-4等为代表的大语言模型具备强大的语言理解、推理与生成能力,正在逐步拓展至博弈智能领域。通过语言模型对博弈策略、角色意图和对手行为的理解,智能体可实现自然语言驱动下的策略建模与互动。例如,人机对弈中语言模型可根据历史博弈过程自动生成对手建模框架、预测博弈发展方向甚至制定应对策略。此外,语言模型还可用于构建语言博弈场景(如谈判、协商),在文本输入驱动下模拟复杂博弈互动,有望在社会模拟、人机互动等领域实现突破。

自监督与元学习在多智能体博弈中的应用。自监督学习(Self-Supervised Learning)可在无标签数据中自动提取结构化信息,为策略学习提供额外的辅助信号。在多智能体博弈中,自监督机制可挖掘智能体行为序列中的隐含模式,提升策略估计效率。而元学习(Meta-Learning)则可使博弈智能体在多种博弈任务中积累“策略经验”,进而快速适应新博弈任务、应对突变环境。典型的“模型无关元学习”(MAML)机制可帮助智能体在少量迭代中迅速逼近最优策略,解决新环境策略初始化困难的问题。二者结合将极大增强博弈智能的任务适应性、策略迁移能力与泛化性。

6. 总结与未来展望

博弈智能作为人工智能发展中的关键一环,正成为连接博弈论、机器学习、认知科学与智能决策的交汇点。它不仅提供了解决复杂多智能体决策问题的理论工具,也为构建能够自主推理、适应协作与对抗的AI系统提供了技术路径。尤其在大模型时代与多智能体系统泛化部署趋势的推动下,博弈智能正逐步走出封闭对弈场景,进入智慧交通、网络安全、智能制造、能源博弈与社会系统等更具挑战性的实际环境中。

从研究范式看,博弈智能的发展愈发依赖多学科交叉融合。博弈论提供均衡性、理性行为与策略推导框架,人工智能提供深度学习、强化学习与自监督等策略学习工具,认知科学则使博弈系统更贴近真实个体行为模式。三者融合将催生出面向“类人智能”的博弈建模方法,使AI在社会系统、人机互动中的表现更加自然、稳健与高效。

在国家战略层面,博弈智能已被广泛视为人工智能自主决策、算法安全、战略模拟等关键场景的技术支柱。无论是在军事对抗、虚拟训练系统,还是在公共资源调度、智能治理与网络舆情干预中,博弈智能都具备强大支撑潜力。国家新质生产力体系建设亦高度依赖AI智能体的博弈协作能力,未来将在智能基础设施、数字经济与智慧社会中实现广泛部署。

展望未来,博弈智能的核心目标将不仅是“胜负决策”,而是实现跨智能体系统的稳定协作、长期博弈优化与复杂人机共生结构的建模。例如,面向智慧城市中的无人车博弈、人-车-基础设施三元对抗结构、或医疗协同诊断中的智能体间策略协调,都需要高阶博弈建模能力。同时,博弈系统的可解释性、公平性与可控性将成为构建可信AI系统的重要评价维度。

随着大语言模型、因果学习、图神经网络与元学习等技术的引入,博弈智能将在认知水平、泛化能力、环境适应性与策略透明性方面迈出关键一步。可以预见,未来的博弈智能系统将不仅限于规则定义的静态对抗,更将成长为能够与人类共谋共创、共享决策责任的智能协同体。

附录与延伸资源(可选)

附录A:典型博弈模型速查表

| 博弈类型 | 特征说明 | 示例应用 |

|---|---|---|

| 零和博弈 | 一方收益=他方损失 | 军事对抗、象棋 |

| 协同博弈 | 多方可达成共同最优 | 联盟组建、物流协同 |

| 不完美信息博弈 | 各方信息部分可观测 | 拍卖、市场竞争 |

| 重复博弈 | 同一博弈多轮次重复进行 | 长期贸易、外交博弈 |

| 演化博弈 | 策略随时间进化与适应 | 生物进化、社会模仿行为 |

附录B:博弈学习常用算法比较表

| 算法名称 | 学习方式 | 适用博弈类型 | 是否支持多智能体 |

|---|---|---|---|

| Q-learning | 值函数更新 | 零和博弈 | 有限支持 |

| Policy Gradient | 策略直接优化 | 协同/对抗博弈 | 支持 |

| DQN / Double DQN | 深度强化学习 | 离散状态空间博弈 | 有限支持 |

| MADDPG | 多智能体策略梯度 | 连续动作博弈 | 强 |

| AlphaZero | 蒙特卡洛+深度搜索 | 完全信息对抗博弈 | 强 |

参考文献

- Osborne, M. J., & Rubinstein, A. (1994). A Course in Game Theory. MIT Press.

- Shoham, Y., & Leyton-Brown, K. (2009). Multiagent Systems: Algorithmic, Game-Theoretic, and Logical Foundations. Cambridge University Press.

- Zhang, K., Yang, Z., & Başar, T. (2021). Multi-Agent Reinforcement Learning: A Selective Overview of Theories and Algorithms. Handbook of Reinforcement Learning and Control, Springer.

浙公网安备 33010602011771号

浙公网安备 33010602011771号