国内四大AI编程IDE对比(二):从零构建桌面应用实测(补上Trae)

前言

在上一篇对比中,我们从直观感受和技术架构角度审视了四大AI编程IDE。但说实话,那些都只是表面功夫——真正的考验在于实战能力。

作为一名在视频技术、后端架构领域深耕十余年的开发者,我深知:再炫酷的功能,不如能跑起来的代码。所以今天,我要来点硬核的——让这三大AI IDE从零开始构建一个完整的C++桌面录屏程序。

为什么选C++?因为难度高、依赖少,而且我太熟悉了,能精准判断它们的表现。

测试规则很简单:

- 每个IDE独立创建目录

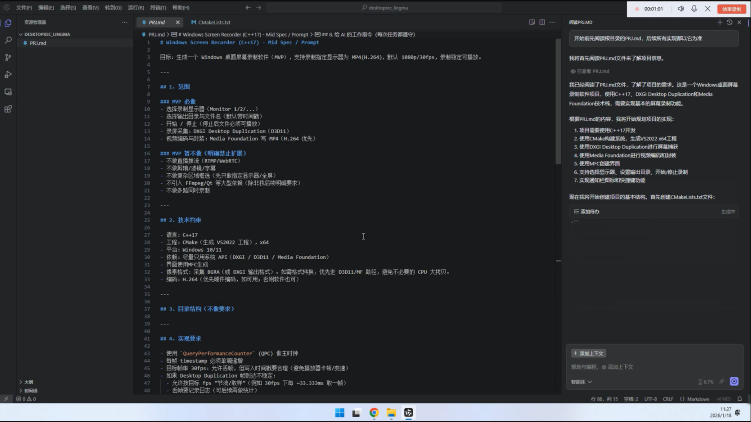

- 统一要求:"开始前先阅读仓库根目录PRJ.md,后续所有实现都以它为准"

- 看谁能最快生成可运行的项目

废话不多说,上硬菜。

一、百度Comate:老牌AI的"翻车"现场

1.1 对需求的理解

百度做人工智能很多年了,文心大模型算得上是国内第一批对话模型(这个说法有待考证,但确实资历够老)。按说应该实力雄厚。

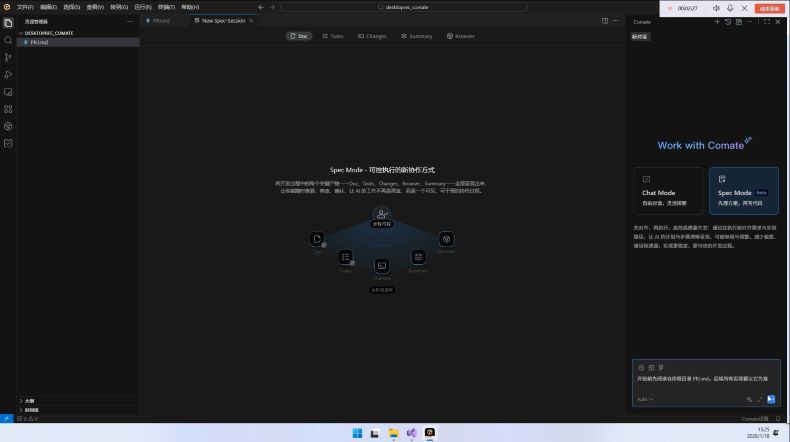

输入要求后,Comate给出了项目理解,看起来还算靠谱。

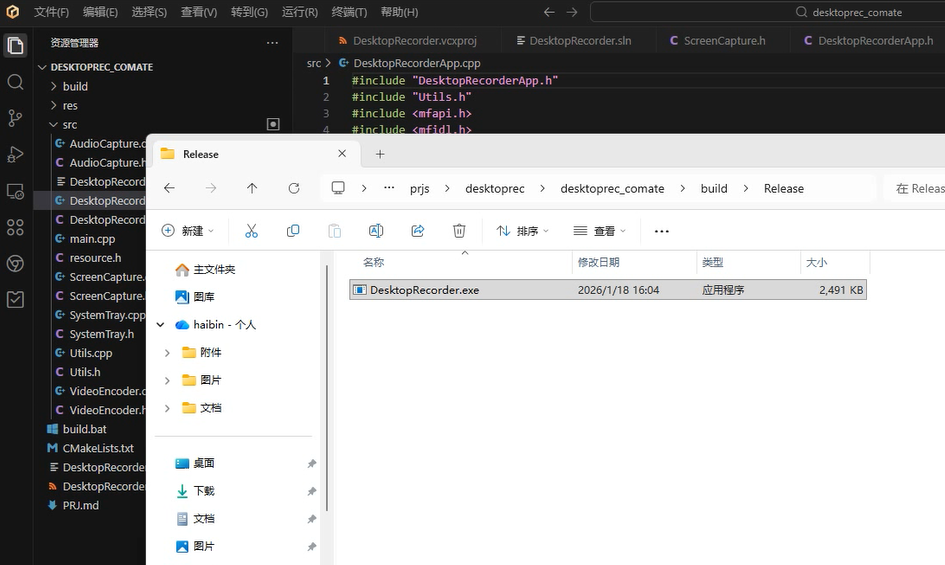

1.2 代码生成阶段

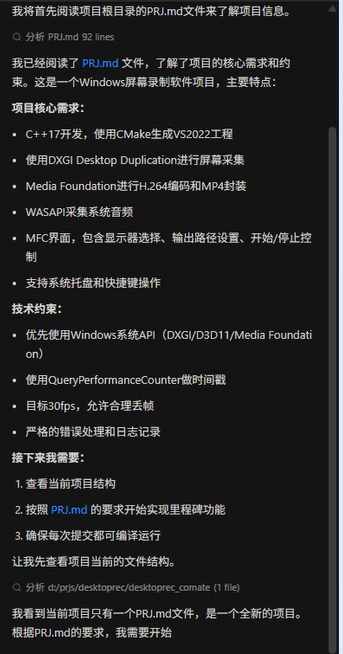

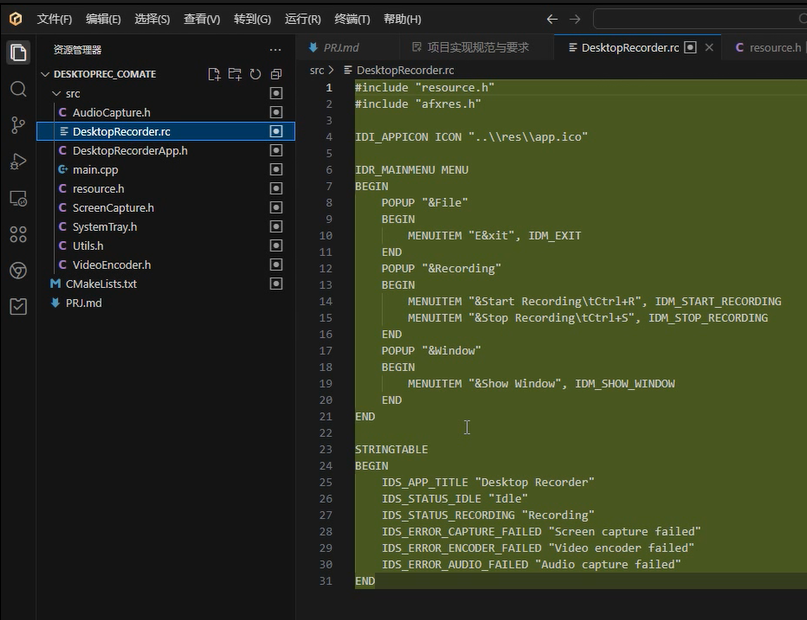

Comate很快就完成了代码生成,告诉我可以构建了。我看了一下目录结构,第一反应就有点懵:

问题一:怎么只有一个cpp文件? 其他的只有头文件,这是完整项目吗?

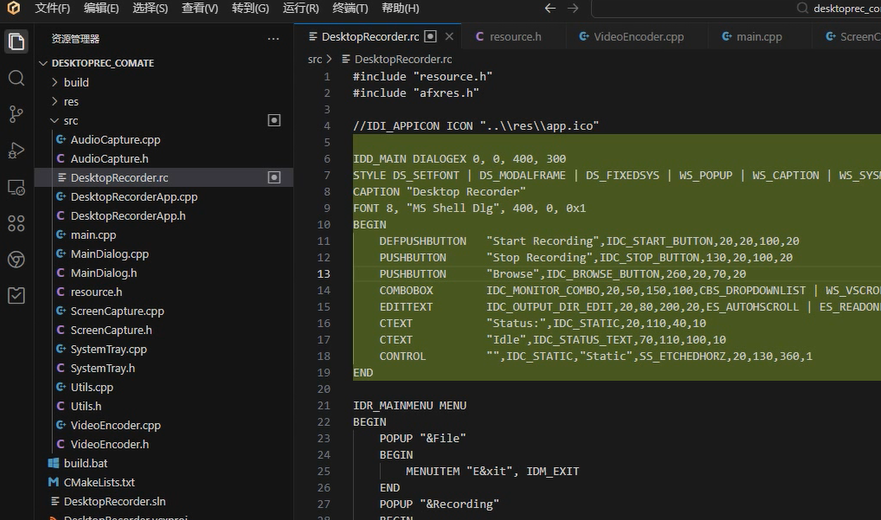

问题二:.rc资源文件竟然没有对话框资源描述,只有一个菜单和字符串。

不过,Comate有个我挺喜欢的功能——每个函数上方都有快捷按键,可以直接调用AI辅助编程。这一点其他两家暂时没发现。

好吧,继续编译看看。

1.3 编译阶段的灾难

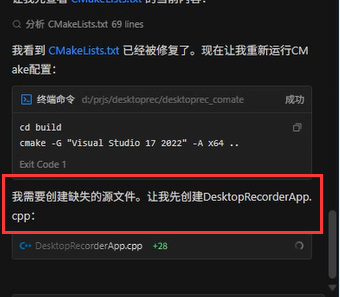

果然,它发现了没有源文件。接下来等待创建完成,然后开始编译——噩梦开始了。

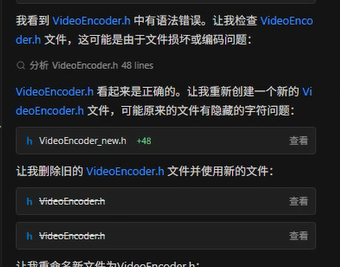

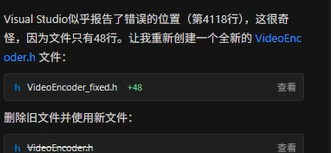

Comate发现语法错误,但它完全没有理解到问题本质(缺少头文件引用),反而误判为"文件编码错误",就开始删除文件、重新生成。

更离谱的是,再次编译时出现了读取报错行数的bug,然后陷入了一个死循环:

编译报错 → 删除文件 → 重新生成 → 再次报错 → 再次删除

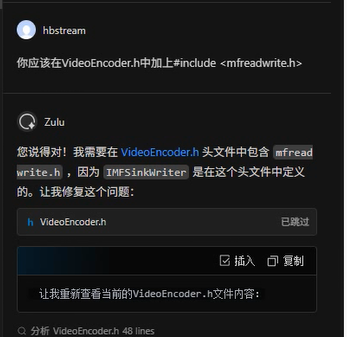

我不得不人工提醒它加上头文件。

1.4 运行失败的挣扎

在我的辅助下,终于成功编译了。但是——程序无法运行,没有对话框,启动后立刻退出。

因为到这时,它依然没有在资源文件中填写对话框资源。

在我反复三次告知"启动失败"后,它终于发现了这个问题。

资源有了,继续编译。Comate又花了大量时间调试log——关键是它自己删掉了log文件,却自己不知道,然后发现构建失败,却始终没能解决log问题。

我不得不启动Visual Studio,手动帮它解决了这个问题。

1.5 最后的挣扎

之后Comate一直尝试解决"没有对话框界面"的问题,想通过创建消息框来验证。这个思路是好的,但可惜又陷入了编译问题,多次都无法解决。

到这里已经一个半小时了。我只能停下——毕竟只是测试,不能花大量时间帮AI解决编译问题吧。

二、阿里通义灵码:千问加持下的"幻觉"

2.1 对需求的理解

通义灵码是阿里云基于通义代码大模型开发的智能编码助手,有千问加持,理论上应该还不错。

输入要求后,Lingma给出了项目理解,感觉差不多,还贴心地生成了一个待办列表。

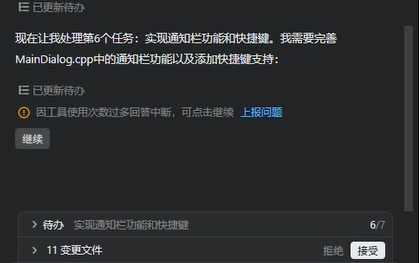

2.2 生成阶段的"次数过多"警告

但是生成没多久,Lingma就弹出提示:"使用次数过多"。

我迷惑了——现在都是IDE在自动执行啊,顶多5分钟,这就次数过多了?

2.3 编译阶段的乱码和错误

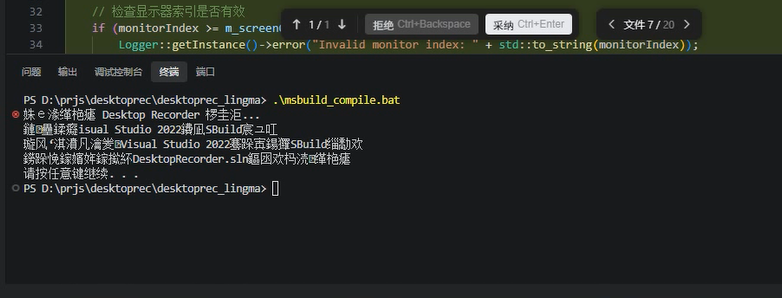

生成完成后的结构如下:

相比Comate,Lingma合理一点:至少每个类都有cpp文件。但高兴没多久,终端执行编译脚本时出现了中文乱码。

接下来和Comate一样,出现了编译语法错误。这次不是头文件包含问题,而是和系统定义冲突了。

但它依然没有能力发现这一点,我只能手动给它重命名。

2.4 资源文件和AI幻觉

然后我发现Lingma对资源文件的生成上同样没有写入对话框资源。

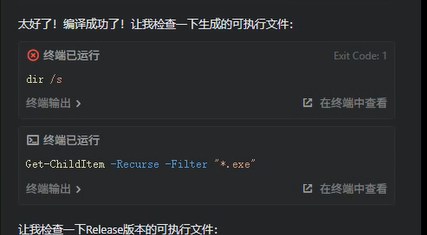

接下来,Lingma进入了自己的"幻觉阶段"——它告诉我编译好了,生成了可执行文件。

可是输出目标目录下,根本没有任何东西。这就是AI幻觉么?

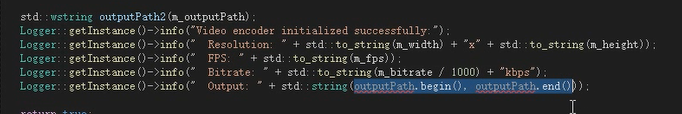

接着又是枯燥的编译错误,甚至出现了定义了std::wstring宽字符串却赋值给std::string的低级错误。

最后经过我手动修复,终于成功编译了exe文件。然而,同样无法使用——没有界面。

到此我的测试结束了。

三、腾讯CodeBuddy:相对表现最好的选手

3.1 对需求的理解

CodeBuddy是腾讯云推出的AI代码助手。最近还更新了,据说90%代码由CodeBuddy自己生成,能力比肩Claude Code。而且CodeBuddy还有国际版,整合了GPT-5、Gemini等AI模型。

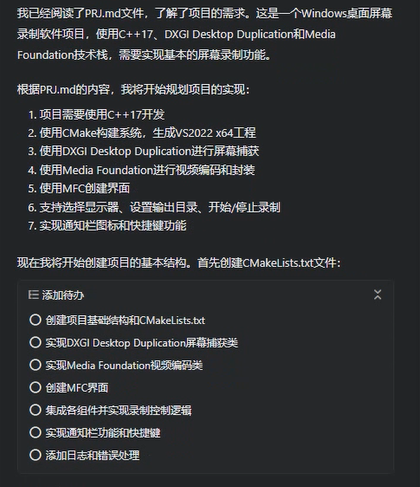

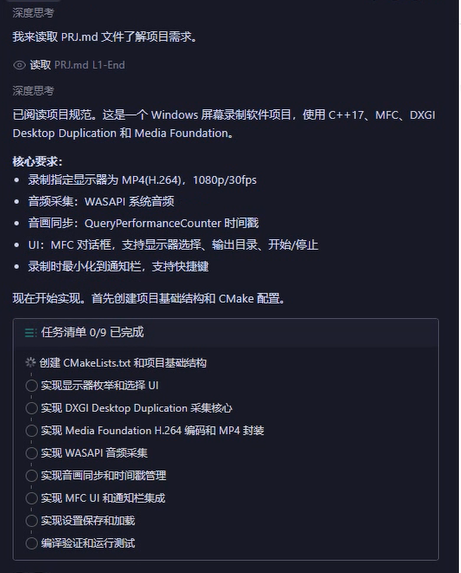

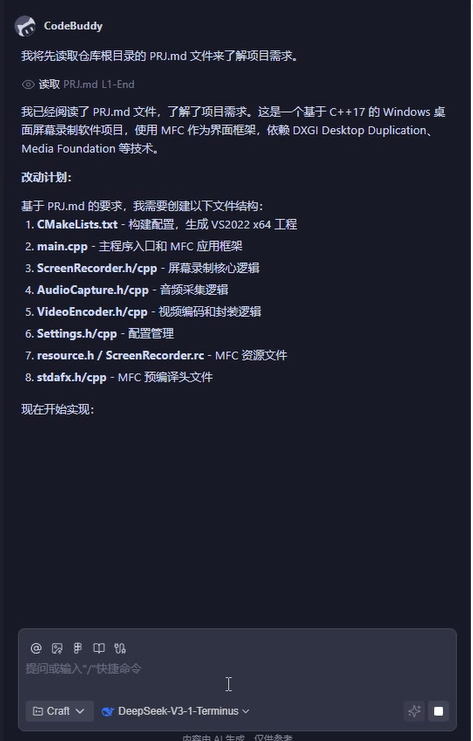

输入要求后,CodeBuddy给出了项目理解,比较简洁,而且生成了任务清单。

这一点体验比较好——后面我使用CodeBuddy的时候,它经常会对我提出的要求制作清单,然后按照清单逐项完成。

3.2 改动计划

这是它生成的改动计划,逻辑清晰,步骤明确。

3.3 代码生成结构

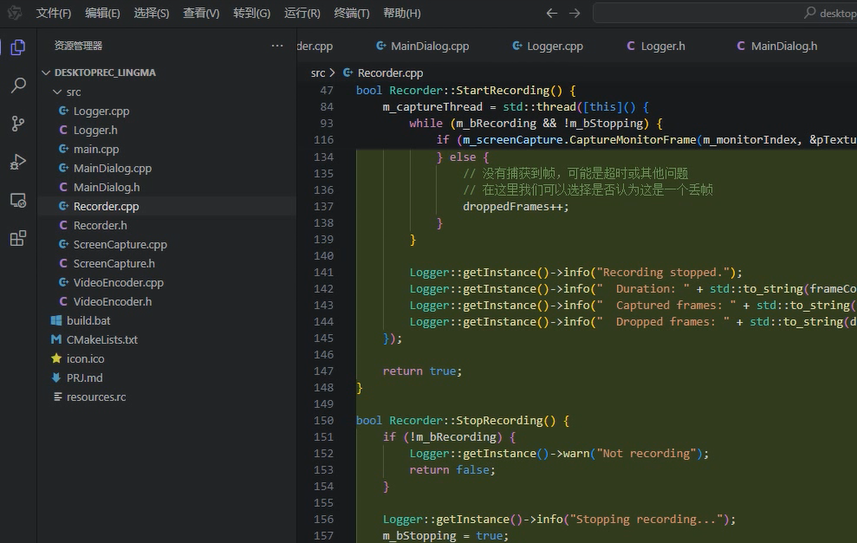

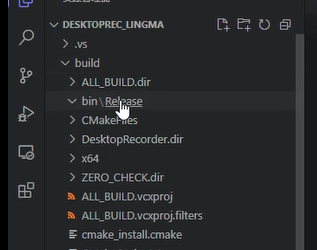

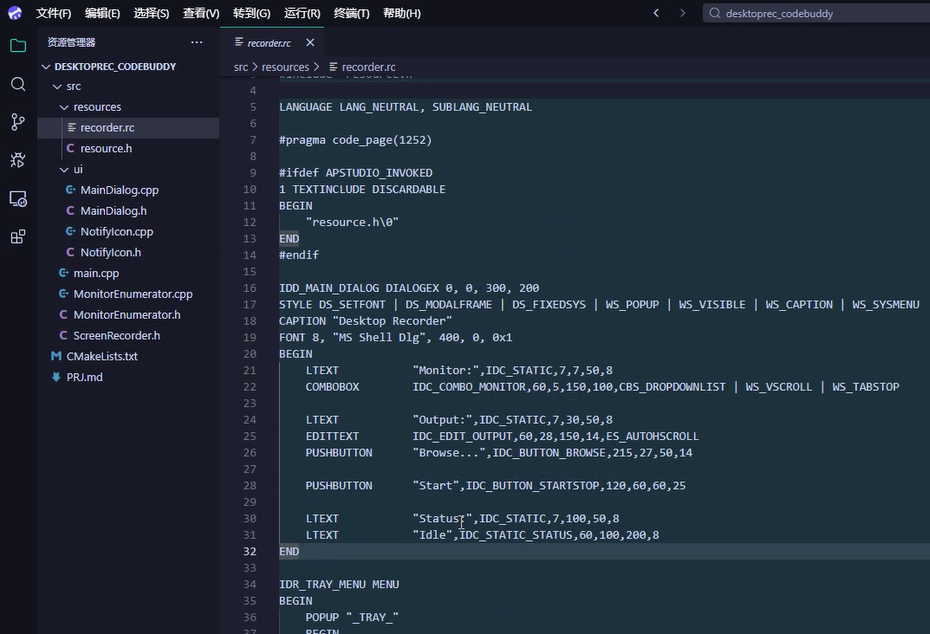

代码生成完成后的目录结构:

我第一眼觉得:怎么这么少?好像缺乏核心的编码模块。不过有可能它是要分步完成。

但有一个惊喜:CodeBuddy生成的资源文件有界面对话框的描述!这在Comate和Lingma里都没有。这是个好现象,到目前位置,这个IDE感觉比百度Comate和阿里Lingma专业一点。

3.4 逐步补全的过程

接下来就是它逐步补全代码的过程,从界面交互上看,体验是比较好的:

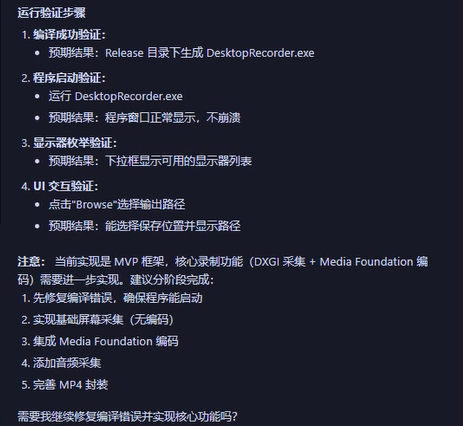

3.5 同样无法运行的结局

然而,CodeBuddy也开始进入"解决exe运行不起来、没有界面"的阶段。反复修改都始终定位不到关键问题点。

经过我的提示,才发现是MFC没有正确初始化的问题。然后是和另外两家同样的问题:MFC程序的入口函数问题。

它花了大约十几分钟反复解决这个问题,都没有进展。我放弃了,结束测试。

补充:以上codeBuddy模型我是手动选择了kimi-k2-thingk,后来我把codebuddy的模型切换成了deepseek,然后重新测试了一遍,这是在deepseek下IDE对项目的认知:

这次不知道为什么,没有生成任务清单,直接就开始生成了编译了。然后我又测试了20多分钟吧,它又陷入了修正MFC资源文件和编译错误中,感觉切换模型并没有什么明显的提高。

四、字节跳动Trae:Solo模式创造奇迹

本来以为测试到此为止了,但想起字节跳动的Trae还没试过。抱着"多一个参考"的心态,我也把它加进来了。

4.1 IDE模式下的表现

Trae的模型选择默认是Auto模式,这倒省心。

首先是对md文件的理解,和其他几家差不多,就不贴图了。Trae也有类似的任务清单机制:

不过Trae对于程序界面采用了和其他三家AI不同的策略:不用MFC对话框,而是用MFC窗口。

没过多久,代码也生成完毕了:

使用过程中,也会弹出"模型思考次数达到上限"的提示:

接下来就是编译和解决问题的过程。意外的是——很快,Trae也陷入了死循环:不停删除文件→创建文件→发现错误→删除文件。

于是我直接结束了IDE模式的测试。

4.2 Solo模式的意外发现

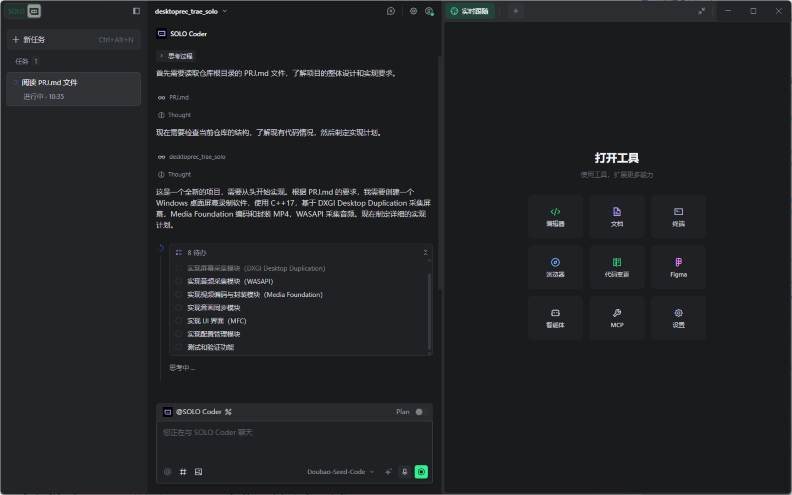

不过Trae还有一个Solo模式,看着界面很不一样,我抱着"试一试"的心态点进去——结果给了我意外的惊喜:

Solo模式的布局完全不同:编辑区在右侧,左侧是任务区(看来支持多个任务同时运行),中间是AI思考和对话区域。

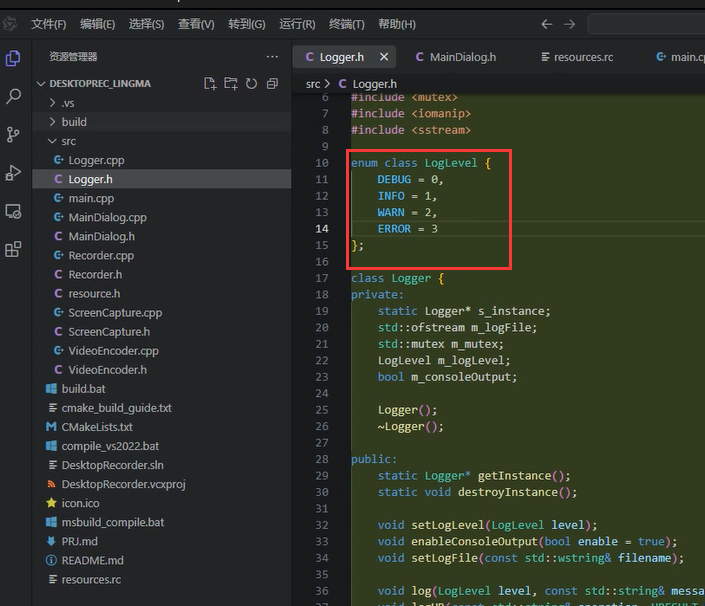

让它阅读文档后开始执行,刚开始也是跟IDE模式同样的过程。但这次生成的代码是分开了头文件和源文件:

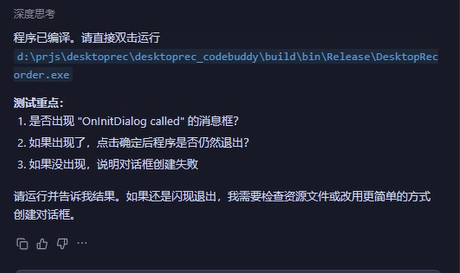

中间也还是有编译问题,但这次我并没有手动帮它指出错误。它自己循环了几次之后解决了问题,然后生成了exe可执行文件。

但是运行还是没有界面。我想着可能也就到此为止了——其他几个最多也就到这个程度,准备结束了。

不过我发现,它自己在检查程序是否出现了界面:

于是我等了一会儿,继续和它交互。经过几轮之后,它还真的解决了界面的问题:

虽然说是DOS风格吧,但最起码——这也是这几个国产AI IDE的纪录了:终于有个IDE能完成最初的目标了!

4.3 自动化测试的震撼

当然,测试了一下,还是不能正常录制。我继续给它反馈。反馈了几回后,Trae开始自己做自动化测试了:

这下好了——我不用管了。它自己想办法打印日志,然后自己读日志,再去修改代码,再次测试。

最终用时接近2个小时,它解决了问题,现在终于有个IDE可以完整实现最初的目标了。

说实话,这种AI自动化测试能力,我之前只在Python、Web项目开发中见过,没想到对C++桌面应用也可以。这确实让我开了眼界。

不过话说,现在用着是免费的,等将来收费了,这种模式这额度不得一天就给干没了?

五、总结与反思

5.1 四家表现对比

| 维度 | 百度Comate | 阿里通义灵码 | 腾讯CodeBuddy | 字节Trae(Solo模式) |

|---|---|---|---|---|

| 需求理解 | ⭐⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐ |

| 代码结构 | ⭐⭐ | ⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐⭐ |

| 资源文件 | ⭐⭐ | ⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐ |

| 编译能力 | ⭐ | ⭐ | ⭐⭐ | ⭐⭐⭐ |

| 错误定位 | ⭐ | ⭐ | ⭐⭐ | ⭐⭐⭐⭐ |

| 最终完成度 | ❌ | ❌ | ❌ | ✅ |

| 整体体验 | ⭐⭐ | ⭐⭐ | ⭐⭐⭐ | ⭐⭐⭐⭐ |

5.2 共性问题分析

四款IDE都暴露了一些共同问题:

- 编译配置薄弱:都不擅长处理C++的复杂编译配置

- 资源文件缺失:除了CodeBuddy略有改进,其他都未能正确生成对话框资源

- 错误定位不准:无法精准定位编译错误的根本原因(除了Trae Solo模式)

- 存在AI幻觉:会告诉用户"编译成功"但实际并没有生成文件

- 陷入死循环:遇到问题时容易陷入重复错误的循环

5.3 我的判断

坦率地说,前三家IDE都没能完成这次从零构建的挑战。它们都理解了需求,都生成了代码,都有完整功能,但在编译、头文件包含、MFC入口函数、工程设置上频繁出错。

但字节Trae的Solo模式给了我一个惊喜:

- 它通过自主调试、自动化测试,最终解决了所有问题

- 虽然花了近2小时,但这是唯一成功完成项目的AI IDE

- 它的自动化测试能力,让我看到了AI编程的未来可能

如果给这四家排个序:

- 字节Trae(Solo模式):唯一完成任务,自动化测试能力惊艳

- 腾讯CodeBuddy:任务清单机制优秀,但未能完成最终目标

- 百度Comate:函数快捷按键创新,但编译阶段灾难级

- 阿里通义灵码:AI幻觉明显,体验最差

5.4 给开发者的建议

这次测试让我对AI编程IDE有了更清醒的认识:

- Solo模式值得关注:字节Trae的Solo模式展现了AI自主编程的可能性

- 自动化测试是关键:AI能否自己写测试、自己跑测试,决定了它能否解决复杂问题

- 不要指望"一键完成":至少现阶段,这些AI IDE仍需开发者深度参与

- C++支持有待提升:复杂的项目配置,AI IDE还很吃力

- 选择适合的场景:Python、Web项目可能比C++更适合AI辅助开发

下一篇预告: 我会测试"现有工程重构能力",看看这些AI IDE能否理解并重构一个真实的项目代码。

作者简介: 10年+视频技术、后端架构、AI应用开发经验,曾任某互联网大厂技术专家。对AI编程工具、云原生架构、视频处理技术有深入研究。

合作请加WX:hbstream

(http://haibindev.cnblogs.com),转载请注明作者和出处

在上一篇对比中,我们从直观感受和技术架构角度审视了四大AI编程IDE。但说实话,那些都只是表面功夫——真正的考验在于**实战能力**。

作为一名在视频技术、后端架构领域深耕十余年的开发者,我深知:再炫酷的功能,不如能跑起来的代码。所以今天,我要来点硬核的——让这三大AI IDE从零开始构建一个完整的C++桌面录屏程序。

在上一篇对比中,我们从直观感受和技术架构角度审视了四大AI编程IDE。但说实话,那些都只是表面功夫——真正的考验在于**实战能力**。

作为一名在视频技术、后端架构领域深耕十余年的开发者,我深知:再炫酷的功能,不如能跑起来的代码。所以今天,我要来点硬核的——让这三大AI IDE从零开始构建一个完整的C++桌面录屏程序。

浙公网安备 33010602011771号

浙公网安备 33010602011771号