https://mp.weixin.qq.com/s/TH24qu1fDlMkRSr4e8z7zw

《导航定位与授时》2025年第3期封面文章由北京自动化控制设备研究所尚克军研究员等完成。

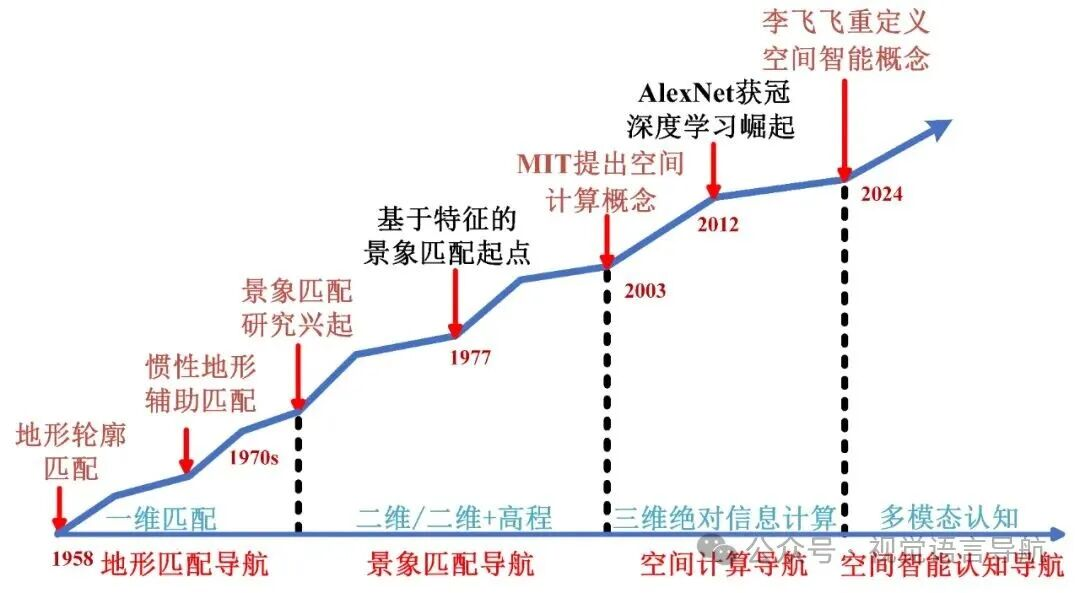

视觉导航对于飞行器的自主性和智能化发展具有重要意义。随着各类技术特别是人工智能技术的飞速发展,飞行器视觉导航进入了一个新的时代。通过分析飞行器视觉导航的演进历程及其在不同发展阶段的技术特点和应用,揭示飞行器视觉导航的发展趋势和发展重点。根据输入信息和输出导航参数的特点,此封面文章将飞行器视觉导航技术的发展分为地形匹配导航、景象匹配导航、空间计算导航和空间智能认知导航四个阶段,重点归纳整理了各阶段具有代表性的导航方式、信息处理特点及应用情况,简要介绍了团队在飞行器空间计算导航方面的研究。讨论了当前视觉导航与人工智能融合情况,并对后续发展进行了展望,随着数据不断积累、算法持续迭代、端侧算力不断提升,未来,基于空间大模型的“空间智能认知导航”,也许能“让飞行器像人一样导航”,开辟一种全新的飞行器自主导航方法,为极端环境下飞行器的自主决策与复杂任务执行提供有力支撑。关键词:飞行器视觉导航;地形匹配导航;景象匹配导航;空间计算导航;空间智能认知导航论文标题:飞行器视觉导航新时代——从地形匹配到空间智能论文作者:尚克军,黄承林,徐策,明丽,赵亮,张伟建作者单位:北京自动化控制设备研究所;北京理工大学自动化学院引用格式:尚克军,黄承林,徐 策,等. 飞行器视觉导航新时代——从地形匹配到空间智能[J]. 导航定位与授时,2025,12(3):1-14.

视觉主导了人类约80%的信息获取,是人类认知世界的核心,视觉导航是人类的主要导航方式。因此,学者们长期致力于研究如何用机器模拟人类实现视觉导航,即机器视觉导航。

通常机器视觉导航可按人类的视觉导航过程(见图1)抽象为4个环节(见图2):成像、感知、认知和导航参数计算。在成像环节,通过视觉传感器以图像或者视频的方式采集环境信息;在感知环节,通过算法提取图像的显/隐式特征;在认知环节,将提取的特征与已有知识(先验数据、历史信息或某种规律)进行比对,获取两者相似性;在导航参数计算环节,基于相似性通过几何模型计算载体的导航参数,在很多场合,此环节还包含引导载体到达目的地。

机器视觉导航(以下简称视觉导航)起步于20世纪60年代,2000年左右在工业领域被广泛应用,进入稳定发展期。2015年前后,人工智能(artificial intelligence,AI)的发展推动了视觉导航的新发展,视觉导航凭借其高精度、强自主和低成本等优势,为机器人、无人车等载体提供了高效的导航方案,特斯拉辅助驾驶系统采用的视觉导航技术便是杰出代表。然而,受到端侧算力、算法规模、飞行环境及传感器能力等因素的制约,飞行器视觉导航发展一直受限。近年来,随着硬件性能的提升与算法轻量化的发展,飞行器视觉导航技术开始加速发展。该技术在室内无人机的检测和避障方面表现优异。特别是视觉导航与惯性导航深度融合后,能更好地应对环境变化,为飞行器提供实时、连续的高精度导航信息。这确保飞行器在很多情况下正常完成任务,展现出了巨大的发展潜力。结合AI的发展浪潮,该技术未来可能表现出更强大的综合性能。在此背景下,有必要回顾飞行器视觉导航发展历程,厘清不同方式的技术本质,探讨其未来发展趋势与重点。根据输入信息和输出导航参数的特点,本文将飞行器视觉导航划分为四个阶段:地形匹配导航、景象匹配导航(scene matching navigation, SMN)、空间计算导航和空间智能导航,如图3所示。

1 萌芽: 地形匹配导航

地形匹配导航源于1958年提出的指纹导航(fingerprint navigation,FN),基于采集到的一维地形高程信息,与高程数据库进行匹配,以获取对应区域的二维水平位置。该技术虽然只是一种位置修正技术,无法直接提供速度、姿态等信息,需与惯导联合使用,但其不依赖外部信号,隐蔽性好,可在无全球定位系统(global positioning system,GPS)或其他外部导航信号的环境中工作。

地形匹配导航的原理与使用视觉景深信息进行定位类似,但该信息通过无线电高度表测量获得,严格来说并不属于视觉导航。不过,在地形匹配的研究中,学者们首次系统性提出了“预存数字地图与实时传感器数据匹配”的导航架构,为后续景象匹配、空间计算等飞行器视觉导航技术的发展奠定了基础,因此被视为近代飞行器视觉导航技术的雏形。

地形匹配导航早期主要是地形轮廓匹配(terrain contour matching, TERCOM)导航,后来逐渐发展出桑迪亚惯性地形辅助导航(Sandia inertial terrain-aided navigation,SITAN)。

1.1 地形轮廓匹配导航

美国空军将指纹导航更名为地形轮廓匹配导航后,其很快被应用于巡航导弹的辅助制导,并逐渐发展成为一种可靠而准确的导航方法。

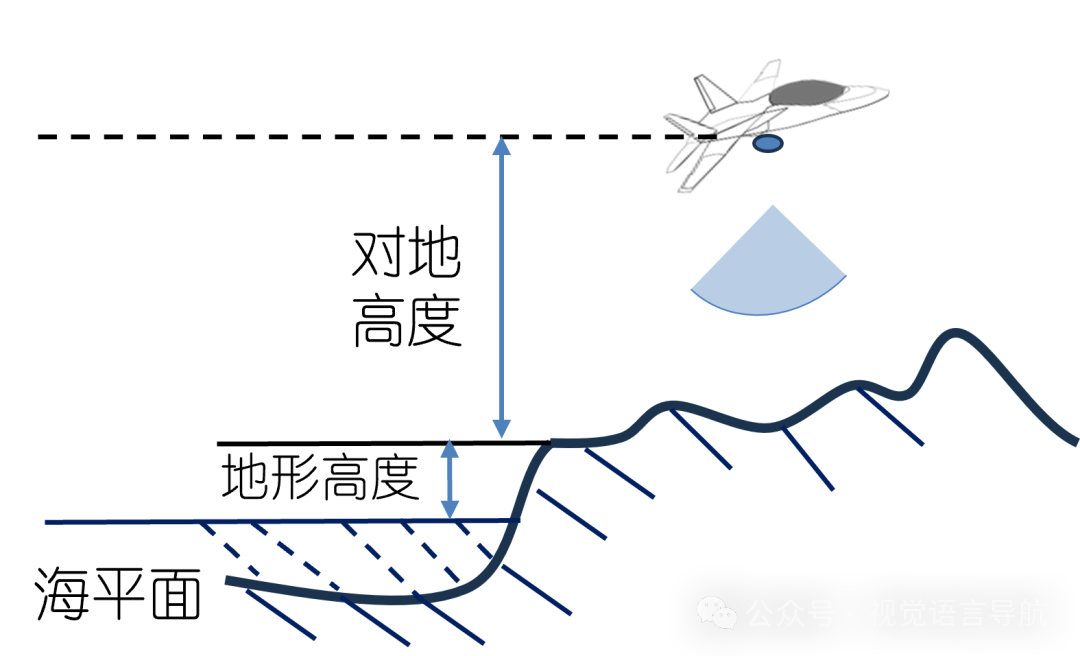

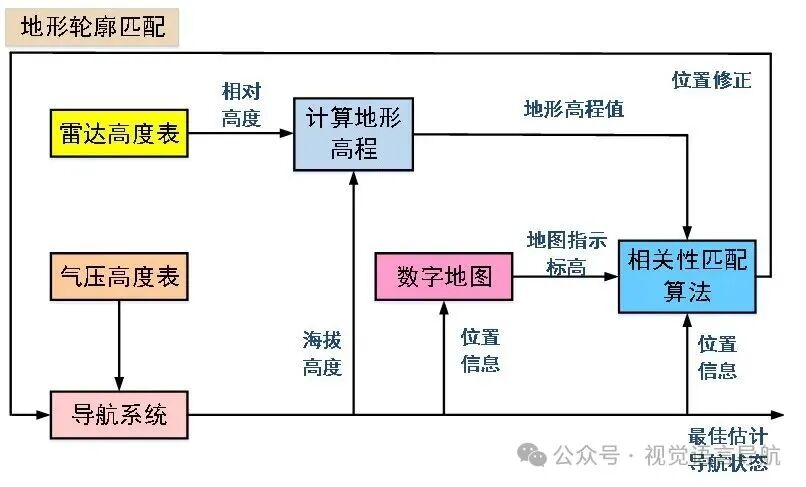

地形轮廓匹配导航利用飞行器高度表测得的相对高度,与海拔高度相减获得地形高度,然后将其与数据库中的数字高程进行比对,基于批处理相关的搜索算法(如平均方差算法、平均绝对差算法及交叉相关算法)实现遍历,获取该地形高度对应的平面位置信息,定期对惯导进行校准,以消除惯导累积误差。地形轮廓匹配导航的测量参数和工作原理如图4和图5所示。

遍历搜索算法导致地形轮廓匹配导航实时性较差,为此学者们研究了大量的优化算法。同时,为了降低匹配难度,任务中飞行器必须尽可能沿预先规划的路径飞行,但依旧无法解决长距离飞行后惯导误差过大导致高程匹配失败的问题。在地形高程变化缓慢的平坦区域,地形轮廓匹配导航不能确保水平位置求解的唯一性,导致惯导校准效果不佳。

1.2 桑迪亚惯性地形辅助系统

为克服地形轮廓匹配导航的局限性,20世纪70年代,美国Sandia实验室的Hosterler提出了桑迪亚惯性地形辅助导航。

桑迪亚惯性地形辅助导航在地形轮廓匹配导航的基础上引入了地形斜率,通过考虑地形变化增加求解约束,提高了地形相对平坦地区的可求解性,但这需要引入更复杂的惯性导航误差校准方法。因此,学者们将主要研究方向集中于惯性/高程扩展卡尔曼滤波技术,旨在实现短距离高精度实时修正,并持续进行改进。这提升了飞行器在地形相对平坦地区的表现,提高了导航精度,也在一定程度上放宽了飞行路径限制,增强了机动性。

通常地形匹配导航在航线较为固定的飞行器上应用,最早以1958年美国装备的“马斯”巡航弹为代表,其圆概率误差在百米量级。在20世纪70~80年代研制的中远程巡航导弹中,该技术得到了广泛应用,如美国“战斧”系列的BGM-109A/G等导弹,其典型的圆概率误差约为30m。1991年海湾战争和2003年伊拉克战争2次实战证明了地形匹配导航技术的实用性,但也暴露出其固有的局限性。当前地形匹配在飞行器上的应用日渐稀少,但在水下运载体上,海底地形匹配导航正在兴起,如文献[12]、文献[14]和文献[17-18]的工作。

2 成长: 景象匹配导航

景象匹配导航从20世纪70年代开始发展,基于飞行器上的相机获取地物图像,与地图数据库进行匹配,从而获得载体的二维水平位置。该技术采用航拍图像与基准图像进行匹配,改变了地形匹配基于高程信息获取水平位置的局限性,在特征显著区域的定位能力优于地形匹配导航。景象匹配导航的关键在于图像匹配算法,因此,学者们将研究重点聚焦于提升图像匹配的精度与鲁棒性。

早期的景象匹配导航按匹配算法可分为2大类:基于模板的景象匹配导航和基于几何特征的景象匹配导航。随着AI的崛起,又出现了基于深度学习的景象匹配导航技术。

2.1 基于模板的景象匹配导航

基于模板的景象匹配导航源于美国海军航空电子设备中心开发的景象匹配区域相关器(scene matching area correlation, SMAC)。自1978年SMAC在“战斧”导弹上飞行测试成功后,该技术便开始成为研究重点。很快,基于模板的景象匹配导航在飞行器末制导中展现出巨大价值。

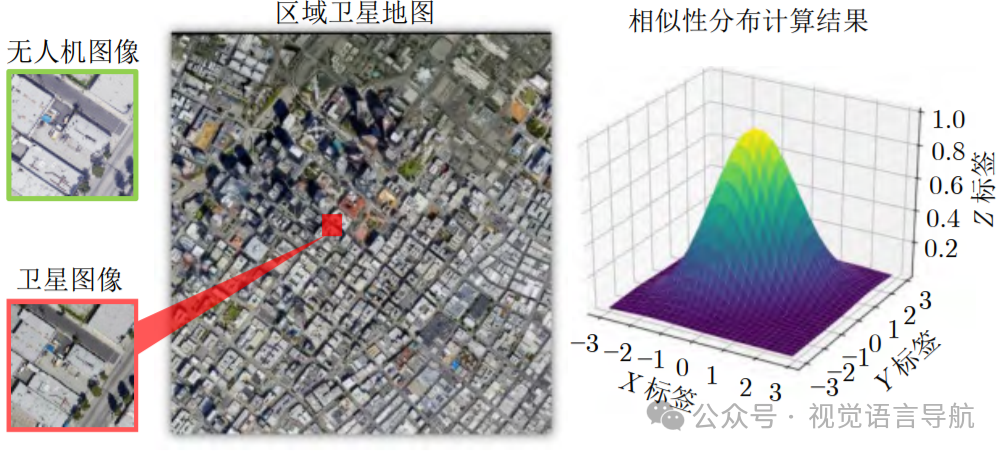

基于模板的景象匹配导航通过滑动模板与基准图计算重叠区域的相似性,利用绝对误差和、互相关法等实现图像匹配。例如:绝对误差和方法将实拍目标区域图像与基准图进行逐像素比对,通过误差累加值判断是否匹配成功;互相关法则基于窗口区域与匹配模板的相似度以确定两幅图像之间的对应关系,如图6所示。图像匹配成功后,基于图像之间的变换关系,计算出飞行器的二维定位结果。该技术在光照稳定和静态场景下,导航误差可控制在米级。

2 成长: 景象匹配导航

景象匹配导航从20世纪70年代开始发展,基于飞行器上的相机获取地物图像,与地图数据库进行匹配,从而获得载体的二维水平位置。该技术采用航拍图像与基准图像进行匹配,改变了地形匹配基于高程信息获取水平位置的局限性,在特征显著区域的定位能力优于地形匹配导航。景象匹配导航的关键在于图像匹配算法,因此,学者们将研究重点聚焦于提升图像匹配的精度与鲁棒性。

早期的景象匹配导航按匹配算法可分为2大类:基于模板的景象匹配导航和基于几何特征的景象匹配导航。随着AI的崛起,又出现了基于深度学习的景象匹配导航技术。

2.1 基于模板的景象匹配导航

基于模板的景象匹配导航源于美国海军航空电子设备中心开发的景象匹配区域相关器(scene matching area correlation, SMAC)。自1978年SMAC在“战斧”导弹上飞行测试成功后,该技术便开始成为研究重点。很快,基于模板的景象匹配导航在飞行器末制导中展现出巨大价值。

基于模板的景象匹配导航通过滑动模板与基准图计算重叠区域的相似性,利用绝对误差和、互相关法等实现图像匹配。例如:绝对误差和方法将实拍目标区域图像与基准图进行逐像素比对,通过误差累加值判断是否匹配成功;互相关法则基于窗口区域与匹配模板的相似度以确定两幅图像之间的对应关系,如图6所示。图像匹配成功后,基于图像之间的变换关系,计算出飞行器的二维定位结果。该技术在光照稳定和静态场景下,导航误差可控制在米级。

飞行器上通常配备红外相机或者合成孔径雷达(synthetic aperture radar, SAR),而基准图通常为可见光图,因此需要解决图像异源匹配问题。于是,出现了基于相位相关的方法,将原图从空间域转换到频域进行匹配,以解决异源匹配问题并提高计算效率。针对飞行器上常见的光照强度变化影响其导航性能的问题,文献[28-31]对归一化互相关算法进行研究,以使其在光照变化条件下仍能实现稳健匹配,但该算法的效果仍然易受天气和噪声等因素影响。为此,相关学术研究转向了鲁棒性更强的互信息法,尝试通过统计图像相关性实现相似性度量,以适应异源图像匹配。

尽管基于模板的景象匹配导航存在易受拍摄视角影响,对光照变化、局部遮挡及突发场景变化(如自然灾害)敏感等一系列问题。但它仅通过机载传感器和预存基准图即可提高自主导航精度,具有不依赖其他外部信号的优势。20世纪80年代初,美国很快就将其应用于导弹巡航段。

随后,在20世纪90年代至21世纪初,各国开始在巡航导弹和战术导弹上采用基于模板的景象匹配导航技术,如美国的“战斧”BGM-109C/D、俄罗斯的“口径”X-101/102等。采用这种技术的导弹圆概率误差在10 m量级,可直接用于精准打击固定军事目标。在1991年的海湾战争中,首次使用该技术的“战斧”Block II型BGM-109C/D导弹,在全自主导航的情况下,命中率高达95%。

2.2 基于几何特征的景象匹配导航

为了改善景象匹配在光照变化、遮挡、尺度变化及旋转等情况下的表现,以更好地满足飞行器导航的需求。研究者开始尝试对模板匹配方法进行革新,于是出现了基于几何特征的景象匹配导航,其思想是提取实时图和基准图的一系列局部特征进行匹配,以提高复杂环境下景象匹配的鲁棒性和计算效率。

美国国家航空航天局(National Aeronautics and Space Administration, NASA)的Moravec教授首次提出了特征点提取方法,其“兴趣点”检测方法为基于几何特征的景象匹配导航的发展作出了开创性的贡献。随后这方面的研究日新月异,局部特征匹配方法不断得到完善,部分里程碑的研究如图7所示。

图7 基于几何特征检测的经典算法

其中,Harris算法改进了Moravec算法,首次实现了方向不变性;尺度不变特征转换(scale invariant feature transform, SIFT)算法首次基于高斯差分金字塔实现了几何特征的尺度和旋转不变性;方向梯度直方图(histogram of oriented gradient, HOG)算法实现了线特征的匹配,开创了基于局部形状检测物体的范式;加速稳健特征(speeded up robust features, SURF)算法首次采用积分图像方法加速计算,其计算速度较SIFT提升了约3倍,满足了飞行器视觉导航对计算速度的需求;FAST(features from accelerated segment test)算法首次提出了二进制角点检测准则,在角点检测方面表现出色,计算复杂度低,更适合实时处理;ORB(oriented FAST and rotated BRIEF)算法首次融合了方向敏感的FAST与旋转不变的BRIEF(binary robust independent elementary features),提供了稳定且更强的实时匹配能力等。

这些方法都具有代表性,但也各有优缺点。此外,各种方法对应的特征描述子通常需组合使用。而描述子的快速增加导致在飞行器上难以实时计算,特别是传统浮点型描述子(如文献[38-41]所述)的计算复杂度很快成为瓶颈,因此出现了二进制描述子以降低运算量。

在飞行器上的相关研究也在持续深入。例如:文献[45]为满足多模态景象匹配的需求,使用了改进的SIFT特征;文献[46]通过提取谷歌地图与无人机实拍图像的HOG特征,实现了景象匹配;文献[47]和文献[48]基于SIFT特征分别对景象匹配的匹配精度和尺度适应性开展研究;文献[49]和文献[50]使用SURF特征实现了基于SAR图像的景象匹配,提高了实际场景下的匹配速度和精度;文献[51]使用多描述子优化将惯性测量单元(inertial measurement unit, IMU)与视觉信息进行融合,实现了无卫星信号情况下的飞行器导航参数估计。

但无论如何变化,以上方法都需要基于先验知识定义特征(如梯度、角点),依赖手工设计特征(如SIFT,ORB,HOG等),基于特征点之间的几何关系描述相似性,再制定明确的匹配规则。实际使用时操作繁琐,受环境影响大,使用限制多。

经过作者团队大量的试验比对发现,使用上述方法在不刻意约束飞行器运动场景的前提下,图像匹配成功率一般不超过35%。光照、噪声、地物色彩变化及尺度变化均会显著影响结果。同时,由于缺乏定量的相似性表达,即便图像匹配成功,对惯导的校准也需要极为谨慎。在无专用预制图、无规定匹配区等保障能力较弱的场合,可用于惯导校准的图像比例不足20%。这一时期又恰逢卫星导航飞速发展并规模化应用,其精度和覆盖范围远超视觉导航,因此面向应用研究较多而实际应用较少,飞行器视觉导航技术应用逐渐式微。

2.3 基于深度学习的景象匹配导航

2015年,深度学习算法在ImageNet数据集上取得了重大突破,残差网络ResNetTop-5的识别准确率达到了96.43%,首次超过了人类专家(识别精度约94.9%)。深度学习算法使图像识别由“像素比对颜色概率统计背景主导”走向“深度学习语义理解内容主导”,“跨越了语义鸿沟”。

自文献[53]基于深度学习实现图像匹配后,相关研究呈爆发式增长,研究重点也逐渐转向探讨深度学习在飞行器景象匹配导航中的应用。部分里程碑性质的研究如图8所示。

图8 基于深度学习的图像匹配算法

其中,SuperPoint算法首次实现了自监督训练,使用预训练后的网络仅需较少的计算资源就可以完成特征提取,为景象匹配奠定基础,比较适用于飞行器;D2-Net算法颠覆了“先检测后描述”的图像匹配步骤,建立了一种景象匹配算法的新方式;基于Transformer的无检测器局部特征匹配(detector-free local feature matching with transformers)算法首次将Transformer架构引入无检测器的密集匹配,能在弱纹理和相似度极高的区域实现高质量匹配;Swin-Transformer算法改进了Transformer架构,首次在视觉模型中构建层级化窗口注意力机制,以实现对复杂场景的高效理解和表达;分割匹配法(matching everything by segmenting anything,MESA)基于先进的图像分割模型,实现了基于语义的区域匹配;鲁棒密集特征匹配(robust dense feature matching,RoMa)算法提供了一个定制的Transformer匹配解码器,突破了传统方法在跨模态匹配中的瓶颈。

飞行器上的应用研究也在开展。例如:文献[61]通过SuperGlue网络获得航拍图像和谷歌地图之间局部特征的对应关系,从而实现无人机导航;文献[62]优化了SuperPoint算法,提高了特征提取的稳定性,并将其用于无人机导航;文献[63]对SuperPoint算法的尺度适应性和Transformer算法的多头注意力机制部分开展研究;文献[64]使用SuperPoint和SuperGlue算法,实现了基于商业地图的无人机导航。

深度学习对飞行器景象匹配导航而言,不仅可以提高图像匹配精度,更重要的是可以通过端到端学习直接预测匹配关系。此外,还可以结合注意力机制、图神经网络等方法自动学习多层级特征并进行“内容级”的匹配,包括过去的边缘、角点和现在的图像语义等。这可以很好地应对更加复杂的环境,例如光照、季节、遮挡、角度、尺度及更显著的飞行姿态变化等,同时也意味着可以显著降低保障需求,大幅度放宽对飞行器的约束。作者团队设计的UAVnet系列网络在戈壁、荒漠等地区进行了大量实飞验证,数据统计表明,可用于定位的图像比例达到75%~91%,是经典景象匹配方法的2~5倍。

如果说基于传统方法的景象匹配是“小而美”,那么基于深度学习的景象匹配就是“大而强”。这为飞行器视觉导航的再次发展打开了一扇全新的大门。

2.4 景象匹配导航的局限性

景象匹配导航并不具备连续的定位测姿能力,因此在飞行器上通常需要与惯导组合使用。无论是基于传统的模板匹配方法,还是基于现代的深度学习技术,景象匹配导航的目标均为提高实时图和基准图的匹配成功率,尽可能多地找到可用于定位的图像,进而计算飞行器的位置,对惯导的位置误差进行校准。虽然少量算法会考虑对惯导的速度误差进行校准,但考虑到直接利用图像定位结果计算速度时存在较大噪声,这种校准需要极为谨慎。

然而,惯导的误差源头包括仪表测量误差、安装误差及初始对准误差。速度误差和位置误差是这些误差综合作用的结果,因此只修正位置、偶尔修正速度,是典型的“治标不治本”。在实际使用中,设计师需要考虑景象匹配定位失败的风险,此时导航精度依然依赖惯性导航来保持,因此必须对仪表及其安装精度、惯导初始对准提出更高的指标要求,这严重制约了视觉导航技术在飞行器上的应用。为此,作者团队近年来深入研究机器视觉领域的最新进展,在空间计算导航技术中形成了一种新的飞行器高精度自主导航范式,取得了显著的效果。

3 新生: 空间计算导航

空间计算(spatial computing)被认为是融合物理世界与数字世界的下一代计算方法,通过实时感知、建模和交互,实现虚拟内容与真实空间的动态融合。其概念出现于2003年前后,随后在三维重建、无人车及虚拟现实等领域得到发展和应用。

近年来,作者团队基于该领域的发展成果,提出了一种飞行器空间计算导航技术,主要基于IMU、多模态视觉、测距机/高度表等传感器信息,将惯性测量与视觉空间计算相融合,实现连续图像世界与真实世界的时空对齐,从而获得飞行器位置、相对姿态、相对平移及相对转动等参数。这些参数经坐标转换后与惯性导航信息深度组合,在校正惯性导航位置、速度误差的基础上,进一步校正惯性导航姿态误差和陀螺、加速度计误差。该方法利用惯性导航保证了视觉信息的空间相关性,随后通过视觉测量抑制了引起惯性导航发散的误差源头,获得了比经典惯性/景象匹配更高的鲁棒性和精度。

飞行器空间计算导航的基础是单视图几何和多视图几何,据此可分为2大类:基于单视图几何的空间计算和基于多视图几何的空间计算。其中,单视图几何基于单张二维图像和场景先验信息(如基准图),通过几何推理、摄影几何等方法获取空间关系,典型应用包括平面测量、位姿估计及三维重建等。多视图几何从多个视角的不同图像中恢复三维场景结构,并获取空间关系,其准确性比单视图几何更高,可获取的空间关系也更丰富,对先验知识的依赖性显著降低。融合惯性信息后,还可以使空间计算变得更加简单,鲁棒性更强。

3.1 基于单视图几何的空间计算导航

基于单视图几何的空间计算导航,通过单张图像及其对应的先验知识提取场景、结构,计算空间关系,进而获取位置、姿态等导航参数。这将单张图像的用法从景象匹配导航的“看位置”演进到“测关系”。

先验知识包括基准图或某些几何约束,例如场景中的已知平面(地面、墙面)、平行线等。计算方法包括直接线性变换、P3P(perspective-3-point)及透视相似三角形等,这些计算都依赖于共轭点的精确提取(本文依据文献[67]将共轭点定义为实时图、序列图、关联图及基准图间的任何一对共同点)。在深度学习出现之前,由于手工设计的特征对环境信息的表达能力有限,且易受光照变化、视角变化等因素干扰,导致共轭点提取难度大,通常精度不高,因此费时费力。深度学习的突破简化了这一工作,同时提高了提取精度,进而提高了导航精度。

文献[68]实现了基于二维码的惯性/视觉位姿估计算法;文献[69]通过单个影消点到基准面的参考距离,计算场景中每个特征点的深度,相当于获得了高度信息;文献[70]基于共轭点实现了飞行器空间位置和姿态角的精确解算;文献[71]提出了PoseNet算法,将卷积神经网络(convolutional neural network, CNN)引入相机的位姿估计;文献[72]提出了PlanNet算法,通过端到端网络直接预测平面参数(法矢量、偏移量);文献[73]和文献[74]基于深度学习的方法进行飞行器相对跑道的位姿测量,实现了无人机视觉导航自主着陆;文献[75]将长短期记忆网络(long short-term memory, LSTM)结构引入PoseNet网络,显著提高了定位精度。

基于单视图几何的空间计算导航依赖于基准图与场景的几何约束假设,获取的导航参数包含位置和姿态,这不仅可以校准惯导的位置误差,还能校准仪表误差。但在特征不显著的区域,空间计算精度会下降,此时校准惯性仪表误差的风险极大,有时甚至得不偿失,可能会导致严重破坏惯导的误差特性,带来灾难性影响。此外,依赖单视图无法直接获得尺度信息,获得的相对位置与真值相差一个比例系数,但这可以通过惯导补齐,或者通过增加基准图中的先验信息等方法补齐。

3.2 基于多视图几何的空间计算导航

基于多视图几何的空间计算导航技术不仅能完成单视图几何的任务,还能在不需要先验信息的条件下,通过极几何和矩阵计算实现载体三维运动参数的估计,并在大多数情况下实现场景三维结构的测量,进一步从 “测关系”演进到“测定量关系”,从而获取完备的飞行器运动参数,实现与惯导参数的深度融合。

文献[76]提出的多状态约束卡尔曼滤波(multi-state constraint Kalman filter, MSCKF)算法,后来被应用于飞行器下降、着陆和自主飞行[78];文献[79]首次在无外部信号的情况下,成功实现了微型空中飞行器(micro air vehicle,MAV)的自主控制与定位;文献[80]首次将特征点与直接法相结合,凭借计算速度快的优势,使其在算力平台受限的场景中表现出色,在MAV上可达55 FPS。

随着基于CNN和Transformer的图像识别网络能力的不断提高,意味着在跨维度等复杂场景下共轭点的提取精度也在不断提升,这为该领域提供了新的发展机遇。文献[82]通过多幅图像计算得到导航参数。随着基于多视图几何的三维重建技术的广泛应用(相关工作见文献[83-89]),空间计算方法不断创新,这也为实现更高性能的视觉导航创造了条件。有时,我们也可将其简化理解为“三维图像匹配”技术。美国Maxar等公司已经开展了相关研究。

作者团队实现了基于多视图几何的空间计算导航,并将其与惯导信息深度融合,将过去的“只校准惯导位置”发展到了“校准惯导的陀螺、加速度计误差等十几种误差源”,基本实现了“治标治本”,将惯性仪表的误差放宽到过去的1/5。当前研究的难点在于如何降低特征相似区的共轭点误提取率、提高算法的实时性及提高时空同步精度,从而进一步提高组合导航性能等。

4 未来: 空间智能认知导航

空间智能(spatial intelligence)建立在空间计算基础之上,是机器系统在物理空间中实现环境感知理解决策交互全链路智能化的能力。这种能力能够赋予机器“空间思维”,使其像人类一样理解三维世界的几何关系、物理特性和语义内涵。李飞飞将传统理论与前沿AI技术相结合,实现了技术应用层面的创新,并将其重定义为机器在三维空间和时间中感知、推理与行动的能力。

可以畅想,未来可能会出现一种基于空间大模型和视觉环境认知的“空间智能认知导航”技术。该技术首先通过星载、机载及地面的各种传感器获取空间地理信息数据,并将这些数据融合映射为三维虚拟世界。在飞行器飞行过程中,机载传感器(如相机)获得的视觉信息会与这个三维虚拟世界进行跨视角、跨模态的计算,从而实现对环境的感知、理解和测量,并进行实时在线推理和自主认知,确定自身与所处环境的空间关系,进而实现导航。甚至,飞行器能像人一样,环顾周边就能确定自己所处的位置。

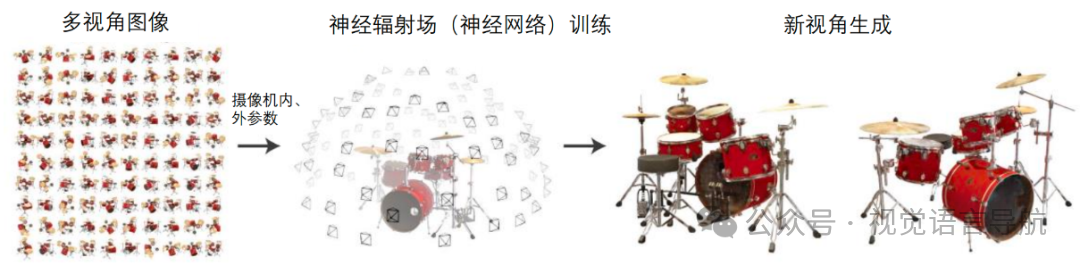

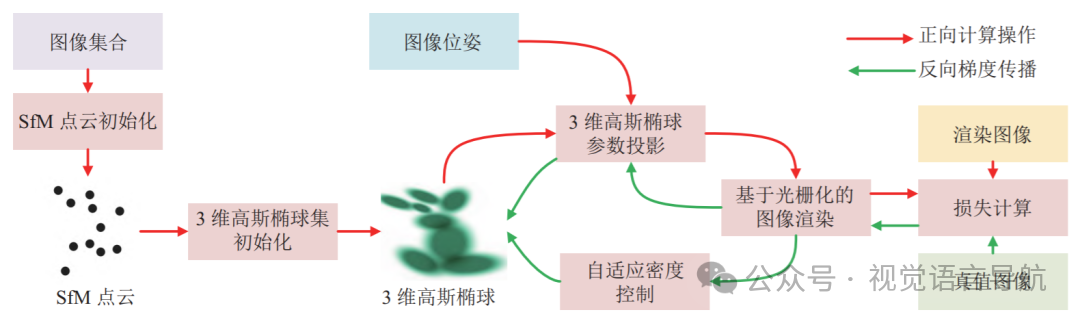

这种畅想并非遥不可及,因为相关的一些技术已经开始崭露头角。例如,2020年出现的神经辐射场(neural radiance fields, NeRF)算法,通过神经辐射场实现隐式三维场景建模(见图9),尽管其计算速度慢且难以处理动态场景,但已具备在不同视角上进行三维空间位姿测量的能力(相关工作见文献[92-93]);2023年,文献[94]提出了三维高斯溅射(3D Gaussian splatting,3DGS)技术(见图10),该技术在场景渲染速度和动态场景处理方面表现出色(相关工作见文献[95-101]);2024年,由李飞飞联合创立的World Labs发布了其三维世界生成大模型(见图11),已经能够很逼真地表达现实世界的复杂性;类似的工作还有谷歌DeepMind的Genie 2及国产的Matrix-Zero等。这均为空间智能认知导航的发展提供了技术基础。

5 总结

导航是飞行器的关键功能,导航能力在一定程度上决定了飞行器的自主性和智能化程度,惯性/视觉导航为此提供了一种可行的技术路线。

回望过去,随着数据不断积累、算法持续迭代及端侧算力不断提升,基于空间计算的惯性/视觉导航能力已经远远超越了传统的惯性/景象匹配导航,其使用约束不断放宽,使用保障持续降低。

展望未来,尽管空间智能所涉及的算法在实时性方面还难以满足飞行器视觉导航的需求,但目前来看,飞行器的算力突破和算法的轻量化正在突飞猛进。随着视觉大模型和视觉Transformer等技术的发展,基于高精度感知、语义化理解及大模型决策的“空间智能,认知导航”时代似乎正缓缓向我们走来,“让飞行器像人一样导航”也许很快就能成为现实。

浙公网安备 33010602011771号

浙公网安备 33010602011771号