线性代数的本质

向量

不同的看待向量的视角

- 物理学家看向量

一个有方向有大小的量,可以自由移动而不改变 - 计算机科学家看向量

有序的数字列表,用来存储数据 - 数学家看向量

高度抽象,任何东西都可以是向量,只要保证加法以及数乘有意义即可

向量的两种运算的几何意义

- 加法

按照平行四边形法则去看待几何意义就好了。根据平行四边形法则,向量\(\vec{x}_1=x_{11}\vec{i}+x_{12}\vec{j},\vec{x}_2=x_{21}\vec{i}+x_{22}\vec{j}\),于是\(\vec{x}_1+\vec{x}_2\)可以理解为先沿着\(x\)轴走\(x_{11}\)步,再沿着\(y\)轴走\(x_{12}\)步,再沿着\(x\)轴走\(x_{21}\)步,再沿着\(y\)轴走\(x_{22}\)步,也就相当于先沿着\(x\)轴走\(x_{11}+x_{21}\)步,再沿着\(y\)轴走\(x_{12}+x_{22}\)步,所以可推导出向量加法的公式:\(\vec{x}_1+\vec{x}_2=(x_{11}+x_{21})\vec{i}+(x_{12}+x_{22})\vec{j}\) - 数乘

几何意义就是变化向量长度

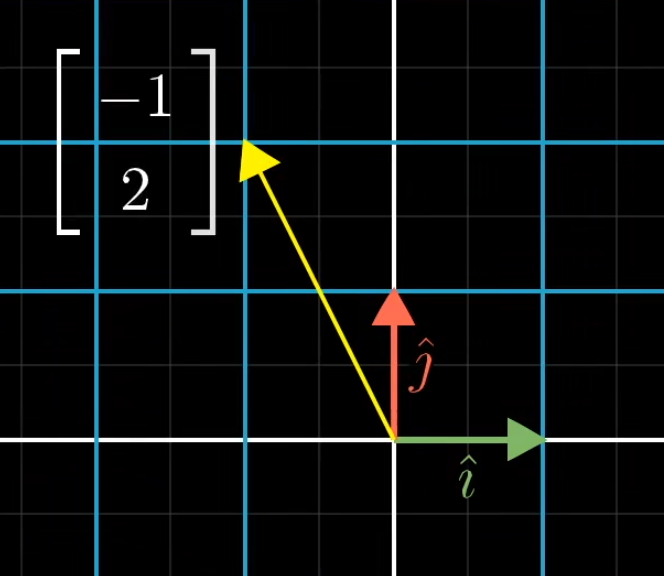

线性组合,张成的空间与基

span

对于给定的两个向量\(\vec{v},\vec{w}\),他们两个张成的空间就是这两个向量的线性组合(span这个概念不一定非要针对线性无关的向量,存在共线的向量也是可以定义span的,只不过现在张成的空间的维度与向量维度不同,如果向量维度和给定的向量个数是一样的话)。span其实就是想要得到在给定的向量只通过加法和数乘两个操作可以得到的所有向量

基

对于\(xOy\)坐标系来说,\(\vec{i}\)和\(\vec{j}\)就是这个坐标系的基向量。在空间维度一定的时候,可以选择不同的基,此时这个空间中的向量也就有了不同的表示方法(向量的坐标是由这个空间的基决定的)。基的严格定义:向量空间的一组基是张成这个空间的线性无关向量集

矩阵与线性变换

线性变换

变换的定义:在同一个空间中,将一个向量变换到另一个向量的过程

线性变换的定义

- 直线变换之后仍保持为直线(注意是对任意一条直线来说都满足;有些变换并没有变换坐标轴,但是可能会存在一条原空间的直线弯曲了,从而不是线性变换)

- 原点必须保持固定

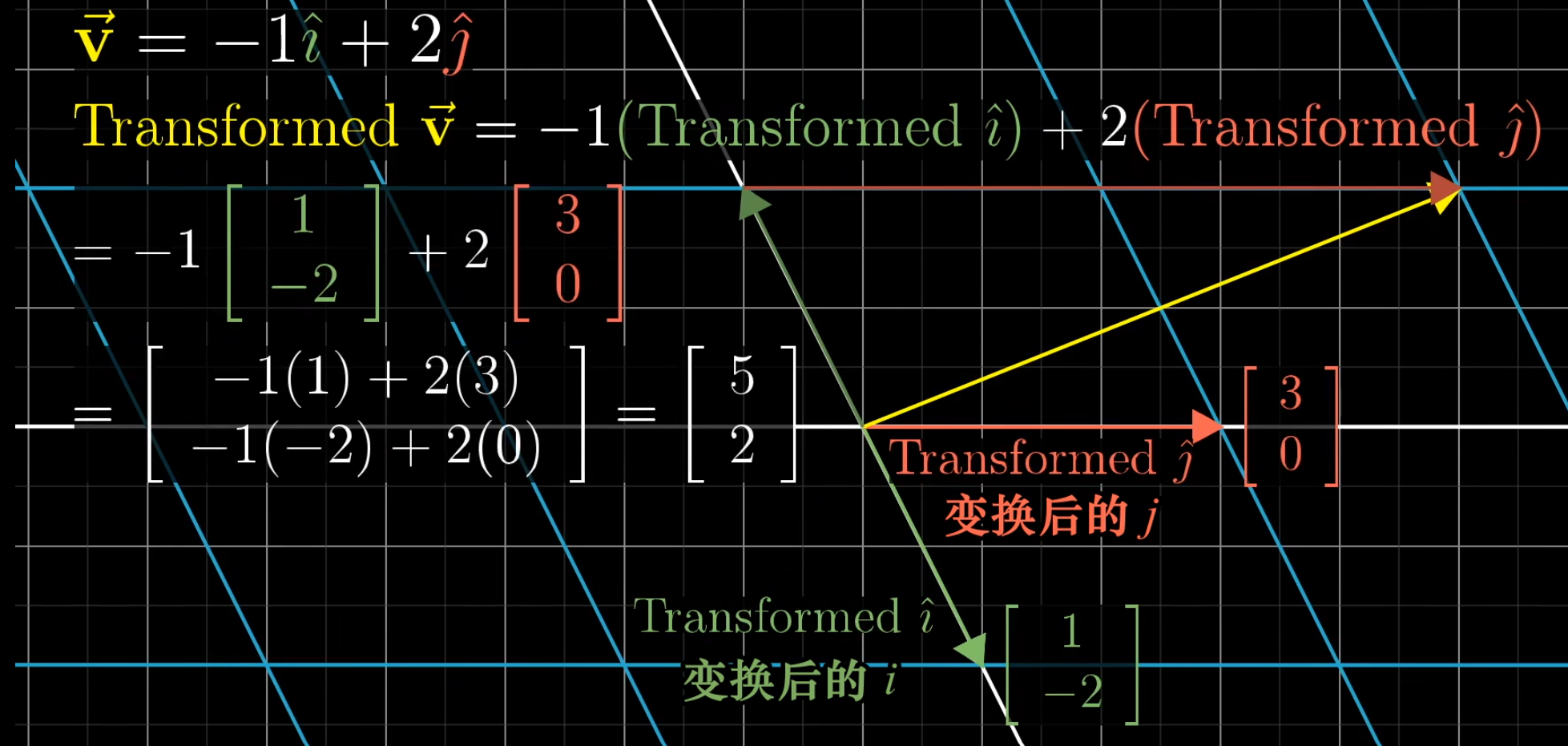

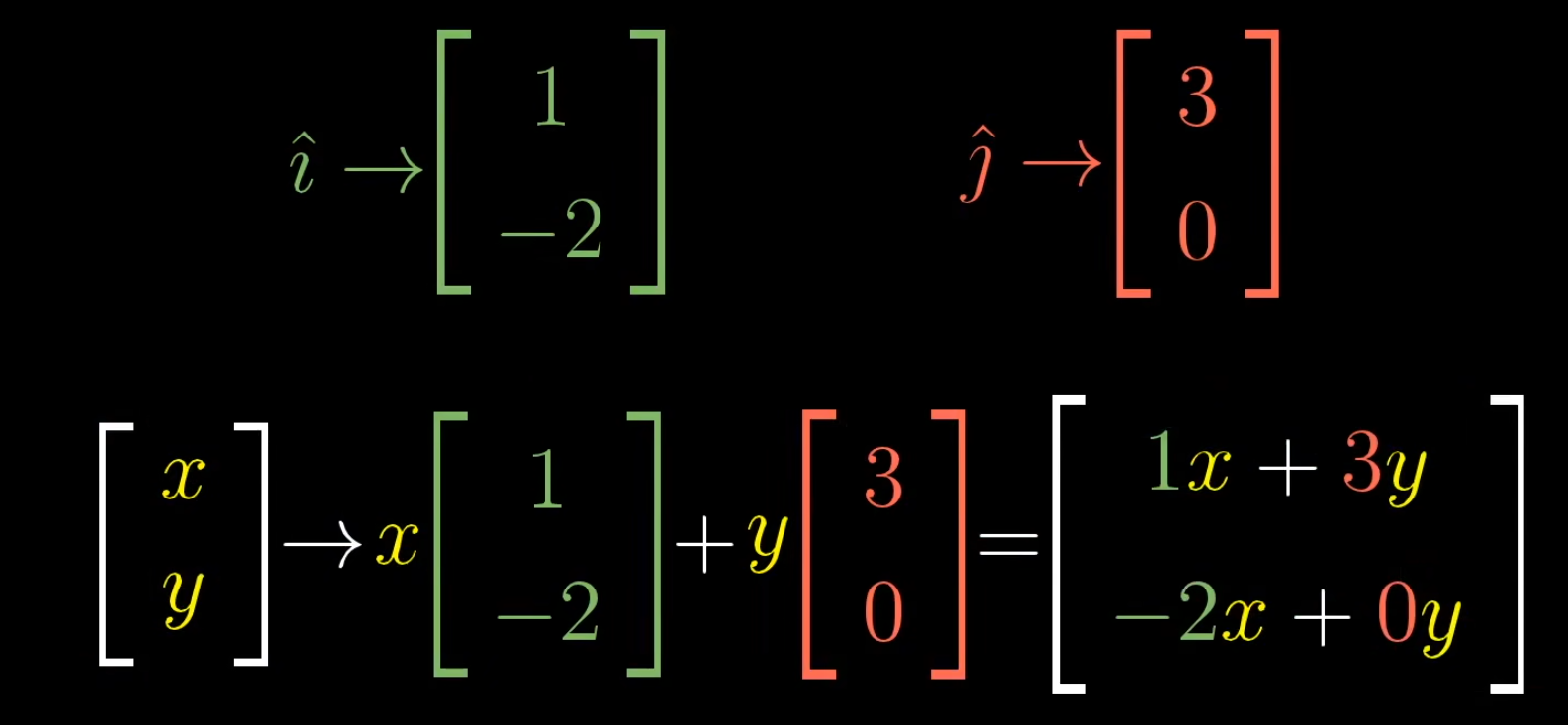

更简单的理解:如果在原空间中对每个坐标轴都做出无限条与之平行的等距的直线,那么在变化之后,所以这些直线仍然等距并且平行。这一点可以推导出一个性质:向量之间的线性组合关系不会变化(也就是说假设向量\(y\)是\(x_1,x_2,...,x_n\)的线性组合,在变换之后这\(n+1\)个向量会有新的坐标,分别为\(y^{'},x_1^{'},x_2^{'},...,x_n^{'}\),那么\(y^{'}\)还是\(x_1^{'},x_2^{'},...,x_n^{'}\)一模一样的线性组合)

所以我们关注变换之前的基与变换之后的基就好了

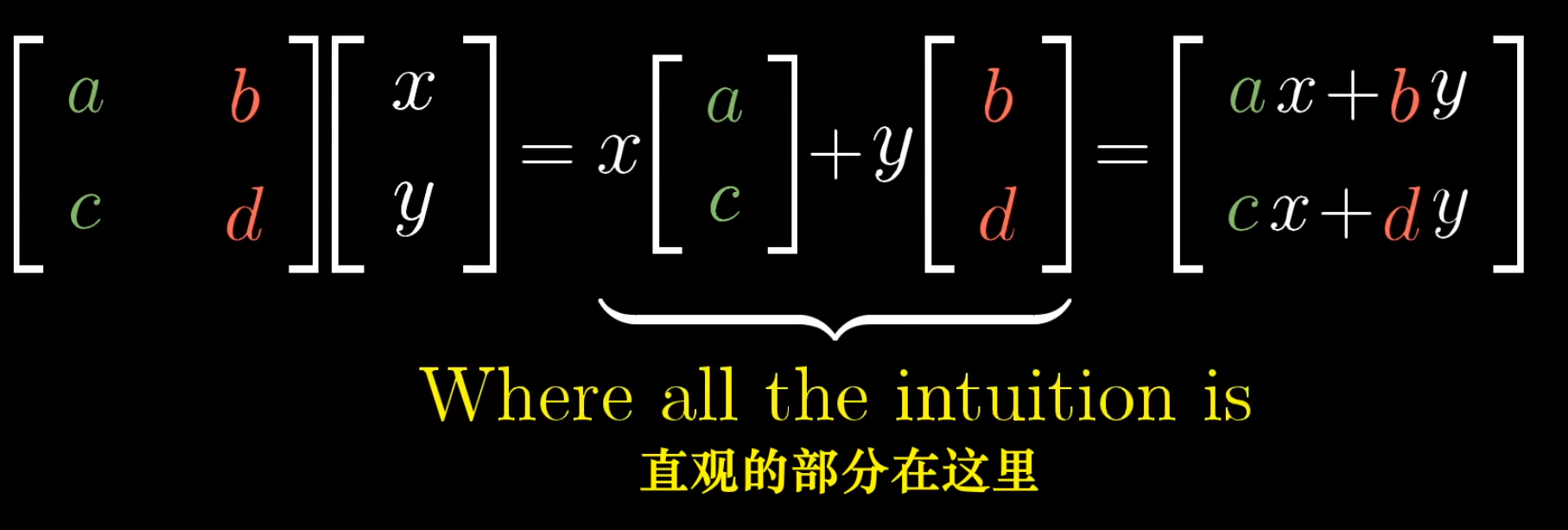

矩阵

矩阵是用来做线性变换的,以上面的例子为例,由于我们只需要知道基的变换,所以我们用矩阵的列向量来表示变换之后的基,然后做矩阵乘法,就可以知道变换之后的向量了

更一般地

下面介绍一些常见的变换,设变换矩阵为\(A\)

- 逆时针旋转\(90\)°

- 剪切

由方阵的几何意义,我们就可以知道,如果两个列向量线性相关,我们就降维了,只能得到更低维度的向量了。这是因为根据线性变换的简单理解,现在变换之后有两个向量共线,那么根据这两个向量画出来的平行线之间就是平行的,我们就没办法走出这个平行的方向了(结合视频9:24开始理解)

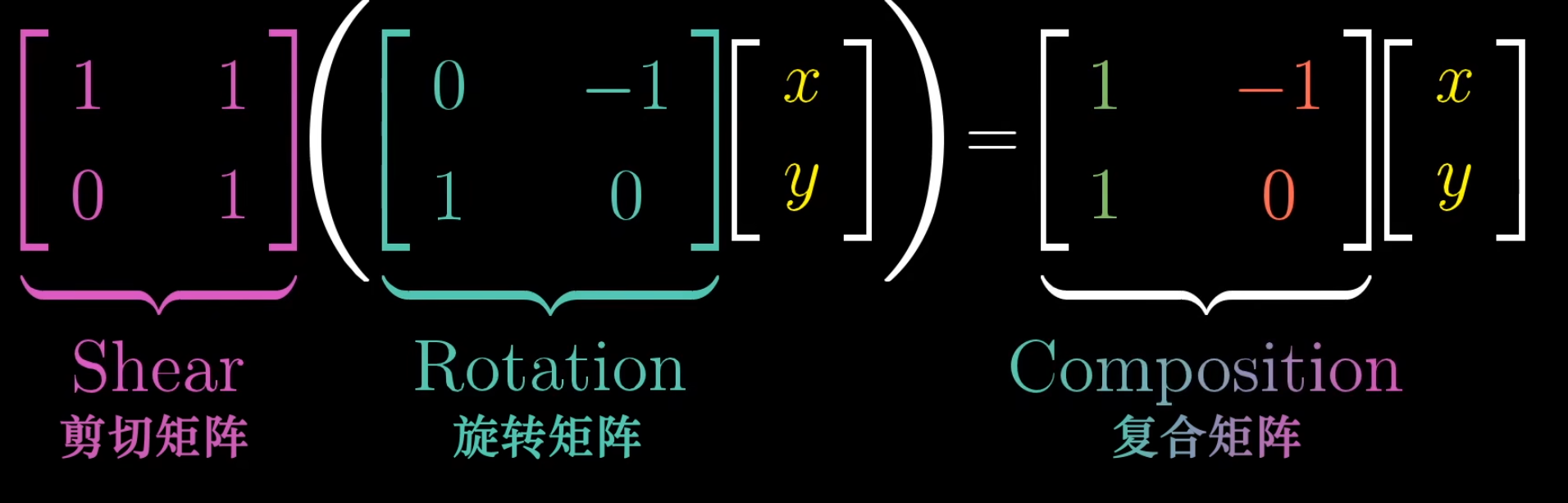

矩阵乘法与线性变换复合

复合:将多个基础的线性变换以一次矩阵乘法的形式完成

比如现在我想要先进行旋转,再进行剪切,可以依次进行,也可以一次到位

所以两个矩阵的乘积的几何意义就是若干个线性变换的复合(注意方向是从右到左不是从左到右)。对于这个命题的证明,可以看视频6:15

从几何意义也可以知道,矩阵相乘的时候的顺序也是重要的,即\(AB\)不一定等于\(BA\),也可以在脑海里面想出为啥结合律(\((AB)C=A(BC)\))成立了

上面的所有内容都是二维的,不难知道完全可以推广到更高维空间

行列式

我们现在关心一个问题,就是在进行变换之后,原来的一块给定区域的面积(如果是三维空间,就是体积)的变化是怎么样的?

我们先定义方向:面积指的都是有向面积。以二维空间说明空间方向的严格定义。在原坐标系中\(y\)轴在\(x\)轴右边(右手法则),如果变换之后,\(x\)轴在\(y\)轴右边了,那么空间就发生了转向

为了简单,我们考虑给定区域是左下角为原点,右上角为\((1,1)\)的小正方形的有向面积的变化(由“如果在原空间中对每个坐标轴都做出无限条与之平行的等距的直线,那么在变化之后,所以这些直线仍然等距并且平行”这个命题可以知道,任意区域的面积的变化都是相同的)

我们定义,小正方形的有向面积放大倍数,就是一个矩阵的行列式(注意假设此时我们还不知道怎么计算行列式)

如果一个矩阵的行列式为\(0\)了,就说明小正方形的面积变成了\(0\),也就是降维了

那么从这个几何意义就可以推导出行列式的计算方法,具体见视频7:38

有了上面的基础,就可以尝试从几何意义的角度理解\(|AB|=|A||B|\)

逆矩阵,列空间与零空间

对于线性方程组\(A\vec{x}=\vec{y}\),从几何意义来理解就是找到一个向量\(\vec{x}\)使得在\(\vec{x}\)经过旋转和拉伸的变换之后与向量\(\vec{y}\)重合。分两种情况讨论

- \(|A|≠0\)

此时空间没有降维,显然有且仅有一个向量满足\(\vec{x}\)

可以通过对\(\vec{y}\)进行逆向变换找到这个向量。我们可以定义逆向变换为\(A^{-1}\)。从几何意义可以直接推导出\(AA^{-1}=E\)(即“什么都不做”的矩阵)。于是\(\vec{x}=A^{-1}\vec{y}\)(从几何上看就是在做逆变换) - \(|A|=0\)

此时不存在逆变换。因为逆变换本质上是我们定义的一个函数,也就是要求一个向量在经过一个逆变换之后会得到另一个唯一的向量。假设存在逆变换,那么低维空间的某一个向量就会唯一映射到高维空间的某一个向量,这是不正确的,因为高维空间中有无数条向量可以通过变换得到这个低维空间的向量。举个例子说明,假设高维空间是二维的,低维空间是一维的,变换矩阵为\[A=\begin{bmatrix} 1 & -1 \\ 0 & 0 \end{bmatrix} \],也就是将\(y\)轴逆时针旋转\(90°\)

那么对于以为空间中的向量\(\vec{y}=(1)\),可以将其写成\(\vec{y}=(1+x)+(-x),\forall x∈R\);也就是说对二维空间中的任意向量\(\vec{x}=(1+x,x)\),经过\(A\)的变换都可以得到\(\vec{y}\),所以此时有无数个向量对应\(\vec{y}\).从这里也可以知道为什么此时的解有无数个

我们定义变换后空间的维度为变换矩阵的秩

定义列空间为经过变换后的空间里面的所有向量,也就是矩阵的列张成的空间,所以列空间的维数也就是秩的数值

零向量一定在列空间中,因为我们要求变换前后原点不变

原空间的向量如果经过变换之后是零向量,那么这些向量构成的几何就叫做零空间或者核。零空间也就是\(A\vec{x}=\vec{0}\)的所有解

我们接下来来稍微看一下非方阵。比如讨论

那么这个方阵就是将二维空间中的\((1,0)\)和\((0,1)\)映射到了三维空间中的两个向量\((2,-1,-2)\)和\((0,1,1)\);在三维空间中这两个向量张成了一个平面,所以二维空间中任何一个向量经过这个变换都会在这个平面里面

注意这个变换仍然是满秩的,因为输入空间与列空间的维度是相等的

那么如果变化矩阵是\(2\times 3\)的,就代表一个二维空间到三维空间之间的变换

点积

点积的几何意义就是就是做投影。点积运算是对称的(也就是说\(\vec{x}\cdot\vec{y}=\vec{y}\cdot\vec{x}\)),从几何意义上来考虑(注意利用一个向量的长度扩大\(x\)倍那么投影长度也扩大\(x\)倍就很好理解了)

下面是一个性质:在高维空间中等距分布在一条直线上的向量经过变换之后如果到了低维空间中那么仍然在低维空间的一条直线上等距分布。具体例子见视频5:00.这个性质的证明比较简单,利用分布在一条直线上的向量的各个维度的变化都是成比例的(也就是说一个维度增加了\(x\),那么其他维度会增加\(k_1x,k_2x\)等等,其中\(k_i\)是一个常数)。一个变化是线性变换当且仅当满足这个性质

有了这个性质,我们就可以解释为什么点积的几何意义是投影

对于二维空间,我们在这个平面上找到一条经过原点的直线,并规定正方向。设这条直线的单位基向量为\(\vec{u}=(1)\),并假设在二维空间中\(\vec{u}=(u_x,u_y)\);现在考虑这么一个变换:将所有二维平面上的所有向量对这个直线进行投影(也就是输入一个二维向量输出一个一维向量);由于这个变换满足上面的性质(且这条直线经过原点),所以这个变换是一个线性变换,也就是可以找到一个矩阵\(A∈R^{1\times 2}\)来代表这个变换;考虑如何找到这个变换,也就是找到\(\vec{i}=(1,0)\)和\(\vec{j}=(0,1)\)在这条直线上的投影,具体找的方法利用对称性,见视频8:55;于是就有\(A=[u_x,u_y]\),所以二维平面上的向量如果想做到这条直线上的头像,就将这个向量与\(A\)相乘即可;注意到这个矩阵乘法的过程与向量点击运算的过程一模一样,所以向量点积运算就是在做向量到这条直线上的投影

非单位向量的推导与这个非常相似,见视频10:35(后面的对偶性都没看,看看能不能得出什么东西)

叉积

介绍

两个向量\(\vec{v},\vec{w}\)的叉积\(\vec{v}\times\vec{w}\)定义为这两个向量张成的平行四边形的面积(使用右手法则确定正负号)

由于计算面积,所以我们可以利用行列式

对于二维向量的叉积,我们将两个向量的坐标分别作为一个\(2\times2\)的方阵的列向量(注意\(\vec{v}\)作为第一列,而\(\vec{w}\)作为第二列,这个样子符号就对了),然后计算这个列向量的行列式即可

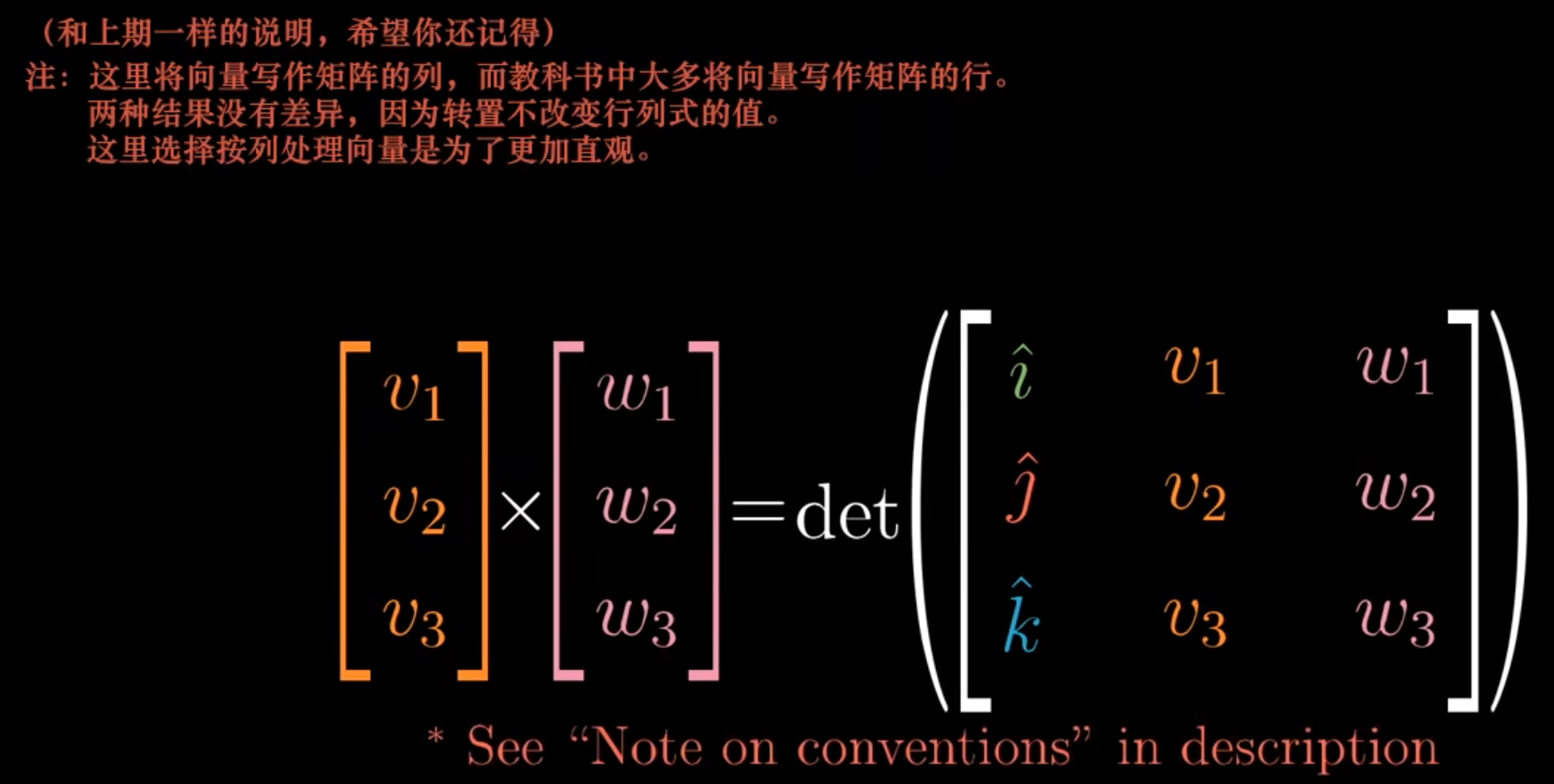

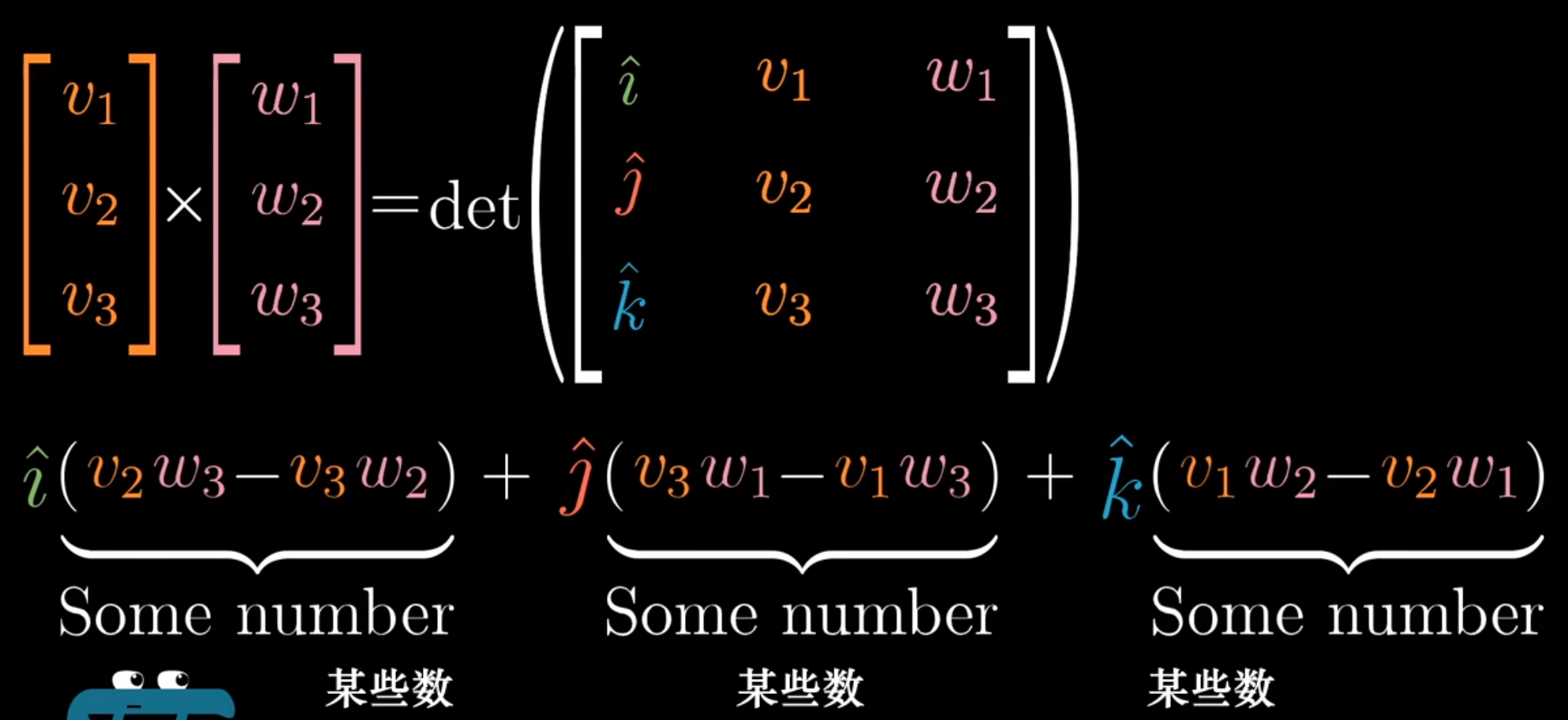

三维空间的叉积,会生成一个新的向量,见视频5:10

以线性变换的眼光看叉积

三维空间的叉积有一个公式

这个行列式的计算结果如下

那么为什么矩阵的元素可以是向量(\(\vec{i},\vec{j},\vec{k}\))呢?有人会说这只是一个符号上的技巧,并没有特殊含义,但其实不是的

然后视频的1:45开始要用到对偶性,还没看

基变换

对于一个二维空间,实际上他就是一个空间,本身是没有坐标系的。我们不同人可以定义不同的坐标系,于是每个人的基向量都不一样(当然这里的不一样指的是以某一个人的视角去看所有人的基向量的坐标,是不一样的;每个人看自己的基向量的坐标都是一样的,都是\((1,0)\)和\((0,1)\));同一个向量,在不同的坐标系中的坐标不同,所有人描述其的方式也就不同;但是不同人的坐标系的原点是重合的

一个很自然的问题:如果在不同的坐标系中进行转换?

假设以\(A\)为观察者去考察所有人的坐标。\(A\)的坐标系的基向量为\((1,0)\)和\((0,1)\),\(B\)的坐标系的基向量为\((2,1)\)和\((-1,1)\)(当然在\(B\)自己看来还是\((1,0)\)和\((0,1)\))

那么在\(B\)的视角中为\((-1,2)\)的向量,在\(A\)的视角中为多少呢?

在\(B\)的视角中,\((-1,2)=-1(1,0)+2(0,1)\);而在\(A\)的视角中,\(B\)的\((1,0)\)和\((0,1)\)分别为\((2,1)\)和\((-1,1)\),于是可以得到,在\(A\)的视角中,在\(B\)的视角中为\((-1,2)\)的向量为\(-1(2,1)+2(0,1)=(-4,1)\)

不难进行一般化,在\(B\)的视角中,某一个向量的坐标为\(\vec{x}\),那么在\(A\)的视角中,这个向量的坐标就为

这个成立的原因稍微进行几何意义的想象就好了

那相反过来怎么办呢?也就是说在\(A\)的视角中为\((-1,2)\)的向量,在\(B\)的视角中为多少呢?此时只用将上面的矩阵换成逆矩阵就好了。也就是说在\(A\)的视角中,某一个向量的坐标为\(\vec{x}\),那么在\(B\)的视角中,这个向量的坐标就为

这个由逆矩阵的几何意义也不难得出

由上面对\(A\)和\(B\)的基向量的定义可以知道,\(A\)的基向量是垂直的,但是\(B\)的不是

考虑一个逆时针旋转\(90\)°的变换,显然对于\(A\)的视角的向量\(\vec{x}\),只需要将其乘以

即可

那么在\(B\)的视角下,如何进行逆时针旋转\(90\)°的操作呢?注意此时不能将\(B\)视角下的向量\(\vec{x}\)直接乘以上述矩阵,因为\(B\)的基向量不是垂直的,直接乘以上述矩阵就不是逆时针旋转\(90\)°了。正确的操作应该是,先将\(B\)视角下的向量转换为\(A\)视角下的向量,然后再乘以上述矩阵进行旋转\(90\)°,最后再将得到的向量转换为\(B\)视角下的向量,也就是

所以对于表达式\(A^{-1}MA\),这其实代表了一种转换作用:中间的矩阵\(M\)是在普通坐标系下的变换,而边缘的两个矩阵代表了坐标系的转换

特征向量与特征值

数学表达形式为\(A\vec{x}=\lambda\vec{x}(\vec{x}≠\vec{0})\),那么根据前面的几何知识,我们其实不难理解特征值和特征向量的几何意义

\(A\vec{x}\)是对\(\vec{x}\)进行一个变换,而\(\lambda\vec{x}\)与\(\vec{x}\)共线,所以特征值几何意义就是经过变换之后的向量被放大了特征值这么多倍,而特征向量就是符合上面条件的向量

在三维空间中考察特征值和特征向量是很有意思的,如果一个变换是单纯的旋转操作(特征值为\(1\)),那么特征向量就相当于旋转轴(考察旋转轴比考察矩阵要形象得多)

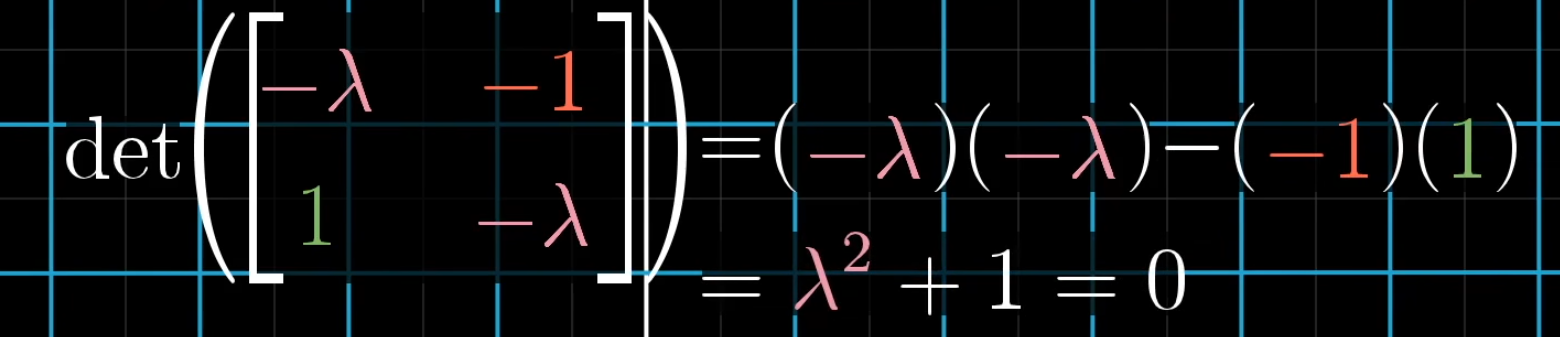

要找出特征值和特征向量,我们将等式变换为\((A-\lambda E)\vec{x}=\vec{0}\);由于\(\vec{x}≠\vec{0}\),所以当且仅当矩阵代表的变换可以将空间压缩到更低维度的时候,才存在一个非零向量,经过这个矩阵的变换之后变成零向量,于是可以推出\(|A-\lambda E|=0\)

当然不一定有特征向量,比如二维平面中逆时针旋转\(90\)°

还要注意,一个特征值的特征向量不一定是共线的,比如矩阵

现在考虑一个问题,如果我们想要计算一个矩阵的高次幂,应该怎么办?要解决这个问题,首先要知道特征基:如果变换矩阵\(A\)使得基也是特征向量,那么这些基就叫做特征基

如果\(A\)的一些特征向量的组合能够张成全空间,那么我们就可以变换当前坐标系,使得这些特征向量是基向量,下面以二维平面为例进行说明

设

于是不难知道两个不共线的特征向量为\(\vec{x}=(1,0)\)和\(\vec{y}=(-1,1)\)

现在假设另一个人已经把\(\vec{x}\)和\(\vec{y}\)当成了基向量(也就是对他来说,\(\vec{x}=(1,0),\vec{y}=(0,1)\),尽管\(\vec{y}\)的长度为\(\sqrt{2}\)),那么在他的视角下的一个向量\(\vec{a}\),经过了\(A\)的变换之后,坐标应为

而在另一个人的视角下,\(A\)变换就是将基向量进行长度倍增,所以\(a\)的各个坐标也应该进行长度倍增,于是设

那么可以知道\(B\vec{a}\)就是将\(a\)的各个坐标进行长度倍增,也就是说\(B\)肯定是一个对角矩阵

对角矩阵的高次幂是非常好进行计算的,于是现在要计算\(A\)的高次幂,我们计算\(B\)的高次幂即可

上面就告诉我们,如果我们要计算一个矩阵的高次幂,先找出其能长成全空间的特征向量,然后计算出相应的\(B\),对\(B\)进行高次幂计算即可

抽象向量空间

我们想要弄清楚,向量到底是什么?

首先回顾一下线性变换的定义。设现在有一个集合\(S\)和一个变换\(L\)。若\(\forall \vec{v},\vec{w}∈S\),有如下两个定理满足

- \(L(\vec{v}+\vec{w})=L(\vec{v})+L(\vec{w})\)

- \(cL(\vec{v})=L(c\vec{v})\)

那么就说\(L\)满足线性变换的定义

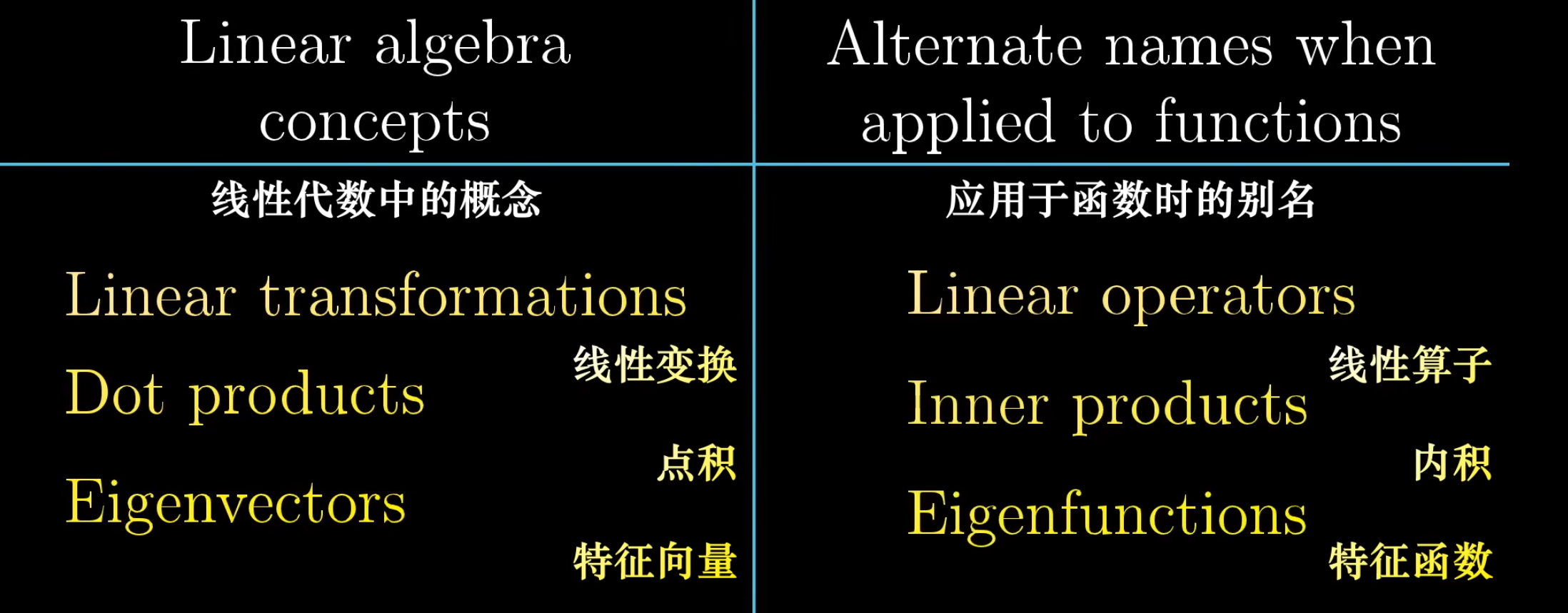

我们知道,以数作为元素的向量,矩阵乘法是满足上述定义的,所以矩阵乘法可以看做是线性变换

我们考虑另一个例子:导数。假设\(S\)是多项式函数的集合,\(L\)是求导,那么可以知道\(L\)也是一个线性变换

这与矩阵乘法有什么联系呢?

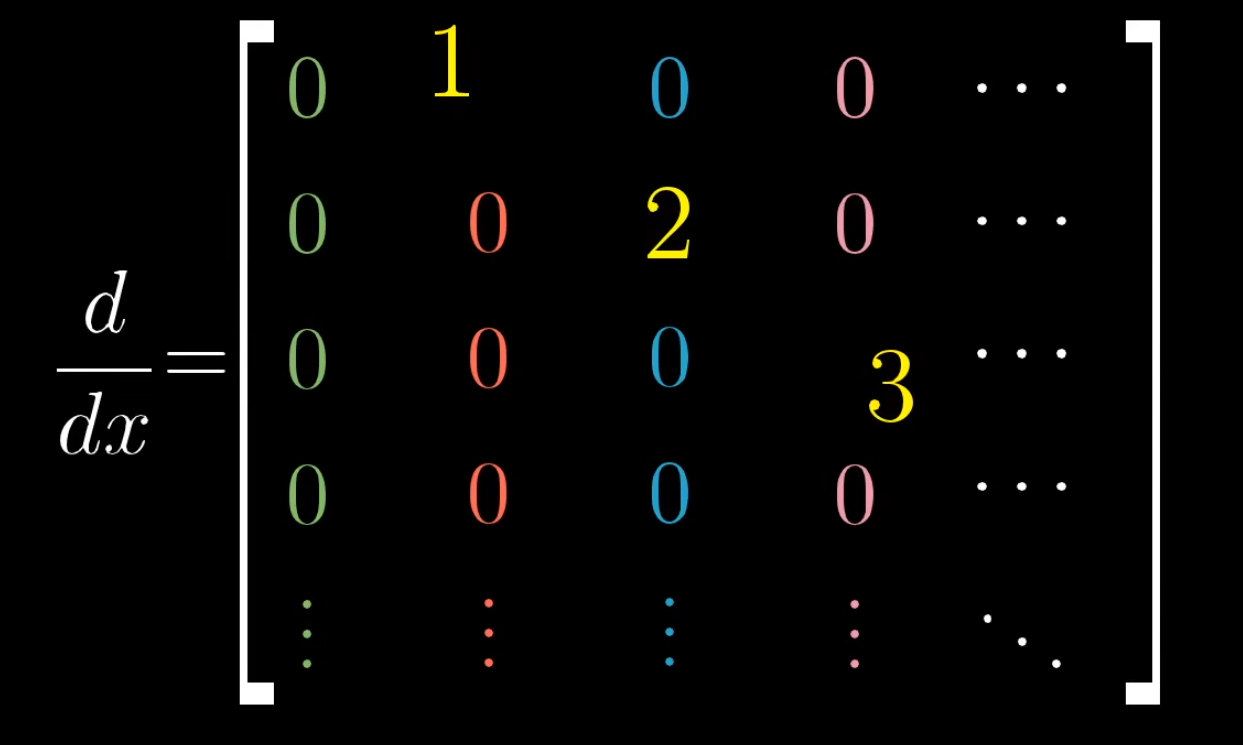

我们考虑如何描述一个函数,很自然地可以以\(x^0,x^1,x^2...\)作为基(有无穷多个基),于是一个函数就像向量一样有了坐标。我们当然也就可以将求导描述为一个矩阵,如下

这个矩阵是如何得出的呢?实际上,与向量的变换矩阵的得出过程是一样的:首先对第一个基\(x^0=(1,0,0...)\)求导然后作为变换矩阵的第一列,然后对第二个基\(x^1=(0,1,0...)\)求导然后作为变换矩阵的第二列,然后对第三个基\(x^2=(0,0,1...)\)求导然后作为变换矩阵的第三列,依次类推

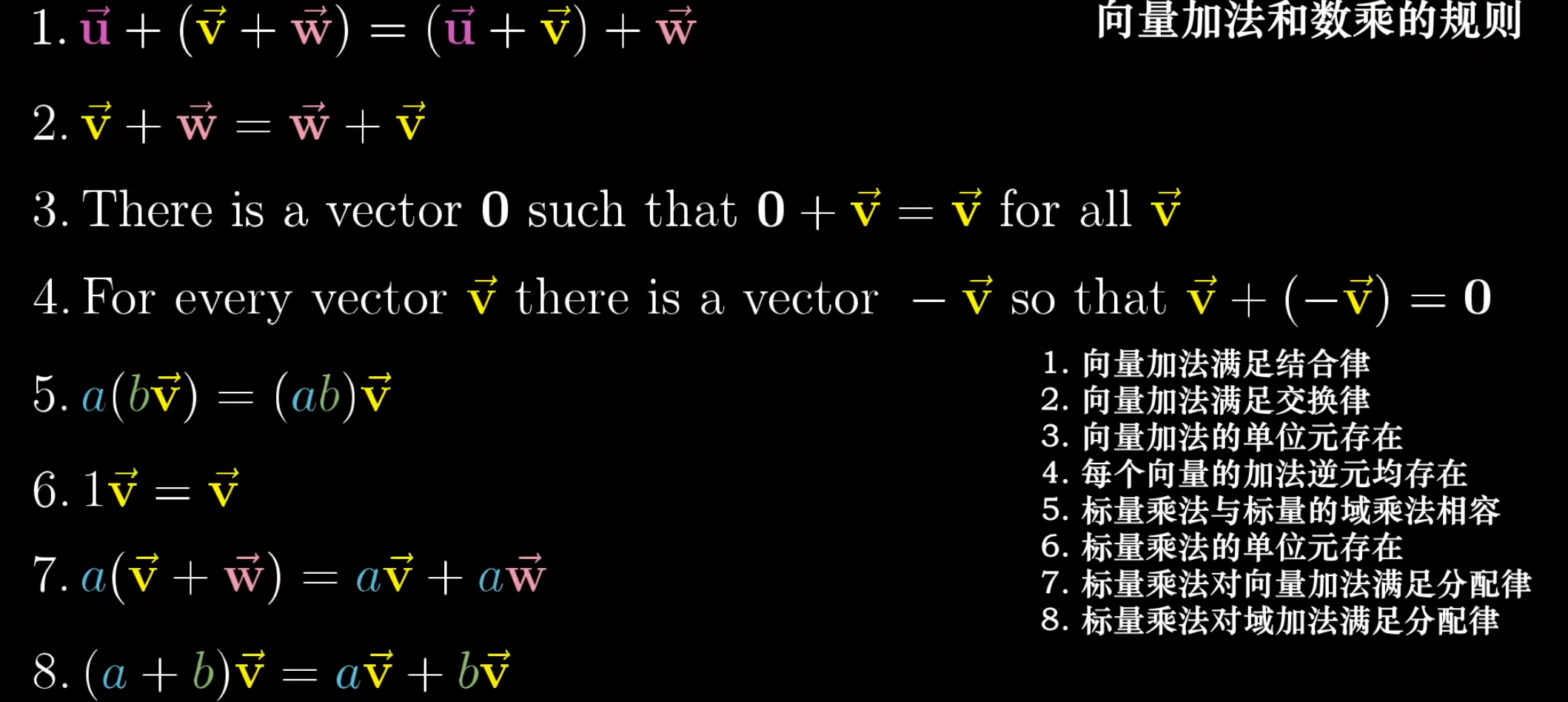

从上面的例子可以看出,我们可以定义奇奇怪怪的集合\(S\)和线性变换\(L\)。不需要对每一个定义都去证明一些性质,我们只要证明其满足如下公理

那么线性代数的所有结论都可以用于这些定义。比如函数与线性代数的对应

克莱姆法则

这个没看

浙公网安备 33010602011771号

浙公网安备 33010602011771号