14.8.6 整合代码

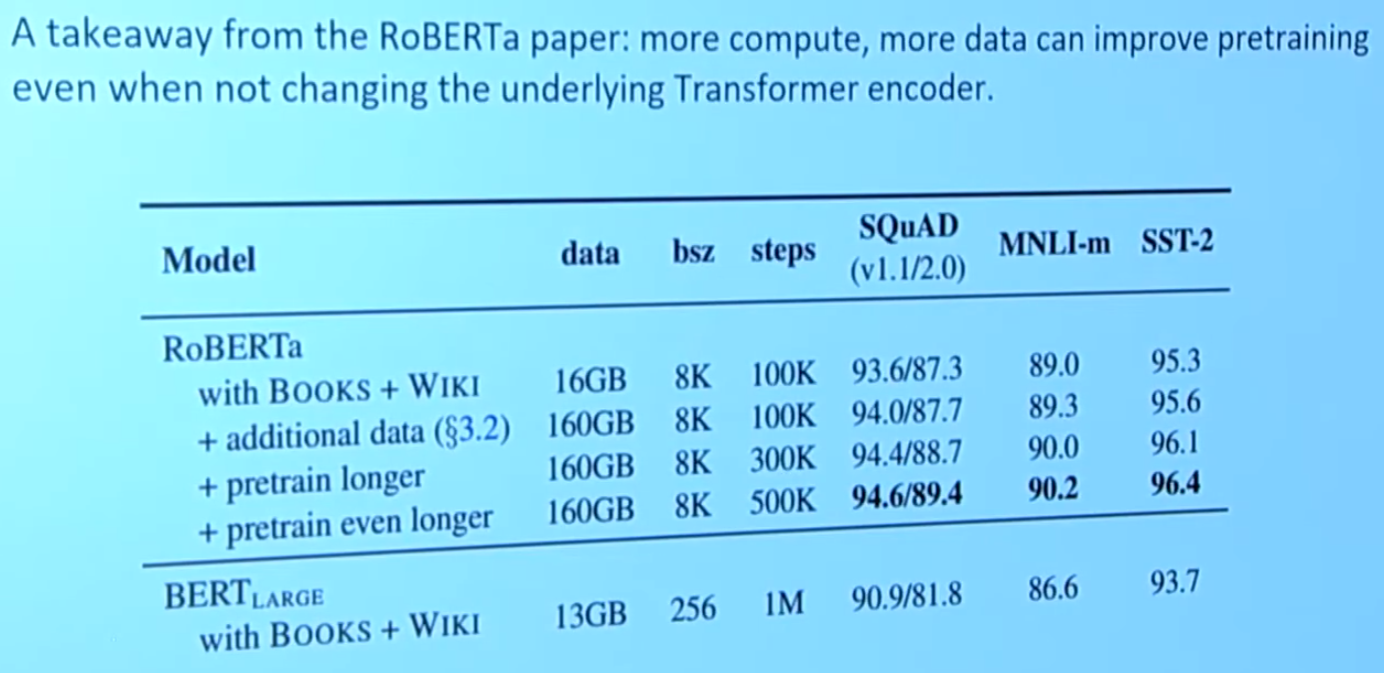

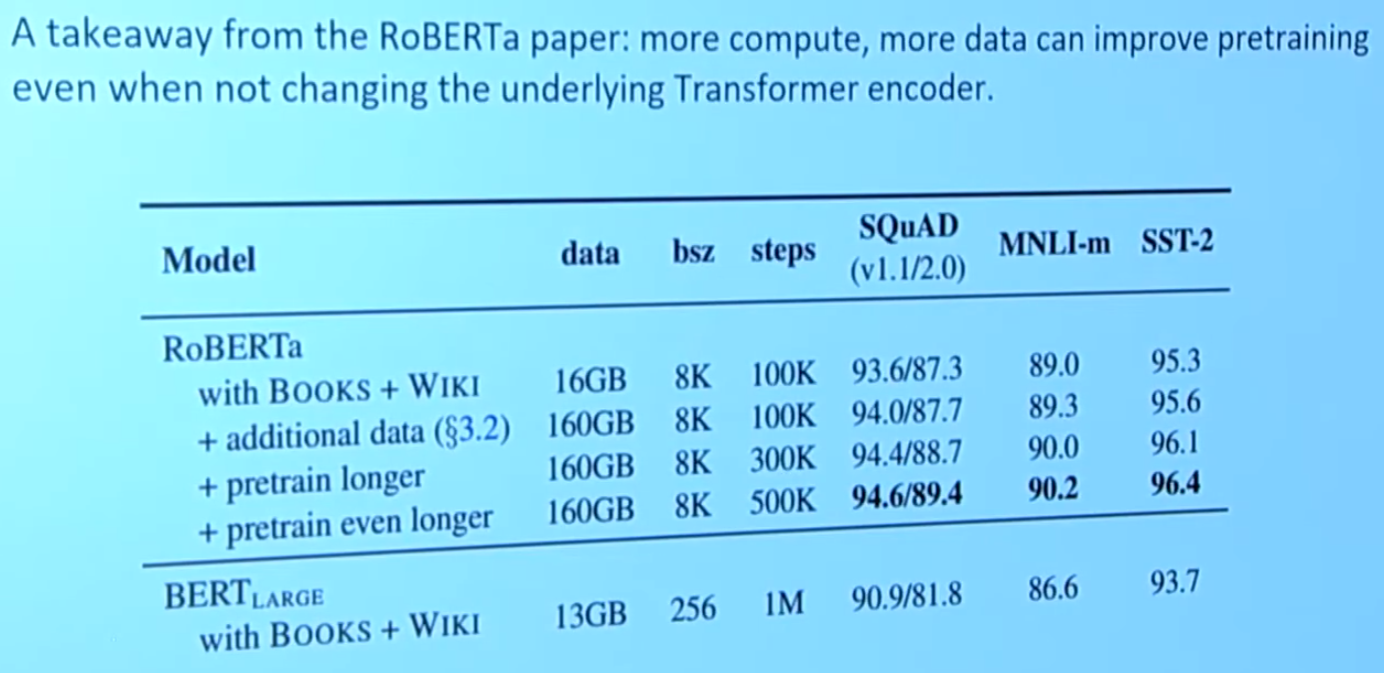

其实BERT预训练任务中,掩蔽语言模型才是最重要的,下一句预测这个任务造成不了什么影响(BERT的原始论文做了两个预训练任务,但后面有一个人只做了掩蔽语言模型,效果还更好,如下)。但是我们需要学到的就是,无论是什么任务,我们总是期望教会模型一点东西(比如下一句预测就是希望模型学会长距离的关系)

上图中,RoBERTa与BERT在预训练任务上的区别就是前者只使用了掩蔽语言模型

所以书上的代码将下一句预测当做一定要训练的任务我不是很理解

其实BERT预训练任务中,掩蔽语言模型才是最重要的,下一句预测这个任务造成不了什么影响(BERT的原始论文做了两个预训练任务,但后面有一个人只做了掩蔽语言模型,效果还更好,如下)。但是我们需要学到的就是,无论是什么任务,我们总是期望教会模型一点东西(比如下一句预测就是希望模型学会长距离的关系)

上图中,RoBERTa与BERT在预训练任务上的区别就是前者只使用了掩蔽语言模型

所以书上的代码将下一句预测当做一定要训练的任务我不是很理解