4.5.1 范数与权重衰减

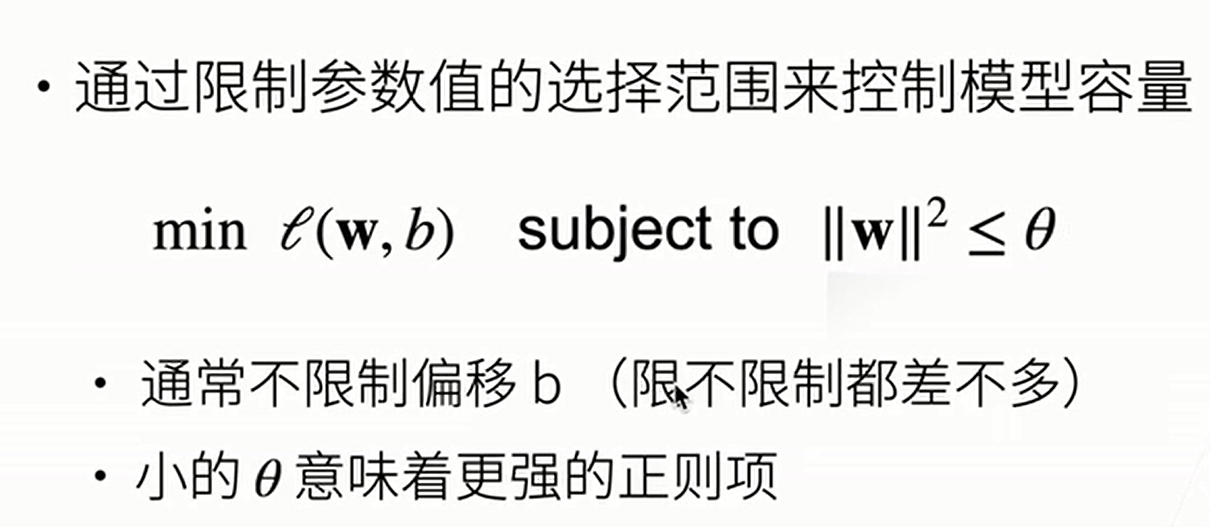

其实一般的正则化项都是软限制,我们也可以硬限制,如下

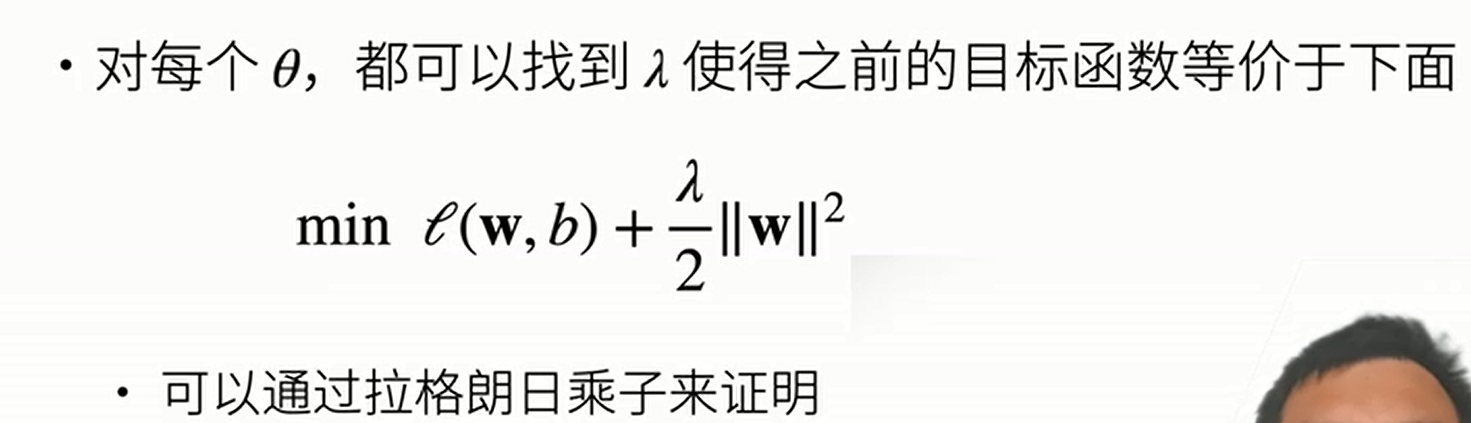

但是硬限制是不好优化的,实际上,软限制与硬限制是等价的

书上式\((4.13)\),如果是多层感知机,将\(\frac{\lambda}{2}||w||^2\)变成\(\frac{\lambda}{2m}\sum||w||^2_F\)即可(\(||w||^2_F\)表示\(F\)范数)

一般的理解就是\(\lambda\)越大,\(\text{w}\)就会接近\(0\),相当于消除了一些参数,能够拟合的函数就更简单,所以消除了过拟合

另外有一个新观点是基于神经网络的。神经网络会使用激活函数,假设激活函数为\(\text{tanh}\),在零点附近,其接近线性函数,于是可知,当\(\lambda\)越大,\(\text{w}\)就会接近\(0\),于是\(\text{z}^{[l]}\)就会接近\(0\),于是激活函数就类似于线性函数,所以整个神经网络相当于在拟合线性函数,于是就失去了神经网络的拟合功能,就不太容易过拟合了

浙公网安备 33010602011771号

浙公网安备 33010602011771号