7. Spark SQL

1.分析SparkSQL出现的原因,并简述SparkSQL的起源与发展。

SparkSQL出现的原因:

SparkSQL的前身Shark对于Hive的太多依赖(如采用Hive的语法解析器、查询优化器等等),制约了Spark的One Stack Rule Them All的既定方针,制约了Spark各个组件的相互集成,所以提出了SparkSQL项目。

SparkSQL的起源与发展:

Hadoop刚开始出来的时候,使用的是hadoop自带的分布式计算系统MapReduce,但是MapReduce的使用难度较大,所以就开发了Hive,Hive编程用的是类SQL的HQL的语句,这样编程的难度就大大的降低了,Hive的运行原理就是将HQL语句经过语法解析、逻辑计划、物理计划转化成MapReduce程序执行。当Spark出来以后,Spark团队也开发了一个Shark,就是在Spark集群上安装一个Hive的集群,执行引擎是Hive转化成Mapreduce的执行引擎,这样的框架就是Hive on Spark,但是这样是有局限性的,因为Shark的版本升级是依赖Hive的版本的,所以2014年7月1日spark团队就将Shark转给Hive进行管理,Spark团队开发了一个SparkSQL,这个计算框架就是将Hive on Spark的将SQL语句转化为Spark RDD的执行引擎换成自己团队从新开发的执行引擎。

(1)1.0版本以前:Hive on Spark Shark

(2)1.0.x版本:Spark SQL Alpha版本(测试版本,不建议商业项目使用),这个版本让Spark升为了Apache的顶级项目。

(3)1.3.x版本:SparkSQL DataFrame、Release(成熟,可以使用)

(4)spark 1.5.x版本:钨丝计划(底层代码的优化)

(5) spark 1.6.x版本:DataSet(alpha版本)

(6)Spark 2.x.x版本:DataSet(正式的)、Structrued Streaming

2.简述RDD 和DataFrame的联系与区别。

RDD 和 DataFrame 均为 Spark 平台对数据的一种抽象,一种组织方式,但是两者的地位或者说设计目的却截然不同。

RDD 是整个 Spark 平台的存储、计算以及任务调度的逻辑基础,更具有通用性,适用于各类数据源,

而 DataFrame 是只针对结构化数据源的高层数据抽象,其中在 DataFrame 对象的创建过程中必须指定数据集的结构信息( Schema ),

所以 DataFrame 生来便是具有专用性的数据抽象,只能读取具有鲜明结构的数据集

下图直观地体现了 DataFrame 和 RDD 的区别。

左侧的 RDD[Person] 虽然以 Person 类为类型参数,但 Spark 平台本身并不了解 Person 类的内部结构。

而右侧的 DataFrame 却提供了详细的结构信息,使得 Spark SQL 可以清楚地知道该数据集中包含哪些列,每列的名称和类型各是什么。

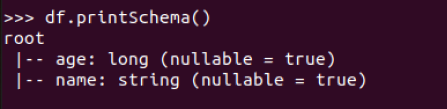

DataFrame 多了数据的结构信息,即 schema 。

RDD 是分布式的 Java 对象的集合, DataFrame 则是分布式的 Row 对象的集合。

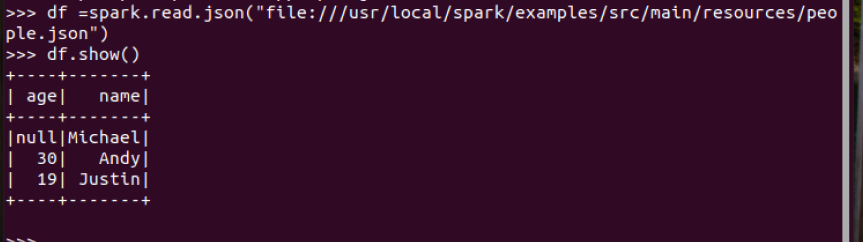

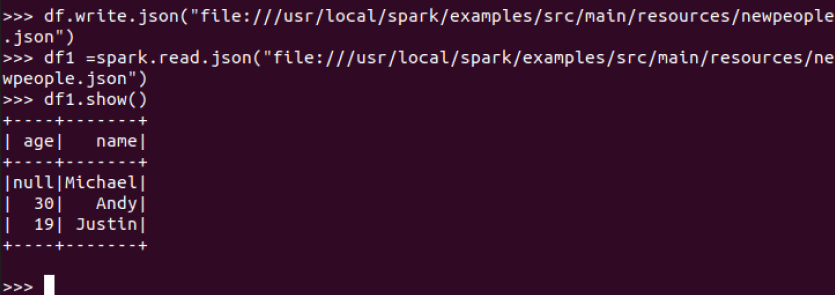

3.DataFrame的创建与保存

4.选择题:

4.1单选(2分)关于Shark,下面描述正确的是:(C)

A.Shark提供了类似Pig的功能

B.Shark把SQL语句转换成MapReduce作业

C.Shark重用了Hive中的HiveQL解析、逻辑执行计划翻译、执行计划优化等逻辑

D.Shark的性能比Hive差很多

4.2单选(2分)下面关于Spark SQL架构的描述错误的是:(D)

A.在Shark原有的架构上重写了逻辑执行计划的优化部分,解决了Shark存在的问题

B.Spark SQL在Hive兼容层面仅依赖HiveQL解析和Hive元数据

C.Spark SQL执行计划生成和优化都由Catalyst(函数式关系查询优化框架)负责

D.Spark SQL执行计划生成和优化需要依赖Hive来完成

4.3单选(2分)要把一个DataFrame保存到people.json文件中,下面语句哪个是正确的:(A)

A.df.write.json("people.json")

B.df.json("people.json")

C.df.write.format("csv").save("people.json")

D.df.write.csv("people.json")

4.4多选(3分)Shark的设计导致了两个问题:(AC)

A.执行计划优化完全依赖于Hive,不方便添加新的优化策略

B.执行计划优化不依赖于Hive,方便添加新的优化策略

C.Spark是线程级并行,而MapReduce是进程级并行,因此,Spark在兼容Hive的实现上存在线程安全问题,导致Shark不得不使用另外一套独立维护的、打了补丁的Hive源码分支

D.Spark是进程级并行,而MapReduce是线程级并行,因此,Spark在兼容Hive的实现上存在线程安全问题,导致Shark不得不使用另外一套独立维护的、打了补丁的Hive源码分支

4.5 多选(3分)下面关于为什么推出Spark SQL的原因的描述正确的是:(AB)

A.Spark SQL可以提供DataFrame API,可以对内部和外部各种数据源执行各种关系操作

B.可以支持大量的数据源和数据分析算法,组合使用Spark SQL和Spark MLlib,可以融合传统关系数据库的结构化数据管理能力和机器学习算法的数据处理能力

C.Spark SQL无法对各种不同的数据源进行整合

D.Spark SQL无法融合结构化数据管理能力和机器学习算法的数据处理能力

4.6多选(3分)下面关于DataFrame的描述正确的是:(ABCD)

A.DataFrame的推出,让Spark具备了处理大规模结构化数据的能力

B.DataFrame比原有的RDD转化方式更加简单易用,而且获得了更高的计算性能

C.Spark能够轻松实现从MySQL到DataFrame的转化,并且支持SQL查询

D.DataFrame是一种以RDD为基础的分布式数据集,提供了详细的结构信息

4.7多选(3分)要读取people.json文件生成DataFrame,可以使用下面哪些命令:(AC)

A.spark.read.json("people.json")

B.spark.read.parquet("people.json")

C.spark.read.format("json").load("people.json")

D.spark.read.format("csv").load("people.json")

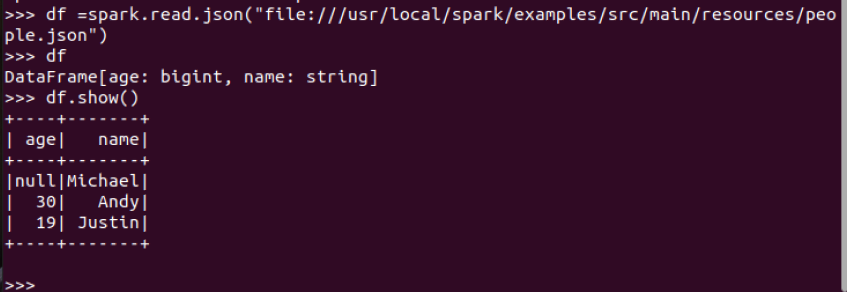

5. PySpark-DataFrame各种常用操作

基于df的操作:

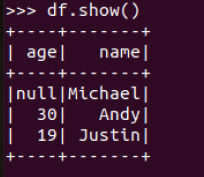

打印数据 df.show()默认打印前20条数据

打印概要 df.printSchema()

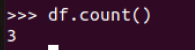

查询总行数 df.count()

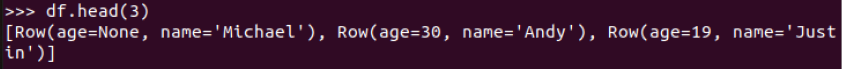

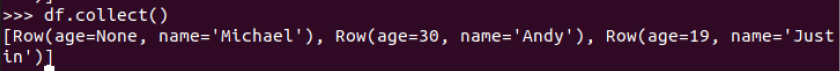

df.head(3) #list类型,list中每个元素是Row类

输出全部行 df.collect() #list类型,list中每个元素是Row类

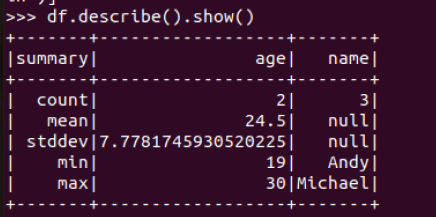

查询概况 df.describe().show()

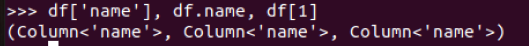

取列 df[‘name’], df.name, df[1]

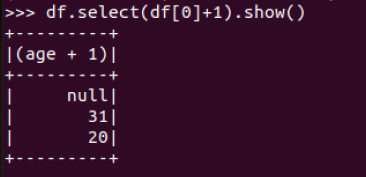

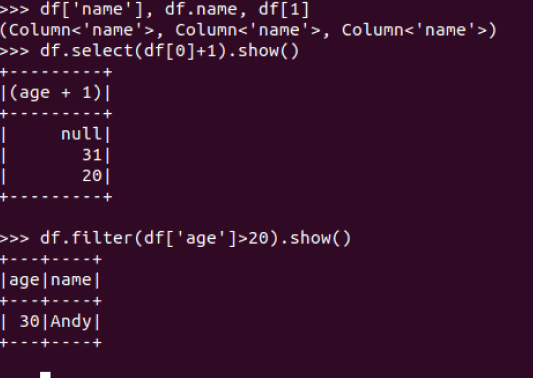

选择 df.select() 每个人的年龄+1

筛选 df.filter() 20岁以上的人员信息

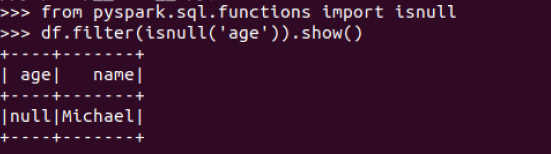

筛选年龄为空的人员信息

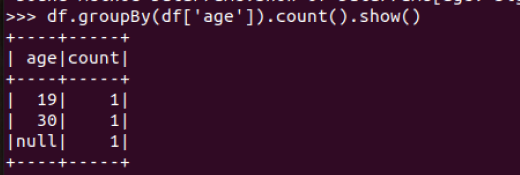

分组df.groupBy() 统计每个年龄的人数

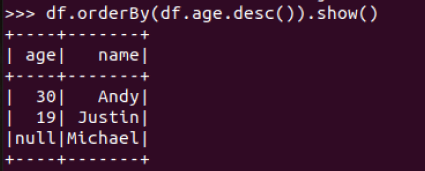

排序df.sortBy() 按年龄进行排序

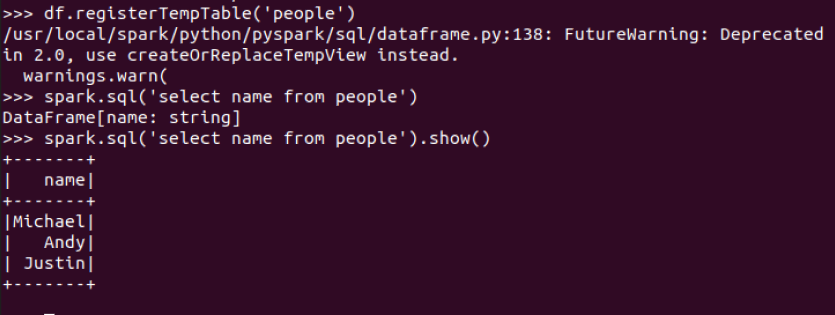

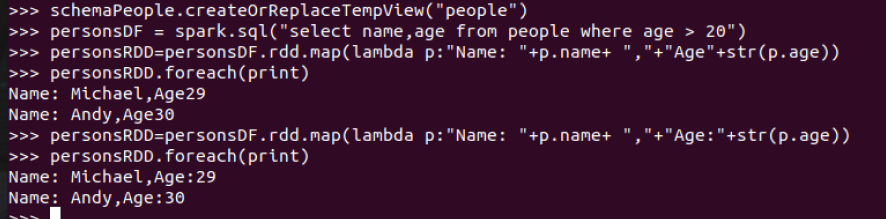

基于spark.sql的操作

创建临时表 df.registerTempTable('people')

spark.sql执行SQL语句 spark.sql('select name from people').show()

pyspark中DataFrame与pandas中DataFrame

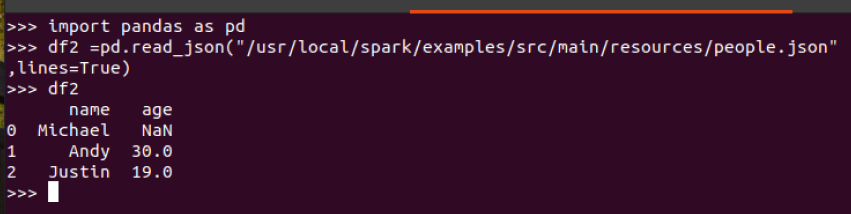

分别从文件创建两种DataFrame

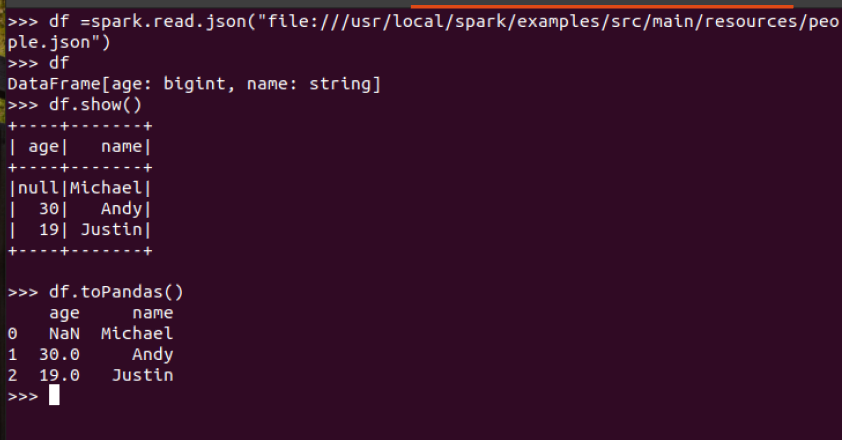

pyspark创建DataFrame

pandas中DataFrame

查看两种df的区别

(1) 地址写法不同

(2) pyspark的df要通过操作查看结果

(3) pandas的df自动加索引

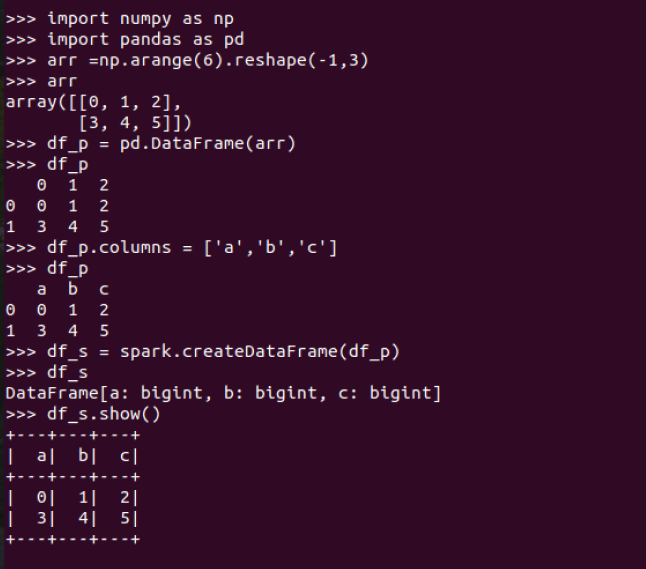

pandas中DataFrame转换为Pyspark中DataFrame

Pyspark中DataFrame转换为pandas中DataFrame

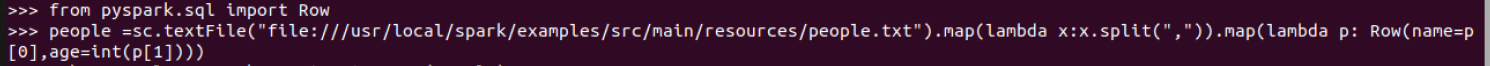

6.从RDD转换得到DataFrame

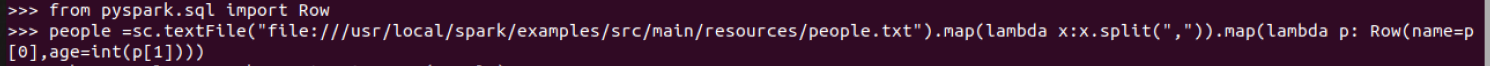

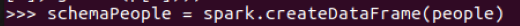

利用反射机制推断RDD模式

创建RDD sc.textFile(url).map(),读文件,分割数据项

每个RDD元素转换成 Row

由Row-RDD转换到DataFrame

6.2 使用编程方式定义RDD模式

#下面生成“表头”

#下面生成“表中的记录”

#下面把“表头”和“表中的记录”拼装在一起

6.选择题

6.1单选(2分)以下操作中,哪个不是DataFrame的常用操作:D

A.printSchema()

B.select()

C.filter()

D.sendto()

6.2多选(3分)从RDD转换得到DataFrame包含两种典型方法,分别是:AB

A.利用反射机制推断RDD模式

B.使用编程方式定义RDD模式

C.利用投影机制推断RDD模式

D.利用互联机制推断RDD模式

6.3多选(3分)使用编程方式定义RDD模式时,主要包括哪三个步骤:ABC

A.制作“表头”

B.制作“表中的记录”

C.制作映射表

D.把“表头”和“表中的记录”拼装在一起

浙公网安备 33010602011771号

浙公网安备 33010602011771号