论文精读《Bilateral Grid Learning for Stereo Matching Networks》2021 CVPR

title: Bilateral Grid Learning for Stereo Matching Networks date: 2023-04-10 08:35:32 tags: 论文精读 轻量级 39fps

|

作者 |

Bin Xu1, Yuhua Xu1,2,*, Xiaoli Yang1, Wei Jia2, Yulan Guo |

|

单位 |

奥比中光、合肥工业大学、中山大学 |

|

代码 |

https://github.com/YuhuaXu/BGNet |

|

期刊/会议 |

CVPR |

|

关键词 |

2021 |

0.摘要

- 问题:

立体匹配网络的实时性能在许多应用中都很重要,如自动驾驶、机器人导航和增强现实(AR)。尽管近年来立体匹配网络取得了重大进展,但平衡实时性能和准确性仍然具有挑战性。

- 工作内容:

在本文中,我们提出了一种新的基于学习双边网格中切片操作的保边代价体积上采样模块。切片层是无参数的,这允许我们有效地学习引导图的指导下,从低分辨率成本体积获得高分辨率的高质量成本体积。此外,我们设计了一个基于该模块的实时网络(命名为 BGNet)。

- 效果:

所提出的成本体积上采样模块可以无缝嵌入到许多现有的立体匹配网络中,例如 GCNet、PSMNet 和 GANet。由此产生的网络经过多次加速,同时保持相当的准确性。 BGNet性能优于现有的已发表的实时深度立体匹配网络,以及 KITTI 立体数据集上的一些复杂网络。

1. Introduction

本文的动机是提出一种解决方案,可以高分辨率回归视差图,以保持较高的精度,同时保持高效率。这项工作的主要贡献如下

我们的主要贡献是:

- 设计了一种基于学习双边网格的边缘保持成本体积上采样模块。它可以通过切片操作从低分辨率成本体积中高效地获得用于视差估计的高分辨率成本体积。有了这个模块,成本体积聚合(例如 3D 卷积)可以以低分辨率执行。所提出的成本量上采样模块可以无缝地嵌入到许多现有的网络中,例如GCNet、PSMNet和GANet。由此产生的网络可以在保持可比精度的同时加速 4∼29 倍。据我们所知,这是第一次将差分双边网格操作应用于深度立体匹配网络。

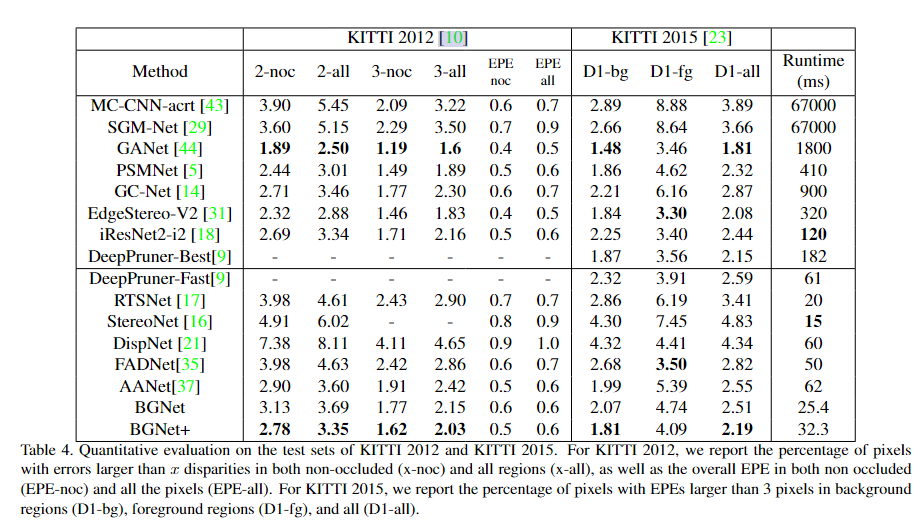

- 基于所提出的成本量上采样模块的优点,设计了一种实时立体匹配网络BGNet,该网络可以在KITTI 2012和KITTI 2015数据集上以39fps的速度处理立体声对。实验结果表明,在KITTI 2012和KITTI 2015立体数据集上,BGNet优于现有的实时深度立体匹配网络,以及GCNet、AANet、DeepPruner-Fast和FADNet等复杂网络。

2. Related Work

Stereo Matching Network.

Bilateral Grid

3. Method

受双边网格处理[7]的启发,我们提出了一个边缘感知的成本体积上采样模块。有了这个模块,我们可以以较低的分辨率执行大部分计算。同时,我们可以获得高分辨率上采样成本体积的精确视差预测。在本节中,我们首先详细描述所提出的成本量上采样模块。然后,我们证明了上采样模块可以作为许多现有的立体匹配网络中的嵌入模块。此外,基于该模块的优点,我们设计了一个实时立体匹配网络。

3.1. Cost Volume Upsampling in Bilateral Grid

如第 1 节所述,本文的目的是寻求一种能够以高分辨率回归视差图以保持高精度的解决方案,同时保持高效率。为了实现这一目标,我们设计了一个双边网格(CUBG)成本量上采样模块。CUBG 模块可以通过双边网格处理的切片操作将低分辨率(例如 1/8)计算的成本量上采样到高分辨率。

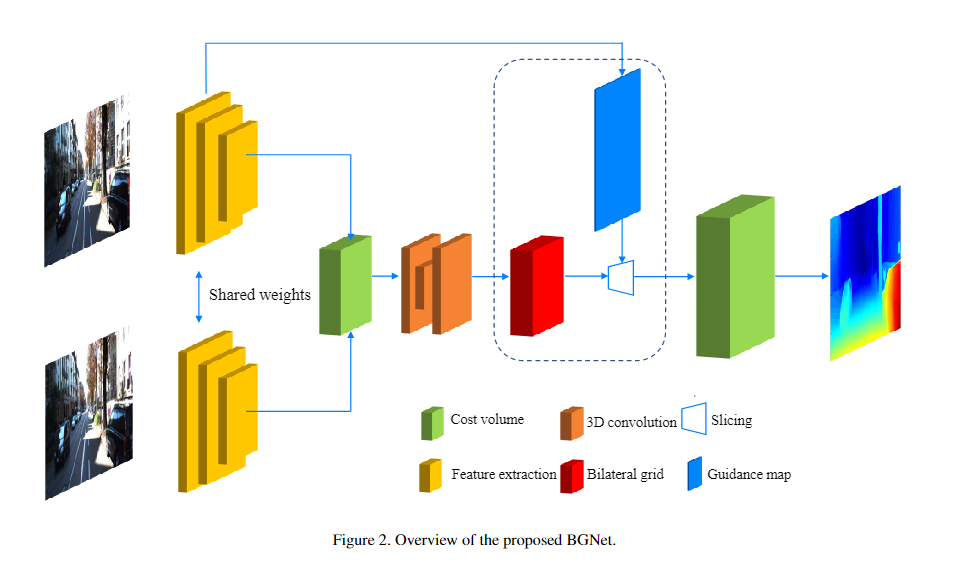

如图1所示,CUBG模块的输入是低分辨率成本体积CL和图像特征映射,输出是上采样的高分辨率成本体积。CUBG模块的操作包括双边网格创建和切片

Cost volume as a bilateral grid.

给定一个具有四个维度(包括宽度 x、高度 y、视差 d 和通道 c)在低分辨率(例如 1/8)的聚合成本体积 CL,从成本体积 CL 到双边网格 B 的转换很简单。在所有实验中,我们使用 3×3 的 3D 卷积来实现转换。双边网格 B 有四个维度:宽度 x、高度 y、视差 d 和引导特征 g。双边网格的值由 B(x, y, d, g) 表示。

Upsampling with a slicing layer.

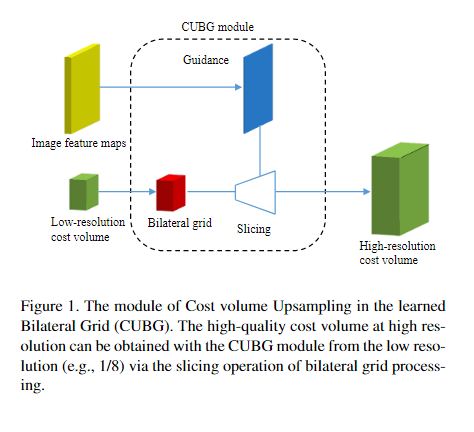

通过双边网格,我们可以通过切片层产生 3D 高分辨率成本体积 CH(CH ∈ RW,H,D )。该层在匹配成本的低分辨率网格中执行依赖于数据的查找。具体来说,切片操作是高分辨率二维引导图G的指导下四维双边网格中的线性插值。切片层是无参数的,可以有效地实现。形式上,切片操作定义为

其中 s ∈ (0, 1) 是网格维度 w.r.t 的高分辨率成本体积维度的宽度或高度比,sg ∈ (0, 1) 是网格 (lgrid) 的灰度级与引导图 lguid 的灰度级的比率。

引导图 G 是通过两个 1×1 卷积从高分辨率特征图生成的。请注意,每个像素的引导信息取决于它自己的特征向量。因此,可以获得尖锐的边缘。与[7]中设计的原始网格不同,本工作的双边网格是从成本量自动学习的。在实验中,网格的大小通常设置为 W/8 ×H/8 × Dmax/8 × 32,其中 W 和 H 分别是图像的宽度和高度。Dmax 是最大视差值。

3.2. Network Architecture

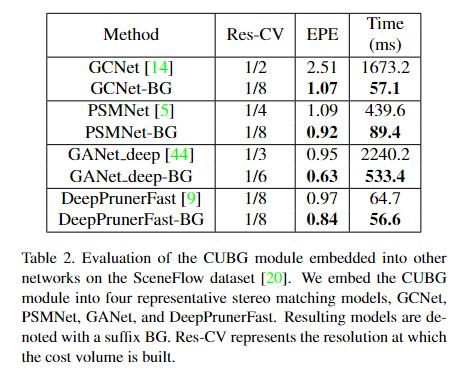

3.2.1 Embedded Module

所提出的CUBG模块可以无缝地嵌入到许多现有的端到端网络架构中。在这项工作中,我们将CUBG模块嵌入到四个具有代表性的立体匹配模型中:GCNet[14]、PSMNet[5]、GANet[44]和DeepPrunerFast[9]。生成的模型用后缀 BG(例如,GCNet-BG)表示。对于前三个网络,我们分别以 1/8、1/8 和 1/6 的分辨率重新构建成本量。然后,通过我们的CUBG模块对成本量进行上采样,分辨率分别为1/2、1/4和1/3。对于DeepPrunerFast,以1/8的分辨率将类似PatchMatch的上下界估计模块和窄代价体积聚合模块替换为全代价体积聚合。然后,通过CUBG模块对成本量进行上采样,分辨率为1/2。所有其他部分与原始实现相同。

3.2.2 BGNet

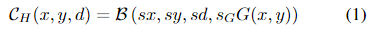

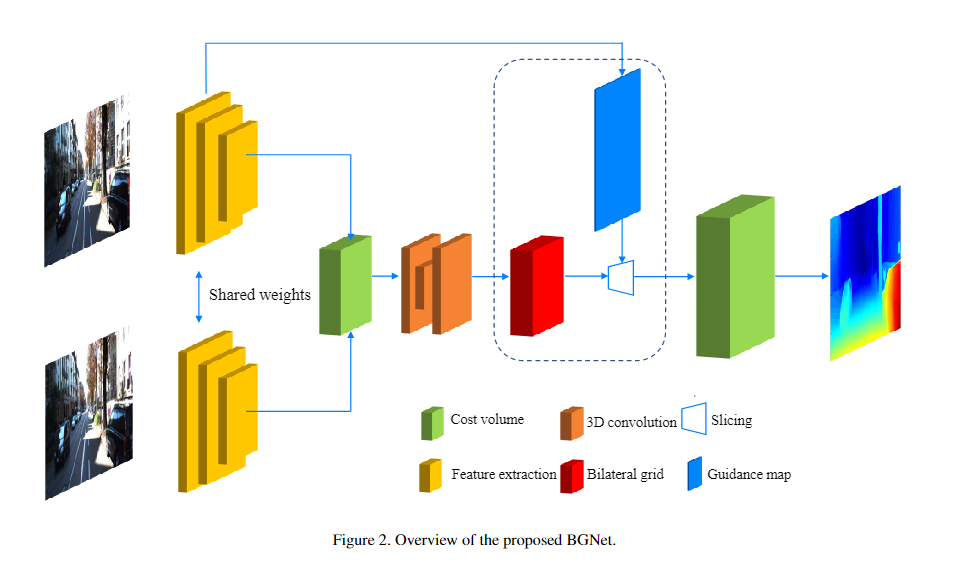

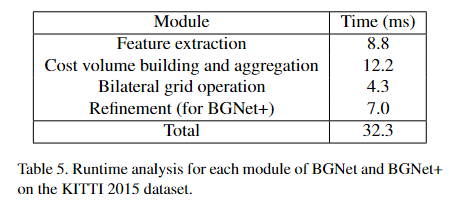

基于CUBG模块,我们还设计了一个高效的端到端立体匹配网络BGNet。图 2 概述了网络。该网络由特征提取、成本体积聚合、成本体积上采样和残差视差细化四个模块组成。它可以在KITTI立体数据集的分辨率实时运行。在下文中,我们将详细介绍这些模块。

Feature Extraction

类 ResNet 的架构广泛用于立体匹配网络 [5, 13]。我们利用类似的架构来提取图像特征进行匹配。对于前三层,使用步长为 2、1 和 1 的 3 × 3 内核的三个卷积对输入图像进行下采样。然后,遵循步长为1、2、3和1的四个残差层,以1/8分辨率快速生成一元特征。然后采用两个沙漏网络获取大的接受域和丰富语义信息。最后,将1/8分辨率的所有特征图串联起来,形成352个通道的特征图,生成成本体积。我们使用 fland fr 分别表示从左右图像中提取的最终特征图。

Cost Aggregation.

在特征提取模块之后,我们构建了一个组相关成本体积 [13] 进行聚合,它结合了连接体积和相关体积的优点。通过将特征通道划分为 N ̄g 组,计算视差级别 d 处的每个像素位置 (x, y) 的组相关,与 [13] 中的相同。在我们的实验中,N ̄g = 44。

在 PSMNet [5] 中,使用堆叠的沙漏架构来使用上下文信息优化成本量。在这里,考虑到效率,只使用一个沙漏架构来过滤成本量。具体来说,我们首先使用两个 3D 卷积将成本量的通道数从 44 减少到 16。然后,使用类似 U-Net 的 3D 卷积网络进行成本聚合,其中跳过连接被逐元素求和操作替换以减少计算成本。我们使用 CL 来表示 1/8 分辨率的聚合成本量。

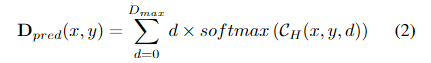

Disparity Regression.

对于高分辨率成本体积 CH,我们可以通过 sof t argmin 回归视差预测

损失函数。使用平滑 L1 损失 L 在最终预测 Dpred 上定义损失函数 L,

5. Experiments

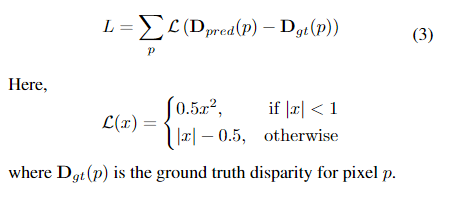

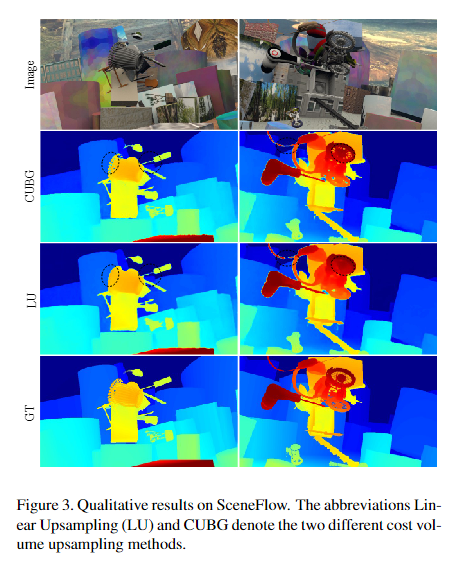

4.1 消融实验

4.2 评估CUBC模块

4.3 评估BGNet

4.4 模型切片

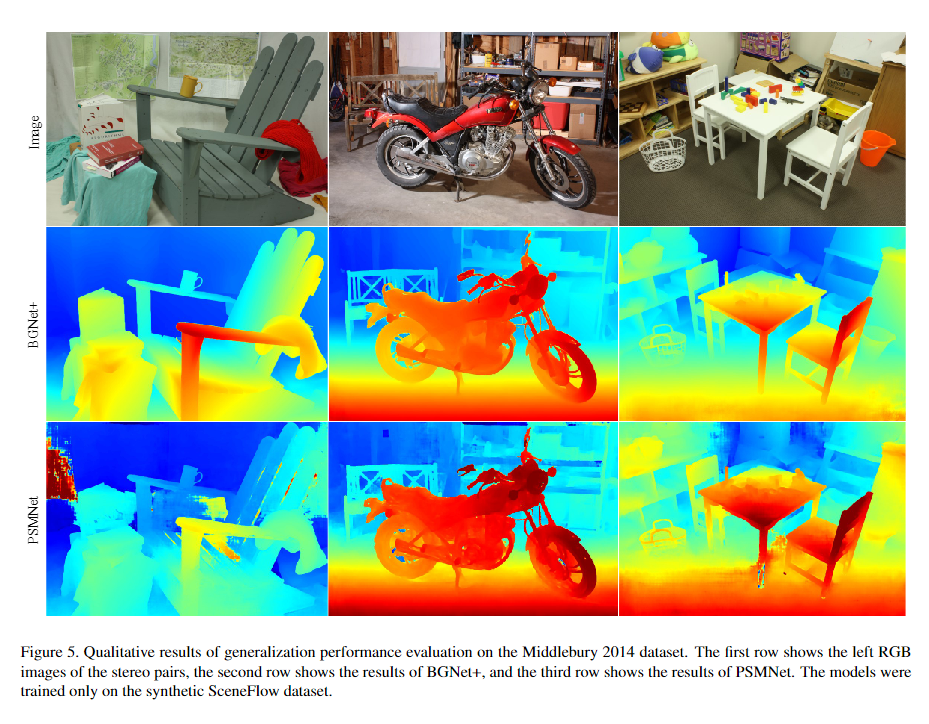

4.5 泛化表现

6. Conclusion

在本文中,我们在学习的双边网格中提出了一个成本体积上采样模块。上采样模块可以无缝地嵌入到许多现有的端到端网络架构中,并且可以在保持可比精度的同时显着加速这些网络。此外,基于这个上采样模块,我们设计了两个实时网络BGNet和BGNet+。在 KITTI 2012 和 KITTI 2015 数据集上,它们优于所有已发布的网络,计算时间小于 50 毫秒。实验结果也证明了我们的网络具有良好的泛化能力。

------------

参考: 1.

浙公网安备 33010602011771号

浙公网安备 33010602011771号