一、漫谈,数据库的发展史

观今宜鉴古,无古不成今 要了解一数据库的现在及将来,要首先了解数据库的过去……. 我们记录信息大致经历了以下几个历史…….

无库时代——文件系统

无论是通过石头、龟壳、羊皮卷、竹签记录信息的能力及其有限。当纸张出现后,虽然得到改善,但无法适应时代的发展。因为随着计算机的大范围应用,信息的产生、操作、共享、传输都呈现爆发式增长。这个时候,人们大多将数据信息保存到文件中。通过操作文件的形式,来处理数据信息。

层状数据库

顾名思义,层次状数据库使用树形结构表示实体间的关系,层次清晰,但是对于复杂的数据结构模型,树形深度比较大,较深结构会使数据形成冗余。

顾名思义,层次状数据库使用树形结构表示实体间的关系,层次清晰,但是对于复杂的数据结构模型,树形深度比较大,较深结构会使数据形成冗余。

网状数据库

网状结构数据库将数据库管理向前迈了一步,网状结构能够表示数据之间的联系,但是这也带了另一个问题,实体之间往往关系复杂且有相互纠缠,随着网越大,这种弊端越发凸显。

网状结构数据库将数据库管理向前迈了一步,网状结构能够表示数据之间的联系,但是这也带了另一个问题,实体之间往往关系复杂且有相互纠缠,随着网越大,这种弊端越发凸显。

关系型数据库

层状数据库和网状数据库欢快的使用着,直到——关系型数据库的出现。 虽然层状和网状结构解决了数据集中和数据共享的问题,但在数据独立性和抽象方面仍有很大的欠缺,直到1970年埃德加·科特提出了关系模型的概念,关系模型从此横行江湖。 关系模型将数据放在一种二维的存储结构中,整个数据库由若干个相互关联的二维表组成。关系型数据库解决了数据冗余问题,操作更加简化。

其他类型的数据库

数据库的分类

二、MySQL

为什么选择MySQL?

我将从以下几个角度来简要说明,数据库软件那么多,但为什么选择MySQL?

数据库排行榜

DB-Engines:https://db-engines.com/en/ranking

DB-Engines排名根据其受欢迎程度对数据库管理系统进行排名。排名每月更新一次,下图是截取日期是2021年2月份。

开源

开源就意味着免费!在中国,免费意味着什么?还用我多说吗? 当然,自从MySQL被Oracle收购后,就不太好了,但是我们还有mariaDB。

健壮的社区

这是一个要命的话题!MySQL有着健壮的社区,有专门的人员在维护这个社区。 一个资源丰富的社区,是一个软件成功的关键,这点从Python就可以看出来,Python的社区做的可以说是非常的好,大家可以在这个社区找到自己想要的东西,碰到问题能很快的找到解决办法,有了新的见解,也愿意写成博客之类的供大家参考,良性发展下,Python也越发展越好,这个道理同样适用于各个软件,包括MySQL,MySQL在世界范围内有着庞大的用户群,这些用户都在为MySQL的发展提供了直接或间接的力量。

稳定

没错,对于一个公司,尤其是互联网公司而言,开发出来的软件稳定肯定是要放在第一位的。更何况重中之重的数据库。MySQL经过几十年的发展,已经越来越稳定,极少出现宕机情况。

跨平台

MySQL支持AIX、FreeBSD、HP-UX、Linux、Mac OS、NovellNetware、OpenBSD、OS/2 Wrap、Solaris、Windows等多种操作系统

丰富的API接口

不管你数据库再厉害,那也是要搭配编程语言来实现具体的功能,丰富的API接口意味着有更多的编程语言可以与MySQL无缝协作,完成高效的开发。这些编程语言包括C、C++、Python、Java、Perl、PHP、Eiffel、Ruby和Tcl等

支持标准的SQL语句

世界范围内,有那么多的数据库软件,你有你的一套操作规则,他有他的一套操作规则,那么,一个公司在选择一个数据库,还要专门的学习这门数据库的相关规则,查询语法什么的,这就增了生产成本。为了解决这个问题,在1970年的埃德加·科德的一篇相当有影响力的论文中《一个对于大型共享型数据库的关系模型》描述了SQL这个结构化查询语言,主要应用与数据库的管理。后来这玩意儿成了数据库语言的标准。MySQL使用这种标准的SQL语言。

多种存储引擎

是的,MySQL有不同的引擎来支持不同的应用场景。

MySQL的模糊历史

MySQL的发展历程

让我们牢记一个人:天才少年蒙提。 MySQL的历史最早可以追溯到1979年,那时候,蒙提用BASIC设计了一个报表工具,没过多久,就用C语言重写了该工具,移植到了Unix平台,在当时,他只是一个很底层的面向报表的存储引擎,这个工具叫做Unireg。

- 1985年,他与Allan Larsson一起创办了TCX DataKonsult AB(一家瑞典数据仓库公司)。

- 1990年,在最初,他们只是自己设计了一个利用索引顺序取数据的方法,也就是ISAM(Indexed Sequential Access Method)存储引擎核心算法的前身,利用ISAM结合mSQL来实现需求。早期的时候,该公司主要为瑞典的一些大型零售商提供数据仓库服务,但是随着数据量增大、系统复杂度越来越高,ISAM和mSQL的组合逐渐不堪重负。在分析性能的瓶颈后,问题出现在mSQL上,后来他们抛弃了mSQL,重新开发一套功能类似的数据存储引擎,这就是ISAM存储引擎。

- 1995年,蒙提使用David Axmark编写第一版MySQL数据库,于1996年发布。需要说明的蒙提和David Axmark及Allan Larsson在同年创立了MySQL AB公司。

- 1996年,MySQL的1.0版本发布,当时真是面向一部分人,直到同年的10月,MySQL的3.11.1发布!是的,这群不按套路的天才们,直接跳过了2.x版本!最开始,只是提供了Solaris下的二进制版本。一个月后,有了Linux版本。 在接下来的两年里,MySQL不断的移植到各个平台下。

- 1999年至2000年,MySQL AB与Sleepycat合作开发Berkeley DB引擎,因为该引擎支持事物处理。

- 2000年,MySQL对旧的存储引擎进行了整理,命名为MyISAM。

- 2001年,Innobase公司与MySQL AB达成合作,共同开发InnoDB引擎,该引擎同样支持事物,并且支持行级锁。同年MySQL发布MySQL4.0版本,该版本正式支持InnoDB引擎。

- 2005年,MySQL发布了经典的5.0版本,MySQL在该版本中加入了游标、触发器、存储过程、视图等功能。同年,Oracle公司以迅雷不及掩耳之势收购了innobase公司。

- 2008年,Sun公司以10亿美金收购了MySQL AB公司。

- 2010年,可惜,Sun公司好景不长,因为2010年,Oracle公司又收购了Sun公司。从此,MySQL归Oracle所有。Oracle公司对MySQL分为社区版和企业版,社区版免费,企业版收费,当然,也提供更多的功能!同年4月22日MySQL5.5和MySQL Cluster7.1版本发布。

- 2013年,2013年2月6日MySQL5.6发布,InnoDB性能和复制一致性加强。

- 2014年,2014年4月4日Oracle发布MySQL里程碑式的版本MySQL5.7版本,此版本满足网络、云和嵌入式需求,性能更强、扩展性和可靠性得到提高。

- 2016年,2016年9月12日,Oracle正式发布MySQL8.0版本。没错,直接跳过了6.x、7.x版本。

sakila

我们都知道MySQL的logo是海豚(sakila),而sakila的由来则是来自MySQL AB公司创始人从"海豚命名"竞赛中得来的,这个sakila是来自于坦桑尼亚的Arusha的一个小镇的名字。

目前主流的MySQL版本及分支

目前较为主流的MySQL版本:

其他版本:

- Oracle: - MySQL官方版

- 红帽: - MariaDB,MySQL被Oracle收购后,MySQL的开发者就搞了个MariaDB继续开源!感谢大佬!!!

- Percona: - PerconaDB,了解即可。

建议版本选择:

- Oracle的官方版本,5.6和5.7,当然,目前还是推荐5.7。

- GA(稳定发布)

如何获取MySQL:

- 企业版Enterprise,互联网行业一般不选择

- 社区版,推荐

- 源码包,通用二进制

如何学好MySQL

SQL介绍

SQL历史

SQL是一种结构化的查询语言。

关于SQL的历史:

图片来自维基百科:https://zh.wikipedia.org/wiki/SQL。

MySQL5.7以后符合SQL92标准的严格模式,通过sql_mode参数来控制。

常用的SQL分类

- DDL(Data Definition Language):数据定义语言,就是我们在创建表的时候用到的一些sql,比如说:CREATE、ALTER、DROP等。DDL主要是用在定义或改变表的结构,数据类型,表之间的链接和约束等初始化工作上。

- DCL(Data Control Language):数据控制语言,是用来设置或更改数据库用户或角色权限的语句,包括(grant,deny,revoke等)语句。这个比较少用到。

- DML(Data Manipulation Language):数据操作语言,就是我们最经常用到的 SELECT、UPDATE、INSERT、DELETE。 主要用来对数据库的数据进行一些操作。

MySQL相关概念

连接

MySQL提供了两种连接方式:

- TCP/IP方式(本地、远程):

mysql -uroot -p123 -h 10.0.0.1 -P330

- Socket方式(仅本地):

mysql -uroot -p123 -S /tmp/mysql.sock

当我们本地连接MySQL的时候,默认用的是socket方式,一般在配置文件中有体现:

1

2

3

4

5

6

7

8

9

10

11

|

[root@cs /]# cat /etc/my.cnf

[mysqld]

user=mysql

basedir=/opt/mysql

datadir=/data/mysql

server_id=6

port=3306

socket=/tmp/mysql.sock

[mysql]

socket=/tmp/mysql.sock

prompt=3306 [\\d]>

|

如上socket指向的/tmp/mysql.sock文件就是socket文件,通过这个文件进行连接;我们也能在本地找到这个文件:

[root@cs /]# ll /tmp/mysql.sock

srwxrwxrwx 1 mysql mysql 0 8月 14 16:28 /tmp/mysql.sock

实例

MySQL实例由以下几部分组成:

- MySQL后台守护进程

- Master Thread

- Work Thread

- 预分配的内存

一台物理机上,通常可以部署一个实例;当然为了最大化的利用硬件性能,也可以部署多个实例。

MySQL架构

MySQL架构总共四层:

-

首先,最上层的服务并不是MySQL独有的,大多数给予网络的客户端/服务器的工具或者服务都有类似的架构。比如:连接处理、授权认证、安全等。

-

第二层的架构包括大多数的MySQL的核心服务。包括:查询解析、分析、优化、缓存以及所有的内置函数(例如:日期、时间、数字和加密函数)。同时,所有的跨存储引擎的功能都在这一层实现:存储过程、触发器、视图等。

-

第三层包含了存储引擎。存储引擎负责MySQL中数据的存储和提取。服务器通过API和存储引擎进行通信。这些接口屏蔽了不同存储引擎之间的差异,使得这些差异对上层的查询过程透明化。存储引擎API包含十几个底层函数,用于执行“开始一个事务”等操作。但存储引擎一般不会去解析SQL(InnoDB会解析外键定义,因为其本身没有实现该功能),不同存储引擎之间也不会相互通信,而只是简单的响应上层的服务器请求。

-

第四层包含了文件系统,所有的表结构和数据以及用户操作的日志最终还是以文件的形式存储在硬盘上。

MySQL中一条SQL的执行过程:

-

由客户端向mysqld发送SQL语句

-

连接层

- 提供连接协议:TCP/IP、SOCKET

- 提供验证:用户、密码、IP、SOCKET

- 提供专用连接线程:接收SQL、返回结果,我们可以通过下面的语句来查看到当前有几个客户端连接:

1

2

3

4

5

6

7

8

|

mysql> show processlist;

+----+------+-----------+------+---------+------+----------+------------------+

| Id | User | Host | db | Command | Time | State | Info |

+----+------+-----------+------+---------+------+----------+------------------+

| 3 | root | localhost | NULL | Sleep | 20 | | NULL |

| 4 | root | localhost | NULL | Query | 0 | starting | show processlist |

+----+------+-----------+------+---------+------+----------+------------------+

2 rows in set (0.00 sec)

|

-

SQL层:

- 接收上层传送过来的SQL语句

- 语法验证模块:验证语句语法,是否满足

SQL_MODE

- 语义检查:判断SQL语句的类型

- DDL:数据定义语言

- DCL:数据控制语言

- DML:数据操作语言

- DQL:数据查询语言

- ………

- 权限检查:用户对库表有没有相关权限

- 解析器:进行SQL预处理,产生执行计划

- 优化器:根据解析器得出多种执行计划,进行选择最优的执行计划

- 代价模型:资源(CPU、IO、MEM)的损耗评估性能情况

- 执行器:根据最优执行计划,执行SQL语句,产生执行结果,数据在磁盘的某个位置上

- 根据查询缓存(默认是关闭的),会使用redis、tair替代查询缓存功能

- 提供日志记录:binlog,默认是关闭的

-

存储引擎层(类似Linux中的文件系统):根据SQL层执行的结果,从磁盘上拿数据,将16进制的磁盘数据,交由SQL结构化成表,由连接层的专用线程返回给用户

逻辑结构

在MySQL中,逻辑结构由库和表组成,并且各自有各自的规范:

库的物理结构

库相当于目录(文件夹)。

表的物理结构

在磁盘上,表的物理存储根据存储引擎的不同而有所不同,目前常用的有两种:

MyIASM:

- user.frm:存储列相关信息

- user.MYD:存储记录

- user.MYI:索引

INNODB:

[root@cs mysql]# ll user.*

-rw-r----- 1 mysql mysql 10816 6月 8 09:25 user.frm

-rw-r----- 1 mysql mysql 396 6月 8 09:51 user.MYD

-rw-r----- 1 mysql mysql 4096 6月 8 09:51 user.MYI

[root@cs mysql]# ll time_zone.*

-rw-r----- 1 mysql mysql 8636 6月 8 09:25 time_zone.frm

-rw-r----- 1 mysql mysql 98304 6月 8 09:25 time_zone.ibd

如上示例是两种不同存储引擎的表的物理结构。

我们可以对应来理解:

- 数据库相当于文件夹。

- 数据表相当于文件夹内的Excel表。

- 记录相当于Excel表中的一行行数据。

只不过MySQL对这些有更严格的规范。

各平台安装MySQL

本小节将介绍,如何下载MySQL和安装MySQL。

download

这里先告诉大家怎么下载MySQL。

打开官网下载地址:https://downloads.mysql.com/archives/community/,按照截图所示下载即可。

Windows

centos

请先下载好安装包,再往下看如何进行安装和相关配置的。

for Windows

win10 + mysql-5.7.20-winx64.zip

注意:后续所有在Windows终端中的操作,都必须是以管理员身份运行的终端。

install

下载到本地的安装包是zip包,选择一个指定目录进行解压,解压的过程就是安装的过程,解压后的位置就是MySQL的安装位置。 注意,安装目录不允许有中文、空格和其他特殊字符。 如下截图,我将MySQL解压并安装到C盘的根目录:

配置环境变量

拷贝安装目录内的bin路径,并将其添加到系统的环境变量中。

执行初始化 在任意路径下,以管理员的身份打开终端执行:

1

|

mysqld --initialize-insecure

|

--initialize-insecure,表示不安全的初始化。这个参数来自于--initialize参数,在MySQL5.7版本中,在初始化过程中,会生成一个临时密码(临时密码文件在data目录内的"你的主机名.err"文件),后续处理相对麻烦,所以这里改为--initialize-insecure,初始化时将root用户的登录密码设置为空。 注意,如果报错:提示缺少MSVCP120.dll文件的话,后面有解决办法。 初始化成功如下图: 初始化成功的另一个标志是,在MySQL的安装目录中,会多个data目录,这个data目录是是MySQL在初始化过程中创建的数据目录。

初始化成功的另一个标志是,在MySQL的安装目录中,会多个data目录,这个data目录是是MySQL在初始化过程中创建的数据目录。

如果你没有发现data目录,说明初始化过程有些问题,重新以管理员的身份打开终端执行初始化命令:

如上图中的ERROR报错,说初始化过程中,data目录内存在文件,初始化被终止。这是因为之前初始化成功了,data目录被创建,期内也有了文件。 当然有了这些提示,说明整个初始化过程成功了。

添加MySQL服务到系统的服务中并启动MySQL 这一步是将MySQL服务添加到系统的服务中,并且设置为自动。然后,我们就可以使用net命令来管理MySQL服务了。注意,也必须是在以管理员身份运行的终端中才能使用net命令管理MySQL服务。

现在系统的服务中就可以找到MySQL了。

现在系统的服务中就可以找到MySQL了。 但此时MySQL服务还没有启动,你可以在服务中点击启动,也可以在终端中使用net命令来启动/关闭MySQL服务。

但此时MySQL服务还没有启动,你可以在服务中点击启动,也可以在终端中使用net命令来启动/关闭MySQL服务。 ok,现在MySQL服务正常启动了,并且,由于系统服务中的MySQL服务设置的是自动,下次系统启动时,MySQL服务也默认启动了。

ok,现在MySQL服务正常启动了,并且,由于系统服务中的MySQL服务设置的是自动,下次系统启动时,MySQL服务也默认启动了。

测试 当MySQL服务正常启动后,我们就可以尝试使用客户端连接并操作MySQL了。 PS:后续使用客户端连接M操作MySQL时,终端就没有"以管理员身份运行终端"这个要求了,普通终端也可以。

PS:后续使用客户端连接M操作MySQL时,终端就没有"以管理员身份运行终端"这个要求了,普通终端也可以。

创建密码 以管理员的身份打开终端执行:

1

|

mysqladmin -uroot -p password 123

|

ok,在Windows平台安装MySQL完事了。

可能的报错,缺少MSVCP120.dll文件

当执行初始化的时候,提示缺少MSVCP120.dll文件。

一般新的系统容易缺少一些依赖库。这个报错(可能)就是系统缺少Visual C ++可再发行组件包。

扩展:什么是Visual C ++可再发行组件包?

Visual C ++可再发行组件是使用Microsoft的Visual Studio软件开发环境构建的程序或游戏所需的DLL(动态链接库)文件。当程序需要DLL或其他支持文件才能运行时,这称为依赖项。

原文链接:https://www.groovypost.com/howto/fix-visual-c-plus-plus-redistributable-windows-10/

解决办法

-

打开microsoft官网:https://www.microsoft.com/en-us/download/details.aspx?id=40784,点击下载:

-

根据系统位数选择下载:

-

以管理员的身份运行,然后默认安装即可。

-

重新以管理员身份打开终端,执行初始化步骤吧!

1

|

mysqld --initialize-insecure

|

for centos

install

在安装之前,如果你的系统曾经安装过Mariadb,请先卸载:

好了,开始吧!

- 安装依赖包:

yum install -y epel-release

yum update -y

yum install -y cmake gcc-c++ ncurses-devel perl-Data-Dumper boost-doc boost-devel libaio-devel

- 下载、解压缩、重命名,当然,你也可以把原来的压缩包删除掉:

[root@cs ~]# cd /opt/

[root@cs opt]# wget https://downloads.mysql.com/archives/get/p/23/file/mysql-5.7.20-linux-glibc2.12-x86_64.tar.gz

[root@cs opt]# tar -xvf mysql-5.7.20-linux-glibc2.12-x86_64.tar.gz

[root@cs opt]# mv mysql-5.7.20-linux-glibc2.12-x86_64 mysql

[root@cs opt]# rm -rf mysql-5.7.20-linux-glibc2.12-x86_64.tar.gz

[root@cs opt]# ls

mysql

- 添加环境变量:

[root@cs opt]# vim /etc/profile

# 添加如下内容

export PATH=/opt/mysql/bin:$PATH

# 然后source生效

[root@cs opt]# source /etc/profile

- (如果已有请忽略)建立mysql用户、用户组,后续使用该用户用来管理MySQL:

[root@cs opt]# useradd mysql

- 创建相关目录并授权:

[root@cs opt]# mkdir /data/mysql -p

[root@cs opt]# chown -R mysql:mysql /opt/mysql/*

[root@cs opt]# chown -R mysql:mysql /data/*

其中:

/opt/mysql/是MySQL软件所在目录。/data/mysql是将来存放MySQL数据的目录。

- 初始化数据库:

# 保证/data/mysql/目录是空的,避免不必要的问题

rm -rf /data/mysql/*

mysqld --initialize-insecure --user=mysql --basedir=/opt/mysql --datadir=/data/mysql

[root@cs opt]# rm -rf /data/mysql/*

[root@cs opt]# mysqld --initialize-insecure --user=mysql --basedir=/opt/mysql --datadir=/data/mysql

2020-06-08T01:25:34.199239Z 0 [Warning] TIMESTAMP with implicit DEFAULT value is deprecated. Please use --explicit_defaults_for_timestamp server option (see documentation for more details).

2020-06-08T01:25:34.357149Z 0 [Warning] InnoDB: New log files created, LSN=45790

2020-06-08T01:25:34.381441Z 0 [Warning] InnoDB: Creating foreign key constraint system tables.

2020-06-08T01:25:34.436113Z 0 [Warning] No existing UUID has been found, so we assume that this is the first time that this server has been started. Generating a new UUID: f352c664-a926-11ea-a90d-000c29872edd.

2020-06-08T01:25:34.437057Z 0 [Warning] Gtid table is not ready to be used. Table 'mysql.gtid_executed' cannot be opened.

2020-06-08T01:25:34.438213Z 1 [Warning] root@localhost is created with an empty password ! Please consider switching off the --initialize-insecure option.

上述参数,并不难理解:

--initialize-insecure,表示不安全的初始化。这个参数来自于--initialize参数,在MySQL5.7版本中,在初始化成功后,会生成一个临时密码,相对比较麻烦,所以这里改为--initialize-insecure,初始化成功后,密码为空。--user=mysql,管理MySQL的用户是mysql。--basedir=/opt/mysql,是你MySQL的安装目录。--datadir=/data/mysql,是管理数据的目录。

在初始化完成后,你的MySQL的数据目录,应该有这些文件:

1

2

3

4

5

6

7

8

9

10

|

[root@CS opt]# ll /data/mysql/

总用量 110628

-rw-r----- 1 mysql mysql 56 11月 27 14:21 auto.cnf

-rw-r----- 1 mysql mysql 419 11月 27 14:21 ib_buffer_pool

-rw-r----- 1 mysql mysql 12582912 11月 27 14:21 ibdata1

-rw-r----- 1 mysql mysql 50331648 11月 27 14:21 ib_logfile0

-rw-r----- 1 mysql mysql 50331648 11月 27 14:21 ib_logfile1

drwxr-x--- 2 mysql mysql 4096 11月 27 14:21 mysql

drwxr-x--- 2 mysql mysql 8192 11月 27 14:21 performance_schema

drwxr-x--- 2 mysql mysql 8192 11月 27 14:21 sys

|

- 编写配置文件,编辑

vim /etc/my.cnf,内容如下:

1

2

3

4

5

6

7

8

9

10

|

[mysqld]

user=mysql

basedir=/opt/mysql

datadir=/data/mysql

server_id=6

port=3306

socket=/tmp/mysql.sock

[mysql]

socket=/tmp/mysql.sock

prompt=3306 [\\d]>

|

prompt参数为登录进MySQL客户端的提示信息,当你use到指定的数据库中,该库名将显示在中括号内。

管理MySQL服务的几种方式

第一种,使用MySQL自带的mysql.server启动/停止/重启MySQL服务。

mysql.server在哪呢?在MySQL安装目录中的support-files目录中:

1

2

3

|

[root@CS opt]# cd /opt/mysql/support-files/

[root@CS support-files]# ls

magic mysqld_multi.server mysql-log-rotate mysql.server

|

我们用mysql.server来管理MySQL:

[root@CS support-files]# ./mysql.server start

Starting MySQL.Logging to '/data/mysql/CS.err'.

SUCCESS!

[root@CS support-files]# ./mysql.server restart

Shutting down MySQL.. SUCCESS!

Starting MySQL. SUCCESS!

[root@CS support-files]# ./mysql.server stop

Shutting down MySQL.. SUCCESS!

第二种,使用service管理MySQL服务。

在centos6中使用service管理服务,所以,我们来演示下如何使用service来管理MySQL服务:

1

2

3

4

5

6

7

8

|

[root@cs opt]# cp /opt/mysql/support-files/mysql.server /etc/init.d/mysqld

[root@CS opt]# service mysqld start

Starting MySQL. SUCCESS!

[root@CS opt]# service mysqld restart

Shutting down MySQL.. SUCCESS!

Starting MySQL.

[root@CS opt]# service mysqld stop

Shutting down MySQL.. SUCCESS!

|

第三种,配置systemctl管理MySQL服务,也是推荐使用的方式。

在centos7版本中,可以使用systemctl来替代service了。

编辑vim /etc/systemd/system/mysqld.service文件,内容如下:

[Unit]

Description=MySQL Server

Documentation=man:mysqld(8)

Documentation=http://dev.mysql.com/doc/refman/en/using-systemd.html

After=network.target

After=syslog.target

[Install]

WantedBy=multi-user.target

[Service]

User=mysql

Group=mysql

ExecStart=/opt/mysql/bin/mysqld --defaults-file=/etc/my.cnf

LimitNOFILE = 5000

编辑内容中,只需要将ExecStart=/opt/mysql/bin/mysqld的路径改为你的MySQL安装目录即可,其他的照抄。

完事之后,你就可以使用systemctl命令来管理MySQL服务了,可用命令:

systemctl start mysqld

systemctl restart mysqld

systemctl stop mysqld

systemctl status mysqld

systemctl enable mysqld

此时,你可以在任意位置执行mysql来进入MySQL客户端了,但是此时登录还不要密码。

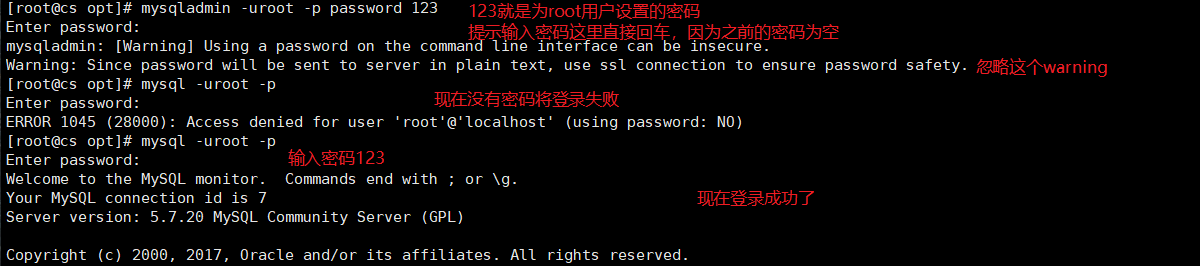

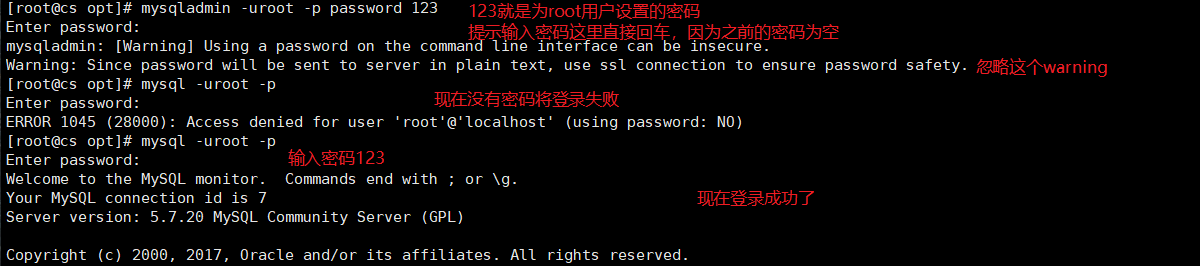

创建密码 此时,我们能正常的启动/停止MySQL服务了,但在初始化MySQL的时候,我们还没有配置登录密码,现在,我们来创建密码。 为root用户(该用户为本地用户)创建密码:

mysqladmin -uroot -p password 123

-p password后面跟你要为root用户设置的密码。

(可选),你也可以使用以下命令查看MySQL监听端口

netstat -lnp|grep 3306

ss -lnp|grep 3306

ps -ef|grep mysqld

用户管理

用户名@白名单

MySQL支持用户名@白名单的方式连接,有以下几种方式:

| 连接方式 | 描述 |

|---|

wordpress@'10.0.0.%' |

只允许10网段连接 |

wordpress@'%' |

所有地址 |

wordpress@'10.0.0.200' |

只允许某一个地址链接 |

wordpress@'localhost' |

只允许本地连接 |

wordpress@'db03' |

只允许别名是db03连接 |

wordpress@'10.0.0.5%' |

只允许IP地址末尾51~59的连接 |

wordpress@'10.0.0/255.255.254.0' |

只允许254这个网段的连接 |

白名单用户管理操作:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

|

mysql> create user zhangkai@'localhost' identified by '123';

Query OK, 0 rows affected (0.00 sec)

mysql> select user,host from mysql.user;

+---------------+-----------+

| user | host |

+---------------+-----------+

| mysql.session | localhost |

| mysql.sys | localhost |

| root | localhost |

| zhangkai | localhost |

+---------------+-----------+

4 rows in set (0.00 sec)

mysql> alter user zhangkai@'localhost' identified by '1234';

Query OK, 0 rows affected (0.00 sec)

mysql> drop user zhangkai@'localhost';

Query OK, 0 rows affected (0.00 sec)

mysql> select user,host from mysql.user;

+---------------+-----------+

| user | host |

+---------------+-----------+

| mysql.session | localhost |

| mysql.sys | localhost |

| root | localhost |

+---------------+-----------+

3 rows in set (0.00 sec)

|

上面示例演示了白名单用户的增删改查的操作。不过这个白名单用户仅能用来登录到MySQL,权限有限!

常用的权限:

ALL:

SELECT,INSERT, UPDATE, DELETE, CREATE, DROP, RELOAD, SHUTDOWN,

PROCESS, FILE, REFERENCES, INDEX, ALTER, SHOW DATABASES, SUPER,

CREATE TEMPORARY TABLES, LOCK TABLES, EXECUTE, REPLICATION SLAVE,

REPLICATION CLIENT, CREATE VIEW, SHOW VIEW, CREATE ROUTINE, ALTER ROUTINE,

CREATE USER, EVENT, TRIGGER, CREATE TABLESPACE

ALL : 以上所有权限,一般是普通管理员拥有的

with grant option:超级管理员才具备的,给别的用户授权的功能

创建用户并授权:

1

2

3

4

5

6

7

|

mysql> grant all on database_name.* to zhangkai@'localhost' identified by '123';

-- grant:授权命令

-- all:权限

-- on:为什么对象设置权限

-- wordpress.*:wordpress库下的所有表;需要注意的是,wordpress库如果不存在,该语句也能执行

-- zhangkai@'localhost':指定的用户

-- 修改权限还是使用grant命令来做,grant命令可以反复使用

|

一般的,应用用户的权限应该是有限的,常用的也就是select insert update delete。

PS:在MySQL8.0之后,grant命令有了新特性:

- 创建用户和授权分开

grant命令不再支持创建用户,也不支持修改密码- 授权之前,必须要创建用户

也就是,以后创建用户和授权操作要分开来做。

另外,权限范围有几种写法:

| 权限 | 描述 |

|---|

*.* |

所有库下的所有表,使用与管理员用户 |

wordpress.* |

指定库下的所有表,适用于开发和应用用户 |

wordpress.t1 |

指定库下的指定表,用的不多 |

那么,如何查看用户的权限信息和如何回收权限呢?

1

2

3

4

|

-- 查看用户权限

show grants for zhangkai@'localhost';

-- 回收权限

revoke delete,drop on database@table from zhangkai@'localhost';

|

关于查看用户权限,需要补充一些内容。

- 使用

create user root@'%' identified by '123'创建的用户,仅能用来登录MySQL,别的啥也干不了。

1

2

3

4

5

6

7

|

mysql> show grants for root@'192.168.85.%';

+---------------------------------------------+

| Grants for root@192.168.85.% |

+---------------------------------------------+

| GRANT USAGE ON *.* TO 'root'@'192.168.85.%' |

+---------------------------------------------+

1 row in set (0.00 sec)

|

正如上例的关键字USAGE表示该用户只有登录MySQL权限。想要别的权限,需要自己用有grant权限的账号为该账号授权,因为这个账号此时也没有授权这个权限。

- 关于

WITH GRANT OPTION,当你查看权限时,发现账号拥有ALL权限外,还有 WITH GRANT OPTION权限。

1

2

3

4

5

6

7

8

|

mysql> show grants for root@'localhost';

+---------------------------------------------------------------------+

| Grants for root@localhost |

+---------------------------------------------------------------------+

| GRANT ALL PRIVILEGES ON *.* TO 'root'@'localhost' WITH GRANT OPTION |

| GRANT PROXY ON ''@'' TO 'root'@'localhost' WITH GRANT OPTION |

+---------------------------------------------------------------------+

2 rows in set (0.00 sec)

|

WITH GRANT OPTION表示该用户可以将自己拥有的权限授权给别人。

注意,如果在授权时没有加WITH GRANT OPTION参数,就表示该账户的权限只能自己用,而不能赋予别人,所以你在授权时要考虑好加不加WITH GRANT OPTION参数。

1

2

|

grant all on *.* to root@'%' identified by '123';

grant all on *.* to root@'%' identified by '123' with grant option;

|

也就是,上面两条命令你要事情况而选择。

本地管理员用户密码忘记了怎么办

解决思路是:

- 关闭MySQL服务

mysqld_safe模式启动,即关闭MySQL的用户密码验证模块,也就是不加载授权表,然后禁止远程连接,仅能通过本地socket链接- 无密码登登录到MySQL

- 修改密码

- 重启MySQL

流程:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

|

[root@cs mysql]# systemctl stop mysqld

[root@cs mysql]# mysqld_safe --skip-grant-tables --skip-networking &

[root@cs mysql]# mysql

Welcome to the MySQL monitor. Commands end with ; or \g.

Your MySQL connection id is 3

Server version: 5.7.20 MySQL Community Server (GPL)

Copyright (c) 2000, 2017, Oracle and/or its affiliates. All rights reserved.

Oracle is a registered trademark of Oracle Corporation and/or its

affiliates. Other names may be trademarks of their respective

owners.

Type 'help;' or '\h' for help. Type '\c' to clear the current input statement.

mysql> flush privileges;

Query OK, 0 rows affected (0.00 sec)

mysql> alter user root@'localhost' identified by '123';

Query OK, 0 rows affected (0.00 sec)

mysql> exit;

Bye

[root@cs mysql]# pkill mysqld

[root@cs mysql]# systemctl start mysqld

|

相关参数解释:

--skip-grant-tables:关闭授权表,这样就可以无验证登录了。--skip-networking:关闭TCP/IP,该参数的目的是只能本地通过socket连接登录,保证修改密码时的安全性。&是后台执行。- 至于在修改密码前的

flush privileges操作是因为修改密码还是要使用授权表,但是由于mysqld_safe模式启动授权表没有从磁盘加载到内存,所以直接执行alter命令会失败,所以要使用flush privileges命令将授权表加载到内存中,才能修改密码成功。

连接管理

连接参数

前文中已经说过,MySQL支持socket和TCP/IP两种连接方式。

[root@cs mysql]# mysql -uroot -p -S /tmp/mysql.sock

Enter password:

-S指定socket来连接;一般我们不加-S就可以登录到MySQL中,是因为MySQL使用的socket文件默认的存放在/tmp/mysql.sock中,或者你在配置文件中指定,这样我们不指定也能找到socket文件。另外,一般使用socket登录都是本地登录,所以,你要保证你的登录用户是有localhost的权限的。

而使用TCP/IP的方式就是:

[root@cs mysql]# mysql -uroot -p -h192.168.85.133 -P3306

Enter password:

其他常用的参数:

-u:用户名。-p:密码。-h:IP。-P:port。-S:socket文件。-e:免交互执行命令。<:导入SQL脚本。

PS:

- 参数和值之间可以挨着也可以空格分割。

- 如果

TCP/IP和socket连接同时使用,默认TCP/IP方式优先。

1

2

3

4

5

6

7

8

9

|

[root@cs mysql]# mysql -uzhangkai -p -h 192.168.85.133 -P3306 -S /tmp/mysql.sock

Enter password:

mysql> show processlist;

+----+----------+----------+------+---------+------+----------+------------------+

| Id | User | Host | db | Command | Time | State | Info |

+----+----------+----------+------+---------+------+----------+------------------+

| 7 | zhangkai | cs:59128 | NULL | Query | 0 | starting | show processlist |

+----+----------+----------+------+---------+------+----------+------------------+

1 row in set (0.00 sec)

|

在外部执行MySQL的内部命令,如shell脚本中,可以使用-e参数:

1

2

3

4

5

6

7

|

[root@cs mysql]# mysql -uzhangkai -p123 -h 192.168.85.133 -P3306 -e "show processlist;"

mysql: [Warning] Using a password on the command line interface can be insecure.

+----+----------+----------+------+---------+------+----------+------------------+

| Id | User | Host | db | Command | Time | State | Info |

+----+----------+----------+------+---------+------+----------+------------------+

| 8 | zhangkai | cs:59130 | NULL | Query | 0 | starting | show processlist |

+----+----------+----------+------+---------+------+----------+------------------+

|

-e后跟引号,引号内可以写想要执行的命令。

如果有一些SQL脚本要执行,可以使用<符号来处理,首先准备一个data.sql文件,文件内容如下:

1

|

create database data_test;

|

然后导入到数据库中即可:

[root@cs home]# ls

data.sql

[root@cs home]# cat data.sql

create database data_test;

[root@cs home]# mysql -uroot -p <data.sql

Enter password:

[root@cs home]# mysql -uroot -p -e"show databases;"

Enter password:

+--------------------+

| Database |

+--------------------+

| information_schema |

| data_test |

| mysql |

| performance_schema |

| sys |

+--------------------+

此时,如果你进入MySQL中,就可以查询到SQL脚本创建的data_test数据库了。

多种启动方式

如上图,在centos6中,我们可以通过service来调用mysql.server脚本来启动MySQL,而mysql.server脚本内部会调用mysqld_safe脚本来调用mysqld这个启动程序脚本来 启动MySQL服务。mysqld_safe的作用是监控mysqld的运行状态。我们也可以通过./bin/mysqld_safe &临时启动mysqld_safe来完成一些操作。

另外在centos7中,可以直接是使用systemctl来直接调用mysqld启动MySQL,而且centos7中也可以配置service的启动方式。

当然,无论是systemctl,还是service的启动方式,都是相对固定的start、stop这些操作,那有些情况下需要临时维护或者做其他的操作,就需要用到mysqld_safe模式或者直接启动mysqld了。

初始化配置

初始化配置的目的是:干预MySQL的启动,或者干预客户端的连接,说白了就是让MySQL按照我们的意愿来启动。

初始化配置都有哪些方法:

- 预编译,这个方法可以pass掉了,因为我们一般都是下载二进制的源码包。

- 配置文件,也就是

/etc/my.cnf文件,适用于所有的启动方式。

- 命令行,直接在命令行启动时添加各种参数,当然,这种参数仅限于

mysqld_safe、mysqld这两种方式。

综上所述,推荐使用配置文件的的方式来做数据库初始化启动。

先来看,MySQL在启动时,都(默认)读取了哪些配置文件:

[root@cs ~]# mysqld --help --verbose | grep my.cnf

/etc/my.cnf /etc/mysql/my.cnf /usr/local/mysql/etc/my.cnf ~/.my.cnf

my.cnf, $MYSQL_TCP_PORT, /etc/services, built-in default

如果多个配置文件有相同的参数,那就会以最后读取到的为准,也就是~/.my.cnf文件为准。但是如果启动时加入--defaults=/etc/my.cnf时,会以你defaultsd的路径为准,其他的文件就不读取了。

配置文件的介绍

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

|

[标签]

配置项=xxxx

# 标签的类型主要包括,服务端和客户端的定义

# 服务端包括以下几类:

[mysqld]

[mysqld_safe]

[server] # 所有服务端的统称,不过不建议使用

# 客户端包括:

[mysql]

[mysqldump] # 备份用

[client]

# 来个示例

[root@cs ~]# cat /etc/my.cnf

[mysqld]

user=mysql # mysql工作时的用户

basedir=/opt/mysql # mysql所在的目录,必须设定的参数

datadir=/data/mysql # mysql数据存放的目录,必须设定的参数

server_id=6

port=3306

socket=/tmp/mysql.sock # 服务器端socket所在路径

log_error=/data/mysql/mysql.log # 错误日志

[mysql]

socket=/tmp/mysql.sock # 必须参数

# prompt=3306 [\\d]> # 提示符

# user=root # 登录的用户名和密码,这里不建议用,不安全

# password=123

|

需要补充的是,带下划线的参数,如server_id,在MySQL5.5版本以前可以写成中横线的形式,但是中横线这种方式存在问题,所以后续版本都统一使用下划线这种连接方式(当然,为了兼容,也支持中横线的形式)。

另外,关于socket可能的报错,就是找不到socket文件,该报错的原因:

- 数据库没启动,没启动没有生成socket文件。

- 启动时,指定的socket文件路径不对,也可能是配置文件中的路径写错了。

server_id参数,主从复制用,可以简单理解在MySQL5.7以后必加的一个参数,值是1~65535之间的任意数字,并且跟其他的实例区分开。

DDL操作

本小节主要介绍MySQL中的库和表的操作。

库操作

MySQL自带的数据库

先来看MySQL中自带的库有哪些:

1

2

3

4

5

6

7

8

9

10

|

mysql> show databases;

+--------------------+

| Database |

+--------------------+

| information_schema |

| mysql |

| performance_schema |

| sys |

+--------------------+

4 rows in set (0.01 sec)

|

各库解释如下:

-

information_schema,虚拟库,不占用磁盘空间,存储的是数据库启动后的一些参数,如用户表信息、列信息、权限信息、字符信息等。

-

performance_schema, MySQL 5.5开始新增一个数据库,主要用于收集数据库服务器性能参数,记录处理查询请求时发生的各种事件、锁等现象 。

-

mysql,授权库,主要存储系统用户的权限信息。

-

sys库所有的数据源来自performance_schema,目标是把performance_schema的把复杂度降低,让DBA能更好的阅读这个库里的内容。让DBA更快的了解数据库的运行情况。

-

test,MySQL数据库系统自动创建的测试数据库。test库在MySQL中特殊存在,一般部署完mysql后应当删除该库,并规定不能创建以test和test_字符开头的数据库。因为在MySQL中,test库对任意用户都有管理员权限,因此,线上数据库不要用test。如果已有test,添加用户时想要禁止对test库的权限,可以在mysql.db表中添加这个新用户,禁止所有权限,或者删除该表中user为空的记录,并刷新权限

select * from mysql.db where db='test' \G ;

创建数据库

创建数据库语法:

1

|

CREATE DATABASE database_name;

|

一般的,在MySQL中,关键字等信息推荐大写…….

数据库的命名规范:

- 可以由字母、数字、下划线、@、#、$组成。

- 区分大小写,库名不能大写,也不建议以大写字母开头。

- 首字母不能是数字。

- 数据库名具有唯一性,也就是不能重名。

- 应该避开关键字,如select等。

- 不能单独使用数字。

- 最长不超过128位。

- 一般库名应该和业务相关。

- 也不要创建以

test火test_开头的数据库,原因在前面说过了。

关于字符集,在MySQL中,数据库默认的字符集是拉丁语:

1

2

3

4

5

6

7

|

mysql> show create database mysql;

+----------+------------------------------------------------------------------+

| Database | Create Database |

+----------+------------------------------------------------------------------+

| mysql | CREATE DATABASE `mysql` /*!40100 DEFAULT CHARACTER SET latin1 */ |

+----------+------------------------------------------------------------------+

1 row in set (0.00 sec)

|

但我们用的更多的是utf8或者是utf8mb4,所以我们一般在创建数据库库的时候还需要指定字符集:

1

2

3

4

5

6

7

8

9

10

|

mysql> CREATE DATABASE t1 CHARSET utf8;

Query OK, 1 row affected (0.00 sec)

mysql> show create database t1;

+----------+-------------------------------------------------------------+

| Database | Create Database |

+----------+-------------------------------------------------------------+

| t1 | CREATE DATABASE `t1` /*!40100 DEFAULT CHARACTER SET utf8 */ |

+----------+-------------------------------------------------------------+

1 row in set (0.00 sec)

|

除了utf8和utf8mb4,MySQL还支持其他的字符集,我们来查看MySQL中支持的所有字符集:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

|

mysql> SHOW CHARSET;

+----------+---------------------------------+---------------------+--------+

| Charset | Description | Default collation | Maxlen |

+----------+---------------------------------+---------------------+--------+

| big5 | Big5 Traditional Chinese | big5_chinese_ci | 2 |

| dec8 | DEC West European | dec8_swedish_ci | 1 |

| cp850 | DOS West European | cp850_general_ci | 1 |

| hp8 | HP West European | hp8_english_ci | 1 |

| koi8r | KOI8-R Relcom Russian | koi8r_general_ci | 1 |

| latin1 | cp1252 West European | latin1_swedish_ci | 1 |

| latin2 | ISO 8859-2 Central European | latin2_general_ci | 1 |

| swe7 | 7bit Swedish | swe7_swedish_ci | 1 |

| ascii | US ASCII | ascii_general_ci | 1 |

| ujis | EUC-JP Japanese | ujis_japanese_ci | 3 |

| sjis | Shift-JIS Japanese | sjis_japanese_ci | 2 |

| hebrew | ISO 8859-8 Hebrew | hebrew_general_ci | 1 |

| tis620 | TIS620 Thai | tis620_thai_ci | 1 |

| euckr | EUC-KR Korean | euckr_korean_ci | 2 |

| koi8u | KOI8-U Ukrainian | koi8u_general_ci | 1 |

| gb2312 | GB2312 Simplified Chinese | gb2312_chinese_ci | 2 |

| greek | ISO 8859-7 Greek | greek_general_ci | 1 |

| cp1250 | Windows Central European | cp1250_general_ci | 1 |

| gbk | GBK Simplified Chinese | gbk_chinese_ci | 2 |

| latin5 | ISO 8859-9 Turkish | latin5_turkish_ci | 1 |

| armscii8 | ARMSCII-8 Armenian | armscii8_general_ci | 1 |

| utf8 | UTF-8 Unicode | utf8_general_ci | 3 |

| ucs2 | UCS-2 Unicode | ucs2_general_ci | 2 |

| cp866 | DOS Russian | cp866_general_ci | 1 |

| keybcs2 | DOS Kamenicky Czech-Slovak | keybcs2_general_ci | 1 |

| macce | Mac Central European | macce_general_ci | 1 |

| macroman | Mac West European | macroman_general_ci | 1 |

| cp852 | DOS Central European | cp852_general_ci | 1 |

| latin7 | ISO 8859-13 Baltic | latin7_general_ci | 1 |

| utf8mb4 | UTF-8 Unicode | utf8mb4_general_ci | 4 |

| cp1251 | Windows Cyrillic | cp1251_general_ci | 1 |

| utf16 | UTF-16 Unicode | utf16_general_ci | 4 |

| utf16le | UTF-16LE Unicode | utf16le_general_ci | 4 |

| cp1256 | Windows Arabic | cp1256_general_ci | 1 |

| cp1257 | Windows Baltic | cp1257_general_ci | 1 |

| utf32 | UTF-32 Unicode | utf32_general_ci | 4 |

| binary | Binary pseudo charset | binary | 1 |

| geostd8 | GEOSTD8 Georgian | geostd8_general_ci | 1 |

| cp932 | SJIS for Windows Japanese | cp932_japanese_ci | 2 |

| eucjpms | UJIS for Windows Japanese | eucjpms_japanese_ci | 3 |

| gb18030 | China National Standard GB18030 | gb18030_chinese_ci | 4 |

+----------+---------------------------------+---------------------+--------+

41 rows in set (0.00 sec)

|

ci是case insensitive即"大小写不敏感", a 和 A 会在字符判断中会被当做一样的。

借此机会我们再来简单说说字符集中的校验规则(排序规则)。

查询字符集校验规则:

SHOW COLLATION;

这里以utf8来简单说说:

utf8_unicode_ci和utf8_general_ci对中英文来说没有实质的差别。utf8_general_ci::校对速度快,但准确度稍差。utf8_unicode_ci: 准确度高,但校对速度稍慢;若数据库中有德语、法语或者俄语需求,需使用utf8_unicode_ci。utf8_bin:将字符串中的每一个字符用二进制数据存储,区分大小写。

创建大小写敏感的数据库:

1

|

CREATE DATABASE database_name CHARSET utf8mb4 COLLATE utf8mb4_bin;

|

关于utf8和utf8mb4的区别:

MySQL在 5.5.3 之后增加了 utf8mb4 字符编码,mb4即 most bytes 4。简单说 utf8mb4 是 utf8 的超集并完全兼容utf8,能够用四个字节存储更多的字符。

但抛开数据库,标准的 UTF-8 字符集编码是可以用 1~4 个字节去编码21位字符,这几乎包含了是世界上所有能看见的语言了。然而在MySQL里实现的utf8最长使用3个字节,也就是只支持到了 Unicode 中的 基本多文本平面(U 0000至U FFFF),包含了控制符、拉丁文,中、日、韩等绝大多数国际字符,但并不是所有,最常见的就算现在手机端常用的表情字符 emoji和一些不常用的汉字,如 “墅” ,这些需要四个字节才能编码出来。

注:QQ里面的内置的表情不算,它是通过特殊映射到的一个gif图片。一般输入法自带的就是。

也就是当你的数据库里要求能够存入这些表情或宽字符时,可以把字段定义为 utf8mb4,同时要注意连接字符集也要设置为utf8mb4,否则在 严格模式 下会出现 Incorrect string value: /xF0/xA1/x8B/xBE/xE5/xA2… for column 'name'这样的错误,非严格模式下此后的数据会被截断。

create database & create schema

你在一些地方,可能会看到如下建库语句:

不要迷惑,关于create database和create schema语句,在MySQL中是等价的;下面摘自MySQL8.0官网:https://dev.mysql.com/doc/refman/8.0/en/create-database.html的解释:

CREATE DATABASE creates a database with the given name. To use this statement, you need the CREATE privilege for the database. CREATE SCHEMA is a synonym for CREATE DATABASE.

删除数据库

注意,生产中开发人员"禁止删库",这种操作应该交给专门的人员来操作,或者向上级申请。

修改

1

|

alter database t1 charset utf8;

|

注意,修改字符集时,修改后的字符集一定是原字符集的严格超集。

查看数据库

1

2

3

4

|

show create databse database_name; # 查看数据库创建信息

show databases; # 查看所有的数据库

use database_name; # 进入创建的数据库

use database_name; # 切换数据库,且进入某个数据库无法回退

|

表操作

MySQL中的表你可以理解为是一个有严格规范的excel表格:

表中的id、name、age、gender是字段,其余每一行称为记录。

创建表

基本语法:

1

2

3

4

5

6

|

-- 语法:

CREATE TABLE 表名(

字段名1 类型[(宽度) 约束条件],

字段名2 类型[(宽度) 约束条件],

字段名3 类型[(宽度) 约束条件]

);

|

关于数据类型和约束,我们在下个章节会展开学习。

注意:

- 在同一张表中,字段名是不能相同。

- 宽度和约束条件可选。

- 字段名和类型是必须的。

示例:

1

2

3

4

5

6

7

8

9

|

USE school;

CREATE TABLE stu(

id INT NOT NULL PRIMARY KEY AUTO_INCREMENT COMMENT '学号',

sname VARCHAR(255) NOT NULL COMMENT '姓名',

sage TINYINT UNSIGNED NOT NULL DEFAULT 0 COMMENT '年龄',

sgender ENUM('m','f','n') NOT NULL DEFAULT 'n' COMMENT '性别',

sfz CHAR(18) NOT NULL UNIQUE COMMENT '身份证',

intime TIMESTAMP NOT NULL DEFAULT NOW() COMMENT '入学时间'

) ENGINE=INNODB CHARSET=utf8 COMMENT '学生表';

|

USE语句相当于进入一个目录,然后CREATE TABLE语句相当于创建一个excel表格,然后再这个表格中,针对每个字段有不同的规定和注释,最后再指定这个表格的文件系统(存储引擎)和字符编码。

注意,最后一个字段后无需跟逗号。

建表规范

- 表名小写

- 不能是数字开头

- 注意字符集和存储引擎

- 表名和业务有关

- 选择合适的数据类型

- 每个列都要有注释

- 每个列设置为非空,无法保证非空,用0来填充

查看表结构

首先,我们应该进入某个数据库中use database_name;

1

2

3

4

5

6

7

|

show tables; # 查看所有表

show create table score; # 查看指定表的表结构,信息比较全面

show create table score \G # 上同,格式化整理

show create table score \G; # 上同,结尾加分号也行,但会提示No query specified,忘掉它吧

desc score; # 查看表的字段信息

describe score; # 上同,desc为其缩写。

create table t1 like t2; -- 复制结构一样的空表

|

删除

1

2

|

use school;

drop table t1;

|

注意,生产中"禁止"使用,小心造成事故。

修改

修改这里无非就是修改表和其中的字段。

修改表操作

- 修改表名:

1

|

ALTER TABLE <旧表名> RENAME [TO] <新表名>;

|

其中TO为可选参数,使用与否均不影响结果。

- 修改表字符集:

1

|

ALTER TABLE t1 DEFAULT CHARACTER SET utf8 COLLATE utf8_general_ci;

|

- 修改表引擎(慎重使用):

1

|

ALTER TABLE table_name engine=innodb;

|

修改字段操作

- 修改字段名称和属性:

1

2

|

ALTER TABLE stu CHANGE sgender sg ENUM('m','f','n') NOT NULL DEFAULT 'm' COMMENT '性别';

-- change操作在修改字段名称的同时也可以修改其属性

|

- 添加字段:

1

2

3

4

5

6

|

-- 默认添加到最后

ALTER TABLE stu ADD qq VARCHAR(20) NOT NULL UNIQUE COMMENT 'QQ号';

-- 添加到最前面

ALTER TABLE stu ADD nickname VARCHAR(32) NOT NULL COMMENT '昵称' FIRST;

-- 添加到指定字段之后,注意,并没有添加到指定字段之前的操作

ALTER TABLE stu ADD wechat VARCHAR(64) NOT NULL UNIQUE COMMENT '微信号' AFTER sname;

|

- 删除字段(慎重操作):

1

2

3

|

ALTER TABLE stu DROP qq;

ALTER TABLE stu DROP wechat;

ALTER TABLE stu DROP nickname;

|

- 修改字段的属性:

1

2

3

|

ALTER TABLE stu MODIFY sname VARCHAR(128) NOT NULL COMMENT '姓名';

-- 注意,该操作会覆盖掉原来的所有属性,所以该操作一定要把原来不变的属性都加上

-- modify操作只用来修改字段属性

|

- 修改字段字符集:

1

|

ALTER TABLE t1 CHANGE title title VARCHAR(100) CHARACTER SET utf8 COLLATE utf8_general_ci;

|

注意,修改表结构的操作,MySQL8.0之前的版本默认是会锁表的,所以,不要在业务高峰期做这些操作,而是选择在晚间进行操作,当然,我们也可以在晚间使用在线的DDL工具来处理这些事情,避免锁表对业务造成影响。

常用的在线DDL工具:

- MySQL的Online。

- pt-osc,推荐使用。

复制表

最后,再来看看复制表相关的操作:

- 复制一份一摸一样的表:

1

2

|

-- 创建一个a2表,表结构跟a1一样,这里复制的a2表跟a1的表结构是一样的,但不会复制a1表中的记录

CREATE TABLE a2 LIKE a1;

|

- 创建一个表,复制另一张表的指定字段和记录。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

|

-- 注意,自己创建的表字段一定要跟被复制表字段一致

CREATE TABLE a3(

HOST CHAR(60),

USER CHAR(16),

PRIMARY KEY(HOST,USER) -- 注意,key不会复制: 主键、外键和索引,所以这里需要自己建立主键

)

SELECT

HOST,USER

FROM mysql.user;

-- 如果出现自己创建的表字段跟被复制的表字段不一致的情况,那么创建的表就是自己创建的字段和被复制的表的指定字段同时存在

CREATE TABLE a4(

ip CHAR(60) DEFAULT '1.1.1.1',

username CHAR(16) DEFAULT 'root'

-- primary key(ip,username) -- 因为新表会拷贝记录,所以上面两个字段有默认值,但是由于建立联合主键,默认值都一样又建不了,所以,这也是要考虑的地方

)

SELECT HOST,USER

FROM mysql.user;

-- 最终,a4表会有4个字段,ip,username,host,user,即当复制的字段不一致时,被复制的表字段会追加到当前表中

|

- 创建一个表,复制另一张表的指定字段和记录,但是创建的表字段又想不跟被复制表字段不一致:

1

2

3

4

5

6

7

|

CREATE TABLE a5(

ip CHAR(60),

username CHAR(16),

PRIMARY KEY(ip,username)

)

SELECT HOST AS ip,USER AS username

FROM mysql.user;

|

记录操作(DML)

现在,就要对表中的记录进行增删改这些操作了。

还是那张表:

1

2

3

4

5

6

7

8

9

|

USE school;

CREATE TABLE stu(

id INT NOT NULL PRIMARY KEY AUTO_INCREMENT COMMENT '学号',

sname VARCHAR(255) NOT NULL COMMENT '姓名',

sage TINYINT UNSIGNED NOT NULL DEFAULT 0 COMMENT '年龄',

sgender ENUM('m','f','n') NOT NULL DEFAULT 'n' COMMENT '性别',

sfz CHAR(18) NOT NULL UNIQUE COMMENT '身份证',

intime TIMESTAMP NOT NULL DEFAULT NOW() COMMENT '入学时间'

) ENGINE=INNODB CHARSET=utf8 COMMENT '学生表';

|

insert

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

|

-- 按照指定的字段顺序插入一条数据,也是标准的插入数据格式

INSERT INTO stu(id,sname,sage,sg,sfz,intime) VALUE (1,'张三',18,'m','1100',NOW());

-- 如果按照字段顺序插入的话,可以省略字段,直接插入值

INSERT INTO stu VALUE(2,'张三2',18,'n','1101',NOW());

-- 针对性的插入,根据字段的属性发现,要么是自增长,要么是有默认值,所以这里直接插入必须插入的字段即可

INSERT INTO stu(sname,sage,sfz) VALUE('张三3',18,'1102');

-- 一次插入多条数据

INSERT INTO stu(sname,sage,sfz)

VALUES

('张三4',18,'1103'),

('张三5',18,'1104'),

('张三6',18,'1105'); -- 最后一个括号后不用逗号,直接跟结尾符号很分号即可

-- 可以使用下面语句查询插入的数据

SELECT * FROM stu;

|

update

首先来说一个不要轻易使用的命令,即对指定字段进行全表更新:

1

|

UPDATE stu SET sname='李四';

|

经过set之后,全表的sname都会变成李四,如果数据量较大,非常影响性能。

根据条件更新:

1

2

3

4

|

UPDATE stu SET sname='王五' WHERE id=3;

-- 修改id<3的记录中的sname的值,还可以使用大于符号,不等于符号

UPDATE stu SET sname='赵六' WHERE id<3;

|

条件选择一般选择具有唯一性的,如果条件不唯一,则所有符合条件的记录都将受影响,如:

1

|

UPDATE stu SET sname='赵六' WHERE sg='m';

|

注意,update必须要加where条件,而且操作要慎重。

delete

危险命令!

1

2

|

DELETE FROM stu; -- 表中所有的记录都将被逐行删除,性能差,不要用

DELETE FROM stu WHERE id=1;

|

注意,delete命令删除是逻辑删除,不会释放磁盘空间!

现在我们再说另一条命令:

1

2

|

TRUNCATE TABLE stu;

-- 该命令不支持where条件

|

truncate命令清空表后会释放磁盘空间。

小结:

delete命令(DML操作)只是在逻辑层面删除了记录,但是占用的磁盘空间并没有释放;另外该表的建表结构还在。truncate命令(DDL操作)清空表的数据页,保留表的建表结构。drop删表操作就是逻辑和磁盘上都会删除。

为了解决delete的缺点,我们采用伪删除来解决,即使用update来代替delete,思路是为表添加一个状态字段,如果有需要删除的,就改下状态,后续的查询也根据状态来查看:

1

2

3

4

5

6

7

8

|

-- 1. 添加状态字段

ALTER TABLE stu ADD state TINYINT NOT NULL DEFAULT 1;

-- 2. update替代delete

UPDATE stu SET state=0 WHERE id=3;

-- 3. 业务查询语句

SELECT * FROM stu WHERE state=1;

|

数据类型

从本小节开始,就开始为学习如何操作记录做准备了。

我们先来学习,MySQL中常用的数据类型。

在MySQL中,我们需要了解的数据类型共有以下几种:

- 数值类型。

- 日期类型。

- 字符串类型。

- ENUM和SET类型。

我们一一来看看吧。

数值类型

MySQL支持所有标准SQL数值类型。包括严格数值数据类型(INTEGER、SMALLINT、DECIMAL和NUMERIC),以及近似数值数据类型(FLOAT、REAL和DOUBLE PRECISION)。

关键字INT是INTEGER的同义词,关键字DEC是DECIMAL的同义词。

MySQL支持的整数类型有TINYINT、SMALLINT、MEDIUMINT、INT和BIGINT。下面的表显示了需要的每个整数类型的存储和范围。

对于小数的表示,MYSQL分为两种方式:浮点数和定点数。浮点数包括float(单精度)和double(双精度),而定点数只有decimal一种,在mysql中以字符串的形式存放,比浮点数更精确,适合用来表示货币等精度高的数据。

BIT数据类型保存位字段值,并且支持MyISAM、MEMORY、InnoDB和BDB表。

| 类型 | 大小 | 范围(有符号) | 范围(无符号) | 用途 |

|---|

| TINYINT |

1字节 |

(-128, 127) |

(0, 255) |

小整数值 |

| SMALLINT |

2字节 |

(-32768, 327667) |

(0, 65535) |

大整数值 |

| MEDIUMINT |

3字节 |

(-8388608, 8388697) |

(0, 16777215) |

大整数值 |

| INT or INTEGER |

4字节 |

(-2147483648, 2147483647) |

(0, 4294967295) |

大整数值 |

| BIGINT |

8字节 |

(-9 233 372 036 854 775 808,9 223 372 036 854 775 807) |

(0,18 446 744 073 709 551 615) |

极大整数值 |

| FLOAT |

4 字节 float(255,30) |

(-3.402 823 466 E+38,-1.175 494 351 E-38),0,(1.175 494 351 E-38,3.402 823 466 351 E+38) |

0,(1.175 494 351 E-38,3.402 823 466 E+38) |

单精度浮点数值 |

| DOUBLE |

8 字节double(255,30) |

(-1.797 693 134 862 315 7 E+308,-2.225 073 858 507 201 4 E-308),0,(2.225 073 858 507 201 4 E-308,1.797 693 134 862 315 7 E+308) |

0,(2.225 073 858 507 201 4 E-308,1.797 693 134 862 315 7 E+308) |

双精度浮点数值 |

| DECIMAL |

对DECIMAL(M,D) ,如果M>D,为M+2否则为D+2 |

依赖于M和D的值 |

依赖于M和D的值 |

小数值 |

int类型

这里我们先以int为例展开讨论。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

|

create table t1(n1 int(4));

desc t1;

+-------+--------+------+-----+---------+-------+

| Field | Type | Null | Key | Default | Extra |

+-------+--------+------+-----+---------+-------+

| n1 | int(4) | YES | | NULL | |

+-------+--------+------+-----+---------+-------+

insert into t1 values(11);

insert into t1 values(111111);

select n1 from t1;

+--------+

| n1 |

+--------+

| 11 |

| 111111 |

+--------+

|

由最后的查看结果,我们为int类型设定的宽度为4,结果插入一个6位的也行。这是怎么回事?

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

|

create table t2(n1 int(4) zerofill);

desc t2;

+-------+--------------------------+------+-----+---------+-------+

| Field | Type | Null | Key | Default | Extra |

+-------+--------------------------+------+-----+---------+-------+

| n1 | int(4) unsigned zerofill | YES | | NULL | |

+-------+--------------------------+------+-----+---------+-------+

insert into t2 values(11);

insert into t2 values(111111);

select n1 from t2;

+--------+

| n1 |

+--------+

| 0011 |

| 111111 |

+--------+

|

可以看到,我们在创建表的时候,为n1字段加上zerofill,表示不够4位就填充0。而最后的查询结果告诉我们,如果为int类型指定宽度,则是显示字符的宽度(字符数量),超过这个限制也会显示。

而查询表结构的时候,有个unsigned,这是无符号的类型。那这是什么意思呢?

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

|

create table t3(n1 int);

desc t3;

+-------+---------+------+-----+---------+-------+

| Field | Type | Null | Key | Default | Extra |

+-------+---------+------+-----+---------+-------+

| n1 | int(11) | YES | | NULL | |

+-------+---------+------+-----+---------+-------+

insert into t3 values(11111111111111111111111111);

insert into t3 values(-11111111111111111111111111);

select n1 from t3;

+-------------+

| n1 |

+-------------+

| 2147483647 |

| -2147483648 |

+-------------+

|

首先,desc告诉我们int类型的默认显示宽度是11位,而最大表示数值范围是2147483647,如果你插入的数据是超过这个范围的话。而2147483647的显示宽度是10位,为什么不是默认的11位呢?这是因为int类型默认类型是有符号的,而有符号的就要考虑正号和负号,而符号仅用1位就能表示。

原因如下:

int的存储宽度是4个Bytes,即32个bit,即2^32

无符号最大值为:4294967296-1

有符号最大值:2147483648-1

有符号和无符号的最大数字需要的显示宽度均为10,而针对有符号的最小值则需要11位才能显示完全,所以int类型默认的显示宽度为11是非常合理的。

那么如何设置一个无符号的呢?

1

2

3

4

5

6

7

8

9

10

11

12

13

14

|

create table t4(n1 int unsigned);

desc t4;

+-------+------------------+------+-----+---------+-------+

| Field | Type | Null | Key | Default | Extra |

+-------+------------------+------+-----+---------+-------+

| n1 | int(10) unsigned | YES | | NULL | |

+-------+------------------+------+-----+---------+-------+

insert into t4 values(11111111111111111111111111);

select n1 from t4;

+------------+

| n1 |

+------------+

| 4294967295 |

+------------+

|

无符号的需要在int类型指定unsigned。结果也是没错的。都最开始列举的表中数据一致。

最后:int类型,其实没有必要指定显示宽度,使用默认的就行;如果你的整数范围超过int类型范围,请选用别的数据类型;并且默认的,我们创建的int类型是有符号类型。

float类型

先来看定义:

FLOAT[M, D] [UNSIGNED] [ZEROFILL]

DOUBLE[(M,D)] [UNSIGNED] [ZEROFILL]

DECIMAL[(m[,d])] [unsigned] [zerofill]

float表示单精度浮点数(非准确小数值),M表示数字总个数,最大值是255;D是小数点后的数字个数,最大值30。也就是说,如果float(255,30)意思是,小数位是30位,而整数位就不是255了,而是255-30=225位。它的精准度:随着小数的增多,精度变得不准确。

双精度(double)浮点数(非准确小数值),m是数字总个数,d是小数点后个数。m最大值为255,d最大值为30。它的精准度:随着小数的增多,精度比float要高,但也会变得不准确。

而decimal的准确的小数值,m是数字总个数(负号不算),d是小数点后个数。 m最大值为65,d最大值为30。它的精准度:随着小数的增多,精度始终准确;对于精确数值计算时需要用此类型。decaimal能够存储精确值的原因在于其内部按照字符串存储。

1

2

3

4

5

6

7

8

9

10

11

|

create table f1(weight float(256,30));

ERROR 1439 (42000): Display width out of range for column 'weight' (max = 255) # 说显示宽度超过了255

create table f2(weight float(255,31));

ERROR 1425 (42000): Too big scale 31 specified for column 'weight'. Maximum is 30. # 告诉我们小数点后的位数最多30位

create table f3(weight float(255,30)); # 这样就没问题了

desc f3;

+--------+---------------+------+-----+---------+-------+

| Field | Type | Null | Key | Default | Extra |

+--------+---------------+------+-----+---------+-------+

| weight | float(255,30) | YES | | NULL | |

+--------+---------------+------+-----+---------+-------+

|

首先,我们创建的float类型是有符号类型。

同样的,你想创建一个无符号的,也要指定unsigned。

1

2

3

4

5

6

7

8

|

create table f4(weight float(255,30) unsigned);

desc f4;

+--------+------------------------+------+-----+---------+-------+

| Field | Type | Null | Key | Default | Extra |

+--------+------------------------+------+-----+---------+-------+

| weight | float(255,30) unsigned | YES | | NULL | |

+--------+------------------------+------+-----+---------+-------+

1 row in set (0.01 sec)

|

在使用浮点型的数据时,我们考虑的核心是关注它们的精度。来看对比。

1

2

3

4

5

6

|

create table f5(weight float(255,30) unsigned);

create table f6(weight double(255, 30) unsigned);

create table f7(weight decimal(65, 30) unsigned);

insert into f5 values(1.111111111111111111111111111111111111111111111111111);

insert into f6 values(1.111111111111111111111111111111111111111111111111111);

insert into f7 values(1.111111111111111111111111111111111111111111111111111);

|

我们创建三张不同类型的表,并插入一些数据,并且这些小数位都超过30位。来观察他们的精度:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

|

select weight from f5;

+----------------------------------+

| weight |

+----------------------------------+

| 1.111111164093017600000000000000 |

+----------------------------------+

select weight from f6;

+----------------------------------+

| weight |

+----------------------------------+

| 1.111111111111111200000000000000 |

+----------------------------------+

select weight from f7;

+----------------------------------+

| weight |

+----------------------------------+

| 1.111111111111111111111111111111 |

+----------------------------------+

|

由各自的查询结果可以看到,float类型的精度只有前7位是精确的;double类型的精度是15位;而decimal则保留完整的精度,毕竟是字符串形式的存储么。 但是decimal虽然精度较高,但是它也是有限制的,因为它的数字总大小为65位,所以抛出小数位的30位,还剩30位整数位。

最后,最后,这里只是说的显示宽度仅是在int中使用,其他数据类型宽度是存储限制。比如BIT类型。

BIT

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

|

create table b1(b bit(1));

desc b1;

+-------+--------+------+-----+---------+-------+

| Field | Type | Null | Key | Default | Extra |

+-------+--------+------+-----+---------+-------+

| b | bit(1) | YES | | NULL | |

+-------+--------+------+-----+---------+-------+

insert into b1 values(0);

insert into b1 values(1);

insert into b1 values(2);

select b from b1;

+------+

| b |

+------+

| |

| � |

| � |

+------+

|

首先了解,字段b的类型是bit,宽度是1,那能表示多少数值呢,一个bit,只能表示0和1两个。但是通过查询发现,跟我们想要的结果不一样。

这是为什么,bit类型存储是以二进制存储到硬盘上的。所以,我们想要查询到我们想要的值,还要借助MySQL提供给我们的函数bin()和hex(),意思是返回二进制值的字符串形式表示和十六进制的表示形式。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

|

select bin(b) from b1;

+--------+

| bin(b) |

+--------+

| 0 |

| 1 |

| 1 |

select hex(b) from b1;

+--------+

| hex(b) |

+--------+

| 0 |

| 1 |

| 1 |

+--------+

|

可以看到,字段b的bit(1)类型只能表示0和1,而插入的2超出了范围。所以,你在用的时候,需要注意:

1

2

3

4

5

6

7

8

|

create table b2(b bit(2));

insert into b2 values(2);

select bin(b) from b2;

+--------+

| bin(b) |

+--------+

| 10 |

+--------+

|

可以看到,2的二进制形式是10。

时间类型

日期类型有:

- DATE(YYYY-MM-DD(1000-01-01/9999-12-31)),2019-07-31,出生年月日

- TIME(HH:MM:SS('-838:59:59'/‘838:59:59’)),16:40:40,下班时间

- DATETIME(YYYY-MM-DD HH:MM:SS(1000-01-01 00:00:00/9999-12-31 23:59:59 Y))、2019-07-31 16:40:40,注册时间、文章发布时间、员工入职时间

- TIMESTAMP(YYYYMMDD HHMMSS(1970-01-01 00:00:00/2037 年某时))、2019-07-31 16:40:40

- YEAR(YYYY(1901/2155))、2019,历史大事件,出生年

来个示例:

1

2

3

4

5

6

7

8

9

10

11

12

|

create tabled1(

born_date date,

get_time time,

reg_time datetime,

born_year year # 最后一个字段后面不要有逗号

);

insert into d1 values(

'1999-11-11',

'18:30:00',

'2018-11-11 11:11:11',

'1999' # 不要写成18/30/30

);

|

来查询:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

|

desc d1;

+-----------+----------+------+-----+---------+-------+

| Field | Type | Null | Key | Default | Extra |

+-----------+----------+------+-----+---------+-------+

| born_date | date | YES | | NULL | |

| get_time | time | YES | | NULL | |

| reg_time | datetime | YES | | NULL | |

| born_year | year(4) | YES | | NULL | |

+-----------+----------+------+-----+---------+-------+

select * from d1;

+------------+----------+---------------------+-----------+

| born_date | get_time | reg_time | born_year |

+------------+----------+---------------------+-----------+

| 1999-11-11 | 18:30:00 | 2018-11-11 11:11:11 | 1999 |

+------------+----------+---------------------+-----------+

|

再来掌握一个now()函数:

1

2

3

4

5

6

7

|

insert into d1 values(now(), now(), now(), now());

select * from d1;

+------------+----------+---------------------+-----------+

| born_date | get_time | reg_time | born_year |

+------------+----------+---------------------+-----------+

| 1999-11-11 | 18:30:00 | 2018-11-11 11:11:11 | 1999 |

| 2019-07-31 | 16:57:51 | 2019-07-31 16:57:51 | 2019 |

|

由第二行记录可以发现,各类型都按照自己的规则截取所需的日期数据。

了解:datetime与timestamp的区别

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

|

create table d2(x datetime, y timestamp);

desc d2;

+-------+-----------+------+-----+-------------------+-----------------------------+

| Field | Type | Null | Key | Default | Extra |

+-------+-----------+------+-----+-------------------+-----------------------------+

| x | datetime | YES | | NULL | |

| y | timestamp | NO | | CURRENT_TIMESTAMP | on update CURRENT_TIMESTAMP |

+-------+-----------+------+-----+-------------------+-----------------------------+

insert into d2 values(Null, Null);

insert into d2 values('1111-11-11','1111-11-11');

select * from d2;

+---------------------+---------------------+

| x | y |

+---------------------+---------------------+

| NULL | 2019-07-31 17:05:43 |

| 1111-11-11 00:00:00 | 0000-00-00 00:00:00 |

+---------------------+---------------------+

|

通过上述验证分析,虽然这两种日期格式,都能满足我们大多数使用场景,但是在某些情况下,它们也有自己的优劣之分,来看看它们的区别:

- DATETIME的日期范围是1001——9999年,TIMESTAMP的时间范围是1970——2038年。

- DATETIME存储时间与时区无关,TIMESTAMP存储时间与时区有关,显示的值也依赖于时区。在mysql服务器,操作系统以及客户端连接都有时区的设置。

- DATETIME使用8字节的存储空间,TIMESTAMP的存储空间为4字节。因此,TIMESTAMP比DATETIME的空间利用率更高。

- DATETIME的默认值为null,TIMESTAMP的字段默认不为空(not null),默认值为当前时间(CURRENT_TIMESTAMP),如果不做特殊处理,并且update语句中没有指定该列的更新值,则默认更新为当前时间。

字符串类型

字符串类型这里需要重点掌握的就是char和varchar两个,存放名字、性别、密码、文本内容等等。

先看它们的区别,注意,长度指的是字符的长度:

-

char,定长,简单粗暴,浪费空间,存取速度快。

- 字符长度范围:0~255,一个汉字是一个字符,utf8编码一个普通汉字占用3个字节。

- 存储:如果存储的值,不满足指定的长度时,会往右填充空格来满足长度,例如指定长度为10,存储大于10个字符报错,小于10个字符会用空格填充,凑够十个字符。

- 查询(或称检索):查询出的结果会自动删除尾部的空格,除非我们打开

pad_char_to_full_length SQL模式

1

|

set sql_mode = 'PAD_CHAR_TO_FULL_LENGTH'

|

char VS varchar:存储范围验证

1

2

3

4

5

6

7

|

create table c1(s char(256));

ERROR 1074 (42000): Column length too big for column 's' (max = 255); use BLOB or TEXT instead

create table c2(s char(255));

create table c3(s varchar(21845));

ERROR 1118 (42000): Row size too large. The maximum row size for the used table type, not counting BLOBs, is 65535. This includes storage overhead, check the manual. You have to change some columns to TEXT or BLOBs

create table c4(s varchar(21844));

create table c5(s varchar(65534));

|

通过打印结果,可以看到,char类型,如果长度超过255,就提示我们字段长度最大是255;varchar的列长度如果超过21844,提示我们varchar类型的最大行大小为65535。

但是最后的c5却成功创建,这是为什么呢?我们来看它的表结构:

1

2

3

4

5

6

7

8

9

10

11

12

|

desc c4;

+-------+----------------+------+-----+---------+-------+

| Field | Type | Null | Key | Default | Extra |

+-------+----------------+------+-----+---------+-------+

| s | varchar(21844) | YES | | NULL | |

+-------+----------------+------+-----+---------+-------+

desc c5;

+-------+------------+------+-----+---------+-------+

| Field | Type | Null | Key | Default | Extra |

+-------+------------+------+-----+---------+-------+

| s | mediumtext | YES | | NULL | |

+-------+------------+------+-----+---------+-------+

|

可以看到,c5表的字段类型已经变成了mediumtext,而不是varchar类型。

char VS varchar:存储长度验证

1

2

3

4

5

6

|

create table c6(s char(3));

create table c7(s varchar(3));

insert into c6 values('abcd');

insert into c6 values('生存还是毁灭');

insert into c7 values('abcd');

insert into c7 values('生存还是毁灭');

|

再来看查询结果:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

|

select s from c6;

+-----------+

| s |

+-----------+

| abc |

| 生存还 |

+-----------+

select s from c7;

+-----------+

| s |

+-----------+

| abc |

| 生存还 |

+-----------+

|

可以看到,无论是char还是varchar;无论是中文还是其他,它们限制的是字符个数。

char VS varchar:定长与可变长度

再来研究它们之间的特点的区别,也就是定长和可变长度的区别。

我们通过表格来看看他们的存储关系:

| Value | CHAR(4) | 存储需求 | VARCHAR(4) | 存储需求 |

|---|

| '' |

' ' |

4 bytes |

'' |

1 bytes |

| ‘ab’ |

‘ab ' |

4 bytes |

‘ab’ |

3 bytes |

| ‘abcd’ |

‘abcd’ |

4 bytes |

‘abcd’ |

5 bytes |

| ‘abcdefg’ |

‘abcd’ |

4 bytes |

‘abcd’ |

5 bytes |

不要被5bytes所迷惑,abcd占4个字节,还有一个字节存储该字符串的长度。

先了解两个函数:

- length:查看字节数。

- char_length:查看字符数。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

|

create table c8(s1 char(3), s2 varchar(3));

desc c8;

+-------+------------+------+-----+---------+-------+

| Field | Type | Null | Key | Default | Extra |

+-------+------------+------+-----+---------+-------+

| s1 | char(3) | YES | | NULL | |

| s2 | varchar(3) | YES | | NULL | |

+-------+------------+------+-----+---------+-------+

insert into c8 values('a', 'b');

select s1, s2 from c8;

+------+------+

| s1 | s2 |

+------+------+

| a | b |

+------+------+

|

现在看是啥也看不出来,所以,我们用上char_length函数:

1

2

3

4

5

6

|

select char_length(s1), char_length(s2) from c8;

+-----------------+-----------------+

| char_length(s1) | char_length(s2) |

+-----------------+-----------------+

| 1 | 1 |

+-----------------+-----------------+

|

这也看不出来啥呀,a和b不就是各占用一个字符长度么。

这是因为啊,我们在查询char类型数据的时候,MySQL会默默的删除尾部的空格(装作我并没有浪费空间!),我们来让它现原形:

1

2

3

4

5

6

7

|

SET sql_mode = 'PAD_CHAR_TO_FULL_LENGTH';

select char_length(s1), char_length(s2) from c8;

+-----------------+-----------------+

| char_length(s1) | char_length(s2) |

+-----------------+-----------------+

| 3 | 1 |

+-----------------+-----------------+

|

这个时候再看,是不是现原形了,char类型占用指定的3个字符宽度,当然,一个英文字符也占用一个字节。而varchar就占用一个字符。

中文也一样:

1

2

3

4

5

6

7

8

|

insert into c8 values('你', '好');

select char_length(s1), char_length(s2) from c8;

+-----------------+-----------------+

| char_length(s1) | char_length(s2) |

+-----------------+-----------------+

| 3 | 1 |

| 3 | 1 |

+-----------------+-----------------+

|

这就是我们使用char和varchar时需要注意的点。

小结:

InnoDB存储引擎:建议使用VARCHAR类型 单从数据类型的实现机制去考虑,char数据类型的处理速度更快,有时甚至可以超出varchar处理速度的50%。

但对于InnoDB数据表,内部的行存储格式没有区分固定长度和可变长度列(所有数据行都使用指向数据列值的头指针),因此在本质上,使用固定长度的CHAR列不一定比使用可变长度VARCHAR列性能要好。因而,主要的性能因素是数据行使用的存储总量。由于CHAR平均占用的空间多于VARCHAR,因此使用VARCHAR来最小化需要处理的数据行的存储总量和磁盘I/O是比较好的。 其他字符串系列(效率:char>varchar>text)

- TEXT系列 TINYTEXT TEXT MEDIUMTEXT LONGTEXT

- BLOB 系列 TINYBLOB BLOB MEDIUMBLOB LONGBLOB

- BINARY系列 BINARY VARBINARY

text:text数据类型用于保存变长的大字符串,可以组多到65535 (2**16 − 1)个字符。

枚举与集合

有些情况,我们需要在一堆选项中选择一个,或者选择多个,如单选框和复选框。 那,在MySQL的字段中,字段的类型也可以有单选和多选。

- enum单选,只能在给定范围内选一个值,如果性别;适用于给定范围后续不会发生变化的场景;另外数字类型不适用枚举。

- set多选,在给定的范围聂选择多个值,如爱好。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

|

create table user1(

id int,

name char(5),

sex enum('male', 'female', 'unknow'),

hobby set('eat', 'sleep', 'play mobile phone')

);

desc user1;

+-------+----------------------------------------+------+-----+---------+-------+

| Field | Type | Null | Key | Default | Extra |

+-------+----------------------------------------+------+-----+---------+-------+

| id | int(11) | YES | | NULL | |

| name | char(5) | YES | | NULL | |

| sex | enum('male','female','unknow') | YES | | NULL | |

| hobby | set('eat','sleep','play mobile phone') | YES | | NULL | |

+-------+----------------------------------------+------+-----+---------+-------+

insert into user1 values(1, '张三', 'male', 'eat,sleep');

select * from user1;

+------+-----------+------+-----------+

| id | name | sex | hobby |

+------+-----------+------+-----------+

| 1 | 张三 | male | eat,sleep |

+------+-----------+------+-----------+

|

如果是set类型,多个参数以逗号隔开。 这里,我们也可以设置默认值,如果用户不填写的话:

1

2

3

4

5

6

7

8

9

10

|

create table user2 (id int, sex enum('male', 'female', 'unknow') default 'male');

insert into user2(id) values(1);

insert into user2 values(2, 'female');

select * from user2;

+------+--------+

| id | sex |

+------+--------+

| 1 | male |

| 2 | female |

+------+--------+

|

根据查询结果可以看到,如果性别字段传值就用我们传的值,不传就用默认的。

约束

约束条件与数据类型一样的宽度一样,都是可选参数。

作用是用于保证数据的完整性和一致性,以免不符合规范的数据写入数据库。

在MySQL中,主要约束有:

PRIMARY KEY (PK),标识字段为该表的主键,可以唯一标识某一条记录,及设置字段非空且唯一。FOREIGN KEY (PK),标识该字段为该表的外键。NOT NULL:约束字段不能为空。UNIQUE,标识该字段的值是唯一的。AUTO_INCREMENT,标识该字段的值自动增长(整数类型,而且为主键)。DEFAULT,为字段设置默认值,比如设置性别默认为男。UNSIGNED,设置整形类型为无符号类型。ZEROFILL,使用0填充。

not null

是否可空,null表示空,非字符串。

not null 不可空,null可空。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

|

create table n1(

id int not null,

name char(5) not null,

age int

);

desc n1;

+-------+---------+------+-----+---------+-------+

| Field | Type | Null | Key | Default | Extra |

+-------+---------+------+-----+---------+-------+

| id | int(11) | NO | | NULL | |

| name | char(5) | NO | | NULL | |

| age | int(11) | YES | | NULL | |

+-------+---------+------+-----+---------+-------+

insert into n1 values(1, '张开1', 18);

insert into n1 values(2, null, 20);

ERROR 1048 (23000): Column 'name' cannot be null

insert into n1 values(null, '张开2', 30);

ERROR 1048 (23000): Column 'id' cannot be null

select * from n1;

+----+---------+------+

| id | name | age |

+----+---------+------+

| 1 | 张开1 | 18 |

+----+---------+------+

|

可以看到,当字段设置了not null的后,我们就必须为该字段传值。

not null的坑

来,做个试验,刚才不是说not null的作用是约束字段不能为空么?我们再来创建个表:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

|

create table n2(

id int not null,

name char(5) not null,

age int

);

insert into n2 values(1, '张开1', 20);

insert into n2 values(2, null, 21);

insert into n2 values(null, '张开2', 22);

select * from n2;

+----+---------+------+

| id | name | age |

+----+---------+------+

| 1 | 张开1 | 20 |

+----+---------+------+

|

如果你查询的话,会发现跟之前的n1表一模一样,哪有问题呀?那好,我们再来插入数据:

1

2

3

4

5

6

7

8

9

10

11

12

|

insert into n2 values(null, null, null), (2, null, 23), (null, '张开腿', 24);

Query OK, 3 rows affected, 4 warnings (0.05 sec)

Records: 3 Duplicates: 0 Warnings: 4

select * from n2;

+----+-----------+------+

| id | name | age |

+----+-----------+------+

| 1 | 张开1 | 20 |

| 0 | | NULL |

| 2 | | 23 |

| 0 | 张开腿 | 24 |

+----+-----------+------+

|

这是什么情况?not null也不管用了啊!参照官网的解释说,MySQL服务器可以在不同的SQL模式下运行,并且可以针对不同的客户端以不同的方式应用这些模式,具体取决于sql_mode系统变量的值。所以,机缘巧合下,发生了这种事情。那么就从sql_mode下手,先来看当前的sql_mode:

1

2

3

4

5

6

|

show variables like "sql_mode";

+---------------+------------------------+

| Variable_name | Value |

+---------------+------------------------+

| sql_mode | NO_ENGINE_SUBSTITUTION |

+---------------+------------------------+

|

可以看到,sql_mode只有一个关于NO_ENGINE_SUBSTITUTION设置,意思是MySQL在创建表的时候,可以指定engine子句,也就是指定表的存储引擎。

ps:如果你的结果不是这样的, 你可手动将sql_mode设置为空,来演示这个效果:

抛开这个不管,我们发现并没有什么关于约束之类的设置(我们称为设置严格模式)。那我们就给它设置上,设置有两种方式。第一是在当前客户端设置:

1

|

set sql_mode="STRICT_TRANS_TABLES,NO_AUTO_CREATE_USER,NO_ENGINE_SUBSTITUTION";

|

这么一设置,立马见效:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

|

create table n3(

id int not null,

name char(5) not null,

age int

);

insert into n3 values(1, '张开1', 20);

insert into n3 values(null, null, null), (2, null, 23), (null, '张开腿', 24);

ERROR 1048 (23000): Column 'id' cannot be null

select * from n3;

+----+---------+------+

| id | name | age |

+----+---------+------+

| 1 | 张开1 | 20 |

+----+---------+------+

|

可以看到,只有第一次的插入生效了。完美!但是,这么着,如果服务器重启就生效了,想要一劳永逸的话,还是要从配置文件下手,我们可以修改MySQL的配置文件my.ini:

1

2

|

[mysqld]

sql-mode="STRICT_TRANS_TABLES,NO_AUTO_CREATE_USER,NO_ENGINE_SUBSTITUTION"

|

然后重启服务。

default

如果某一列字段经常用重复的内容,在我们频发插入的时候,就比较麻烦。所以,我们要是使用default默认值来减少麻烦。比如一个班级内有95%的都是男生,只有5%的女生,那么在插入学生数据的时候,我们就可以为性别这一列给一个默认值是男生:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

|

create table d1(

id int not null,

name char(5) not null,

gender enum('male', 'female', 'unknow') not null default 'male'

);

insert into d1 values(1, '小明', 'male');

insert into d1 values(2, '小红', 'female');

insert into d1 values(1, '小李');

ERROR 1136 (21S01): Column count doesn't match value count at row 1

select * from d1;

+----+--------+--------+

| id | name | gender |

+----+--------+--------+

| 1 | 小明 | male |

| 2 | 小红 | female |

+----+--------+--------+

|

我们原本以为gender字段是有默认值,就可以不写,但是,如上那么写,出了错。这是因为MySQL并不能理解我们是想要使用gender的默认值。而是认为你少了一个字段没有填写。怎么办呢,怎么应用上默认值呢:

1

2

3

4

5

6

7

8

9

|

insert into d1(id, name) values(3, '小李');

select * from d1;

+----+--------+--------+

| id | name | gender |

+----+--------+--------+

| 1 | 小明 | male |

| 2 | 小红 | female |

| 3 | 小李 | male |

+----+--------+--------+

|

比如按照上面的方式,告诉MySQL指定字段传值,gender字段不传值,就使用默认值吧。

default可以这么用:

1

2

3

4

5

6

|

create table d1(

id int not null,

name char(5) not null,

age int default 18,

gender enum('male', 'female', 'unknow') not null default 'male'

);

|

比如直接为age字段设置默认值,而无需指定not null。但是我们一般是default和not null连用。

auto_increment

针对数字列,顺序的自动填充数据,默认从1开始,也可以设置步长和偏移量;常用来设置自增id。

1

2

3

4

5

6

7

8

9

|

create table a0(

id int primary key auto_increment,

name char(5)

);

desc a0;

insert into a0(name) values ("张开"), ("李开"), ("张不开");

select * from a0;

|

上面是默认的自增长配置,现在来一个修改初始自增id初始值的配置:

1

2

3

4

5

6

7

8

9

10

|

-- 创建表时指定

CREATE TABLE a1(id INT PRIMARY KEY AUTO_INCREMENT, NAME CHAR(3)) ENGINE='innodb' AUTO_INCREMENT=5;

-- 或者使用alter语句修改

ALTER TABLE tbl AUTO_INCREMENT = 100;

SHOW CREATE TABLE a1;

INSERT INTO a1(name) VALUES('11'),('22');

-- id值将会从5开始

SELECT * FROM a1;

|

再来了解一个不常用的配置,就是修改自增id的初始值和步长:

- 设置自增初始值:

auto_increment_offset。

- 设置自增步长:

auto_increment_increment。

比如自增id从2开始,然后步长是2,怎么设置呢?有两种方式可以设置。

基于session级别的配置

也就是针对本次会话有效,来看示例:

1

2

3

4

5

6

7

8

9

10

|

set session auto_increment_increment=2;

set session auto_increment_offset=4;

create table a2(

id int primary key auto_increment,

name char(5)

);

insert into a2(name) values ('张开'),('李开');

select * from a2;

|

但是,这仅仅是针对本次会话,当前会话关闭后,就失效了。

基于全局级别的配置

1

2

3

4

5

6

7

8

9

10

11

|

-- 也可以在配置文件中配置

set global auto_increment_increment=2;

set global auto_increment_offset=2;

create table a3(

id int primary key auto_increment,

name char(5)

);

insert into a3(name) values ('张开'),('李开');

select * from a3;

|

如果你是终端执行的,请quit退出重新登录才能生效。

另外,auto_increment_increment和auto_increment_offset这两个变量会相互影响,来自官网:

When the value of auto_increment_offset is greater than that of auto_increment_increment, the value of auto_increment_offset is ignored.

当auto_increment_offset的值大于auto_increment_increment时,auto_increment_offset的值将被忽略,也就是说只有步长生效,初始值还是从1开始。

来个不生效的例子:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

|

mysql> set session auto_increment_increment=2;

Query OK, 0 rows affected (0.00 sec)

mysql> set session auto_increment_offset=3;

Query OK, 0 rows affected (0.00 sec)

mysql> show variables like '%incre%';

+-----------------------------+-------+

| Variable_name | Value |

+-----------------------------+-------+

| auto_increment_increment | 2 |

| auto_increment_offset | 3 |

| div_precision_increment | 4 |

| innodb_autoextend_increment | 64 |

+-----------------------------+-------+

4 rows in set (0.01 sec)

mysql> create table a4(id int primary key auto_increment,name char(10));

Query OK, 0 rows affected (0.00 sec)

mysql> insert into a4(name) values('aa'),('bb');

Query OK, 2 rows affected (0.00 sec)

Records: 2 Duplicates: 0 Warnings: 0

mysql> select * from a4;

+----+------+

| id | name |

+----+------+

| 1 | aa |

| 3 | bb |

+----+------+

2 rows in set (0.00 sec)

|

注意,这两个值不常用,记得改回来。

通常,一个表中只能有一个自增长字段,并且该字段必须被约束为key,这个key可以是unique或者primary key。

key

约束中的key我们学习三种:

- unique

- primary key

- foreign key

其中unique和primary key可以提高查询速度,而foreign key用来表与表之间的关系的。

unique

1

2

3

4

5

6

|

create table u1(

id int unique,

name char(5) unique

);

insert into u1(name) values ('张开'),('李开');

select * from u1;

|

如果id或name字段有重复则会报错。

primary key

primary key指主键,主键的效果非空且唯一,可以加速查询。

1

2

3

4

5

|

create table p1(

id int primary key,

name char(3)

);

desc p1;

|

primary key等价于 not null unique:

1

2

3

4

5

|

create table p2(

id int not null unique primary key,

name char(3)

);

desc p2;

|

也可以使用constraint定义约束:

constraint 约束名称 约束类型 (约束字段)

示例:

1

2

3

4

5

6

|

create table p3(

id int,

name char(3),

constraint primary_id primary key (id)

);

desc p3;

|

当然,也可以省略constraint关键字:

1

2

3

4

5

6

|

create table p4(

id int,

name char(3),

primary key (id)

);

show create table p4;

|

注意,一张表中,只能有一个主键,但是可以有多个not null unique。

1

2

3

4

5

|

create table p5(

id int not null unique ,

name char(3) not null unique

);

show create table p5;

|

联合唯一:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

|

create table p6(

id int primary key auto_increment,

ip char(15) not null ,

port int not null ,

unique (ip, port)

);

show create table p6;

insert into p6(ip, port) values

('1.1.1.1', 3306),

('1.1.1.0', 3306),

('1.1.1.1', 8080);

select * from p6;

|

将ip和端口设置为联合唯一,保证数据唯一性。

foreign key

为了快速理解foreign key,我们这准备两张表来进行关联:

- 部门表,也称被关联表,父表,一个部门可以关联多个员工。

- 员工表(工号,姓名,所属部门),子表,一个员工只属于一个部门。

首先来分析表与表之间的关系,分析步骤:

-

先站在左表的角度去找

- 是否左表的多条记录可以对应右表的一条记录,如果是,则证明左表的一个字段foreign key 右表一个字段(通常是id)

-

再站在右表的角度去找

- 是否右表的多条记录可以对应左表的一条记录,如果是,则证明右表的一个字段foreign key 左表一个字段(通常是id)

-

总结:

-

多对一:

- 如果只有步骤1成立,则是左表多对一右表

- 如果只有步骤2成立,则是右表多对一左表

-

多对多:

- 如果步骤1和2同时成立,则证明这两张表时一个双向的多对一,即多对多,需要定义一个这两张表的关系表来专门存放二者的关系

-

一对一:

- 如果1和2都不成立,而是左表的一条记录唯一对应右表的一条记录,反之亦然。这种情况很简单,就是在左表foreign key右表的基础上,将左表的外键字段设置成unique即可

来看如何使用foreign key:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

|

-- 表类型必须是innodb存储引擎,且被关联的字段,即references指定的另外一个表的字段,必须保证唯一

CREATE TABLE department(

id INT PRIMARY KEY AUTO_INCREMENT,

NAME CHAR(32) NOT NULL

)ENGINE=INNODB CHARSET=utf8;

-- 父表先插入数据,便于子表关联

INSERT INTO department(NAME) VALUES

('人事部'),

('财务部'),

('行政部');

-- department_id外键关联到父表的id字段,并且指定同步更新和删除

CREATE TABLE employee(

id INT PRIMARY KEY AUTO_INCREMENT,

NAME VARCHAR(32) NOT NULL,

department_id INT,

CONSTRAINT fk_name FOREIGN KEY(department_id) REFERENCES department(id) ON DELETE CASCADE ON UPDATE CASCADE

)ENGINE=INNODB CHARSET=utf8;

INSERT INTO employee(NAME, department_id) VALUES

('zhang3',1),

('li4',2),

('wang5',3),

('zhao6',2),

('wang7',1),

('qian9',3),

('sun10',2),

('zhou11',1);

|

来看示例:

1

2

3

4

5

6

7

|

-- 当父表的数据被修改,同时子表的相关数据也同步修改

UPDATE department SET id=4 WHERE id=1; -- 将id为1的修改为4,

SELECT * FROM employee; -- 子表的关联id也随之改变

-- 当父表的数据被删除,子表的相关记录也被同步删除

DELETE FROM department WHERE id=4;

SELECT * FROM employee; -- 子表的关联字段也被随之删除