VGGT: Visual Geometry Grounded Transformer以及DUSt3R & MASt3R

https://jytime.github.io/data/VGGT_CVPR25.pdf

VGGT只看一堆2D照片,就能在一秒内瞬间补出这个场景的完整3D结构。

Visual Geometry Grounded Transformer (VGGT) 是一个大型的、纯前馈(feed-forward)神经网络模型。其核心目标是利用一个统一的框架,直接从一组单视角或多视角的静态场景图像中,一次性推断出该场景全部的关键三维(3D)几何属性。这些属性包括:

- 相机参数(Camera Parameters): 每张图像的内参(如焦距)和外参(空间位置和姿态)。

- 深度图(Depth Maps): 每张图像中每个像素点到相机的距离。

- 点图(Point Maps): 从各视角观测到的、配准对齐的稠密三维点云。

- 三维点轨迹(3D Point Tracks): 跨越多张图像的同一空间点的三维坐标序列。

VGGT 的设计理念旨在根本性地简化并加速 3D 重建流程,通过端到端的深度学习推理,取代传统方法中复杂、多阶段且计算成本高昂的几何优化过程。

VGGT 工作原理的核心

- 目标是什么 (问题定义)

- 核心引擎是什么 (骨干网络)

- 如何得到具体结果 (预测头)

- 如何教会模型 (训练)

1. 问题定义:模型要做什么?

- 输入 (Input):

输入是 N 张观察同一个静态 3D 场景的 RGB 图像 (I₁, I₂, ..., Iₙ)。 - 输出 (Output):

对于输入的每一张图像 Iᵢ,模型都会对应输出一套完整的 3D 几何信息 (gᵢ, Dᵢ, Pᵢ, Tᵢ)

- gᵢ - 相机参数: 一个包含9个数字的向量,精确描述了拍摄第 i 张照片时相机的内外参数,包括它的空间姿态(旋转q和平移t)和视野(f)。

- Dᵢ - 深度图 (Depth Map): 一张灰度图,图中每个像素的值代表了真实场景中该点到相机的距离。

- Pᵢ - 点图 (Point Map): 核心输出之一。它为图中每个像素都赋予了一个三维空间坐标 (x, y, z)。一个关键设定是:所有点图 (P₁, P₂, ..., Pₙ) 的三维坐标都定义在同一个坐标系下,也就是第一台相机 g₁ 的坐标系。这确保了所有视图的点云可以完美地对齐,形成一个统一的 3D 模型。

- Tᵢ - 追踪特征图 (Tracking Features): 这不是最终的追踪轨迹,而是一张包含丰富信息的“特征地图”。后续会有一个专门的追踪模块利用这些特征图来完成点的追踪任务。

- “过度完备”的预测 (Over-complete Predictions)

输出其实是冗余的。比如,一旦知道了点图 P 和相机参数 g,深度图 D 是可以直接计算出来的。但实验发现:

训练时: 让模型同时学习预测所有这些冗余信息,能显著提升整体性能。

推理时 (实际使用时): 反而用模型独立预测出的深度图 D 和相机参数 g 来反推计算出的 3D 点云,比直接使用模型预测的点图 P 精度更高。这是一个非常重要的实践结论。

2. 核心骨干网络:信息如何处理?

- 基本思路: 遵循“轻设计,重数据”的原则,采用一个相当标准的 Transformer 架构,尽量减少内置的 3D 几何假设,让模型自己从海量数据中学习规律。

- 工作流程:

- 图像“符号化” (Patchify): 首先,使用一个预训练好的模型 (DINO) 将每张输入图像切割成很多个小“图块 (patch)”,并把每个图块转换成一个数学向量,也叫“Token”。

- 核心处理 - 交替式注意力机制 (Alternating-Attention): 这是 VGGT 架构的一个微小但关键的创新。所有图像的所有 Token 被送入 Transformer 后,会交替经过两种注意力层:

- 帧内自注意力 (Frame-wise self-attention): 模型专注于处理单张图片内部的 Tokens,理解这张图片自身的内容。

- 全局自注意力 (Global self-attention): 模型将注意力扩展到所有图片的所有 Tokens,寻找和关联不同视图之间的对应关系。

这种交替机制,使得模型既能深刻理解每张独立图像,又能有效地整合全局信息,是实现高质量 3D 重建的关键。

3. 预测头:如何从特征得到最终输出?

骨干网络处理完信息后,输出了一堆更新过的 Tokens。

预测头 (Prediction heads) 的任务就是把这些 Tokens “翻译”成我们想要的最终结果。

- 相机参数预测:

- 模型为每张图额外增加了一个特殊的“相机 Token”。这个 Token 在网络中流动时,会专门负责收集和汇总与相机位姿相关的信息。

- 网络处理完毕后,一个专门的“相机头”(由几个注意力层和一个线性层构成)会读取这个相机 Token,并解码出最终的9个相机参数。

- 为了确立参考系,第一张图像的相机 Token 是独一无二的,让模型知道它是“世界坐标系”的原点。

- 稠密预测 (深度图、点图、追踪特征):

- 处理后的图像 Tokens 会被送入一个 DPT 模块,这个模块负责将这些离散的 Tokens 重新组织成一张密集的、像素对齐的特征图 F。

- 然后,用几个简单的 3x3 卷积层处理这张特征图 F,就能分别得到最终的深度图 D、点图 P 和用于追踪的特征图 T。

- 追踪模块:

- 这一步使用的是一个现成的、名为 CoTracker2 的架构。

- 它的原理很简单:给定查询点(比如第一张图里的某个像素),先在追踪特征图 T₁ 中找到该点的特征向量,然后在所有其他图像的特征图 T₂, T₃, ... 中,去寻找与这个特征向量最相似(相关性最高)的位置,这些位置就是对应点。

4. 训练:如何“教会”这个庞大的模型?

- 损失函数 (Losses):

模型同时学习四个任务,所以它的“考试成绩”也由四部分构成:L = L_相机 + L_深度 + L_点图 + λ * L_追踪。通过一个总的损失函数来同时优化所有任务的预测精度。 - 真值坐标归一化:

这是一个关键的“数据预处理”步骤。为了避免同一个场景因为缩放或平移导致 3D 坐标不同而让模型混淆,所有训练数据都被标准化了:

- 将第一台相机的位置定为坐标原点。

- 对整个场景进行缩放,使得所有 3D 点到原点的平均距离为一个固定值。

模型被训练来直接输出这种归一化之后的“标准答案”。

- 训练规模:

- 模型总参数量约为 12 亿。

- 使用了 64 块 A100 GPU,连续训练了 9 天。

- 训练数据极其庞大和多样,混合了包括 Co3Dv2, MegaDepth, ScanNet 等在内的十几个大型数据集,覆盖了室内、室外、真实、合成等各种场景。

3D 视觉任务的实验成果

1. 相机姿态估计 (证明:又快又准)

展示了 VGGT 在核心功能上的领先地位。

- 完胜所有对手: 无论是传统方法 (Colmap)、混合方法 (VGGSfM) 还是直接的竞争者 (DUSt3R/MASt3R),VGGT 的纯前馈模型 (Ours (Feed-Forward)) 在两个数据集上的精度都最高。

- 速度碾压: VGGT 仅需 0.2 秒,比需要 7-15 秒的 DUSt3R、MASt3R 和 VGGSfM 等方法快了几十倍。

- 强大的泛化能力: RealEstate10K 是一个所有模型都没见过的“新”数据集。VGGT 在上面的领先优势更大,证明了它不是靠“背题”,而是真正学会了三维几何,泛化能力极强。

- 潜力巨大: 如果在 VGGT 的超快预测之后,再结合传统的 BA 优化 (Ours (with BA)),精度还能飙升到一个新的高度,而且总耗时也只有 1.8 秒,依然很快。

2. 多视图深度估计 (证明:信息不全时也能做得很好)

模型生成稠密几何体的精度。

- 关键: 表格上方的方法是被告知了真实的相机位置(相当于“开卷考试”),而下方的 DUSt3R 和 VGGT 则需要自己去估计相机位置(“闭卷考试”)。

- VGGT 在“闭卷”的情况下,其重建精度 (Overall 0.382) 竟然媲美甚至超过了那些“开卷”的顶尖方法。它也以巨大优势击败了同为“闭卷”的 DUSt3R (1.741)。

- 证明了 VGGT 联合估计相机和深度的能力非常强大,因为它在训练中已经“原生”地学会了多视图几何的原理。

3. 点图/点云估计 (证明:方法分解的有效性)

最终生成的三维点云质量。

- VGGT 在速度快得多的情况下 (0.2s vs. ~9s),精度显著优于 DUSt3R 和 MASt3R。

- VGGT 的两个结果中,Ours (Depth + Cam) 比 Ours (Point) 效果更好。这证实了之前的结论:用模型预测的深度图和相机参数来反算点云,比直接用模型输出的点云头结果更精确。这说明将一个复杂任务分解成几个子问题联合学习是有效的。

4. 图像匹配 (证明:通用性强,“降维打击”)

模型在最简单的“两张图找对应点”任务上的表现。

- 尽管 VGGT 是为多视图(N张图)设计的,并没有为两视图任务进行特化训练,但它的追踪头性能依然超越了所有为两视图匹配专门设计的顶尖方法 (如 Roma)。

- 这说明 VGGT 学到的特征具有非常好的通用性和鲁棒性。

5. 消融实验 (证明:模型的设计都是有用的)

验证模型设计的合理性。

- 交替式注意力机制 (Alternating-Attention) 是最优选择: 对比只用全局注意力或交叉注意力的方案,VGGT 采用的“交替式”架构效果最好。

- 多任务学习确实能提升性能: 实验中,他们尝试去掉某个学习任务(比如不学习相机参数),结果点云的重建精度就下降了。这证明让模型同时学习相机、深度、点云和追踪这四个看似冗余的任务,是可以相互促进,最终达到最好效果的。

6. 下游任务微调 (证明:可作为强大的“基础模型”)

不直接用它来重建,而是把它当作一个强大的特征提取器,来增强其他任务。

- 新视角合成: 把 VGGT 稍作修改,用于生成新视角的图像。在不知道输入相机参数和训练数据更少的劣势下,其性能依然非常有竞争力。

- 动态点追踪: 将最先进的追踪器 CoTracker 的“眼睛”(特征提取主干)换成 VGGT,结果追踪性能显著提升。这证明 VGGT 即使在它本不擅长的动态场景中,也能提取出极为有用的几何特征。

新视角合成 (Feed-forward Novel View Synthesis)

模型需要根据几张输入图像,生成一个全新、从未见过的视角的图像。

VGGT 的性能指标:

PSNR: 30.41 (越高越好)

SSIM: 0.949 (越高越好)

LPIPS: 0.033 (越低越好)

虽然略低于当时最顶尖的 LVSM 模型 (PSNR 31.71),但含金量极高,因为 VGGT 是在两个巨大劣势下取得这个成绩的:

- 不知道相机参数: 所有其他对比方法都需要被告知输入图像的精确相机位置,而 VGGT 是在完全不知道这些信息的情况下进行预测的,难度要大得多。

- 训练数据更少: VGGT 用于此任务的训练数据量只有主要竞争对手 LVSM 的 20%。

结论:在解决一个更难的问题且训练不充分的情况下,还能取得与 SOTA (State-of-the-art) 方法相近的成果,这有力地证明了 VGGT 学习到的三维特征质量非常高。

动态点追踪 (Dynamic Point Tracking)

模型需要在包含移动物体的视频中,持续追踪指定的点。

将当时最先进的追踪器 CoTracker 的特征提取主干换成了 VGGT 的预训练主干,然后在多个基准(TAP-Vid)上进行测试。

结果显示,仅仅是替换了特征主干,就让 CoTracker 的性能在所有指标上都获得了巨大提升。例如,在 RGB-S 数据集上:

- 追踪可见点的准确率 (δ_vis_avg): 从 78.9 提升到 84.0

- 综合准确率 (AJ): 从 67.4 提升到 72.1

- 遮挡预测准确率 (OA): 从 85.2 提升到 91.6

结论:这是一个非常惊人的结果。它表明,尽管 VGGT 本身是在静态、无序的图像集合上训练的,但它学习到的几何特征具有极强的通用性和鲁棒性,以至于能直接迁移到它从未见过的动态视频场景中,并显著增强专业追踪器的性能。

方法对比

1.传统方法 (Optimization-based alternatives)

先收集一张张照片,然后比对照片中的同一个物体(特征点匹配),初步推测相机的位置,再根据这个推测反复计算、调整、修正,直到所有证据都能完美对上。这个过程非常严谨,但也很缓慢,需要一步一步地迭代优化。

传统的 Structure from Motion (SfM) 流程(以 COLMAP 为代表)

一个多阶段的模块化系统,通常包括:

- 特征提取与匹配: 在图像间寻找同名点。

- 几何验证与三角化: 恢复初始的稀疏三维结构和相机姿态。

- 捆绑调整 (Bundle Adjustment, BA): 一个计算密集型的迭代优化过程,用于联合精炼所有三维点和相机参数,以最小化重投影误差。

- 相机姿态估计: 计算出每张照片的拍摄位置和角度。这个子领域叫做 Structure from Motion (SfM)。

- 稠密重建: 在相机位置已知后,生成精细、密集的 3D 模型。这个子领域叫做 Multi-view Stereo (MVS)。

DUSt3R 和 MASt3R

- 目标是简化甚至取代上述那个复杂、分步的传统流程。

- 用一个统一的深度学习模型(特别是 Transformer 架构),可以直接从任意图片集(不需要预先知道相机信息)中,端到端地一次性输出稠密的 3D 点云和相机参数。

如何从普通照片中自动、快速、准确地创建三维模型。

2.VGGT (Feed-forward transformer)

采用了一个相当标准的大型 Transformer 架构,几乎没有引入任何特定的 3D 归纳偏见。

不需要繁琐的推理过程。你把几百张现场照片(证据)一次性全给,凭借其强大的“直觉”和海量的经验,瞬间就出:

- 每张照片是在哪里、什么角度拍的 (predicts cameras)。

- 整个场景的 3D 骨架是什么样的 (point maps)。

- 每张照片里,哪个物体离得近、哪个离得远 (depth maps)。

- 同一个物体在不同照片里的移动轨迹 (point tracks)。

这个过程是“一气呵成”的 (feed-forward),所以速度极快,而且结果往往比普通方法辛苦半天得到的还要准。

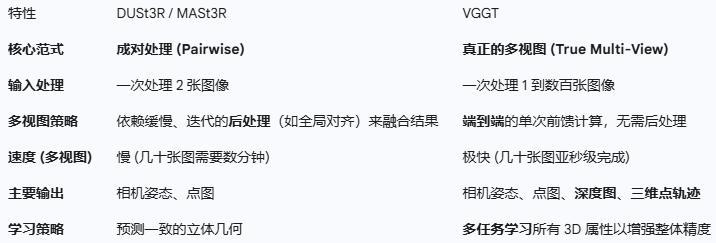

DUSt3R & MASt3R 和 VGGT都基于Transformer,有什么区别呢?

最核心的区别在于可扩展性 (Scalability)。VGGT 是一个为真正“多视图”重建而生的系统,而 DUSt3R 和 MASt3R 本质上是一个“双视图”(成对处理)系统,只是通过后续步骤适配了多视图的场景。

- 核心架构设计:成对处理 vs. 真正的多视图

- DUSt3R & MASt3R (成对处理为基础):

这两个模型的架构是为了一次性处理两张图像而设计的。它们的核心能力是输入一对图像,然后预测出在统一坐标系下完美对齐的两个稠密点云。- 如何处理多张图像? 当需要处理一个包含很多(如10张或100张)图像的场景时,它们必须依赖一个复杂且缓慢的“后处理”步骤。这通常需要对场景中的许多不同图像对分别运行模型,然后再用一个计算成本高昂的“全局对齐”或“捆绑调整”算法,将所有成对的重建结果“缝合”成一个统一、连贯的三维模型。这个过程很慢,而且容易累积误差。

- VGGT (真正的多视图架构):

VGGT 的架构则完全不同。它被设计为在单次前馈计算中,一次性“消化”一张、几张甚至数百张图像。- 如何处理多张图像? 它使用创新的“交替式注意力机制”同时处理所有图像,从一开始就建立对整个场景的全局一致性理解,同时考虑了所有视点。这完全消除了 DUSt3R/MASt3R 所依赖的成对融合与复杂的后处理步骤。

- 速度和效率

- DUSt3R & MASt3R:

虽然处理单个图像对的推理速度很快,但对于多视图场景,整体重建时间主要被缓慢的后处理对齐步骤所占据。重建一个32张图像的场景可能需要几分钟。 - VGGT:

整个过程就是一次性的前馈计算。这使得它在处理多视图场景时,速度要快几个数量级。重建一个32张图像的场景不到一秒钟,而DUSt3R则需要超过200秒。

- 输出范围

- DUSt3R & MASt3R:

主要专注于生成相机姿态和稠密点图(三维点云)。MASt3R 在 DUSt3R 的基础上增加了一个用于稠密特征匹配的预测头。 - VGGT (更全面):

它是一个统一的多任务模型,可以同时预测更广泛的 3D 属性:- 相机参数

- 深度图

- 点图

- 三维点轨迹 (通过一个专门的追踪头)

多任务学习方法,迫使模型同时学习这些相互关联的量,最终被证明可以提升所有预测任务的整体精度。

- 性能和泛化能力

- DUSt3R & MASt3R:

它们是开创性的工作,取得了当时最先进的结果,证明了端到端 Transformer 方法的可行性。 - VGGT:

在几乎所有多视图基准测试的直接对比中,VGGT 在精度上都显著优于 DUSt3R 和 MASt3R。它一次性处理所有视图的能力,在创建全局一致性更强、更准确的重建方面具有巨大优势。实验还表明,它对新的、未见过的数据集具有更好的泛化能力。

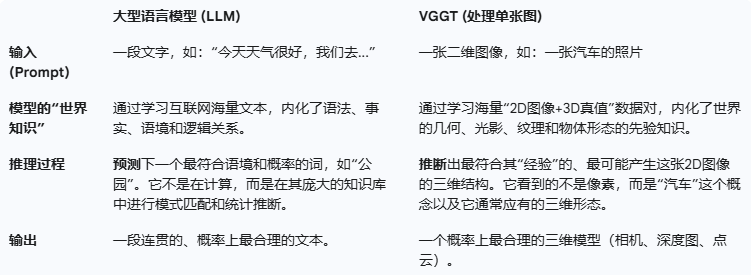

为什么vggt一张图就能工作,可以说 vggt处理一张图其实有点像直接用大模型推理吗?

VGGT 能够处理单张图像并产出三维信息,其根本原因在于它通过在海量数据上的学习,已经内化了关于我们三维世界的大量先验知识 (prior knowledge),学会了如何从单个二维视图中“脑补”出三维结构。

这和人类大脑的工作方式非常相似。当您看到一张桌子的照片时,即使只有一个视角,您也能立刻理解它是一个三维物体,大致猜出它的深度和形状。这是因为您一生中见过无数张桌子,已经对“桌子”这个物体的三维形态有了深刻的先验知识。

1. 学习了丰富的单目深度线索 (Monocular Depth Cues)

在训练过程中,VGGT 接触了数以百万计的、同时包含 2D 图像和其对应的真实 3D 标注(深度图、点云等)的数据。这使得它能够像人类一样,学会从单张图像中识别出推断深度的各种微妙线索:

- 透视关系 (Perspective): 模型学会了“近大远小”的规则。比如,在图像中,一条延伸向远方的路,两条路边虽然是平行的,但在图像上会汇聚到一点。模型看到这种模式,就能推断出深度变化。

- 纹理梯度 (Texture Gradient): 地面或墙壁上的重复性纹理,在图像中会随着距离的增加而变得越来越密集和模糊。模型捕捉到这种纹理密度的变化,就能推断出远近。

- 光照与阴影 (Lighting and Shading): 物体表面的明暗变化和投下的阴影,蕴含了大量关于其三维形状的信息。模型通过学习光影如何塑造物体,来反推其凹凸和形态。

- 遮挡关系 (Occlusion): 如果物体 A 挡住了物体 B 的一部分,模型就能立刻知道物体 A 在物体 B 的前面。

- 物体知识 (Object Knowledge): 这是最关键的一点。通过在包含无数常见物体(如汽车、椅子、建筑)的数据集上进行训练,VGGT 对这些物体的标准尺寸和典型形状形成了统计学上的“记忆”。当它在单张图片中看到一辆汽车时,它会从其“记忆”中调取关于汽车应该有多大、什么形状的先验知识,来辅助生成一个符合常理的三维模型。

2. “过度完备”的多任务学习框架

VGGT 不仅仅学习“图像到点云”这一个任务。它被要求同时预测相机参数、深度图、点图和追踪特征。这种设计迫使模型去学习这些量之间内在的几何关系。

对于单张图像,虽然没有其他视图来提供直接的几何约束,但模型为了能够输出一个自洽 (self-consistent) 的结果(即,预测出的相机参数、深度图和点图三者在数学上是匹配的),它必须依赖其学到的先验知识来生成一个最“合理”的三维解释。

3. DUSt3R 范式的继承

VGGT 的设计也借鉴了其前身 DUSt3R 的思想。DUSt3R 的论文中就提到,它的框架可以“平滑地统一单目和双目重建的情况 (smoothly unifies the monocular and binocular reconstruction cases)”。当 DUSt3R 只接收一张图作为输入时,它内部会将其复制一份,当作一个“双胞胎”图像对来处理,从而激活其深度预测能力。VGGT 作为一个更强大的多视图模型,自然也继承并优化了这种处理单视图输入的能力。

总结

因此,当 VGGT 只看到一张图时,它并不是在进行传统意义上的几何计算(因为信息不足),而是在进行一次基于海量经验的、高度复杂的“模式识别”和“推理”。它会问自己:“根据我见过的数百万个三维场景,眼前这张二维图像最可能对应于一个什么样的三维结构?” 然后,它会给出一个概率上最可信的答案。

VGGT 单视图工作模式的本质和我们熟知的大型语言模型(如 GPT)的工作方式如出一辙,是一个典型的“大模型推理 (Inference)”过程。

这就是为什么它的结果在“数据分布内”(in-distribution),即与训练数据相似的场景中会非常惊艳,而在面对非常奇特、罕见(out-of-distribution)的物体或场景时,可能会犯一些“想当然”的、违反物理常识的错误。

为什么 VGGT 能做到,还有什么缺点

1. Large feed-forward transformer (它的大脑构造)

目标: 实现端到端的快速推理,避免传统方法缓慢的迭代优化过程。

- Transformer 是一种强大的 AI 模型架构,它最擅长全局性地理解信息。当它看到几百张图片时,它不是一张一张地看,而是同时处理所有图片,理解它们之间的相互关联。这就像人一样,同时看多张照片能更好地构建出空间感。

- Feed-forward (前馈) 指的是数据从输入到输出只走一个方向,中间没有循环往复的计算。这就是它速度飞快的核心原因。它不像传统方法那样需要“猜一下 -> 修正一下 -> 再猜一下”,而是一步到位,直接给出答案。

2. Minimal 3D-inductive biases (它的学习方式)

目标: 让模型具有更强的通用性和适应性,不被预设的规则束缚。

- “Inductive bias”(归纳偏见)可以理解为 AI 被预先植入的“常识”或“假设”。例如,很多传统 3D 视觉算法被预设了很多几何学规则(比如透视原理)。

- VGGT 的这种“常识”非常少 (minimal)。它更像一个“白纸”,不依赖于人类预先设定的几何规则,而是借鉴了大型语言模型(如 GPT)和视觉模型(如 DINO)的成功经验:通过在包含丰富 3D 标注信息的大规模数据集上进行训练,让模型自行学习并内化潜在的几何规律与物理世界规则。这种方法的优势在于模型的通用性和扩展性更强,能够学习到比人类设计的规则更复杂的模式。

但缺点是,它需要极其庞大的数据量来“喂养”。

3. Trained on a trove of 3D-annotated data (它的教科书)

目标: 弥补 Minimal 3D-inductive biases 带来的“先天知识不足”,让模型从数据中学会 3D 重建。

- 既然模型本身是张“白纸”,那就需要一本极其详尽的“教科书”来学习。这本“教科书”就是海量的、带有 3D 标注的数据 (3D-annotated data)。

- 这些数据不仅包含图片,还精确地标注了每张图片对应的相机位置、场景的 3D 点云、深度信息等。模型通过对比自己的预测和这些“标准答案”,不断学习和进化,最终掌握了从 2D 图像重建 3D 空间的能力。

缺点1:对高质量、大规模标注数据的极端依赖

- 学术解释: VGGT 的强大能力源于在“海量带有 3D 标注的数据”上进行训练,以弥补其自身最小化的“归纳偏见”(即内置的几何规则)。这意味着模型的性能与训练数据的数量、多样性和标注精度直接挂钩。获取覆盖各种场景、光照、物体材质的大规模三维标注数据集,成本极其高昂且异常困难。

- 造成的结果:

- 高昂的训练/迁移成本: 若想让模型适应一个新的、垂直领域的应用(如工业零件扫描、室内设计),就需要为该领域重新收集和标注大量数据,这对大多数机构来说是不可行的。

- “偏见”继承: 如果训练数据本身存在某种系统性的偏差(例如,绝大多数是户外晴天的场景),那么模型在处理与训练数据分布差异较大的场景时(如室内、夜间、雨雪天气),性能会急剧下降。

- 应用领域的影响:

- 专业领域难以落地: 在医疗影像(如CT/MRI三维重建)、地质勘探、文物保护等专业领域,几乎不可能获得像训练 VGGT 那样规模的 3D 标注数据,导致模型难以直接应用或进行有效的微调。

- 利基市场受限: 对于特定的小众应用场景,例如重建一种特殊材料的物体,数据稀缺问题将成为模型应用的主要障碍。

缺点2:泛化能力的不确定性与“黑箱”问题

- 学术解释: 由于缺乏强大的几何约束作为“安全网”,VGGT 在面对其训练数据分布之外的“未知”情况(Out-of-Distribution)时,其行为可能变得不可预测。它可能不会像传统几何方法那样“优雅地失败”(例如,因找不到匹配点而报错),而是可能输出一个看似合理但实际上完全错误的、甚至违反物理常识的三维结构。同时,作为一个巨大的神经网络,其决策过程缺乏透明度,难以解释和调试。

- 造成的结果:

- 可靠性风险: 模型的错误可能是灾难性的,且难以预测其何时会发生。

- 调试和归因困难: 当重建结果出现问题时,很难定位失败的根本原因,只能通过调整数据或模型结构进行“猜测式”修复,这在工程上是巨大的挑战。

- 应用领域的影响:

- 安全关键领域慎用: 在自动驾驶、机器人导航、无人机测绘等对可靠性要求极高的安全关键(safety-critical)领域,一个几何上不合逻辑的重建结果可能导致灾难性后果。因此,对此类“黑箱”模型的部署会非常谨慎。

- 高精度测量领域存疑: 在建筑工程、测绘、工业质检等需要可量化、可验证精度的领域,传统方法的可解释性和可预测性依然具有不可替代的优势。VGGT 的结果可能非常出色,但在没有传统方法交叉验证的情况下,其精度保证(accuracy guarantee)是存疑的。

缺点3:对动态场景的天然局限性

- 学术解释: VGGT 的核心是解决一个类似 Structure from Motion (SfM) 的问题,其基本假设是场景本身是静态、刚性的,只是相机在移动。对于场景中存在的动态物体(如行人、车辆),模型会将其视为噪声或试图强行重建为一个扭曲的静态几何体。

- 造成的结果:

- 模型假设与现实脱节: 绝大多数现实世界中的视频和图像序列都包含动态元素。

- 重建结果污染: 动态物体会在三维点云中产生大量噪点、拖影或错误的几何结构,严重污染整体重建结果。

- 应用领域的影响:

- 视频和现实场景处理受限: 无法直接用于重建繁忙的城市街道、体育赛事、人群活动等包含大量动态物体的场景。

- AR/VR 应用挑战: 在需要实时理解和重建动态环境的增强现实(AR)应用中,VGGT 的静态假设使其无法直接胜任。虽然其提取的特征可以辅助追踪,但其核心重建功能在此类场景中是无效的。

缺点4:巨大的模型体积和计算资源需求

- 学术解释: 作为一个“大型”Transformer 模型,VGGT 拥有数十亿甚至更多的参数。这意味着模型文件本身非常大,并且即便其前馈推理速度很快(小于1秒),也需要高端的、拥有大显存的 GPU 才能运行。

- 造成的结果:

- 部署门槛高: 难以将模型部署到资源受限的边缘设备上。

- 能耗和成本: 在云端持续运行此类大型模型进行服务,也会带来不菲的计算成本和能源消耗。

- 应用领域的影响:

- 边缘计算(Edge Computing)受阻: 几乎无法在手机、无人机、普通汽车的嵌入式芯片或 AR 眼镜等设备上实时运行完整的 VGGT 模型。这限制了它在移动端和物联网设备上的应用。

- 大规模商业化成本: 对于需要处理海量用户数据的云服务,模型的高资源占用意味着更高的运营成本。

VGGT 的核心理念:用“大模型思维”颠覆传统 3D 视觉

借鉴自然语言处理领域(如 GPT)和 2D 视觉领域(如 DINO)的成功经验,即:用一个巨大、通用的基础模型来统一解决多个相关任务,而不是为每个小任务都设计一个专门的工具。

1. 一体化设计 (All-in-One Shared Backbone)

- 做法: VGGT 使用一个共享的 Transformer 网络,一次性预测出场景的所有关键 3D 属性(相机内外参、深度图、点云图、3D 点轨迹)。

- 对比: 这与之前的很多模型(如 DepthAnything, LRM)形成鲜明对比,那些模型通常只专注于一个任务,比如只预测单目深度或只生成新视角。

- 原因: 3D 属性是内在关联的。例如,准确的相机位置有助于生成更精确的深度图。通过让模型同时学习和预测所有这些属性,可以相互促进,最终提升整体的准确性。

2. 轻设计,重数据 (Minimal Inductive Biases)

- 做法: VGGT 并未采用专门为 3D 几何问题精心设计的复杂网络结构。相反,它用的是一个“相当标准的大型 Transformer”。

- 对比: 传统方法和一些混合方法(如 VGGSfM)深度依赖于几何约束和优化算法,比如捆绑调整 (Bundle Adjustment, BA)——一种通过迭代优化来同时精炼 3D 点位置和相机参数的经典算法。

- 原因: 模型设计哲学出现重大转变。VGGT 的强大能力并非源于内置的几何“常识”(即 Inductive Biases),而是源于在海量带有 3D 标注的数据集上进行“暴力”学习。它自己从数据中学会了三维几何的规律,使其更加灵活和强大。

VGGT 的关键优势:为何它更快、更强?

1. 速度与效率:告别缓慢的迭代优化

做法: VGGT 是一个前馈 (feed-forward) 网络,只需一次计算(a single forward pass)就能得到所有结果,耗时不到一秒。

对比:

- 传统方法: 严重依赖如 BA 这样的迭代优化技术,计算成本高,非常耗时。

- DUSt3R / MASt3R: 虽然也是神经网络,但它们一次只能处理两张图片,要重建一个大场景,就需要对很多图片对进行两两重建,然后再通过复杂的后处理步骤将它们拼接起来,同样耗时且可能引入累积误差。

优势: VGGT 可以一次性处理数百张视图,直接从全局信息中理解整个场景,省去了所有中间步骤和后处理优化,因此既快又准。

2. 卓越的性能与通用性

- 直接可用性: VGGT 的预测结果“开箱即用”,其精度在没有经过任何额外优化的情况下,就常常优于那些需要漫长后处理的 SOTA (State-of-the-art) 方法。

- 强大的基础模型 (Backbone): 论文证明,预训练好的 VGGT 可以作为一个强大的特征提取器。将它用于其他下游任务(如动态视频中的非刚性点跟踪、新视角合成),能显著提升这些任务的效果。这证明了它作为“3D 视觉基础模型”的巨大潜力。

- 兼容并包: 虽然 VGGT 的目标是“摆脱”后处理,但论文也指出,如果将 VGGT 的输出作为初始值,再结合传统的 BA 进行优化,得到的结果将是“全面 SOTA”,甚至大幅超越专门为某一任务设计的模型。这说明 VGGT 也能极大地增强现有工作流程。

在计算机视觉研究领域的定位

1. 相对于 Structure from Motion (SfM)

VGGT 被定位为传统 SfM 流程的直接替代品。它将一个复杂的、依赖迭代优化的系统,转变为一个高效的、基于数据驱动的端到端学习问题。

2. 相对于 Multi-view Stereo (MVS)

VGGT 是对先前 MVS 领域学习方法(如 DUSt3R, MASt3R)的重大超越。先前的方法通常局限于处理两个视点(pairwise),对于多视图场景需要复杂的后续融合步骤。VGGT 的核心优势在于能够一次性处理从单个到数百个任意数量的视点,利用全局上下文信息生成全局一致的稠密重建,从而在精度和鲁棒性上都取得了显著提升。

3. 相对于点追踪 (Tracking-Any-Point, TAP)

在此领域,VGGT 的角色并非直接竞争者,而是一个强大的赋能者(enabler)或特征骨干(feature backbone)。VGGT 自身学习到的特征表示包含了丰富的几何感知信息。当这些特征被提供给现有的专业点追踪算法(如 CoTracker)时,能够极大地提升其追踪性能,尤其是在处理遮挡等复杂场景时的鲁棒性。这证明了 VGGT 作为一个 3D 视觉基础模型的巨大潜力。

总结

VGGT 的核心思想是用一个巨大、强大的 Transformer 模型,通过暴力学习海量数据的方式,来取代传统 3D 视觉中那个缓慢、分步、依赖规则的优化过程。

它代表了 AI 领域的一个趋势:当计算能力和数据量足够大时,一个端到端的、学习驱动的“大力出奇迹”模型,可以在速度和精度上同时超越精心设计的传统算法。

浙公网安备 33010602011771号

浙公网安备 33010602011771号