KDNuggets-博客中文翻译-二十九-

KDNuggets 博客中文翻译(二十九)

原文:KDNuggets

Python 向量数据库和向量索引:LLM 应用的架构设计

原文:

www.kdnuggets.com/2023/08/python-vector-databases-vector-indexes-architecting-llm-apps.html

图片由 Christina Morillo 提供

由于使用其硬件创建的生成 AI 应用,Nvidia 体验到了显著的增长。另一项软件创新——向量数据库——也在乘上生成 AI 的浪潮。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持组织的 IT 工作

开发者们正在使用 Python 和向量数据库构建 AI 驱动的应用程序。通过将数据编码为向量,他们可以利用向量空间的数学属性,实现对非常大数据集的快速相似性搜索。

让我们从基础开始吧!

向量数据库基础

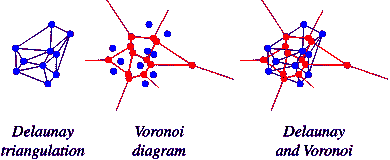

向量数据库将数据存储为坐标空间中的数值向量。这使得可以通过如余弦相似度等操作计算向量之间的相似性。

最近的向量代表最相似的数据点。与标量数据库不同,向量数据库被优化用于相似性搜索,而不是复杂的查询或事务。

检索相似向量只需几毫秒,而非几分钟,即使在数十亿数据点中也是如此。

向量数据库构建索引,以通过接近度高效地查询向量。这有点类似于文本搜索引擎如何为快速全文搜索对文档进行索引。

向量搜索相较于传统数据库的好处

对于开发者来说,向量数据库提供:

-

快速相似性搜索 - 毫秒级找到相似向量

-

动态数据支持 - 持续用新数据更新向量

-

可扩展性 - 在多台机器上扩展向量搜索

-

灵活的架构 - 向量可以存储在本地、云对象存储或托管数据库中

-

高维度 - 每个向量索引数千维度

-

API - 如果你选择托管的向量数据库,它通常附带干净的查询 API 和与现有数据科学工具包或平台的集成。

向量搜索(向量数据库的关键功能)支持的流行用例示例如下:

-

视觉搜索 - 查找相似的产品图片

-

推荐 - 建议内容

-

聊天机器人 - 匹配查询意图

-

搜索 - 从文本向量中提取相关文档

向量搜索开始获得关注的用例有:

-

异常检测 - 识别异常向量

-

药物发现 - 按属性向量关联分子

什么是 Python 向量数据库?

一个包含支持向量数据库完整生命周期的 Python 库的向量数据库就是一个 Python 向量数据库。 数据库本身不需要用 Python 构建。

这些 Python 向量数据库库应该支持什么?

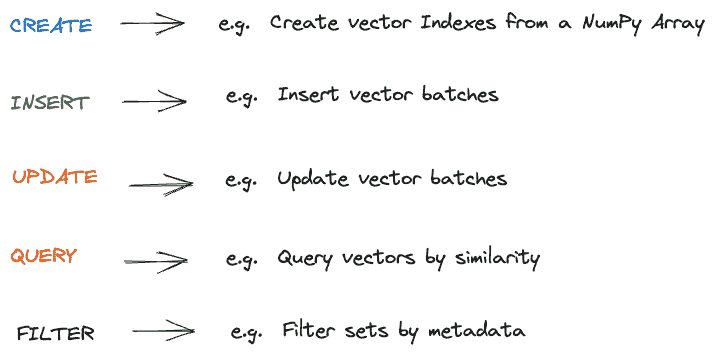

对向量数据库的调用可以分为两类 - 数据相关和管理相关。 好消息是它们遵循与传统数据库类似的模式。

数据相关功能库应支持的内容

标准管理相关功能库应支持的内容

现在让我们进入一个稍微复杂的概念,即在这些数据库之上构建 LLM 应用

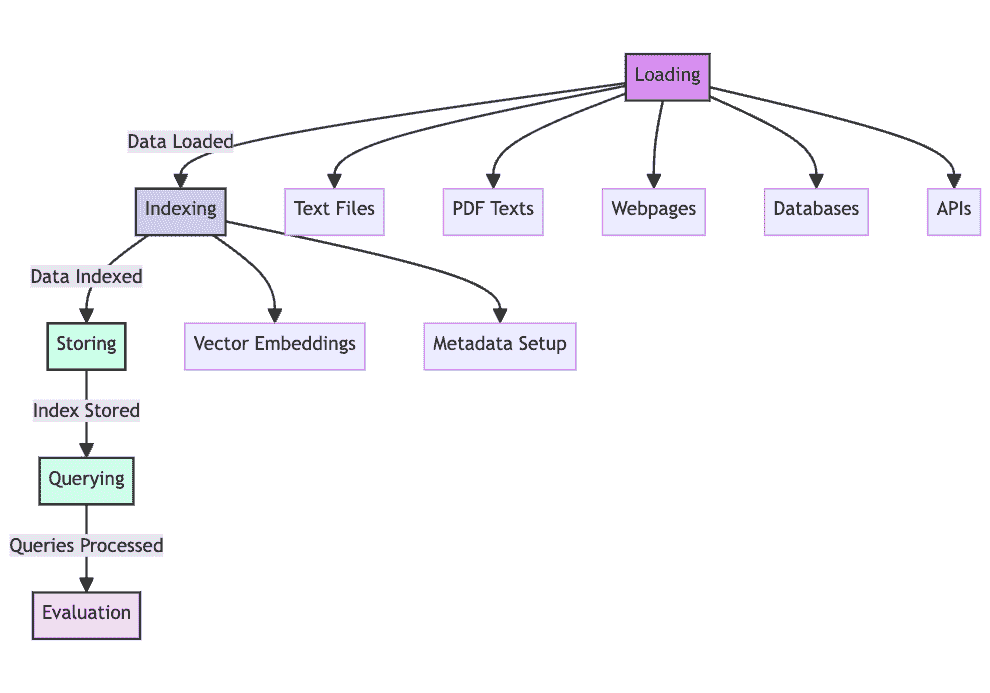

架构 LLM 应用

在深入了解由向量搜索驱动的 LLM 应用架构之前,让我们从工作流的角度理解涉及的内容。

一个典型的工作流包括:

-

数据的丰富或清洗。这是一个轻量的数据转换步骤,有助于数据质量和一致的内容格式化。这也是需要对数据进行丰富的地方。

-

通过模型将数据编码为向量。这些模型包含一些变换器(例如句子变换器)

-

将向量插入向量数据库或向量索引(稍后会解释)

-

通过 Python API 暴露搜索

-

文档协调工作流

-

在应用程序和用户界面中测试和可视化结果(例如聊天用户界面)

现在让我们看看如何使用不同的架构组件来启用这个工作流的不同部分。

对于 1),你可能需要开始从其他源系统(包括关系型数据库或内容管理系统)获取元数据。

预训练模型几乎总是优选用于上面的步骤 2)。 OpenAI 模型是通过托管服务提供的最受欢迎的模型。 出于隐私和安全原因,你也可以托管本地模型。

对于 3),如果需要进行大规模相似性搜索(例如数据集超过十亿条记录),你需要一个向量数据库或向量索引。从企业的角度来看,通常在进行“搜索”之前会有更多背景信息。

关于 4)上面的内容,好消息是,暴露的搜索通常遵循类似的模式。类似于以下代码:

来自 Pinecone。

index = pinecone.Index("example-index")

index.upsert([

("A", [0.1, 0.1, 0.1, 0.1], {"genre": "comedy", "year": 2020}),

)

index.query(

vector=[0.1, 0.1, 0.1, 0.1],

filter={

"genre": {"$eq": "documentary"},

"year": 2019

},

top_k=1,

)

这里有一句有趣的话:

filter={

"genre": {"$eq": "documentary"},

"year": 2019

},

它真的将结果筛选到接近“类型”和“年份”的向量。你还可以按概念或主题筛选向量。

现在的挑战是在企业环境中,它包括其他业务过滤器。重要的是解决来自数据源(如表结构和元数据)的数据建模缺失的问题。需要改进文本的准确性,减少与结构化数据相矛盾的错误表达。在这种情况下,需要一种“数据管道”策略,企业“内容匹配”变得重要。

对于 5) 除了常见的扩展挑战外,变化中的语料库也有其挑战。新文档可能需要重新编码和重新索引整个语料库,以保持向量的相关性。

对于 6) 这是一个全新的领域,除了测试相似度水平外,还需要一种人工干预的方法,以确保搜索质量在各个范围内的一致性。

自动搜索评分和不同类型的上下文评分不是一个容易完成的任务。

Python 向量索引:为你现有数据库提供一种更简单的向量搜索替代方案。

向量数据库 是一个复杂的系统,能够实现如上例所示的上下文搜索,并具备所有额外的数据库功能(创建、插入、更新、删除、管理等)。

向量数据库的例子包括 Weaviate 和 Pinecone。这两个都提供了 Python API。

有时,更简单的设置已经足够。作为一种更轻量的替代方案,你可以使用已经在用的存储,并基于此添加一个 向量索引。这个向量索引用于检索带有上下文的搜索查询,例如用于你的生成性 AI。

在向量索引设置中,你需要:

-

你通常的数据存储(例如 PostgreSQL 或带文件的磁盘目录)提供了你需要的基本操作:创建、插入、更新、删除。

-

你的向量索引,能够在你的数据上实现快速的基于上下文的搜索。

实现向量索引的独立 Python 库包括 FAISS、Pathway LLM、Annoy。

好消息是,向量数据库和向量索引的 LLM 应用流程是相同的。主要区别在于,除了使用 Python 向量索引库外,你还需要继续使用现有的数据库进行“普通”数据操作和数据管理。例如,如果你使用 PostgreSQL,可能会用到 Psycopg;如果你将数据存储在文件中,可以使用标准的 Python “fs” 模块。

向量索引的支持者关注以下优点:

-

数据隐私:保持原始数据安全且不受干扰,减少数据暴露风险。

-

成本效率:减少与额外存储、计算能力和许可相关的成本。

-

可扩展性:通过减少管理的组件数量来简化扩展。

什么时候使用向量数据库与向量索引?

当以下一个或多个条件成立时,向量数据库是有用的:

-

你对大规模处理向量数据有特殊需求。

-

你正在为向量创建一个独立的定制应用程序。

-

你不期望在其他类型的应用程序中使用存储的数据。

向量索引在以下一个或多个条件成立时是有用的:

-

你不想信任新技术来进行数据存储。

-

你现有的存储可以从 Python 中轻松访问。

-

你的相似性搜索只是其他更大企业 BI 和数据库需求中的一种能力。

-

你需要将向量附加到现有的标量记录中。

-

你需要一种统一的方法来处理数据工程团队的管道。

-

你需要在数据上使用索引和图结构,以帮助你的LLM 应用程序或任务。

-

你需要来自其他来源的增强输出或增强上下文。

-

你想从语料库中创建规则,以应用于你的事务数据。

企业向量搜索的未来

向量搜索为开发者解锁了颠覆性的能力。随着模型和技术的进步,预计向量数据库或向量索引将成为应用程序堆栈的核心部分。

我希望这个概述为你探索 Python 中的向量数据库和向量索引提供一个坚实的起点。如果你对最近开发的向量索引感兴趣,请查看这个开源项目。

Anup Surendran 是一位产品和产品营销副总裁,专注于将 AI 产品推向市场。他曾与两家成功退出(被 SAP 和 Kroll 收购)的初创公司合作,并喜欢教授其他人如何利用 AI 产品提高组织的生产力。

更多相关主题

Python 与 R - 谁在数据科学、机器学习领域真正领先?

原文:

www.kdnuggets.com/2017/09/python-vs-r-data-science-machine-learning.html

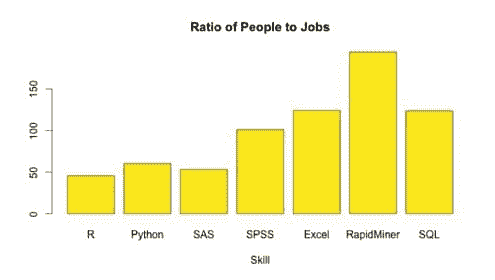

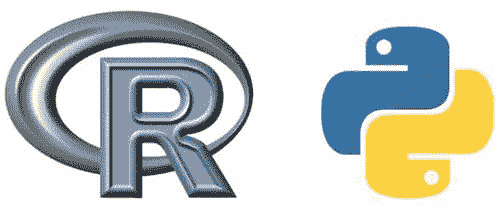

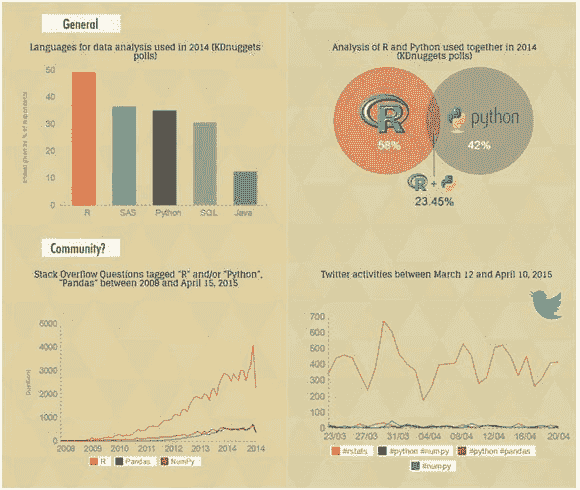

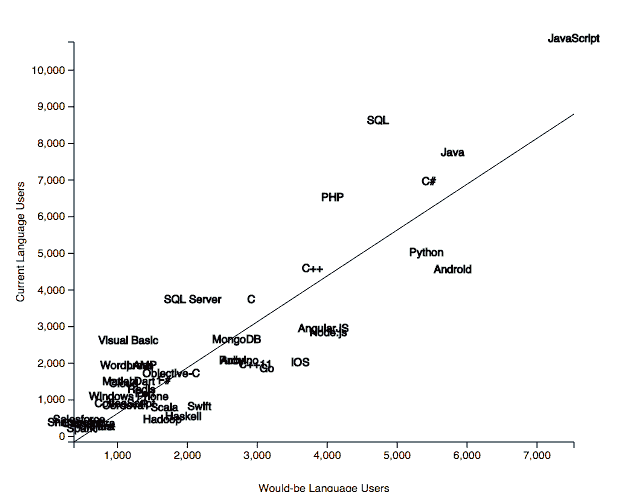

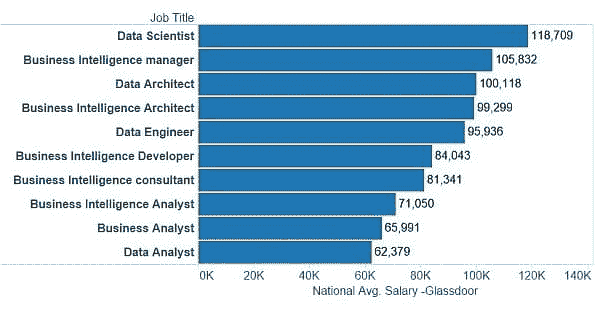

评论我最近对 KDnuggets 调查结果的分析(Python 超越 R,成为数据科学和机器学习平台的领导者)引起了广泛关注,并生成了大量评论、讨论,以及来自两种语言支持者的不可避免的批评。

评论我最近对 KDnuggets 调查结果的分析(Python 超越 R,成为数据科学和机器学习平台的领导者)引起了广泛关注,并生成了大量评论、讨论,以及来自两种语言支持者的不可避免的批评。

一些人抱怨调查不具备科学性,投票者代表的是自我选择的样本。这显然是正确的。但 KDnuggets 自 2001 年以来一直进行调查,并且每月覆盖了数十万的访问者。根据我们的经验,KDnuggets 的调查一直是数据挖掘和数据科学趋势和发展的良好指标。我们跟踪了 R 与 Python 的辩论好几年,因此与其他网站不同,我们可以将最新的调查结果与几年前的结果进行比较。

让我们检查一下数据科学家对 Python 和 R 的受欢迎程度的其他衡量标准。

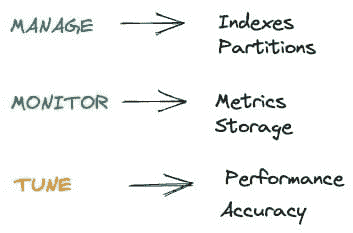

首先,我们分析了 Google Trends(这一点在我们调查结果发布后也被 DSC 进行了分析)。

Python 是一个更受欢迎的编程语言,它在 2017 年 IEEE Spectrum 第 1 语言 排名中名列前茅(感谢 Martin Skarzynski @marskar 提供的链接),因此直接比较 Python 和 R 的搜索量是不公平的,但我们可以比较 Google Trends 上的搜索词“Python 数据科学”与“R 数据科学”。

这是自 2012 年 1 月以来的图表。注意,如果选择包含完整月份的范围,并且从 2012 年开始,那么你会获得平滑的月度趋势,而不是更为混乱的每周趋势。

图 1: Google Trends,2012 年 1 月 - 2017 年 8 月,“Python 数据科学”与“R 数据科学”。

我们注意到,在 2014 年和 2015 年,随着数据科学的普及,R 略微领先,但“Python 数据科学”搜索在 2016 年底超过了“R 数据科学”,并且自 2017 年 1 月以来明显领先。

注意:无论数据科学如何大写(“Data Science”或“data science”),统计数据都是相同的,但 Google 自动完成建议在 Python 和 R 中都使用“data science”。

不过,最近机器学习变得非常流行 - 请参见我在 机器学习超越大数据? 的帖子(2017 年 5 月),所以我们来看看 Google Trends 上的 Python 与 R 在“机器学习”方面的对比。

图 2:Google 趋势,2012 年 1 月 - 2017 年 8 月,“Python 机器学习”、“R 机器学习”、“Python 数据科学”和“R 数据科学”。

我们看到“Python 机器学习”远远领先于“Python 数据科学”,两者都显著领先于“R 数据科学”和“R 机器学习”。

2017 年 8 月的相对搜索量是

-

Python 机器学习:100

-

Python 数据科学:49

-

R 数据科学:33

-

R 机器学习:32

(注意:虽然 Google 自动完成建议搜索词“Python 数据科学”,并且以小写“data science”,它还建议了以大写的“Python 机器学习”。这里可能有一些深层次的含义……)

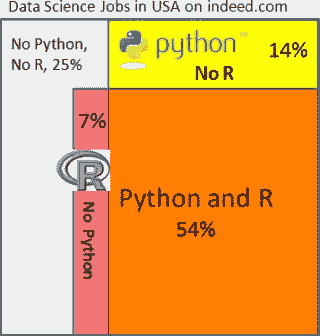

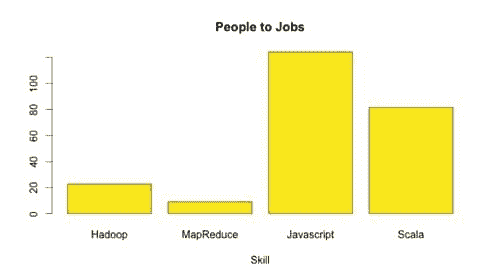

图 3:Snapshot of indeed.com 数据科学家职位广告在美国,同时包含 Python 和/或 R,2017 年 9 月接下来,我们来看 indeed.com 上的职位广告。以下所有数字均为截至 2017 年 9 月 11 日在美国的职位。

-

搜索 "数据科学家" 发现 3,558 个职位

-

搜索 "数据科学家" Python 发现 2,407 个职位(占所有职位的 68%)

-

搜索 "数据科学家" R 发现 2,179 个职位(占所有职位的 61%)。

-

搜索 "数据科学家" Python R 发现 1,906 个职位(占所有职位的 54%)

-

搜索 "数据科学家" -Python -R 发现 892 个职位(占所有职位的 25%)

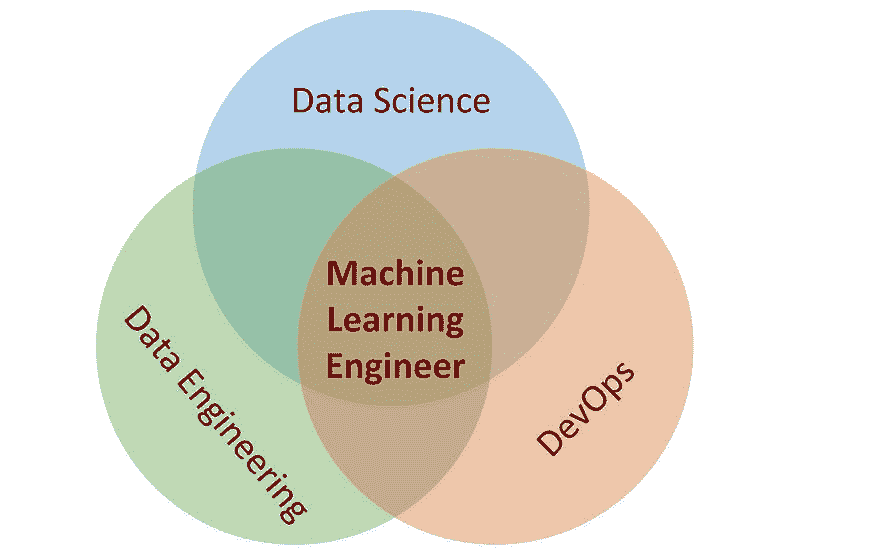

我们在右侧的维恩图中展示了这种关系。

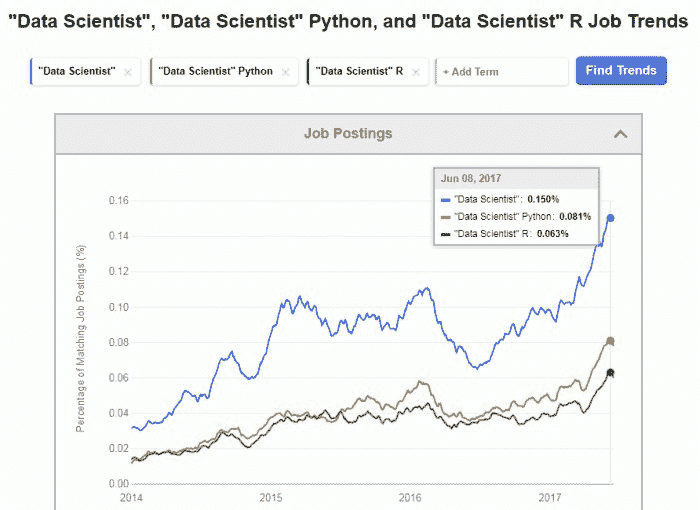

Indeed 职位趋势也显示,了解 Python 和了解 R 的数据科学家的需求直到最近才接近,并且这些职位占所有数据科学家职位的很大一部分。

图 4:Indeed “数据科学家”、“数据科学家” Python 和 “数据科学家” R 职位趋势,2014-2017

这些职位广告数量表明,当前雇主认为大多数数据科学家能够根据需要使用 Python 和 R,但目前 Python 稍有优势。

Google 趋势结果表明,Python 的优势将会增长,而与 Python 相关的数据科学和机器学习职位的增长速度将快于与 R 相关的职位。

注意:使用 indeed.com 时,你需要仔细指定搜索字符串,搜索 [数据科学家 Python] 会包含很多职位,这些职位可能包含“数据”或“科学家”,但不一定两者都有。

最后,在我原始帖子 Python 超越 R 在数据科学中 上的许多评论中,我想强调两个观察点:

-

Stanislav Seltser 指出,在 github 上排名前 15 的语言中,

octoverse.github.com中,Python 排名第 3,而 R 不在列表中。 -

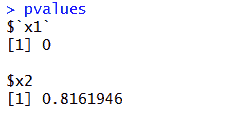

Stanislav 还提到 Kaggle 2016 年总结,其中指出

过去几年,R 是 Kaggle 上的首选语言,但 2016 年 Python 在编写的 kernels 数量上脱颖而出,成为明显的赢家。

![Kaggle Python 与 R Kernels 2016]()

相关:

-

Python 超越 R,成为数据科学和机器学习平台的领导者

-

Python 超越 R?

-

Python 与 R 在人工智能、机器学习和数据科学中的对比

更多相关话题

初学者和 Udacity 深度学习纳米学位的 PyTorch 备忘单

原文:

www.kdnuggets.com/2019/08/pytorch-cheat-sheet-beginners.html

评论

评论

由 Uniqtech 提供

使用一致的自上而下的方法入门 Pytorch 的备忘单。这份备忘单应该比官方文档更容易消化,并且应作为一个过渡工具,帮助学生和初学者尽快开始阅读文档。本文正在不断改进,频繁更新,并将保持在建设中,直到显著改善。您的反馈非常感谢 hi@uniqtech.co,错误和拼写错误将会被及时纠正。

大新闻:我们在 Medium 机器学习和数据科学主页上发表了文章。请点击 ← 并评论以表示支持。下面的备忘单主要是叙述性的。详细备忘单的 PDF JPEG 版本将很快发布,并将发布在本文中。更新于 2019 年 6 月 18 日,为了使本备忘单/教程更具连贯性,我们将插入来自获奖 Kaggle 内核的代码片段,以说明重要的 PyTorch 概念 — 使用 PyTorch 进行的疟疾检测,一个图像分类计算机视觉 Kaggle 内核 [见 Source 3 下] 作者 devilsknight 和 vishnu aka qwertypsv。

uniqtech 提供的初学者 PyTorch 备忘单

Pytorch 用自己的话定义

Pytorch 是“一个开源深度学习平台,提供从研究原型到生产部署的无缝路径。”

根据 Facebook 研究 [Source 1],PyTorch 是一个提供两个高级特性的 Python 包:

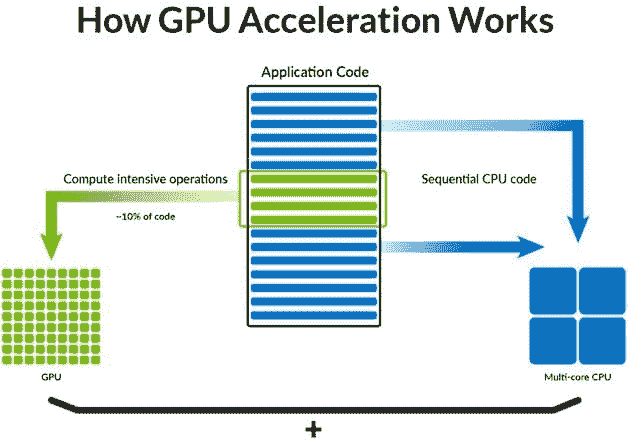

具有强大 GPU 加速的张量计算(如 NumPy)

基于带状自动微分系统构建的深度神经网络

你可以在需要时重用你最喜欢的 Python 包,如 NumPy、SciPy 和 Cython,以扩展 PyTorch。

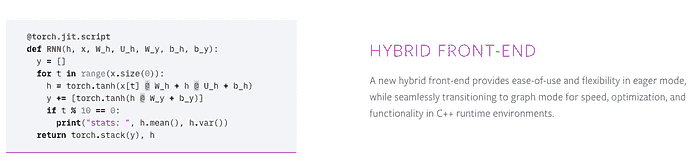

Soumith Chintala,Facebook 研究工程师和 PyTorch 的创造者,提供了一些关于 PyTorch 的有趣事实:自动微分曾经是用 Python 编写的,但大多数(代码)已改为 C++(以适应生产)。他认为有趣的 PyTorch 1.0 特性包括混合前端、生产模型解析、使用 Jit 编译器使模型适合生产等。来源:Chintala 在 Udacity 学习中的访谈。

主要特点

组件 | 描述 [Source 2]

torch:一个类似于 NumPy 的张量库,具有强大的 GPU 支持

torch.autograd: 一个基于带状的自动微分库,支持 torch 中所有可微分的张量操作

torch.jit:一个编译堆栈(TorchScript),用于从 PyTorch 代码创建可序列化和可优化的模型。

torch.nn:一个深度集成自动求导的神经网络库,设计为最大灵活性。

torch.multiprocessing:Python 多进程,但具有跨进程共享 torch 张量的神奇内存功能。适用于数据加载和 Hogwild 训练。

torch.utils:DataLoader 和其他实用函数,方便使用。

主要特性:混合前端、分布式训练、Python 优先、工具和库。

这些功能通过 功能页面 上的并排代码示例得到了优雅的展示!

Pytorch 文档中的功能页面展示了优雅的代码示例以说明每个功能。还需注意 Python 3 的点积简写,如“@”。

混合前端允许在即时模式和(计算)图模式之间切换。Tensorflow 曾经仅支持图模式,这被认为是快速和高效的,但很难修改、原型设计和研究。由于 Tensorflow 现在也提供即时模式(不再需要session run),这个差距正在缩小。

分布式训练:支持 GPU、CPU 和两者之间的轻松切换。(Tensorflow 还支持 TPU,即 Tensor 处理单元。)

Python 优先:为 Python 开发者打造。轻松创建神经网络,在 Pytorch 中运行深度学习。工具和库包括强大的计算机视觉库(卷积神经网络和预训练模型)、自然语言处理等。

Pytorch 还包括像 torch.tensor 实例化和计算、模型、验证、评分、自动计算梯度的 Pytorch 特性(使用 autograd,它也会为你执行所有的反向传播)、迁移学习准备好的预加载模型和数据集(阅读我们关于迁移学习的超短有效文章),还有使用 CUDA 的 GPU。

何时使用 Pytorch

AWS、Google 和 GCP 的 GPU 支持 Pytorch 作为一流公民。

Pytorch 为 1.0 版本新增了生产和云合作伙伴支持,包括 AWS、Google Cloud Platform 和 Microsoft Azure。现在你可以在任何深度学习任务中使用 Pytorch,包括计算机视觉和自然语言处理,甚至是在生产环境中。

因为它易于使用且具有 Python 风格,高级数据科学家 Stefan Otte 说:“如果你想要有趣的体验,使用 pytorch”。

Pytorch 也得到了 Facebook AI 研究的支持,因此如果你想在 Facebook 从事数据和机器学习工作,你应该了解 Pytorch。如果你擅长 Python 并且想成为开源贡献者,Pytorch 也是一个不错的选择。

迁移学习

迁移学习使用模型来预测未曾训练的数据集的类型。它可以显著提高训练时间和准确性。它还可以帮助处理可用训练数据有限的情况。Pytorch 有一个专门页面,介绍了预训练模型及其在行业标准基准数据集上的性能。请在我们的 Pytorch 迁移学习文章中阅读更多内容。

# pretrained models are at torchvision > models

model = torchvision.models.resnet152(pretrained=False)

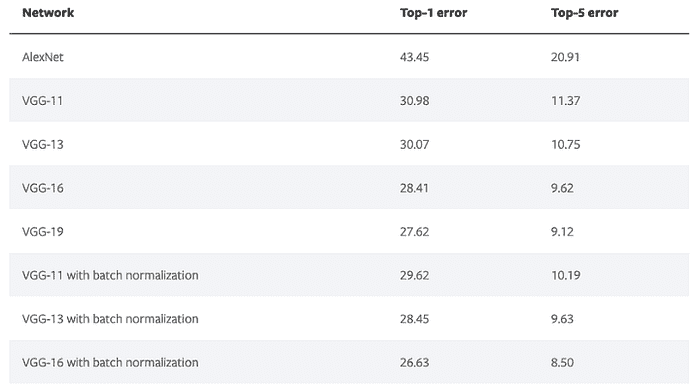

阅读 Pytorch 文档中所有可用模型。请注意,模型的 top-1-error 和 top-5-error,即模型的性能也可以查看。

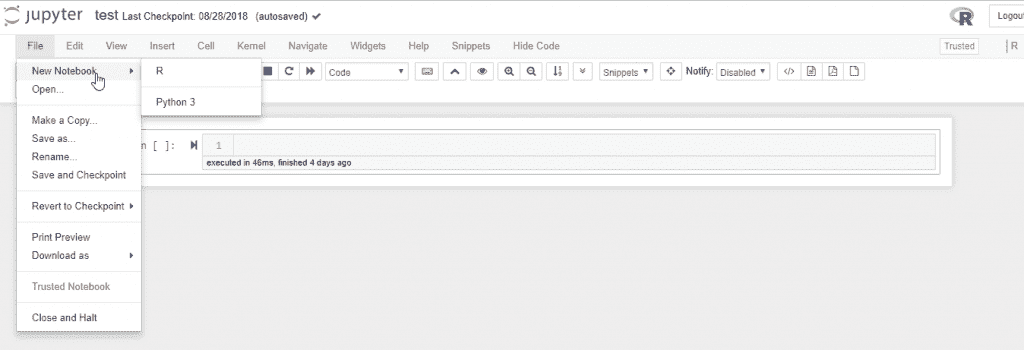

数据科学,学术研究 | 使用 Jupyter Notebook 进行演示

由于 Python 拥有庞大的开发者社区,因此在学生和研究人员中更容易找到转向数据科学和学术研究的 Python 人才,甚至使用 Pytorch 编写生产代码。这消除了学习另一种语言的需求。许多数据分析师和科学家已经熟悉 Jupyter Notebook,Pytorch 在其上运行得非常完美。请在我们的部署 Pytorch 模型到 Amazon Web Service SageMaker 中阅读更多内容。

Pytorch 是一个深度学习框架

Pytorch 是一个深度学习框架,就像 Tensorflow 一样,这意味着:对于传统的机器学习模型,目前请使用其他工具。Scikit-learn 是一个 Python 风格的深度学习框架,具有极易使用的 API。文档非常好,每页底部都有代码片段的示例。去看看。你知道吗,许多 Kaggle 用户包括大师们仍然使用 sklearn 的 train_test_split() 来拆分和 scaler 来预处理数据,sklearn 的 Gradient Boosting Tree 或支持向量机来基准测试性能,而顶级高性能的 XGBoost 却显著缺失。

Tensorflow.js 和 Tensorflow.lite 让 Tensorflow 在浏览器和移动设备上展翅飞翔。苹果刚刚在 2019 年 6 月宣布了 Swift 的 CreateML。移动支持在 Pytorch 中尚未原生实现。不要气馁。向下滚动以阅读关于 ONNX 的内容,它几乎被所有流行框架支持的交换格式。Pytorch 也有一个关于将模型移动到移动设备的教程,尽管这条路与 Tensorflow 相比仍有些绕行。

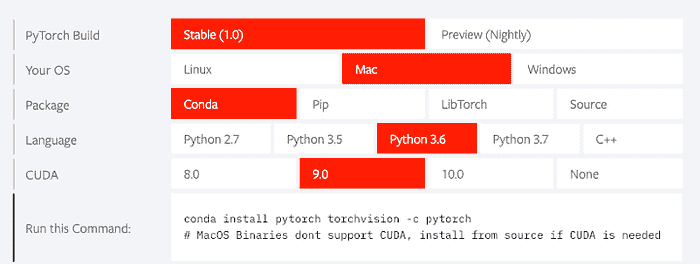

安装 Pytorch

对于安装技巧,首先使用官方的 Pytorch 文档。pytorch.org/get-started/locally/ 以上截图是可用安装的示例。

使用 Anaconda 安装 Pytorch 是一个在各种系统中包括 Windows 上的良好起点。我们能够在游戏电脑上使用 Anaconda 安装 Pytorch 并立即开始使用它的 CUDA GPU 功能。阅读我们的 Anaconda 速查表。

conda install numpy jupyter notebook

conda install pytorch torchvision -c pytorch

你好,Pytorch 的世界就像在启动 Google Colab 一样简单(没错,在 Google 的领地上),然后import torch,看看这个只读共享笔记本。现代托管数据科学笔记本如 Kaggle Kernel 和 Google Colab 都预先安装了 Pytorch。

看呐:无需服务器的深度学习!

更喜欢基于 Jupyter Notebook 的教程吗?从这篇文章底部找到 Udacity Intro to Pytorch 仓库开始入门。

更喜欢其他的安装方法?二进制文件,从源代码编译,和 Docker 镜像,请见来源 2。

来自来源 3 的代码片段

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import torch

from torch import nn, optim

from torchvision import transforms, datasets, models

from torch.utils.data.sampler import SubsetRandomSampler

import os

print(os.listdir("../input/cell_images/cell_images/"))

导入torch是执行核心 Pytorch 任务所必需的。你还会看到导入 torch 神经网络模块nn、优化器optim和计算机视觉模块torchvision,数据转换管道transforms、datasets和现有的models。在这种情况下,Kaggle 团队还使用了一个SubsetRandomSampler,你将在后续片段中看到它如何被输送到数据转换和加载管道中。

数据转换

来自来源 3 的代码片段

注意,训练、测试和验证转换器是相似但不同的。为了增广数据,训练数据会被随机旋转、调整大小和裁剪,甚至垂直翻转(在这种情况下,一个翻转的疟疾细胞不会对分类结果产生负面影响)。因为测试和验证数据应该模拟真实世界数据,不引入任何随机噪音或翻转。就像它们一样,带有中心裁剪。注意大小必须保持一致。深度学习涉及大量的矩阵乘法。维度大小总是很重要的。在图像分类任务中,我们通常希望根据将要使用的预训练模型或现有数据集对图像进行归一化。

# Define your transforms for the training, validation, and testing sets

train_transforms = transforms.Compose([transforms.RandomRotation(30),

transforms.RandomResizedCrop(224),

transforms.RandomVerticalFlip(),

transforms.ToTensor(),

transforms.Normalize([0.485, 0.456, 0.406],

[0.229, 0.224, 0.225])])test_transforms = transforms.Compose([transforms.Resize(256),

transforms.CenterCrop(224),

transforms.ToTensor(),

transforms.Normalize([0.485, 0.456, 0.406],

[0.229, 0.224, 0.225])])validation_transforms = transforms.Compose([transforms.Resize(256),

transforms.CenterCrop(224),

transforms.ToTensor(),

transforms.Normalize([0.485, 0.456, 0.406],

[0.229, 0.224, 0.225])])

为什么要进行归一化?那些奇怪数字是什么?均值和标准差。

normalize = transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]) # Source 4

千万别忘记使用 ToTensor 将所有内容转换为 Pytorch 张量。

为什么?因为 Pytorch 需要它。阅读 Pytorch 的创作者 Chimtala 关于此的讨论串 [Source 5]。

输入图像首先被加载到范围[0, 1]中,然后这种归一化被应用到 RGB 图像中,如此描述.. torch vision — 专门用于计算机视觉的数据集、转换和模型

所有预训练模型都希望输入图像以相同方式进行归一化,即形状为(3 x H x W)的 3 通道 RGB 图像的小批量,其中 H 和 W 至少应为 224。

图像必须被加载到范围[0, 1]中,并且使用均值=[0.485, 0.456, 0.406]和标准差=[0.229, 0.224, 0.225]进行归一化

这种归一化的示例可在此 Imagenet 示例中找到[来源 4]

使用训练和测试加载器加载数据

train_loader = torch.utils.data.DataLoader(train_data, batch_size=batch_size, num_workers=num_workers)

test_loader = torch.utils.data.DataLoader(test_data, batch_size=batch_size, num_workers=num_workers)

源 3 的代码片段

datasets.ImageFolder 和 torch.utils.data.DataLoader 一起工作,以根据 batch_size 和之前部分中的数据变换来分别加载训练、验证和测试数据。每个数据集都有自己的加载器。

img_dir='../input/cell_images/cell_images/'

train_data = datasets.ImageFolder(img_dir,transform=train_transforms)... # omitted

*# convert data to a normalized torch.FloatTensor*

... # omitted

*# obtain training indices that will be used for validation*

... # omitted

print(len(valid_idx), len(test_idx), len(train_idx))

*# define samplers for obtaining training and validation batches*

train_sampler = SubsetRandomSampler(train_idx)

valid_sampler = SubsetRandomSampler(valid_idx)

test_sampler = SubsetRandomSampler(test_idx)

*# prepare data loaders (combine dataset and sampler)*

train_loader = torch.utils.data.DataLoader(train_data, batch_size=64,sampler=train_sampler, num_workers=num_workers)

valid_loader = torch.utils.data.DataLoader(train_data, batch_size=32, sampler=valid_sampler, num_workers=num_workers)

test_loader = torch.utils.data.DataLoader(train_data, batch_size=20, sampler=test_sampler, num_workers=num_workers)

Pytorch 模型概述

使用 Sequential 是快速定义模型的一种简单方法。一个命名的有序字典包含了所有被封装在 nn.Sequential 中的层,然后将其存储在 model.classifier 变量中。这是一种快速定义模型基本结构的方法,但不一定是最 Pythonic 的。它帮助我们说明一个 Python 模型由全连接的线性层组成,形状由 (row, col) 元组指定。ReLU 激活层、20% 概率的 Dropout 和一个输出的 Softmax 或 LogSoftmax 函数。现在不用担心这些。你只需要知道 Softmax 通常是多分类任务深度学习模型的最后一层。著名的 ImageNet 数据集有 1000 多个类别,因此 Softmax 的输出至少有 1000 个以上的组件。

一个由全连接层组成的集合,间隔着 ReLU 激活层和一些 Dropout,最后是另一个全连接线性层,这个层连接到一个 Softmax 激活层,是一个典型的普通深度学习神经网络结构。

from collections import OrderedDictclassifier = nn.Sequential(OrderedDict([

('fc1', nn.Linear(2048, 1024)),

('relu', nn.ReLU()),

('dropout',nn.Dropout(0.2)),

('fc2', nn.Linear(1024, 512)),

('relu', nn.ReLU()),

('dropout',nn.Dropout(0.2)),

('fc3', nn.Linear(512, 256)),

('relu', nn.ReLU()),

('dropout',nn.Dropout(0.2)),

('fc4', nn.Linear(256, 102)),

('output', nn.LogSoftmax(dim=1))

]))model.classifier = classifier

在 Pytorch 中,查看模型结构非常简单,只需使用 print(model_name)。稍后会详细介绍。

源 3 的代码片段

如前所述,在 pytorch 部分的迁移学习中,我们可以使用如 resnet50 的预训练模型。将所有层的梯度关闭,除了最后新增的全连接层。

model = models.resnet50(pretrained=True)

for param in model.parameters():

param.requires_grad = False # turn all gradient off

model.fc = nn.Linear(2048, 2, bias=True)

#add new fully connected layer

fc_parameters = model.fc.parameters()

for param in fc_parameters:

param.requires_grad = True #turning last layer gradient to true

model

注意最后一层是 2048 x 2,因为我们只是分类两个类别:真或假,疟疾或非疟疾。

模型变量返回一个大型的 ResNet 模型结构,并包含我们自定义的最后一层。

Downloading: "https://download.pytorch.org/models/resnet50-19c8e357.pth" to /tmp/.torch/models/resnet50-19c8e357.pth

100%|██████████| 102502400/102502400 [00:01<00:00, 89692748.86it/s]

在下面的代码片段中,我们省略了很多细节,以便将模型架构适配到屏幕上。如果你访问源 3 的 kernel 链接,你会看到相当多的瓶颈和顺序层。

(layer1): Sequential(

(0): Bottleneck(

(conv1): Conv2d(64, 64, kernel_size=(1, 1), stride=(1, 1), bias=False)

(bn1): BatchNorm2d(64, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

(conv2): Conv2d(64, 64, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1), bias=False)

(bn2): BatchNorm2d(64, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

(conv3): Conv2d(64, 256, kernel_size=(1, 1), stride=(1, 1), bias=False)

(bn3): BatchNorm2d(256, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

(relu): ReLU(inplace)

(downsample): Sequential(

(0): Conv2d(64, 256, kernel_size=(1, 1), stride=(1, 1), bias=False)

(1): BatchNorm2d(256, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

)

)

在这里,我们展示了最后的自定义层确实是 2048 x 2。注意,在平均池化和 relu 之前的层是 2048,因此是 2048 x 2。

ResNet(

(conv1): Conv2d(3, 64, kernel_size=(7, 7), stride=(2, 2), padding=(3, 3), bias=False)

... #omitted

... #omitted

(bn3): BatchNorm2d(2048, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

(relu): ReLU(inplace)

)

)

(avgpool): AvgPool2d(kernel_size=7, stride=1, padding=0)

(fc): Linear(in_features=2048, out_features=2, bias=True)

)

Pytorch 训练循环

训练循环可能是 Pytorch 作为深度学习框架的最具特点的部分。在 Sklearn 中可以用 fit 来处理,在 Tensorflow 中可以用 transform。在 Pytorch 中,这部分要复杂得多。

model.train() 告诉你的模型你正在训练它。因此,像 dropout、batchnorm 等层在训练和测试过程中表现不同的情况下会知道发生了什么,并能相应地调整行为。

更多细节:它将模式设置为训练模式(见 源代码)。你可以调用 model.eval() 或 model.train(mode=False) 来表明你正在进行测试。期望 train 函数来训练模型是有些直观的,但实际上它并不会这么做。它只是设置模式。

model.eval() 会通知所有层你处于评估模式,这样,batchnorm 或 dropout 层将在评估模式而不是训练模式下工作。

torch.no_grad() 影响自动求导引擎并将其停用。它将减少内存使用并加快计算速度,但你将无法进行反向传播(在评估脚本中你不希望进行反向传播)。— albanD

代码片段训练循环源 3

use_cuda = torch.cuda.is_available()

if use_cuda:

model = model.cuda()

criterion = nn.CrossEntropyLoss()

optimizer = optim.SGD(model.fc.parameters(), lr=0.001 , momentum=0.9)

在开始训练之前,检查 CUDA 可用性,将准则设置为 CrossEntropyLoss(),将优化器设置为 Stochastic Gradient Descent。例如,注意学习率从非常小的 lr=0.001 开始。

注意,训练循环通常包括周期数、模型架构优化器和准则。损失值必须在每个循环开始时先归零!大循环遍历周期数。在每个周期中,我们将模型设置为训练模式 model.train(),如有必要,将模型和数据移到 CUDA,optimizer.zero_grad() 在开始之前将梯度归零,预测输出,使用准则计算损失,loss.backward 基于优化器计算权重变化,optimizer.step() 进行一次反向传播步骤以更新权重。在验证时,将模型切换到评估模式 model.eval()。如果验证损失有所减少,则保存模型,跟踪最低验证损失。

def train(n_epochs, model, optimizer, criterion, use_cuda, save_path):

*"""returns trained model"""*

*# initialize tracker for minimum validation loss*

valid_loss_min = np.Inf

for epoch in range(1, n_epochs+1):

*# initialize variables to monitor training and validation loss*

train_loss = 0.0

valid_loss = 0.0

*###################*

*# train the model #*

*###################*

model.train()

for batch_idx, (data, target) in enumerate(train_loader):

*# move to GPU*

if use_cuda:

data, target = data.cuda(), target.cuda()

*# initialize weights to zero*

optimizer.zero_grad()

output = model(data)

*# calculate loss*

loss = criterion(output, target)

*# back prop*

loss.backward()

*# grad*

optimizer.step()

train_loss = train_loss + ((1 / (batch_idx + 1)) * (loss.data - train_loss))

if batch_idx % 100 == 0:

print('Epoch %d, Batch %d loss: %.6f' %

(epoch, batch_idx + 1, train_loss))

*######################*

*# validate the model #*

*######################*

model.eval()

for batch_idx, (data, target) in enumerate(valid_loader):

*# move to GPU*

if use_cuda:

data, target = data.cuda(), target.cuda()

*## update the average validation loss*

output = model(data)

loss = criterion(output, target)

valid_loss = valid_loss + ((1 / (batch_idx + 1)) * (loss.data - valid_loss))

*# print training/validation statistics*

print('Epoch: {} \tTraining Loss: {:.6f} \tValidation Loss: {:.6f}'.format(

epoch,

train_loss,

valid_loss

))

*## TODO: save the model if validation loss has decreased*

if valid_loss < valid_loss_min:

torch.save(model.state_dict(), save_path)

print('Validation loss decreased ({:.6f} --> {:.6f}). Saving model ...'.format(

valid_loss_min,

valid_loss))

valid_loss_min = valid_loss

*# return trained model*

return model

开发工具

训练循环:

训练和前向传播

云端免费 GPU

感谢像 Google Colab 这样的新云技术。一旦你设置好笔记本,你可以在移动设备上继续训练和监控! 云端选择包括 Google Colab、Kaggle 和 AWS。本地选择包括你的个人笔记本电脑和游戏电脑。

我们之前将一台 MSI NVIDIA GTX 1060 重新用于《刺客信条:起源》 😄 如果你想了解更多,请告诉我们。

能够在本地 GPU 上进行训练是一个重大优势。我们能够快速进行参数调优组合的迭代而不会中断。Google Colab 有 12 小时的超时限制和 12GB 的配额限制。如果你是高级用户,务必避免不断下载数据集,而是将其存储在 Google Drive 中。删除 Google Drive 中的模型后,请务必清空回收站以实际删除它。

无论模型在哪里训练,如果训练损失接近零但验证损失没有减少(没有测试数据集),你可能要注意你的模型是否过拟合,可能在记忆训练数据。暂停并调整你的参数。即使你达到了 99% 的准确率,你的模型也可能不具备泛化能力,因此可能无法在其他地方使用。特别是对于 Udacity 的奖学金挑战和纳米学位的学生,这段信息尤其相关。对 99% 的准确率要保持高度怀疑,但可以先庆祝一下。

向前传播

Pytorch 向前传播实际上会计算 y = wx + b,在此之前我们只是写了占位符。

有用的 Pytorch 库和模块及其安装。

import torch

import torchvision

from torchvision import datasets, transforms, models

import torch.nn.functional as F

from collections import OrderedDict

from torch import nn

from torch import optim

Torchvision 模块非常强大。它包含图像处理和数据处理代码、卷积神经网络(CNN)以及其他预训练模型,如 ResNet 和 VGG。

转换

-

transforms.ToTensor()将数据数组转换为 Pytorch 张量。优点包括在 CUDA 和 GPU 训练中易于使用。 -

开发人员可以在 Pytorch 中 构建转换和转换管道。管道是指将多个转换串联在一起并顺序执行的一种方式。

Pytorch 卷积神经网络(CNN)

本节正在建设中… 请稍后再查看。

使用卷积神经网络完成计算机视觉、图像识别任务。转换和数据增强 API 非常重要,特别是在训练数据有限时。或者,也可以使用许多预加载的模型架构 —— 阅读我们的转移学习部分。

import torch

import numpy as np

from torchvision import datasets

import torchvision.transforms as transforms

最大池化层会丢弃原始图像中包含的详细空间信息。

检查 Pytorch 模型

首先初始化模型。

vgg16 = models.vgg16(pretrained=True)

print(vgg16)

在 Pytorch 中,使用 print(model_name) 来打印模型及其架构。你可以轻松地了解模型的详细信息。

VGG(

(features): Sequential(

(0): Conv2d(3, 64, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(1): ReLU(inplace)

(2): Conv2d(64, 64, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

...

(24): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

...

(29): ReLU(inplace)

(30): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

)

(classifier): Sequential(

(0): Linear(in_features=25088, out_features=4096, bias=True)

(1): ReLU(inplace)

(2): Dropout(p=0.5)

(3): Linear(in_features=4096, out_features=4096, bias=True)

(4): ReLU(inplace)

(5): Dropout(p=0.5)

(6): Linear(in_features=4096, out_features=1000, bias=True)

)

)

注意,每一层都有名称(编号,并且可以通过这个索引进行查询)。我们使用省略号来省略模型细节,以便 VGG 模型能够适应屏幕。

专业提示:检查模型架构是必须的。转移学习,简而言之,就是修改最后几个分类器层。在我们的转移学习文章中阅读更多。

专业提示:对于 Tensorflow,使用 keras model.summary() 来查看整个模型架构。它甚至会输出参数数量和维度。

高级特性

Pytorch 版本

对于 Udacity 项目,并非所有的纳米学位都已经迁移到 Pytorch 1.0。使用正确版本的 Pytorch 对相应的项目至关重要。你可能还需要在 Jupyter Notebook 中更改内核,以使用相应版本的 Python。Udacity 项目已经迁移到 Python3。并非所有现实世界中的项目都已迁移到 Python 3,但现在是时候从 Python 2 迁移过来了。

使用 CUDA

虽然我们决定将 CUDA 放在高级部分,但现实是 CUDA 非常易于使用。今天就使用它吧!通过 Anaconda、Pytorch 和 CUDA,我们将一台配备 NVIDIA 显卡的游戏电脑变成了家庭深度学习的强大机器。无需配置!它直接工作。这个框架在 Windows 机器上就能运行!(这是之前用于《刺客信条:起源》的 MSI NVIDIA GTX 1060 😄 如果你想了解更多,请告诉我们。)

gpu_is_avail = torch.cuda.is_available()if not gpu_is_avail:

print('CUDA is NOT available.')

else:

print('CUDA is available. ')device = torch.device(“cuda” if torch.cuda.is_available() else “cpu”)

使用 CUDA 与 Pytorch 的一个常见错误是不将模型和数据同时移动到 CUDA 上。当需要时将它们都移回 CPU。一般来说,你的模型和数据应该始终位于同一个空间。

在生产环境中部署 Pytorch:将现有的 Pytorch 模型转换为生产就绪的部署有两种方法——追踪和脚本。追踪不支持具有代码控制流的复杂模型。脚本支持具有控制流的 Pytorch 代码,但仅支持有限数量的 Python 模块。

选择最佳的 Softmax 结果:在多类别分类中,通常使用激活函数 Softmax。Pytorch 有一个专门的函数来提取最顶级的结果——从 Softmax 输出中最可能的类别。torch.topk(input, k, dim)返回顶级概率。

torch.topk(input, k, dim=None, largest=True, sorted=True, out=None) -> (Tensor, LongTensor)

Returns the k largest elements of the given input tensor along a given dimension.

If dim is not given, the last dimension of the input is chosen.

If largest is False then the k smallest elements are returned.

在其他平台上使用 Pytorch 模型

import torch.onnx

import torchvision

dummy_input = torch.randn(1, 3, 224, 224)

model = torchvision.models.alexnet(pretrained=True)

torch.onnx.export(model, dummy_input, "alexnet.onnx")

“以标准 ONNX(开放神经网络交换)格式导出模型,以便直接访问 ONNX 兼容的平台、运行时、可视化工具等。” — Pytorch 1.0 文档

更多关于 Pytorch 迁移学习的内容

使用现有模型相当于冻结其某些层和参数,并且不对这些层和参数进行训练。通过将require_grad设置为 False 来关闭训练自动求导。

for param in model.parameters():

param.requires_grad = False

超参数调整

除了使用正确的优化器和调整学习率之外,你还可以使用学习率调度器动态调整学习率。

#define scheduler

scheduler = lr_scheduler.StepLR(optimizer, step_size=3, gamma=0.1)

模型和检查点保存

保存和加载模型检查点

专业提示:你知道可以在本地和 Google Drive 中保存和加载模型吗?这样你不必每次都从头开始。例如,如果你已经训练了 5 个周期,你可以保存权重,然后再训练另外 5 个周期。现在你总共训练了 10 个周期!非常方便。免费的 GPU 资源经常超时并被擦除。记住,增量训练是可能的。

你还可以保存一个检查点并在本地加载它。你可能会看到.pt和.pth扩展名。

# write and then use your custom load_checkpoint function

model = load_checkpoint('checkpoint_resnet50.pth')

print(model)# use pytorch torch.load and load_state_dict(state_dict)

checkpt = torch.load(‘checkpoint_resnet50.pth’)

model.load_state_dict(checkpt)#save locally, map the new class_to_idx, move to cpu

#note down model architecturecheckpoint['class_to_idx']

model.class_to_idx = image_datasets['train'].class_to_idx

model.cpu()

torch.save({'arch': 'resnet18',

'state_dict': model.state_dict(),

'class_to_idx': model.class_to_idx},

'classifier.pth')

来自源 3 的代码片段

model.load_state_dict(torch.load('malaria_detection.pt'))

请注意,你必须将任何检查点保存到 Google Colab 的 Google Drive 中,否则你的数据可能每 12 小时或更早被删除。虽然 GPU 访问是免费的,但 Google Colab 上的存储是临时的。

使用 Pytorch 进行预测

这里是我们不喜欢 Pytorch 的地方。使用 Pytorch 进行预测似乎有点拼凑。尽管编写自己的训练循环看似容易自定义,但比 Tensorflow 更难编写,权衡一下舒适度和自定义性是值得的。然而,预测过程很奇怪,有些函数看起来像是被拼凑在一起的。看看下面的代码片段以了解我们的意思:

来源 3 的代码片段:

def test(model, criterion, use_cuda):

... #omitted

*# convert output probabilities to predicted class*

pred = output.data.max(1, keepdim=True)[1]

*# compare predictions to true label*

correct += np.sum(np.squeeze(pred.eq(target.data.view_as(pred))).cpu().numpy())

total += data.size(0)

.... #omitteddef load_input_image(img_path):

image = Image.open(img_path)

prediction_transform = transforms.Compose([transforms.Resize(size=(224, 224)),

transforms.ToTensor(),

transforms.Normalize([0.485, 0.456, 0.406],

[0.229, 0.224, 0.225])])

*# discard the transparent, alpha channel (that's the :3) and add the batch dimension*

image = prediction_transform(image)[:3,:,:].unsqueeze(0)

return imagedef predict_malaria(model, class_names, img_path):

*# load the image and return the predicted breed*

img = load_input_image(img_path)

model = model.cpu()

model.eval()

idx = torch.argmax(model(img))

return class_names[idx]

output.data.max,np.sum(np.squeeze()),cpu().numpy(),.unsqueeze(0),torch.argmax …… WTF?!这真的很让人沮丧。

重要的要点是:我们在这里处理的是转换为概率的 logits,还有需要转化为矩阵的张量和去除多余的括号。我们需要使用 max 或 argmax 来确定最可能的类别。我们需要将张量移回 CPU,因此使用 cpu(),并将张量转化为 ndarray 以便计算,使用 numpy()。

Pytorch 是一个深度学习框架,而深度学习常涉及矩阵运算,主要是调整维度,因此需要使用 squeeze 和 unsqueeze 来使维度匹配。

>>> import torch

>>> import numpy as np

>>> test = torch.tensor([[1,2,3]])

>>> np.squeeze(test)

tensor([1, 2, 3])

>>> torch.tensor([1]).unsqueeze(0)

tensor([[1]])

这部分备忘单将为你节省很多麻烦,不客气!np.squeeze() 去除了 [[1,2,3]] 中额外的 [] 和多余的维度,原本的形状是 (1, 3),现在变成了 (3,)。

而 unsqueeze 将 [1] 的形状 (1,) 变为 [[1]] 的形状 (1,1)。

深入阅读

-

来源 2: Pytorch Github 主页面

github.com/pytorch/pytorch#getting-started也提供了很好的备忘单。 -

极其棒的论坛,包括许多活跃的核心贡献者,补充了文档

discuss.pytorch.org/ -

来源 3: 使用 Pytorch 的疟疾检测 kaggle 内核

www.kaggle.com/devilsknight/malaria-detection-with-pytorch -

来源 4:

github.com/pytorch/examples/blob/97304e232807082c2e7b54c597615dc0ad8f6173/imagenet/main.py#L197-L198 -

来源 5: Pytorch 社区论坛 Pytorch 图像变换标准化

discuss.pytorch.org/t/whats-the-range-of-the-input-value-desired-to-use-pretrained-resnet152-and-vgg19/1683

Uniqtech: 我们经常编写像这样的适合初学者的 Cheat Sheets。关注我们的个人资料以及我们最受欢迎的数据科学训练营出版物。查看我们关于 Pytorch 中迁移学习、Amazon SageMaker 上的 Pytorch 和数据科学的 Anaconda Cheat Sheet 的单页文章。我们主要在 Medium 上活跃,这是一个我们喜爱并有强烈认同感的社区。Medium 对其作者很好,并拥有一个极好的读者社区。如果您想了解我们即将推出的数据科学训练营课程(2024 年秋季发布)、高质量文章的奖学金,或者想为我们写作、提供反馈,请通过 hi@uniqtech.co 发送电子邮件给我们。感谢 Medium 社区!

主要作者和贡献者 Sun.

原文. 经许可转载。

相关:

-

深度学习 Cheat Sheets

-

使用 PyTorch 框架进行 NLP 入门

-

3 个更多的 Google Colab 环境管理技巧

更多主题

Pytorch Lightning 与 PyTorch Ignite 与 Fast.ai

原文:

www.kdnuggets.com/2019/08/pytorch-lightning-vs-pytorch-ignite-vs-fast-ai.html

评论

评论

由威廉·法尔孔,AI 研究员

显然,狮子、熊和老虎是朋友

我们的前三名课程推荐

1. Google 网络安全证书 - 快速入门网络安全职业。

1. Google 网络安全证书 - 快速入门网络安全职业。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织进行 IT

3. Google IT 支持专业证书 - 支持你的组织进行 IT

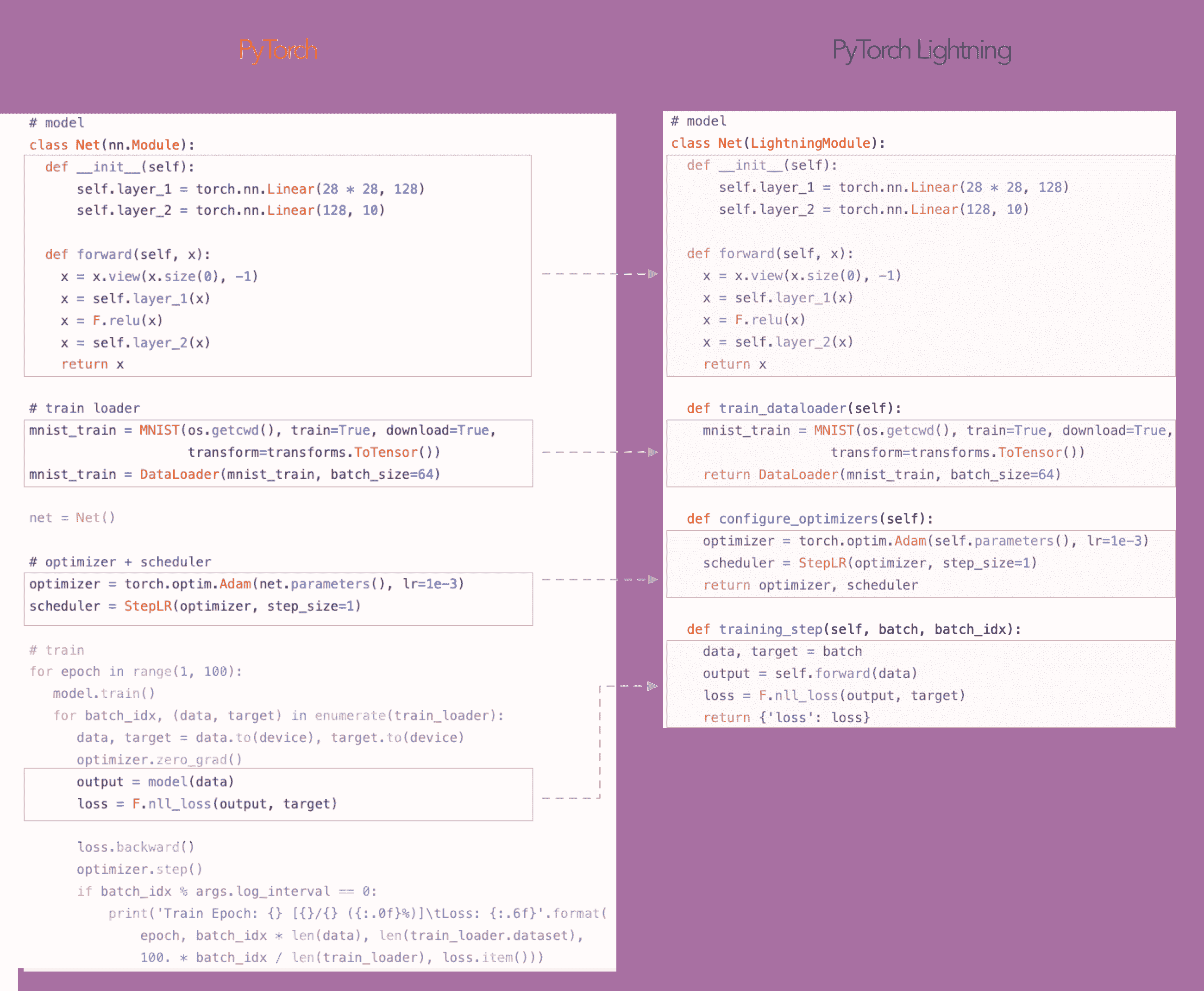

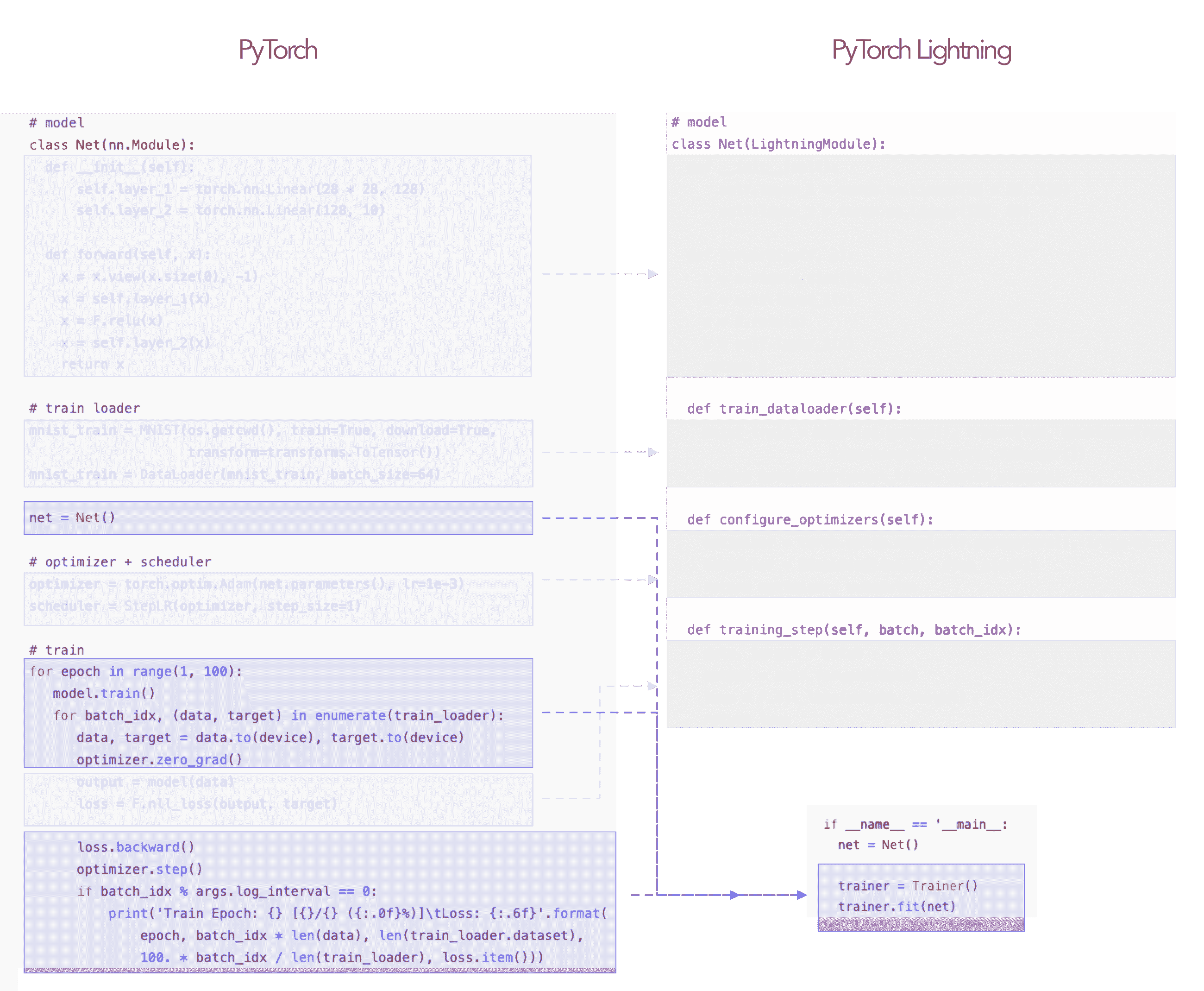

PyTorch-lightning 是一个最近发布的库,是一个类似 Keras 的 PyTorch 机器学习库。它将核心训练和验证逻辑留给你,并自动化其他部分。(顺便提一下,这里的 Keras 意味着没有样板代码,而不是过于简化)。

作为 Lightning 的核心作者,我曾多次被问及 Lightning 与 fast.ai、PyTorch ignite之间的核心差异。

在这里,我将尝试对这三种框架进行客观比较。这一比较基于在所有三个框架的教程和文档中客观发现的相似性和差异性。

动机

Fast.ai 最初是为了方便教学fast.ai 课程而创建的。最近,它还转变成了一个实现常见方法(如 GANs、RL 和迁移学习)的库。

PyTorch Ignite和Pytorch Lightning都是为了给予研究人员尽可能多的灵活性,要求他们定义训练循环和验证循环中的操作。

Lightning 有两个额外的、更雄心勃勃的目标:可重复性和普及最佳实践,只有 PyTorch 高级用户会实现(分布式训练、16 位精度等)。我将在后续章节中详细讨论这些目标。

因此,从基本层面上讲,目标用户是明确的:对于 fast.ai,目标用户是对深度学习感兴趣的人,而另外两个框架则专注于活跃的研究人员,无论是从事机器学习还是使用机器学习(例如:生物学家、神经科学家等)。

学习曲线

Lightning 和 Ignite 都具有非常简单的接口,因为大部分工作仍然由用户在纯 PyTorch 中完成。主要的工作发生在 Engine 和 Trainer 对象中。

然而,Fast.ai 确实需要在 PyTorch 之上学习另一个库。API 大部分时间并不直接操作纯 PyTorch 代码(也有一些地方会),但它需要像 DataBunches、 DataBlocs 等抽象。当“最佳”方法不明显时,这些 API 非常有用。

对于研究人员来说,关键在于不需要再学习另一个库,直接控制研究的关键部分,如数据处理,而不需要其他抽象来操作这些部分。

在这种情况下,fast.ai 库有更高的学习曲线,但如果你不一定知道“最佳”方法是什么,并且只是想把好的方法作为黑箱来使用,这一点是值得的。

Lightning vs Ignite

更像是共享

从上述内容可以明显看出,将 fast.ai 与这两个框架进行比较是不公平的,因为使用案例和用户群体不同(然而,我仍会在本文末尾的比较表中添加 fast.ai)。

Lightning 和 Ignite 之间的第一个主要区别是它们操作的接口。

在 Lightning 中,有一个标准接口(见 LightningModule),每个模型都必须遵循这 9 个必需的方法。

这种灵活的格式允许在训练和验证中获得最大的自由。这个接口应该被视为一个 系统,而不是一个模型。系统可能有多个模型(GANs、seq-2-seq 等),或者它可能是一个模型,比如这个简单的 MNIST 示例。

因此,研究人员可以自由尝试各种疯狂的东西,并且只需要担心这 9 个方法。

Ignite 需要非常类似的设置,但没有一个 标准 接口,每个模型都需要遵循。

请注意,run 函数可能会有不同的定义,即:可能有许多不同的事件添加到训练器中,或者它甚至可能被命名为其他名称,如 main, train, etc…

在一个复杂的系统中,比如训练可能以奇怪的方式进行(看着你们,GAN 和 RL),代码的运行情况可能不容易被直观理解。而在 Lightning 中,你可以查看 training_step 来弄清楚发生了什么。

可重复性

当你尝试重现工作时

如我所提到的,Lightning 是在第二个更雄心勃勃的广泛动机下创建的:可重复性。

如果你尝试阅读某人的论文实现,往往很难弄清楚发生了什么。我们早已不再只是设计不同的神经网络架构。

现代的 SOTA 模型实际上是系统,这些系统使用了多种模型或训练技术来实现特定的结果。

正如我之前所说,LightningModule 是一个系统,而不是一个模型。因此,如果你想知道所有那些复杂的技巧和超级复杂的训练发生在哪里,你可以查看 training_step 和 validation_step。

如果每个研究项目和论文都使用 LightningModule 模板进行实现,那么了解发生了什么将变得非常容易(但可能不容易理解,哈哈)。

在 AI 社区中进行这种标准化将允许一个生态系统蓬勃发展,该生态系统可以使用 LightningModule 接口来执行一些很酷的功能,比如自动化部署、审计系统中的偏差,甚至支持将权重哈希到区块链后端以重建用于关键预测的模型,这些模型可能需要进行审计。

开箱即用的功能

Ignite 和 Lightning 之间的另一个主要区别在于 Lightning 开箱即用的功能。开箱即用意味着你无需额外编写代码。

举例来说,让我们尝试在同一台机器上的多个 GPU 上训练一个模型。

Ignite (demo)**

Lightning (demo)**

好的,没有哪个是坏的……但如果我们想在多台机器上使用多个 GPU 呢?让我们在 200 个 GPU 上进行训练。

Ignite

…

好吧,这里没有内置支持……你需要扩展 这个示例 并添加一种提交脚本的简便方法。然后,你还需要处理加载/保存、确保不会覆盖权重/日志与所有进程等……你明白了。

Lightning

使用 Lightning,你只需设置节点数量并提交适当的作业。 这里有一个关于如何正确配置作业的详细教程。

开箱即用的功能是指那些你无需做任何事即可使用的功能。这意味着你可能现在不需要它们,但当你需要例如...累积梯度、梯度裁剪或 16 位训练时,你不会花费数天/数周的时间阅读教程来使其工作。

只需设置适当的 Lightning 标志,然后继续进行你的研究。

Lightning 预构建了这些功能,以便用户花更多时间进行研究,而不是进行工程开发。这对于非计算机科学/数据科学研究人员,如物理学家、生物学家等尤其有用,他们可能在编程方面不那么精通。

这些功能使 PyTorch 的特性变得普及,只有高级用户可能会花时间去实现。

这里有表格比较了所有三个框架在不同功能集上的特性。

如果我遗漏了任何重要内容,请留言,我会更新表格!

高性能计算

调试工具

可用性

结束语

在这里,我们对三个框架进行了多层次的深入比较。每个框架都有其自身的优点。

如果你刚刚学习或没有跟上所有最新的最佳实践,不需要超高级的训练技巧,并且有时间学习新的库,那么选择 fast.ai。

如果你需要最大的灵活性,可以选择 Ignite 或 Lightning。

如果你不需要超高级的功能,并且可以接受添加 Tensorboard 支持、累积梯度、分布式训练等,那么选择 Ignite。

如果你需要更高级的功能、分布式训练、最新的深度学习训练技巧,并且希望看到一个标准化的实现世界,那就使用 Lightning。

简介: 威廉·法尔肯 是 AI 研究员、初创公司创始人、CTO、Google Deepmind 学者以及 Facebook AI 的现任博士研究实习生。

原文。经许可转载。

相关内容:

-

初学者和 Udacity 深度学习纳米学位的 PyTorch 备忘单

-

使用 PyTorch 框架入门 NLP

-

XLNet 在多个 NLP 任务中超越 BERT

更多相关主题

PyTorch LSTM:文本生成教程

原文:

www.kdnuggets.com/2020/07/pytorch-lstm-text-generation-tutorial.html

评论

作者 Domas Bitvinskas,Closeheat

长短期记忆(LSTM)是一种流行的递归神经网络(RNN)架构。本教程讲解如何在 PyTorch 上使用 LSTM 生成文本;在这种情况下 - 一些相当无聊的笑话。

本教程需要:

我们的前三大课程推荐

1. 谷歌网络安全证书 - 加速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 加速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT

什么是 LSTM?

LSTM 是 RNN 的一种变体,广泛应用于深度学习。如果你在处理数据序列时,可以使用 LSTM。

以下是你可能熟悉的 LSTM 网络的最直接应用场景:

-

时间序列预测(例如,股票预测)

-

文本生成

-

视频分类

-

音乐生成

-

异常检测

RNN

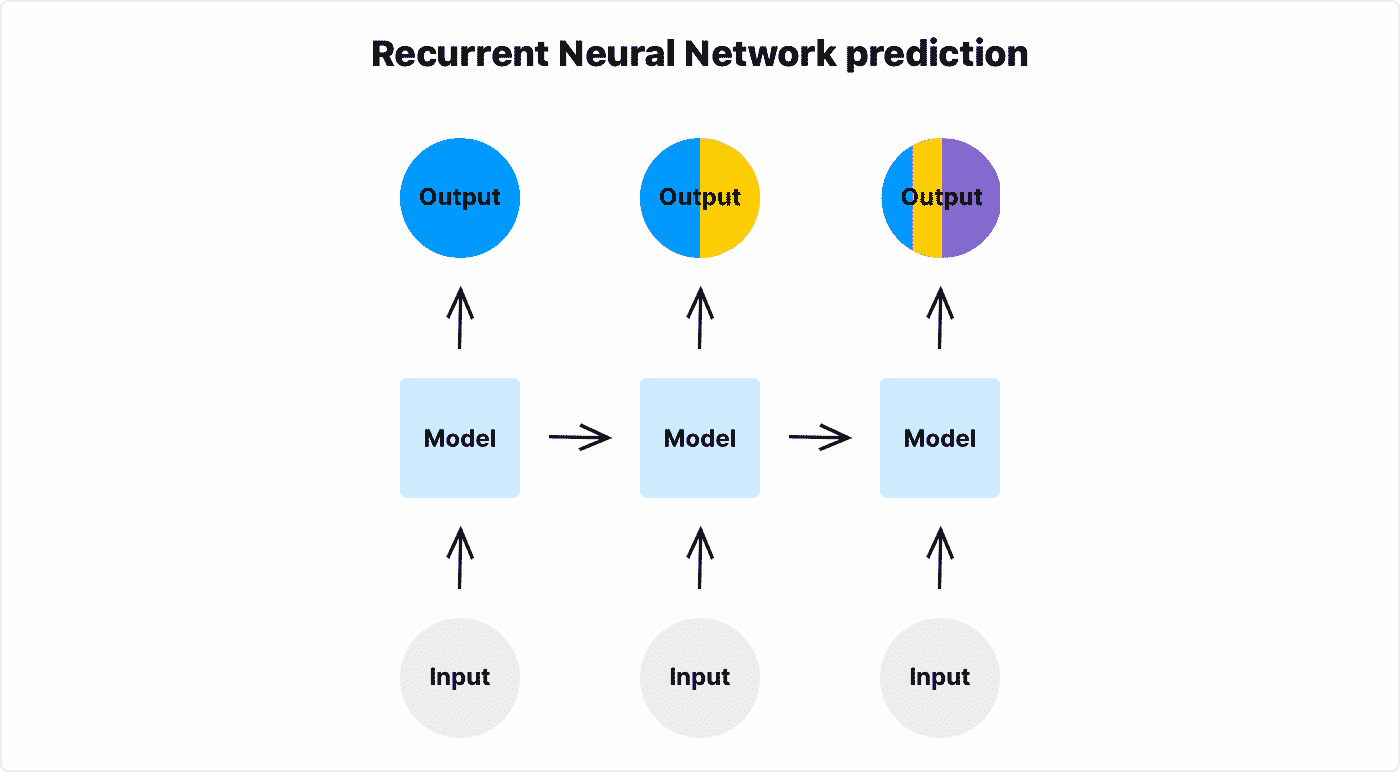

在开始使用 LSTM 之前,你需要了解 RNN 的工作原理。

RNN 是处理序列数据的神经网络。它可以是视频、音频、文本、股市时间序列甚至单张图像被切割成序列的各部分。

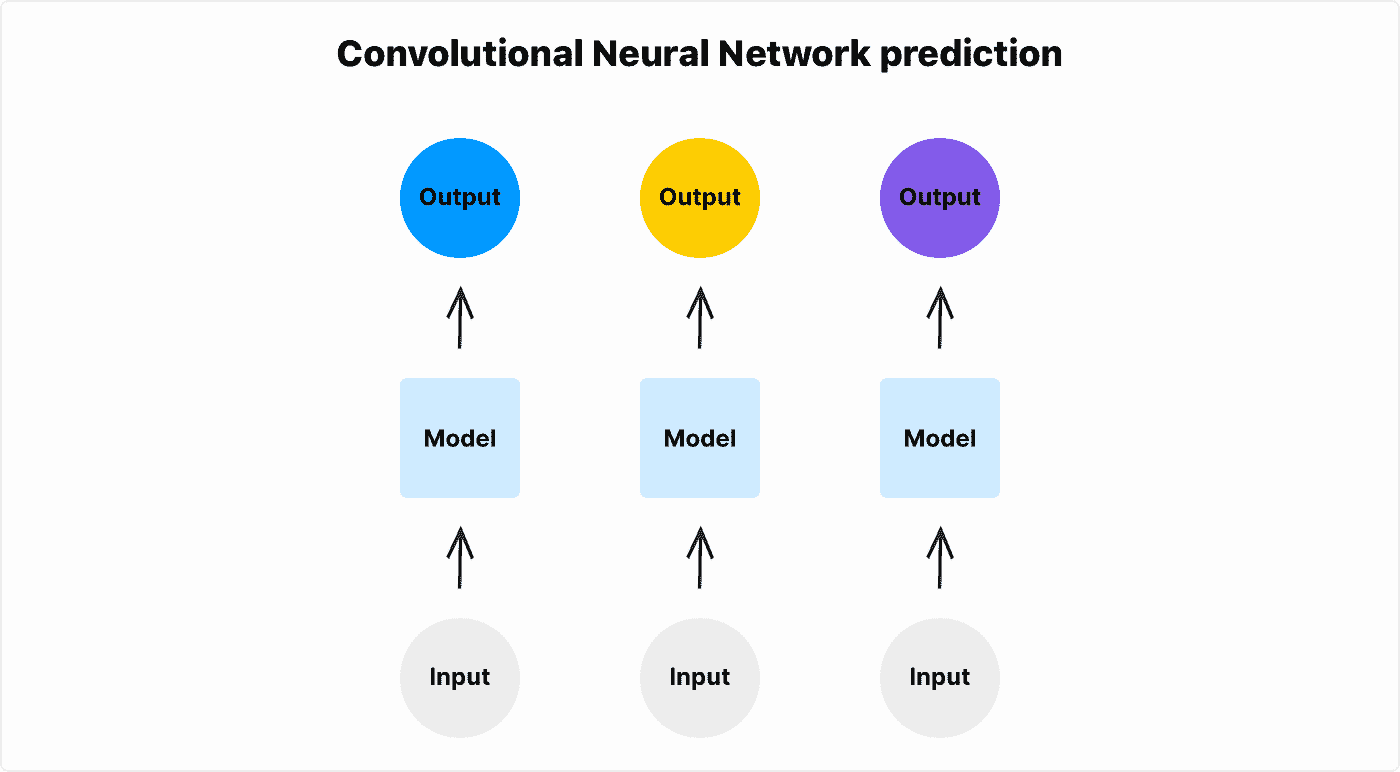

与 RNN 相比,标准神经网络(卷积神经网络或普通神经网络)有一个主要缺点 - 它们不能利用之前的输入来指导后续的预测。没有某种形式的记忆,无法解决某些机器学习问题。

例如,当你有一些视频帧显示一个球的移动,并想预测球的方向时,你可能会遇到问题。标准神经网络看到的问题是:你在一张图像中看到一个球,在另一张图像中也看到一个球。它没有机制将这两张图像作为序列连接起来。标准神经网络不能将两个独立的球的图像与“球在移动”的概念联系起来。它只看到图像#1 中有一个球,图像#2 中也有一个球,但网络输出是分开的。

将其与 RNN 进行比较,RNN 记住最后的帧,并可以用来指导下一次预测。

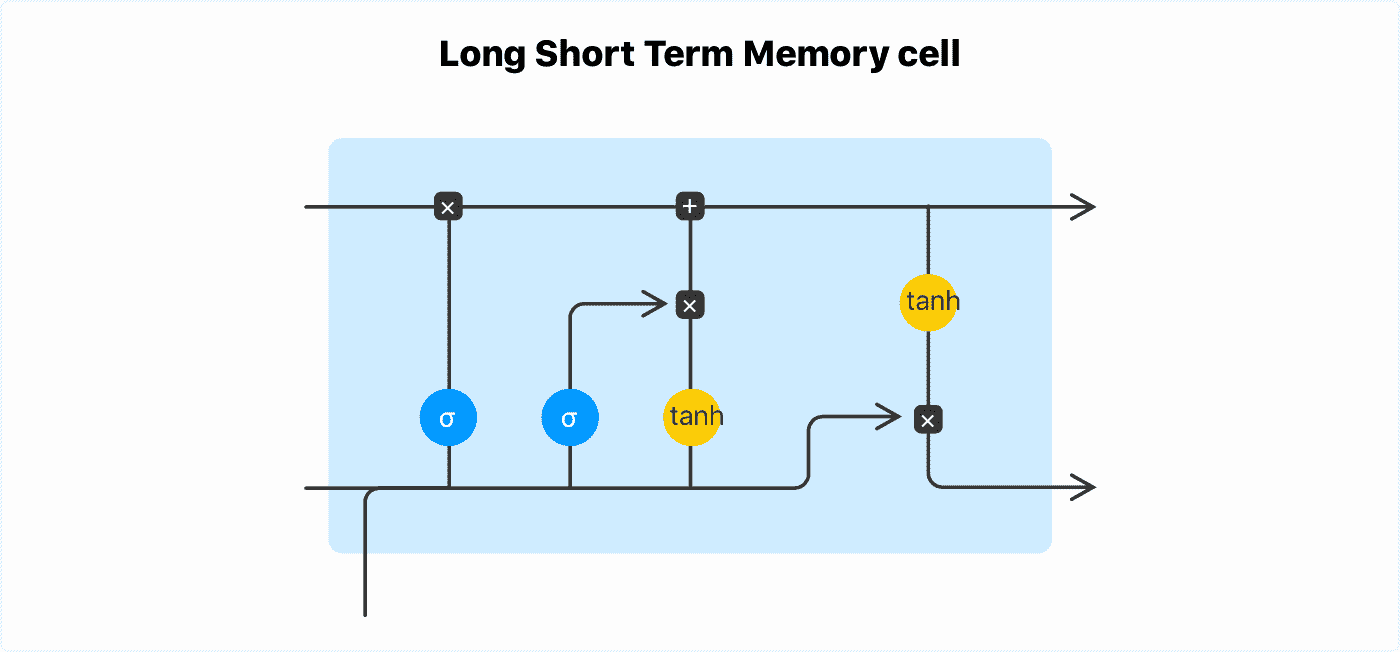

LSTM 与 RNN

典型的 RNN 无法记忆长序列。所谓的“梯度消失”效应发生在 RNN 单元网络的反向传播阶段。携带序列开始部分信息的单元梯度经过小数的矩阵乘法后在长序列中接近 0。换句话说,序列开始部分的信息对序列末端几乎没有影响。

你可以在递归神经网络示例中看到这一点。给定足够长的序列,序列第一个元素的信息对序列最后一个元素的输出没有影响。

LSTM 是一种 RNN 架构,可以记忆长序列 - 最多 100 个元素。LSTM 具有记忆门控机制,使长期记忆能够继续流入 LSTM 单元。

使用 PyTorch 进行文本生成

你将使用 PyTorch 中的 LSTM 网络训练一个笑话文本生成器,并遵循最佳实践。首先,创建一个新的文件夹来存储代码:

$ mkdir text-generation

模型

要创建一个 LSTM 模型,在text-generation文件夹中创建一个名为model.py的文件,内容如下:

import torch

from torch import nn

class Model(nn.Module):

def __init__(self, dataset):

super(Model, self).__init__()

self.lstm_size = 128

self.embedding_dim = 128

self.num_layers = 3

n_vocab = len(dataset.uniq_words)

self.embedding = nn.Embedding(

num_embeddings=n_vocab,

embedding_dim=self.embedding_dim,

)

self.lstm = nn.LSTM(

input_size=self.lstm_size,

hidden_size=self.lstm_size,

num_layers=self.num_layers,

dropout=0.2,

)

self.fc = nn.Linear(self.lstm_size, n_vocab)

def forward(self, x, prev_state):

embed = self.embedding(x)

output, state = self.lstm(embed, prev_state)

logits = self.fc(output)

return logits, state

def init_state(self, sequence_length):

return (torch.zeros(self.num_layers, sequence_length, self.lstm_size),

torch.zeros(self.num_layers, sequence_length, self.lstm_size))

这是一个标准的 PyTorch 模型。Embedding层将单词索引转换为单词向量。LSTM是网络的主要可学习部分 - PyTorch 实现中的LSTM单元内部实现了门控机制,可以学习长序列的数据。

如早前什么是 LSTM?部分所述 - RNN 和 LSTM 具有在训练周期之间传递的额外状态信息。forward函数具有一个prev_state参数。这个状态保持在模型外部,并手动传递。

它还具有init_state函数。在每个 epoch 开始时调用此函数,以初始化正确形状的状态。

数据集

在本教程中,我们使用 Reddit 清理笑话数据集来训练网络。下载 (139KB)数据集,并将其放入text-generation/data/文件夹中。

数据集包含 1623 个笑话,内容如下:

ID,Joke

1,What did the bartender say to the jumper cables? You better not try to start anything.

2,Don't you hate jokes about German sausage? They're the wurst!

3,Two artists had an art contest... It ended in a draw

…

要将数据加载到 PyTorch 中,请使用 PyTorch 的Dataset类。创建一个名为dataset.py的文件,内容如下:

import torch

import pandas as pd

from collections import Counter

class Dataset(torch.utils.data.Dataset):

def __init__(

self,

args,

):

self.args = args

self.words = self.load_words()

self.uniq_words = self.get_uniq_words()

self.index_to_word = {index: word for index, word in enumerate(self.uniq_words)}

self.word_to_index = {word: index for index, word in enumerate(self.uniq_words)}

self.words_indexes = [self.word_to_index[w] for w in self.words]

def load_words(self):

train_df = pd.read_csv('data/reddit-cleanjokes.csv')

text = train_df['Joke'].str.cat(sep=' ')

return text.split(' ')

def get_uniq_words(self):

word_counts = Counter(self.words)

return sorted(word_counts, key=word_counts.get, reverse=True)

def __len__(self):

return len(self.words_indexes) - self.args.sequence_length

def __getitem__(self, index):

return (

torch.tensor(self.words_indexes[index:index+self.args.sequence_length]),

torch.tensor(self.words_indexes[index+1:index+self.args.sequence_length+1]),

)

这个Dataset类继承自 PyTorch 的torch.utils.data.Dataset类,并定义了两个重要的方法__len__和__getitem__。详细了解 PyTorch 中Dataset类的工作原理,请参考数据加载教程。

load_words函数加载数据集。数据集中计算独特的词汇量,以定义网络的词汇表大小和嵌入大小。index_to_word和word_to_index将单词转换为数字索引,反之亦然。

这是过程的一部分是 分词。未来,torchtext 团队计划改进这一部分,但他们正在重新设计,新的 API 对于本教程来说过于不稳定。

训练

创建一个 train.py 文件并定义一个 train 函数。

import argparse

import torch

import numpy as np

from torch import nn, optim

from torch.utils.data import DataLoader

from model import Model

from dataset import Dataset

def train(dataset, model, args):

model.train()

dataloader = DataLoader(dataset, batch_size=args.batch_size)

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

for epoch in range(args.max_epochs):

state_h, state_c = model.init_state(args.sequence_length)

for batch, (x, y) in enumerate(dataloader):

optimizer.zero_grad()

y_pred, (state_h, state_c) = model(x, (state_h, state_c))

loss = criterion(y_pred.transpose(1, 2), y)

state_h = state_h.detach()

state_c = state_c.detach()

loss.backward()

optimizer.step()

print({ 'epoch': epoch, 'batch': batch, 'loss': loss.item() })

使用 PyTorch DataLoader 和 Dataset 抽象来加载笑话数据。

使用 CrossEntropyLoss 作为损失函数,并使用 Adam 作为默认参数的优化器。你可以稍后进行调整。

在他著名的 帖子 中,Andrew Karpathy 也建议最初保持这一部分的简单。

文本生成

将 predict 函数添加到 train.py 文件中:

def predict(dataset, model, text, next_words=100):

model.eval()

words = text.split(' ')

state_h, state_c = model.init_state(len(words))

for i in range(0, next_words):

x = torch.tensor([[dataset.word_to_index[w] for w in words[i:]]])

y_pred, (state_h, state_c) = model(x, (state_h, state_c))

last_word_logits = y_pred[0][-1]

p = torch.nn.functional.softmax(last_word_logits, dim=0).detach().numpy()

word_index = np.random.choice(len(last_word_logits), p=p)

words.append(dataset.index_to_word[word_index])

return words

执行预测

将以下代码添加到 train.py 文件中以执行已定义的函数:

parser = argparse.ArgumentParser()

parser.add_argument('--max-epochs', type=int, default=10)

parser.add_argument('--batch-size', type=int, default=256)

parser.add_argument('--sequence-length', type=int, default=4)

args = parser.parse_args()

dataset = Dataset(args)

model = Model(dataset)

train(dataset, model, args)

print(predict(dataset, model, text='Knock knock. Whos there?'))

使用以下命令运行 train.py 脚本:

$ python train.py

你可以看到损失随训练轮次变化。当训练结束时,模型在 Knock knock. Whos there? 之后预测接下来的 100 个词。默认情况下,它运行 10 个轮次,训练大约需要 15 分钟。

{'epoch': 9, 'batch': 91, 'loss': 5.953955173492432}

{'epoch': 9, 'batch': 92, 'loss': 6.1532487869262695}

{'epoch': 9, 'batch': 93, 'loss': 5.531163215637207}

['Knock', 'knock.', 'Whos', 'there?', '3)', 'moostard', 'bird', 'Book,',

'What', 'when', 'when', 'the', 'Autumn', 'He', 'What', 'did', 'the',

'psychologist?', 'And', 'look', 'any', 'jokes.', 'Do', 'by', "Valentine's",

'Because', 'I', 'papa', 'could', 'believe', 'had', 'a', 'call', 'decide',

'elephants', 'it', 'my', 'eyes?', 'Why', 'you', 'different', 'know', 'in',

'an', 'file', 'of', 'a', 'jungle?', 'Rock', '-', 'and', 'might', "It's",

'every', 'out', 'say', 'when', 'to', 'an', 'ghost', 'however:', 'the', 'sex,',

'in', 'his', 'hose', 'and', 'because', 'joke', 'the', 'month', '25', 'The',

'97', 'can', 'eggs.', 'was', 'dead', 'joke', "I'm", 'a', 'want', 'is', 'you',

'out', 'to', 'Sorry,', 'the', 'poet,', 'between', 'clean', 'Words', 'car',

'his', 'wife', 'would', '1000', 'and', 'Santa', 'oh', 'diving', 'machine?',

'He', 'was']

如果你跳过了这部分并想运行代码,这里有一个可以克隆的 Github 仓库。

下一步

恭喜!你已经编写了第一个 PyTorch LSTM 网络并生成了一些笑话。

接下来你可以做的事情来改进模型是:

-

通过去除非字母字符来清理数据。

-

通过添加更多的

Linear或LSTM层来增加模型的容量。 -

将数据集拆分为训练、测试和验证集。

-

添加检查点,以便你不必每次都训练模型才能运行预测。

简介: Domas Bitvinskas (@domasbitvinskas) 在 Closeheat 领导机器学习和增长实验。

原文。经许可转载。

相关:

-

PyTorch 深度学习:免费电子书

-

使用 TensorFlow 和 LSTM 循环神经网络生成烹饪食谱:逐步指南

-

你应该知道的 PyTorch 最重要的基础知识

更多相关主题

使用 torchlayers 轻松构建 PyTorch 模型

原文:

www.kdnuggets.com/2020/04/pytorch-models-torchlayers.html

评论

根据 在线搜索 和更重要的 PyTorch 采用率的持续增长 来看,PyTorch 继续受到广泛关注。PyTorch 被认为是强大而灵活的,这对研究人员来说是受欢迎的。然而,过去 PyTorch 因缺乏类似 TensorFlow 的 Keras 的简化高级 API 而受到批评。这个情况最近发生了变化。

torchlayers 旨在为 PyTorch 做到 Keras 对 TensorFlow 所做的事情。简洁地由项目开发者定义:

torchlayers 是一个基于 PyTorch 的库,提供

torch.nn层的自动形状和维度推断 + 当前 SOTA 架构中的附加构建块(例如 Efficient-Net)。上述操作无需用户干预(除了对 torchlayers.build 的单次调用),类似于 Keras 中的操作。

除了上述的形状和维度推断,torchlayers 还包括类似 Keras 的附加层,例如 [torchlayers.Reshape](https://szymonmaszke.github.io/torchlayers/packages/torchlayers.html?highlight=reshape#torchlayers.Reshape)(在保持批次维度的同时重塑输入张量),包含之前在 ImageNet 竞赛中看到的 SOTA 层(例如 [PolyNet](https://szymonmaszke.github.io/torchlayers/packages/torchlayers.convolution.html?highlight=polynet#torchlayers.convolution.Poly)),并提供一些有用的默认设置,例如卷积核大小(torchlayers 的默认值为 3)。

使用 pip 安装很简单:

pip install --user torchlayers

额外的安装信息(如 Docker 镜像和 GPU)可以在这里找到。完整的 torchlayers 文档 可以在这里找到。

torchlayers 的 GitHub 页面提供了一些示例来展示其功能。我喜欢这个 简单的图像和文本分类器! 示例,下面我复制了它的代码。这个示例展示了:

-

torch.nn和torchlayers层的混合使用 -

形状和维度推断(

Conv和Linear输入及BatchNorm) -

默认卷积核大小

-

Conv填充默认设置为 "same" -

使用 torchlayers 池化层(

GlobalMaxPool,类似于 Keras)

import torch

import torchlayers as tl

# torch.nn and torchlayers can be mixed easily

model = torch.nn.Sequential(

tl.Conv(64), # specify ONLY out_channels

torch.nn.ReLU(), # use torch.nn wherever you wish

tl.BatchNorm(), # BatchNormNd inferred from input

tl.Conv(128), # Default kernel_size equal to 3

tl.ReLU(),

tl.Conv(256, kernel_size=11), # "same" padding as default

tl.GlobalMaxPool(), # Known from Keras

tl.Linear(10), # Output for 10 classes

)

然后可以使用 [torchlayers.build](https://szymonmaszke.github.io/torchlayers/packages/torchlayers.html?highlight=build#torchlayers.build) 来构建一个定义的网络,同时指定输入形状(下面展示了图像和文本分类的输入形状,适用于上面定义的模型):

# Image...

mnist_model = tl.build(model, torch.randn(1, 3, 28, 28))

# ...or text

# [batch, embedding, timesteps], first dimension > 1 for BatchNorm1d to work

text_model = tl.build(model, torch.randn(2, 300, 1))

build 显然像在 Keras 中一样工作,将模型编译为 PyTorch 基本操作;它通过 post_build 函数(例如下面显示的权重初始化)提供一些附加功能,你可以在这里查看更多。

class _MyModuleImpl(torch.nn.Linear):

def post_build(self):

# You can do anything here really

torch.nn.init.eye_(self.weights)

torchlayers 提供了一些有助于使用 PyTorch 进行类似 Keras 的模型构建的功能,并填补了明显的空白。时间将证明该项目如何发展和长期受欢迎,但它无疑有一个有前途的开始。

相关:

-

OpenAI 正在采用 PyTorch... 他们并不孤单

-

PyTorch 1.2 的温和介绍

-

使用 TensorFlow 和 Keras 进行标记化和文本数据准备

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业。

1. Google 网络安全证书 - 快速进入网络安全职业。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

更多相关主题

PyTorch 多 GPU 指标库及新 PyTorch Lightning 发布中的更多内容

原文:

www.kdnuggets.com/2020/07/pytorch-multi-gpu-metrics-library-pytorch-lightning.html

评论

由 William Falcon,PyTorch Lightning 创始人

今天 [最近] 我们发布了 0.8.1,这是 PyTorch Lightning 的一个重要里程碑。随着用户的惊人增长和采用,我们继续构建工具以轻松进行 AI 研究。

这次重大发布使我们朝着即将到来的 v1.0.0 最终 API 更改的方向迈进!

PyTorch Lightning

PyTorch Lightning 是一个非常轻量的 PyTorch 结构——它更像是一个风格指南而不是一个框架。但一旦你结构化了你的代码,我们会为你提供免费的 GPU、TPU、16 位精度支持以及更多功能!

Lightning 只是结构化的 PyTorch

指标

此次发布在 Lightning 中新增了一个重大包——一个多 GPU 指标包!

关于 Lightning 中的指标包,有两个关键点。

-

它可以与普通 PyTorch 一起使用!

-

它通过 DDP 自动处理多 GPU。这意味着即使你在一个或 20 个 GPU 上计算准确性,我们也会为你自动处理。

指标包还包括与 sklearn 指标的映射,以桥接 numpy、sklearn 和 PyTorch 之间的差距,以及一个你可以用来实现自己指标的高级类。

**class** **RMSE**(TensorMetric):

**def** **forward**(self, x, y):

**return** torch**.**sqrt(torch**.**mean(torch**.**pow(x**-**y, 2.0)))

指标包目前实现了超过 18 种指标(包括功能性指标)。查看 我们的文档 获取完整列表!

overfit_batches

此次发布还清理了我们在 Lightning 中存在已久的非常酷的调试工具。overfit_batches 标志现在可以让你在数据的一个小子集上过拟合,以确保你的模型没有重大缺陷。

逻辑是,如果你甚至无法在 1 个批次的数据上过拟合,那么训练模型的其余部分没有意义。这可以帮助你确定是否正确实现了某些东西,或确保你的数学是正确的

Trainer(overfit_batches=1)

如果你在 Lightning 中这样做,你会得到以下结果:

更快的多 GPU 训练

此次发布的另一个关键部分是通过 DDP 对分布式训练的加速。变化来自允许 DDP 与 num_workers>0 一起在数据加载器中工作

Dataloader(dataset, num_workers=8)

今天,当你通过.spawn()启动 DDP 并尝试在数据加载器中使用 num_workers>0 时,你的程序可能会冻结并且无法开始训练(这在 Lightning 之外也是如此)。

对大多数人来说,解决方案是设置 num_workers=0,但这意味着你的训练将非常慢。为了启用 num_workers>0 和 DDP,我们现在在后台启动 DDP 而不使用 spawn。这消除了许多其他奇怪的限制,比如需要 pickle 一切,以及模型权重在训练完成后不可用的要求(因为权重是在具有不同内存的子进程中学习的)。

因此,我们的 DDP 实现比普通的快得多。当然,我们保留了两者以便灵活使用:

# very fast :)

Trainer(distributed_backend='ddp')# very slow

Trainer(distributed_backend='ddp_spawn')

发布的其他酷炫功能

- .test() 现在会自动加载最佳模型权重!

model = Model()

trainer = Trainer()

trainer.fit(model)# automatically loads the best weights!

trainer.test()

- 现在通过 conda 安装 Lightning

conda install pytorch-lightning -c conda-forge

- ModelCheckpoint 跟踪最佳权重的路径

ckpt_callback = ModelCheckpoint(...)

trainer = Trainer(model_checkpoint=ckpt_callback)

trainer.fit(model)best_weights = ckpt_callback.best_model_path

- 推理期间自动将数据移动到正确的设备

class LitModel(LightningModule): @auto_move_data

def forward(self, x):

return xmodel = LitModel()

x = torch.rand(2, 3)

model = model.cuda(2)# this works!

model(x)

- 还有许多速度改进,包括单 TPU 加速(我们也支持多 TPU)

Trainer(tpu_cores=8)

今天就试试 Lightning

如果你还没有!给 Lightning 一个机会 😃

这个视频讲解了如何将你的 PyTorch 代码重构为 Lightning。

简介:威廉·法尔孔 是一名 AI 研究员,也是 PyTorch Lightning 的创始人。他致力于理解大脑、构建 AI 并在规模上使用它。

原始内容。经授权转载。

相关内容:

-

Pytorch Lightning 与 PyTorch Ignite 与 Fast.ai

-

在 PyTorch 中训练 Lightning-fast 神经网络的 9 个技巧

-

Lit BERT:NLP 转移学习的 3 个步骤

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

更多相关内容

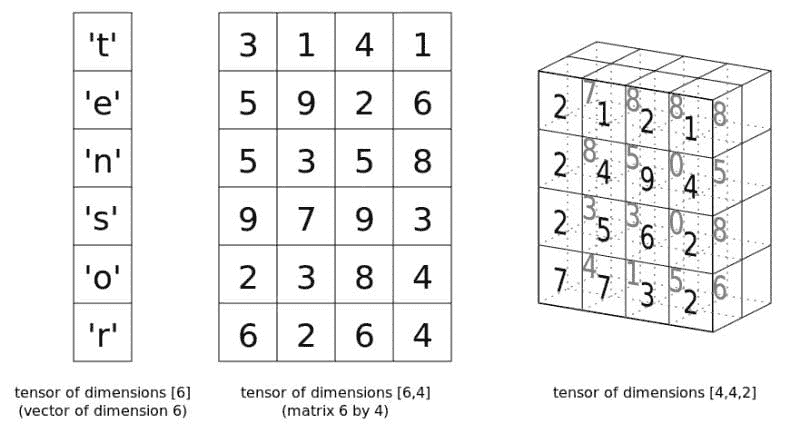

PyTorch 张量基础

评论

评论

现在我们知道了 张量是什么,并了解了 Numpy 的 ndarray 如何用来表示它们,接下来我们来看看它们在 PyTorch 中是如何表示的。

PyTorch 自 Facebook 在 2017 年初开源以来,在机器学习领域产生了令人印象深刻的影响。它可能没有 TensorFlow 那样广泛的采用——TensorFlow 最初发布的时间早了一年多,得到了 Google 的支持,并且在神经网络工具新潮流兴起时奠定了黄金标准——但 PyTorch 在研究界获得的关注确实非常真实。这种关注很大程度上来自于其与 Torch proper 的关系,以及其动态计算图。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 工作

图片来源 尽管我最近对 PyTorch 的关注充满了兴奋,但这实际上并不是一个 PyTorch 教程;它更像是对 PyTorch 的 Tensor 类的介绍,该类与 Numpy 的 ndarray 类似。

张量(非常)基础

所以让我们来看看 PyTorch 的一些张量基础,从创建一个张量(使用 Tensor 类)开始:

import torch

# Create a Torch tensor

t = torch.Tensor([[1, 2, 3], [4, 5, 6]])

t

tensor([[ 1., 2., 3.],

[ 4., 5., 6.]])

你可以通过两种方式转置张量:

# Transpose

t.t()

# Transpose (via permute)

t.permute(-1,0)

两者都产生以下输出:

tensor([[ 1., 4.],

[ 2., 5.],

[ 3., 6.]])

请注意,这两种方法都不会改变原始张量。

使用视图重塑张量:

# Reshape via view

t.view(3,2)

tensor([[ 1., 2.],

[ 3., 4.],

[ 5., 6.]])

另一个例子:

# View again...

t.view(6,1)

tensor([[ 1.],

[ 2.],

[ 3.],

[ 4.],

[ 5.],

[ 6.]])

应该显而易见的是,Numpy 遵循的数学惯例也会延续到 PyTorch 张量中(具体来说,我指的是行和列的表示法)。

创建一个张量并用零填充它(你可以用 ones() 实现类似的功能):

# Create tensor of zeros

t = torch.zeros(3, 3)

t

tensor([[ 0., 0., 0.],

[ 0., 0., 0.],

[ 0., 0., 0.]])

创建一个从正态分布中抽取随机数的张量:

# Create tensor from normal distribution randoms

t = torch.randn(3, 3)

t

tensor([[ 1.0274, -1.3727, -0.2196],

[-0.7258, -2.1236, -0.8512],

[ 0.0392, 1.2392, 0.5460]])

张量对象的形状、维度和数据类型:

# Some tensor info

print('Tensor shape:', t.shape) # t.size() gives the same

print('Number of dimensions:', t.dim())

print('Tensor type:', t.type()) # there are other types

Tensor shape: torch.Size([3, 3])

Number of dimensions: 2

Tensor type: torch.FloatTensor

除了数学概念之外,ndarray 和 Tensor 实现之间还存在许多编程和实例化上的相似之处,这一点也应该显而易见。

你可以像切片ndarrays一样切片 PyTorch 张量,这对使用其他 Python 结构的人来说应该很熟悉:

# Slicing

t = torch.Tensor([[1, 2, 3], [4, 5, 6], [7, 8, 9]])

# Every row, only the last column

print(t[:, -1])

# First 2 rows, all columns

print(t[:2, :])

# Lower right most corner

print(t[-1:, -1:])

tensor([ 3., 6., 9.])

tensor([[ 1., 2., 3.],

[ 4., 5., 6.]])

tensor([[ 9.]])

PyTorch Tensor 与 Numpy ndarray 之间的转换

你可以轻松地从ndarray创建张量,反之亦然。这些操作很快,因为这两种结构的数据会共享相同的内存空间,所以不涉及复制。这显然是一种高效的方法。

# Numpy ndarray <--> PyTorch tensor

import numpy as np

# ndarray to tensor

a = np.random.randn(3, 5)

t = torch.from_numpy(a)

print(a)

print(t)

print(type(a))

print(type(t))

[[-0.52192738 -1.11579634 1.26925835 0.10449378 -1.02894372]

[-0.78707263 -0.05350072 -0.65815075 0.18810677 -0.52795765]

[-0.41677548 0.82031861 -2.46699201 0.60320375 -1.69778546]]

tensor([[-0.5219, -1.1158, 1.2693, 0.1045, -1.0289],

[-0.7871, -0.0535, -0.6582, 0.1881, -0.5280],

[-0.4168, 0.8203, -2.4670, 0.6032, -1.6978]], dtype=torch.float64)

<class 'numpy.ndarray'>

<class 'torch.Tensor'>

# tensor to ndarray

t = torch.randn(3, 5)

a = t.numpy()

print(t)

print(a)

print(type(t))

print(type(a))

tensor([[-0.1746, -2.4118, 0.4688, -0.0517, -0.2706],

[-0.8402, -0.3289, 0.4170, 1.9131, -0.8601],

[-0.6688, -0.2069, -0.8106, 0.8582, -0.0450]])

[[-0.17455131 -2.4117854 0.4688457 -0.05168453 -0.2706456 ]

[-0.8402392 -0.3289494 0.41703534 1.9130518 -0.86014426]

[-0.6688193 -0.20693372 -0.8105542 0.8581988 -0.04502954]]

<class 'torch.Tensor'>

<class 'numpy.ndarray'>

基本张量操作

这里有几个张量操作,你可以与 Numpy 实现进行比较以增添乐趣。首先是叉积:

# Compute cross product

t1 = torch.randn(4, 3)

t2 = torch.randn(4, 3)

t1.cross(t2)

tensor([[ 2.6594, -0.5765, 1.4313],

[ 0.4710, -0.3725, 2.1783],

[-0.9134, 1.6253, 0.7398],

[-0.4959, -0.4198, 1.1338]])

接下来是矩阵乘积:

# Compute matrix product

t = (torch.Tensor([[2, 4], [5, 10]]).mm(torch.Tensor([[10], [20]])))

t

tensor([[ 100.],

[ 250.]])

最后是逐元素相乘:

# Elementwise multiplication

t = torch.Tensor([[1, 2], [3, 4]])

t.mul(t)

tensor([[ 1., 4.],

[ 9., 16.]])

关于 GPU 的一些话

PyTorch 张量具有内置的 GPU 支持。指定使用 GPU 内存和 CUDA 核心来存储和执行张量计算非常简单;cuda包可以帮助确定是否有可用的 GPU,而该包的cuda()方法将张量分配给 GPU。

# Is CUDA GPU available?

torch.cuda.is_available()

# How many CUDA devices?

torch.cuda.is_available()

# Move to GPU

t.cuda()

相关:

-

什么是张量?!?

-

PyTorch 入门第一部分:了解自动微分的工作原理

-

构建神经网络的简单入门指南

更多相关话题

PyTorch 提升生产力的技巧

原文:

www.kdnuggets.com/2023/08/pytorch-tips-boost-productivity.html

作者提供的图片

介绍

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业。

1. 谷歌网络安全证书 - 快速进入网络安全职业。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT

你是否曾经花了几个小时来调试一个机器学习模型,却无法找到准确率没有提高的原因?你是否觉得一切都应该完美无缺,但由于某种神秘原因,你却没有得到理想的结果?

不再如此。对于初学者来说,探索 PyTorch 可能会令人望而却步。在这篇文章中,你将探索经过验证的工作流程,这些工作流程肯定会提高你的结果并提升你模型的性能。

1. 对单个批次进行过拟合

是否曾经在一个大型数据集上训练模型几个小时,却发现损失没有下降,准确率也没有改善?那么,首先做一个合理性检查。

在大型数据集上训练和评估可能是耗时的,首先在小数据子集上调试模型更容易。一旦我们确定模型正常工作,就可以轻松地将训练扩展到完整数据集上。

不要在整个数据集上进行训练,总是对单个批次进行训练以进行合理性检查。

batch = next(iter(train_dataloader)) # Get a single batch

# For all epochs, keep training on the single batch.

for epoch in range(num_epochs):

inputs, targets = batch

predictions = model.train(inputs)

考虑上述代码片段。假设我们已经有了一个训练数据加载器和一个模型。与其遍历整个数据集,不如轻松获取数据集的第一个批次。然后我们可以对这个单独的批次进行训练,以检查模型是否能够学习这个小数据部分中的模式和变化。

如果损失减少到非常小的值,我们知道模型可能会过拟合这些数据,并且可以确定它在短时间内已经学到了东西。然后,我们可以通过简单地修改一行代码在完整数据集上进行训练,如下所示:

# For all epochs, iterate over all batches of data.

for epoch in range(num_epochs):

for batch in iter(dataloader):

inputs, targets = batch

predictions = model.train(inputs)

如果模型能够对单个批次进行过拟合,它应该能够学习完整数据集中的模式。这种过拟合批次的方法使调试变得更加容易。如果模型甚至不能对单个批次进行过拟合,我们可以确定问题出在模型实现上,而不是数据集上。

2. 数据标准化和洗牌

对于数据顺序不重要的数据集,打乱数据是有帮助的。例如,对于图像分类任务,如果模型在单个批次中接收到不同类别的图像,它会更好地拟合数据。以相同的顺序传递数据,我们冒着模型根据数据传递的顺序学习模式的风险,而不是学习数据内部的固有方差。 因此,传递打乱后的数据更为合适。为此,我们可以简单地使用 PyTorch 提供的 DataLoader 对象,并将 shuffle 设置为 True。

from torch.utils.data import DataLoader

dataset = # Loading Data

dataloder = DataLoader(dataset, shuffle=True)

此外,在使用机器学习模型时,规范化数据是非常重要的。尤其是在数据方差较大且某个特定参数的值高于数据集中其他所有属性时,这一点尤为关键。这可能导致某个参数主导其他所有参数,从而降低模型的准确性。我们希望所有输入参数都在相同范围内,最好是均值为 0,方差为 1.0。 为此,我们必须转换数据集。了解数据集的均值和方差后,我们可以简单地使用 torchvision.transforms.Normalize 函数。

import torchvision.transforms as transforms

image_transforms = transforms.Compose([

transforms.ToTensor(),

# Normalize the values in our data

transforms.Normalize(mean=(0.5,), std=(0.5))

])

我们可以在 transforms.Normalize 函数中传递每通道的均值和标准差,它会自动将数据转换为均值为 0 和标准差为 1。

3. 梯度裁剪

梯度爆炸是 RNN 和 LSTM 中的一个已知问题。然而,这个问题不仅限于这些架构。任何具有深层的模型都可能遭遇梯度爆炸。高梯度的反向传播可能导致发散,而不是损失的逐渐减少。

参考下面的代码片段。

for epoch in range(num_epochs):

for batch in iter(train_dataloader):

inputs, targets = batch

predictions = model(inputs)

optimizer.zero_grad() # Remove all previous gradients

loss = criterion(targets, predictions)

loss.backward() # Computes Gradients for model weights

# Clip the gradients of model weights to a specified max_norm value.

torch.nn.utils.clip_grad_norm_(model.parameters(), max_norm=1)

# Optimize the model weights AFTER CLIPPING

optimizer.step()

为了解决梯度爆炸问题,我们使用梯度裁剪技术,将梯度值裁剪到指定范围内。例如,如果我们使用 1 作为裁剪值或规范值,如上所述,所有梯度将被裁剪到 [-1, 1] 范围内。如果我们遇到 50 的梯度爆炸值,它将被裁剪到 1。因此,梯度裁剪解决了梯度爆炸问题,允许模型向收敛方向进行缓慢优化。

4. 切换训练 / 评估模式

这一行代码将显著提高你的模型测试准确性。几乎所有深度学习模型都会使用 dropout 和归一化层。这些层仅在稳定训练和确保模型不会因数据方差而过拟合或发散时才需要。像 BatchNorm 和 Dropout 这样的层在训练过程中提供模型参数的正则化。然而,一旦训练完成,这些层就不再需要。将模型切换到评估模式可以禁用仅在训练中需要的层,从而使模型的所有参数都用于预测。

为了更好地理解,请考虑以下代码片段。

for epoch in range(num_epochs):

# Using training Mode when iterating over training dataset

model.train()

for batch in iter(train_dataloader):

# Training Code and Loss Optimization

# Using Evaluation Mode when checking accuarcy on validation dataset

model.eval()

for batch in iter(val_dataloader):

# Only predictions and Loss Calculations. No backpropogation

# No Optimzer Step so we do can omit unrequired layers.

在评估时,我们不需要对模型参数进行任何优化。在验证步骤中我们不会计算任何梯度。为了更好的评估,我们可以省略 Dropout 和其他归一化层。例如,这将启用所有模型参数,而不是像 Dropout 层中那样仅启用部分权重。这将显著提高模型的准确性,因为你将能够使用完整的模型。

5. 使用 Module 和 ModuleList

PyTorch 模型通常继承自 torch.nn.Module 基类。根据文档:

以这种方式分配的子模块将被注册,并且当你调用 to(),等等时,它们的参数也会被转换。

模块基类允许在模型中注册每一层。然后我们可以使用 model.to() 以及类似的函数,如 model.train() 和 model.eval(),这些函数将应用到模型中的每一层。如果不这样做,将不会更改模型中每一层的设备或训练模式,你需要手动进行。模块基类一旦在模型对象上使用函数,将自动为你进行转换。

此外,一些模型包含类似的顺序层,可以使用 for 循环轻松初始化并放在列表中。这简化了代码。然而,这也会导致上述问题,因为简单的 Python 列表中的模块不会自动在模型中注册。我们应该使用 ModuleList 来包含模型中的类似顺序层。

import torch

import torch.nn as nn

# Inherit from the Module Base Class

class Model(nn.Module):

def __init__(self, input_size, output_size):

# Initialize the Module Parent Class

super().__init__()

self.dense_layers = nn.ModuleList()

# Add 5 Linear Layers and contain them within a Modulelist

for i in range(5):

self.dense_layers.append(

nn.Linear(input_size, 512)

)

self.output_layer = nn.Linear(512, output_size)

def forward(self, x):

# Simplifies Foward Propogation.

# Instead of repeating a single line for each layer, use a loop

for layer in range(len(self.dense_layers)):

x = layer(x)

return self.output_layer(x)

上述代码片段展示了创建模型及其子层的正确方法。使用 Module 和 ModuleList 可以避免在训练和评估模型时出现意外错误。

结论

上述方法是 PyTorch 机器学习框架的最佳实践。它们被广泛使用,并且得到了 PyTorch 文档的推荐。使用这些方法应该是机器学习代码流的主要方式,并且肯定会提高你的结果。

穆罕默德·阿赫姆 是一位从事计算机视觉和自然语言处理的深度学习工程师。他曾在 Vyro.AI 上工作,部署和优化了多个生成 AI 应用程序,这些应用程序在全球排行榜上名列前茅。他对构建和优化智能系统的机器学习模型感兴趣,并相信持续改进。

更多相关内容

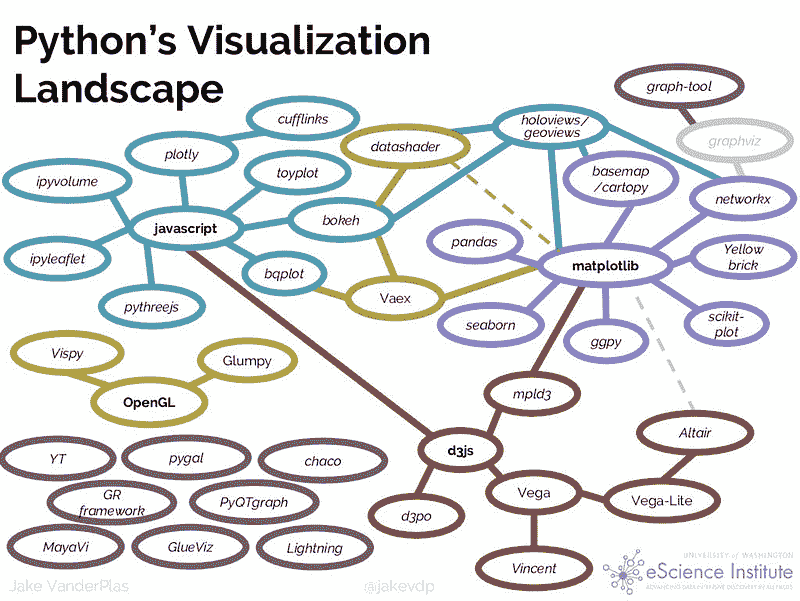

PyViz:简化 Python 中的数据可视化过程

原文:

www.kdnuggets.com/2019/06/pyviz-data-visualisation-python.html

评论

评论

由 Parul Pandey,数据科学爱好者

可视化的目的是洞察,而不是图片。

―本·施奈德曼

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

如果你处理数据,那么数据可视化是你日常工作中的一个重要部分。如果你使用 Python 进行分析,你一定会被众多的数据可视化库所压倒。一些库如 Matplotlib 用于初步的基本探索,但对于展示数据中的复杂关系却不太有用。有些库适用于大数据集,而另一些则主要关注 3D 渲染。实际上,没有一个单一的可视化库可以被称为最好的。一个库在某些功能上可能优于另一个,反之亦然。总之,选择很多,几乎不可能学习和尝试所有的库,或者让它们全部协同工作。那么我们该如何完成工作呢?PyViz 可能有答案。

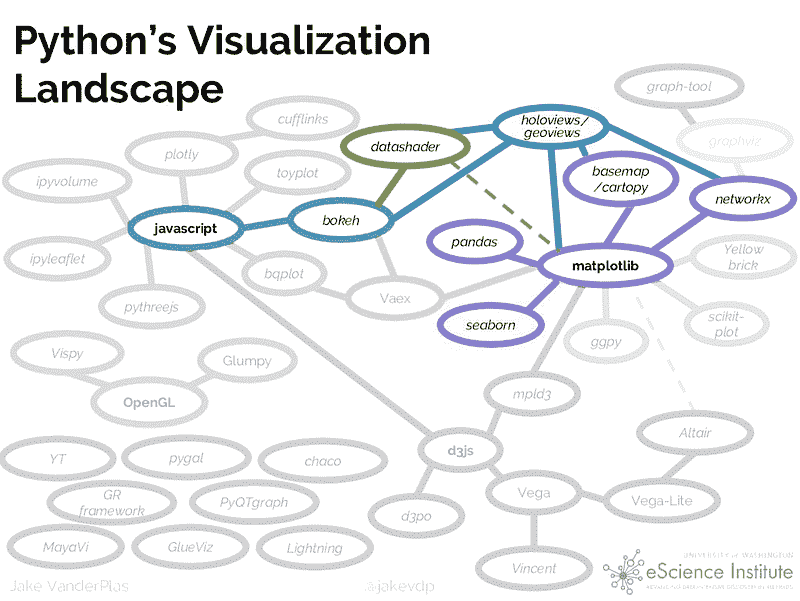

Python 当前的可视化格局

现有的 Python 数据可视化系统似乎是一个令人困惑的网状结构。

现在,从这些工具中选择最合适的一个有点棘手和令人困惑。PyViz 试图解决这一情况。它有助于简化在网页浏览器中处理小型和大型数据集(从几个点到数十亿个点)的过程,无论是进行探索性分析、制作简单的基于小部件的工具还是构建功能齐全的仪表板。

PyViz 生态系统

PyViz 是一个协调努力,使得 Python 中的数据可视化更易于使用、学习和更强大。PyViz 由一组开源 Python 包组成,可以在网页浏览器中轻松处理小型和大型数据集。无论是简单的 EDA 还是复杂的创建启用小部件的仪表板,PyViz 都是绝佳选择。

这是 PyViz 下的 Python 可视化格局。

PyViz 目标

Pyviz 的一些重要目标包括:

-

应重点关注任何规模的数据,而不是编码

-

完整功能和互动应直接在浏览器中提供(而非桌面端)

-

重点应更多放在 Python 用户上,而非网页程序员。

-

重点应更多放在 2D 可视化上,而非 3D。

-

利用 Python 用户已经熟悉的通用 SciPy/PyData 工具

库

组成 PyViz 的开源 库有:

-

HoloViews: 用于立即可视化数据的声明性对象,从方便的高级规格构建 Bokeh 绘图

-

GeoViews: 可视化的地理数据,可以与 HoloViews 对象混合和匹配

-

Bokeh: 在网页浏览器中进行互动绘图,运行 JavaScript 但由 Python 控制

-

Panel: 从许多不同的库中组装对象,创建布局或应用程序,无论是在 Jupyter notebook 还是独立的可服务仪表板中

-

Datashader: 快速将巨大的数据集栅格化为固定大小的图像

-

hvPlot: 快速从 Pandas、Xarray 或其他数据结构中返回互动 HoloViews 或 GeoViews 对象

-

Param: 声明用户相关参数,使得在笔记本上下文内外使用小部件变得简单

除此之外,PyViz 核心工具可以与以下库无缝配合。

此外,几乎所有其他绘图库中的对象都可以与 Panel 一起使用,包括对这里列出的所有内容的特定支持,以及任何可以生成 HTML、PNG 或 SVG 的内容。HoloViews 还支持 Plotly 进行 3D 可视化。

资源

PyViz 提供了示例、演示和培训材料,记录如何解决可视化问题。本教程提供了解决您自己可视化问题的起点。整个教程材料也托管在他们的 Github 代码库 中。

安装

请参阅 pyviz.org 以获取有关这些教程中使用的软件的完整安装说明。这里是这些说明的简化版本,假设您已经下载并安装了 Anaconda 或 Miniconda:

conda create -n pyviz-tutorial python=3.6

conda activate pyviz-tutorial

conda install -c pyviz/label/dev pyviz

pyviz examples

cd pyviz-examples

jupyter notebook

一旦所有内容都安装完成,以下单元格应打印出‘1.11.0a4’或更高版本:

import holoviews as hv

hv.__version__

'1.11.0a11'

hv.extension('bokeh', 'matplotlib')

#should see the HoloViews, Bokeh, and Matplotlib logos

#Import necessary libraries

import pandas

import datashader

import dask

import geoviews

import bokeh

如果完成没有错误,你的环境应该已经准备好了。

使用 PyViz 探索数据

在本节中,我们将探讨不同库如何在从数据中提取不同见解方面发挥作用,它们的结合可以真正帮助更好地分析数据。

数据集

所用数据集涉及每 10 万人中记录的 麻疹和百日咳病例数,涵盖了美国每个州随时间变化的数据。该数据集在 PyViz 教程中预装。

使用 Pandas 进行数据探索

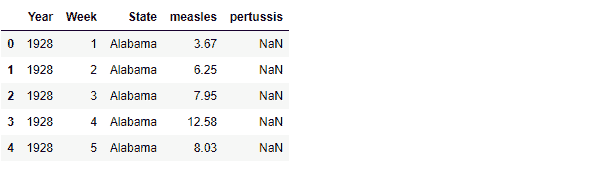

在任何数据科学项目中,开始探索通常是从 pandas 开始。让我们导入并显示数据集的前几行。

import pandas as pd

diseases_data = pd.read_csv('../data/diseases.csv.gz')

diseases_data.head()

数字是好的,但图表能更好地展示数据中的模式。

使用 Matplotlib 进行数据探索

%matplotlib inline

diseases_data.plot();

这并没有传达太多信息。让我们使用 pandas 进行一些操作,以获得有意义的结果。

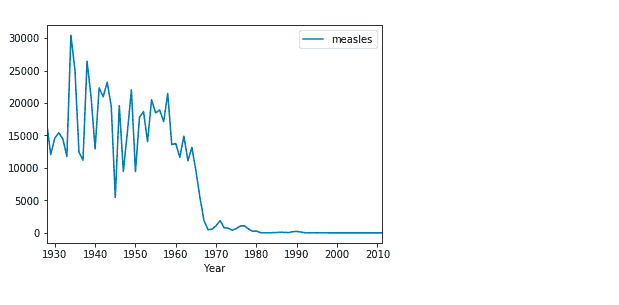

import numpy as np

diseases_by_year = diseases_data[["Year","measles"]].groupby("Year").aggregate(np.sum)

diseases_by_year.plot();

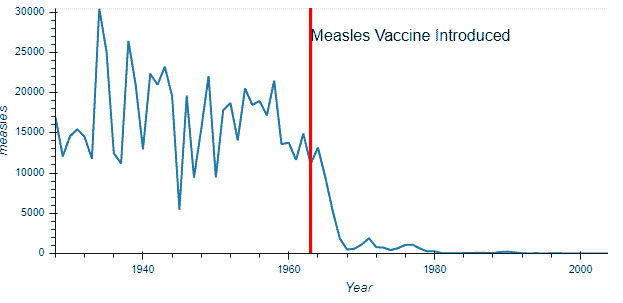

这就更有意义了。在这里,我们可以清楚地推断出大约在 1970 年发生了某些事情,导致麻疹的发生率几乎降为零。这是正确的,因为麻疹疫苗大约在 1963 年引入美国 [Wikipedia]

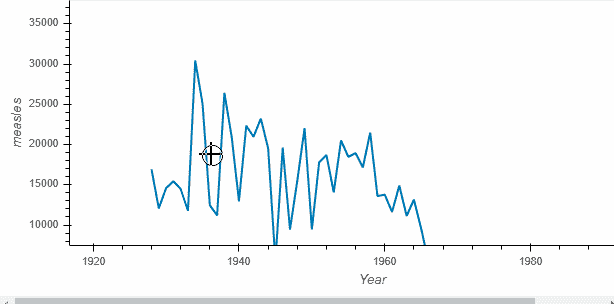

使用 HVPlot 和 Bokeh 进行数据探索

上面的图表传达了正确的信息,但没有提供交互性。这是因为它们是静态图,没有在网页浏览器中平移、悬停或缩放的功能。然而,我们可以通过简单导入 ** hvplot** 包来实现这种交互功能。

import hvplot.pandas

diseases_by_year.hvplot()

调用返回的对象称为 HoloViews 对象(这里是 Holoviews Curve),它 显示 为 Bokeh 图表。Holoviews 图表更丰富,方便在探索数据时捕捉你的理解。

让我们看看 HoloViews 还能做些什么:

在图表上捕捉重要点

1963 年在麻疹方面很重要,我们在图表上记录这一点怎么样。这还将帮助我们比较疫苗引入前后的麻疹病例数。

import holoviews as hv

vline = hv.VLine(1963).options(color='red')

vaccination_introduced = diseases_by_year.hvplot() * vline * \

hv.Text(1963, 27000, "Measles Vaccine Introduced", halign='left')

vaccination_introduced

Holoviews 对象保存了原始数据,而不是其他绘图库。例如,可以以表格格式访问原始数据。

print(vaccination_introduced)

vaccination_introduced.Curve.I.data.head()

在这里,我们能够使用用于绘制图表的数据。此外,现在很容易以多种不同的方式拆分数据。

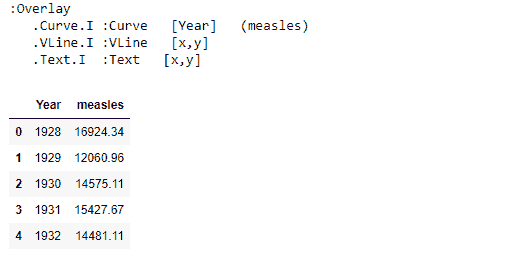

measles_agg = diseases_data.groupby(['Year', 'State'])['measles'].sum()

by_state = measles_agg.hvplot('Year', groupby='State', width=500, dynamic=False)

by_state * vline

我们可以将图表并排放置,以便更好地进行比较,而不是使用下拉菜单。

by_state["Alabama"].relabel('Alabama') + by_state["Florida"].relabel('Florida')

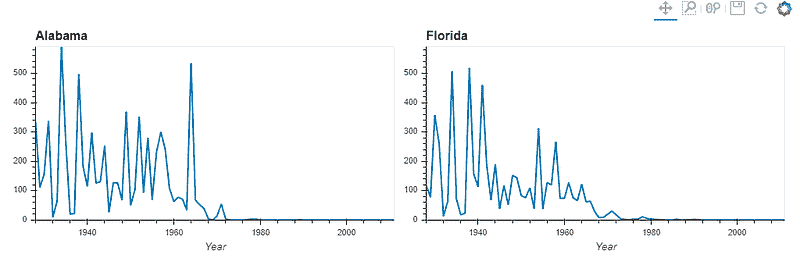

我们还可以改变图表的类型,比如改为柱状图。让我们比较 1980 年至 1985 年四个州的麻疹模式。

states = ['New York', 'Alabama', 'California', 'Florida']

measles_agg.loc[1980:1990, states].hvplot.bar('Year', by='State', rot=90)

从以上示例可以明显看出,通过选择HoloViews+Bokeh图表,我们可以在浏览器中探索数据,具有完全的互动性和最小的代码。

使用 PyViz 可视化大型数据集

PyViz 还能够轻松处理非常大的数据集。对于这样的数据集,PyViz 套件的其他成员将发挥作用。

-

Colorcet用于感知上均匀的大数据色图

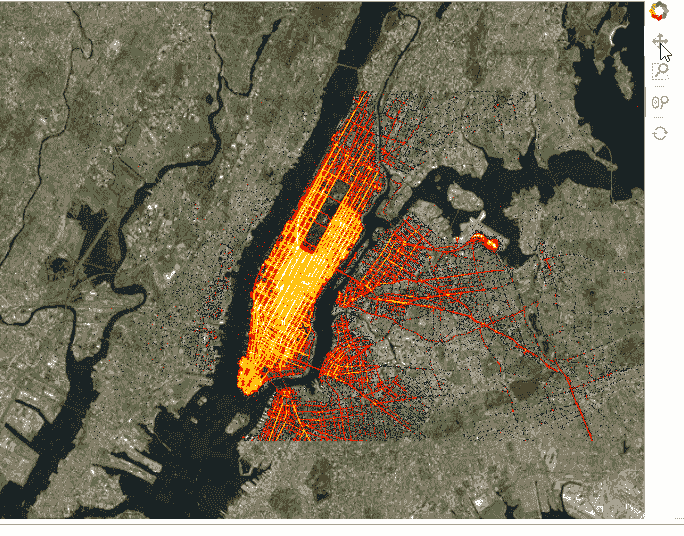

为了展示这些库在处理大量数据时的能力,让我们使用 NYC 出租车数据集,该数据集包含了高达 1000 万次出租车行程的数据。这些数据已在教程中提供。

#Importing the necessary libraries

import dask.dataframe as dd, geoviews as gv, cartopy.crs as crs

from colorcet import fire

from holoviews.operation.datashader import datashade

from geoviews.tile_sources import EsriImagery

Dask 是一个用于 Python 的灵活并行计算库。Dask DataFrame 是一个大型并行 DataFrame,由许多较小的 Pandas DataFrame 组成,按索引拆分。这些 Pandas DataFrame 可以存储在磁盘上,以便在单台机器上进行超出内存限制的计算,或在集群中的许多不同机器上进行计算。一个 Dask DataFrame 操作会触发许多操作在组成的 Pandas DataFrame 上。

Cartopy 是一个 Python 包,旨在进行地理空间数据处理,以生成地图和其他地理空间数据分析。

topts = dict(width=700, height=600, bgcolor='black', xaxis=None, yaxis=None, show_grid=False)

tiles = EsriImagery.clone(crs=crs.GOOGLE_MERCATOR).options(**topts)

dopts = dict(width=1000, height=600, x_sampling=0.5, y_sampling=0.5)

读取和绘制数据:

taxi = dd.read_parquet('../data/nyc_taxi_wide.parq').persist()

pts = hv.Points(taxi, ['pickup_x', 'pickup_y'])

trips = datashade(pts, cmap=fire, **dopts)

tiles * trips

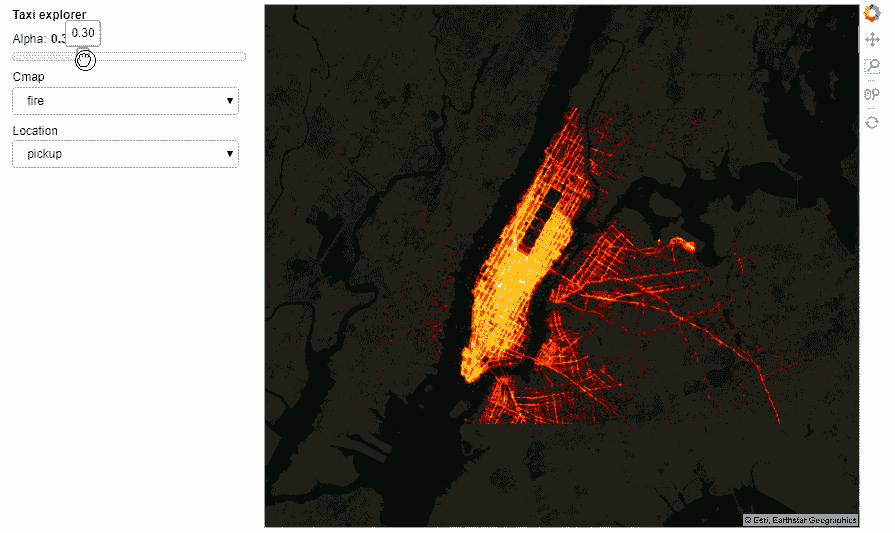

我们还可以添加小部件来控制选择。这可以在笔记本中完成,也可以通过标记可服务对象为.servable(),然后通过 Bokeh Server 运行.ipynb 文件,或者将代码提取到单独的.py 文件中并执行相同操作。

import param, panel as pn

from colorcet import palette

class NYCTaxi(param.Parameterized):

alpha = param.Magnitude(default=0.75, doc="Map tile opacity")

cmap = param.ObjectSelector('fire', objects=['fire','bgy','bgyw','bmy','gray','kbc'])

location = param.ObjectSelector(default='dropoff', objects=['dropoff', 'pickup'])

def make_view(self, **kwargs):

pts = hv.Points(taxi, [self.location+'_x', self.location+'_y'])

trips = datashade(pts, cmap=palette[self.cmap], **dopts)

return tiles.options(alpha=self.alpha) * trips

explorer = NYCTaxi(name="Taxi explorer")

pn.Row(explorer.param, explorer.make_view).servable()

出租车探索器

含有所有运行代码的 Notebook 可以从这里访问。然而,互动性在 GitHub 上无法呈现,但你仍然可以访问笔记本并在本地运行。

结论

PyViz 工具帮助我们即使用少量代码也能创建美观的可视化图表。PyViz 工具集合在一起构建高性能、可扩展、灵活且可部署的可视化、应用程序和仪表板,无需显式使用 JavaScript 或其他网页技术。本文只是对多功能 PyViz 生态系统的简单介绍。深入学习整个教程,以了解其复杂性及其在不同数据类型中的使用。

简介: Parul Pandey 是一位数据科学爱好者,常为数据科学出版物如 Towards Data Science 撰稿。

原文。经许可转载。

相关:

-

用代码在 Python 中进行 5 个快速而简单的数据可视化

-

Python 图形库

-

使用 Folium 在 Python 中可视化地理空间数据

更多相关话题

数据科学的定性研究方法?

原文:

www.kdnuggets.com/2017/05/qualitative-research-methods-data-science.html

虽然我接受过定性方法的培训,但我是一名量化专家,已经从事这个领域超过 30 年。然而,我在整个职业生涯中都是定性研究的用户。除非我们的数据科学领域与人类完全无关,否则这对于量化研究人员来说是非常相关的。我们所做的工作越接近市场研究——用户体验(UX)和客户关系管理(CRM)就是两个例子——它就变得越有用。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

定性研究提供背景和上下文,使得预测分析等量化分析对决策者更有用。消费者调查也是如此,并且这两种研究经常结合使用,定性阶段通常在调查前进行,有时在第三阶段进行。

定性研究如何有用?有很多方式,这里列举了一些例子。

首先,我们应该记住,两个人可能因为相同的原因购买相同的品牌(米勒轻啤味道好极了)。然而,他们也可能因为不同的原因购买相同的品牌(米勒轻啤味道好极了 与 米勒轻啤更不易饱腹),或者因为相同的原因购买不同的品牌(米勒轻啤味道好极了 与 百威轻啤味道好极了),或者因为不同的原因购买不同的品牌(米勒轻啤更不易饱腹 与 百威轻啤味道好极了)。消费者行为也可能因场合或时间的变化而有所不同,因为偏好和生活情况会因为结婚、生育、职位晋升、搬迁、健康问题等而发生变化。

了解人们在特定情况下做某些事情的原因可以帮助我们在构建和解释最终模型时。举例来说,在市场营销的情况下,这有助于我们理解如何与消费者沟通,而不仅仅是针对哪个消费者。还有许多其他方式定性研究可以帮助指导量化研究,但更详细的阐述需要比我这里所能提供的更多的空间。

任何研究都有其优缺点,定性研究也不例外。我的一个主要批评点是从业者的专业水平不可预测。坦率地说,一些从事定性研究的人是业余的。在某些情况下,缺乏培训或经验是罪魁祸首。其他人虽然作为研究者似乎不具备所需的能力,但在客户处理方面表现出色,因此获得了工作。

未经审视的假设是我的另一个痛点,定性研究者似乎比定量研究者更容易出现这种情况。另一个常被“量化派”提出的批评是分析师有时会根据自己的直觉而不是证据得出相当强的结论。将猜测当作事实是一种我们都容易犯的认知错误,但我在定性研究者中遇到这种情况更多。

当然,我们所有人都可能因为... 泛化的概括而指责泛化的概括!

我个人的观点是传统的:一般来说,定性研究应该仅作为探索工具使用,结论和影响应该比定量研究更为谨慎。然而,即使在这种限制下,它在帮助设计和解读定量研究以及发现定量方法无法揭示的洞察方面也可以是无价的。

虽然我不是定性研究专家,但我的许多联系人和商业伙伴是。其中之一是大卫·麦考汉,他是我们音频播客系列MR 现实的共同主持人。“MR”是市场研究的缩写,戴夫和我与特别嘉宾讨论了与市场研究相关的广泛话题。到目前为止,我们已经做了二十多个播客,这里是专门讨论定性研究的播客链接:

-

"符号学:定性研究中的问题儿童"(苏·贝尔,苏珊·贝尔研究)

-

"社交媒体:承诺、挑战与未来"(拉乌尔·库布勒教授,Ozyegin 大学)

-

"如何选择合适的在线定性方法?"(詹妮弗·戴尔,InsideHeads)

-

"行为经济学在客户洞察中的位置"(布里·威廉姆斯,People Patterns)

-

"民族志:从平凡中寻找意义"(戈登·米尔恩,Ipsos)

无需注册——只需点击链接。

认识我的人知道我喜欢书籍。以下是一些我发现特别有用的定性方法的热门书籍:

-

定性研究从头到尾(尹)

-

应用定性研究设计(罗勒和拉夫拉卡斯)

-

Qual-Online: 必备指南(Dale 和 Abbott)

-

内容分析:方法论简介(Krippendorff)

-

符号学基础(Chandler)

-

消费者研究中的人类学(Sunderland 和 Denny)

-

实用人类学(Ladner)

你喜欢的书商可能会让你看看书的内部内容,以便你自己判断这些书是否对你感兴趣。如果你想深入了解,还可以参考在线材料、专业协会和研讨会。

现实世界不像编写良好的计算机程序那样整洁,我建议你对定性研究保持开放的态度。如果没有它,我无法做我现在的工作。

我希望这些内容对你有趣且有帮助!

简历: Kevin Gray 是 Cannon Gray 的总裁,该公司是一家市场科学和分析咨询公司。

原创。经许可转载。

相关:

-

回归分析:入门

-

时间序列分析:入门

-

文本分析:入门

更多相关主题

招聘经理在数据科学家中寻找的素质

原文:

www.kdnuggets.com/2022/04/qualities-hiring-managers-looking-data-scientists.html

Cytonn Photography via Unsplash

作为一名数据科学家,你的首要目标是能够编写有效的代码,以实现组织的目标。

然而,许多其他特质对招聘经理在招聘新数据科学家时也很重要,这些特质有时被严重忽视。软技能对招聘经理来说与硬技能一样重要。我将介绍我认为最重要的那些。

1. 学习的意愿

许多招聘经理希望找到具备角色所需技能的人,同时也希望他们能够适应现有技能并发展新技能。

我们永远不会停止学习,特别是在一个高度技术化的领域中,新工具不断发布,旧工具不断改进。新算法不断被引入,因此如果你不愿意学习,对你的团队经理来说可能会非常令人沮丧。

冒名顶替综合症确实存在,并且影响到许多各个领域的人。它还可能成为你职业成功的障碍,因为你会不断怀疑自己的能力,因为你的主要目标是实现。专注于你当前拥有的技能,以及如何通过学习新技能来发展这些技能,是克服冒名顶替综合症的一种方法。

你将在面试中如何被测试?

许多招聘经理,不论你所在的领域,有时会问你这个问题:

“有没有过你觉得自己缺乏某种技能的时刻?发生了什么,你是如何解决这个问题的?”

这将帮助招聘经理了解你在特定项目或之前的角色中如何处理技能缺乏的情况;证明你是否愿意学习,或者你是否接受自己不知道技能并继续保持原状。

利用工作时间之外的空闲时间学习新技能或发展现有技能,是向招聘经理证明你愿意学习的另一种方式。作为数据科学家,你可以通过各种平台实现这一点,例如 Udemy、Coursera、edX 等。

2. 将代码与业务相关联

Mars via Unsplash

尽管编码是任何数据科学家的主要要求之一,但能够理解并将其应用于业务及其目标同样重要。

对任务和它如何与业务相关有全面的掌握,将使你编码得更好。这将向你的经理证明你理解什么是有利于业务的,而不仅仅是因为被要求完成任务。它可以区分你是否是团队和整个业务的积极成员。

通过这一点,作为数据科学家的你将比技术能力较弱的 CEO 或董事总经理拥有更好的技能和对当前问题的理解。你将能够利用你的硬技能,通过编码和商业头脑引导业务朝正确方向发展。

你将在面试中如何被测试?

在数据科学面试过程中,你将被要求经历一个技术阶段。招聘经理会要求你以对业务独特的方式处理技术测试。

例如,如果你申请的角色是具备机器学习模型专长的数据科学家,那么技术测试可能会涉及到业务中某一特定问题的不同建模解决方案。

这将向招聘经理证明你具备将编码技能应用于业务目标的能力。

3. 识别问题并提出解决方案

如上所述,你的团队中或在公司高层可能会有技术技能和理解能力较少的人。能够识别公司当前存在的问题或所选解决方案的问题,并提出自己的建议,将使你脱颖而出。

这向招聘经理证明你愿意帮助业务改进,当你获得工作时,它将向公司证明你是业务成功的宝贵资产。

说‘是’对每一个抛给你的任务很容易。但说‘我认为这不是正确的解决方案,试试 X 怎么样?’却更难。很多企业因未能采纳其他团队成员的建议和解决方案而失败。

提出你的建议并不会有害,最坏的情况就是你错了或者你的经理给你一个更好的理解,说明为什么业务不能使用那个特定的解决方案。最终,你仍然是在学习。

然而,如果你选择保留自己的想法,你是在对自己不利。雇主会认为你不是一个积极的员工,不愿意为业务的成功做出贡献。

你将在面试中如何被测试?

在面试阶段很难测试这种软技能,因为时间有限。然而,技术面试通常有多个阶段,因此你可以在每个阶段中随时被测试到这种技能。

招聘经理通常会问的问题是:

“是否有过你发现任务中的问题并提出自己的解决方案的情况?如果有,你是怎么做的?”

详细回答你的问题,因为招聘经理会知道你的回答是否肤浅。

4. 提问

大多数(如果不是全部)招聘经理都会问你是否有任何问题。问,问,问!如果你不问,你就得不到。

你申请这个职位是因为你想要这份工作。然而,你也需要确保这是适合你的角色。招聘经理会审查你,所以你也应该审查公司,看看公司的价值观和要求是否是你愿意投入的。

问题可能是:

-

我的典型一天会是什么样的?

-

公司是否提供培训?

-

公司在我在职期间是否提供自我发展的支持?

-

我能否更好地理解职位描述中的好处?

结论

数据科学家的招聘过程并不简单。它有不同的阶段,都需要大量的技术知识并考验你的软技能。

如果你想了解更多,请阅读:

-

数据科学面试指南 - 第一部分:结构

-

数据科学面试指南 - 第二部分:面试资源

尼莎·阿里亚 是一名数据科学家和自由技术写作人。她特别关注提供数据科学职业建议或教程以及数据科学相关的理论知识。她还希望探索人工智能如何/能够促进人类生命的延续。作为一个热心的学习者,她希望拓宽技术知识和写作技能,同时帮助指导他人。

相关话题

量化与 LLMs:将模型浓缩到可管理的大小

原文:

www.kdnuggets.com/quantization-and-llms-condensing-models-to-manageable-sizes

LLM 的规模与复杂性

LLM 的惊人能力得益于其庞大的神经网络,这些网络由数十亿个参数组成。这些参数是通过在大量文本语料库上进行训练得到的,并经过微调以使模型尽可能准确和多才多艺。这种复杂性水平需要大量的计算能力来处理和存储。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 为你的组织提供 IT 支持

3. 谷歌 IT 支持专业证书 - 为你的组织提供 IT 支持

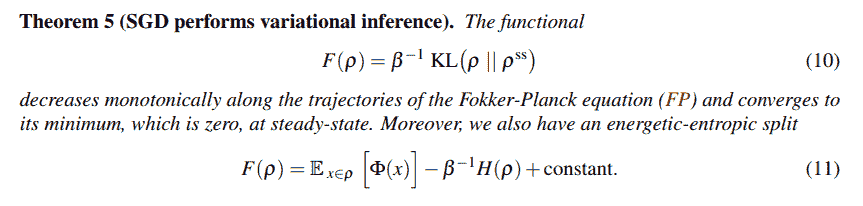

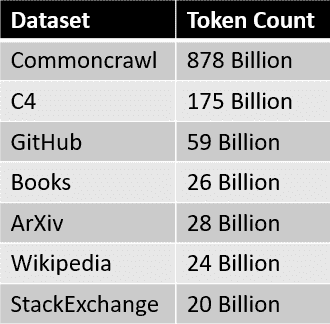

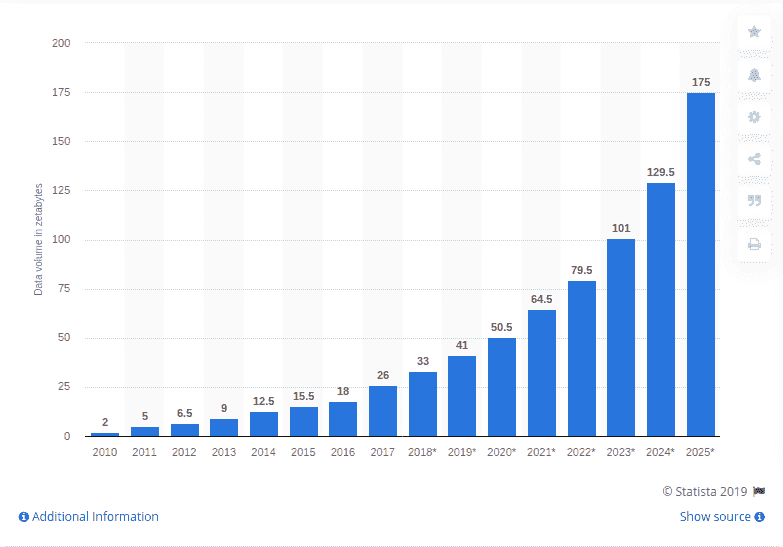

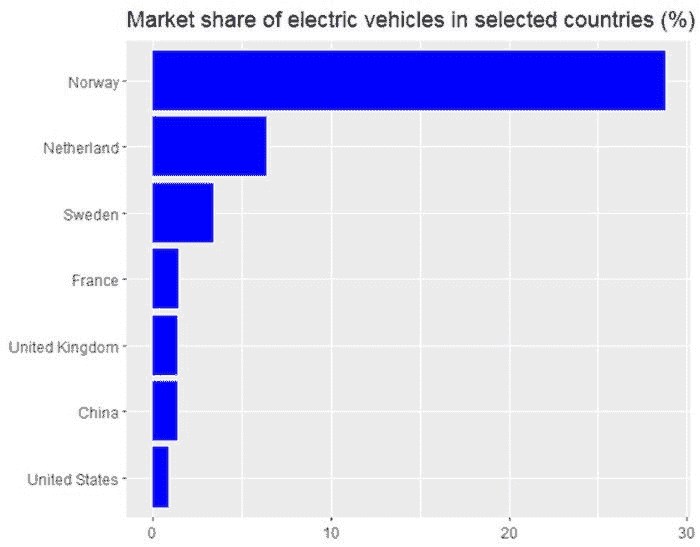

附图条形图描绘了不同规模语言模型的参数数量。随着模型规模的增大,我们可以看到参数数量显著增加,从具有几百万参数的“小型”语言模型到具有数百亿参数的“大型”模型。

然而,具有 1750 亿个参数的 GPT-4 LLM 模型在参数规模上超越了其他模型。GPT-4 不仅使用了图表中最多的参数,还驱动了最具知名度的生成型 AI 模型——ChatGPT。图表中的这一庞大存在代表了同类的其他 LLMs,展示了驱动未来 AI 聊天机器人的需求以及支持如此先进 AI 系统所需的计算能力。

运行 LLMs 的成本与量化

部署和操作复杂的模型可能会很昂贵,因为它们需要使用高端 GPU、AI 加速器以及持续的能源消耗进行云计算。选择本地解决方案可以通过降低成本来节省大量资金,并提高硬件选择的灵活性和系统使用的自由度,但这需要付出维护成本和雇佣专业人员的代价。高成本使得小型企业在训练和运行先进 AI 方面面临挑战。这时,量化技术就显得非常重要。

什么是量化?

量化是一种技术,通过降低模型中每个参数的数值精度,从而减少其内存占用。这类似于将高分辨率图像压缩为较低分辨率,同时保留精髓和最重要的方面,但数据大小有所减少。这种方法使得在硬件条件较差的情况下,也能部署大型语言模型而不会造成显著的性能损失。

ChatGPT 的训练和部署使用了数千台 NVIDIA DGX 系统,数百万美元的硬件以及数万亿美元的基础设施费用。量化可以在性能不逊色(但硬件性能较低)的条件下,实现良好的概念验证甚至完全成熟的部署。

在接下来的部分中,我们将剖析量化的概念、方法及其在缩小大型语言模型对资源的高度依赖与日常技术使用的实际之间差距方面的意义。大型语言模型的变革力量可以在小规模应用中成为主流,为更广泛的受众提供巨大的好处。

量化基础

对大型语言模型进行量化是指减少模型中数值值的精度。在神经网络和深度学习模型的上下文中,包括大型语言模型,数值值通常表示为高精度的浮点数(例如 32 位或 16 位浮点格式)。有关浮点精度的更多信息。

量化通过将这些高精度浮点数转换为较低精度的表示形式,如 16 位或 8 位整数,从而提高模型在训练和推理时的内存效率和速度,尽管牺牲了一些精度。因此,模型的训练和推理需要较少的存储空间,消耗更少的内存,并且可以在支持低精度计算的硬件上更快地执行。

量化类型

为了增加主题的深度和复杂性,了解量化可以在模型开发和部署生命周期的不同阶段应用至关重要。每种方法都有其独特的优点和权衡,根据用例的具体要求和限制进行选择。

1. 静态量化

静态量化是一种在 AI 模型的训练阶段应用的技术,其中权重和激活被量化为较低的位精度,并应用于所有层。权重和激活提前量化并在整个过程中保持固定。静态量化非常适合于已知系统内存需求的模型部署计划。

-

静态量化的优点

-

简化部署规划,因为量化参数是固定的。

-

减少模型的大小,使其更适合边缘设备和实时应用。

-

-

静态量化的缺点

-

性能下降是可预测的;因此某些量化部分可能由于广泛的静态方法而遭受更大的损失。

-

对于静态量化适应性有限,适应不同输入模式的能力差,权重更新不够稳健。

-

2. 动态量化

动态量化涉及静态量化权重,但在模型推理期间激活会动态量化。权重会提前量化,而激活在数据通过网络时动态量化。这意味着模型的某些部分在不同的精度下执行量化,而不是默认固定量化。

-

动态量化的优点

-

平衡了模型压缩和运行效率,准确性没有显著下降。

-

对于激活精度比权重精度更为关键的模型特别有用。

-

-

动态量化的缺点

-

相较于静态方法,性能提升不可预测(但这不一定是坏事)。

-

动态计算意味着比其他方法需要更多的计算开销和更长的训练和推理时间,但仍比没有量化时更轻量。

-

3. 训练后量化(PTQ)

在这种技术中,量化被纳入到训练过程中。它涉及分析权重和激活的分布,然后将这些值映射到更低的位深。PTQ 被部署在资源受限的设备上,如边缘设备和手机。PTQ 可以是静态的也可以是动态的。

-

PTQ 的优点

-

可以直接应用于预训练模型,而无需重新训练。

-

减少模型大小,降低内存需求。

-

提升了推理速度,实现了部署期间和之后更快的计算。

-

-

PTQ 的缺点

-

由于权重的近似,可能会导致模型准确性下降。

-

需要仔细的校准和微调以减轻量化误差。

-

可能不适用于所有类型的模型,特别是那些对权重精度敏感的模型。

-

4. 量化感知训练(QAT)

在训练过程中,模型会了解在推理期间将应用的量化操作,并相应调整参数。这使得模型能够学会处理量化引起的误差。

-

QAT 的优点

-

相比 PTQ,QAT 倾向于保持模型准确性,因为模型训练时考虑了量化误差。

-

对于对精度敏感的模型更为稳健,即使在较低精度下也能更好地进行推理。

-

-

QAT 的缺点

-

需要重新训练模型,从而导致训练时间延长。

-

由于包含量化误差检查,因此计算开销较大。

-

5. 二进制三进制量化

这些方法将权重量化为两个值(二值)或三个值(三值),代表了量化的最极端形式。权重在训练过程中或之后被限制为二值量化的 +1 和 -1,或三值量化的 +1、0 和 -1。这将大幅减少可能的量化权重值数量,同时仍保持一定的动态性。

-

二值三值量化的优点

-

最大化模型压缩和推理速度,且内存需求最小。

-

快速推理和量化计算使得在性能不足的硬件上仍具备实用性。

-

-

二值三值量化的缺点

-

高压缩率和降低精度会显著降低准确性。

-

不适用于所有类型的任务或数据集,并且在处理复杂任务时表现不佳。

-

量化的好处与挑战

大型语言模型的量化带来了多种操作上的好处。主要是显著减少了这些模型的内存需求。我们对量化后的模型的目标是内存占用显著减少。更高的效率使得这些模型可以在内存能力较小的平台上部署,并且量化后的模型所需的处理能力减少,直接提高了推理速度和响应时间,从而提升了用户体验。

另一方面,量化也可能会引入一些模型精度的损失,因为它涉及到对真实数字的近似。挑战在于如何在不显著影响模型性能的情况下进行量化。可以通过在量化前后测试模型的精度和完成时间来评估效果、效率和准确性。

通过优化性能和资源消耗之间的平衡,量化不仅扩大了大语言模型的可及性,还促进了更可持续的计算实践。

原文。经许可转载。

Kevin Vu 负责管理 Exxact Corp 博客,并与许多才华横溢的作者合作,这些作者撰写了有关深度学习不同方面的文章。

更多相关主题

量子计算如何对机器学习有用

原文:

www.kdnuggets.com/2019/04/quantum-computing-machine-learning.html

评论

评论

作者:Roger Huang

如果你听说过量子计算,你可能会对将其应用于机器学习的可能性感到兴奋。如何利用这项新兴技术?我在 Springboard 工作,我们最近推出了一个包括职位保证的机器学习训练营。我们希望确保我们的毕业生接触到前沿的机器学习应用,因此我们将这篇文章作为我们研究量子计算与机器学习交集的一部分。

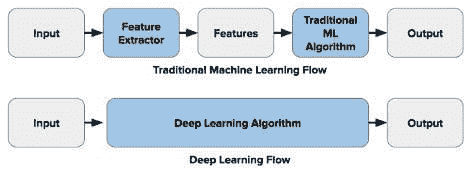

让我们先来探讨一下量子计算与经典计算的区别。 在经典计算中,数据存储在物理比特中,数据是二进制的且互为穷尽:比特要么处于 0 状态,要么处于 1 状态,不能同时处于两者状态。量子计算利用分子间小尺度物理相互作用的物理特性,使得量子比特(简称“qubit”)可以是经典 0 和 1 状态的线性组合——允许在一个 qubit 中存储比在普通比特中更多的数据。

量子计算确实会受到慢速的影响,因为量子分子彼此纠缠,并且直接物理观察它们所处的量子系统(即,从量子计算机中获取经典结果)会存在困难。但它可以更快地处理大量数据,并减少许多经典计算任务的空间/时间考虑——包括与机器学习相关的任务。

现在让我们看看量子计算在某些具体实例中如何提供帮助。

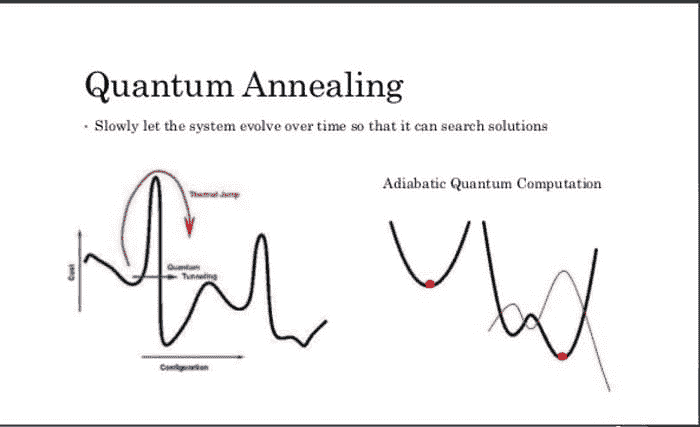

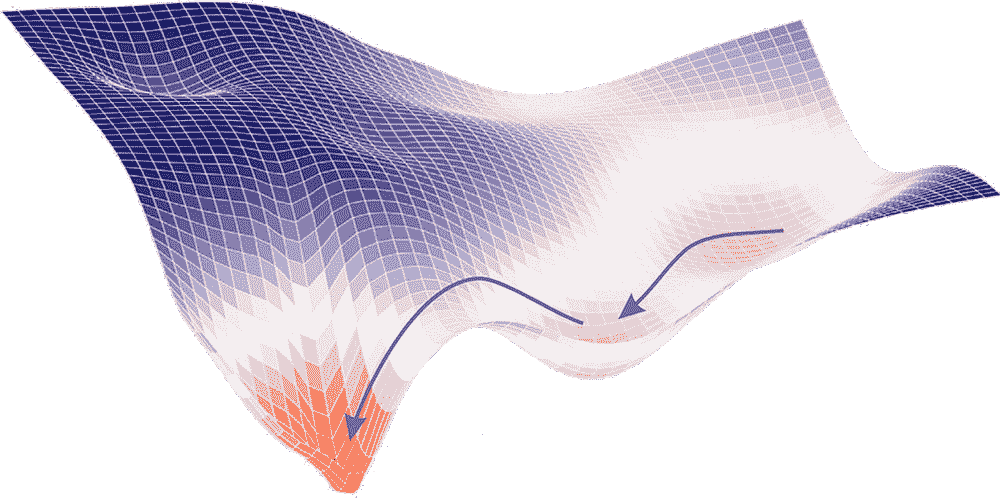

1- 量子退火器与量子隧穿中的损失函数最小化

首先要区分的是通用量子门计算机,它可以执行每个完整量子算法(前述链接中描述了大约 50 个算法)以及量子退火器,它们是适用于特定目的的量子计算机的简化版本。

你可能对量子退火器有所了解,比如来自D-Wave的设备。这篇文章深入解释了量子通用门计算机与退火器的区别。基本上,量子退火器是“简化版”的通用量子计算机,专注于找到超局部极小值,并比经典计算机更接近全局极小值。

来源: www.slideshare.net/donotstalkme/quantum-computing-55840897

量子退火器通过一系列磁铁附着在一个网格上。磁铁相互影响,为了让系统整体节省能量,它们会翻转到一个协调的方向,从而最小化能量使用。在经典设置下,磁铁在找到更低的极小值之前会被困在低能量设置中,但由于量子特性如隧穿效应,它们可以跳过那些大的能量成本设置——这使得函数更容易从局部极小值下降到全局极小值或更接近全局极小值的局部极小值。

当涉及到成本函数时,这可以意味着梯度下降函数在次优设置下被困,还是在最优或接近最优的设置下,尤其是在复杂的非凸误差表面上。

如果你在急需“足够好”的答案的情况下,面对通常需要大量经典计算能力的复杂机器学习优化问题,它们可以是一个可靠的解决方案。通过利用量子隧穿效应,你可以更快地收敛于优化应用中的误差函数,比如投资组合分析(金融领域)。该技术已被用于分析美国电网,传感器每两秒钟收集大约 3PB 的数据,并几乎即时进行快速的损失函数计算。

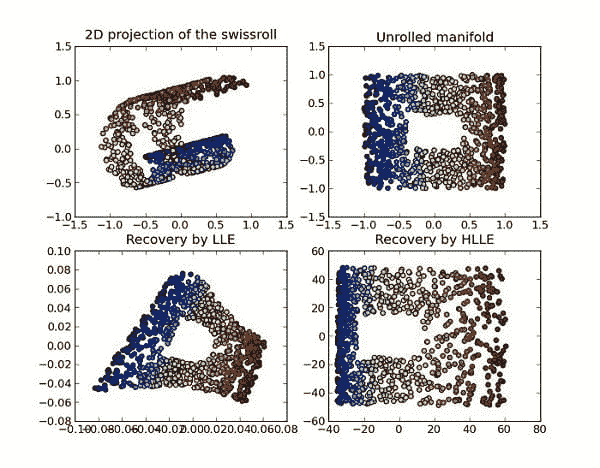

2- 增强或替代 用于维度减少的支持向量机

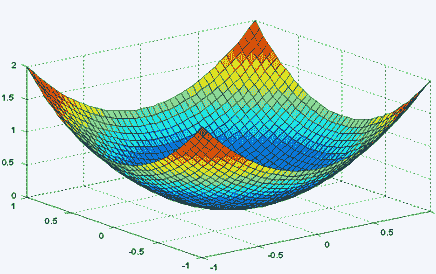

机器学习面临的最大问题之一是处理高维空间中的计算。实际上,机器学习需要使用核技巧来有效地进行计算。量子计算机可以帮助简化这个问题:有量子解释的支持向量机核技巧可以帮助将计算减少到特定维度,并允许将高维数据集拆分成更易于管理的数据集。这篇 2016 年论文在进行维度减少时实现了量子计算机的指数级加速,超过了在经典计算机上运行的任何算法。

来源: 维基百科

随着可用量子比特数量的增加,这种实现变得越来越高效。

通过使用适用于量子门和量子计算的支持向量机实现,有可能以更高的速度和更低的计算成本对非常大且复杂的数据集进行分类,例如基于多个因素判断细胞是否为癌细胞,这比目前经典计算机所能实现的更为高效。

3- 小规模量子计算与强大经典计算的混合实现用于非常大数据集(例如:拓扑分析)

通过利用量子计算和经典计算的优势,你可以为涉及巨大数据集的问题创造新的解决方案。

如果你想例如分析数据的拓扑分布(通常这是一个非常困难的任务,即使对于较小的数据集),以便简化数据中的失真并实质性地权衡数据错误的风险,你可以使用量子计算,即使是在非常小的规模下,也能达到更优的效果,同时使用经典计算来完成其余分析。这是麻省理工学院、滑铁卢大学和南加州大学的学者们正在积极研究的方向。

通过在量子计算机上对数据集进行拓扑分析(当在经典计算机上进行此操作计算成本过高时),你可以快速获得数据集中的所有重要特征,评估其形状和方向,然后继续使用经典计算算法进行剩余工作,手中握有所需的特征和适当的算法方法。

来源:维基媒体

这种方法将使机器学习算法和方法在更大且不断增长的数据集中更有效地实现,结合了越来越强大的量子计算机和经典计算机。

希望这篇文章帮助你了解如何将量子算法和计算与机器学习结合起来。以下的EdX 课程将帮助你提供实际的两个领域结合的例子。Coursera 提供了有关量子计算概念的一系列课程,帮助你更加熟悉这一领域。如果你希望提高机器学习技能或进入一个全职从事机器学习的职业,并思考如上所述的问题,可以参考Springboard 的 AI/机器学习职业路径。

简介: Roger Huang 帮助公司在短短几周内实现收入倍增,并且现在正在帮助人们找到梦想中的工作。

相关:

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织进行 IT

3. 谷歌 IT 支持专业证书 - 支持您的组织进行 IT

更多相关话题

如何查询你的 Pandas 数据框

评论

图片由 Bruce Hong 拍摄,来源于 Unsplash [1]。

目录

-

介绍

-

多重条件

-

在多个特定列上合并

-

总结

-

参考

介绍

无论你是从数据工程师/数据分析师转行,还是想成为更高效的数据科学家,查询你的数据框可以证明是一种非常有用的方法,用于返回你想要的特定行。需要注意的是,pandas 有一个专门的查询函数,名为 query。不过,我将讨论其他模拟查询、筛选和合并数据的方法。我们将展示一些你可能向数据提出的常见场景或问题,而不是使用 SQL,我们将用 Python 来完成。在下面的段落中,我将概述一些用 Python 编程语言查询 pandas 数据框的简单方法。

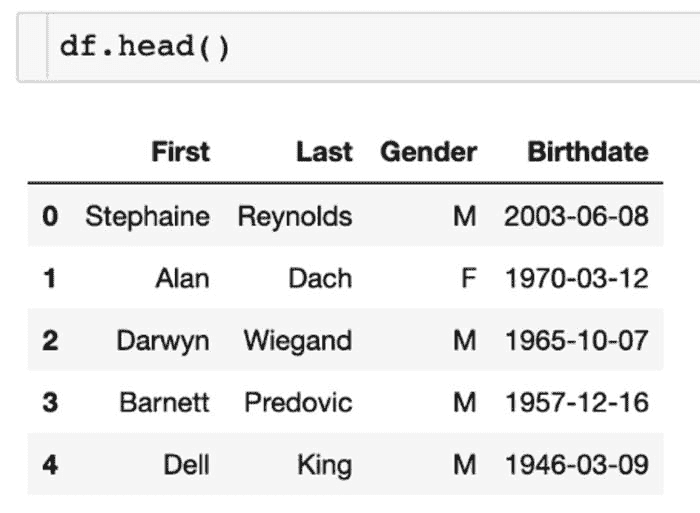

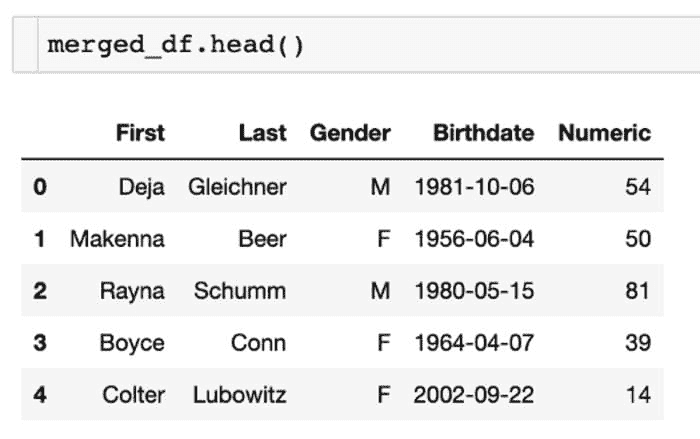

多重条件

示例数据。作者截图 [2]。

作为数据科学家或数据分析师,我们希望返回特定的行数据。一个这样的场景是你想在同一行代码中应用多个条件。为了展示我的示例,我创建了一些虚假的样本数据,包括名字和姓氏,以及相应的性别和出生日期。这些数据在截图中展示。

示例中的多个条件将本质上回答一个特定的问题,就像你使用 SQL 一样。问题是,我们的数据中有多少百分比是男性 OR 出生于 2010 年至 2021 年之间的人。

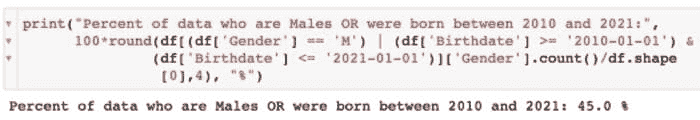

这是解决该问题的代码(有几种方法可以回答这个问题,但这是我具体的做法):

print(“Percent of data who are Males OR were born between 2010 and 2021:”,

100*round(df[(df[‘Gender’] == ‘M’) | (df[‘Birthdate’] >= ‘2010–01–01’) &

(df[‘Birthdate’] <= ‘2021–01–01’)][‘Gender’].count()/df.shape

[0],4), “%”)

为了更好地可视化这段代码,我还包括了上面的相同代码的截图,以及输出/结果。你也可以应用这些条件以返回实际行,而不是获取总行数的比例或百分比。

条件代码。作者截图 [3]。

这里是我们执行的命令顺序:

-

返回男性的

Gender -

包括 OR 函数

| -

返回

Birthdate> 2010 和 2021 的行 -

将所有条件结合起来,然后除以总行数

如你所见,这段代码与 SQL 中你会看到的内容类似。我个人认为在 pandas 中更容易,因为代码量可能更少,同时可以在一个易于查看的位置看到所有代码,而无需上下滚动(但这种格式只是我的偏好)。

在多个特定列上合并