第四周:卷积神经网络Part3

循环神经网络

应用

- 语音/视觉问答

- 机器翻译

- 作诗

- 模仿

- 图像理解

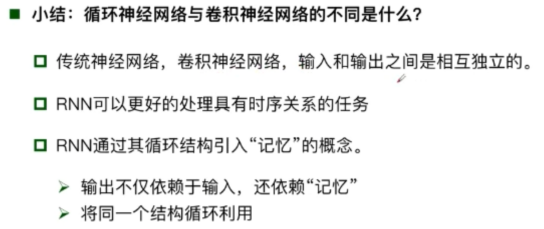

与卷积神经网络的比较

卷积神经网络的应用

- 图像分类

- 检索任务

- 人脸识别

- 图像生成

最主要的区别在于循环神经网络都有一个上下文的关系,上一时刻的输出是会影响下一时刻的输出的,卷积神经网络并不考虑之前发生了什么,它只关注当下。

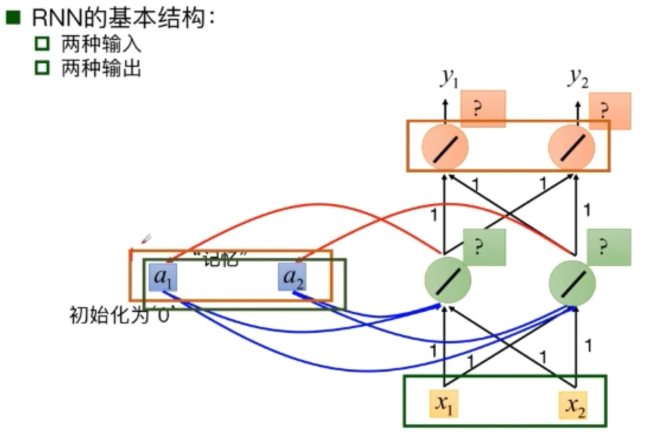

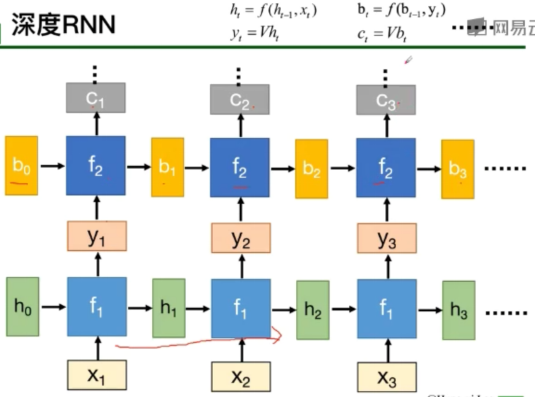

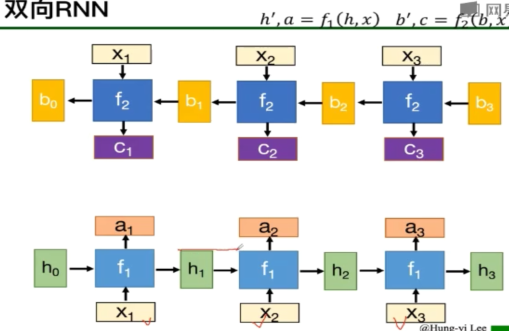

循环神经网络基本组成结构

之所以有上下文的关系是因为“记忆”模块的存在

传统RNN的问题

当循环神经网络基本组在时间维度上非常深的时候,会导致梯度消失以及梯度爆炸问题

梯度爆炸导致的问题:模型训练不稳定,梯度变为无穷大

改进:权重衰减/梯度截断

梯度消失导致的问题:长时依赖问题

改进:改进模型

LIST(使记忆不会被新的输入完全覆盖)

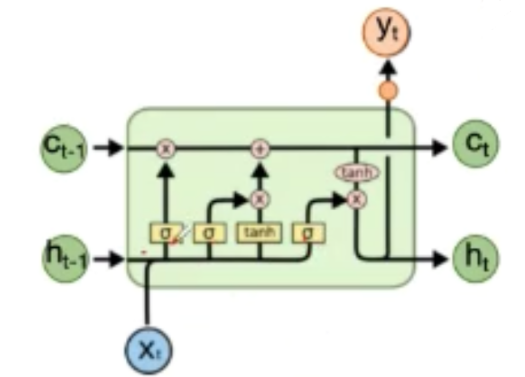

基本结构

LIST拥有三个门

- 遗忘门:决定丢弃信息,每个部分有多少量可以通过(选择记忆)

- 输入门:确定需要更新的信息

- 输出门:输出信息

GRU(解决LIST运算复杂问题)

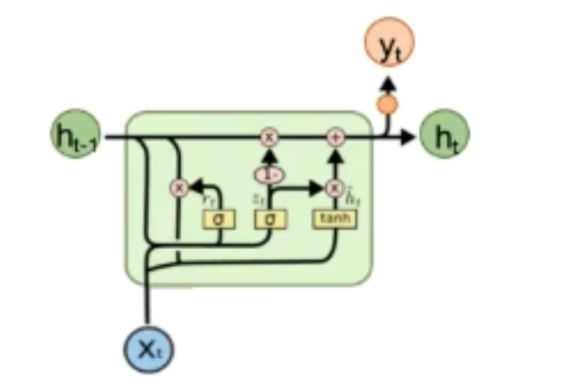

基本结构

GRU只有两个门

- 重置门:控制忽略前一刻的状态信息的程度,重置门越小说明忽略的越多

- 更新门:控制前一刻的状态信息被带入到当前状态中的程度,更新门越大表示前一刻的状态信息带入越多

解决梯度消失问题的其他方法

Clockwise RNN或者基于attention的RNN

浙公网安备 33010602011771号

浙公网安备 33010602011771号