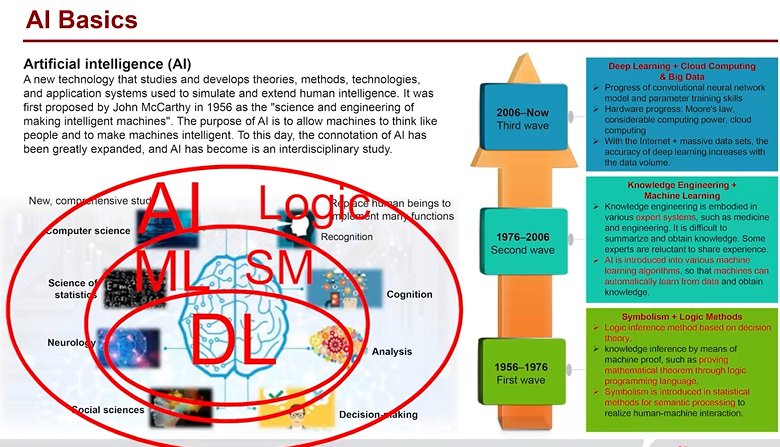

华为AI全栈成长计划课程——AI基础篇——第二周笔记1

第4章 人工智能的能与不能

4.1 人工智能的能与不能:算法

人工智能的理论上限

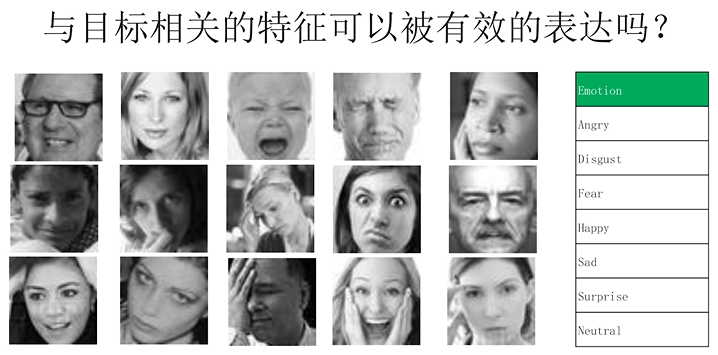

- 例子:人脸表情识别,由于判断标准不同,人类或者机器都可能无法准确预测人脸的表情。

- 改进:机器的预测提供top1到top5的预测结果,而不只是单一一个预测结果。

- Bayes error rate: the lowest possible error rate for any classifier of a random outcome (into, for example, one of two categories) and is analogous to the irreducible error.

- 贝叶斯错误率(贝叶斯上限):对于任何一个随机结果的分类器(例如,分为两个类别中的一个)可能的最低错误率,类似于不可改变的错误(即机器的预测,哪怕是乱猜,也不能高于人类的上限)。

Foolish or fooled:人工智能会犯什么错误

-

人类会犯错

-

理论数据和实际数据的差距

-

道德伦理问题

-

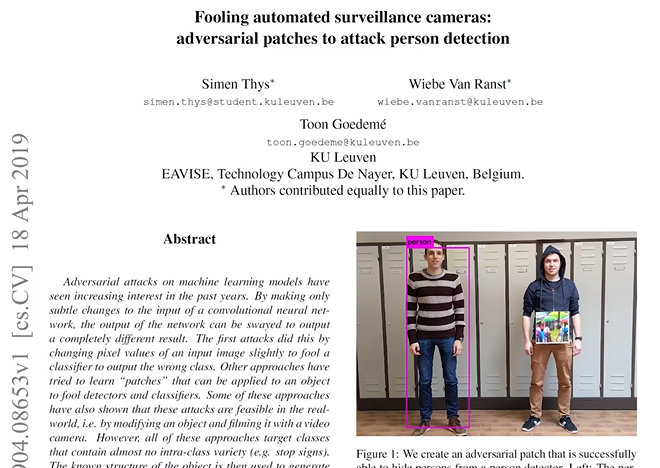

例子1:放一张油画在人的面前,AI就无法识别人的存在。

-

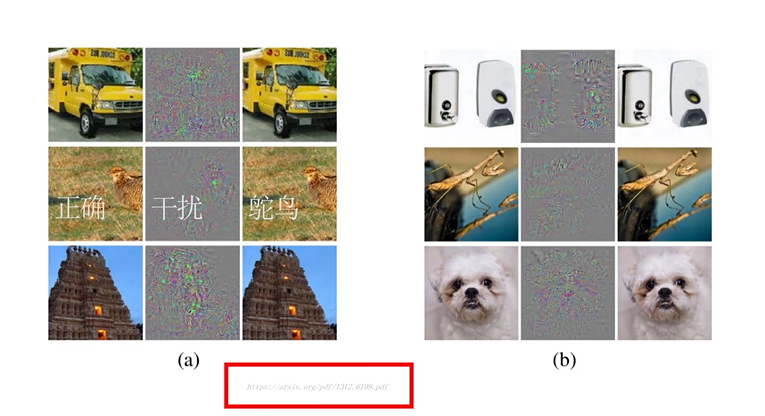

例子2:当AI不知道原图片的内容是什么,给原图片蒙上蒙版,加上一些噪声,可以使AI识别其为鸵鸟。相反,如果起初告诉AI原图片内容是什么,再蒙上蒙版,就不会被识别为鸵鸟。(所以为什么我们训练时会使用数据增强,给测试数据例如图片,加上一些噪声、旋转、融合之类的操作生成新的数据,就是为了使其适应这样的变化,不会识别错误。

-

例子3:上层4张图,虽然已经看不出来是什么模样,但也有99.6%的执行度,所以执行度靠不住。因为本身模型衡量的正负样本数是不一样的,比如1万个样本里,只有一个正样本的分类器,结果分类器简单地将所有的样本都识别成负样本,如此一来精准度是非常高的。但其实没有价值。

-

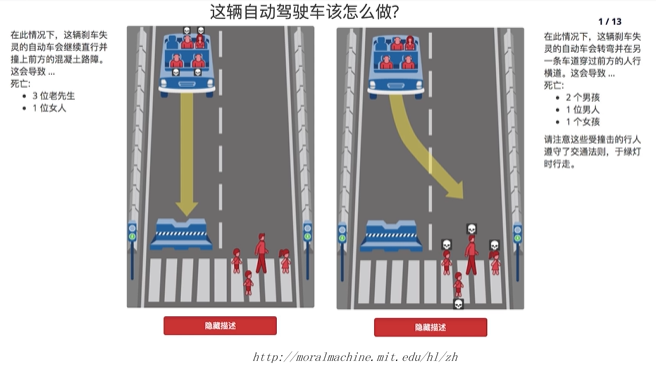

例子4:道德/伦理问题(灰色地带)

1.向AI公司调查结果显示,紧急避险原则上存在一定歧视,比如有老人和青年人时会保全青年人,有男人和女人的情况下会保全男人。

2.自动驾驶应该怎么做,L3标准是在合适时间交还驾驶权给驾驶员,但当面对紧急情况时已为时已晚,此时交还给驾驶员存在甩锅嫌疑,所以L3的问题在于是人背锅还是车背锅。两难问题。

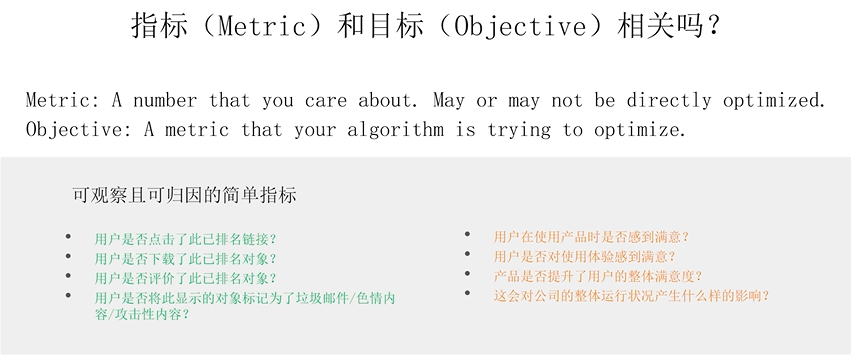

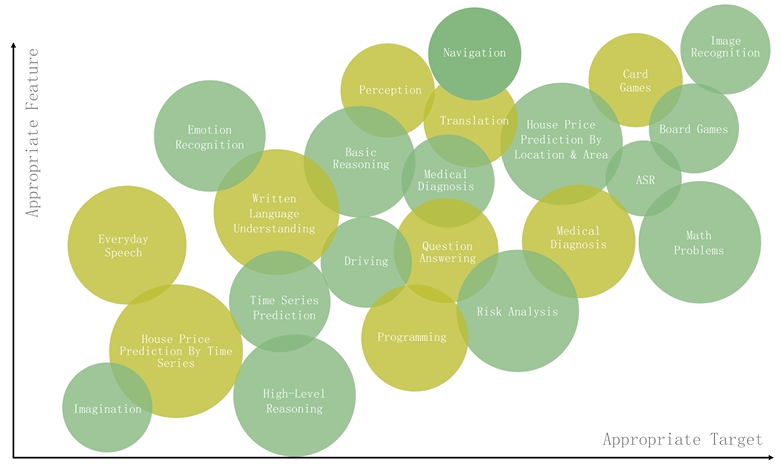

如何确认一个问题是否适合AI解决

- 预测的目标是否可以被量化

- 是否有与目标相关的特征可以被有效的表达

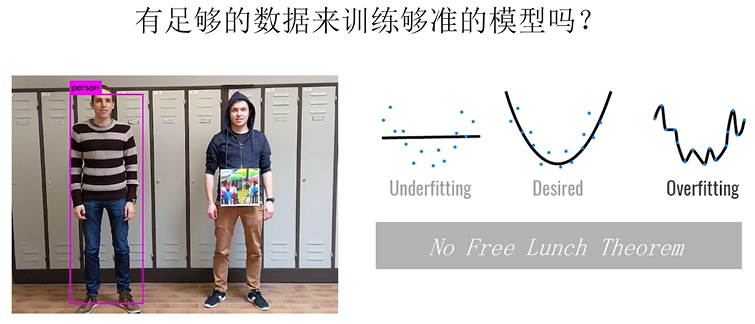

- 是否有足够的数据来训练够准的模型

4.2 人工智能的能与不能:算力

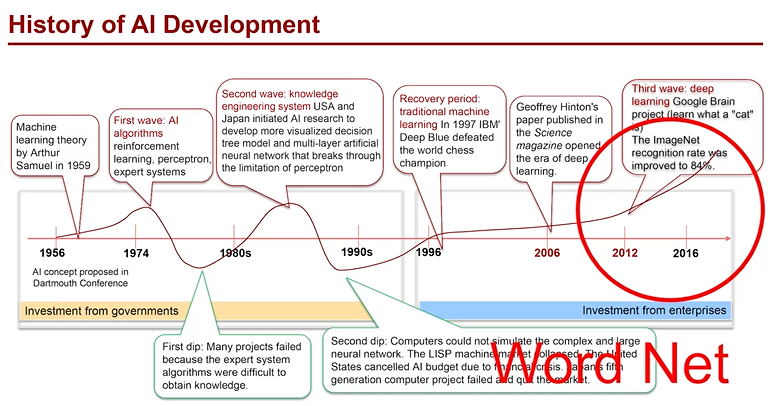

从机器学习到深度学习

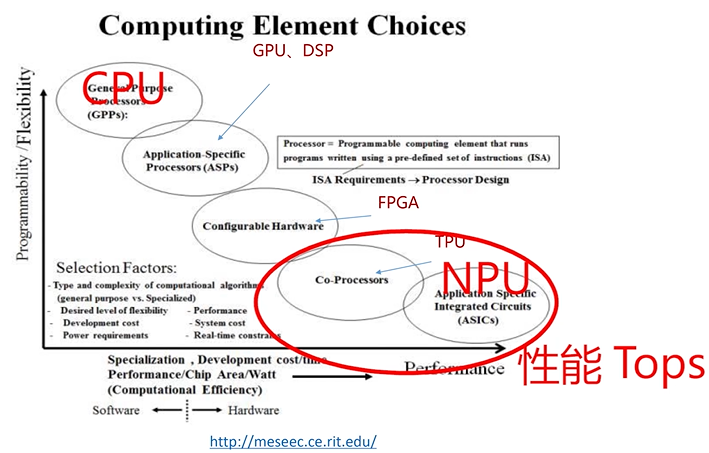

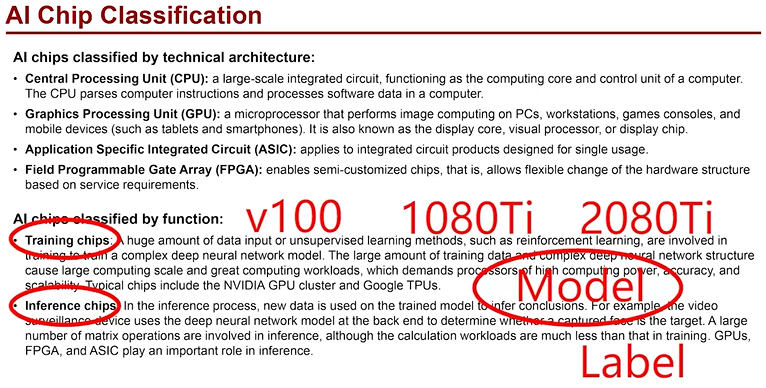

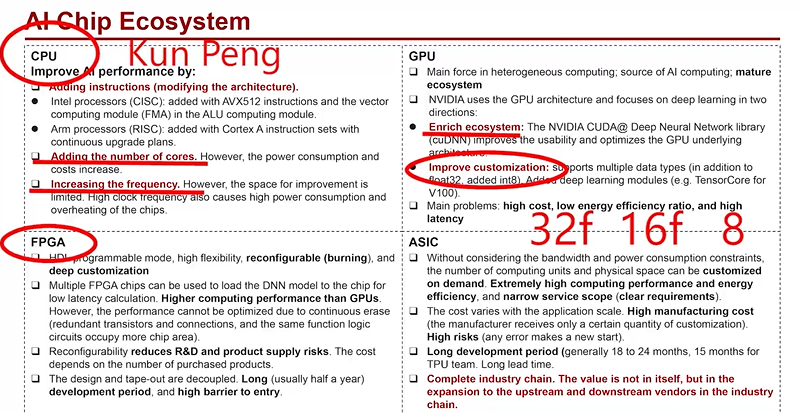

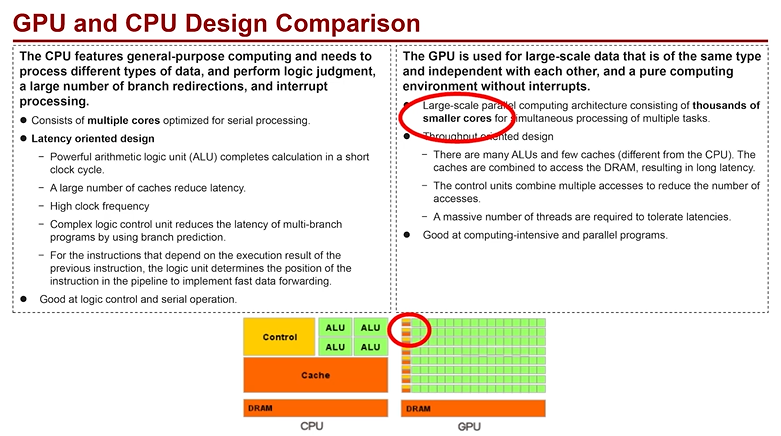

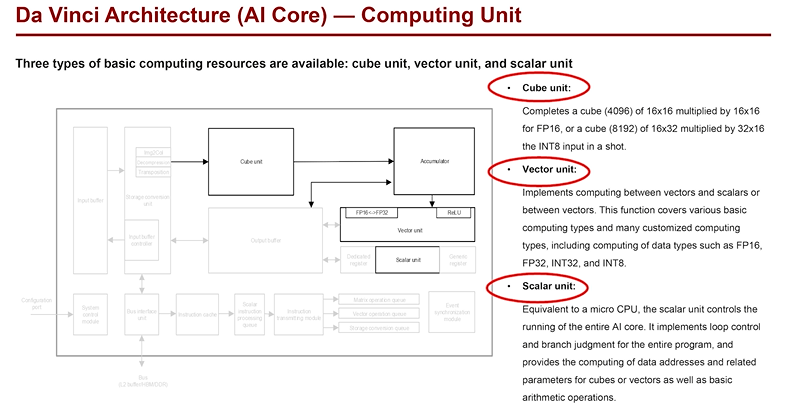

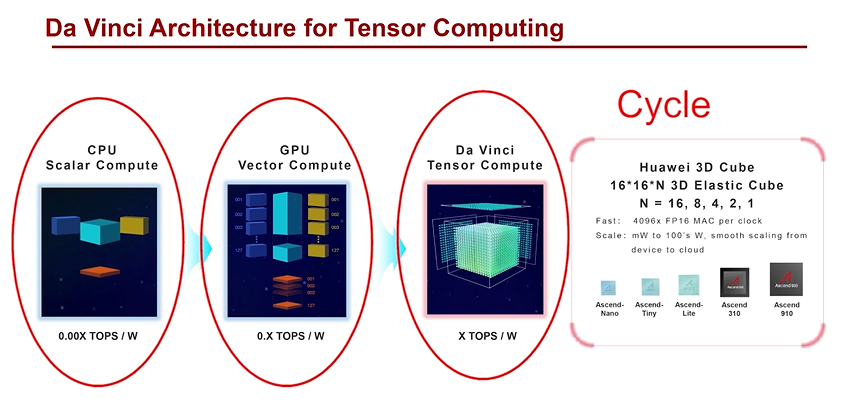

计算架构的迭代:从CPU,GPU到NPU

性能排序:ASIC>FPGA>GPU>CPU

工业落地领域不常见的芯片类型是FPGA,因为同样的性能其成本为GPU3倍以上。

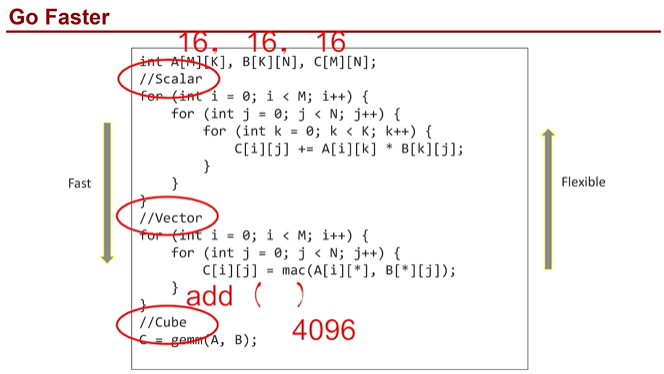

加速矩阵乘:Scalar,Vector与Cube

端边云协同智能落地

学习心得/总结

人工智能的发展存在一定矛盾,形成了其发展瓶颈,阻碍了人工智能进步。算法层面在于预测错误、数据选择造成的误差、人类社会伦理道德。算力层面在于芯片的性能。课程中并没有提到关于大数据层面的问题,但其实又实际存在的,比如数据不足、数据错误等等。总而言之,弱人工智能到强人工智能的路还很漫长,需要我们共同把这路铺好。

浙公网安备 33010602011771号

浙公网安备 33010602011771号