earlying stopping早停法

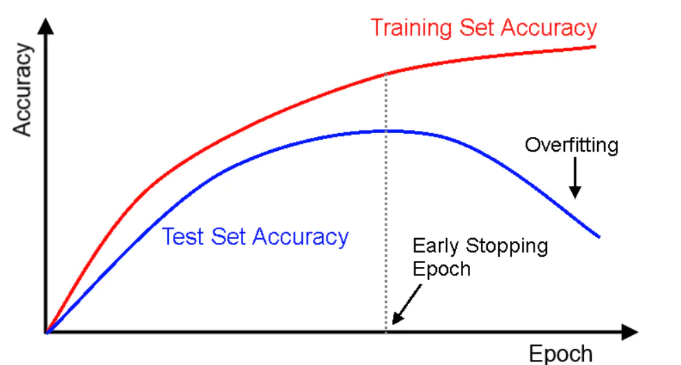

在模型的训练过程中,如果epoch设置过少,网络有可能发生欠拟合;如果epoch设置过多,网络可能发生过拟合。

早停法旨在解决epoch数量需要手动设置的问题。它也可以被视为一种能够避免网络发生过拟合的正则化方法(与L1/L2权重衰减和丢弃法类似)。

根本原因就是因为继续训练会导致测试集上的准确率下降。

那继续训练导致测试准确率下降的原因猜测可能是1. 过拟合 2. 学习率过大导致不收敛

原理

- 将数据分为训练集和验证集

- 每个epoch结束后(或每N个epoch后): 在验证集上获取测试结果,随着epoch的增加,如果在验证集上发现测试误差上升,则停止训练;

- 将停止之后的权重作为网络的最终参数。

浙公网安备 33010602011771号

浙公网安备 33010602011771号