windows系统pyspark部署

安装版本:Java11,python3.9,spark3.3.1,pyspark3.3.1,hadoop3.x

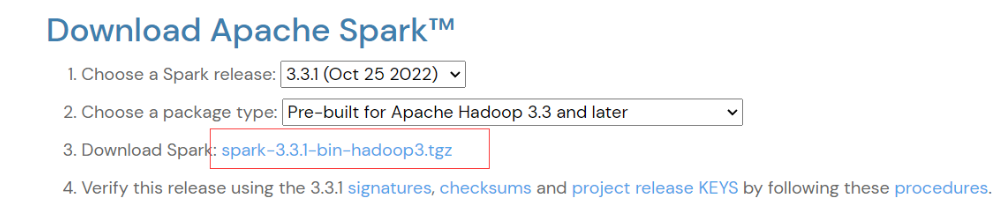

版本说明:python版本需要11.0以下,pyspark版本需要与spark版本保持一致,使用spark-3.3.1-bin-hadoop3.tgz,不用专门下载hadoop3.x

1、Java安装,并配置环境变量

参考:https://www.cnblogs.com/Horizon-asd/p/12602093.html

2、spark以及hadoop配置

(1)可以从官网下载:https://spark.apache.org/downloads.html

也可以从网盘下载:通过网盘分享的文件:spark-3.3.1-bin-hadoop3.zip

链接: https://pan.baidu.com/s/138rpTZ6FIJ6cQ_s85hqNxQ?pwd=7dx6 提取码: 7dx6

--来自百度网盘超级会员v5的分享

下载后解压,文件目录不要包含中文空格特殊字符:D:\program\spark-3.3.1-bin-hadoop3

(2)spark配置环境变量

新建SPARK_HOME

D:\program\spark-3.3.1-bin-hadoop3

Path添加%SPARK_HOME%\bin

(3)hadoop配置环境变量

新建HADOOP_HOME

D:\program\spark-3.3.1-bin-hadoop3

Path添加%HADOOP_HOME%\bin

(4)hadoop需要使用winutil.exe模拟linux下的目录环境

winutils.exe文件获取,下载3.0.0版本:https://github.com/steveloughran/winutils

也可以从从网盘下载,spark-3.3.1-bin-hadoop3文件已经增加了winutils.exe:通过网盘分享的文件:spark-3.3.1-bin-hadoop3.zip

链接: https://pan.baidu.com/s/138rpTZ6FIJ6cQ_s85hqNxQ?pwd=7dx6 提取码: 7dx6

--来自百度网盘超级会员v5的分享

将winutils.exe复制到spark-3.3.1-bin-hadoop3\bin目录下

(5)特殊说明

windows系统用户名全字母,不要包含特殊字符或空格

3、pyspark配置

(1)使用anaconda虚拟pthon环境,python版本需要11.0以下

参考:https://www.cnblogs.com/Horizon-asd/p/18872329

(2)pip安装pyspark==3.3.1,与spark版本保持一致,并安装其它依赖

pip3 install pyspark==3.3.1

pip3 install py4j

pip3 install psutil

pip3 install jieba

4、部署状态测试

(1)在cmd运行 javac -version

(2)在powerShell输入spark-shell

(3)在命令行下python,然后import pyspark 或者 powerShell中输入pyspark

5、Pycharm或Vscode使用配置

解释器选择-->python-->创建的conda虚拟环境python.exe目录

浙公网安备 33010602011771号

浙公网安备 33010602011771号