本地私有化部署大模型(Ollama&vLLM&LMDeploy)

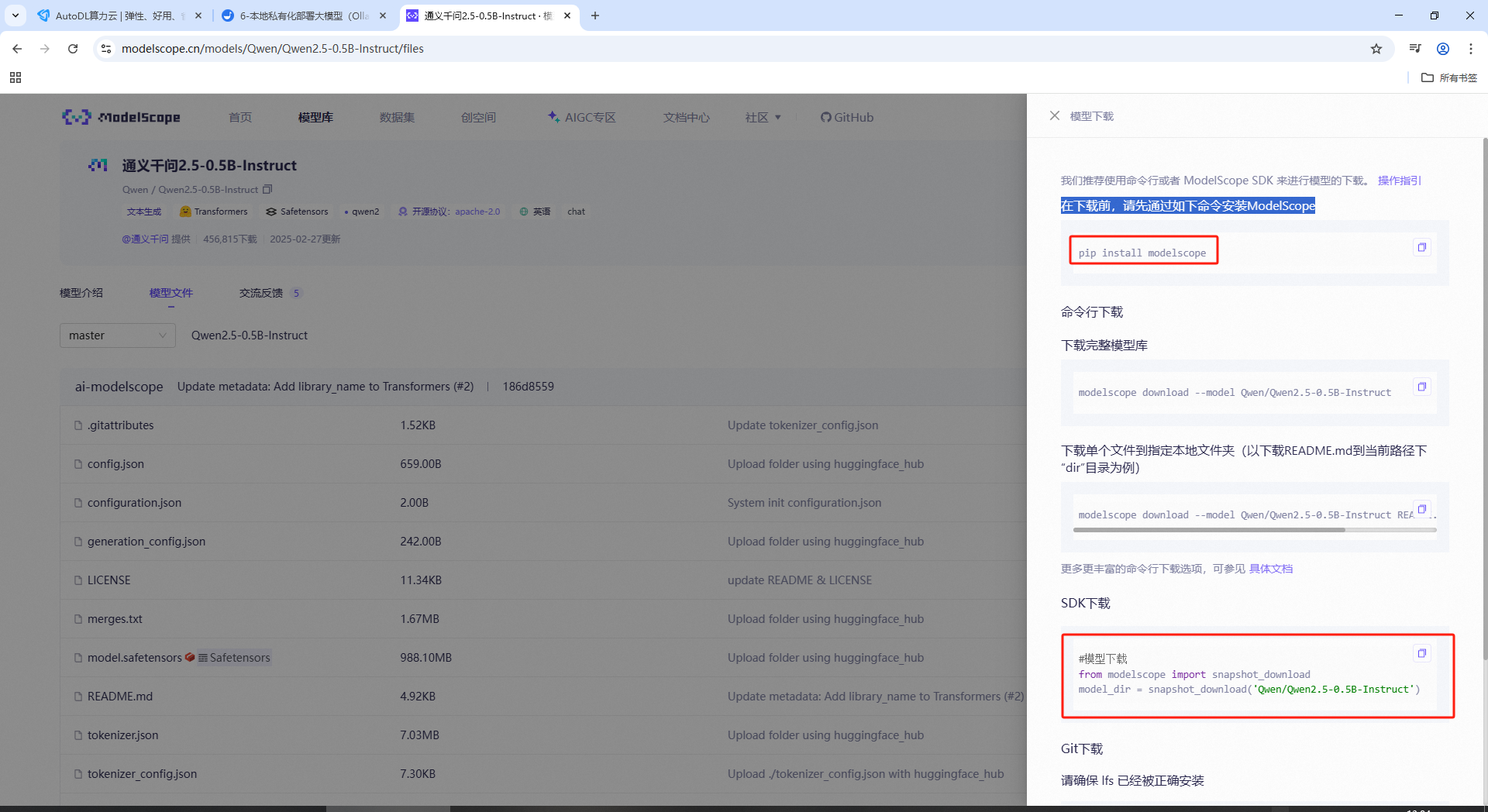

下载Qwen模型

魔塔社区:https://www.modelscope.cn/

模型库中查找 Qwen2.5-0.5B-Instruct

在下载前,请先通过如下命令安装ModelScope

pip install modelscope

使用SDK方式下载模型

download.py

#模型下载

from modelscope import snapshot_download

model_dir = snapshot_download('Qwen/Qwen2.5-0.5B-Instruct',cache_dir='/mnt/workspace/llm/')

执行命令

python download.py

Ollama

官网地址:https://ollama.com/download

curl -fsSL https://ollama.com/install.sh | sh

运行ollama

ollama serve

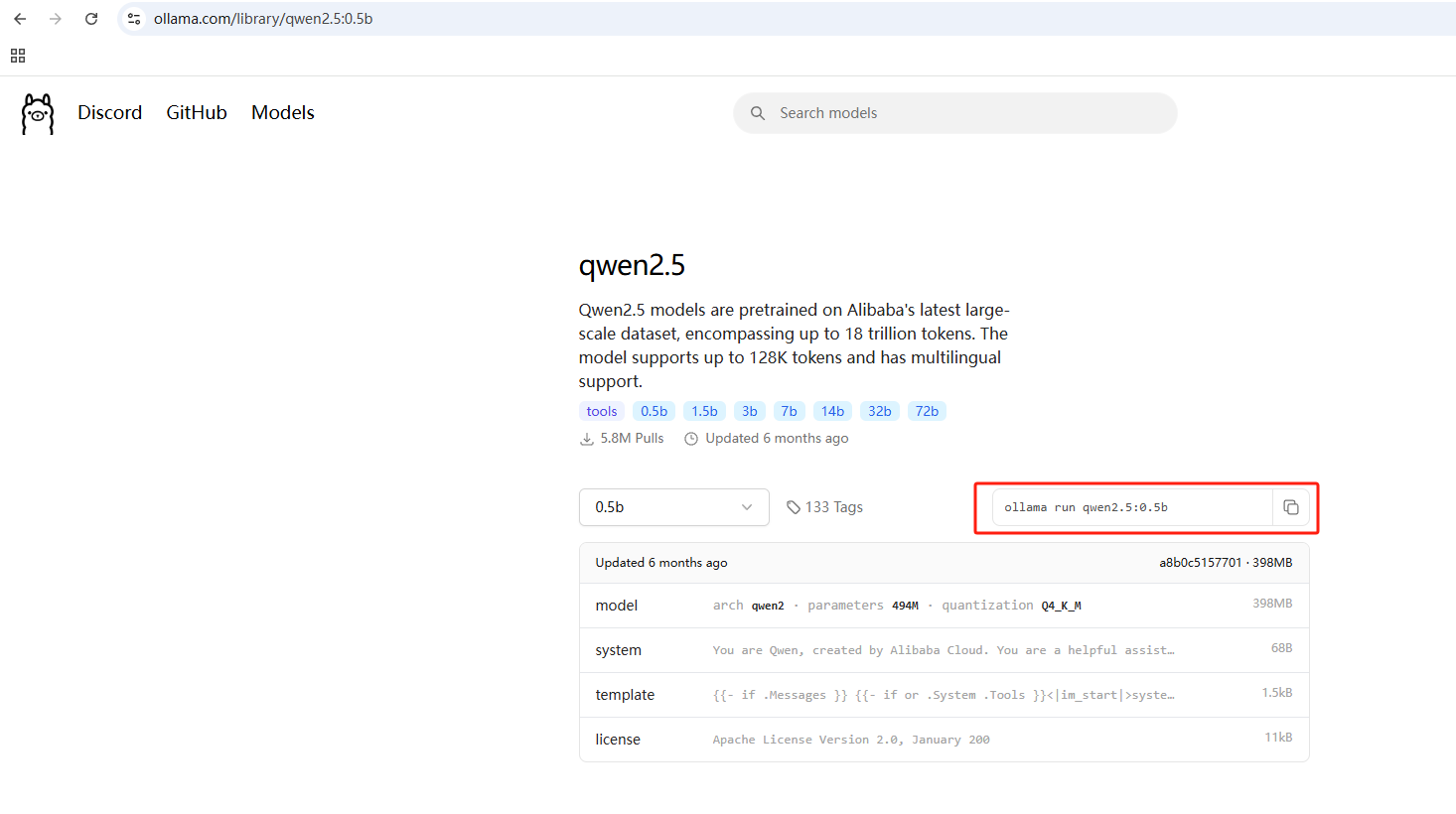

ollama 安装 Qwen

ollama的模型的量化后的GGUF模型

搜索后qwen2.5,可以搜索到模型

#执行命令

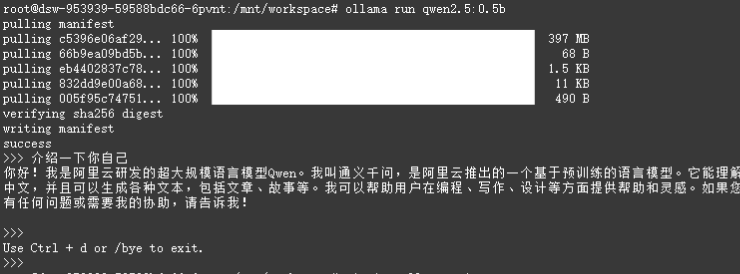

ollama run qwen2.5:0.5b

#查看可运行的模型

ollama list

安装完成后,可以进行对话

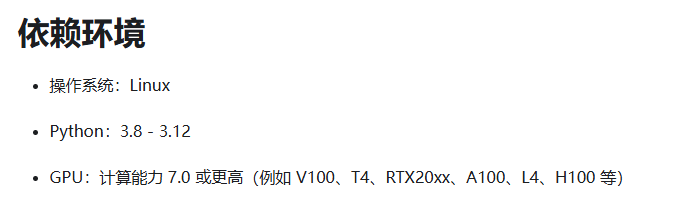

安装VLLM

安装地址:https://vllm.hyper.ai/docs/getting-started/installation

要注意安装的依赖环境

conda create -n vllm python=3.12 -y

conda activate vllm

#安装

pip install vllm

使用本地模型

vllm serve /mnt/workspace/llm/Qwen/Qwen2.5-0.5B-Instruct

LMDeploy模型安装

官网地址:https://lmdeploy.readthedocs.io/zh-cn/latest/get_started/installation.html

conda create -n lmdeploy python=3.8 -y

conda activate lmdeploy

安装模型

pip install lmdeploy

使用本地模型

lmdeploy serve api_server /mnt/workspace/llm/Qwen/Qwen2.5-0.5B-Instruct

浙公网安备 33010602011771号

浙公网安备 33010602011771号