Spark任务调度

不多说,直接上干货!

Spark任务调度

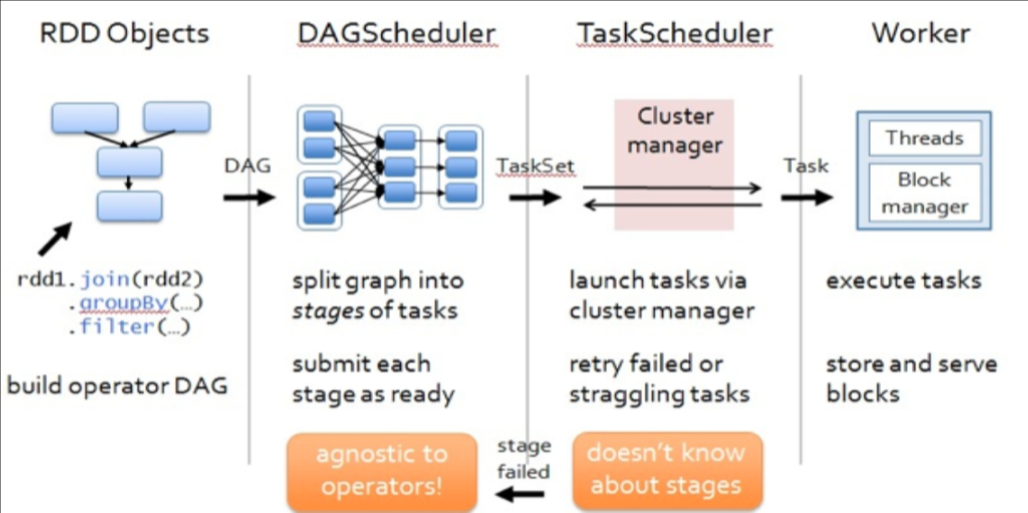

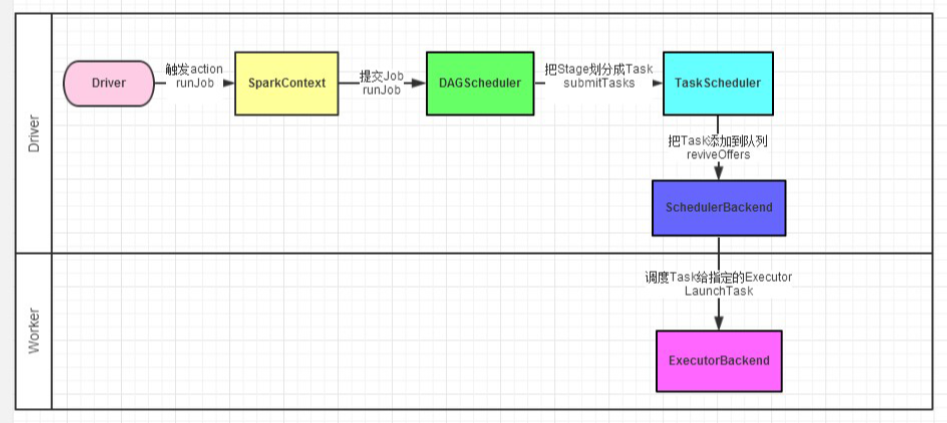

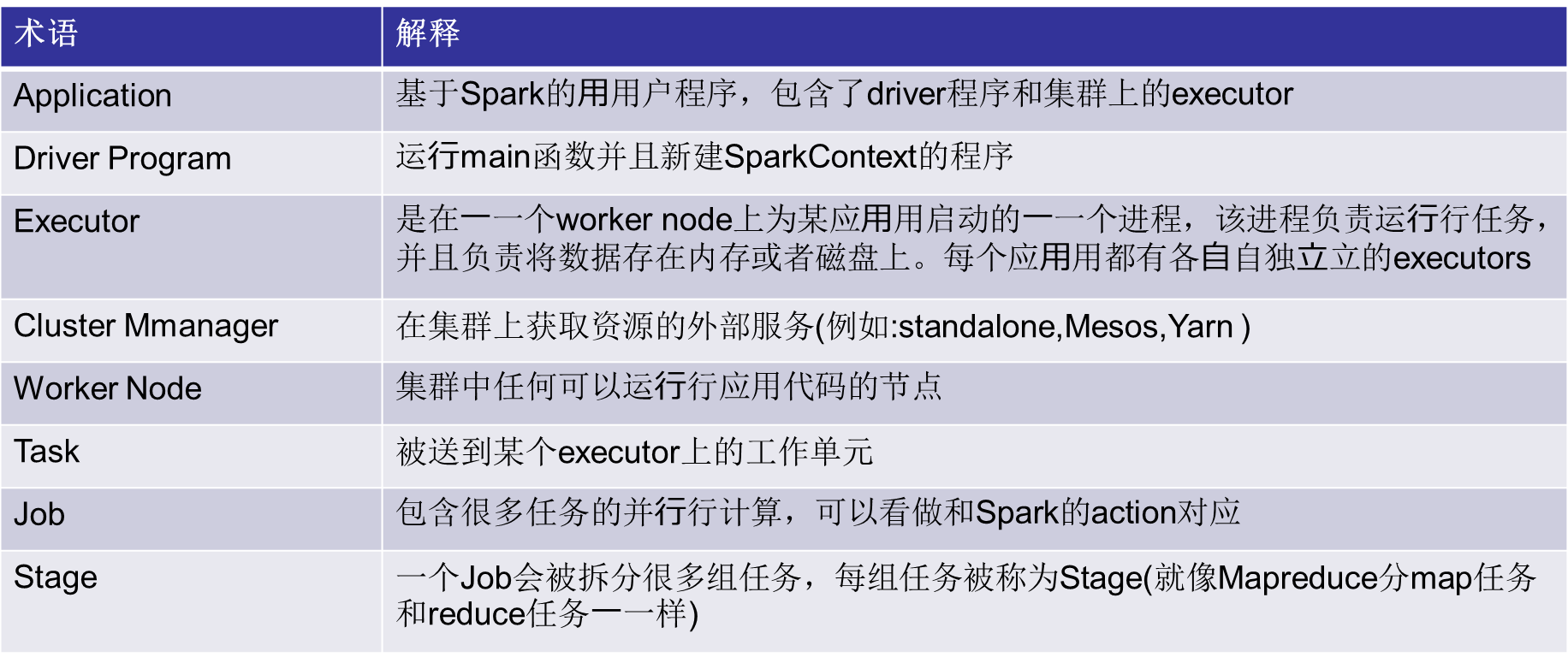

DAGScheduler

构建Stage—碰到shuffle就split

记录哪个RDD 或者Stage 输出被物化

重新提交shuffle 输出丢失的stage

将Taskset 传给底层调度器

本地性策略--- preferredLocations(p)

1.spark-cluster TaskScheduler 2.yarn-cluster YarnClusterScheduler 3.yarn-client YarnClientClusterScheduler

TaskScheduler

为每一个TaskSet 构建一个TaskSetManager 实例管理这个TaskSet 的生命周期

数据本地性决定每个Task 最佳位置(process-local, node-local, rack-local and then and any

提交taskset( 一组task) 到集群运行并监控

推测执行,碰到straggle 任务放到别的节点上重试

出现shuffle 输出lost 要报告fetch failed 错误

ScheduleBacked

实现与底层资源调度系统的交互(YARN,mesos等)

配合TaskScheduler实现具体任务执行所需的资源分配(核心接口receiveOffers)

详细过程

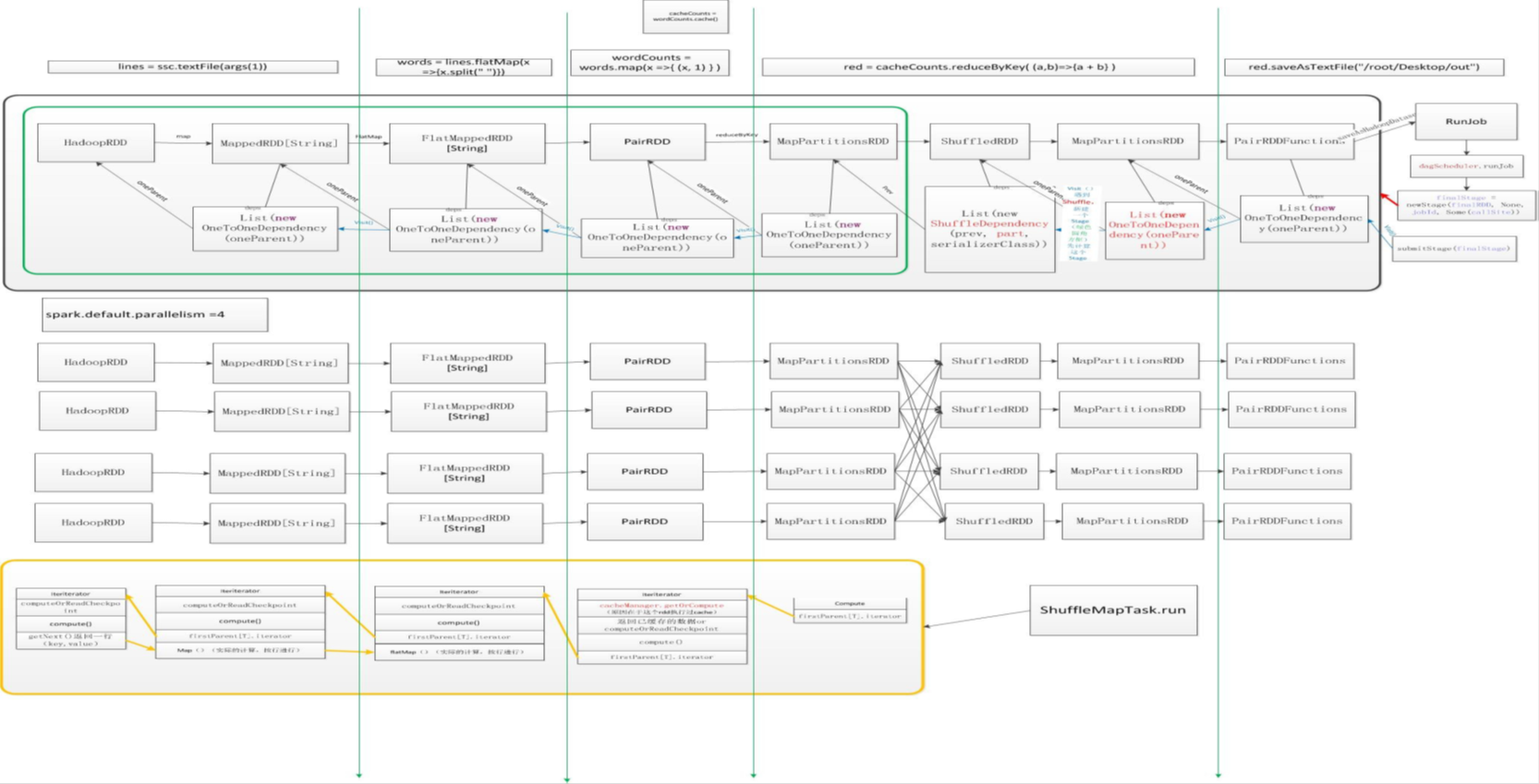

实例分析

val lines = ssc.textFile(args(1)) // 输入

val words = lines.flatMap(x =>x.split(" "))

words.cache() // 缓存

val wordCounts = words.map(x =>(x, 1) )

val red = wordCounts.reduceByKey( (a,b)=>{a + b} , 8)

red.saveAsTextFile(“/root/Desktop/out” , 8) // 行动

作者:大数据和人工智能躺过的坑

出处:http://www.cnblogs.com/zlslch/

本文版权归作者和博客园共有,欢迎转载,但未经作者同意必须保留此段声明,且在文章页面明显位置给出原文链接,否则保留追究法律责任的权利。

如果您认为这篇文章还不错或者有所收获,您可以通过右边的“打赏”功能 打赏我一杯咖啡【物质支持】,也可以点击右下角的【好文要顶】按钮【精神支持】,因为这两种支持都是我继续写作,分享的最大动力!

浙公网安备 33010602011771号

浙公网安备 33010602011771号