【笔记】机器学习基础 - Ch2. PAC Learning Framework

🤔还在慢慢熟悉这种思维方式,希望没有理解错误🙏

2.1 PAC learning model

服从某个分布 \(\cal D\) 抽取样本 \(x\in \cal X\);称一个映射 \(c:\cal X\to Y\) 为概念 concept,称概念的集合 \(\cal C\) 为概念类 concept class。考虑这个概念类 \(\cal C\) 的“可学习性”。

现对于一个固定、未知的待学习目标概念 \(c\in \cal C\),我们有一个假设概念 \(h\) 的集合 hypothesis set \(\cal H\) 以供选择(\(\cal H,C\) 不一定有交 coincide)。以 i.i.d. 抽取样本 \(S=(x _1,\dotsb, x _m)\) 同时得到标签 \((c(x _1),\dotsb, c(x _m))\),据此以某种算法选择 \(h _S\in \cal H\),并用泛化误差 generalization error 刻画 \(h _S\) 相对 \(c\) 的差距:

定义 泛化误差 generalization error

假设概念 \(h\in \cal H\) 相对目标概念 \(c\in \cal C\) 的泛化误差 \(R(h)\),为在给定分布 \(\cal D\) 以 i.i.d. 采样下两者映射结果不相等的概率(错误概率):

但是 \(\cal D, c\) 都是未知的。我们考虑对 \(h\) 计算经验误差 empirical error \(\widehat{R} _S(h)\):

定义 经验误差 empirical error

假设概念 \(h\in \cal H\) 相对目标概念 \(c\in \cal C\) 的经验误差 \(\widehat{R} _S(h)\),为在给定的样本 \(S=(x _1,\dotsb, x _m)\) 下两者映射结果不相等的频率:

可以证明,经验误差 \(\widehat{R} _S(h)\) 当样本在分布 \(\cal D\) 以 i.i.d. 采样下的期望,等于泛化误差 \(R(h)\):

回到概念类 \(\cal C\) 的“可学习性”。

设表示 \(\cal X\) 任一元素的计算开销是 \(O(n)\),表示 \(\cal C\) 任一元素的计算开销是 \(\text{size}(c)\)。对于已知的 \(\cal C\),设计某个算法 \(\cal A\):从 \(\cal D\) 中以 i.i.d. 采样带标签样本集 \(S\),算法 \(\cal A\) 接受 \(S\) 并返回 \(h _S\)。

接下来定义 PAC (Probably Approximately Correct) 学习:

定义 PAC 学习 PAC-learning

称概念集合 concept class \(\cal C\) 是 PAC-learnable,若存在一个算法 \(\cal A\) 和一个多项式函数 \(poly(\cdot,\cdot,\cdot,\cdot)\),使得 \(\forall \epsilon>0, \delta>0, \cal{D}, c\in \cal{C}\),只要满足 \(m\ge poly(1/\epsilon, 1/\delta, n, \text{size}(c))\),就有:

即,只要样本容量 \(m\) 足够大,其喂给算法 \(\cal A\) 得到的 \(h _S\) 就能以至少 \(1-\delta\) 的概率、达到最多只有 \(\epsilon\) 的泛化误差(错误概率),因此称为 probably approximately correct。值得一提的是我们并没有对 \(\cal D\) 做出特别假设。此外若 \(n, \text{size}(c)\) 不需要特别讨论,比如常数,我们可以忽略之。

显然该式等价于 \(\mathbb{P} _{S\sim\cal D ^m}[R(h _S)>\epsilon]\le \delta\)。

有些时候,我们还可以用“泛化界” generalization bound 来等价地表达这种关系,若 \(m\ge poly(1/\epsilon, 1/\delta,\dotsb)\) 可以解得 \(\epsilon\ge poly'(1/m, 1/\delta,\dotsb)\),结合 \(\mathbb{P} _{S\sim\cal D ^m}[R(h _S)>\epsilon]\le \delta\) 可以阐述为:

对于任意 \(\epsilon,\delta>0\),以至少 \(1-\delta\) 的概率,会有 \(R(h _S)\le poly'(1/m, 1/\delta,\dotsb)\)

可见我们以一个上界限制住了 \(h _S\) 的泛化误差。观察该式,往往会发现当 \(m\) 变大,上界随之下降,这符合我们的认知。

例题 Leaning axis-aligned rectangles

二维平面上采样 \(\cal X=\mathbb{R} ^2\),概念类 \(\cal C\) 是平面上所有边平行于坐标轴的矩形,概念 \(c\) 将矩形内部的点都映射为正,其余为负,或者等价认为概念 \(c\) 就是该矩形内的点集。接下来证明 \(\cal C\) 是 PAC-learnable 的。

记目标概念为 \(\rm R\in \cal C\),记采样点落在 \(\rm R\) 内的概率为 \(\mathbb{P}[\rm R]\)。设计算法 \(\cal A\) 为,对于给定样本集 \(S\),\({\rm R} _S\) 为包含且只包含所有正例的最小矩形,显然 \({\rm R} _S\) 包含在 \(\rm R\) 内,则泛化误差 \(R({\rm R} _S)\) 即采样点落在 \(\rm R\) 内、但是不在 \({\rm R} _S\) 内的概率。固定 \(\epsilon>0\),不妨假设 \(\mathbb{P}[\rm R]>\epsilon\)(否则 \(R({\rm R} _S)\le \mathbb{P}[\rm R]\le \epsilon\) 就没意义了)。

接下来,以 \(\rm R\) 的四条边向内做四个子矩形 \(r _i,i\in [4]\),且满足 \(\mathbb{P}[r _i]= \epsilon/4\)。显然若 \({\rm R} _S\) 与四个子矩形都有交,则 \(R({\rm R} _S)\le \mathbb{P}[\cup _i r _i]\le \sum _i \mathbb{P}[r _i]=\epsilon\);于是其逆否命题成立:若 \(R({\rm R} _S)>\epsilon\),则 \({\rm R} _S\) 至少与一个子矩形无交,用概率刻画事件关系😲:

令 \(\mathbb{P} _{S\sim \mathcal{D}^m}[{R}[{\rm R} _S]>\epsilon]\leq 4\exp \left( -m\epsilon /4 \right)\le \delta\),解得 \(m\ge\frac{4}{\epsilon}\ln \frac{4}{\delta}\),故得证。

另外还可以用泛化界表达:结合该式和 \(\epsilon\ge \frac{4}{m}\ln \frac{4}{\delta}\),可阐述为:以至少 \(1-\delta\) 的概率,会有 \({R}[{\rm R} _S]\le \frac{4}{m}\ln \frac{4}{\delta}\)

2.2 Guarantees for finite hypothesis sets - consistent case

称假设 \(h _S\) 对带标签样本 \(S\) 是一致的 consistent,若其在 \(S\) 上的经验误差为零。下文中,我们为对任意 \(S\) 总能从有限假设集合 \(\cal H\) 中找到一致假设 \(h _S\) 的情形(称之为一致情况 consistent case),提出一个一般的样本容量下界。此外,我们还假定 \(c\in \cal H\)(或许有些情况下 \(\forall c\in \cal C, c \notin\cal H\) 也能存在一致假设,但是还不如就假定 \(c\in \cal H\))。

定理 Learning bound - finite \(\cal H\), consistent case

\(\cal H\) 是映射 \(\cal X\to Y\) 的有限集合,若算法 \(\cal A\) 对于任意目标概念 \(c\in \cal H\),总能根据以 i.i.d. 获得的 \(S\) 返回一个一致假设 consistent hypothesis \(h _S: \widehat{R} _S(h _S)=0\),那就是 PAC-learnable 的:\(\forall \epsilon, \delta>0, \mathbb{P} _{S\sim\cal D ^m}[R(h _S)\le\epsilon]\ge 1-\delta\) 成立,若:

也可以用泛化界表达:\(\forall \epsilon, \delta>0\),以至少 \(1-\delta\) 的概率,有:

证明如下,定义 \(\mathcal{H}_{\epsilon}=\left\{ h\in \mathcal{H}:R(h) >\epsilon \right\}\),则 \(h\in \mathcal{H}_{\epsilon}\) 为一致假设、即采样点均不出错的概率 \(\le(1-\epsilon) ^m\);且事件 “\({\cal H} _\epsilon\) 存在一致假设” 的概率为:

现在对于根据 \(S\) 学到的一致假设 \(h _S\),若有 \(h _S\in \mathcal{H}_{\epsilon}\),则事件 “\({\cal H} _\epsilon\) 存在一致假设” 成立,还是用概率刻画:\(\mathbb{P}[ h_S\in \mathcal{H}_{\epsilon}]=\mathbb{P} _{S\sim\cal D ^m}[R(h _S)>\epsilon] \le \mathbb{P}[ \exists h\in \mathcal{H}_{\epsilon}:\widehat{R}_S(h)=0 ] \le |\mathcal{H}|e^{-m\epsilon}\le \delta\),解不等式得证。

例题 Conjunction of Boolean literals

直接代入定理即可。

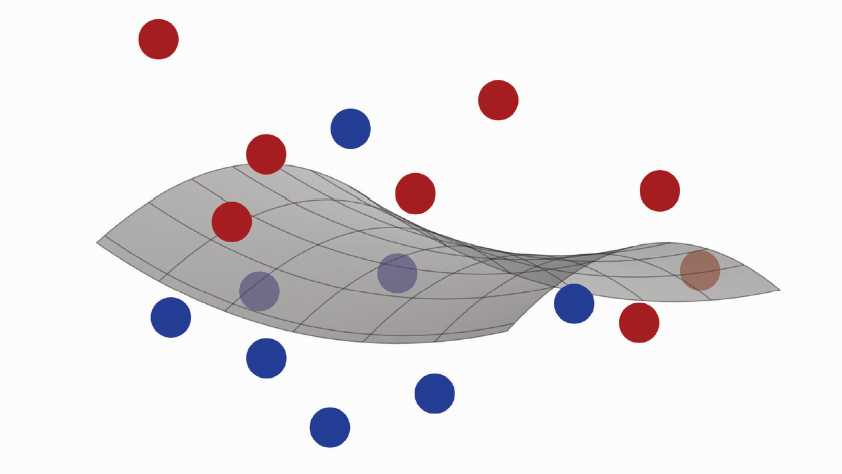

2.3 Guarantees for finite hypothesis sets - inconsistent case

大多数情况下,对于样本集 \(S\) 从 \(\cal H\) 里找不到一致假设,下面就有限假设集合、不一致情况给出保证。

定理 Hoeffding's inequality

\(X _1, \dotsb, X _m\) 为独立随机变量,\(X _i \in [a _i, b _i]\);记 \(S _m=\sum _{i=1}^m X _i\)。对任意 \(\epsilon>0\),下述不等式成立:

根据此定理,对于 \(h:X\to \{0,1\}\) 的情形,令上述 \(X _i=1_{h(x _i)=c(x _i)}/m\in [0, 1/m]\),有 \(S _m=\widehat{R} _S(h), \mathbb{E}[S _m]= R(h)\),得:

推论 固定 \(\epsilon>0\),对任意假设 \(h:X\to \{0, 1\}\),有:

令等式右边等于 \(\delta\),得到对单独一个假设的界:

推论 固定 \(h:X\to \{0,1\}\),对任意 \(\delta>0\),以至少 \(1-\delta\) 的概率,有:

应当指出,这个推论是以固定 \(h\) 为前提的(定理 “经验误差的期望等于泛化误差” 亦是如此);然而在实际应用中我们手头的 \(h _S\) 是一个随 \(S\) 而变化的随机变量,当我们倒回去查看推导时,会发现对于 \(S _m=\widehat{R} _S(h _S)\),\(\mathbb{E}[S _m]\) 通常不等于 \(R(h _S)\),因为前者依然是一个常数,后者是一个随机变量。

因此我们要做的是为整个假设集合 \(\cal H\) 给出一个保证:

定理 Learning bound - finite \(\cal H\), inconsistent case

有限假设集合 \(\cal H\)。对任意 \(\delta>0\),以至少 \(1-\delta\) 的概率,有:

证明:记 \({\cal H}=\{h _1, \dotsb, h _{|\cal H|}\}\),有:

引入 \(\delta\) 得证。

考察 \(m, |{\cal H}|\),相比一致情况为一致假设 \(h _S\) 找到的泛化界 \(R(h _S)\le O(\frac{\log|{\cal H}|}{m})\),非一致情况下为 \(\cal H\) 里的任一假设 \(h\) 找到的泛化界(两者都以 \(1-\delta\) 的概率):

差不多可以看出泛化界的一般形式了,无非就是 \(R(h)\le \widehat{R} _S(h) +\epsilon\),\(\epsilon\) 被我们解出来关于 \((1/m, 1/\delta,\log|\cal H|,\dotsb)\) 的函数,而一致情况的经验误差为零;\(\log|\cal H|\) 可理解为表示 \(\cal H\) 需要的比特量,对应 \(\text{size}(c)\) 概念。

对于非一致情况,\(m\uparrow\) 带来的压低上界被打了个开方的折扣,也就是需要平方倍数的提升才能达到和一致情况一样的效果。另外,从该式中也可以看到一个关于 \(\widehat{R} _S(h)\) 和 \(|{\cal H}|\) 的 trade-off:增大假设集合的大小,可能可以减小经验误差,但是会受到后者的惩罚。对于经验误差基本没差别的情况,我们倾向于减小假设集合的大小。这可以视作 Occam's Razor principle 的一个例子。

2.4 Generalities

关于确定情景和随机情景 Deterministic versus stochastic scenarios

上文中以及大多时候我们只考虑标签是通过某个确定映射 \(\cal X\to Y\) 得到的,称为确定情景 deterministic scenario。但是实际情况中往往 \(y\) 也服从一个分布,称之为随机情景 stochastic scenario。

形式化地说,将 \(\cal D\) 定义在 \(\cal X\times Y\) 上,对于从 \(\cal D\) 以 i.i.d. 抽取的样本 \(S=((x _1, y _1), \dotsb, (x _m, y _m))\),定义泛化误差为

随机情景下,我们提出 “不可知 PAC 学习”(Agnostic PAC-learning)概念(看起来它继承了上面总结的泛化界一般形式)

定义 Agnostic PAC-learning

假设集合 \(\cal H\);称 \(\cal A\) 为 PAC 学习算法,若存在一个多项式函数 \(poly(\cdot,\cdot,\cdot,\cdot)\),使得任意 \(\epsilon>0, \delta>0\),任意 \(\cal X\times Y\) 上的 \(\cal{D}\),只要满足 \(m\ge poly(1/\epsilon, 1/\delta, n, \text{size}(c))\),就有:

贝叶斯误差和噪声 Bayes error and noise

对于确定情景,那个目标概念就可以使 \(R(h)=0\);而对于随机情景我们用所有可能情况的最小值来定义:

定义 Bayes error

对于 \(\cal X\times Y\) 上的分布 \(\cal D\),称其贝叶斯误差 \(R ^*\) 为由可测函数类 \(h:\cal X\to Y\) 产生的误差下界:\(R ^*=\inf _{h\ mearsurable} R(h)\)

一般来说对于随机情景有 \(R ^*\ne 0\)

称满足 \(R(h)=R ^*\) 的假设 \(h _\text{Bayes}\) 为贝叶斯假设或贝叶斯分类器。当然,以二分类为例,它也可以定义为:\(\forall x,h _\text{Bayes}(x)=\arg \max _{y\in \{0,1\}}\mathbb{P}[y|x]\);对应地,其错误概率、也是所有假设的最小错误概率为 \(\min\{\mathbb{P}[0|x],\mathbb{P}[1|x]\}\),据此定义贝叶斯噪声:

定义 Bayes noise

对于 \(\cal X\times Y\) 上的分布 \(\cal D\),称其在 \(x\in \cal X\) 上的贝叶斯噪声为 \(noise(x)=\min\{\mathbb{P}[0|x],\mathbb{P}[1|x]\}\);而 \(\cal D\) 上的 \(\text{noise}\) 定义为 \(\mathbb{E}[noise(x)]\)。

显然 \(\text{noise}=\mathbb{E}[noise(x)]=R ^*\),这个量刻画了学习的难度。

Exercises

Two-Oracle Variant of PAC model

题解应该有不少有待斟酌的地方;其实现在也不确定有没有理解对题目,当然答案根据自己的理解也稍有改动,不保证正确。

考虑二分类问题。标准 PAC 模型认为 \(\cal X\) 采样自分布 \(\cal D\) 并通过某个映射 \(c:\cal X\to \{0,1\}\)。引入其 two-oracle 变种:认为所有正例均采样自 \(\cal D _+\),负例采样自 \(\cal D _-\);假设两者概率分别为 \(p, 1-p\)(至少我是这么理解的);定义对应的 PAC 算法为以至少 \(1-\delta\) 的概率,返回的假设 \(h\) 同时满足 \(\Pr _{x\sim \cal D _+}[h(x)\ne 1]\le \epsilon, \Pr _{x\sim \cal D _-}[h(x)\ne 0]\le \epsilon\)。下文记 \(error _{\cal D}(h)=\Pr _{x\sim \cal D}[h(x)\ne c(x)]\)

试证明,对于概念类 \(\cal C\) 和假设集 \(\cal H\),\(\cal C\) 对于 \(\cal H\) 在标准 PAC 模型是 efficiently PAC-learnable 的,当且仅当 \(\cal C\) 对于 \(\cal H\cup\{h _0, h _1\}\) 在 two-oracle 模型是 efficiently PAC-learnable 的。其中 \(h _{0/1}\) 表示恒映射到 0/1 的函数。

证明:

必要性,前者成立,取分布 \({\cal D=pD _+ }+(1-p)\cal D _-\),不妨假设 \(p\le 1-p\),选取 \(\delta\) 使得 \(\Pr[error _{\cal D}(h)\le p\epsilon]\ge 1-\delta\),于是以至少 \(1-\delta\) 的概率,有泛化误差 \(error _{\cal D}(h)=p\cdot error _{{\cal D} _+}(h)+(1-p)\cdot error _{{\cal D} _-}(h)\le p\epsilon\),于是 \(error _{{\cal D} _+}(h)\le \epsilon, error _{{\cal D} _-}(h)\le \epsilon\) 均成立;

充分性,后者成立,按题目的意思是当 \(m\) “足够大” 时:在两个分布各自抽取的样本量分别应大等于 \(m _+, m _-\),会以至少 \(1-\delta\) 的概率,有 \(error _{{\cal D} _+}(h)\le \epsilon, error _{{\cal D} _-}(h)\le \epsilon\),那么对于标准模型的分布 \(\cal D=pD _+ +(1-p) D _-\),有 \(error _{\cal D}=p\cdot error _{{\cal D} _+}(h)+ (1-p)\cdot error _{{\cal D} _-}(h)\le \epsilon(p+1-p)=\epsilon\),从而成立

那么这个 “足够大” 是多大,才能满足在两个分布各自抽取的样本量都足够多呢?假设 \(S _m\) 等于抽取 \(m\) 个样本时正例(概率 \(p\))的个数,根据 Chernoff bounds 有 \(\Pr [S_m\le (1-\alpha)mp]\le \exp(-mp\alpha^2/2)\),为了保证 \(S _m\ge m _+\),令 \(\alpha=1/2,m=2m _+/p\),得到 \(\Pr [S _m\le m _+]\le \exp(-m _+/4)\) 并令其小等于 \(\delta/2\)(这么取是为了对负例同理且后续相加),解得 \(m\ge \min\{\frac{2m _+}{p},\frac{8}{\epsilon}\log\frac{2}{\delta}\}\)

于是当 \(m\ge \min\{\frac{2m _+}{p},\frac{2m _-}{p},\frac{8}{\epsilon}\log\frac{2}{\delta}\}\) 时,\(\Pr [\{S _m\le m _+\}\vee \{m-S_m\le m _-\}]\le \Pr [\{S _m\le m _+\}]+\Pr [\{m-S _m\le m _-\}]=\delta\),即以至少 \(1-\delta\) 的概率使 \(m\) “足够大”,从而又以至少 \(1-\delta\) 的概率使得误差足够小,这么看来概率下界是 \((1-\delta) ^2\) 吗?那好像还是差了点意思,不太懂

至于为什么题目还提供了 \(\{h _0, h _1\}\):在题解里提到若 \(p<\epsilon\) 或 \(1-p<\epsilon\) 时取常函数就能使得误差小等于 \(\epsilon\),不过不懂是否有必要考虑这个...

the Probably Approximately Correct learning framework

the Probably Approximately Correct learning framework

浙公网安备 33010602011771号

浙公网安备 33010602011771号