神经网络

图像识别

建立模型

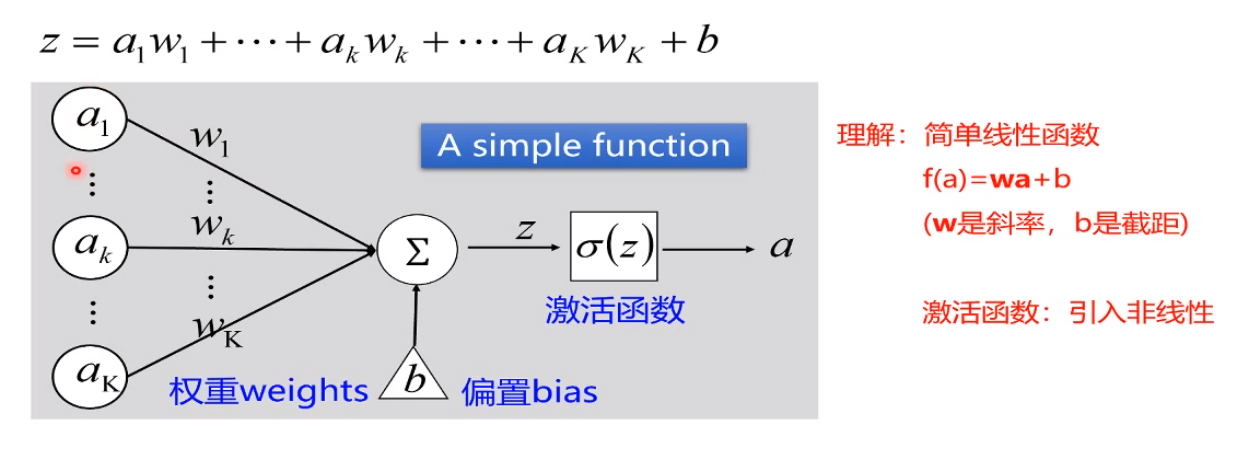

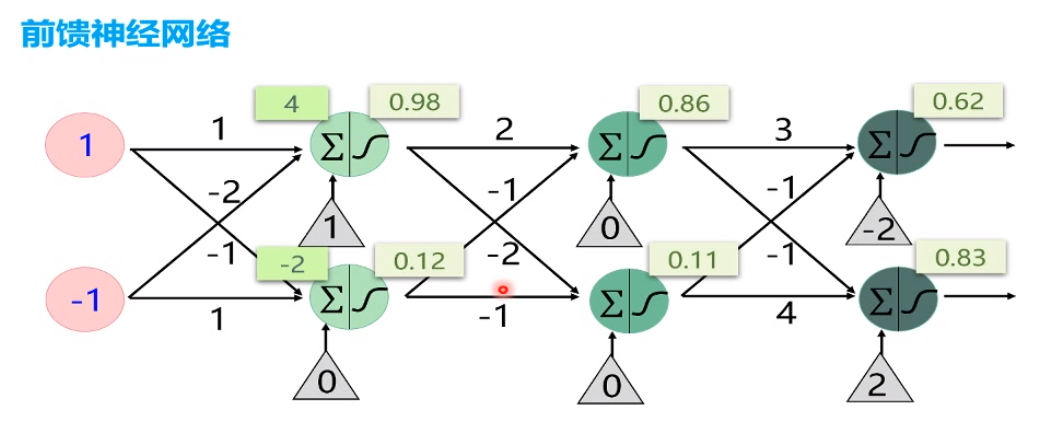

前馈神经网络

只能正向不能反向,即参数*权重 + 偏置--->结果 * 激活函数-》 值

输出层

softmax函数计算损失的效果简单,便于计算

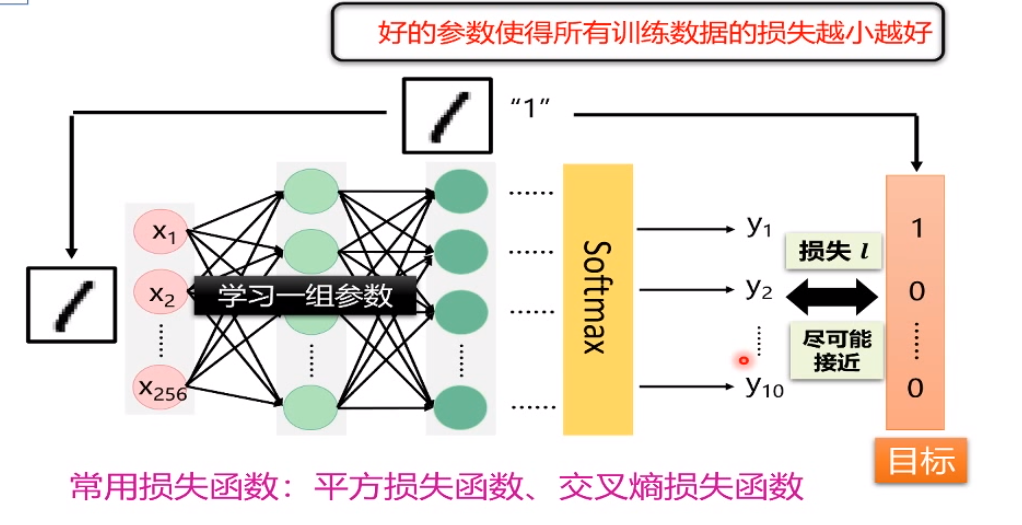

损失函数

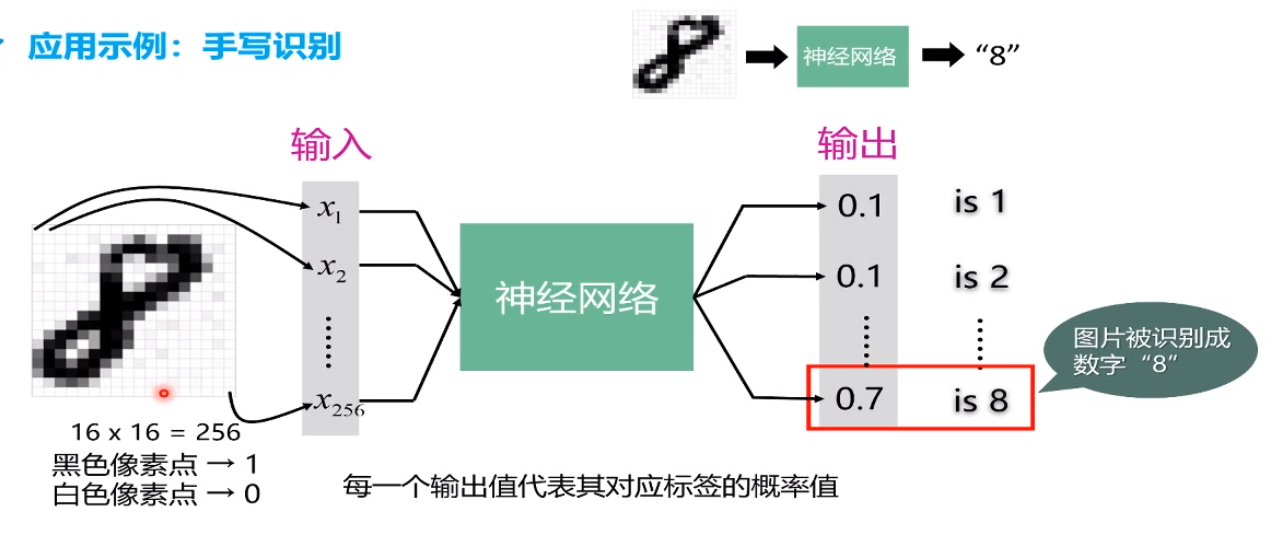

手写识别

- 首先图像进行二值化,即用flatten平展开

![image]()

损失函数

损失函数干嘛?即用于将概率计算出来,把分辨的结果为[0,1]

常用的损失函数

参数学习

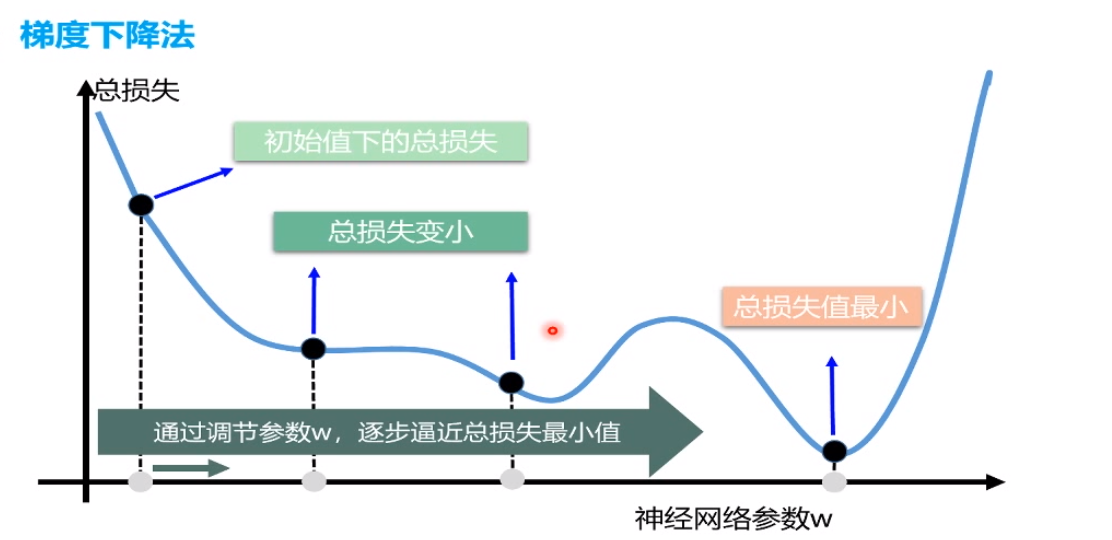

梯度下降

如何调节参数呢?

如图 w' = w - &L/&w Loss为损失,w为权重,w'为新权重

当前损失对于每个权重的偏导数*步长g

步长g为学习率,对于归一化的图片,我选择0.1或更小,g的设置属于调参

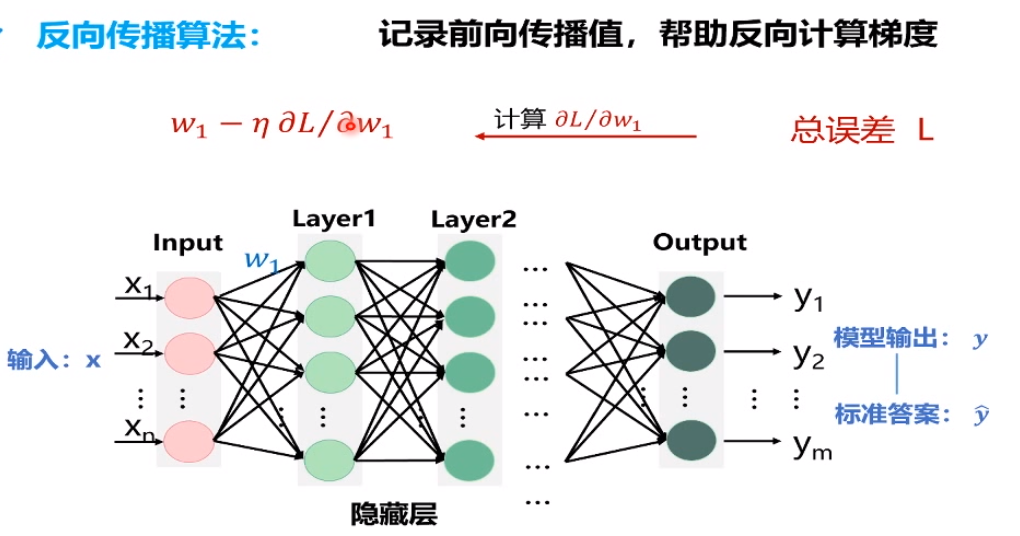

反向传播

反向传播需要进一步读文章

原理是从最后一层全连接层得到的loss,loss只是临时记录,去反向计算倒数第二层较好的参数,然后慢慢向前传播去进行优化。

全连接神经网络

模型的结构不够灵活

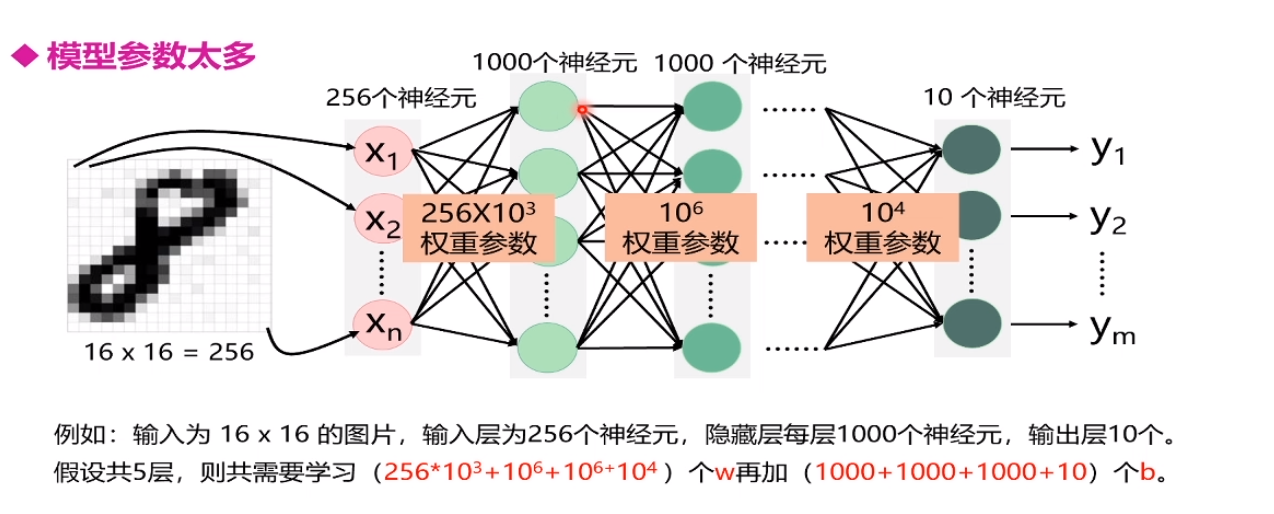

16 16 =256

如果图片大小变化,

模型的参数太多了

需要掌握权重个数的计算:

全连接神经网络的权重参数存在于 层与层之间 即 ab

偏执参数 存在于 层结点上 即b

总计; (ab+b)n-1 这不是公式

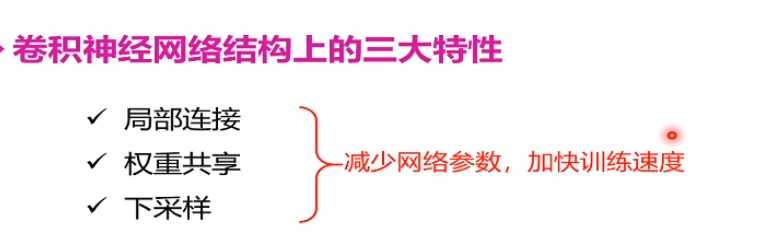

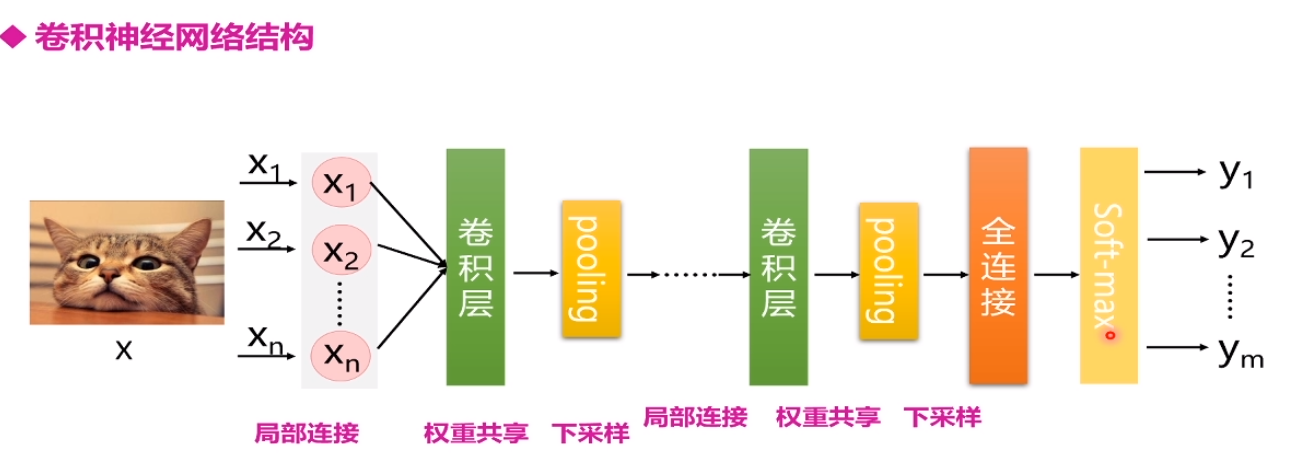

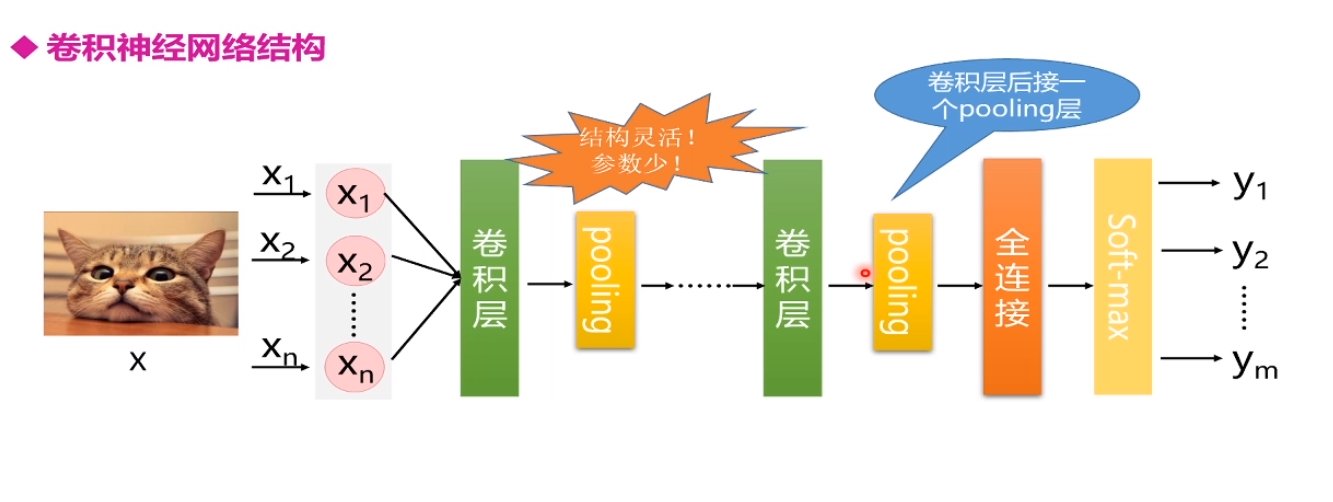

卷积神经网络

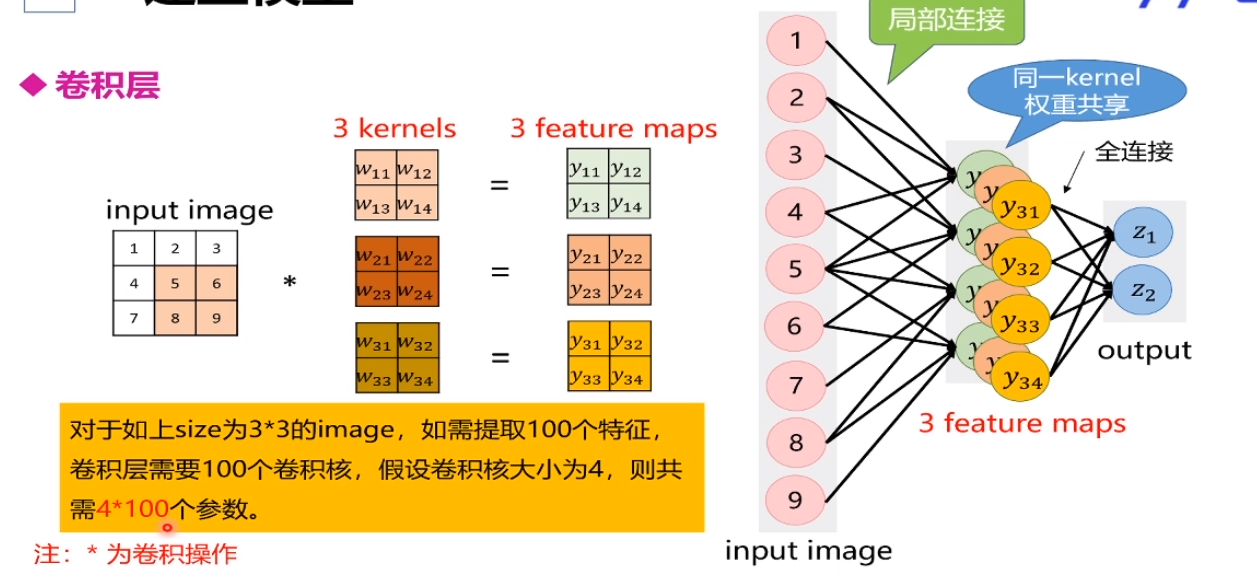

减少参数

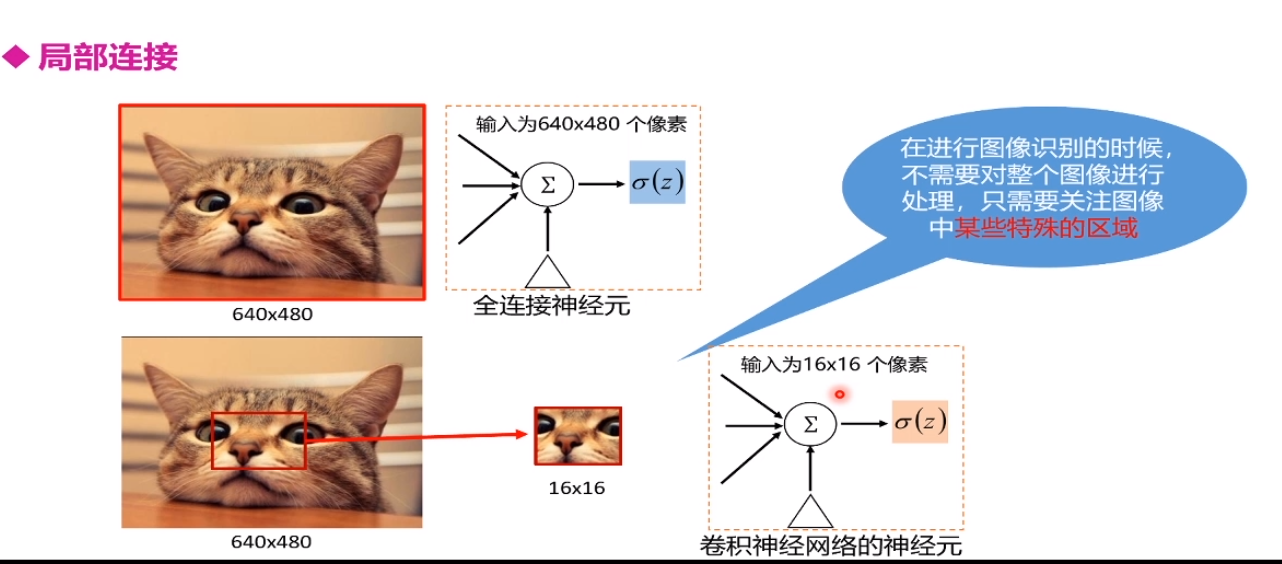

局部连接

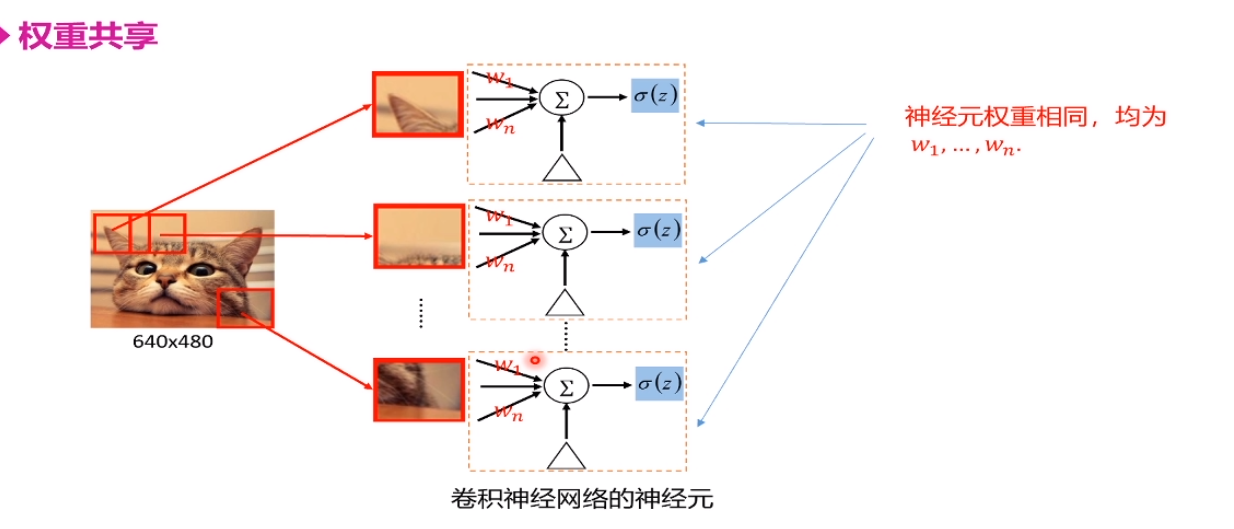

权值共享

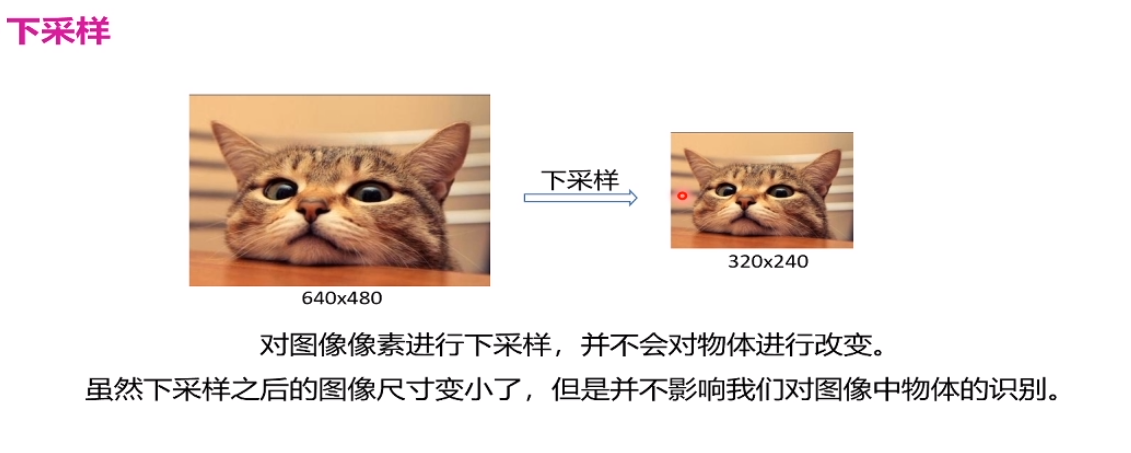

下采样

下采样不易变化过大

网络结构

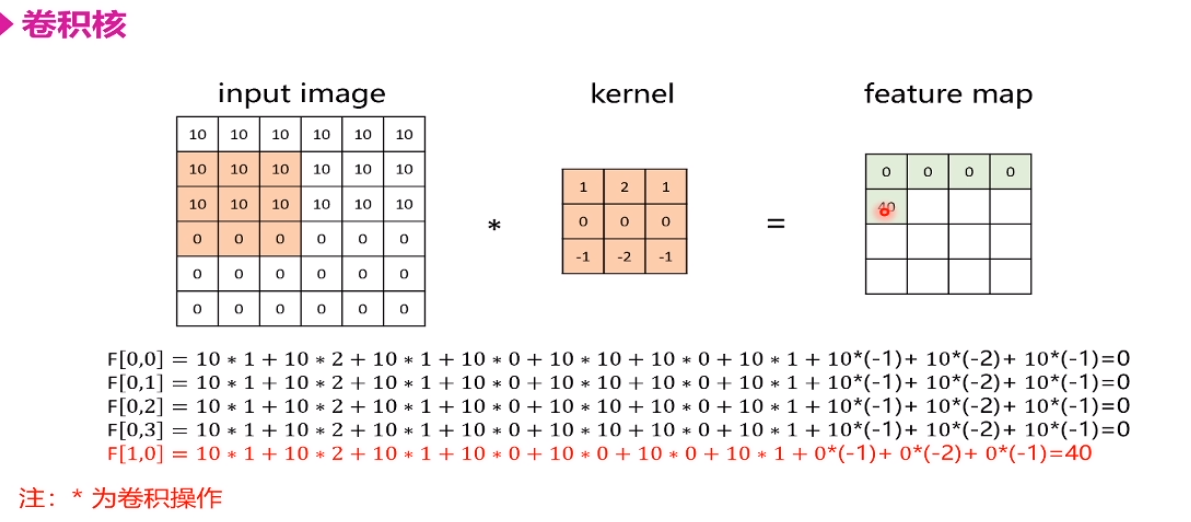

卷积核

我们需要去学习 kernel的值,由于w过多,我们通常忽略了每个卷积核的偏置

掌握计算 参数*卷积核的size

主要是从 特征图去计算特征图,最终接全连接,目的是分类别

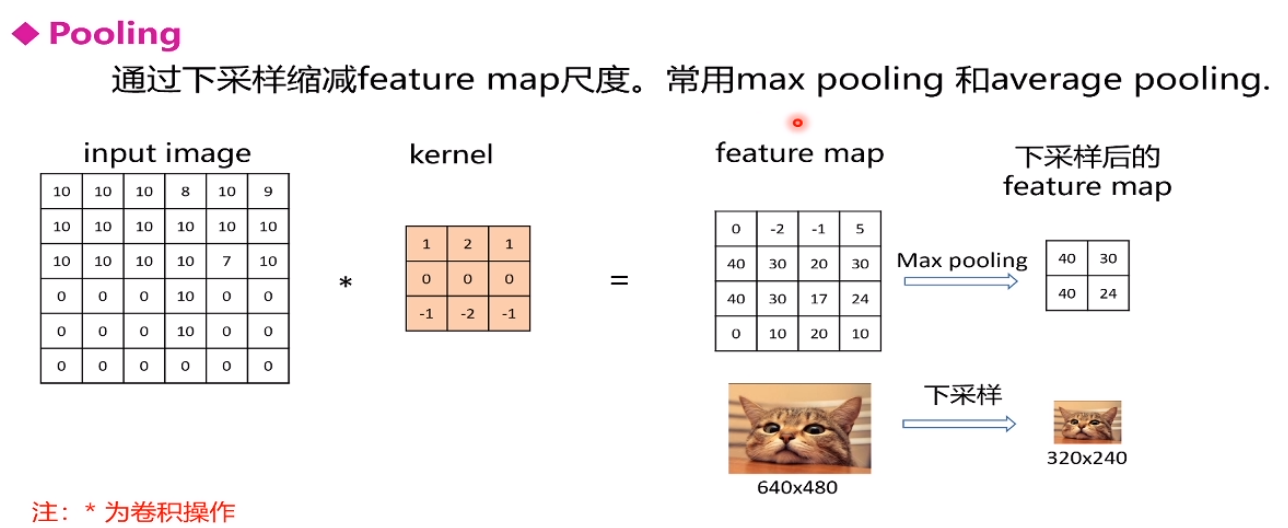

pooling

通过下采样来减少图片 最大采样与平均采样

通道数不变、变成一半或更小,减少参数

结构

LeNet-5经典模型

首先 输入32 * 32 * 1的灰度图——使用551的6个卷积核

浙公网安备 33010602011771号

浙公网安备 33010602011771号