Hadoop的核心由3个部分组成:

HDFS: Hadoop Distributed File System,分布式文件系统,hdfs还可以再细分为NameNode、SecondaryNameNode、DataNode。

YARN: Yet Another Resource Negotiator,资源管理调度系统

Mapreduce:分布式运算框架

1、软件与环境

环境:CentOS-7-x86_64-Minimal-1810

hadoop版本:jdk-8u221-linux-x64.tar.gz,下载地址:https://www.apache.org/dist/hadoop/common/

jdk版本:jdk-8u221-linux-x64.tar.gz,hadoop只支持jdk7和jdk8,不支持jdk11

2、解压安装文件

通过ftp等工具讲安装包上传到服务器上,并解压到/usr/local/目录

cd /usr/local/ tar -zxvf /var/ftp/pub/jdk-8u221-linux-x64.tar.gz tar -zxvf /var/ftp/pub/hadoop-2.9.2.tar.gz

3、配置JDK

修改${HADOOP_HMOE}/etc/hadoop/hadoop-env.sh文件,修改JAVA_HOME配置(也可以修改/etc/profile文件,增加JAVA_HOME配置)。

vi etc/hadoop/hadoop-env.sh

// 修改为

export JAVA_HOME=/usr/local/jdk1.8.0_221/

4、设置伪分布模式(Pseudo-Distributed Operation)

修改etc/hadoop/core-site.xml文件,增加配置(fs.defaultFS:默认文件系统名称):

<configuration> <property> <name>fs.defaultFS</name> <value>hdfs://localhost:9000</value> </property> </configuration>

修改etc/hadoop/hdfs-site.xml文件,增加配置(dfs.replication:文件副本数):

<configuration> <property> <name>dfs.replication</name> <value>1</value> </property> </configuration>

5、设置主机允许无密码SSH链接

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa // 创建公钥私钥对

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys //

chmod 0600 ~/.ssh/authorized_keys // 设置权限,owner有读写权限,group和other无权限

6、格式化文件系统

bin/hdfs namenode -format

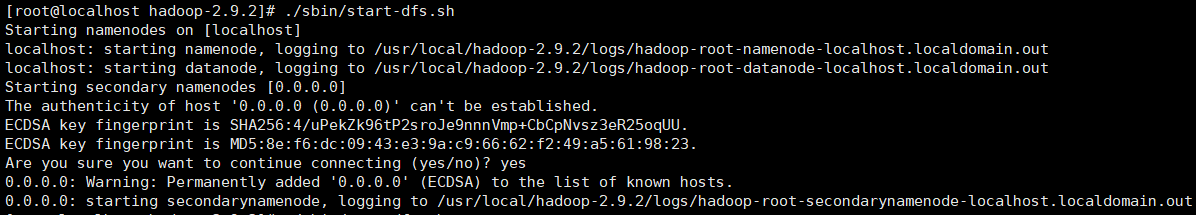

7、启动NameNode和DataNode进程(启动hdfs)

./sbin/start-dfs.sh // 启动NameNode和DataNode进程

./sbin/stop-dfs.sh // 关闭NameNode和DataNode进程

输入地址:http://192.168.114.135:50070,可查看HDFS

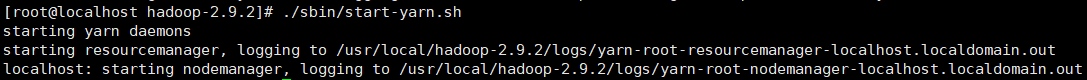

8、 启动YARN

./sbin/start-yarn.sh

./sbin/stop-yarn.sh

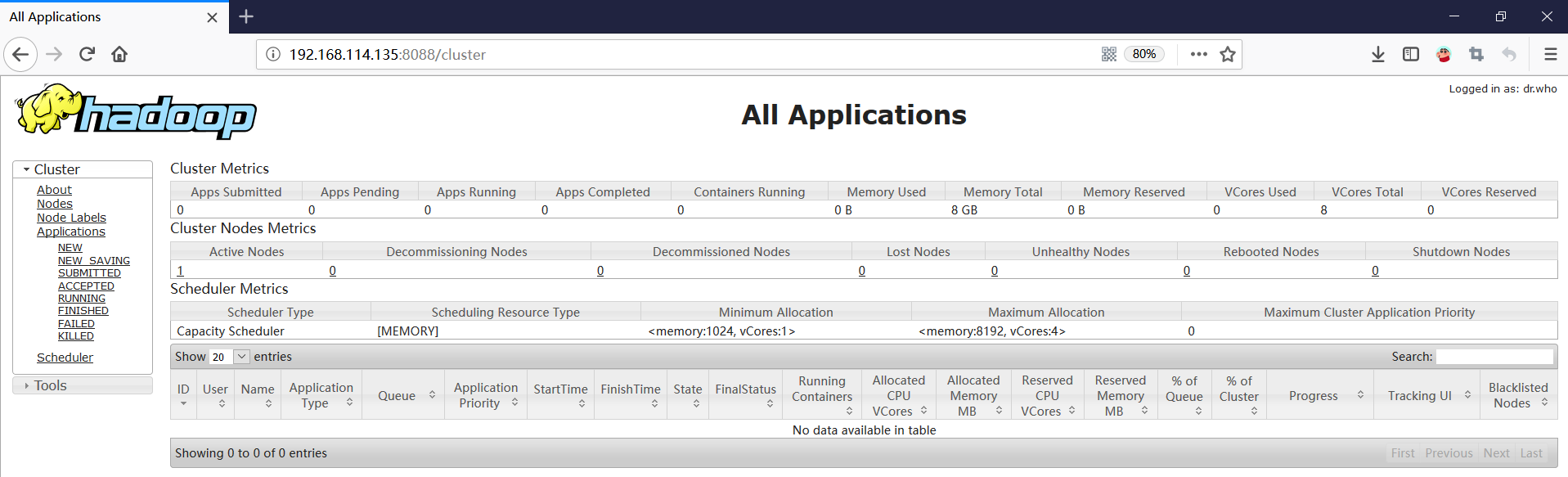

输入地址:http://192.168.114.135:8088/,可查看YARN

浙公网安备 33010602011771号

浙公网安备 33010602011771号