第三次作业

1.Spark已打造出结构一体化、功能多样化的大数据生态系统,请用图文阐述Spark生态系统的组成及各组件的功能。

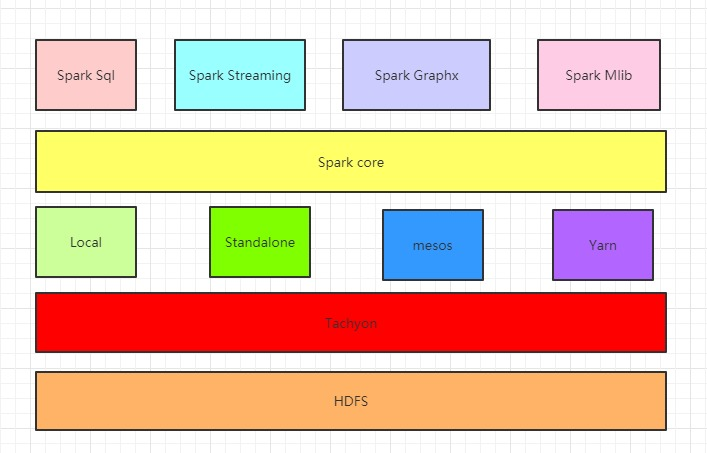

1 . Spark Core:Spark的核心组件,其操作的数据对象是RDD(弹性分布式数据集)

图中在Spark Core上面的四个组件都依赖于Spark Core,可以简单认为Spark Core就是Spark生态系统中的离线计算框架,eg:Spark Core中提供的map,reduce算子可以完成mapreduce计算引擎所做的计算任务

2 . Spark Streaming:Spark生态系统中的流式计算框架,其操作的数据对象是DStream,其实Spark Streaming是将流式计算分解成一系列短小的批处理作业。这里的批处理引擎是Spark Core,也就是把Spark Streaming的输入数据按照batch size(批次间隔时长)(如1秒)分成一段一段的数据系列(DStream),每一段数据都转换成Spark Core中的RDD,然后将Spark Streaming中对DStream的转换计算操作变为针对Spark中对RDD的转换计算操作在内部实现上,DStream由一组时间序列上连续的RDD来表示。每个RDD都包含了自己特定时间间隔内的数据流(如上图中0到1秒接收到的数据成为一个RDD,1到2秒接收到的数据成为一个RDD),使用Spark Streaming对图中DStream的操作就会转化成使用Spark Core中的对应算子(函数)对Rdd的操作

3 . Spark Sql:可以简单认为可以让用户使用写SQL的方式进行数据计算,SQL会被SQL解释器转化成Spark core任务,让懂SQL不懂spark的人都能通过写SQL的方式进行数据计算,类似于hive在Hadoop生态圈中的作用,提供SparkSql CLI(命令行界面),可以再命令行界面编写SQL

4 . Spark Graphx:Spark生态系统中的图计算和并行图计算,目前较新版本已支持PageRank、数三角形、最大连通图和最短路径等6种经典的图算法

5 . Spark Mlib:一个可扩展的Spark机器学习库,里面封装了很多通用的算法,包括二元分类、线性回归、聚类、协同过滤等。用于机器学习和统计等场景

6 . Tachyon:Tachyon是一个分布式内存文件系统,可以理解为内存中的HDFS

7 . Local,Standalone,Yarn,Mesos:Spark的四种部署模式,其中Local是本地模式,一般用来开发测试,Standalone是Spark 自带的资源管理框架,Yarn和Mesos是另外两种资源管理框架,Spark用哪种模式部署,也就是使用了哪种资源管理框架

2.请详细阐述Spark的几个主要概念及相互关系:

Master, Worker; RDD,DAG; Application, job,stage,task; driver,executor,Claster Manager

--------------------------------------------------

DAGScheduler, TaskScheduler.

Master,Worker:Spark集群配好的时候,就有了Master和Worker节点,一个集群有多个Master和多个Worker。Master节点常驻master守护进程,负责管理Worker节点,我们从master节点提交应用。worker节点常驻worker守护进程,与master节点通信,并且管理executor进程。

RDD,DAG:RDD是弹性分布式数据集(Resilient Distributed Graph)的简称,是分布式内存的一个抽象概念,提供一种高度受限的共享内存模型。DAG是有向无环图(Directed Acyclic Graph)的简称,反映RDD之间的依赖关系。

Application, job,stage,task:Application(应用):用户编写的Spark编程应用、job(作业):一个作业包含多个RDD及作用于相应RDD上的各种操作、task(任务):运行在Executor上的工作单元、stage(阶段):是作业的基本调度单位,一个作业会分成多组任务,每组任务都被称为“阶段”或是“任务集”

driver,executor,Claster Manager:driver:每个任务的控制节点,executor:每个工作节点上负责具体任务的执行进程,Claster Manager:集群资源管理器。

1.构建Spark Application的运行环境(启动SparkContext),SparkContext向资源管理器(可以是Standalone、Mesos或YARN)注册并申请运行Executor资源;

2.资源管理器分配Executor资源并启动StandaloneExecutorBackend,Executor运行情况将随着心跳发送到资源管理器上;

3.SparkContext构建成DAG图,将DAG图分解成Stage,并把Taskset发送给Task Scheduler。Executor向SparkContext申请Task,Task Scheduler将Task发放给Executor运行同时SparkContext将应用程序代码发放给Executor;

4.Task在Executor上运行,运行完毕释放所有资源

浙公网安备 33010602011771号

浙公网安备 33010602011771号