如何在本地搭建 deepseek (深度求索)和配置UI界面 (支持本地模型联网)

要求:需要一台windows10以上版本的电脑

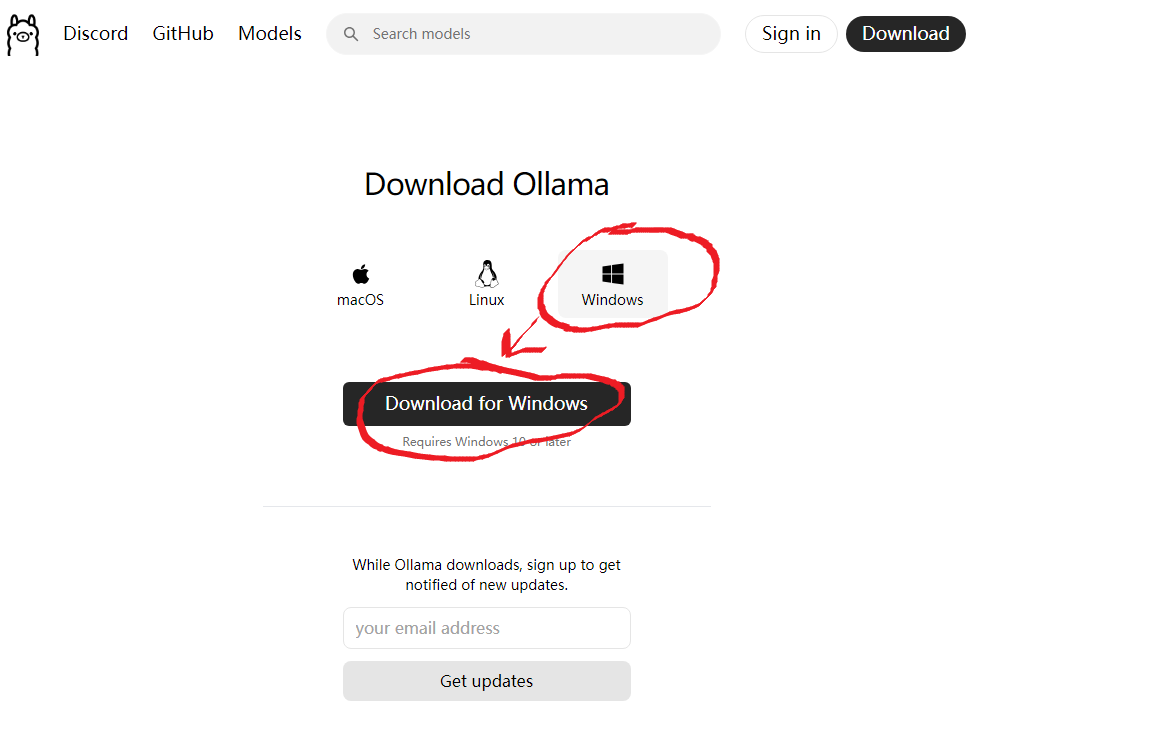

1.安装ollama

打开网址: https://ollama.com/

按你的需求下载相应版的ollma,我这就下一个windows版的,一路自动安装即可。

2.修改一下ollama的模型model安装位置,默认是C盘 (最大版本容量是400G,磁盘够用的可以跳过)

(1) Ollama的模型文件默认存储位置如下:

Windows系统:模型文件默认存储在C:\Users\<用户名>\.ollama\models目录下。

macOS系统:模型文件默认存储在\~/.ollama/models目录下。

Linux系统:模型文件默认存储在/usr/share/ollama/.ollama/models目录下。

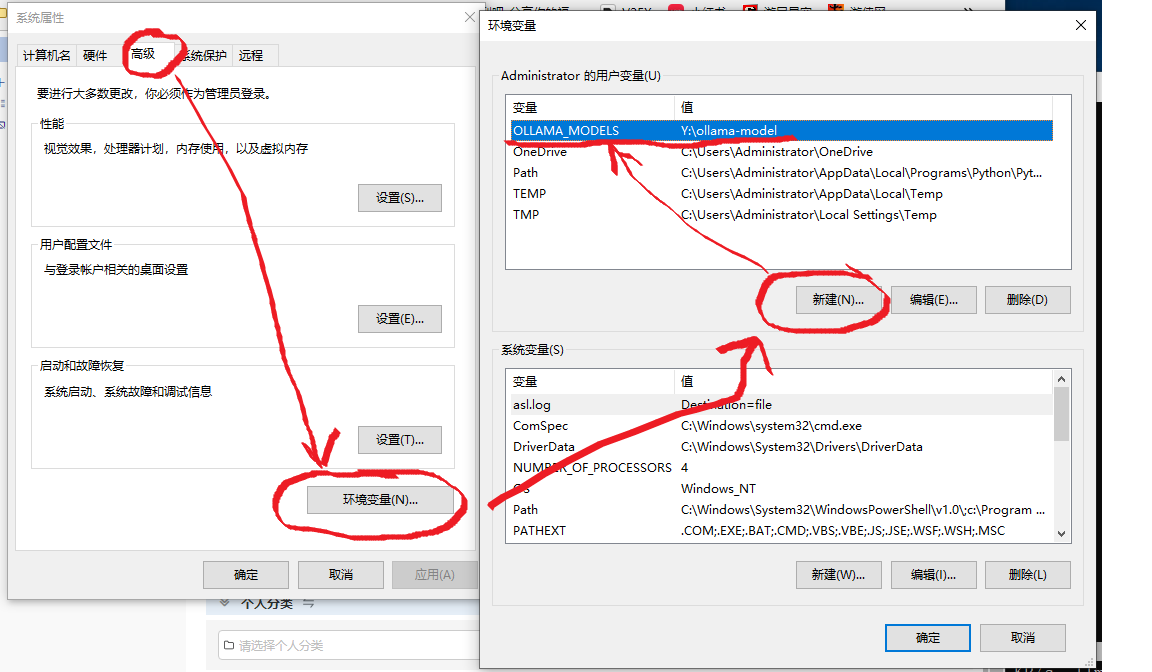

(2) 更改模型存储位置的方法:

Windows系统:

打开系统属性,进入环境变量设置。

在“环境变量”窗口中,新建或修改一个名为OLLAMA_MODELS的环境变量,并将其值设置为新的存储路径(例如D:\Work\ollama\models)。

重启Ollama服务, 即退出右下角图标,再重新启动ollama即可以使更改生效。

(PS:要是允许公开访问本机ollama服务,这里要多配置一个变量:OLLAMA_HOST,值:0.0.0.0:11434)

macOS和Linux系统:

打开配置文件ollama.service,在environment部分添加环境变量OLLAMA_MODELS,并设置新的存储路径。

重新加载配置并重启Ollama服务。

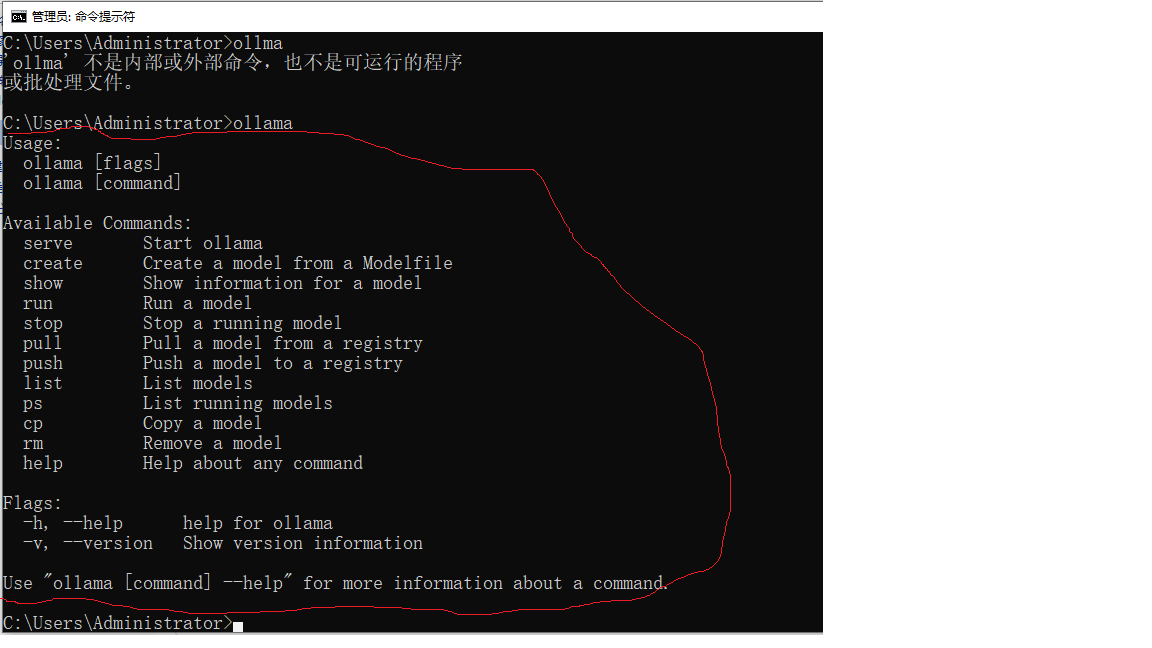

3. 启动CMD(建议使用用管理员模式CMD或PS)

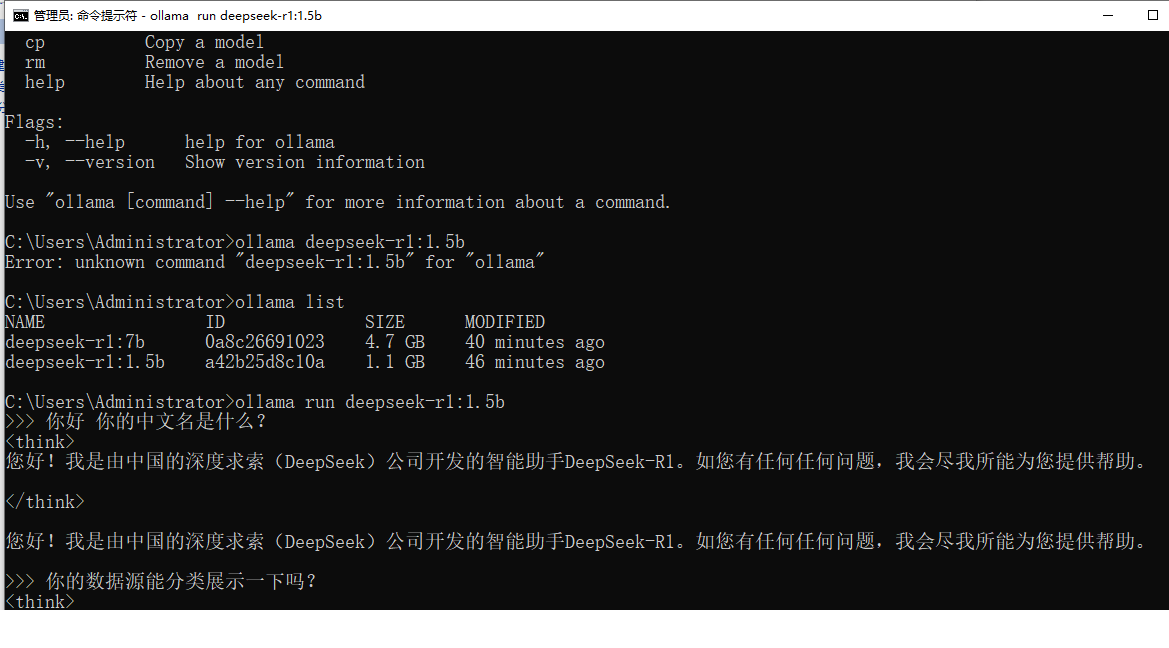

(1) 先输入"ollama",看到出现提示命令表示安装正确:

(2) 直接输入命令“ollama 模型:版本”,ollama会自动下载AI的模型配置好并启动:

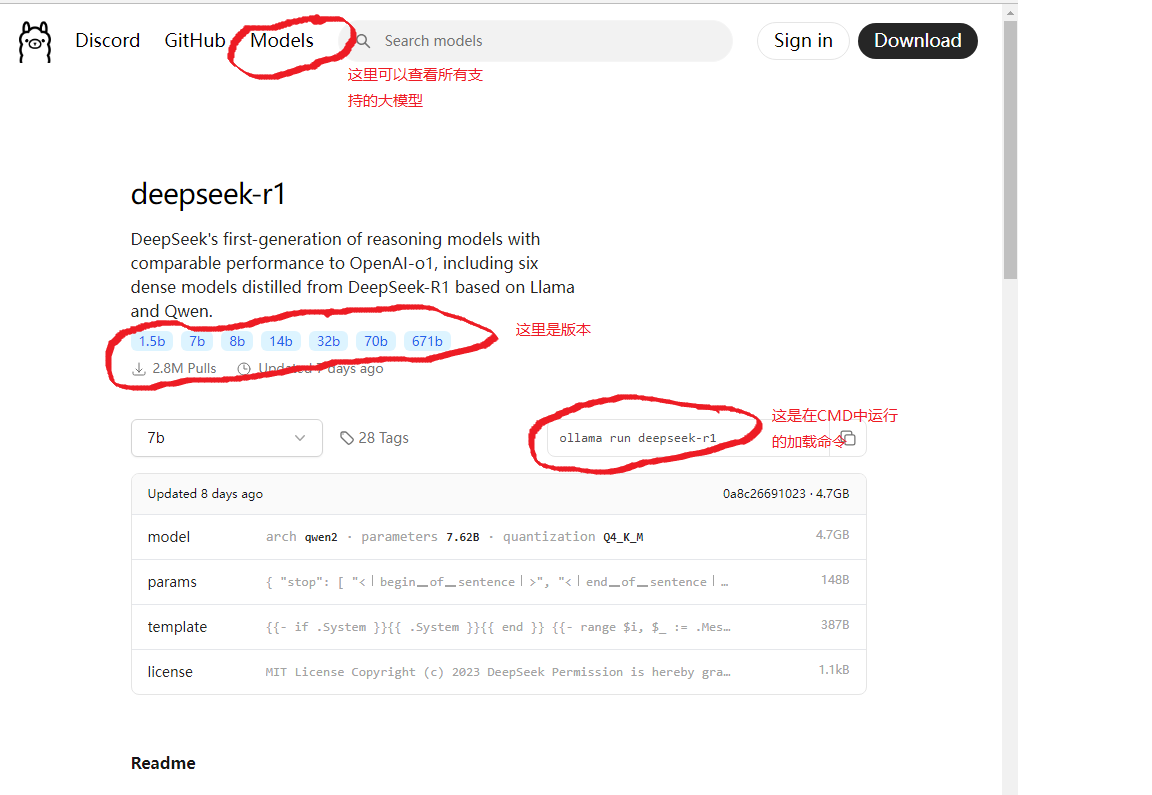

具体支持的版本,访问这个网址:https://ollama.com/library/deepseek-r1

我这里直接按ollama给出的操作提示, 安装一个8b版本的模型,想快速玩耍就下最小容量的1.5b版本

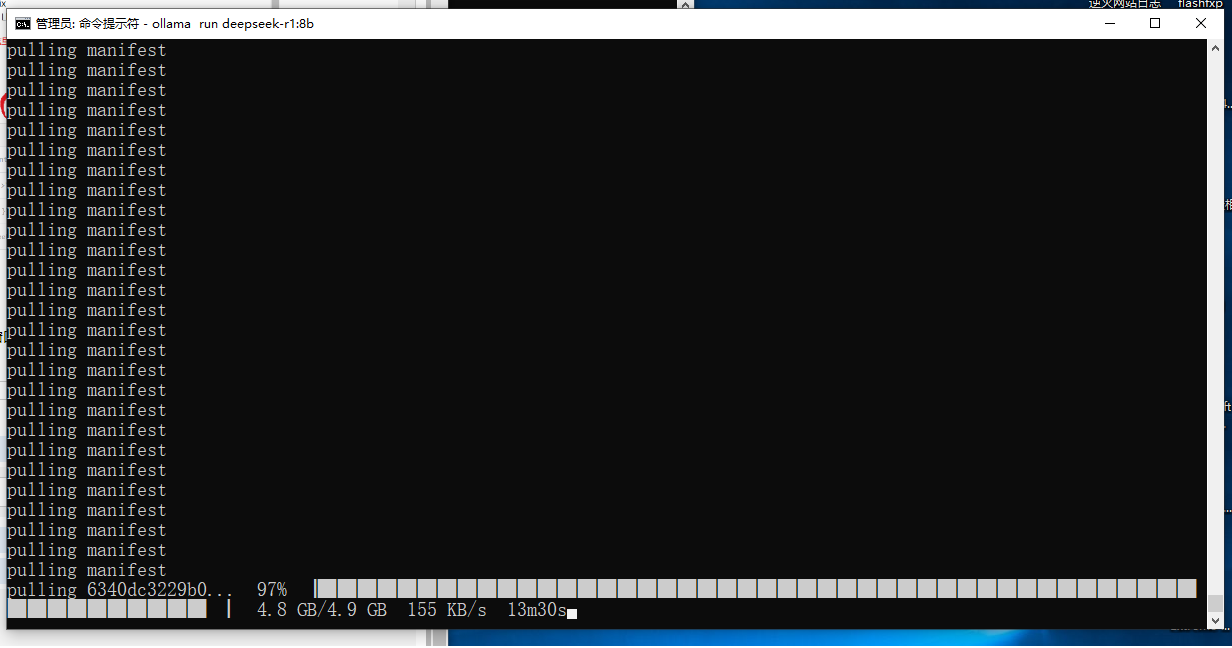

在CMD窗口中输入: ollama run deepseek-r1:8b

ollama run deepseek-r1:8b如下图所示,自动下载完成后,会自动加载deepseek-r1:8b模型:

好了,到此就可以愉快的与deepseek玩耍了。

ollama list #查看已安装好的模型Model

ollama run modelname #启动模型model

4. 给本地deepseek-r1模型安装一个UI界面(支持本地模型联网)

(1)需要安装好chrome浏览器,在插件商店中搜索安装“Page Assist”;

(2)安装好后,在扩展程序管理中即可找到:

(3)点击这个位置选择本地已经部署好的,你想使用的版本即可,我这里就用1.5b了,如下图

(4)用我的公司名称测试了一下,未联网时deepseek是找不到的,勾选联网on状态后能成功给出我公司从事的行业,如下图:

(5)还需要配置一下插件,改成中文,允许联网使用的默认搜索引擎为国内的(能直接上外网的就无需修改了),如下图:

写在最后:2025年开始是AI时代了,不会使用AI辅助生活和工作的人将被社会淘汰,与诸君共勉。

浙公网安备 33010602011771号

浙公网安备 33010602011771号