记一次--------HDP3.1 spark创建表hive读不到,hive创建表spark读不到

1.修改spark配置:

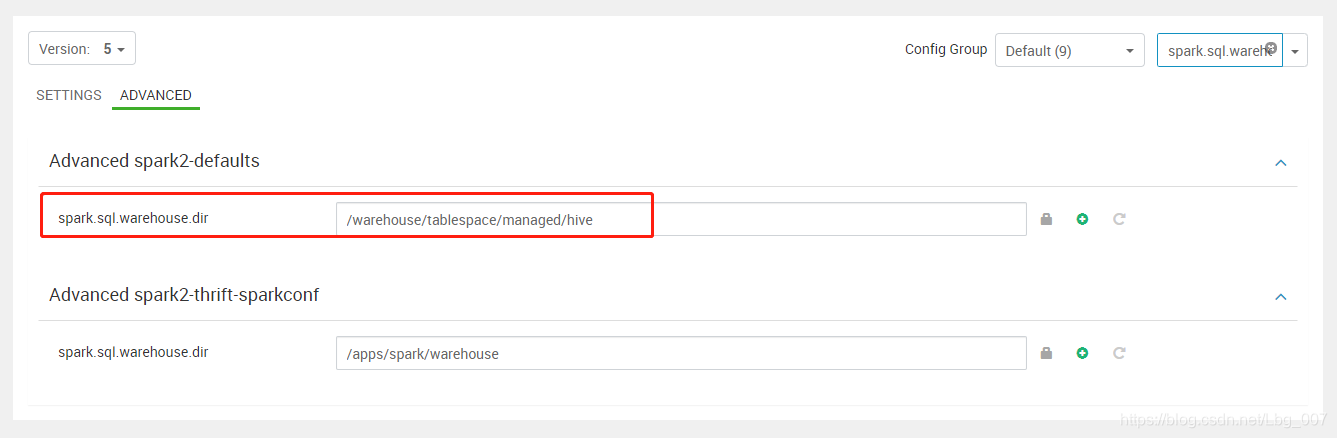

Advanced spark2-defaults

spark.sql.warehouse.dir 值/apps/spark/warehouse 改为hive数据存储hdfs位置:/user/hive/warehouse

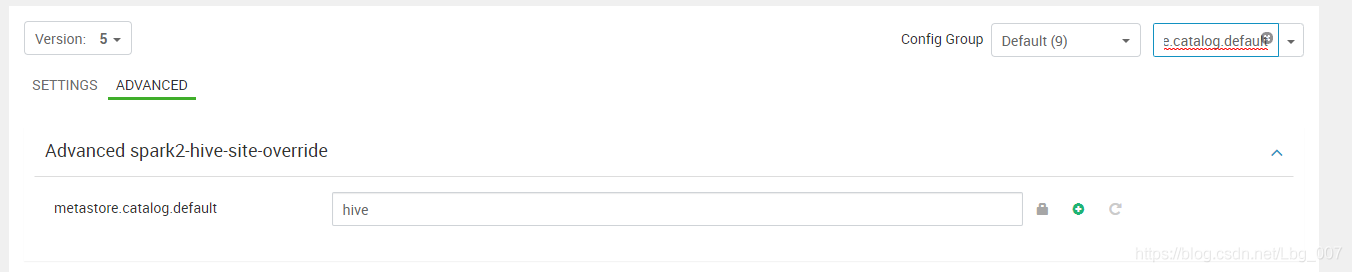

Advanced spark2-hive-site-override

metastore.catalog.default 值 spark 改为 hive

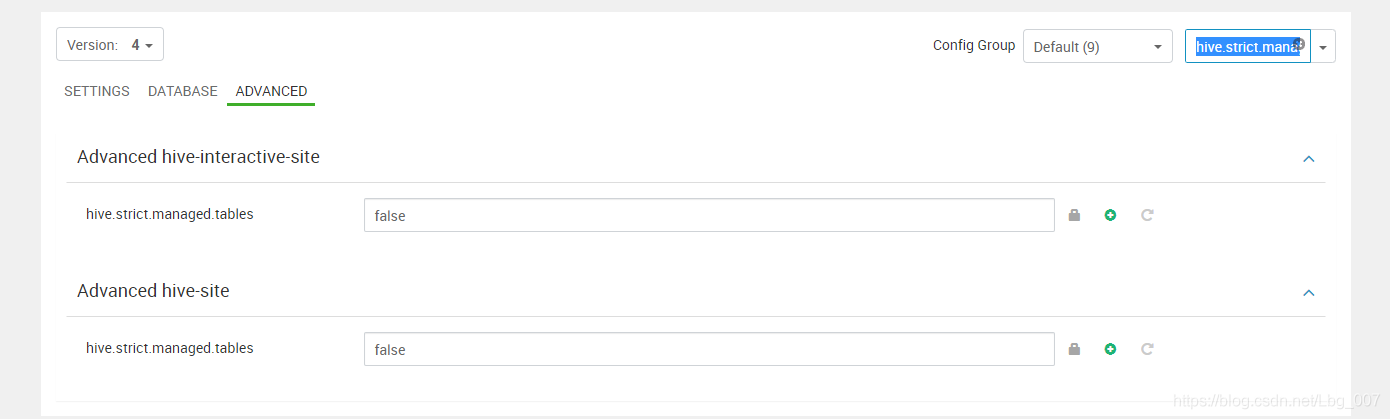

2.到hive组件修改配置

hive.strict.managed.tables 的 true 改为 false

(有两个 hive.strict.managed.tables)

重启 hive和spark即可。

作者:于二黑

本文版权归作者和博客园共有,欢迎转载,但未经作者同意必须保留此段声明,且在文章页面明显位置给出原文连接,否则保留追究法律责任的权利。

浙公网安备 33010602011771号

浙公网安备 33010602011771号