强化学习的基本概念

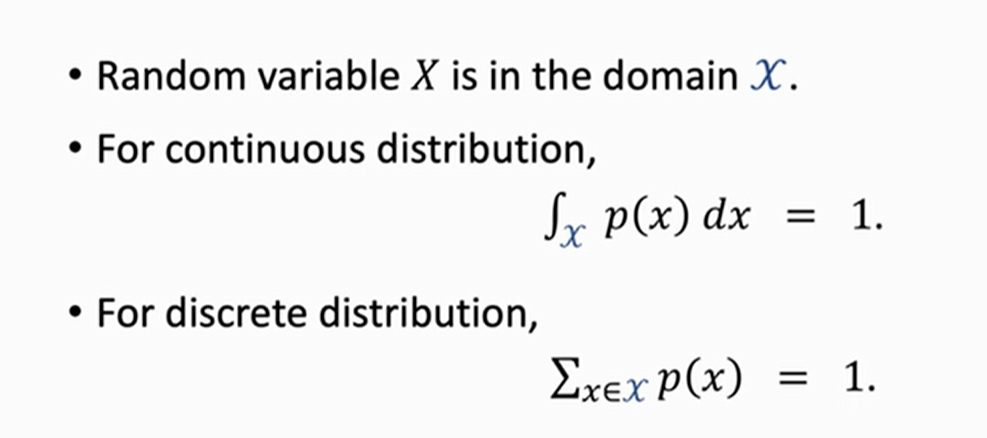

- 概率密度函数

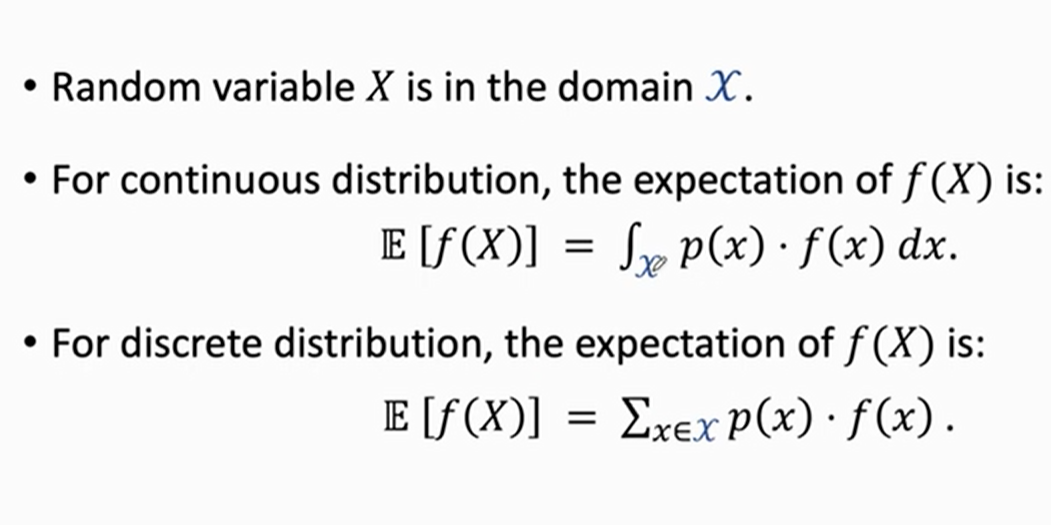

- 期望(expect)

- state s

- action a

- agent

- policy Π(a|s)

- reward r

- state transition p(s'|s,a)

- return(cumulative future reward 未来累计回报)

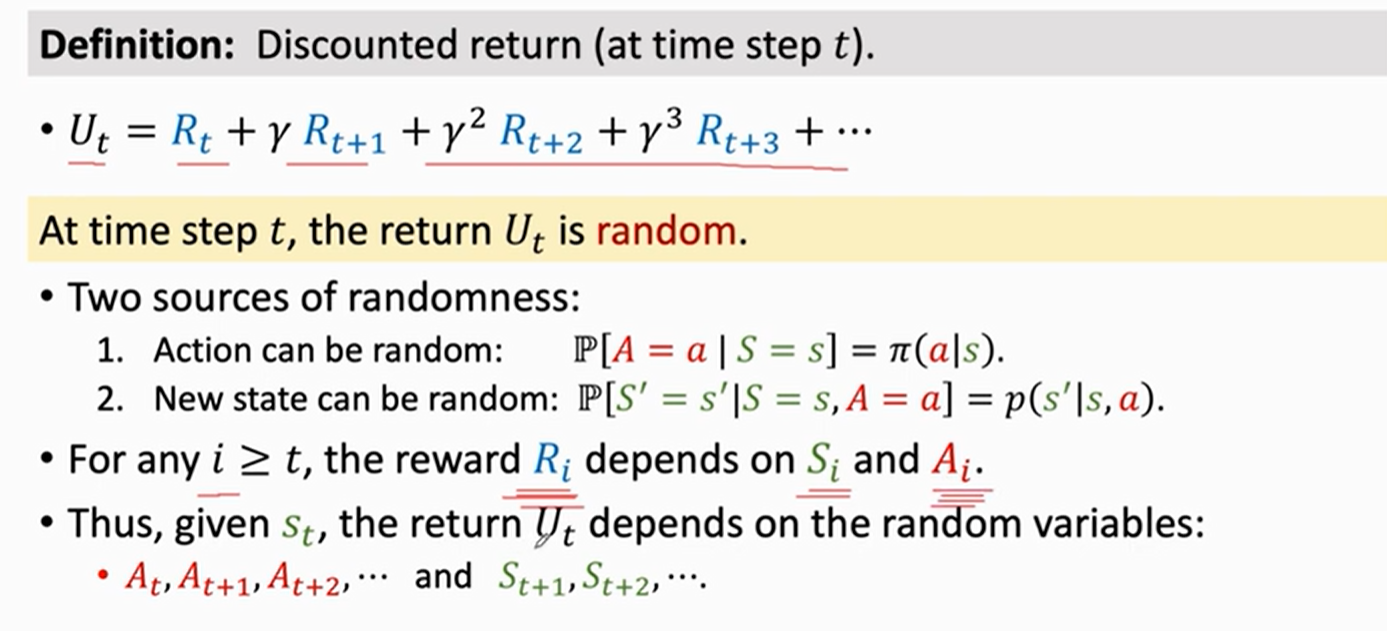

- discounted return(γ 折扣回报)

Ut是未来获得的奖励总和,Ut是随机变量 它依赖于所有未来的随机动作

- value function(价值函数)

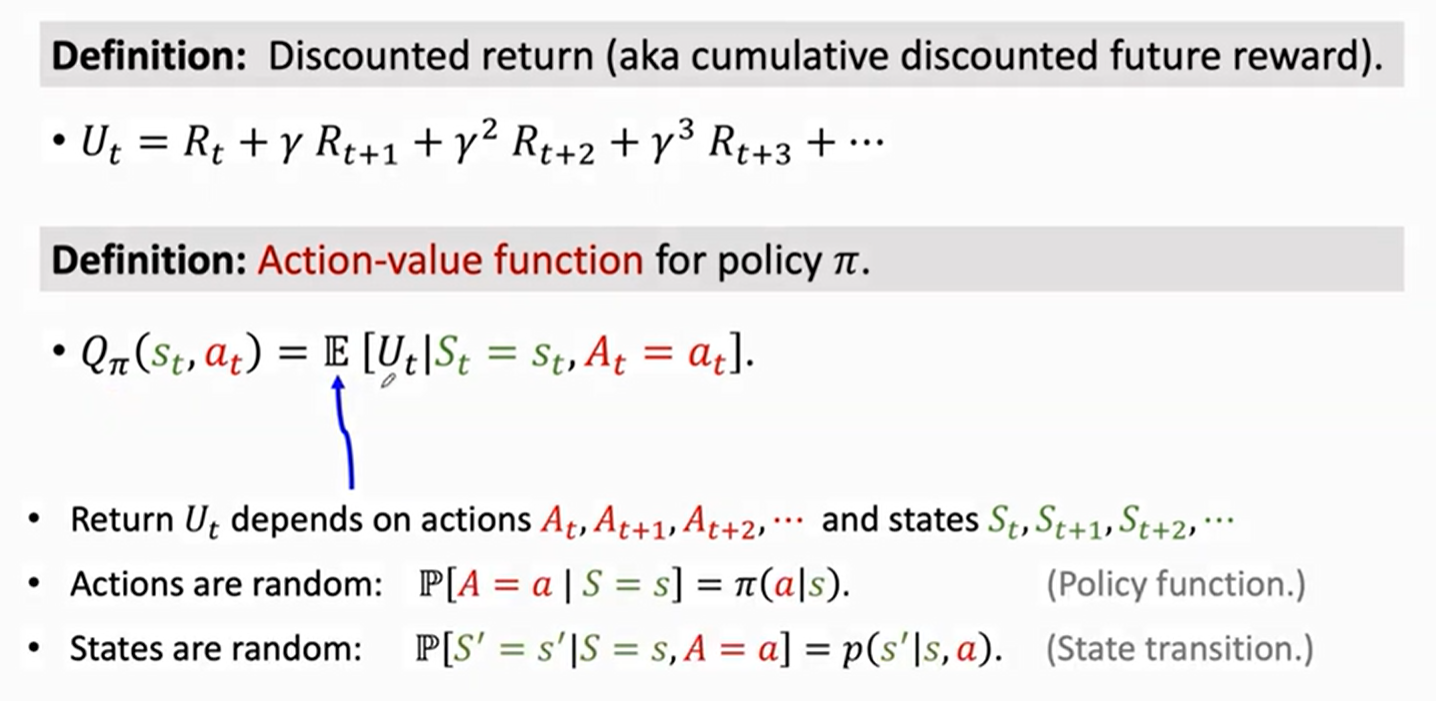

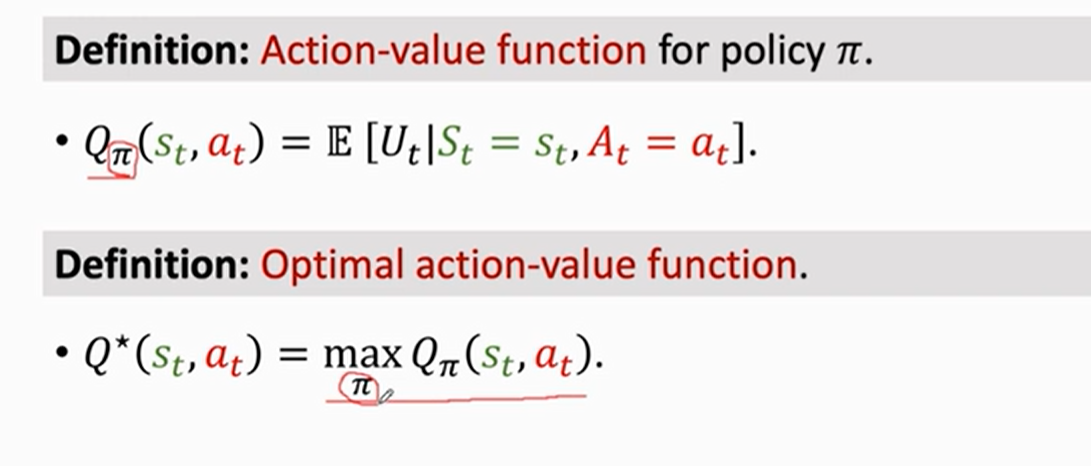

action-value function (动作价值函数)

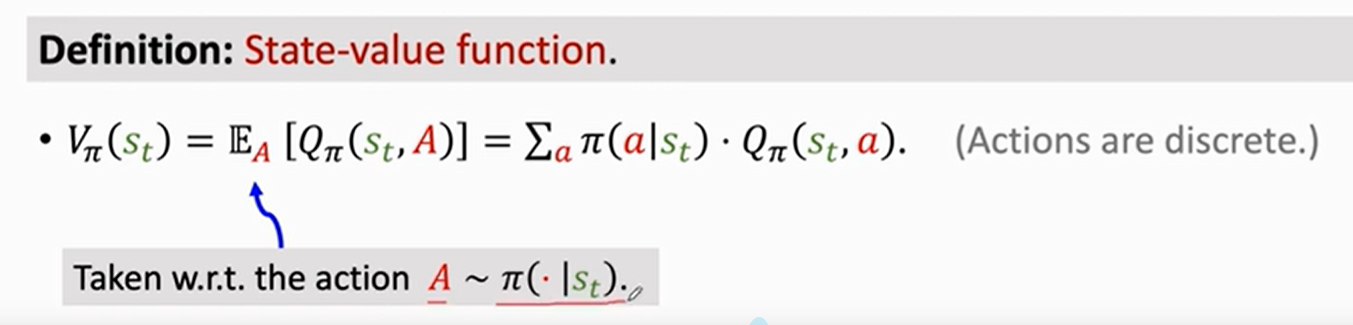

sate-value function(状态价值函数)

![]()

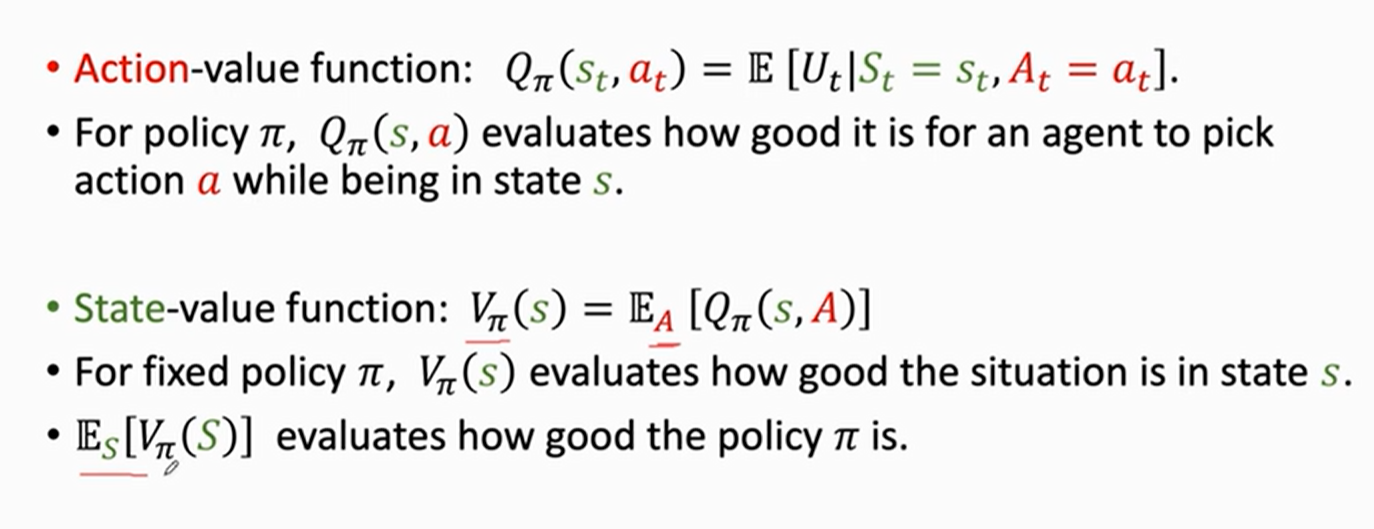

动作价值函数(Action-value function):QΠ,它跟策略函数(policy function)Π、状态s、动作a有关

如果使用policy Π,agent在状态(state)s时,做出动作(action)a是否明智,QΠ可以给动作a打分

状态价值函数(State-value function):VΠ,跟策略函数(policy function)Π、状态s、动作a无关

如果使用policy Π,VΠ可以评价当前情况是好是坏,如果Π是固定的,状态s越好,VΠ数值越大

VΠ还能评价policy函数Π的好坏,如果Π越好,那VΠ的平均值[ES(VΠ(S)]就越大

浙公网安备 33010602011771号

浙公网安备 33010602011771号