elasticsearch中文分词器ik-analyzer安装

前面我们介绍了Centos安装elasticsearch 6.4.2 教程,elasticsearch内置的分词器对中文不友好,只会一个字一个字的分,无法形成词语,别急,已经有大拿把中文分词器做好了,elasticsearch配套的ik-analyzer,我们一起来看看如何安装吧。

我们到ik-analyzer中文分词器开源项目查找与elasticsearch对应的v6.4.2版本(有的是6.0.0版https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v6.0.0/elasticsearch-analysis-ik-6.0.0.zip) https://github.com/medcl/elasticsearch-analysis-ik/releases

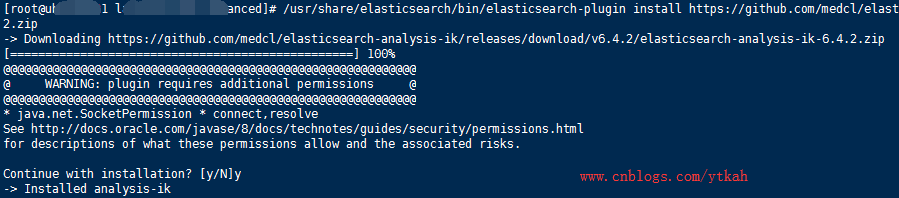

复制ik-analyzer中文分词器v6.4.2的链接地址,进行安装

/usr/share/elasticsearch/bin/elasticsearch-plugin install https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v6.4.2/elasticsearch-analysis-ik-6.4.2.zip

安装完成,重新启动一下elasticsearch

sudo systemctl restart elasticsearch

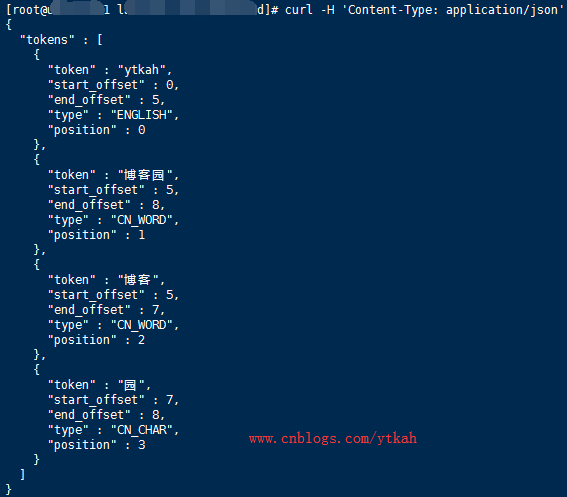

查看一下ik-analyzer的效果

curl -H 'Content-Type: application/json' -XGET 'localhost:9200/_analyze?pretty' -d '{"analyzer":"ik_max_word","text":"ytkah博客园"}'

博客这个词是不是没有被分成“博”和“客”两个字了?说明已经安装成功

本文参考https://baijunyao.com/article/155

浙公网安备 33010602011771号

浙公网安备 33010602011771号