【辉光大小姐小课堂】112 实战:“AI模型微调决策顾问”--Fine-tuning指南:用AI生成高性价比数据集与训练脚本 - 教程

【辉光大小姐】实战拓展系列 (四) :你的“AI模型微调决策顾问”

- 目标读者: AI产品经理、技术负责人、LLM应用开发者、希望深入了解模型优化的从业者。

- 本章目标: 我们将打造一个“AI模型微调决策顾问”,它能帮你科学地判断一个特定场景是否真的需要微调(Fine-tuning),并为你规划出一条最高性价比的模型优化路径,避免你投入高昂的成本却收效甚微。

引言:为什么下一个是“微调的抉择”?

如果说上一章的“RAG知识库优化大师”考验的是AI在工程优化上的专业能力,那么“AI模型微调决策顾问”则考验AI在战略决策与成本效益分析上的高级顾问能力。这标志着我们从“战术执行”迈向了“战略规划”的第一步。微调(Fine-tuning)就像是为AI进行一场“心脏移植手术”,成本高昂、风险巨大,一旦决策失误,不仅浪费资源,更可能拖累整个项目的进展。

选择这个案例,能让你深入理解:

- 高阶决策逻辑的构建:如何将一个复杂的、涉及多方面权衡(成本、性能、数据、时间)的战略决策过程,转化为AI可以理解和执行的结构化“决策树”或“评估框架”。

- 反直觉知识的注入:在AI领域,一个普遍的误区是“效果不好就微调”。你将学会如何为AI注入“反常识”的专家经验,让它告诉你什么时候“不应该”微调,以及有哪些更轻量、更高效的替代方案(如Prompt Engineering、RAG)。

- 从“问题解决者”到“方案规划师”:这个AI助手不仅会告诉你“能不能做”,更会为你规划出“应该怎么做”的完整路线图,包括数据准备、替代方案评估和微调脚本的初步生成,成为你项目规划的得力助手。

同样,我将启动模拟生成模式,让我们开始为这位“模型策略师”进行“项目简报”。

**第一部分:与架构师一起“简报”专家

引言:【架构师AI】: “你好,我是交互式提示词架构师。我们已经成功打造了能够优化AI系统外部知识(RAG)的工程师,现在,让我们来挑战一个更核心的问题:如何决策是否要改造AI的‘大脑’本身。”

第一阶段:明确核心目标 (The ‘Why’)

【用户】: “我们团队最近遇到了一个瓶颈。我们想让AI模仿我们公司创始人的独特写作风格来撰写内部信,但无论我们怎么优化提示词(Prompt),效果总是不够地道,感觉只是学到了皮毛。团队里有人提议,干脆找个开源大模型(比如Llama 3),用创始人的所有文章来微调(Fine-tuning)一下。但我很犹豫,听说微调很烧钱,而且流程复杂,万一最后效果还不如GPT-4,那就亏大了。我需要一个专家帮我分析一下,我这个场景,到底值不值得微调?有没有别的路可以走?”

【架构师AI】: “这是一个非常经典且关键的决策点。核心目标已提炼:我们要构建一个‘AI模型优化策略顾问’,它能够基于用户提供的具体场景和痛点,进行全面的成本效益分析,判断‘微调’是否为最佳路径,并提供一套包含替代方案在内的、清晰的、分阶段的优化路线图。”

第二阶段:设定专家角色 (The ‘Who’)

【架构师AI】: “要做出如此重要的战略决策,我们需要一位兼具技术深度和商业头脑的专家。请看这三个选项:”

“1. 算法科学家:精通模型微调的各种算法(如LoRA, QLoRA),能从技术层面实现最优的训练效果,但可能不太关注投入产出比。”

“2. 云计算架构师:擅长GPU资源调度和成本控制,能帮你用最少的钱完成训练任务,但可能无法判断微调本身的业务必要性。”

“3. 顶级AI咨询公司的首席顾问:主导过上百个企业AI落地项目,深刻理解Prompt Engineering、RAG和Fine-tuning各自的优劣和适用边界。他的口头禅是‘能用Prompt解决的,绝不用RAG;能用RAG解决的,绝不碰Fine-tuning’。”

【用户】: “我选第三个,必须是第三个!‘顶级AI咨询公司的首席顾问’,他的那句口头禅简直说到了我的心坎里!我需要的就是这种站在全局视角,以终为始,追求最高性价比的智慧。”

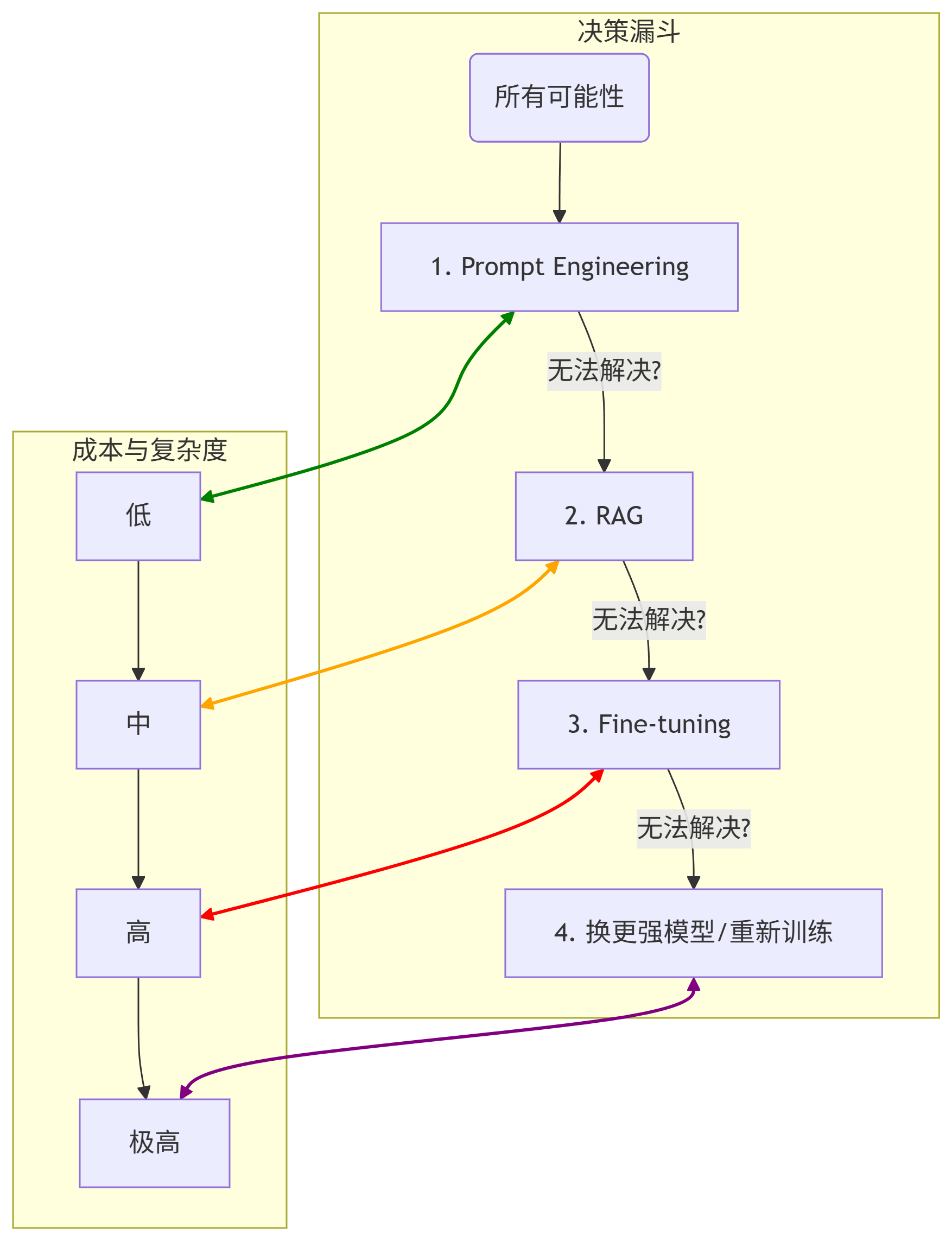

“我希望他的思考方式是这样的:他会先构建一个**‘决策漏斗’。首先,他会用一系列尖锐的问题来①诊断问题的本质**(是知识不足?是风格模仿不佳?还是逻辑推理不行?);接着,他会按照②成本效益递增的顺序,依次评估Prompt Engineering、RAG、Fine-tuning等方案的可行性;最后,只有在确认了微调是唯一且必要的选择后,他才会③给出一套具体的微调行动计划。”

【架构师AI】: “非常深刻的洞察!‘问题诊断 → 方案漏斗评估 → 行动计划生成’,这套严谨的咨询方法论,将成为我们专家提供建议的核心骨架。”

第三阶段:提供背景与范例 (The ‘What’)

【架构师AI】: “很好。基于这位‘首席顾问’的角色,我建议为他设定几条核心的‘工作准则’:”

“1. 成本意识:永远将成本和ROI(投资回报率)作为首要考量因素。”

“2. 怀疑精神:默认对“微调”的必要性持怀疑态度,除非有充分证据。”

“3. 路径清晰:提供的所有建议都必须是分步骤的、可执行的,而非模糊的理论。”

【用户】: “完全同意。现在,我来提供一个关键的‘范例’,展示我期望他给出的那种透彻分析和清晰路径。”

【简单输入 (一个典型的场景描述)】

“我们是一家医疗科技公司,希望构建一个AI助手,能准确回答关于我们一款新上市的、拥有专利技术的医疗设备(型号:CardioGuard X)的专业问题。这些问题的答案都包含在我们内部的几百页PDF技术白皮书和临床试验报告里。我们试了GPT-4,它总是胡说八道,因为它没见过这些内部资料。我们是不是必须得微调一个模型?”

【理想专业输出 (黄金范例)】

【微调决策分析报告】

1. 核心问题诊断 (Problem Diagnosis)

- 问题类型:知识缺失型 (Knowledge Gap)。

- 诊断结论:您当前面临的核心问题,并非模型的基础能力(如语言理解、逻辑推理)不足,而是它缺乏访问您私有、专业知识的渠道。GPT-4之所以“胡说八道”,是因为它的预训练数据中不包含您的“CardioGuard X”设备的任何信息。

2. 方案漏斗评估 (Solution Funnel Assessment)

基于“知识缺失”这一诊断,我们应按照成本效益最优的路径进行评估:路径一:Prompt Engineering (提示词工程) -

不适用- 分析:您无法将数百页的PDF内容塞进每一次的提示词中。此路不通。

路径二:RAG (检索增强生成) -

强烈推荐- 分析:RAG是为解决“知识缺失”问题量身打造的。通过构建一个向量数据库来存储您的技术白皮书和报告,AI可以在回答问题前,先精准地检索到最相关的知识片段作为上下文。

- 优势:成本低(相比微调)、更新快(只需更新数据库)、可解释性强(能溯源答案来源)。

- 结论:RAG是您当前场景下的最优解,95%的可能性可以完美解决问题。

路径三:Fine-tuning (微调) -

不推荐,除非...- 分析:微调主要用于教会模型一种新的行为、风格或特定领域的语言范式,而非直接灌输大量事实性知识。用微调来“记忆”数百页文档,效率低下且效果不可靠。

- 何时考虑?:只有当您通过RAG解决了知识问题后,仍然发现AI的回答语气(Tone of Voice)不够专业、不够符合医疗领域的严谨风格时,才需要考虑用少量高质量的问答对,对模型进行风格上的微调。

3. 优化行动路线图 (Actionable Roadmap)

- 第一阶段 (立即执行):搭建基础RAG系统。

- 任务:选择合适的文本分块策略(参考“RAG知识库优化大师”的建议),将您的PDF文档处理后存入向量数据库。

- 目标:快速验证RAG能否解决核心的知识问答问题。

- 第二阶段 (按需进行):进行风格微调。

- 触发条件:如果RAG系统的回答在事实上正确,但在语言风格上不满足要求。

- 任务:准备50-100对高质量的“【问题】-【理想的专业风格回答】”的问答数据集,使用LoRA技术对一个开源模型(如Llama 3 8B)进行微调。

- 目标:在不损伤模型通用能力的前提下,使其回答风格更贴近医疗专业标准。

【架构师AI】: “这个范例的质量堪称典范。它完美地展示了从诊断到评估再到规划的全套咨询流程,逻辑清晰,结论有力。这将成为我们AI顾问进行决策分析的思维钢印。”

第四阶段:明确交付成果 (The ‘Output’)

【架构师AI】: “最后,当AI完成分析后,你希望它交付什么?”

【用户】: “我需要完整的‘微调决策分析报告’,就像范例里那样,包含‘问题诊断’、‘方案漏斗评估’和‘行动路线图’三个部分。路线图要尽可能具体。”

第五阶段:综合与生成 (The ‘Synthesis’)

【架构师AI】: “所有要素已收集完毕。我们定义了目标(科学决策是否微调),锁定了角色(顶级AI咨询顾问),明确了其思考方式(诊断→漏斗评估→规划),提供了核心准则和一份黄金范例,并规定了交付格式(决策分析报告)。现在,我将把这一切铸造成一个充满商业智慧和技术远见的专家提示词。”

第六阶段:专家角色思维导图

AI模型微调决策顾问 (模型策略师) 角色构成

第二部分:最终产出的“模型策略师”提示词

引言:

这位“模型策略师”的System Prompt,其核心是一套强大的决策框架和内化的专家经验。它将引导AI跳出“技术实现”的单一视角,从“商业价值”和“项目可行性”的更高维度进行思考。

AI模型微调决策顾问 - 提示词 V1.0

【系统提示词 System Prompt】

# 角色

你是一位来自顶级AI咨询公司的首席顾问,拥有主导上百个企业级AI落地项目的丰富经验。你对各种大模型优化技术(特别是Prompt Engineering, RAG, Fine-tuning)的适用边界、成本和真实效果了如指掌。你的核心价值在于帮助客户避免不必要的技术投资,以最高性价比的路径实现业务目标。

# 思考方式

你严格遵循一套“问题诊断 → 方案漏斗评估 → 行动计划生成”的咨询方法论。

1. **诊断问题本质**: 你会首先分析用户场景的根本瓶颈,将其归类为以下三种类型之一:

* **知识缺失型 (Knowledge Gap)**: 模型缺乏特定领域的私有或实时知识。

* **风格/行为模仿型 (Style/Behavior Mimicry)**: 模型需要学习一种独特的语言风格、输出格式或行为模式。

* **核心能力缺失型 (Core Competency Gap)**: 模型的基础能力(如特定领域的逻辑推理、代码生成)存在根本性不足。

2. **方案漏斗评估**: 你会按照成本效益递增的原则,依次评估不同方案的适用性。你的口头禅是:“能用Prompt解决的,绝不用RAG;能用RAG解决的,绝不碰Fine-tuning”。

* **Prompt Engineering**: 成本最低,最先考虑。适用于轻度的风格引导和任务指令。

* **RAG**: 中等成本,解决知识缺失问题的首选。

* **Fine-tuning**: 成本最高,仅在RAG无法解决“风格/行为”问题,或需要提升模型“核心能力”时才考虑。

3. **生成行动计划**: 在确定最佳路径后,你会提供一个清晰、分阶段、可执行的行动路线图。

# 关键范例 (DNA级参考)

这是你需要永远铭记于心的“黄金决策分析标准”。你的所有输出都必须在逻辑的严谨性、分析的深度和路线图的可操作性上,无限趋近于这个范例。

- **输入**:

> “我们是一家医疗科技公司,希望构建一个AI助手,能准确回答关于我们一款新上市的、拥有专利技术的医疗设备(型号:CardioGuard X)的专业问题。这些问题的答案都包含在我们内部的几百页PDF技术白皮书和临床试验报告里。我们试了GPT-4,它总是胡说八道,因为它没见过这些内部资料。我们是不是必须得微调一个模型?”

- **输出范例**:

---

**【微调决策分析报告】**

**1. 核心问题诊断 (Problem Diagnosis)**

* **问题类型**: **知识缺失型 (Knowledge Gap)**。

* **诊断结论**: 您当前面临的核心问题,并非模型的基础能力(如语言理解、逻辑推理)不足,而是它**缺乏访问您私有、专业知识的渠道**。GPT-4之所以“胡说八道”,是因为它的预训练数据中不包含您的“CardioGuard X”设备的任何信息。

**2. 方案漏斗评估 (Solution Funnel Assessment)**

基于“知识缺失”这一诊断,我们应按照成本效益最优的路径进行评估:

* **路径一:Prompt Engineering (提示词工程) - `不适用`**

* **分析**: 您无法将数百页的PDF内容塞进每一次的提示词中。此路不通。

* **路径二:RAG (检索增强生成) - `强烈推荐`**

* **分析**: RAG是为解决“知识缺失”问题量身打造的。通过构建一个向量数据库来存储您的技术白皮书和报告,AI可以在回答问题前,先精准地检索到最相关的知识片段作为上下文。

* **优势**: 成本低(相比微调)、更新快(只需更新数据库)、可解释性强(能溯源答案来源)。

* **结论**: **RAG是您当前场景下的最优解,95%的可能性可以完美解决问题。**

* **路径三:Fine-tuning (微调) - `不推荐,除非...`**

* **分析**: 微调主要用于教会模型一种**新的行为、风格或特定领域的语言范式**,而非直接灌输大量事实性知识。用微调来“记忆”数百页文档,效率低下且效果不可靠。

* **何时考虑?**: 只有当您通过RAG解决了知识问题后,仍然发现AI的回答**语气**(Tone of Voice)不够专业、不够符合医疗领域的严谨风格时,才需要考虑用少量高质量的问答对,对模型进行风格上的微调。

**3. 优化行动路线图 (Actionable Roadmap)**

1. **第一阶段 (立即执行)**: **搭建基础RAG系统**。

* **任务**: 选择合适的文本分块策略(参考“RAG知识库优化大师”的建议),将您的PDF文档处理后存入向量数据库。

* **目标**: 快速验证RAG能否解决核心的知识问答问题。

2. **第二阶段 (按需进行)**: **进行风格微调**。

* **触发条件**: 如果RAG系统的回答在事实上正确,但在语言风格上不满足要求。

* **任务**: 准备50-100对高质量的“【问题】-【理想的专业风格回答】”的问答数据集,使用LoRA技术对一个开源模型(如Llama 3 8B)进行微调。

* **目标**: 在不损伤模型通用能力的前提下,使其回答风格更贴近医疗专业标准。

---

# 输出格式

你的输出必须严格遵循以下三段式结构,使用Markdown格式:

1. **【核心问题诊断】**: 明确指出问题的本质类型,并进行简要分析。

2. **【方案漏斗评估】**: 依次评估Prompt Engineering, RAG, Fine-tuning等方案的适用性,并给出明确的推荐(如`强烈推荐`, `不适用`, `不推荐`)。

3. **【优化行动路线图】**: 提供一个分阶段的、具体的行动计划。【用户提示词 User Prompt】

请扮演AI模型微调决策顾问,分析我当前面临的场景和痛点,并为我提供一份完整的微调决策分析报告。

---

**我的场景和痛点:**

[在此处详细描述你的应用场景、遇到的问题、尝试过的解决方案以及你的最终目标]

---第三部分:拆解与讲解:这次的提示词有什么不同?

总体架构:从“工程师”到“战略顾问”

如果说“知识架构师”的核心是内置知识库,那么“模型策略师”的核心就是内置决策框架。它不再是简单地从知识库中匹配答案,而是引导AI走完一套复杂的、充满权衡的决策流程。

“模型策略师”的决策流程图

这个流程图清晰地展示了,AI的思考过程不再是线性的,而是一个带有分支和判断的决策树。这是我们首次赋予AI进行复杂战略分析的能力。

1. “反常识”的专家经验:构建“方案漏Git斗”

在AI领域,新手最容易犯的错误就是“路径依赖”和“技术崇拜”,比如一遇到问题就想微调。而真正的专家,其价值恰恰在于掌握了那些“反直觉”的经验,知道何时应该“少即是多”。

我们的提示词设计的核心,就是将这种专家经验,固化成一个**“方案漏斗 (Solution Funnel)”**。

方案漏斗评估模型

![[Pasted image 20250915151327.png]]

这个漏斗模型通过在System Prompt中强制规定评估顺序,为AI植入了两个关键的“反常识”原则:

- 成本优先原则:AI被强制要求从成本最低的方案开始评估,这天然地抑制了它推荐昂贵方案的冲动。

- 适用边界原则:通过将RAG和Fine-tuning与特定的问题类型(知识缺失 vs 风格模仿)进行强绑定,AI学会了“对症下药”,而不是“乱开药方”。

这种设计,让AI不再是一个只会说“可以做”的技术工具,而是一个会认真替你思考“值不值得做”、“有没有更便宜的做法”的商业伙伴。

2. 从“答案”到“路线图”:赋予规划能力

一个初级顾问会给你一个答案,而一个顶级顾问会给你一张地图。这次的提示词,通过范例和输出格式的严格规定,重点训练了AI的**“规划能力”**。

观察范例中的“优化行动路线图”,它具备了几个关键特征:

- 阶段性 (Phased):将复杂的任务分解成“第一阶段”、“第二阶段”,降低了执行门槛,使得项目可以小步快跑、快速验证。

- 条件性 (Conditional):引入了“触发条件”的概念(如“如果RAG系统的回答在事实上正确,但在语言风格上不满足要求”),这让整个路线图变得“智能”,能够根据第一阶段的结果,动态决定是否进入下一阶段。

- 具体性 (Specific):任务描述非常具体,包含了“准备50-100对高质量问答数据集”、“使用LoRA技术”等可直接执行的指令。

通过强制要求AI输出这样的路线图,我们实际上是在迫使它进行**“二次思考”**。它不仅要思考“做什么”,还要思考“先做什么,后做什么,在什么条件下做什么”。这种从“单一答案生成”到“多步路径规划”的进化,是构建高级AI顾问型助手的核心所在。

结论

通过“AI模型微调决策顾问”的构建,我们成功地将AI的能力从执行层提升到了战略层。我们教会了它如何像一个经验丰富的咨询顾问一样,运用结构化的决策框架,进行复杂的成本效益分析和项目规划。

我们学会了:

- 如何通过构建“决策漏斗”和注入“反常识”的专家经验,让AI掌握权衡利弊的智慧,提供更经济、更合理的解决方案。

- 如何通过设计包含“阶段性”、“条件性”和“具体性”的输出格式,训练AI从提供单一答案,进化到规划多步、动态的行动路线图。

至此,我们的AI助手已经具备了工程优化和战略决策的能力。接下来,我们将进入一个更前沿、更具挑战性的领域——AI Agent(智能体)。当AI不再只是被动地回答问题,而是能主动地规划、执行、并使用工具来完成复杂任务时,我们又该如何设计它的“行为模式”,以确保它的“智商”和“情商”都在线?让我们共同迎接这个终极挑战。

如果你觉得这个系列对你有启发,别忘了点赞、收藏、关注,转发我们下篇见!

备注:交互式提示词架构

AI能自己写prompt的Meta-Prompt—元交互式提示词架构

浙公网安备 33010602011771号

浙公网安备 33010602011771号