SpringColudAlibaba - 详解

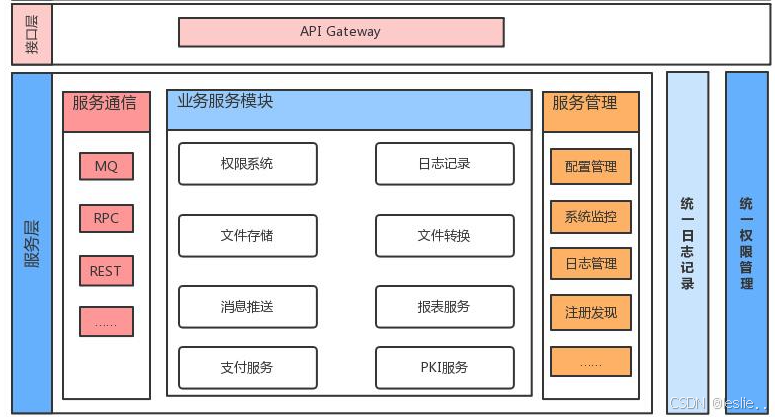

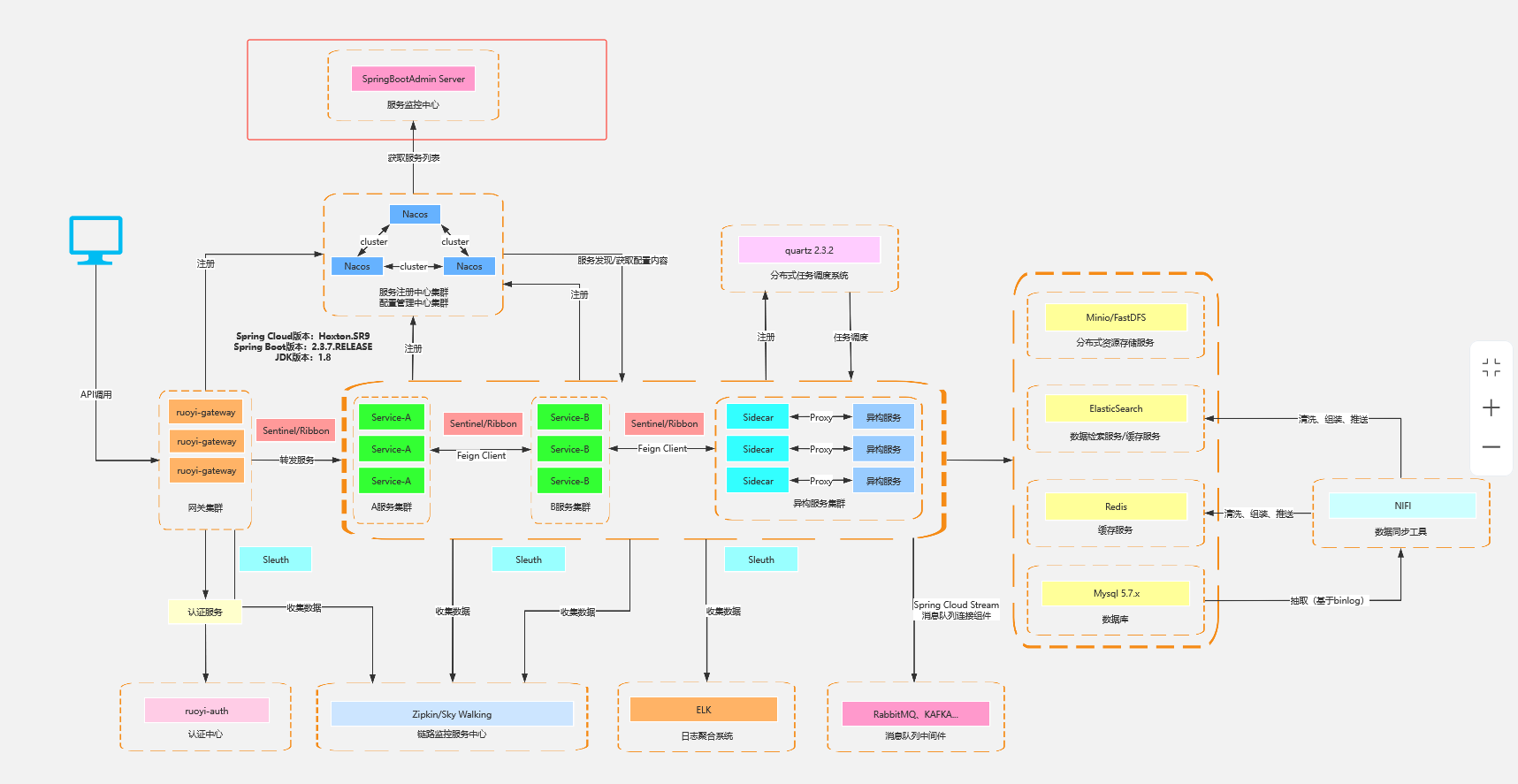

1.微服务架构

将项目所有模块(功能)打成jar或者war,然后部署一个进程

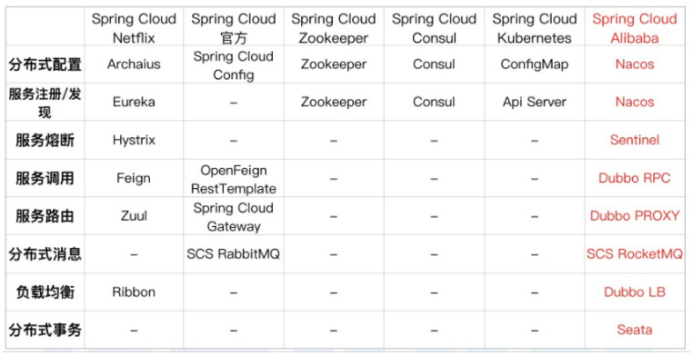

SpringCloud与SpringCloudAlibaba组件

Cloud alibaba

核心组件

服务发现/注册: Eureka Nacos

路由: Zuul Gateway

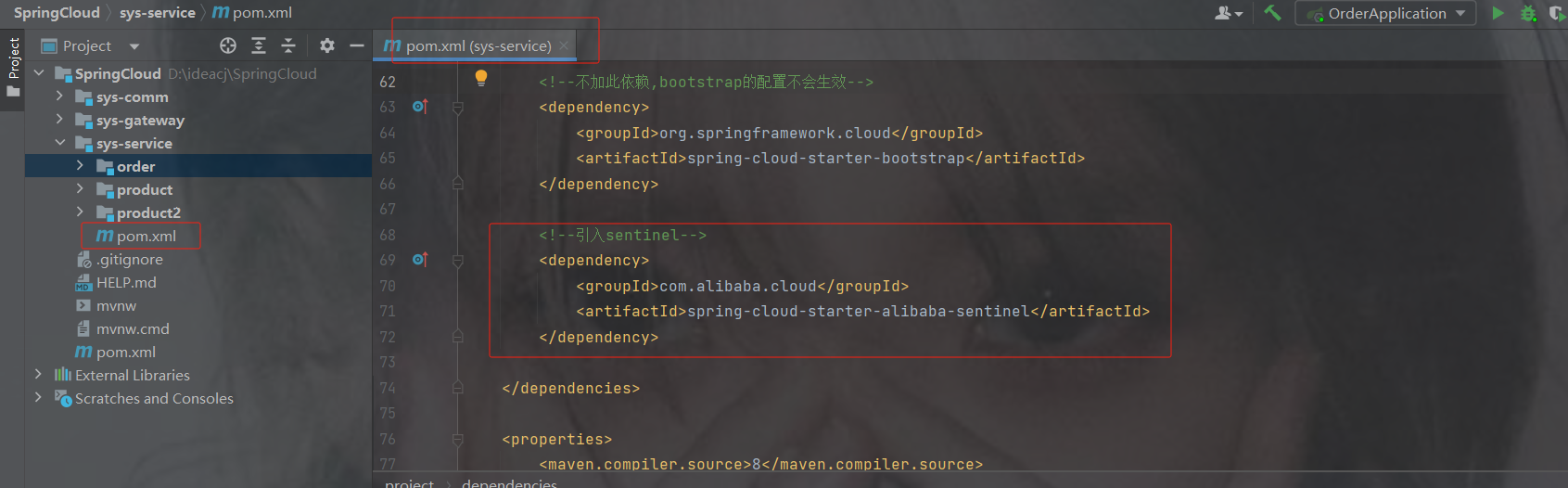

熔断器/断路由: hystrix sentinel

配置中心: config nacos

负载均衡: Ribbon loadbalancer

调用: feign openfeign

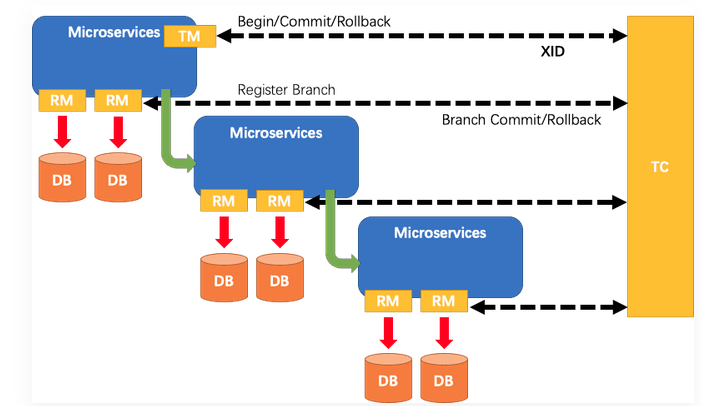

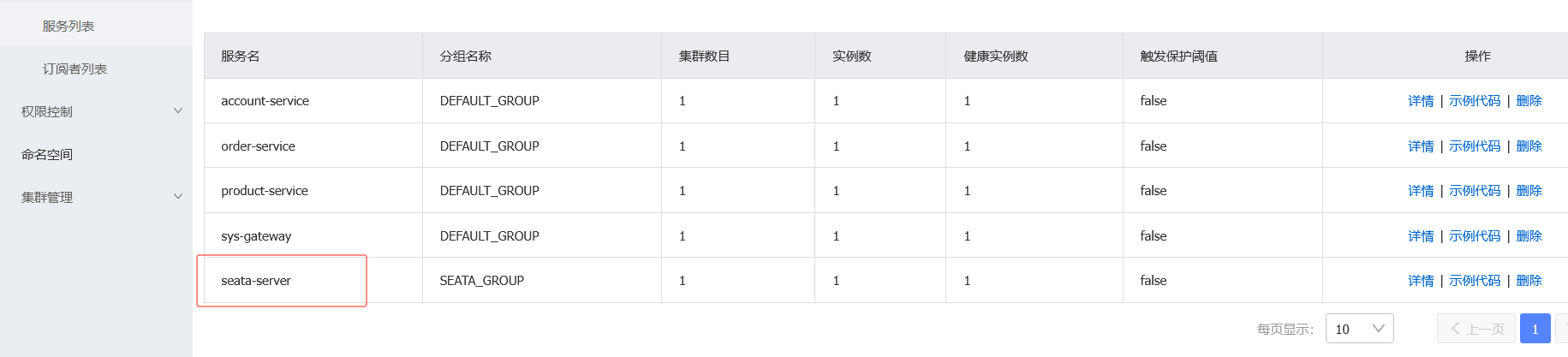

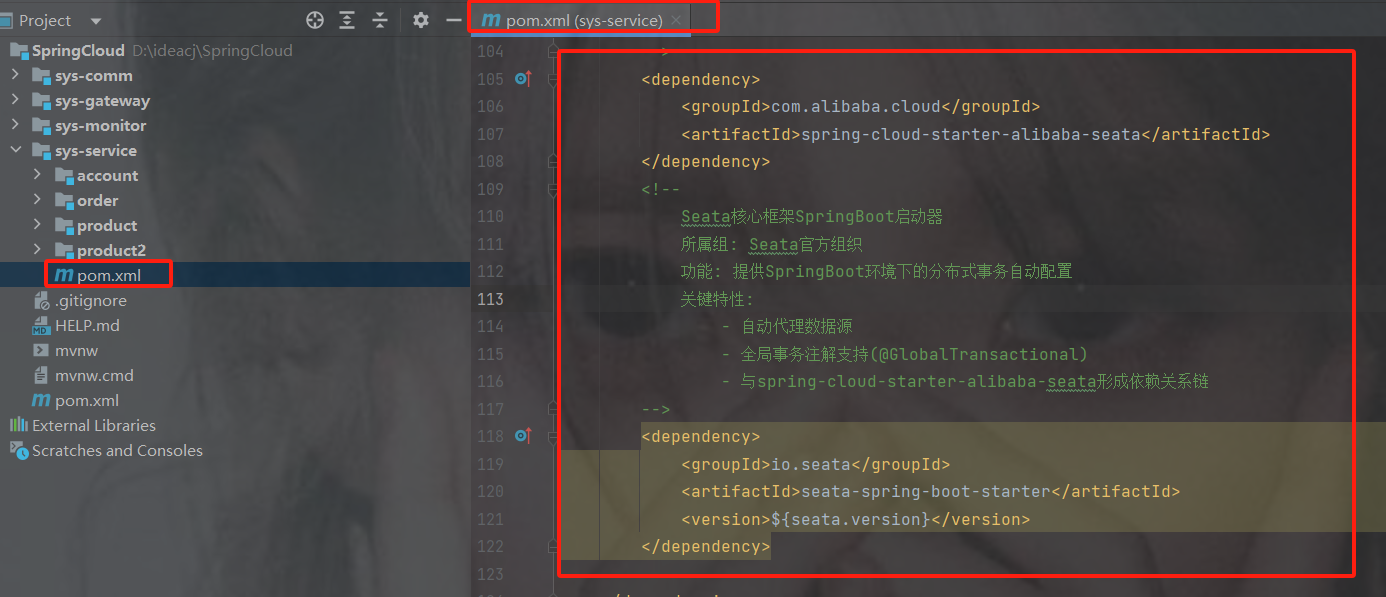

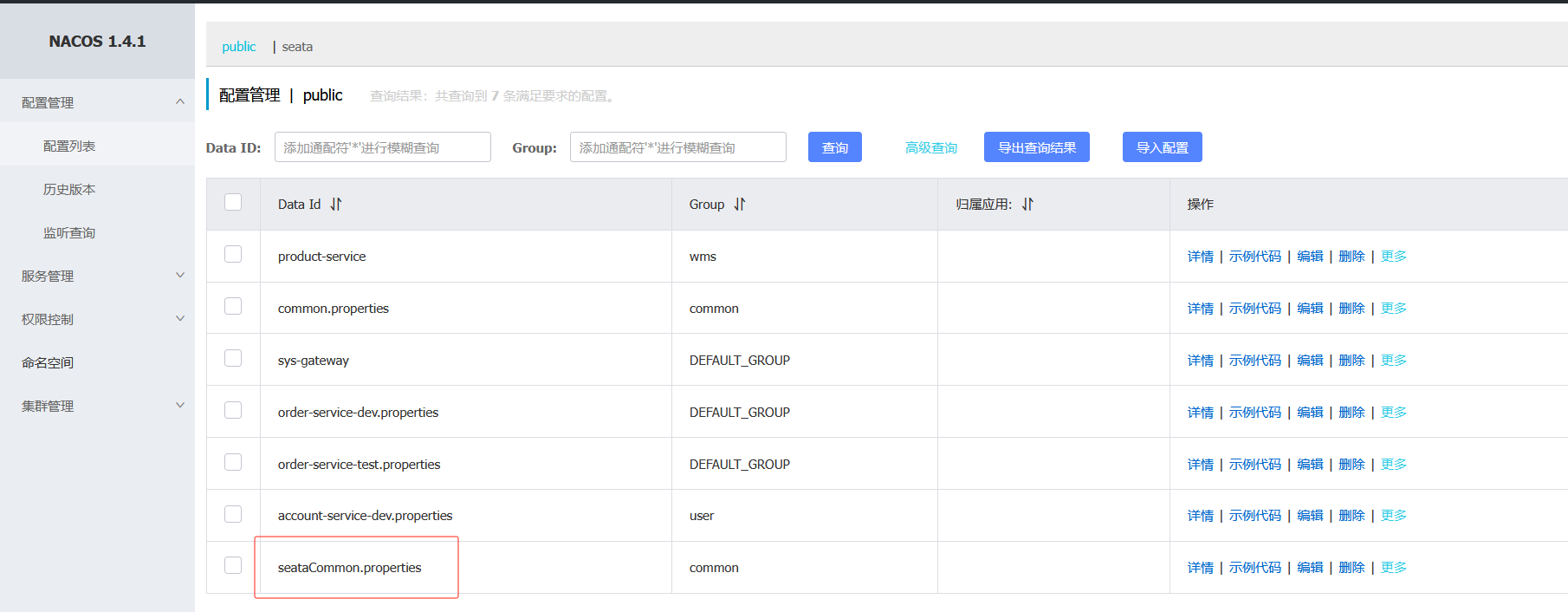

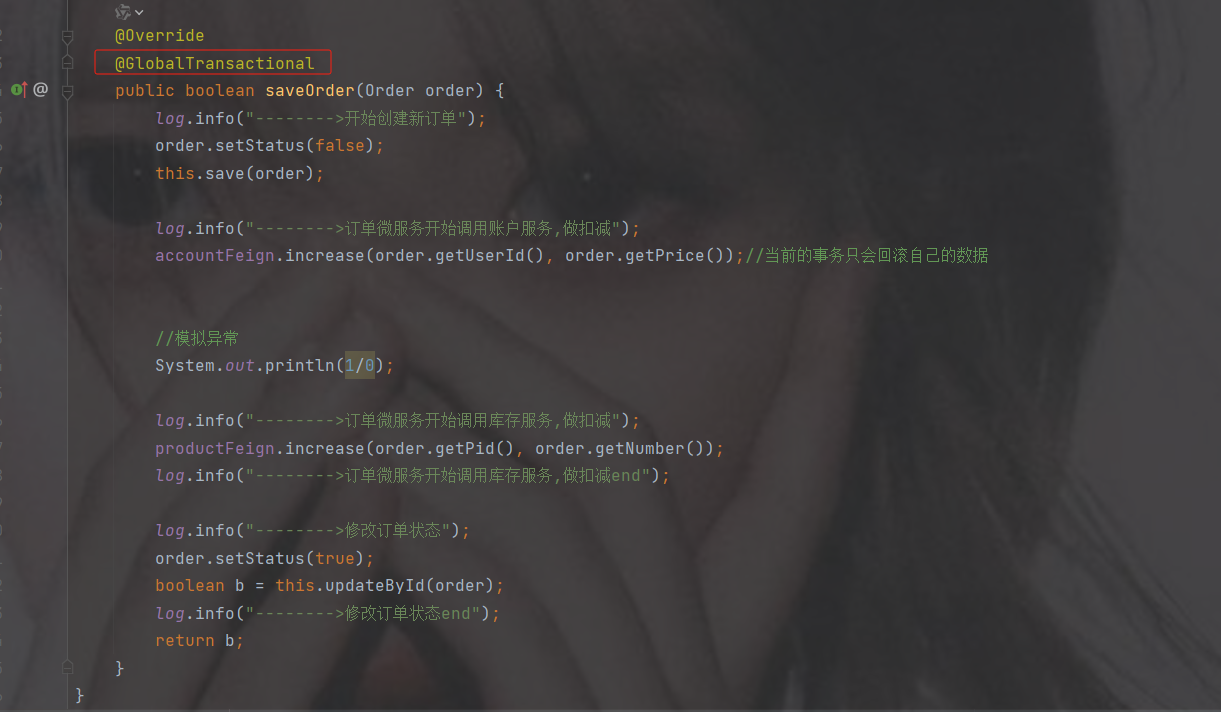

分布式事务: seata(@GlobalTransactional)

问题:

1.这么小服务,如何管理他们

(服务治理 注册中心[服务注册 发现 剔除]):nacos

服务治理就是进行服务的自动化管理,其核心是服务的自动注册与发现。

服务注册:服务实例将自身服务信息注册到注册中心。

服务发现:服务实例通过注册中心,获取到注册到其中的服务实例的信息,通过这些信息去请求它们提 供的服务

服务剔除:服务注册中心将出问题的服务自动剔除到可用列表之外,使其不会被调用到

2.这么多小服务,它们之间如何通讯

Openfeign/dubbo 远程调用

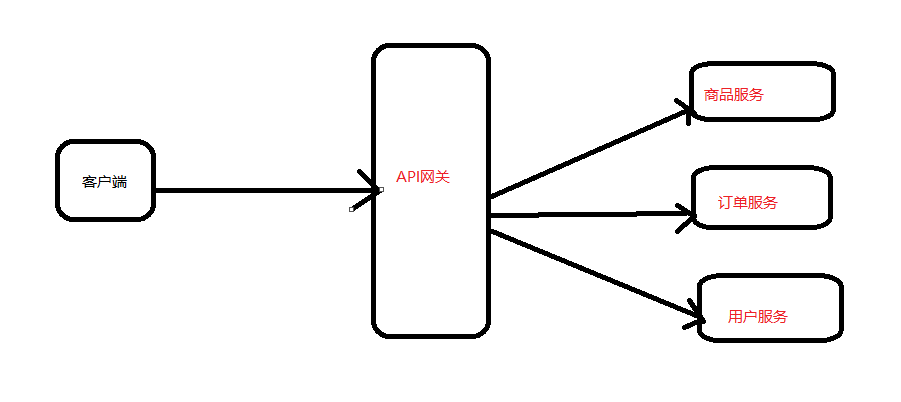

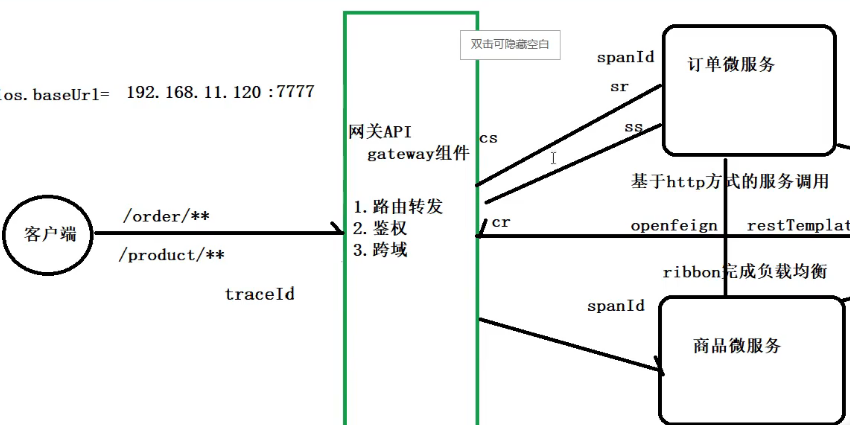

3.这么多小服务,客户端怎么访问他们

(网关 GateWay)

随着微服务的不断增多,不同的微服务一般会有不同的网络地址,而外部客户端可能需要调用多个 服务的接口才能完成一个业务需求,如果让客户端直接与各个微服务通信可能出现:

- 客户端需要调用不同的url地址,增加难度

- 在一定的场景下,存在跨域请求的问题

- 每个微服务都需要进行单独的身份认证

针对这些问题,API网关顺势而生。 API网关直面意思是将所有API调用统一接入到API网关层,由网关层统一接入和输出。一个网关的 基本功能有:统一接入、安全防护、协议适配、流量管控、长短链接支持、容错能力。有了网关之后, 各个API服务提供团队可以专注于自己的的业务逻辑处理,而API网关更专注于安全、流量、路由等问 题

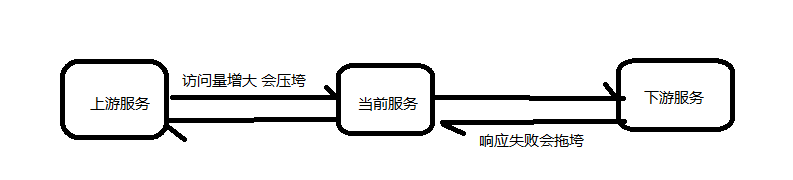

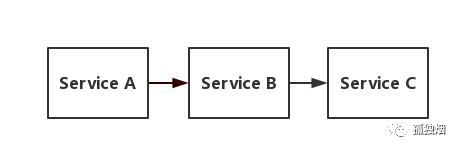

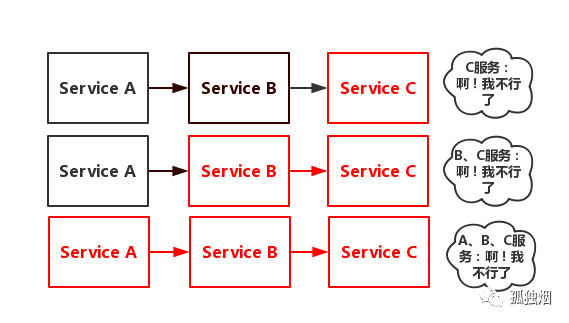

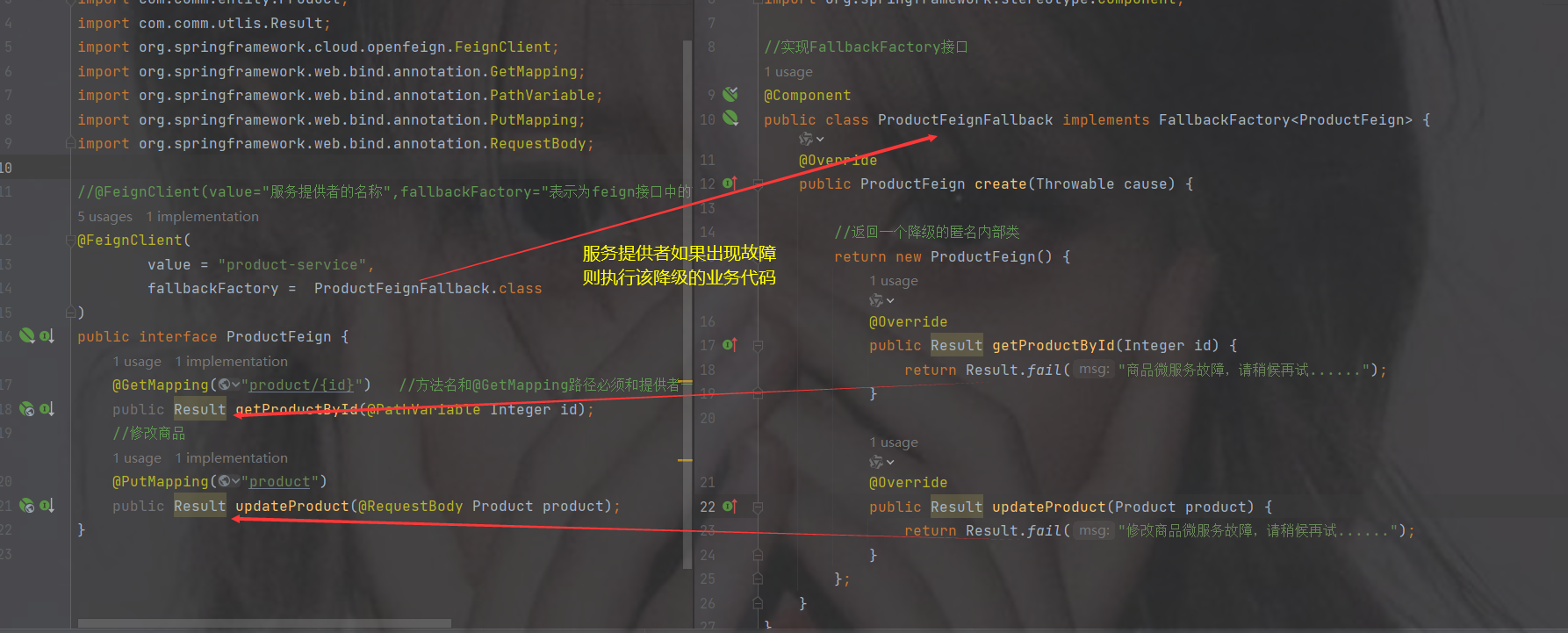

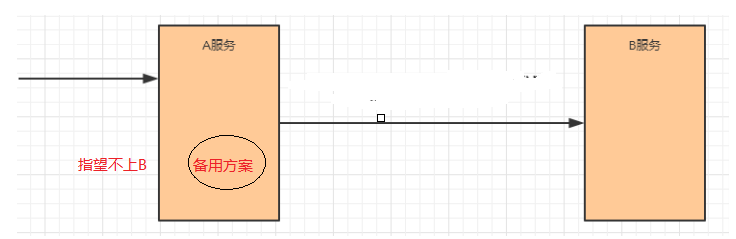

4.这么多小服务,一旦出现问题了,应该如何自处理?

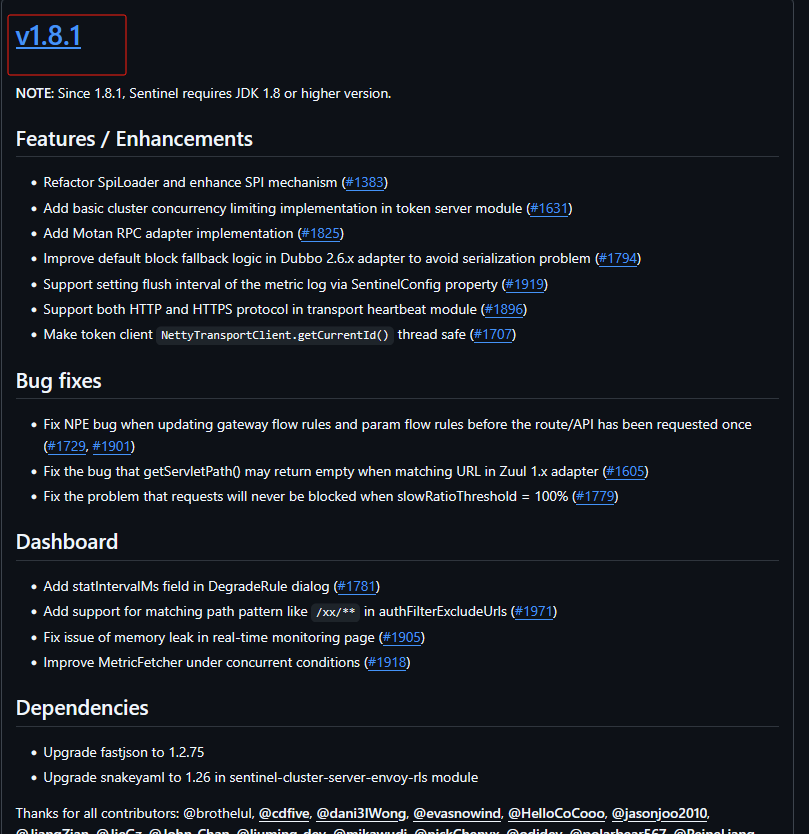

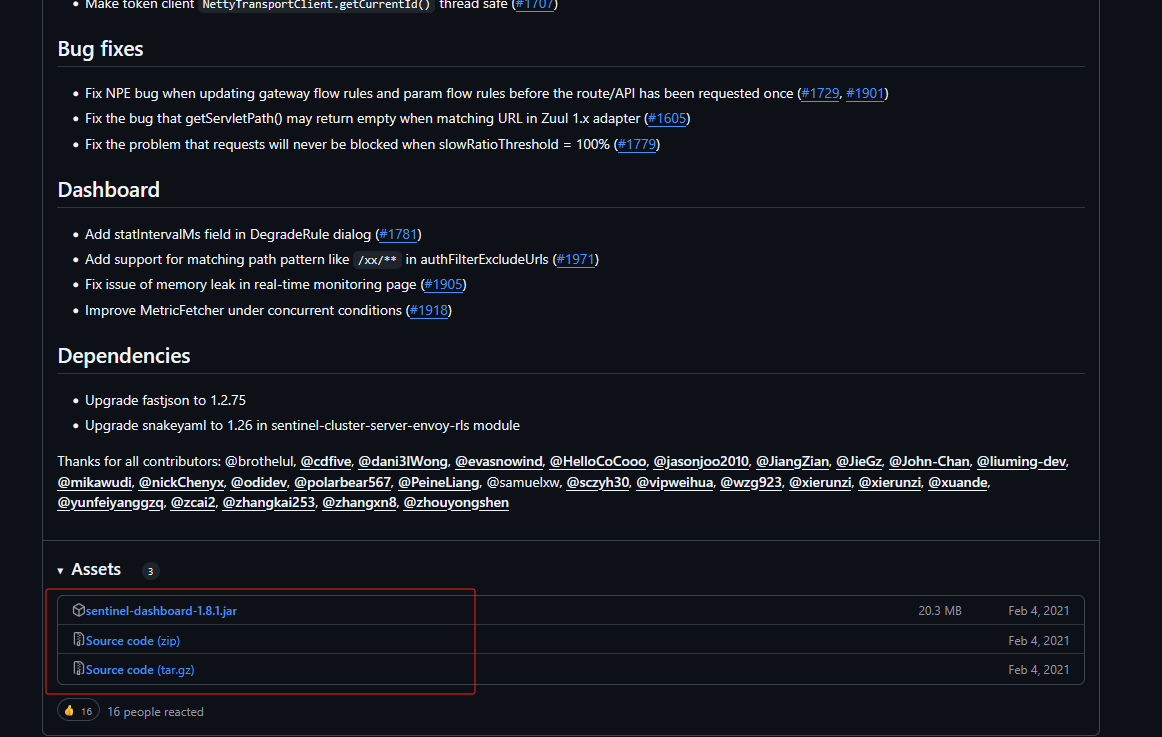

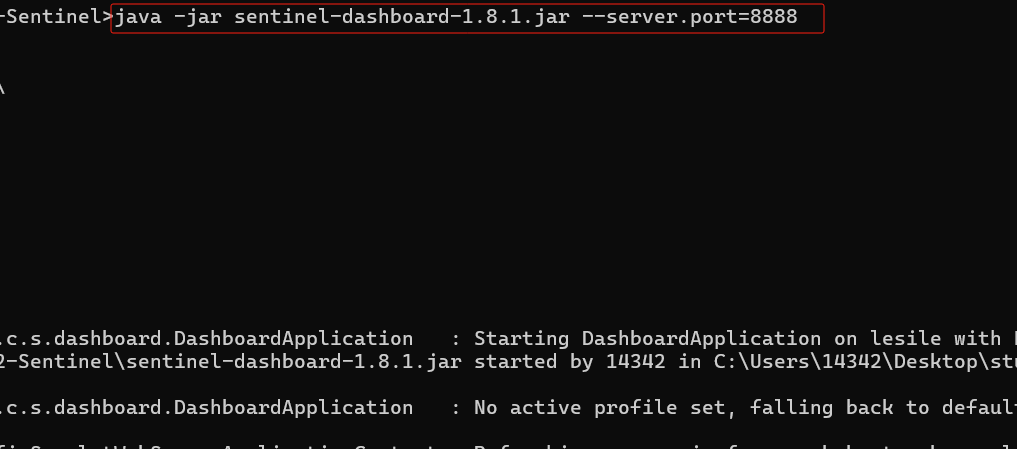

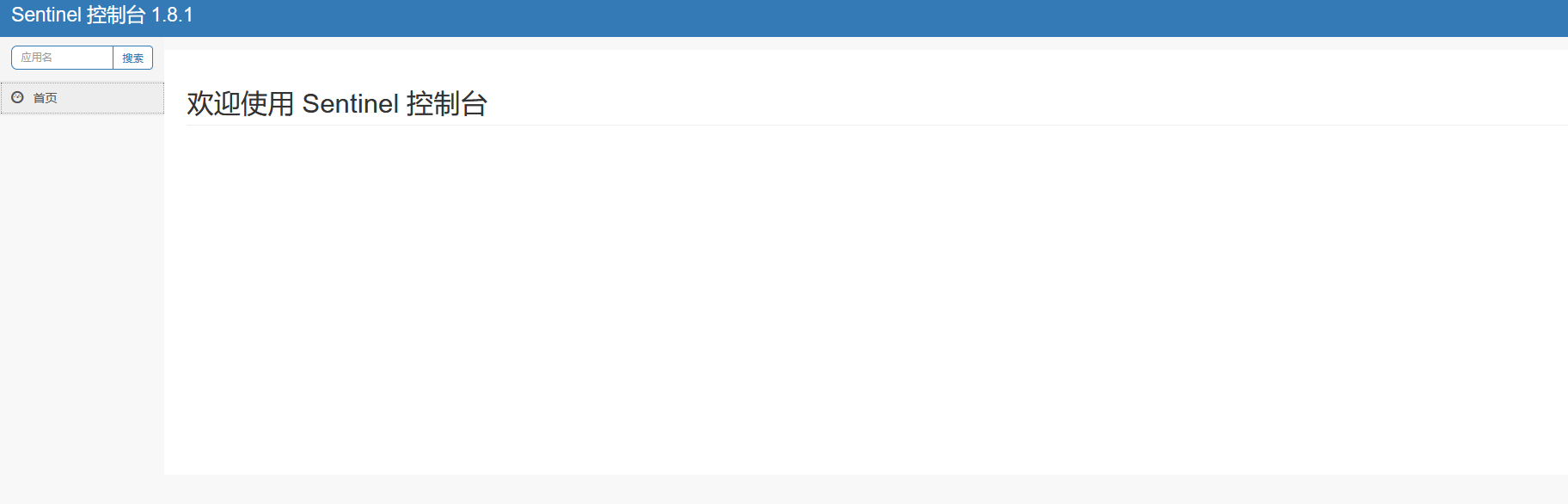

服务熔断sentinel

有兜底的措施 (容错)fallback

比如服务之间调用A->B->C->D D出了问题,那么C就会一直发会挤压过多导致C也崩了,B一直发请求,跟雪崩一样

在微服务当中,一个请求经常会涉及到调用几个服务,如果其中某个服务不可用,没有做服务容错 的话,极有可能会造成一连串的服务不可用,这就是雪崩效应。 我们没法预防雪崩效应的发生,只能尽可能去做好容错。

服务容错的两个核心思想是:

- 不被上游请求压垮---比如服务器请求只能接收300,但是来了5000个请求---sentinel(限流上限等待)

- 不被下游响应拖垮---响应失败---sentinel熔断(兜底措施)

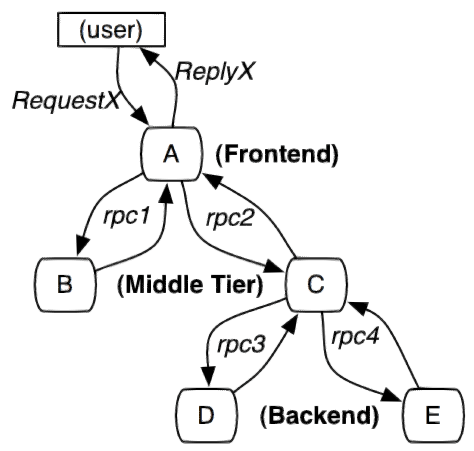

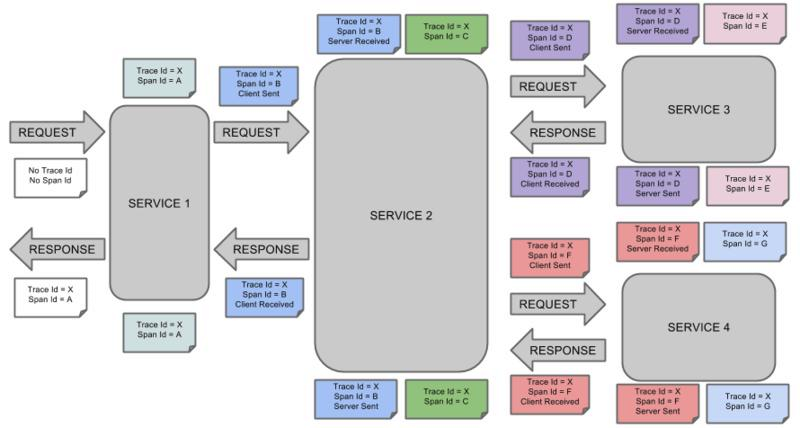

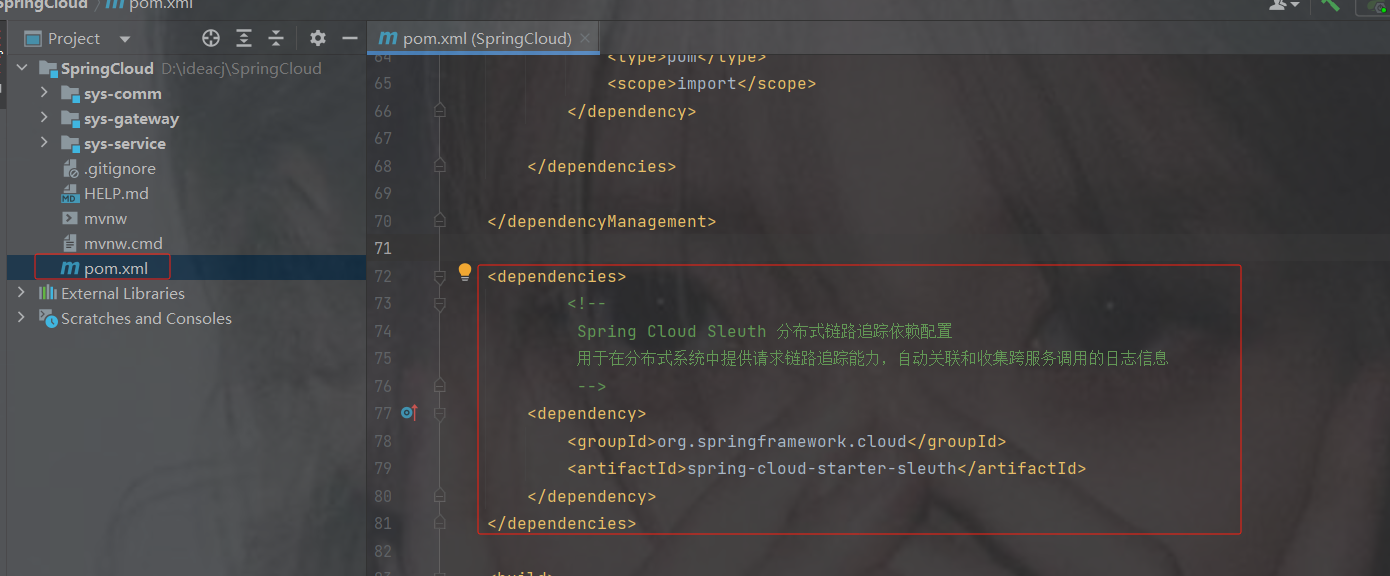

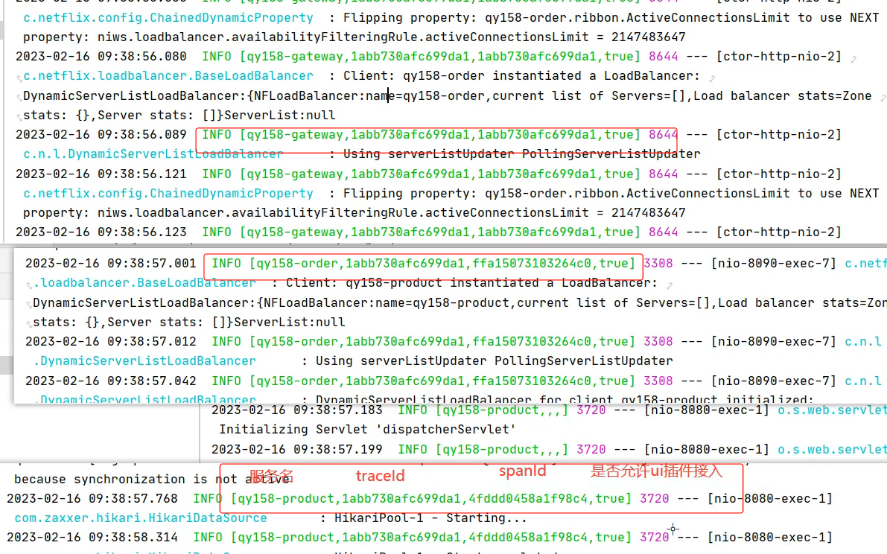

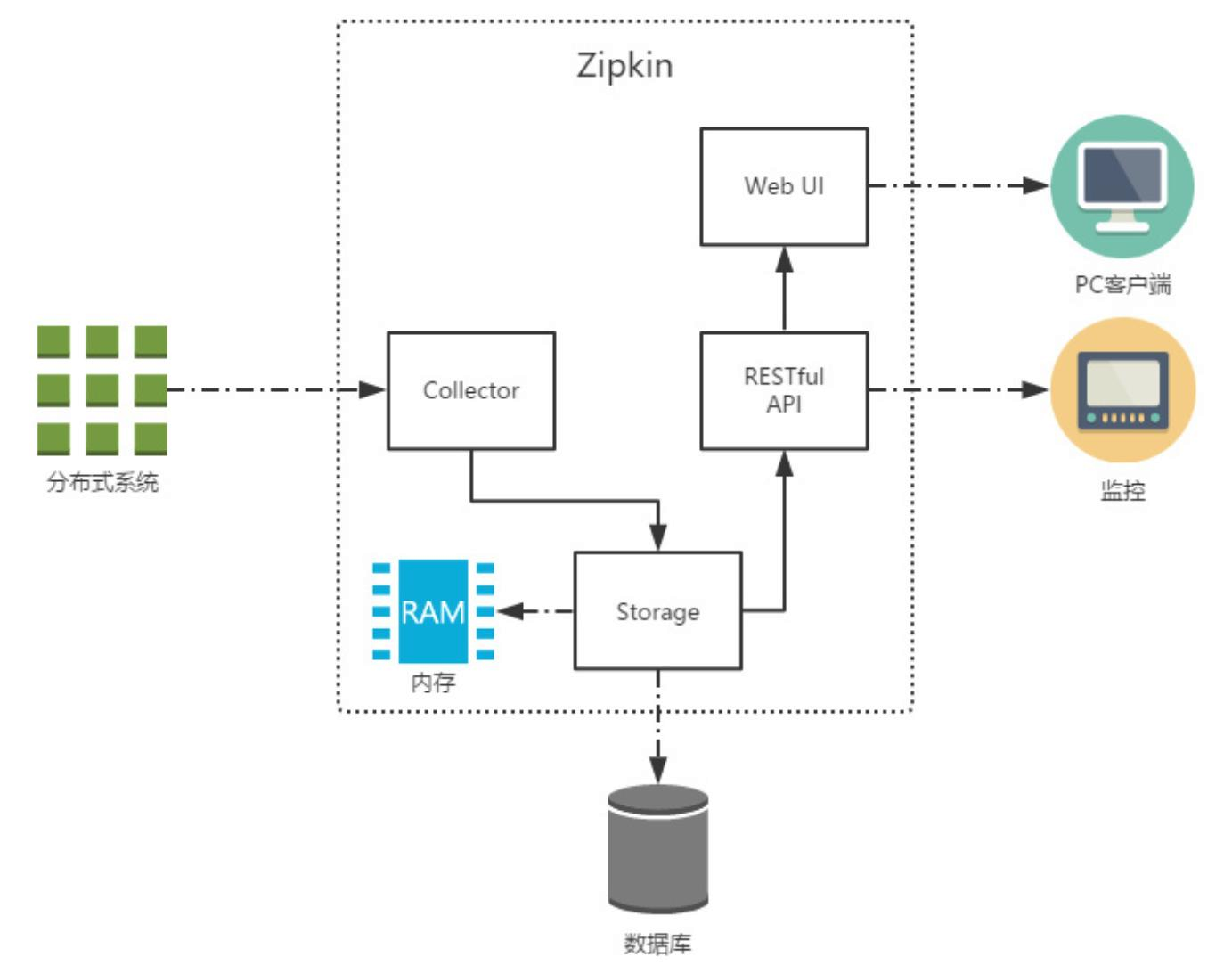

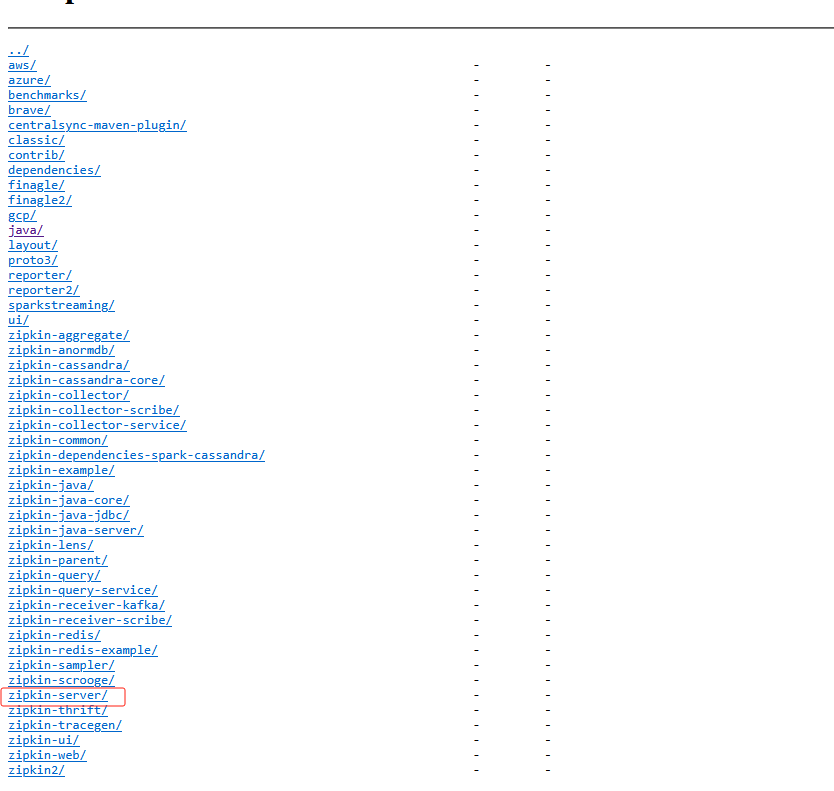

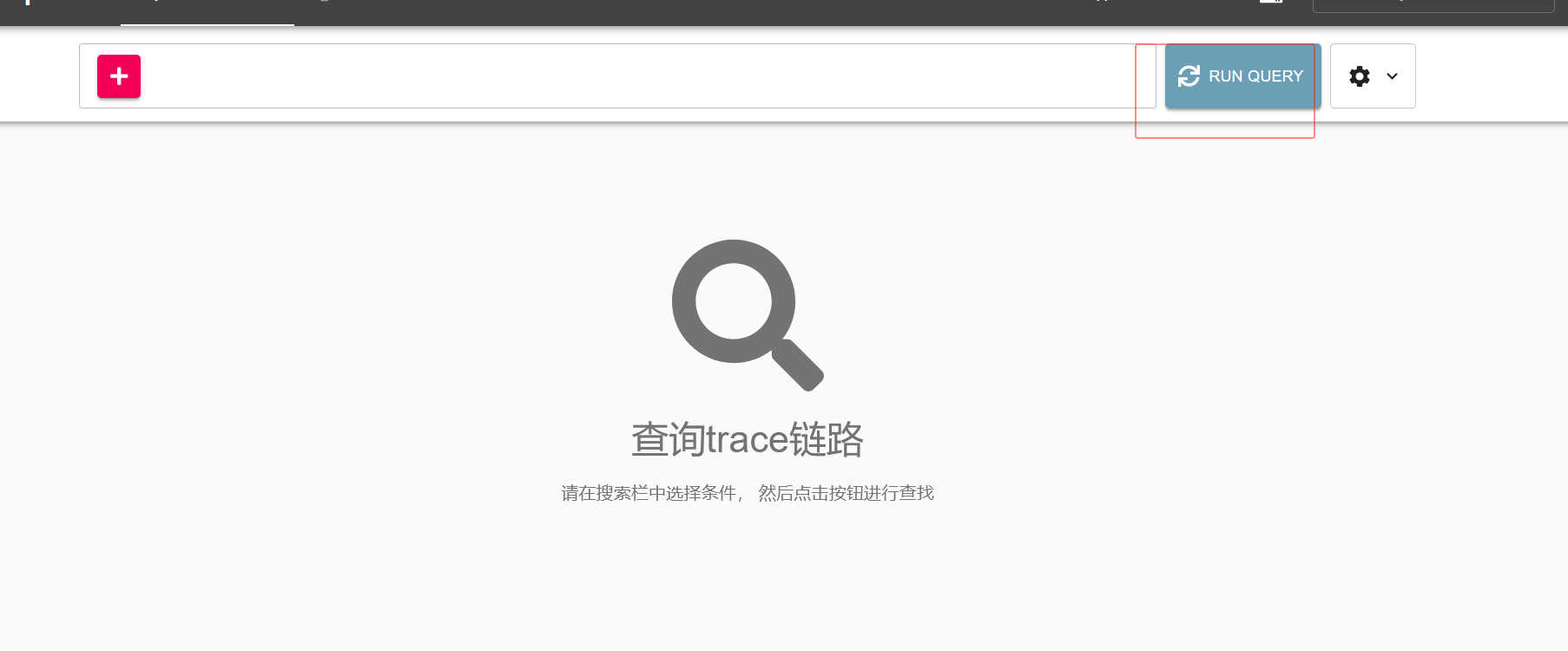

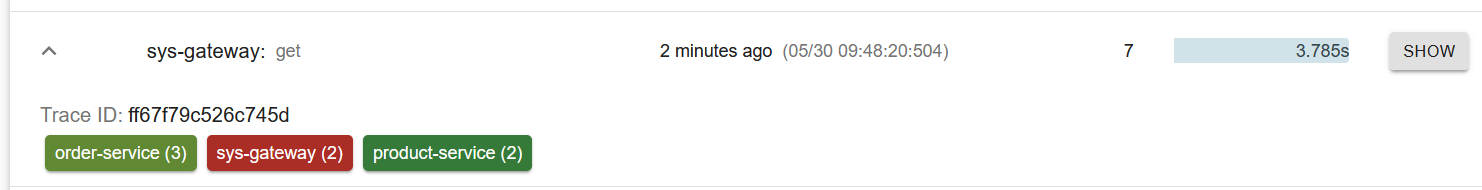

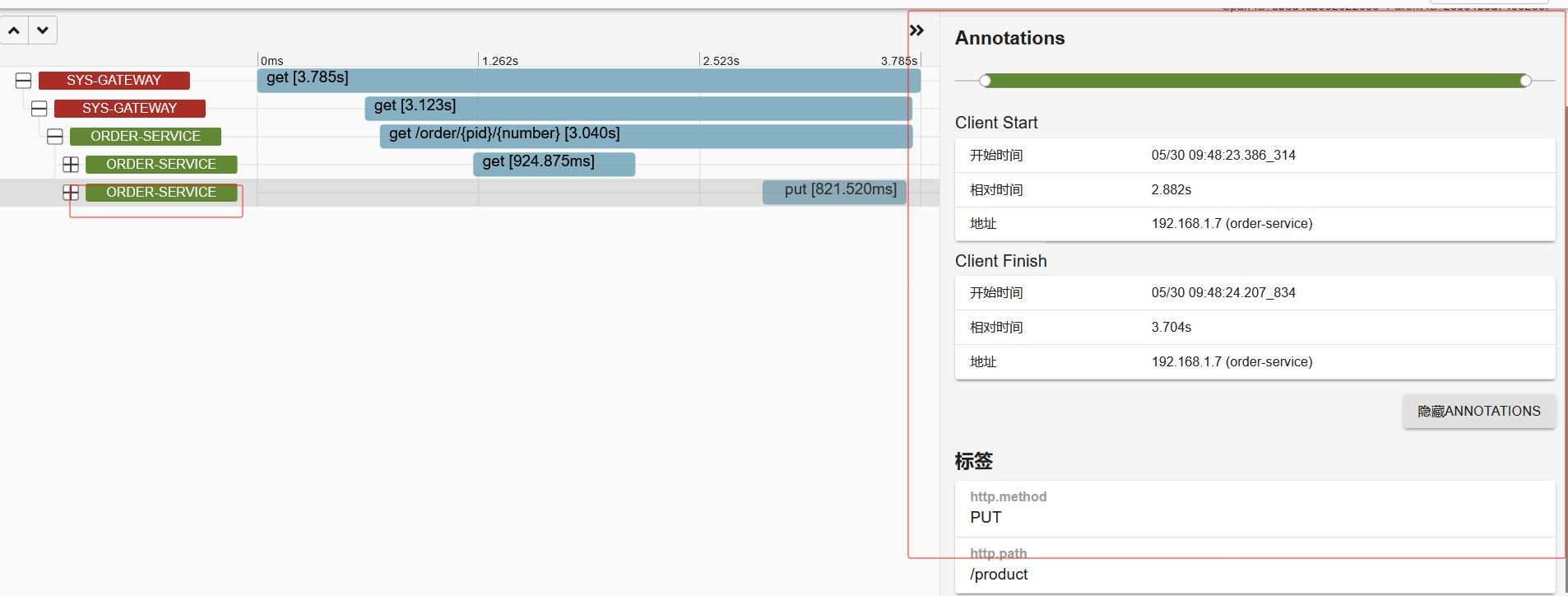

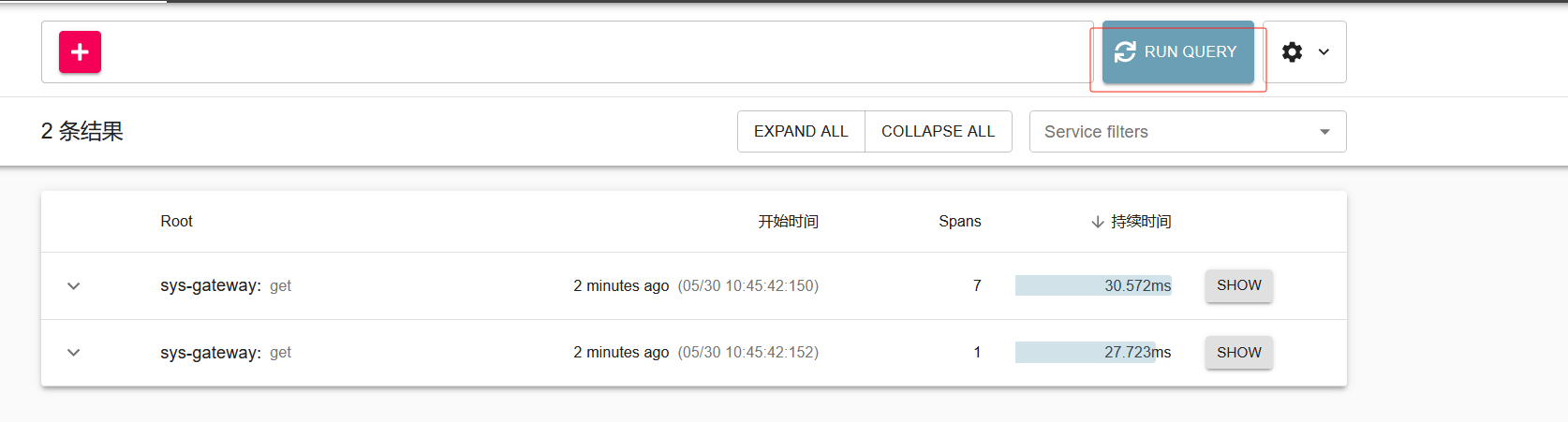

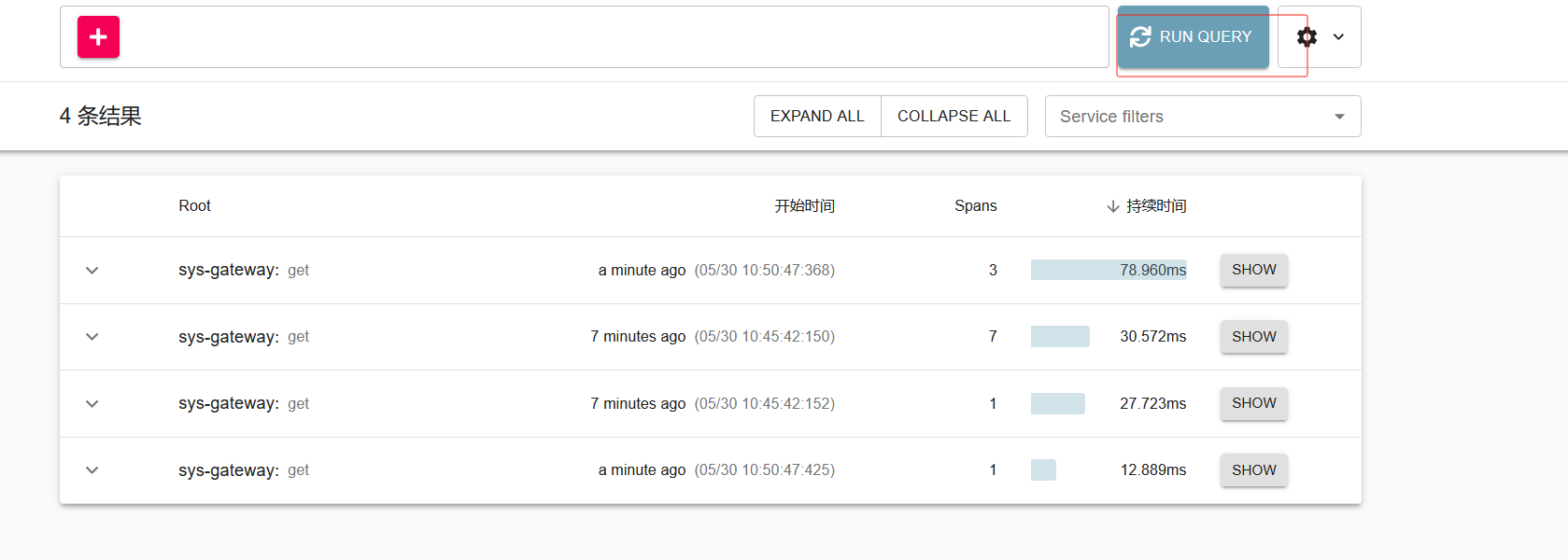

5.这么多小服务,一旦出现问题,应该如何排错

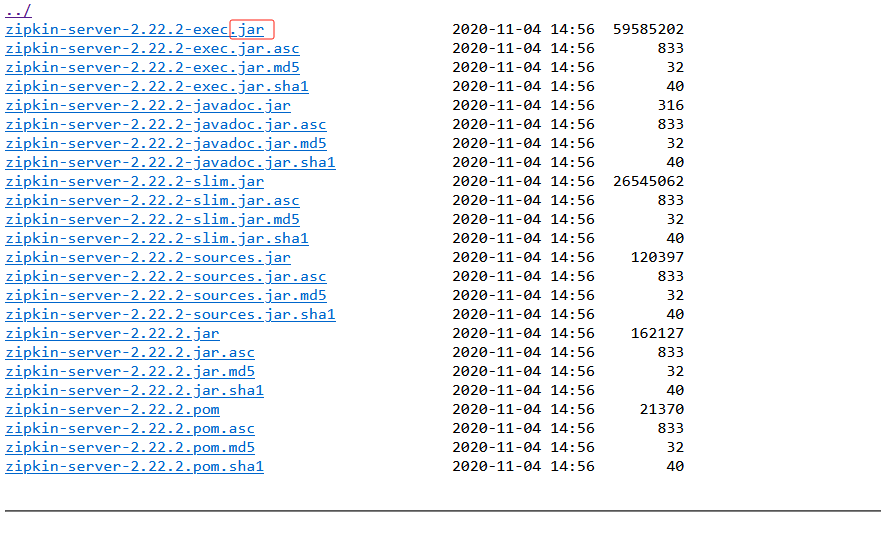

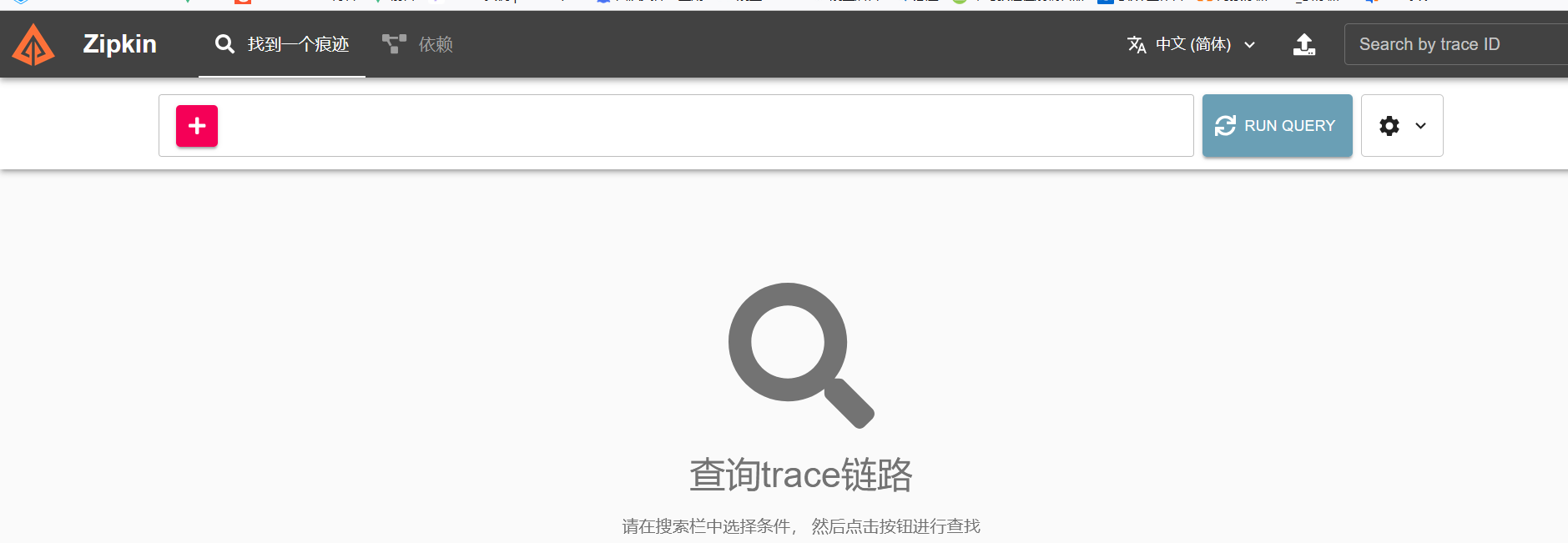

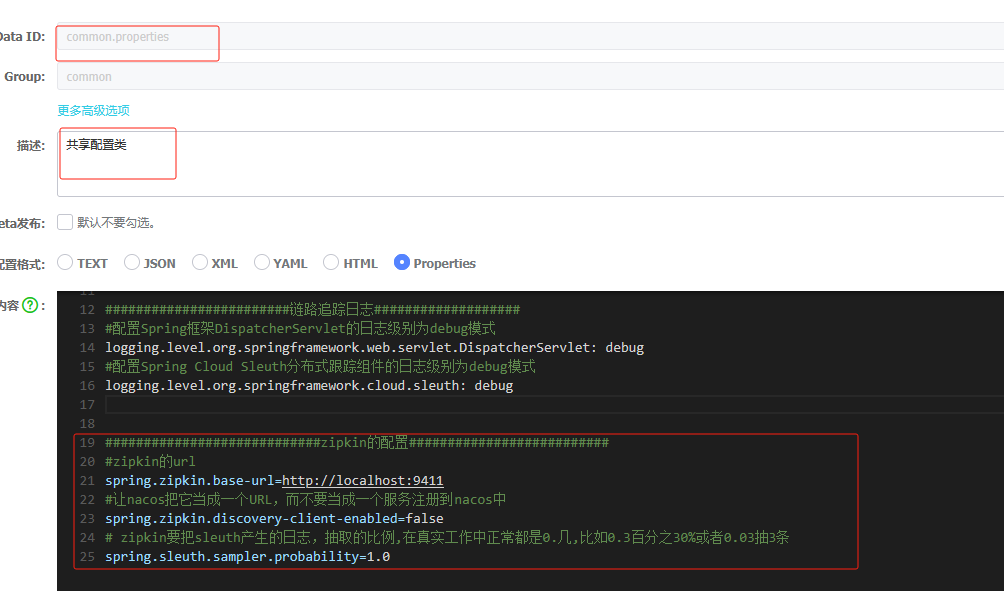

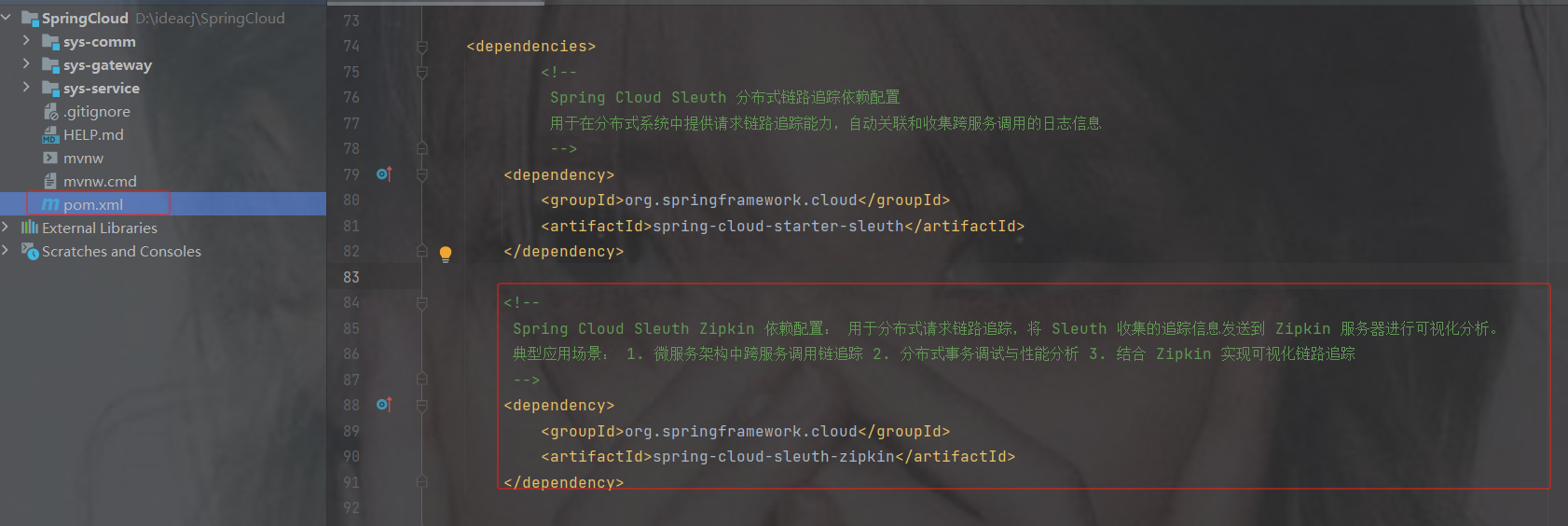

(链路追踪) sluth zipkin

随着微服务架构的流行,服务按照不同的维度进行拆分,一次请求往往需要涉及到多个服务。互联 网应用构建在不同的软件模块集上,这些软件模块,有可能是由不同的团队开发、可能使用不同的编程 语言来实现、有可能布在了几千台服务器,横跨多个不同的数据中心。因此,就需要对一次请求涉及的 多个服务链路进行日志记录,性能监控即链路追踪

2.微服务环境搭建

2.1 微服务环境搭建

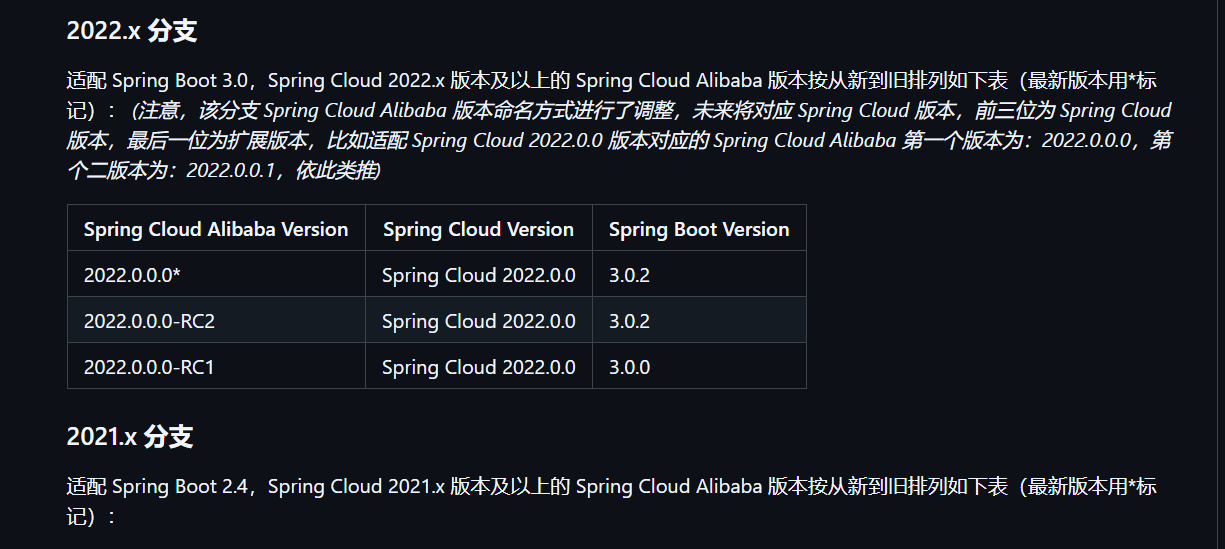

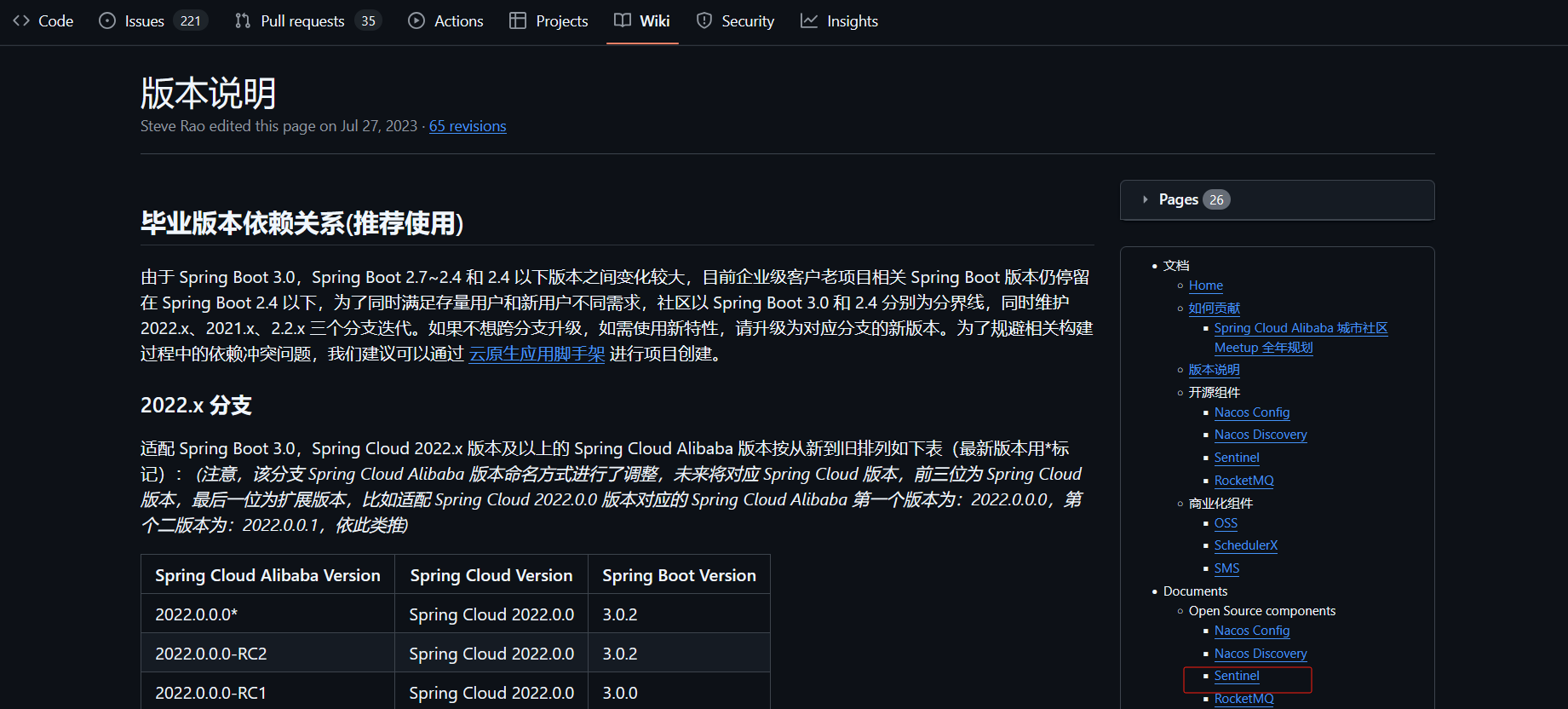

版本依赖

最新的版本对应关系可以参考网址:

版本说明 · alibaba/spring-cloud-alibaba Wiki

组件版本关系

每个 Spring Cloud Alibaba 版本及其自身所适配的各组件对应版本(注意,Spring Cloud Dubbo 从 2021.0.1.0 起已被移除出主干,不再随主干演进)

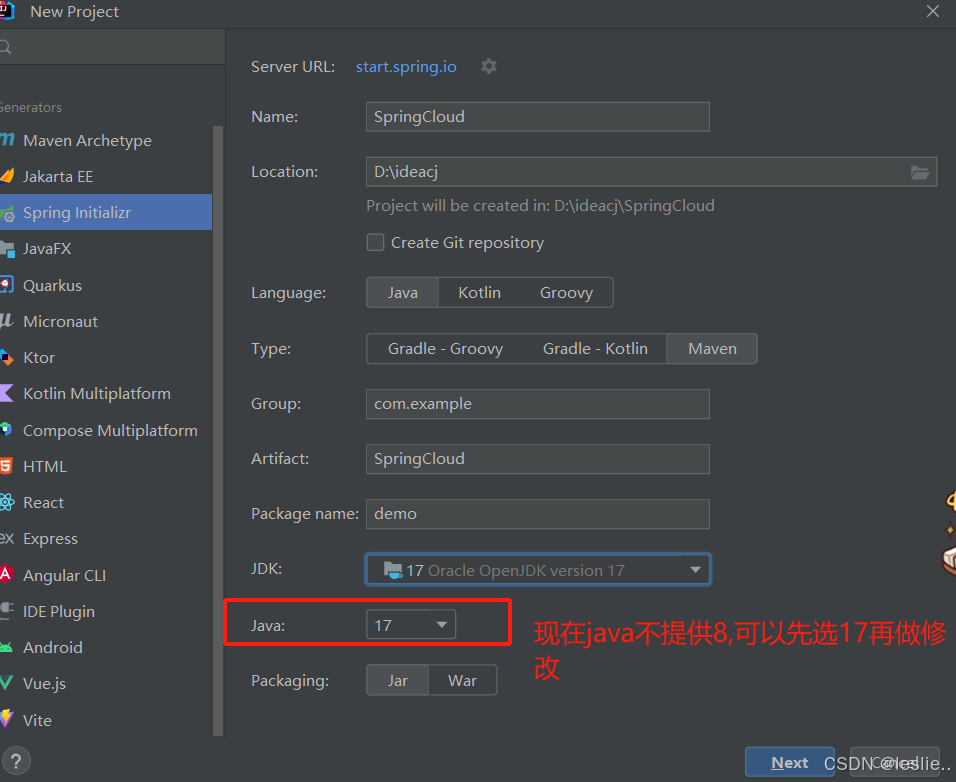

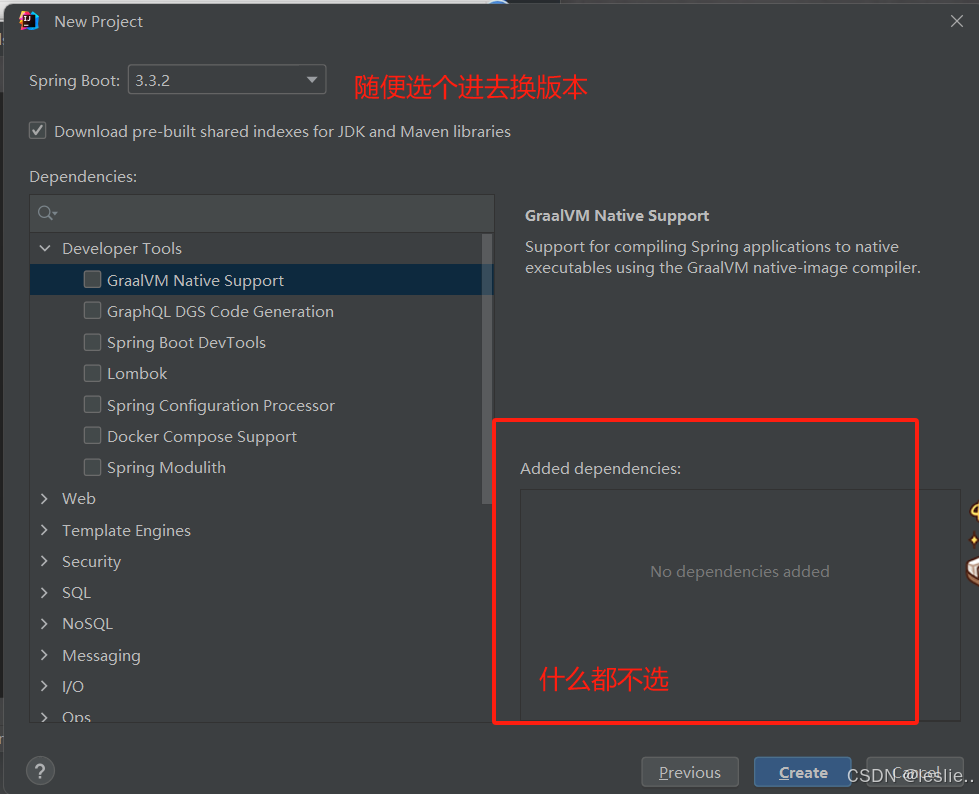

2.2 创建父工程

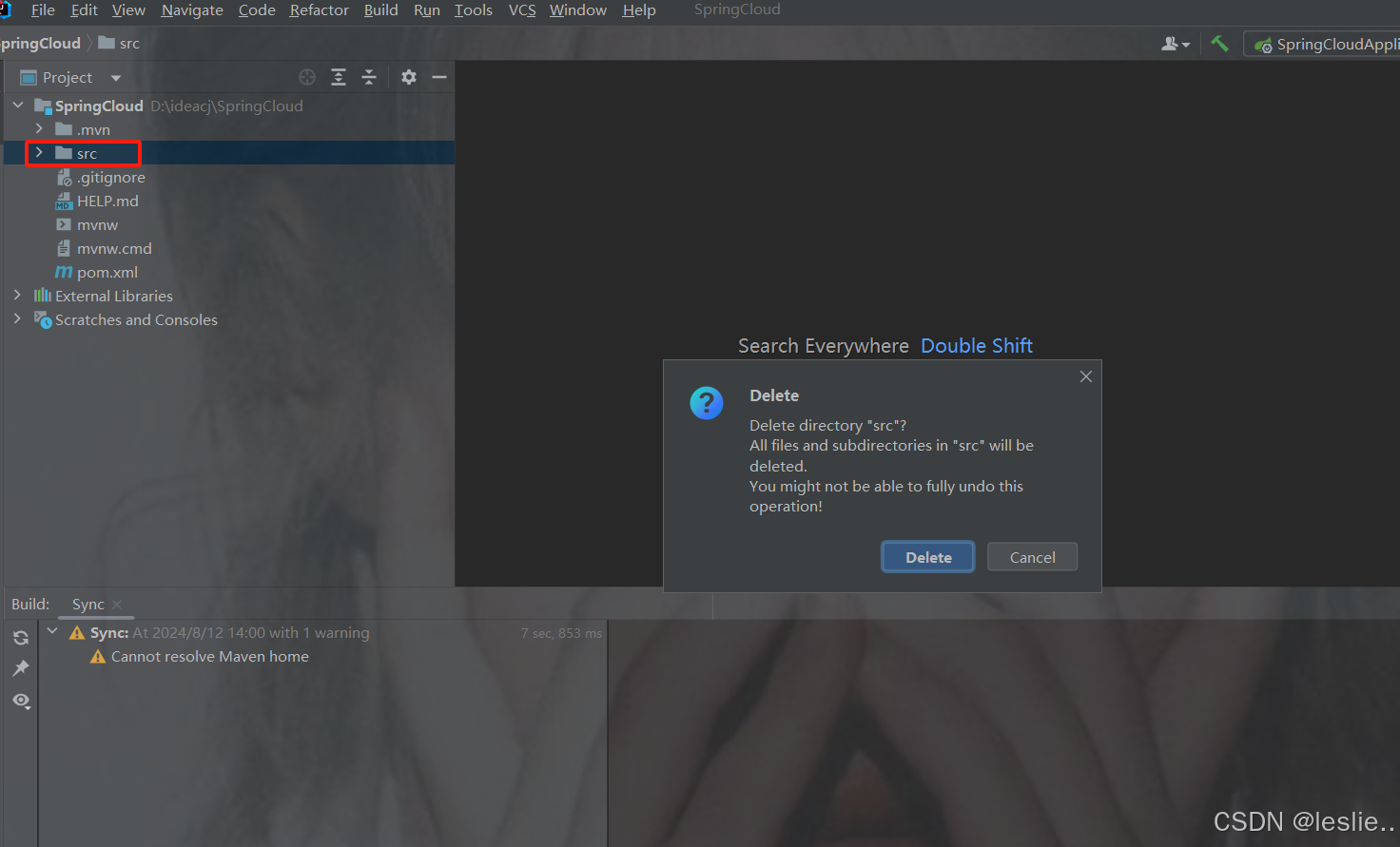

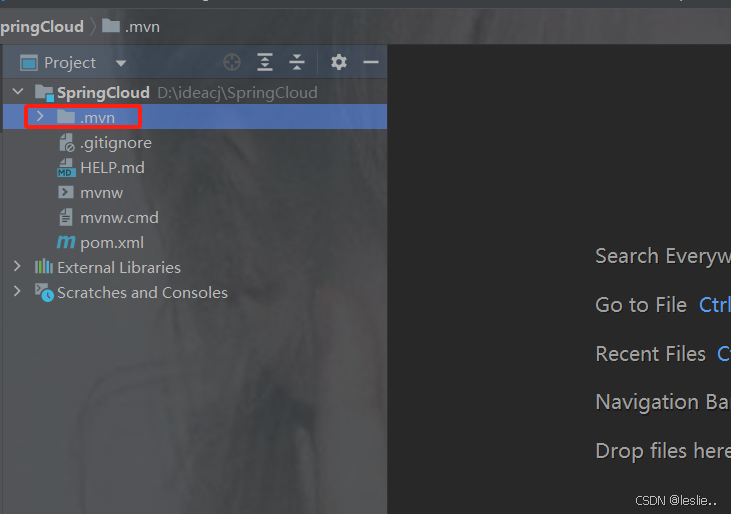

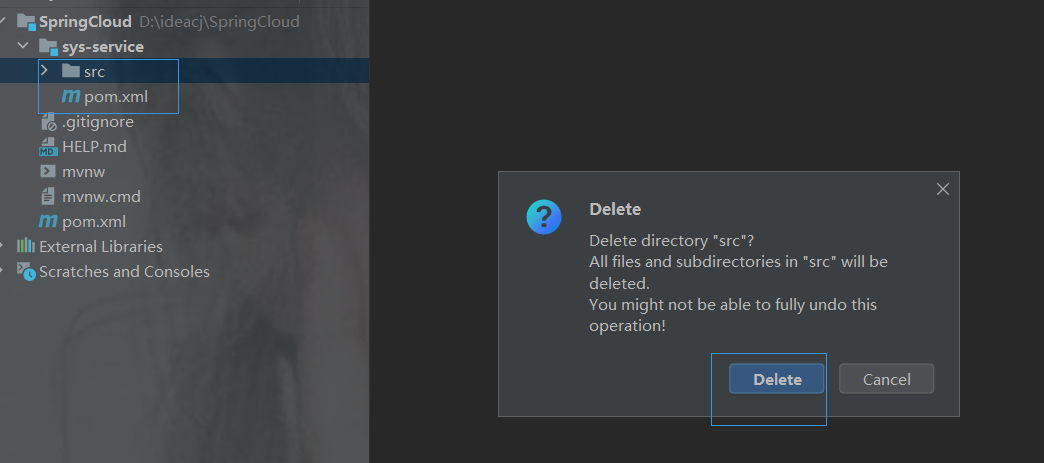

删除src

删除.mvn

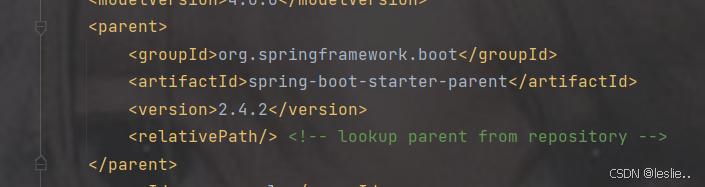

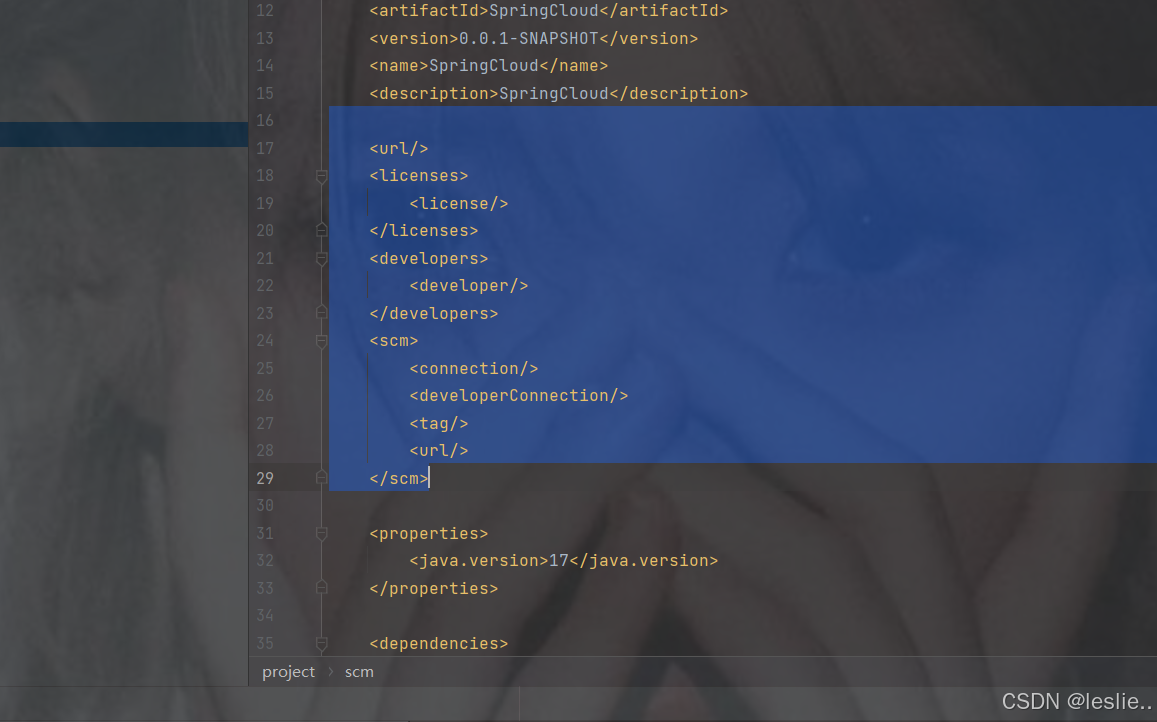

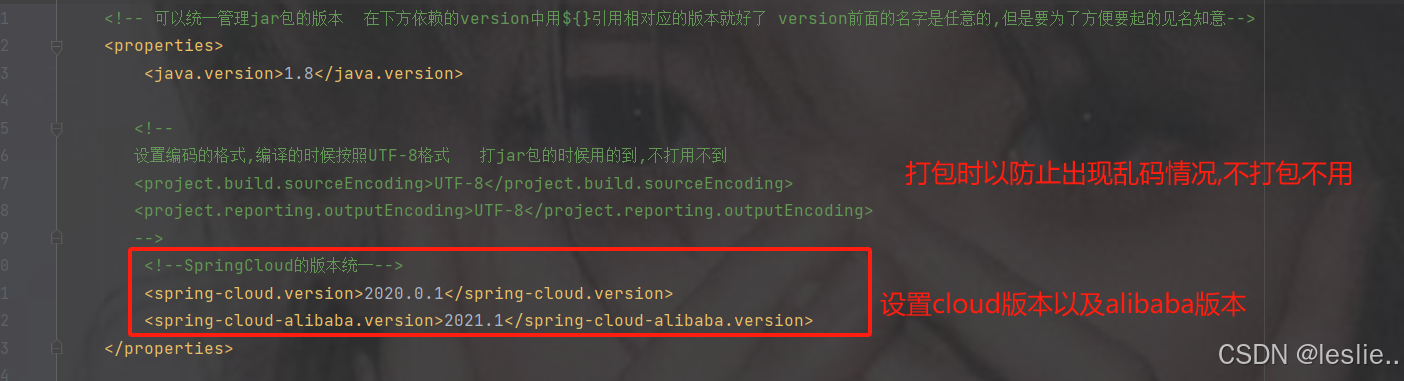

pom.xml里更换springboot的版本

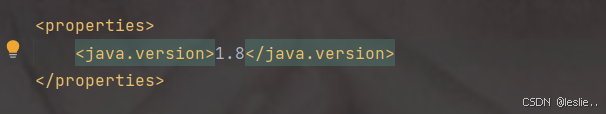

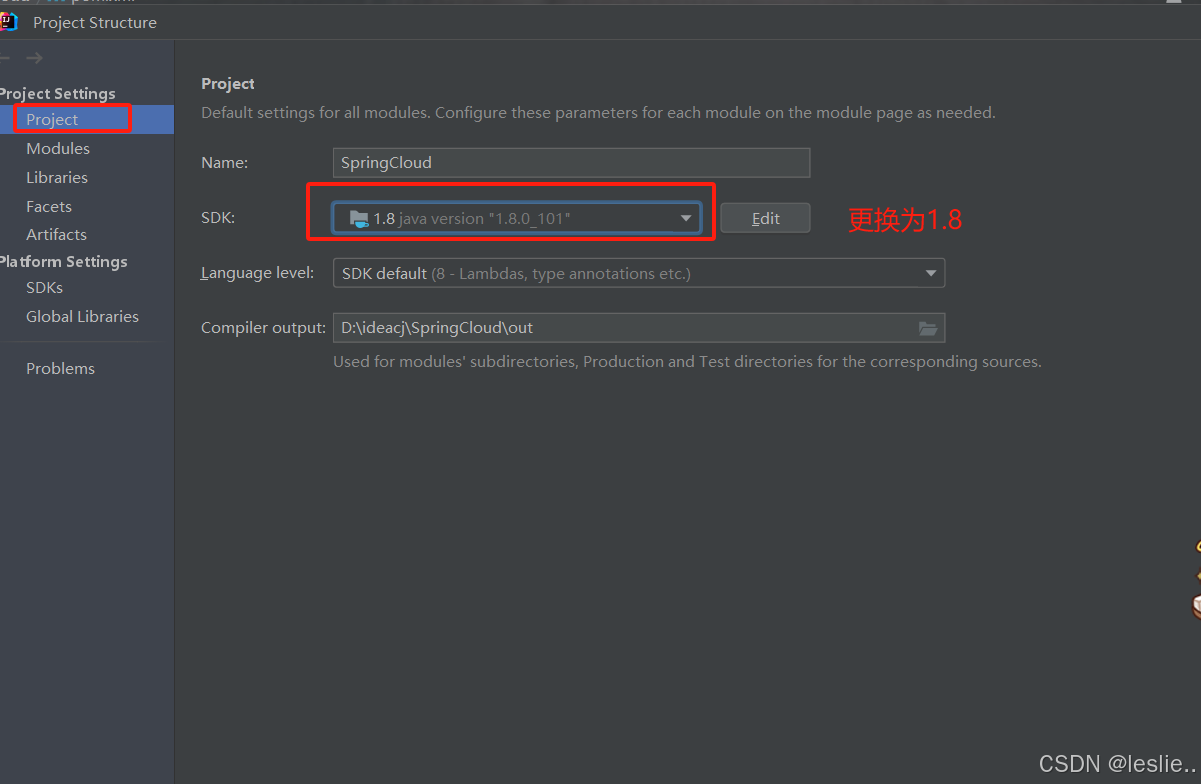

更换java版本

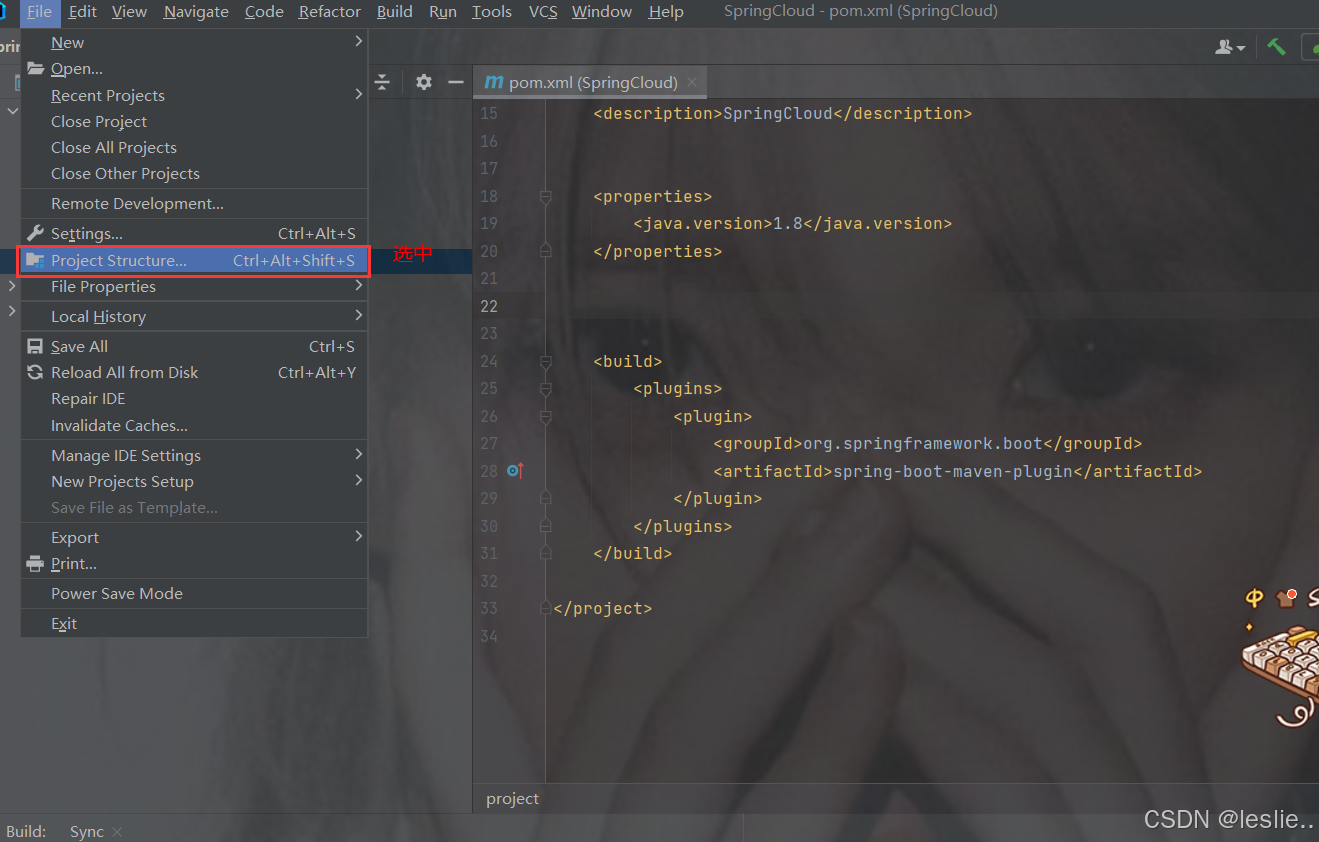

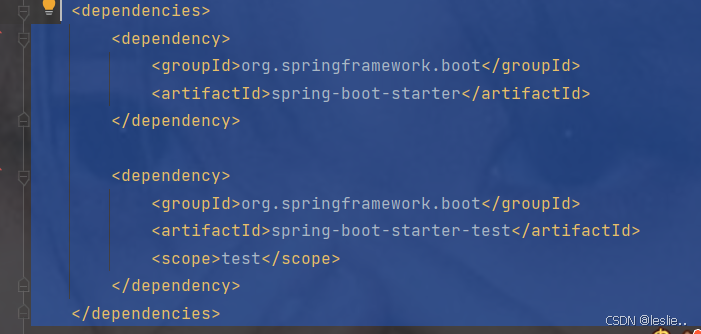

选中的删掉

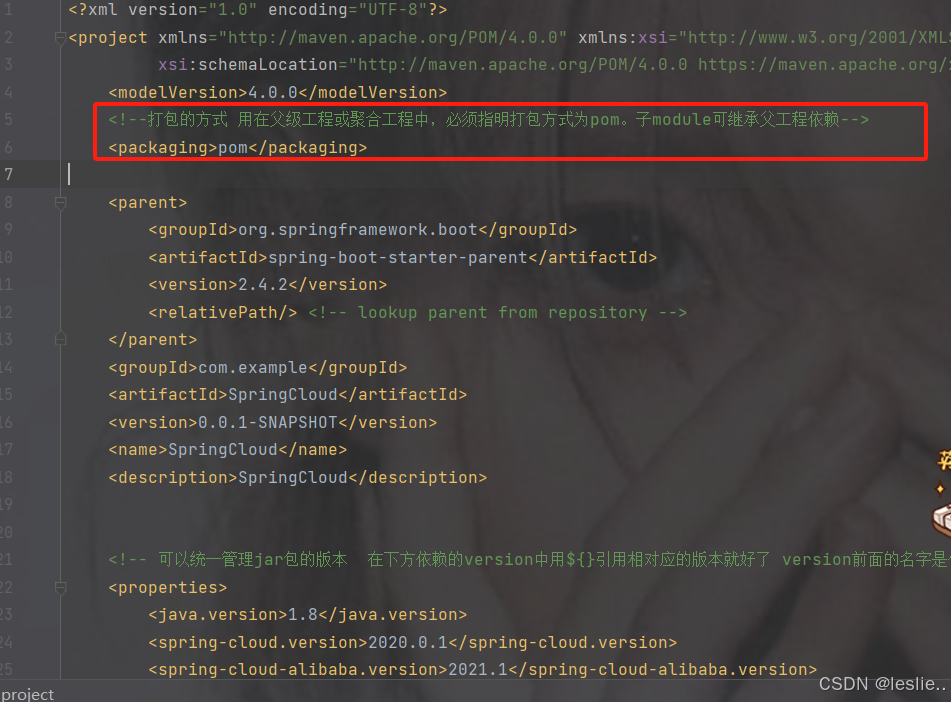

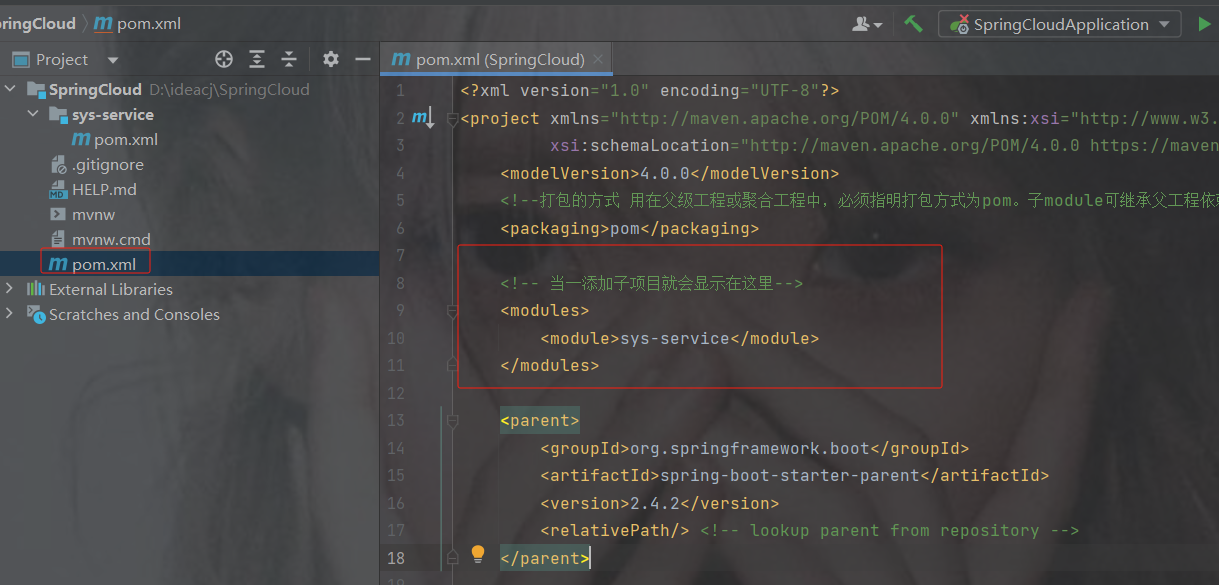

如果是cloud项目,那么打包方式

pom:用在父级工程或聚合工程中,必须指明打包方式为pom。子module可继承父工程依赖。

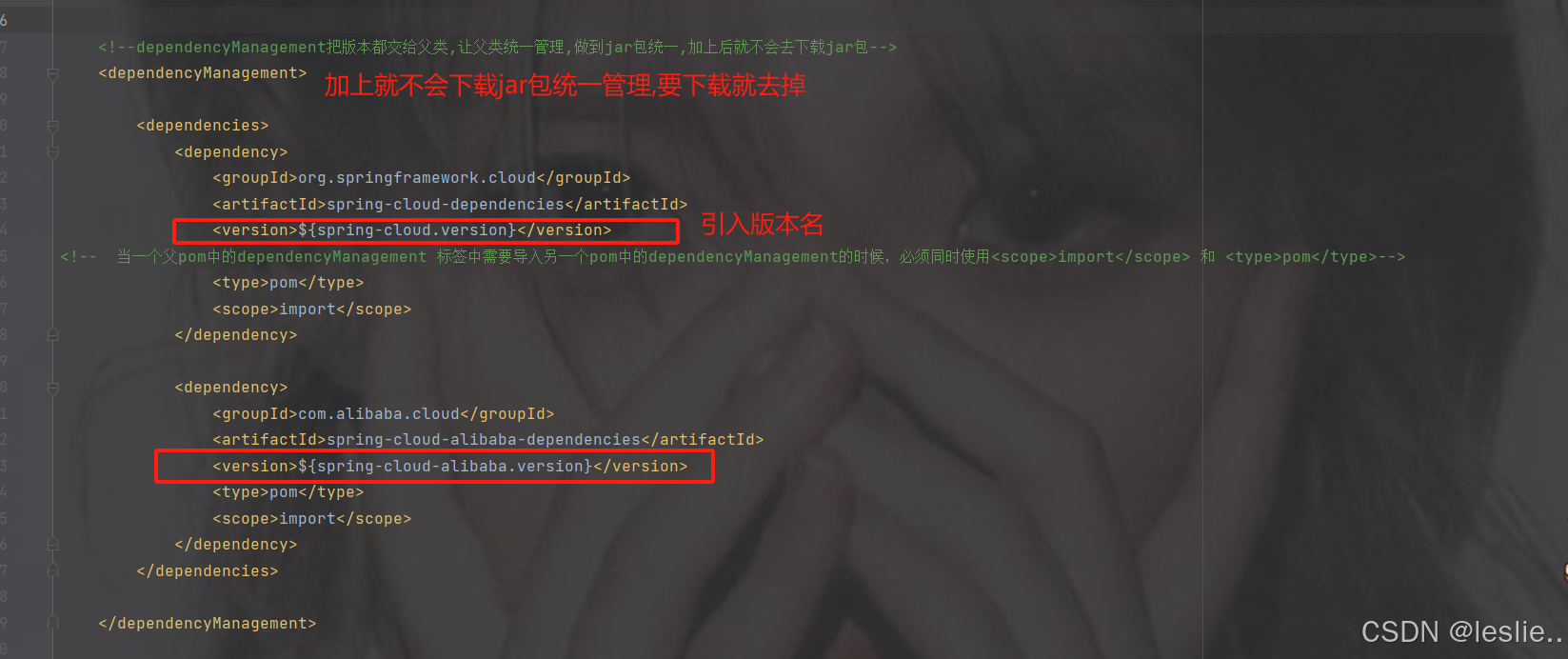

dependencyManagement

完整依赖

4.0.0

pom

org.springframework.boot

spring-boot-starter-parent

2.4.2

com.example

SpringCloud

0.0.1-SNAPSHOT

SpringCloud

SpringCloud

1.8

2020.0.1

2021.1

org.springframework.cloud

spring-cloud-dependencies

${spring-cloud.version}

pom

import

com.alibaba.cloud

spring-cloud-alibaba-dependencies

${spring-cloud-alibaba.version}

pom

import

org.springframework.boot

spring-boot-maven-plugin

注意:设置父工程的打包方式为pom打包。

<packaging>pom</packaging>

建议: 删除src日录。

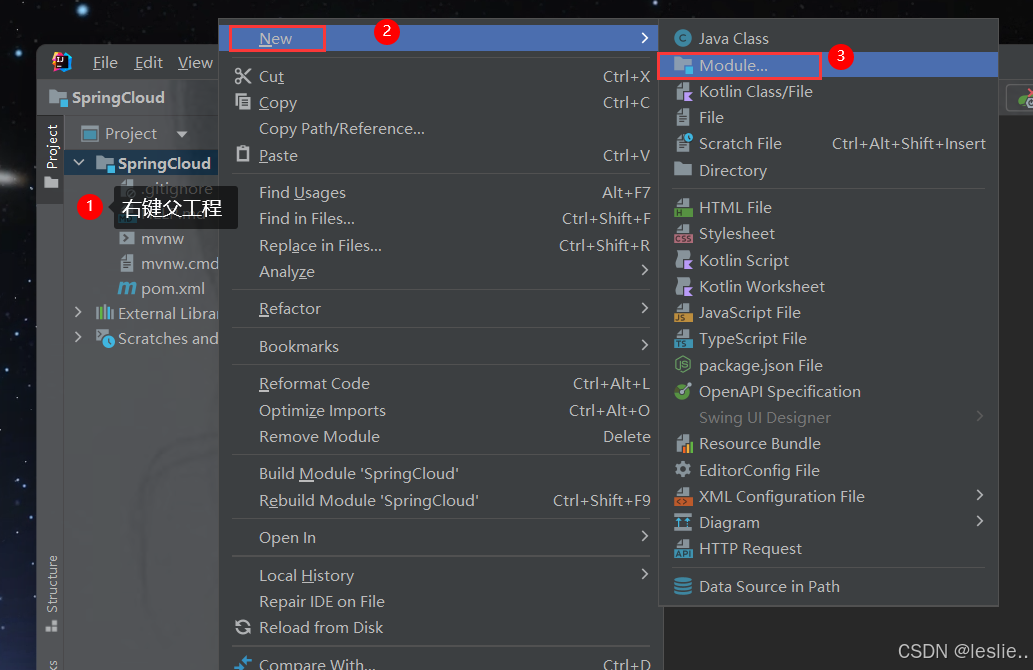

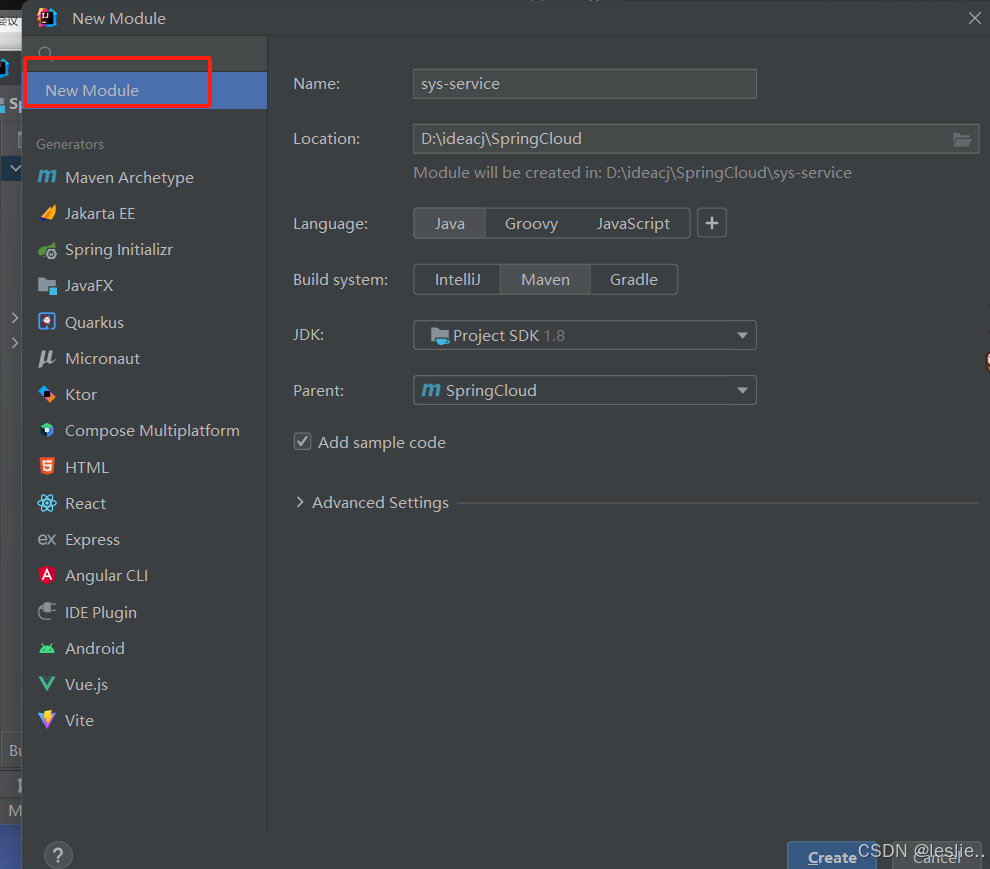

2.3 创建子项目

SSO(单点登录)

Sys-common (公共模块)

Sys-gateway(网关):

Sys-system(系统管理提供接口):

Sys-service:{

Sys-order:

Sys-product:

}

删除src

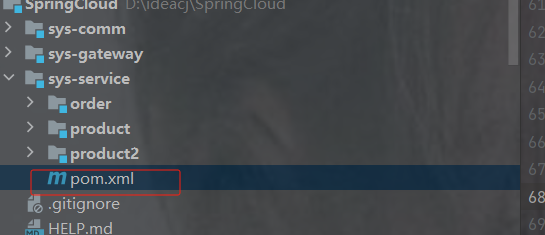

当一创建子项目后,父模块的pom.xml会有子模块

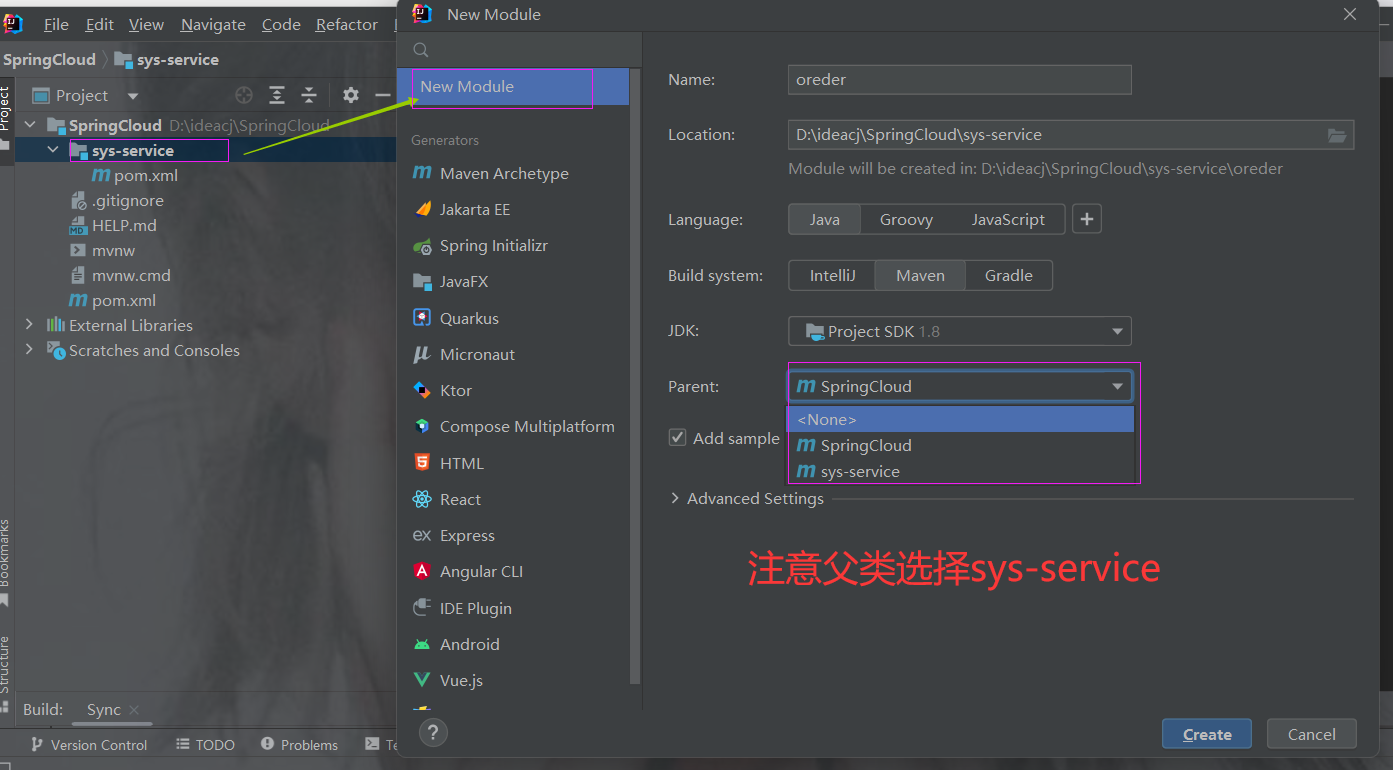

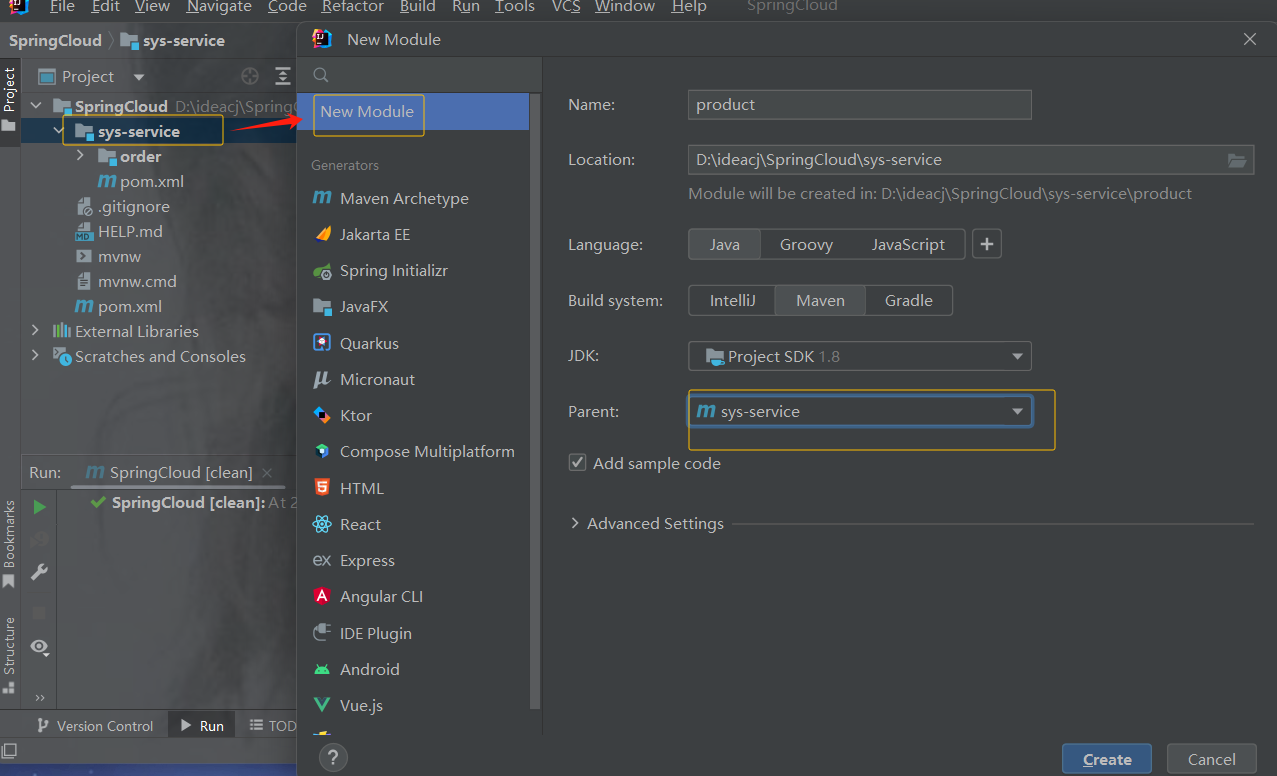

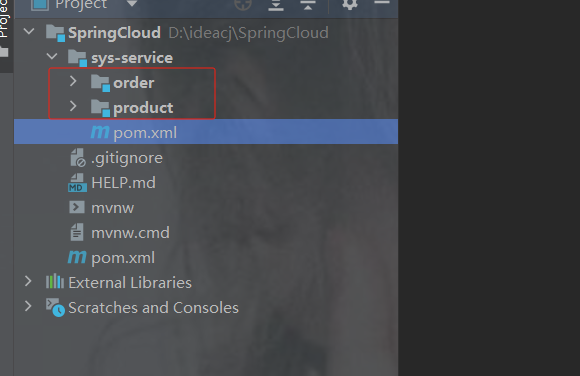

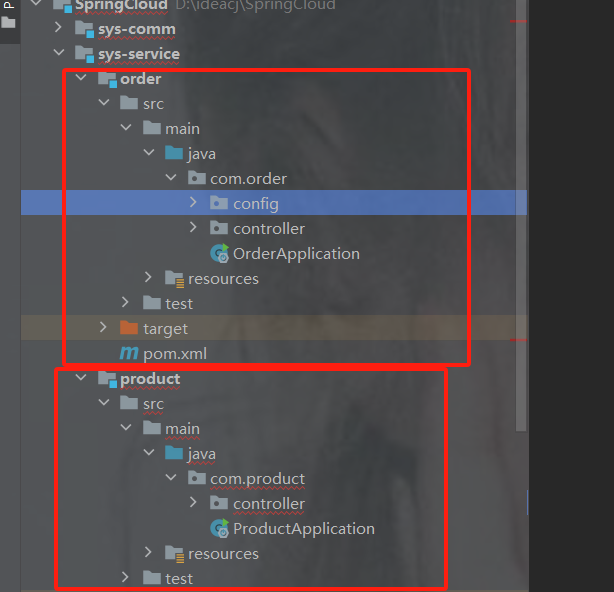

2.4 在子工程下创建订单以及商品模块

创建订单模块

创建商品模块

示例

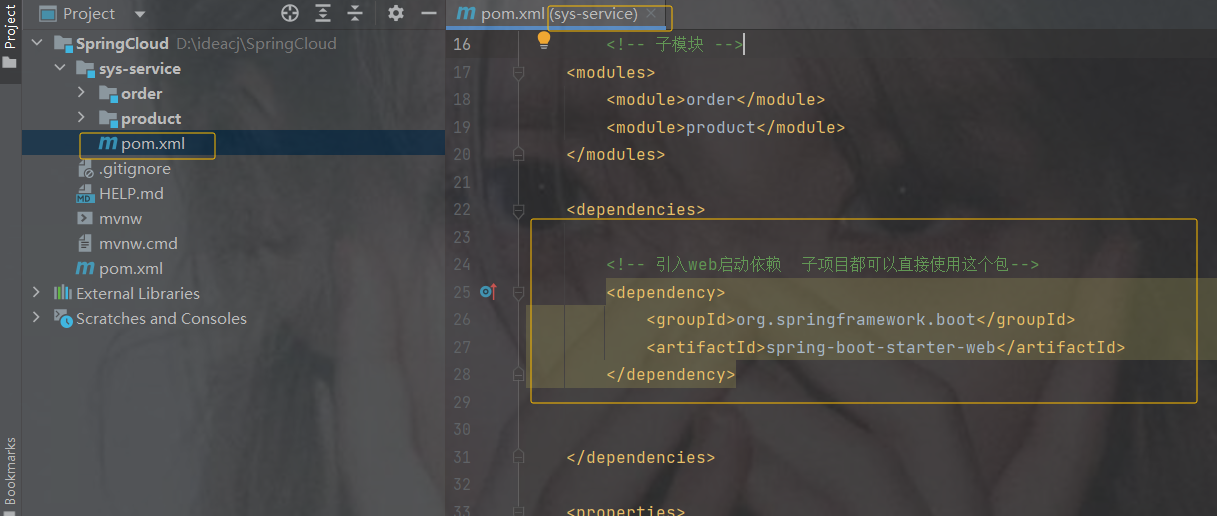

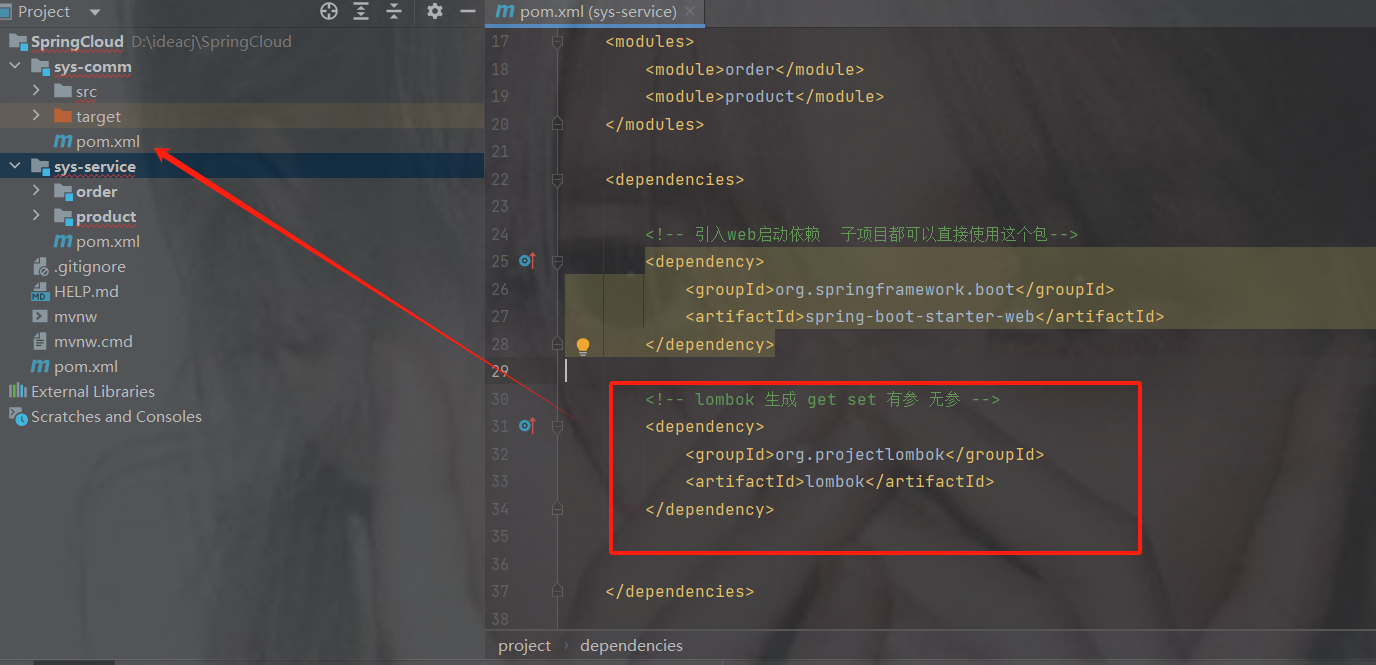

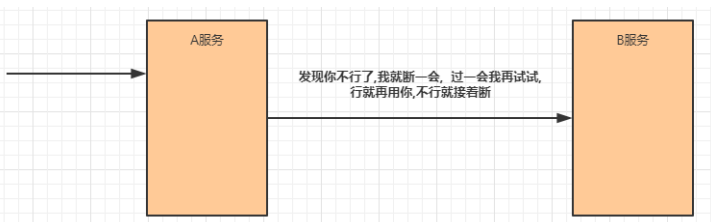

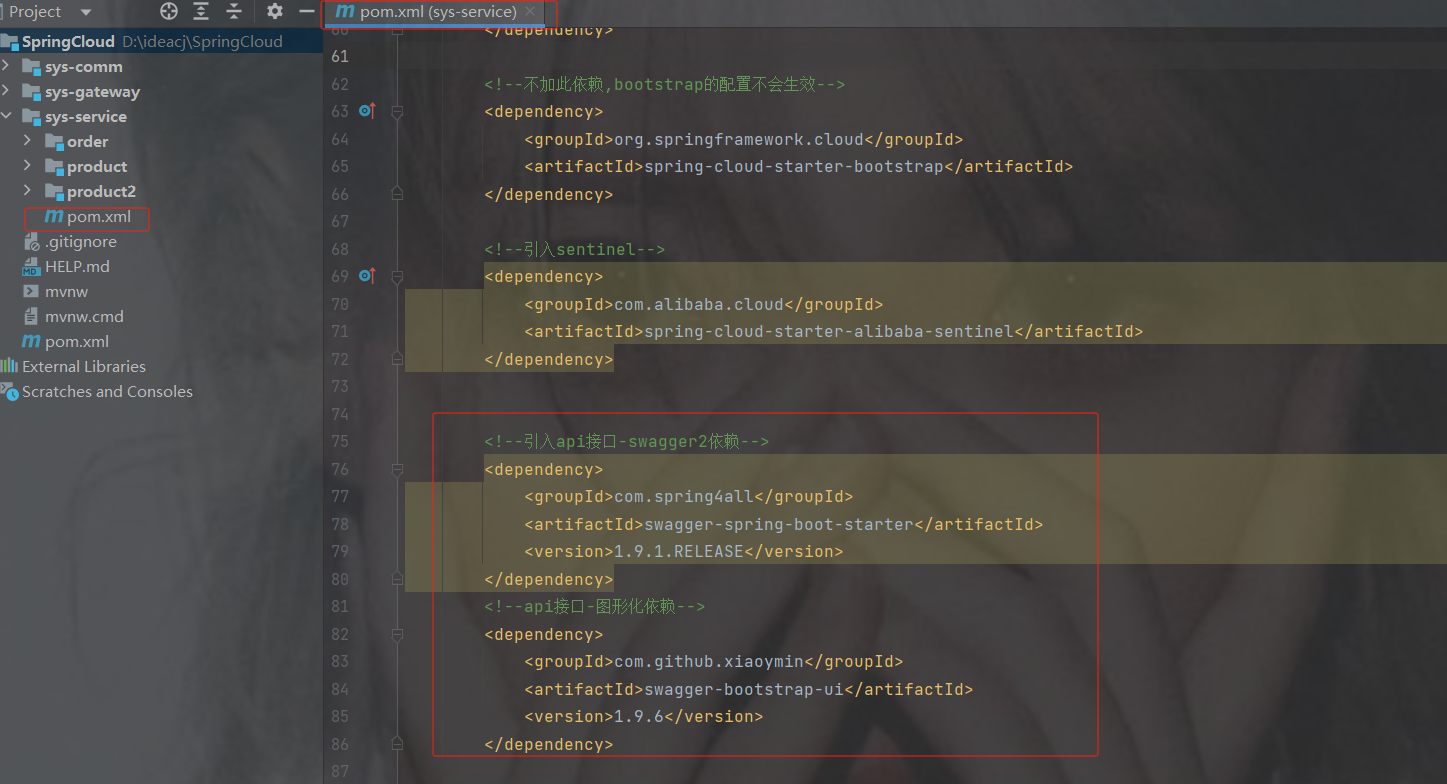

加依赖,注意是sys-service的pom.xml里,它的子模块可以使用父模块里的依赖

4.0.0

com.example

SpringCloud

0.0.1-SNAPSHOT

sys-service

pom

order

product

org.springframework.boot

spring-boot-starter-web

org.projectlombok

lombok

8

8

UTF-8

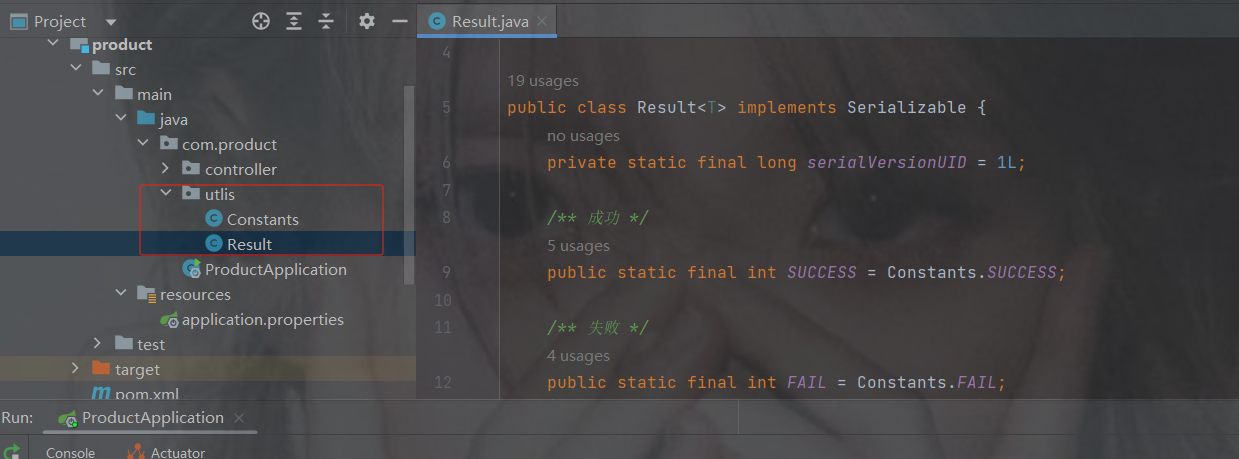

2.5 实现功能 商品模块

根据商品 id 商品的信息返回,这里为了方便先不连接数据库,后边会连接

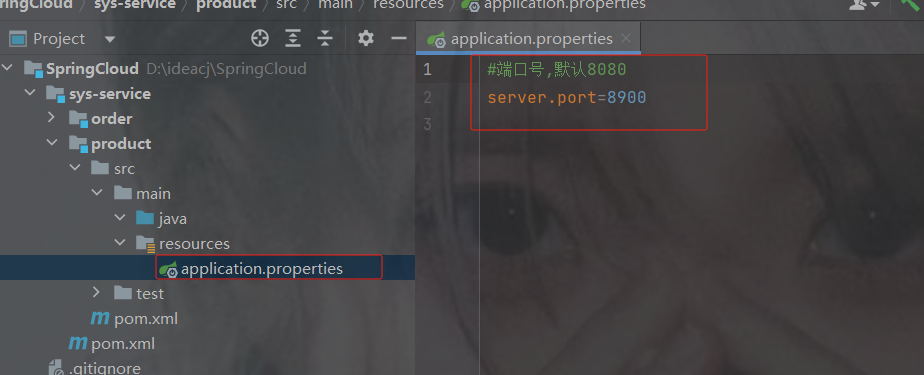

创建application.properties

指定端口号,否则后边服务多了端口号重复,不要用8080

商品端口号

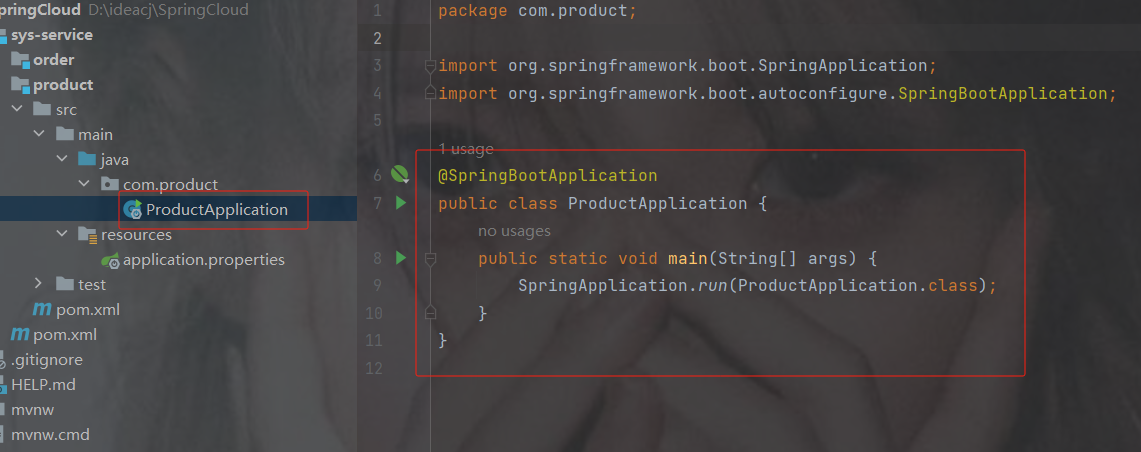

创建启动类

商品启动类

工具类响应

package com.product.utlis;

import java.io.Serializable;

public class Result implements Serializable {

private static final long serialVersionUID = 1L;

/** 成功 */

public static final int SUCCESS = Constants.SUCCESS;

/** 失败 */

public static final int FAIL = Constants.FAIL;

private int code;

private String msg;

private T data;

private Long timestamp;

public static Result ok()

{

return restResult(null, SUCCESS, null);

}

public static Result ok(T data)

{

return restResult(data, SUCCESS, null);

}

public static Result ok(T data,long timestamp)

{

Result r = restResult(data, SUCCESS, null);

r.timestamp = timestamp;

return r;

}

public static Result ok(T data, String msg)

{

return restResult(data, SUCCESS, msg);

}

public static Result fail()

{

return restResult(null, FAIL, null);

}

public static Result fail(String msg)

{

return restResult(null, FAIL, msg);

}

public static Result fail(T data)

{

return restResult(data, FAIL, null);

}

public static Result fail(T data, String msg)

{

return restResult(data, FAIL, msg);

}

public static Result fail(int code, String msg)

{

return restResult(null, code, msg);

}

public Long getTimestamp() {

return timestamp;

}

public void setTimestamp(Long timestamp) {

this.timestamp = timestamp;

}

private static Result restResult(T data, int code, String msg)

{

Result apiResult = new Result<>();

apiResult.setCode(code);

apiResult.setData(data);

apiResult.setMsg(msg);

return apiResult;

}

public int getCode()

{

return code;

}

public void setCode(int code)

{

this.code = code;

}

public String getMsg()

{

return msg;

}

public void setMsg(String msg)

{

this.msg = msg;

}

public T getData()

{

return data;

}

public void setData(T data)

{

this.data = data;

}

public static Boolean isError(Result ret)

{

return !isSuccess(ret);

}

public static Boolean isSuccess(Result ret)

{

return Result.SUCCESS == ret.getCode();

}

} package com.product.utlis;

public class Constants {

/**

* UTF-8 字符集

*/

public static final String UTF8 = "UTF-8";

/**

* GBK 字符集

*/

public static final String GBK = "GBK";

/**

* www主域

*/

public static final String WWW = "www.";

/**

* RMI 远程方法调用

*/

public static final String LOOKUP_RMI = "rmi:";

/**

* LDAP 远程方法调用

*/

public static final String LOOKUP_LDAP = "ldap:";

/**

* LDAPS 远程方法调用

*/

public static final String LOOKUP_LDAPS = "ldaps:";

/**

* http请求

*/

public static final String HTTP = "http://";

/**

* https请求

*/

public static final String HTTPS = "https://";

/**

* 成功标记

*/

public static final Integer SUCCESS = 200;

/**

* 失败标记

*/

public static final Integer FAIL = 500;

/**

* 登录成功状态

*/

public static final String LOGIN_SUCCESS_STATUS = "0";

/**

* 登录失败状态

*/

public static final String LOGIN_FAIL_STATUS = "1";

/**

* 登录成功

*/

public static final String LOGIN_SUCCESS = "Success";

/**

* 注销

*/

public static final String LOGOUT = "Logout";

/**

* 注册

*/

public static final String REGISTER = "Register";

/**

* 注销

*/

public static final String LOGOFF = "Logoff";

/**

* 登录失败

*/

public static final String LOGIN_FAIL = "Error";

/**

* 当前记录起始索引

*/

public static final String PAGE_NUM = "pageNum";

/**

* 每页显示记录数

*/

public static final String PAGE_SIZE = "pageSize";

/**

* 排序列

*/

public static final String ORDER_BY_COLUMN = "orderByColumn";

/**

* 排序的方向 "desc" 或者 "asc".

*/

public static final String IS_ASC = "isAsc";

/**

* 验证码有效期(分钟)

*/

public static final long CAPTCHA_EXPIRATION = 2;

/**

* 资源映射路径 前缀

*/

public static final String RESOURCE_PREFIX = "/profile";

/**

* 自动识别json对象白名单配置(仅允许解析的包名,范围越小越安全)

*/

public static final String[] JSON_WHITELIST_STR = { "org.springframework", "com.ruoyi" };

/**

* 定时任务白名单配置(仅允许访问的包名,如其他需要可以自行添加)

*/

public static final String[] JOB_WHITELIST_STR = { "com.ruoyi" };

/**

* 定时任务违规的字符

*/

public static final String[] JOB_ERROR_STR = { "java.net.URL", "javax.naming.InitialContext", "org.yaml.snakeyaml",

"org.springframework", "org.apache", "com.ruoyi.common.core.utils.file" };

}商品实体

package com.product.entity;

import lombok.AllArgsConstructor;

import lombok.Data;

import lombok.NoArgsConstructor;

import java.math.BigDecimal;

@Data //自动生成 get set

@AllArgsConstructor //自动生成 有参构造

@NoArgsConstructor //自动生成 无参构造

public class Product {

/**

* 商品id

*/

private Integer id;

/**

* 商品名称

*/

private String pName;

/**

* 商品价格

*/

private BigDecimal price;

/**

* 商品库存

*/

private Integer inventory;

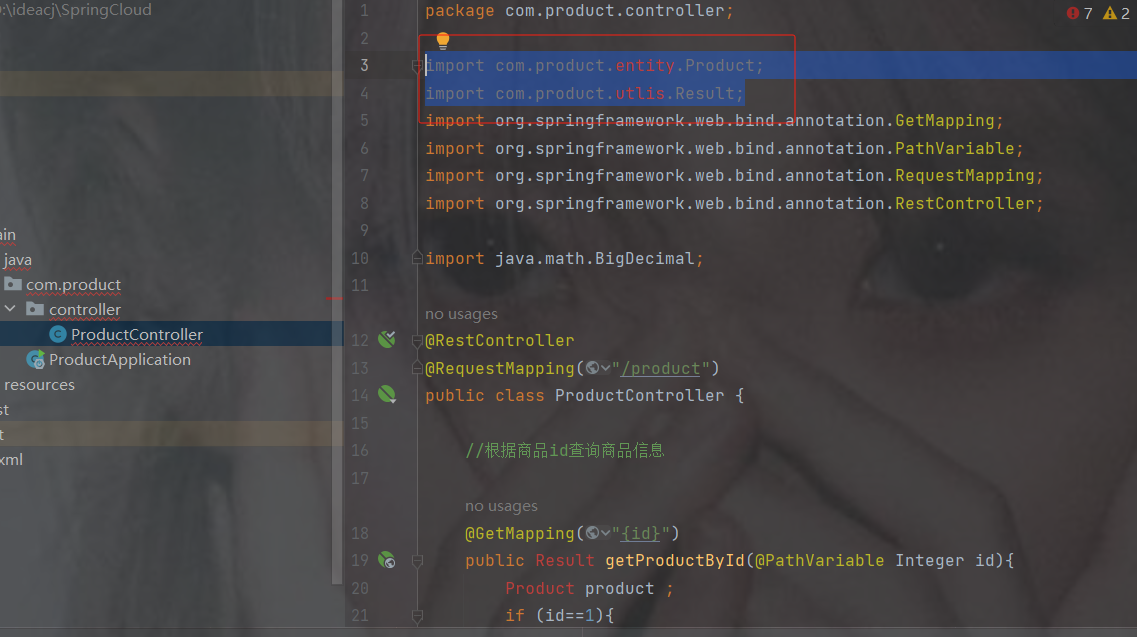

}商品controller

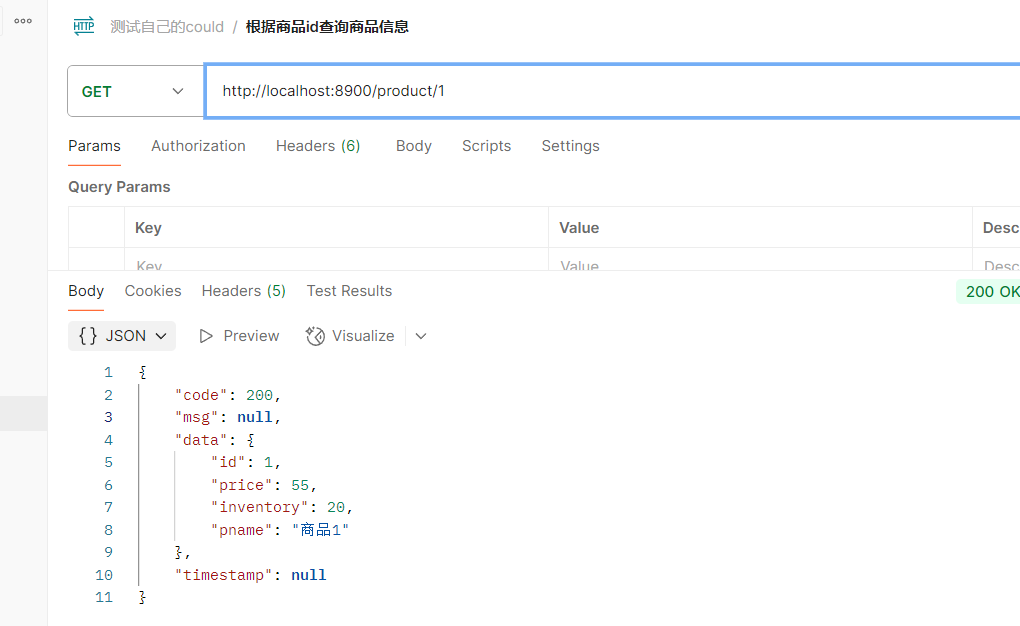

编写完重启

package com.product.controller;

import com.product.entity.Product;

import com.product.utlis.Result;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PathVariable;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RestController;

import java.math.BigDecimal;

@RestController

@RequestMapping("/product")

public class ProductController {

//根据商品id查询商品信息

@GetMapping("{id}")

public Result getProductById(@PathVariable Integer id){

Product product ;

if (id==1){

product = new Product(1,"商品1",new BigDecimal(55),20);

}else {

product = new Product(12,"商品2",new BigDecimal(99),10);

}

return Result.ok(product);

}

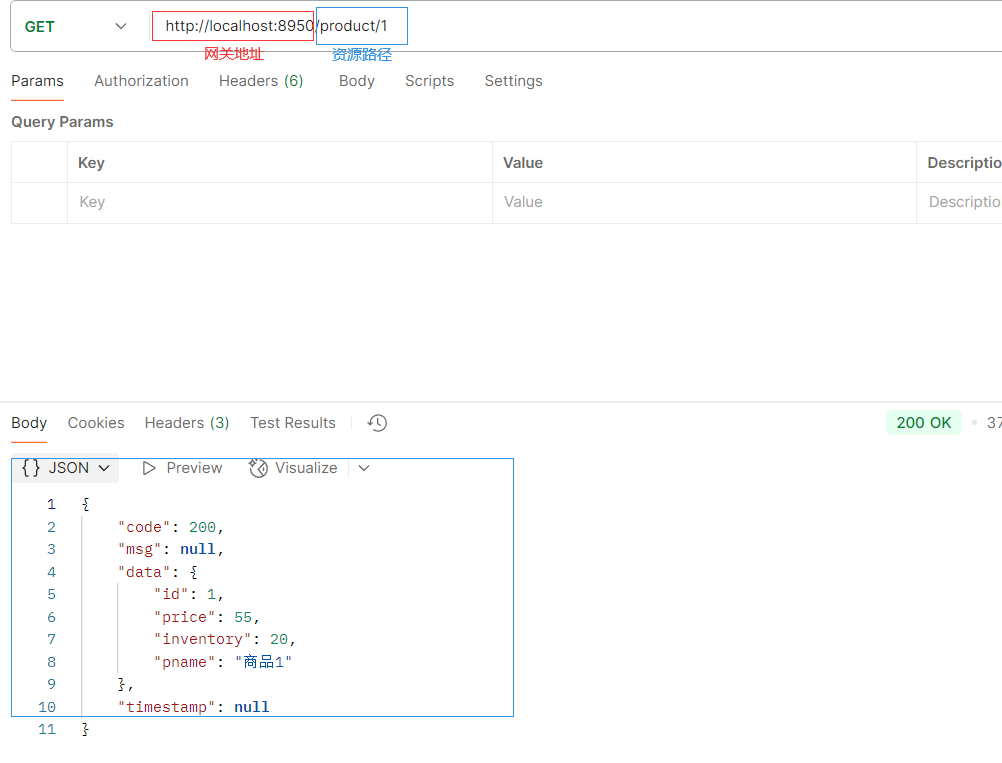

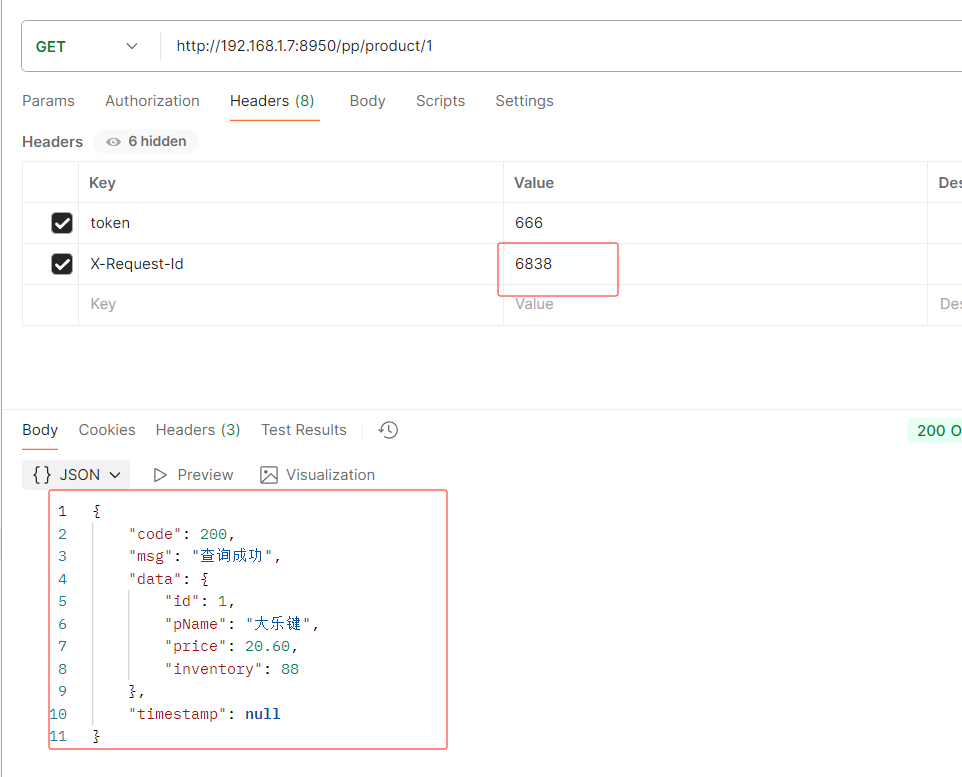

}访问结果

2.6. 远程调用 restTemplate 以及公共模块

订单模块实现的功能

1.根据商品的id 查询商品的价格 库存 2.存入订单

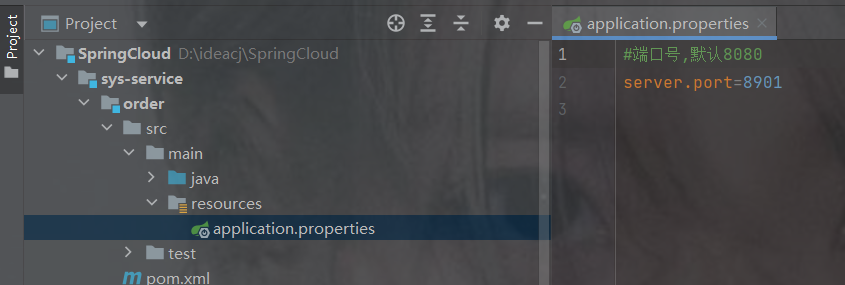

创建application.properties

订单端口号

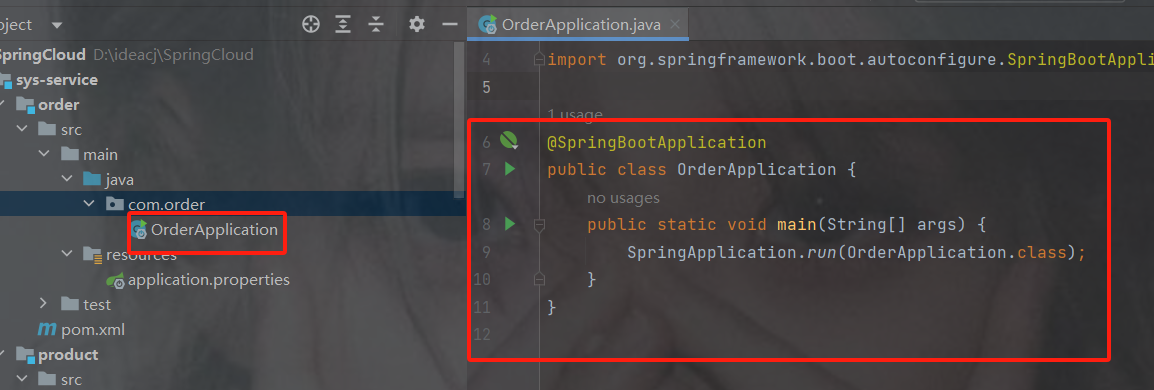

启动类

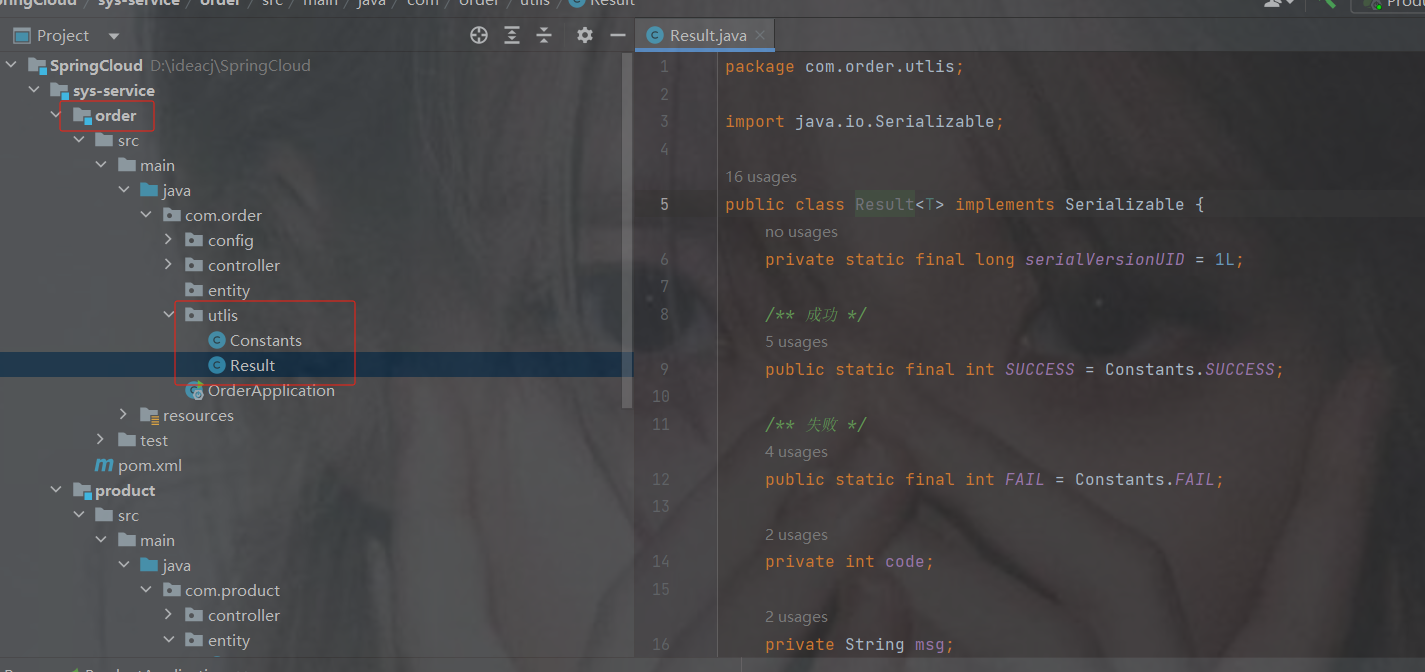

工具类响应

package com.order.utlis;

import java.io.Serializable;

public class Result implements Serializable {

private static final long serialVersionUID = 1L;

/** 成功 */

public static final int SUCCESS = Constants.SUCCESS;

/** 失败 */

public static final int FAIL = Constants.FAIL;

private int code;

private String msg;

private T data;

private Long timestamp;

public static Result ok()

{

return restResult(null, SUCCESS, null);

}

public static Result ok(T data)

{

return restResult(data, SUCCESS, null);

}

public static Result ok(T data,long timestamp)

{

Result r = restResult(data, SUCCESS, null);

r.timestamp = timestamp;

return r;

}

public static Result ok(T data, String msg)

{

return restResult(data, SUCCESS, msg);

}

public static Result fail()

{

return restResult(null, FAIL, null);

}

public static Result fail(String msg)

{

return restResult(null, FAIL, msg);

}

public static Result fail(T data)

{

return restResult(data, FAIL, null);

}

public static Result fail(T data, String msg)

{

return restResult(data, FAIL, msg);

}

public static Result fail(int code, String msg)

{

return restResult(null, code, msg);

}

public Long getTimestamp() {

return timestamp;

}

public void setTimestamp(Long timestamp) {

this.timestamp = timestamp;

}

private static Result restResult(T data, int code, String msg)

{

Result apiResult = new Result<>();

apiResult.setCode(code);

apiResult.setData(data);

apiResult.setMsg(msg);

return apiResult;

}

public int getCode()

{

return code;

}

public void setCode(int code)

{

this.code = code;

}

public String getMsg()

{

return msg;

}

public void setMsg(String msg)

{

this.msg = msg;

}

public T getData()

{

return data;

}

public void setData(T data)

{

this.data = data;

}

public static Boolean isError(Result ret)

{

return !isSuccess(ret);

}

public static Boolean isSuccess(Result ret)

{

return Result.SUCCESS == ret.getCode();

}

} package com.order.utlis;

public class Constants {

/**

* UTF-8 字符集

*/

public static final String UTF8 = "UTF-8";

/**

* GBK 字符集

*/

public static final String GBK = "GBK";

/**

* www主域

*/

public static final String WWW = "www.";

/**

* RMI 远程方法调用

*/

public static final String LOOKUP_RMI = "rmi:";

/**

* LDAP 远程方法调用

*/

public static final String LOOKUP_LDAP = "ldap:";

/**

* LDAPS 远程方法调用

*/

public static final String LOOKUP_LDAPS = "ldaps:";

/**

* http请求

*/

public static final String HTTP = "http://";

/**

* https请求

*/

public static final String HTTPS = "https://";

/**

* 成功标记

*/

public static final Integer SUCCESS = 200;

/**

* 失败标记

*/

public static final Integer FAIL = 500;

/**

* 登录成功状态

*/

public static final String LOGIN_SUCCESS_STATUS = "0";

/**

* 登录失败状态

*/

public static final String LOGIN_FAIL_STATUS = "1";

/**

* 登录成功

*/

public static final String LOGIN_SUCCESS = "Success";

/**

* 注销

*/

public static final String LOGOUT = "Logout";

/**

* 注册

*/

public static final String REGISTER = "Register";

/**

* 注销

*/

public static final String LOGOFF = "Logoff";

/**

* 登录失败

*/

public static final String LOGIN_FAIL = "Error";

/**

* 当前记录起始索引

*/

public static final String PAGE_NUM = "pageNum";

/**

* 每页显示记录数

*/

public static final String PAGE_SIZE = "pageSize";

/**

* 排序列

*/

public static final String ORDER_BY_COLUMN = "orderByColumn";

/**

* 排序的方向 "desc" 或者 "asc".

*/

public static final String IS_ASC = "isAsc";

/**

* 验证码有效期(分钟)

*/

public static final long CAPTCHA_EXPIRATION = 2;

/**

* 资源映射路径 前缀

*/

public static final String RESOURCE_PREFIX = "/profile";

/**

* 自动识别json对象白名单配置(仅允许解析的包名,范围越小越安全)

*/

public static final String[] JSON_WHITELIST_STR = { "org.springframework", "com.ruoyi" };

/**

* 定时任务白名单配置(仅允许访问的包名,如其他需要可以自行添加)

*/

public static final String[] JOB_WHITELIST_STR = { "com.ruoyi" };

/**

* 定时任务违规的字符

*/

public static final String[] JOB_ERROR_STR = { "java.net.URL", "javax.naming.InitialContext", "org.yaml.snakeyaml",

"org.springframework", "org.apache", "com.ruoyi.common.core.utils.file" };

}restTemplate

注意不要在订单里设置查询商品的信息,这样没有意义

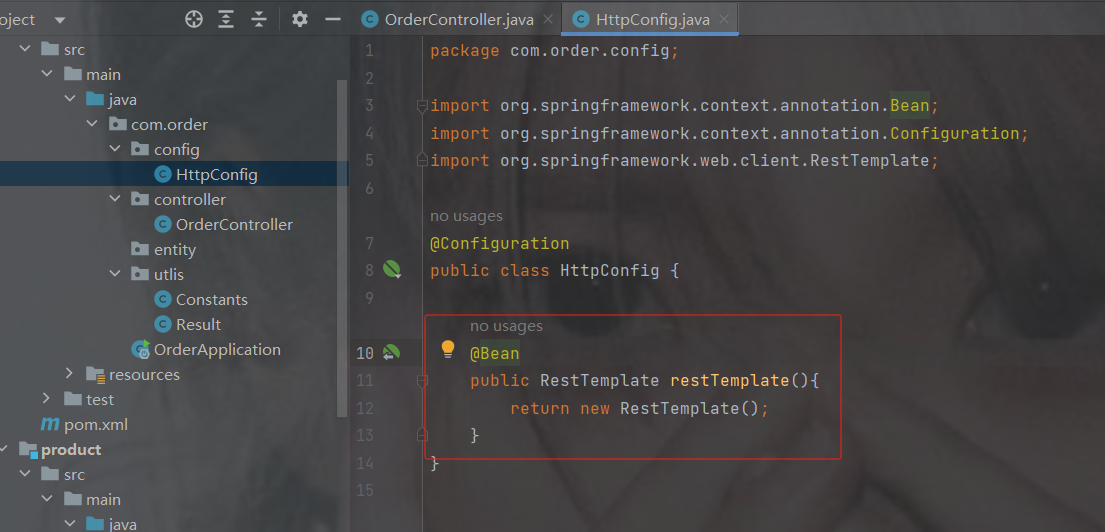

此时我们需要用到一个http的客户端restTemplate来调用服务,需要我们自己来配置

获取商品的信息 ===>通过HTTP协议调用其他微服务 ===>自己封装Http工具===>

spring提供RestTemplate没有交于spring管理,需要我们自己配置

变成bean的配置形式

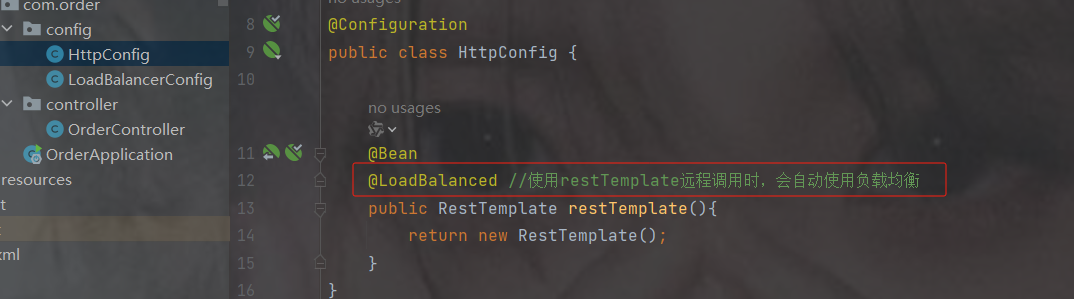

代码

package com.order.config;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import org.springframework.web.client.RestTemplate;

@Configuration

public class HttpConfig {

@Bean

public RestTemplate restTemplate(){

return new RestTemplate();

}

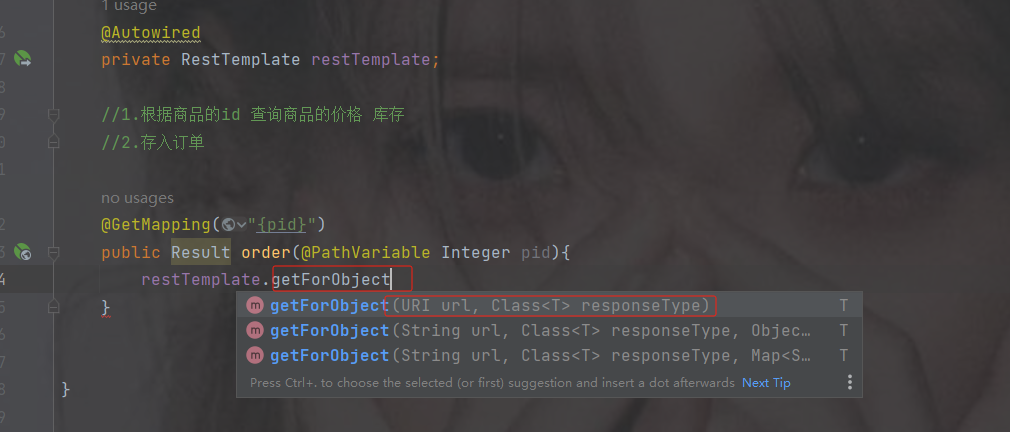

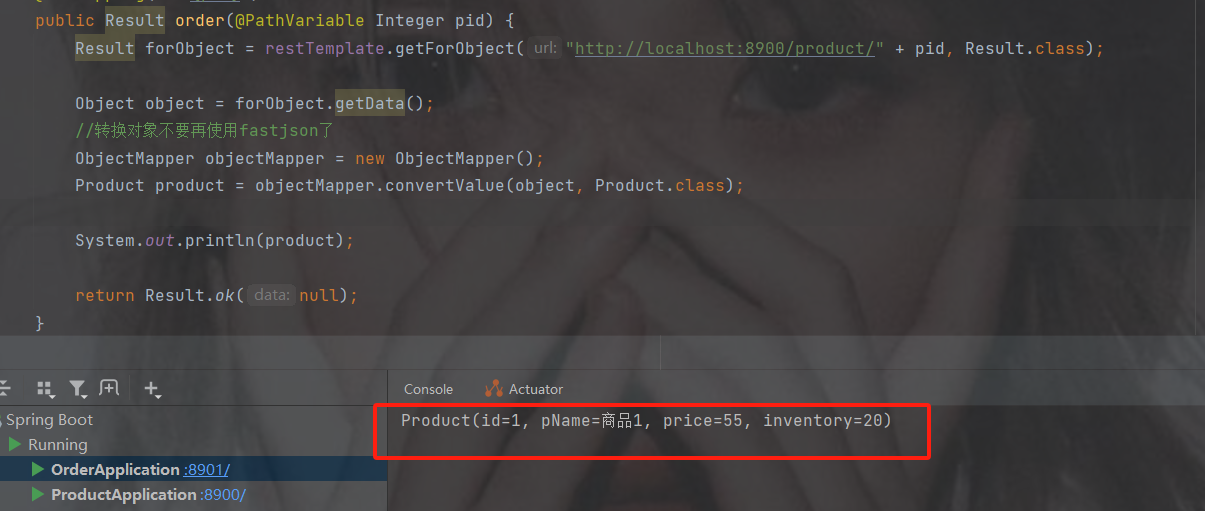

}订单controller

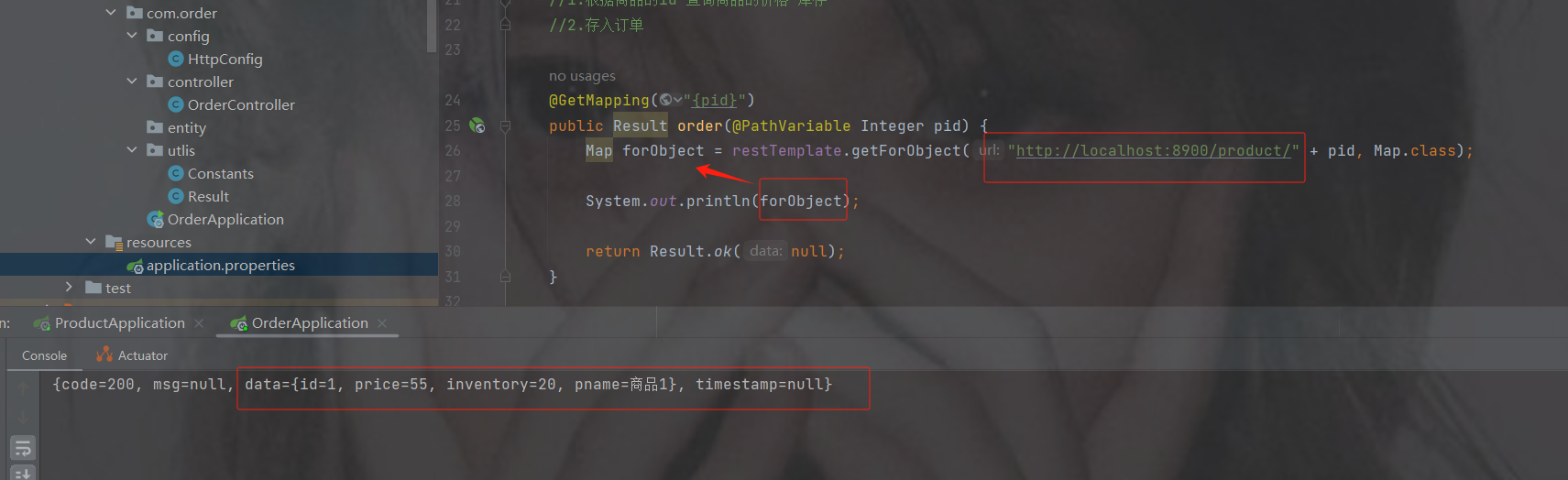

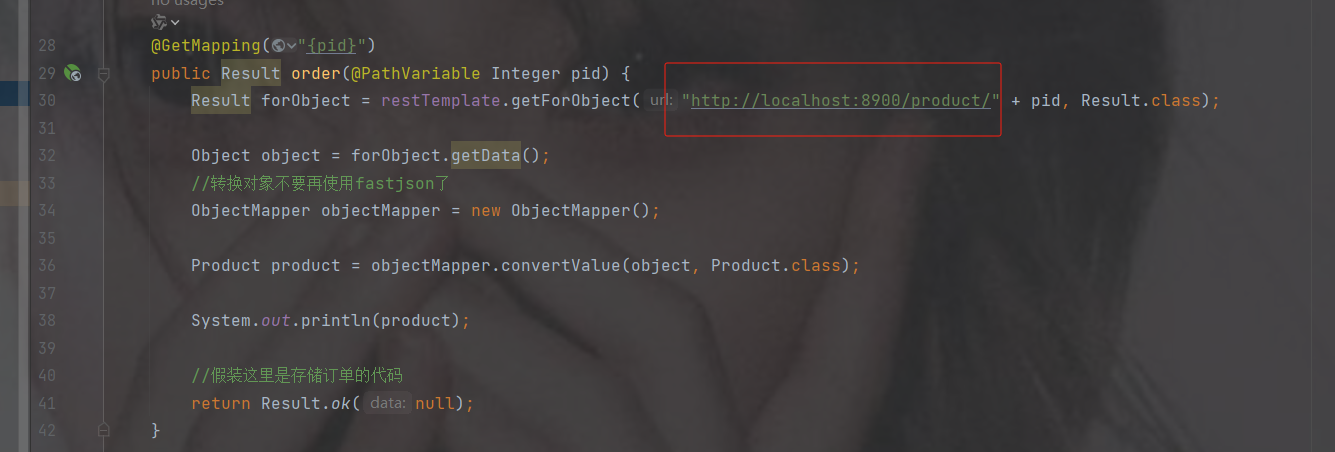

注入restTemplate后调用getForObject方法

需要传入路径以及你想返回的数据类型(反射类型)

路径的地址就是商品的路径地址,并且要转成你想要的类型

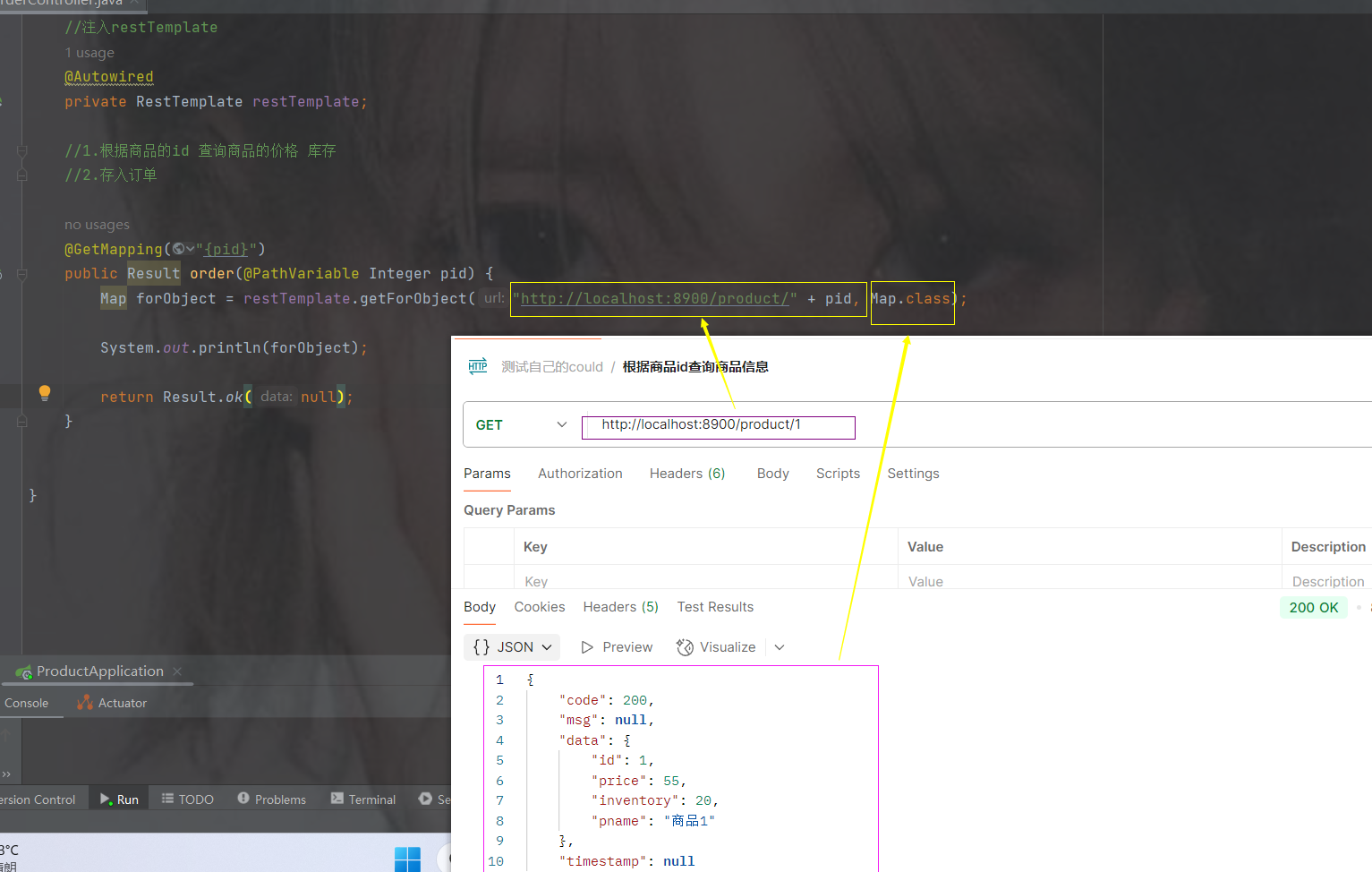

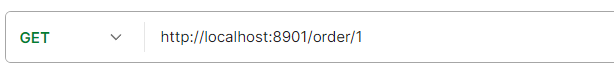

访问订单接口

发现的问题

当一访问订单的服务就会去调用商品的信息

但是如果想转换商品对象实体,会转不了的问题,有时候我们需要商品的信息,这样启动访问会报错的

当我们转换为result获取data数据的时候,发现需要转换为商品的实体对象,但是我们没有

而且像工具类,我们如果每建一个服务,如果用到工具类,我们难道都要挨个加吗?

像这些问题我们需要单独有一个公共的模块,像一些工具以及公共的配置以及实体都可以放在里面

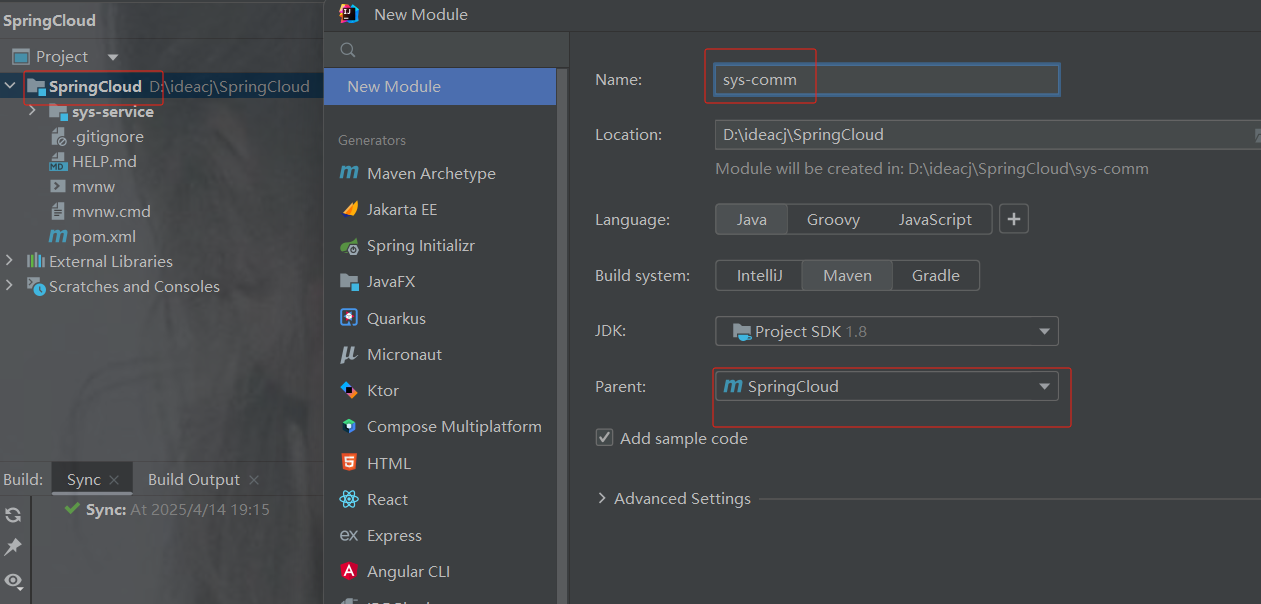

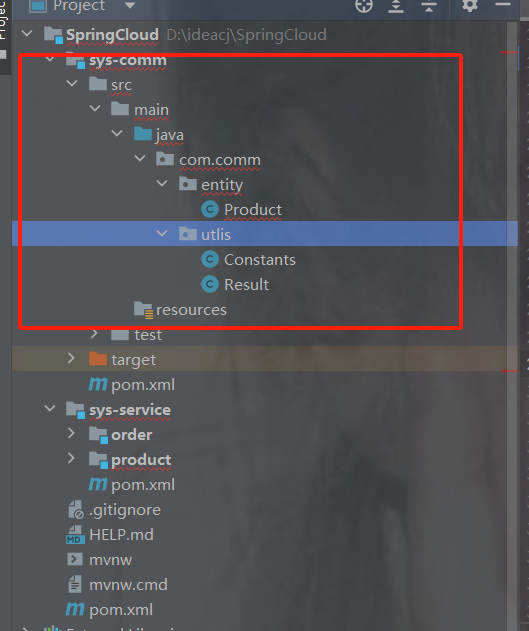

公共模块

创建公共模块

注意父类是springcloud

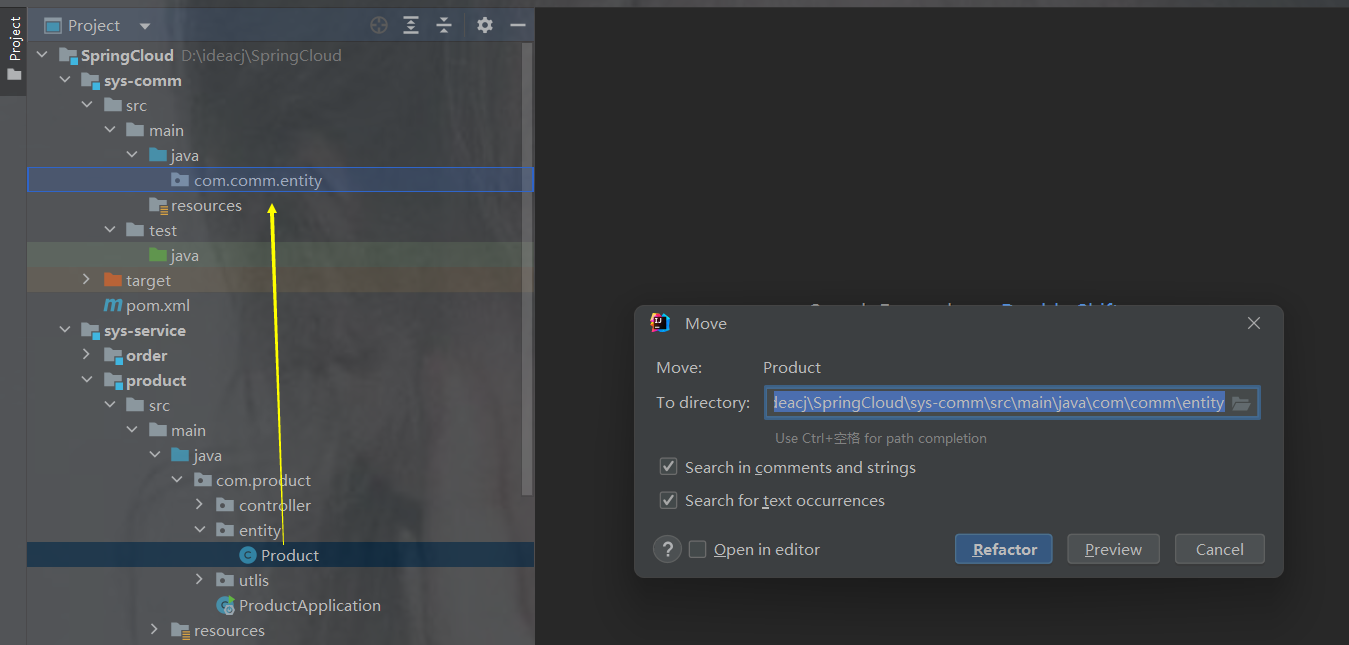

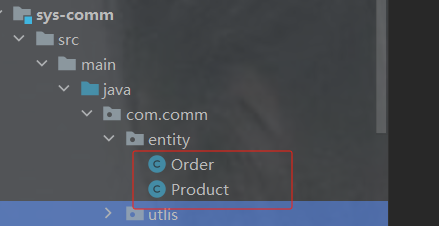

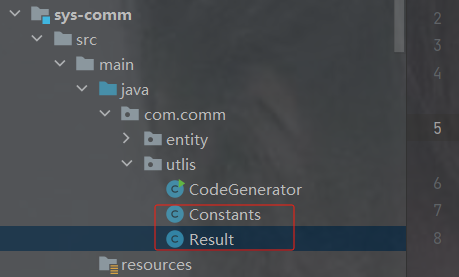

把商品的实体和两个模块的工具类移过去

示例

删完多余的包以及订单和商品目前是这个样子

comm 的包示例

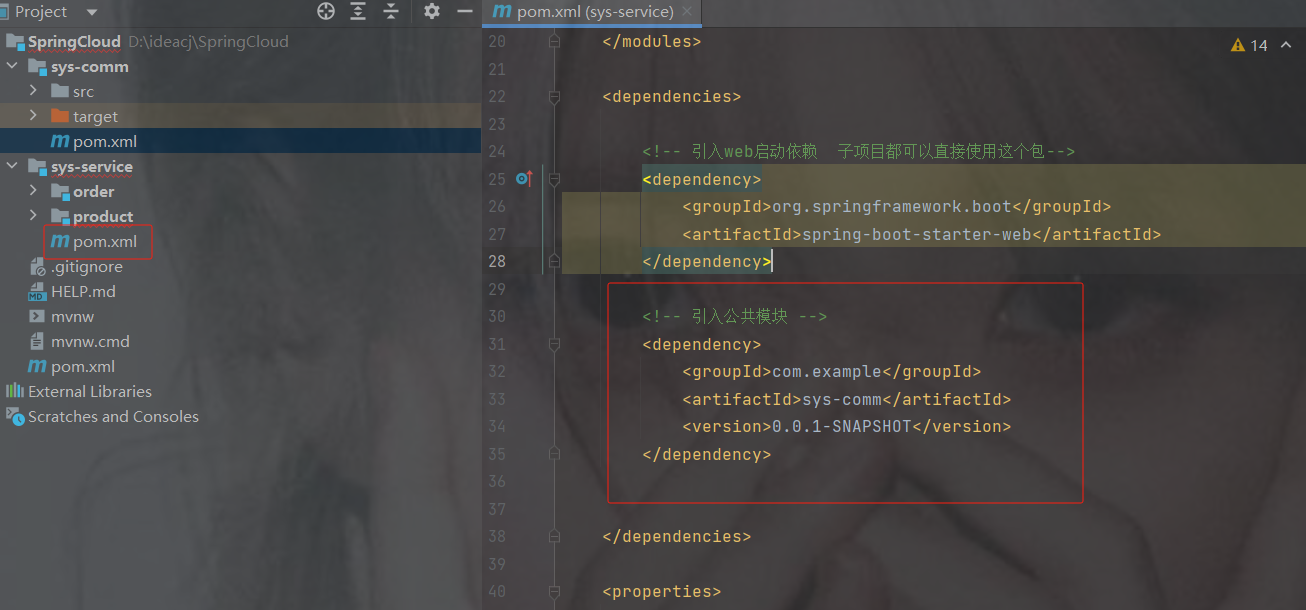

sys-service 的 lombok移过去

把service的lombok移到comm的pom.xml里

service的pom.xml引入comm公共模块包

4.0.0

com.example

SpringCloud

0.0.1-SNAPSHOT

sys-service

pom

order

product

org.springframework.boot

spring-boot-starter-web

com.example

sys-comm

0.0.1-SNAPSHOT

8

8

UTF-8

删除商品和订单的重新导入

修改订单模块远程调用

package com.order.controller;

import com.comm.entity.Product;

import com.comm.utlis.Result;

import com.fasterxml.jackson.databind.ObjectMapper;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PathVariable;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RestController;

import org.springframework.web.client.RestTemplate;

import java.util.Map;

@RestController

@RequestMapping("/order")

public class OrderController {

//注入restTemplate

@Autowired

private RestTemplate restTemplate;

//1.根据商品的id 查询商品的价格 库存

//2.存入订单

@GetMapping("{pid}")

public Result order(@PathVariable Integer pid) {

Result forObject = restTemplate.getForObject("http://localhost:8900/product/" + pid, Result.class);

Object object = forObject.getData();

//转换对象不要再使用fastjson了

ObjectMapper objectMapper = new ObjectMapper();

Product product = objectMapper.convertValue(object, Product.class);

System.out.println(product);

return Result.ok(null);

}

}访问接口地址http://localhost:8901/order/1

此时发现可以获取到商品的对象信息

修改列表服务展示

3.服务治理

3.1 什么是服务治理

服务治理是微服务架构中最核心最基本的模块。用于实现各个微服务的自动化注册与发现

服务注册:在服务治理框架中,都会构建一个*注册中心*,每个服务单元向注册中心登记自己提供服务的详细信息。并在注册中心形成一张服务的*清单*,服务注册中心需要以*心涨30s 90s*的方式去监测清单中的服务是否可用,如果不可用,需要在服务清单中剔除不可用的服务。

服务发现:服务调用方向服务注册中心咨询服务,并获取*所有服务*的实例清单,实现对具体服务实例的访问。

3.2 常见的注册中心软件

Zookeeper

zookeeper是一个分布式服务框架,是Apache Hadoop 的一个子项目,它主要是用来解决分布式应用中经常遇到的一些数据管理问题,如:统一命名服务、状态同步服务、集群管理、分布式应用配置项的管理等,----一般用于大数据

Eureka

Eureka是Springcloud Netflix中的重要组件,主要作用就是做服务注册和发现。但是现在已经闭源,更不停用。

Consul

Consul是基于GO语言开发的开源工具,主要面向分布式,服务化的系统提供服务注册、服务发现和配置管理的功能。Consul的功能都很实用,其中包括:服务注册/发现、健康检查、Key/alue存储、多数据中心和分布式一致性保证等特性。Consul本身只是一个二进制的可执行文件,所以安装和部罢都非常简单,只需要从官网下载后,在执行对应的启动脚本即可。

Nacos(服务治理 配置中心)

Nacos是一个更易于构建云原生应用的动态服务发现、配置管理和服务管理平台。它是SpringCloud Alibaba 组件之一,负责服务注册发现和服务配置.

[服务治理的作用和微服务配置管理]

3.3 nacos注册中心

Nacos 致力于帮助您发现、配置和管理微服务。Nacos 提供了一组简单易用的特性集,帮助您快速实现动态服务发现、服务配置、服务元数据及流量管理。从上面的介绍就可以看出,nacos**的作用就是一个注册中心**,用来管理注册上来的各个微服务的信息。

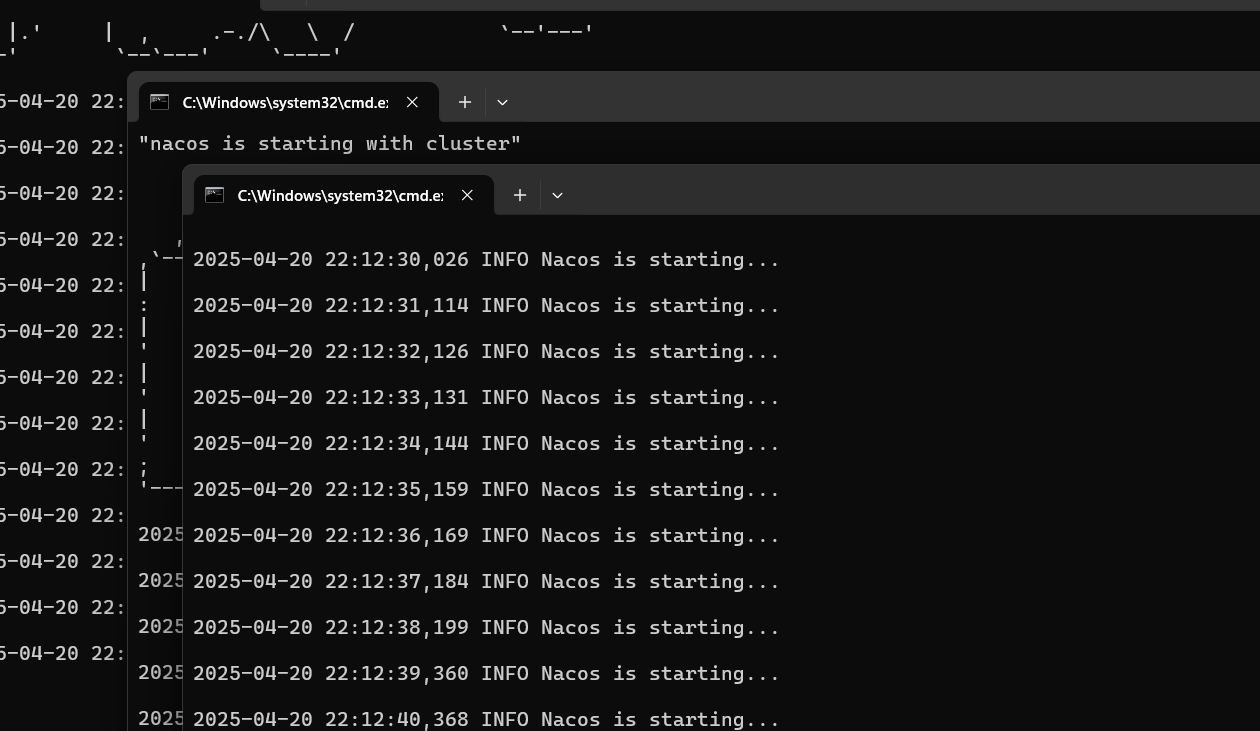

nacos注册中心的搭建

接下来,我们就在现有的环境中加入nacos,并将我们的两个微服务注册上去

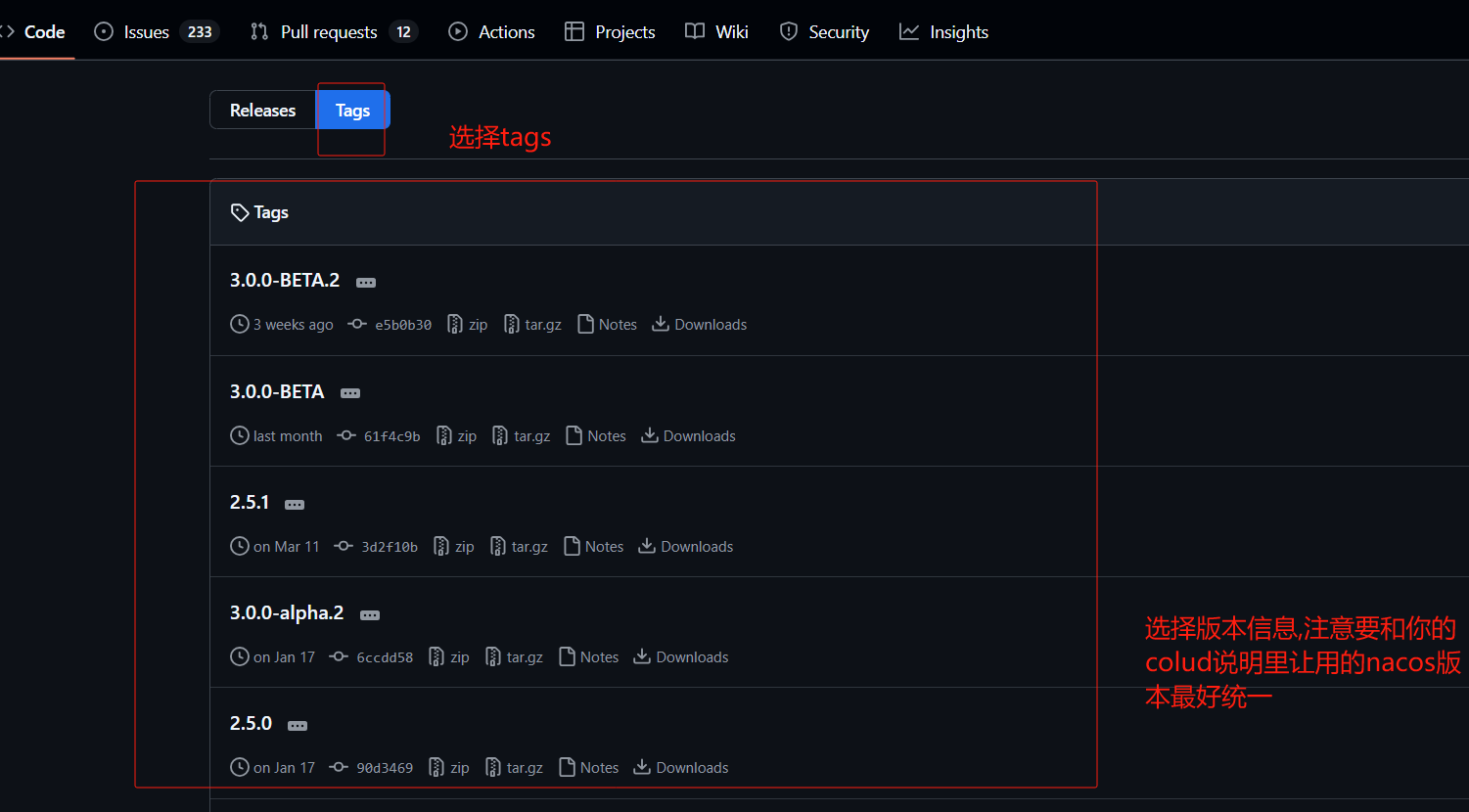

第1步: 安装nacos

下载地址: https://github.com/alibaba/nacos/releases 下载zip格式的安装包,然后进行解压缩操作 |

注意nacos版本要根据你cloud版本对应关系,下图只是个示例

解压到安装目录中即可。要求安装目录不允许有中文和特殊符号。…必须配置过JDK的环境。

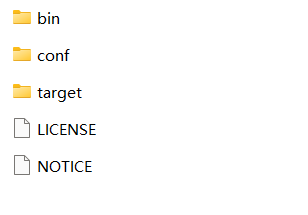

目录结构

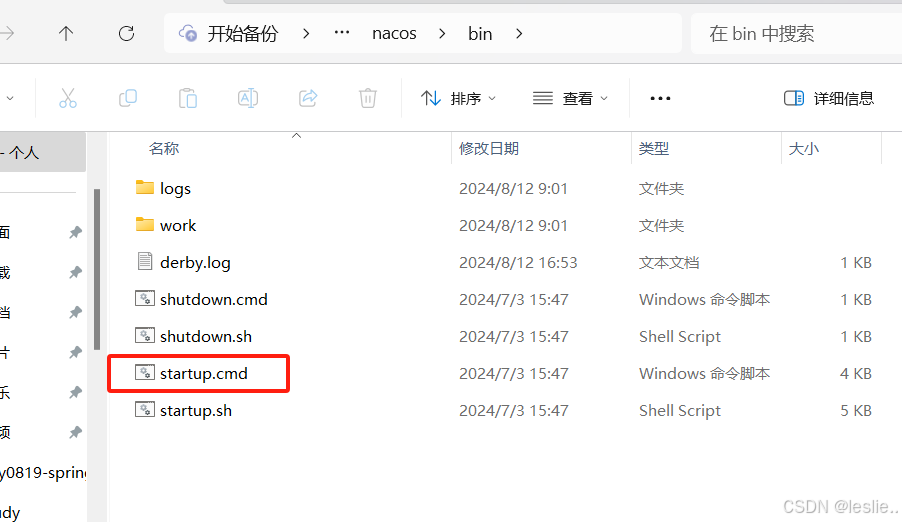

bin -- 一些脚本命令,比如启动

conf ---配置

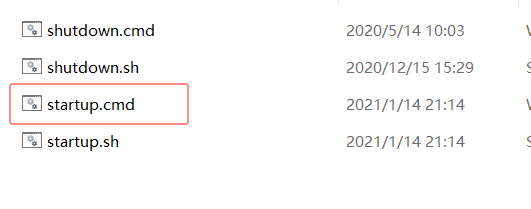

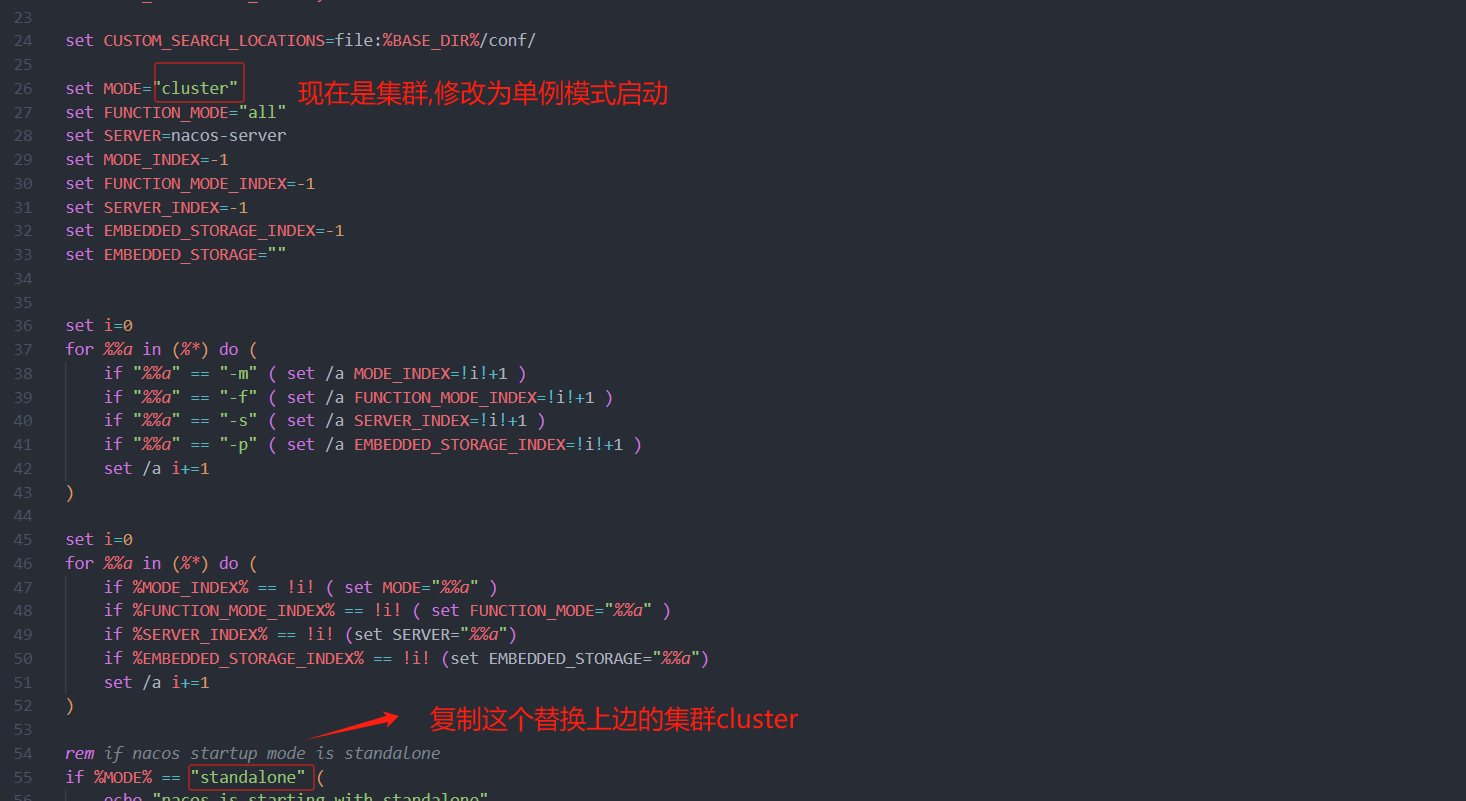

nacos默认是集群模式启动,不能直接双击startup.cmd,除非配置了集群模式,或者改为单例模式

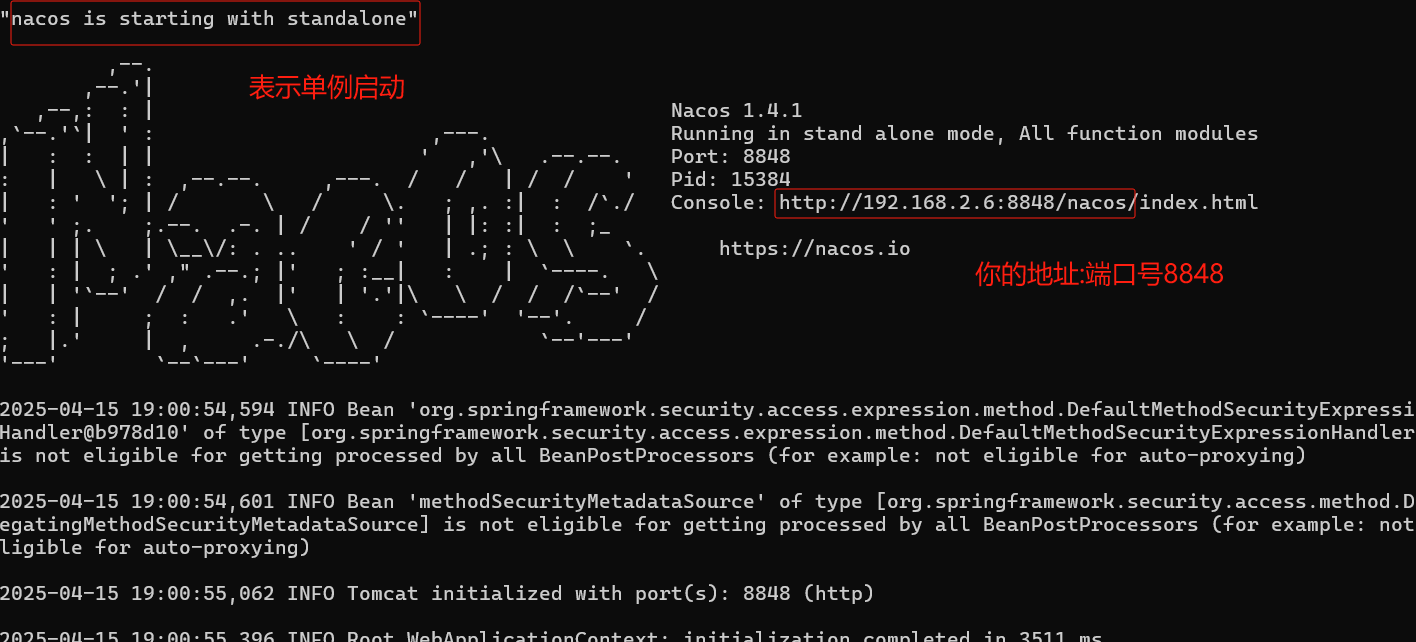

不修改模式单例启动方式

需要进入bin/目录下, 打开cmd 窗口

window启动命令 : startup.cmd -m standalone

linux启动命令是: sh startup.sh -m standalone

访问nacos

打开浏览器输入http://localhost:8848/nacos,即可访问服务, 默认密码是nacos/nacos

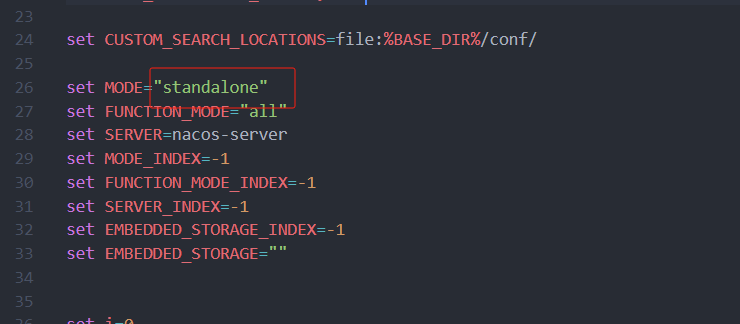

修改模式为单例模式启动方式

右键 startup.cmd 用记事本打开或拖到编译器中

修改为保存

此时可以双击startup.cmd 启动

访问nacos

打开浏览器输入http://localhost:8848/nacos,即可访问服务, 默认密码是nacos/nacos

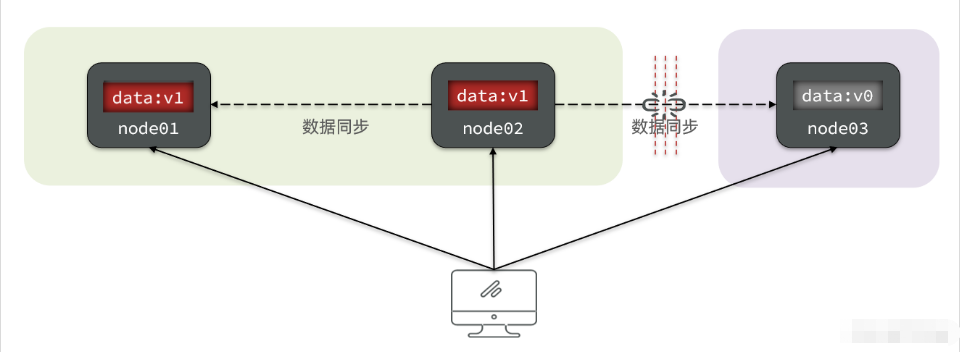

nacos集群搭建

在实际开发过程中,如果使用Nacos的话,为了确保高可用,我们一般都会对其进行集群的部署。Nacos规定集群中Nacos节点的数量需要大于等于3个;同时,单机模式下Nacos的数据默认保存在其内嵌数据库中deby,不方便观察数据存储的基本情况。而且如果集群中启动多个默认配置下的Nacos节点,数据存储是存在一致性问题的。为了解决这个问题,Nacos采用了集中式存储的方式来支持集群化部署,目前只支持MySQL的存储;此外,我们还需要借助Nginx实现负载均衡。这一过程的部署架构图如下所示:

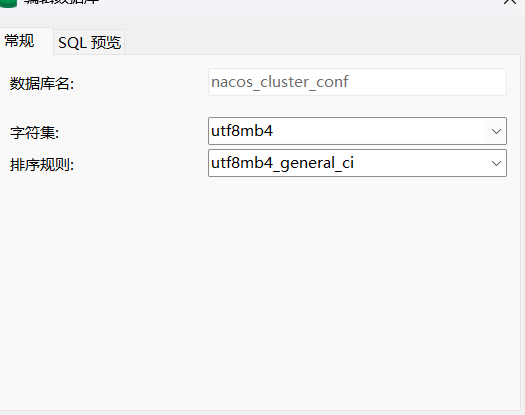

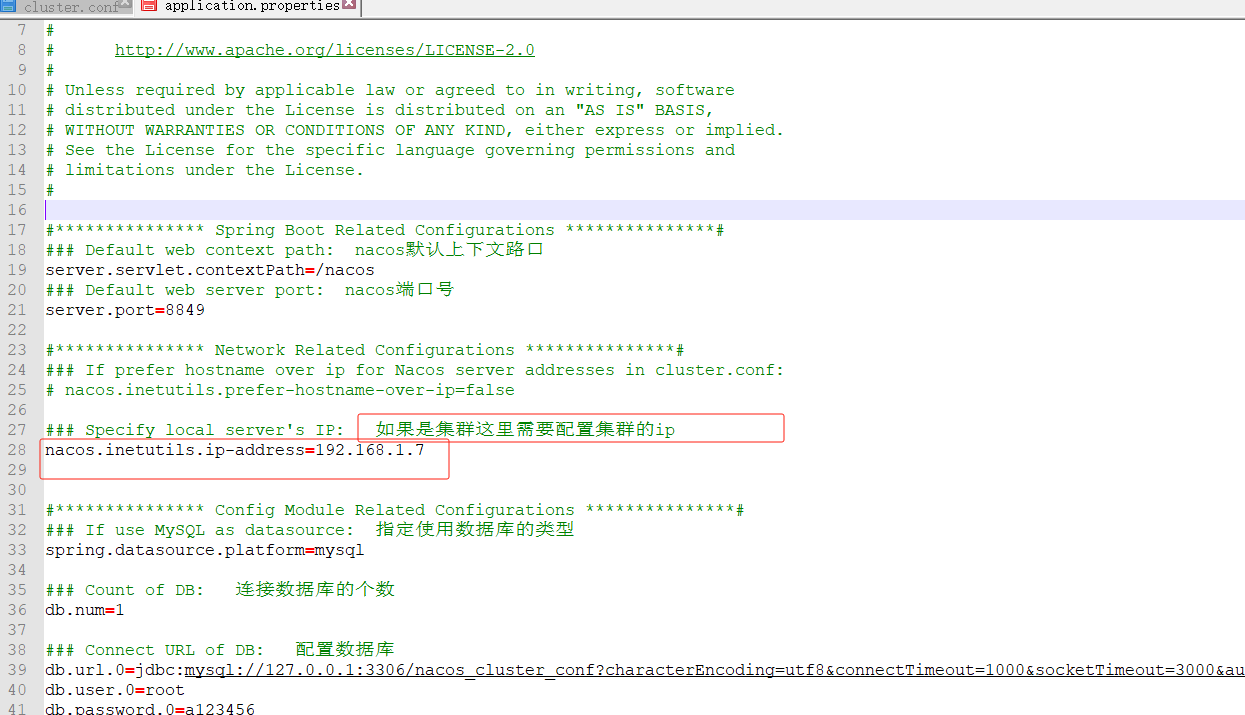

1.配置数据库信息

默认每个nacos都内置了一个deb数据库,如果使用内置的数据库则nacos集群之间无法共享数据。

新建一个数据库

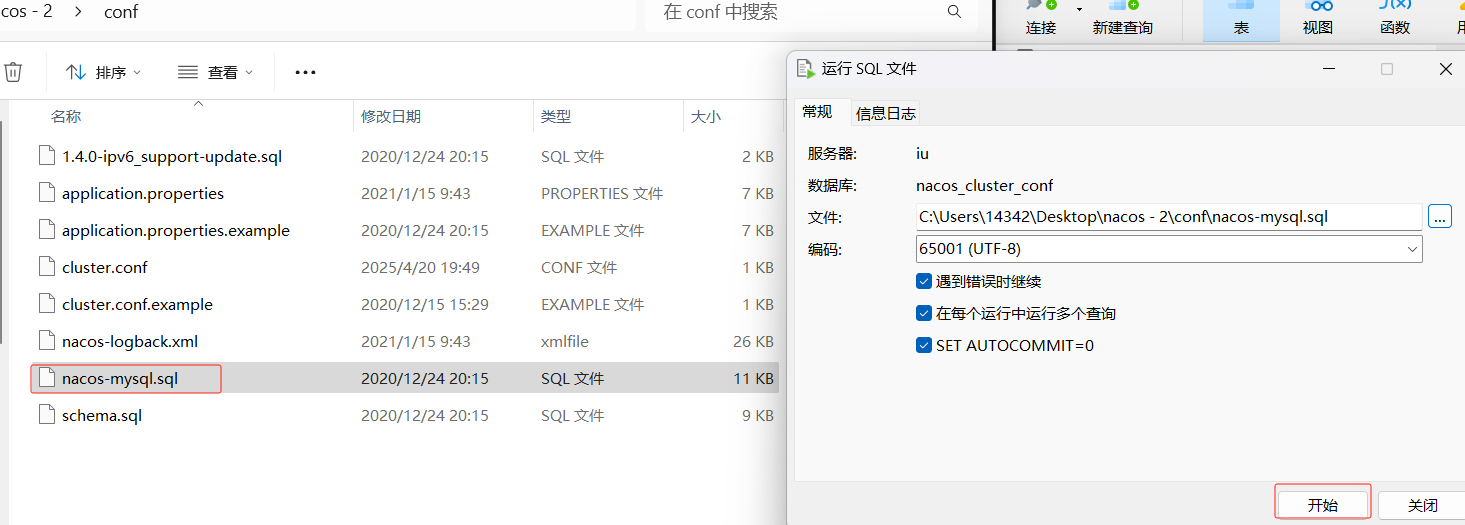

在nacos的conf下,把这个sql放入刚才建的库中

加完刷新会是这几张表

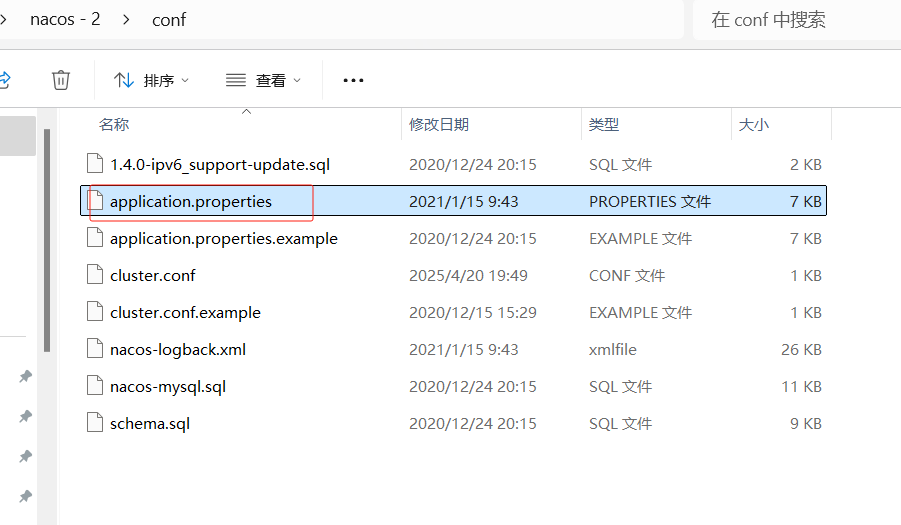

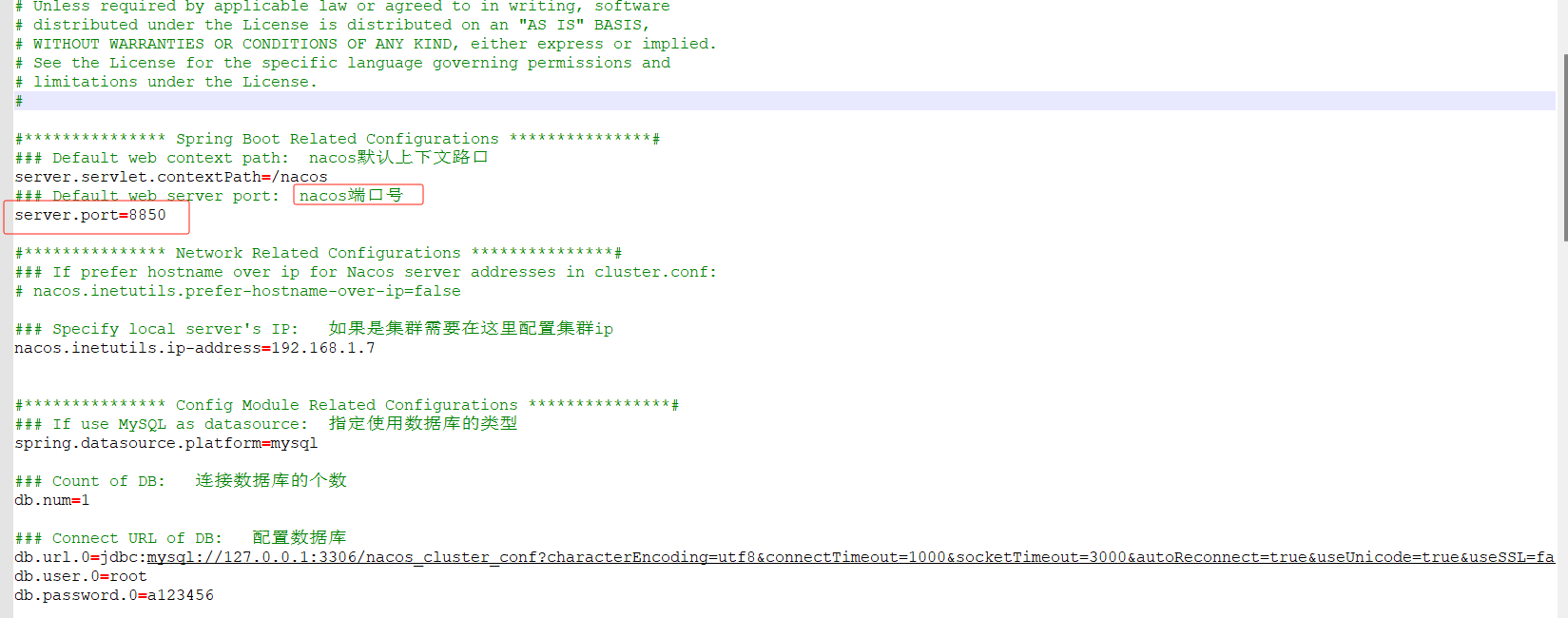

2.指定使用mysql作为数据存储

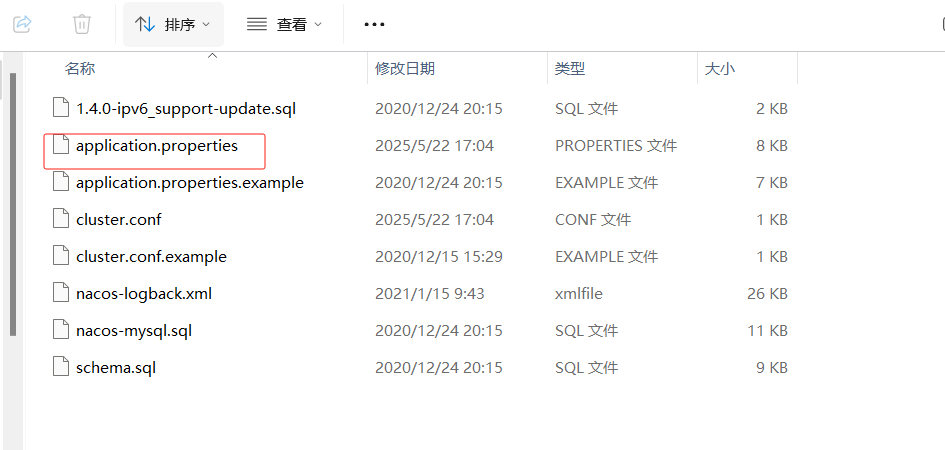

在nacos的conf下打开这个properties

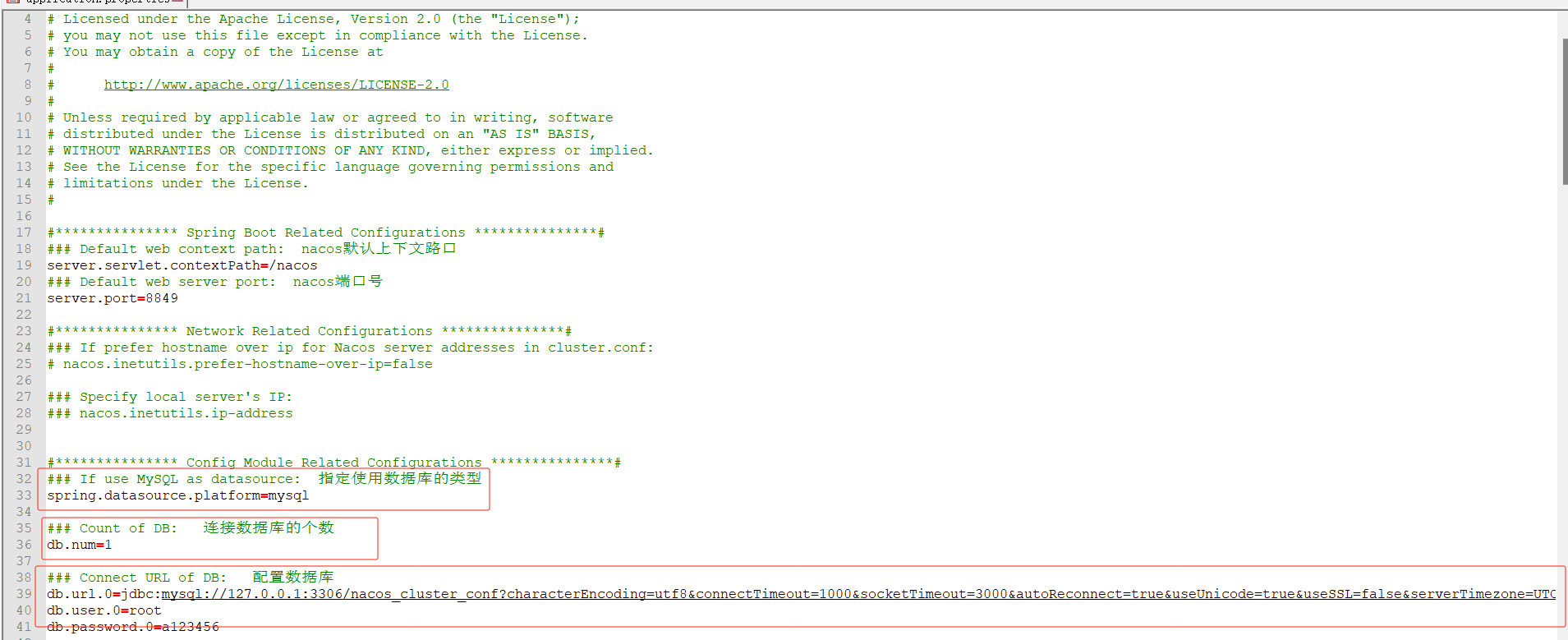

框起来的是要修改的

解开33行

解开36行

以及配置39、40、41行的数据库信息

解开28行并且配置你集群的ip

3.配置集群文件

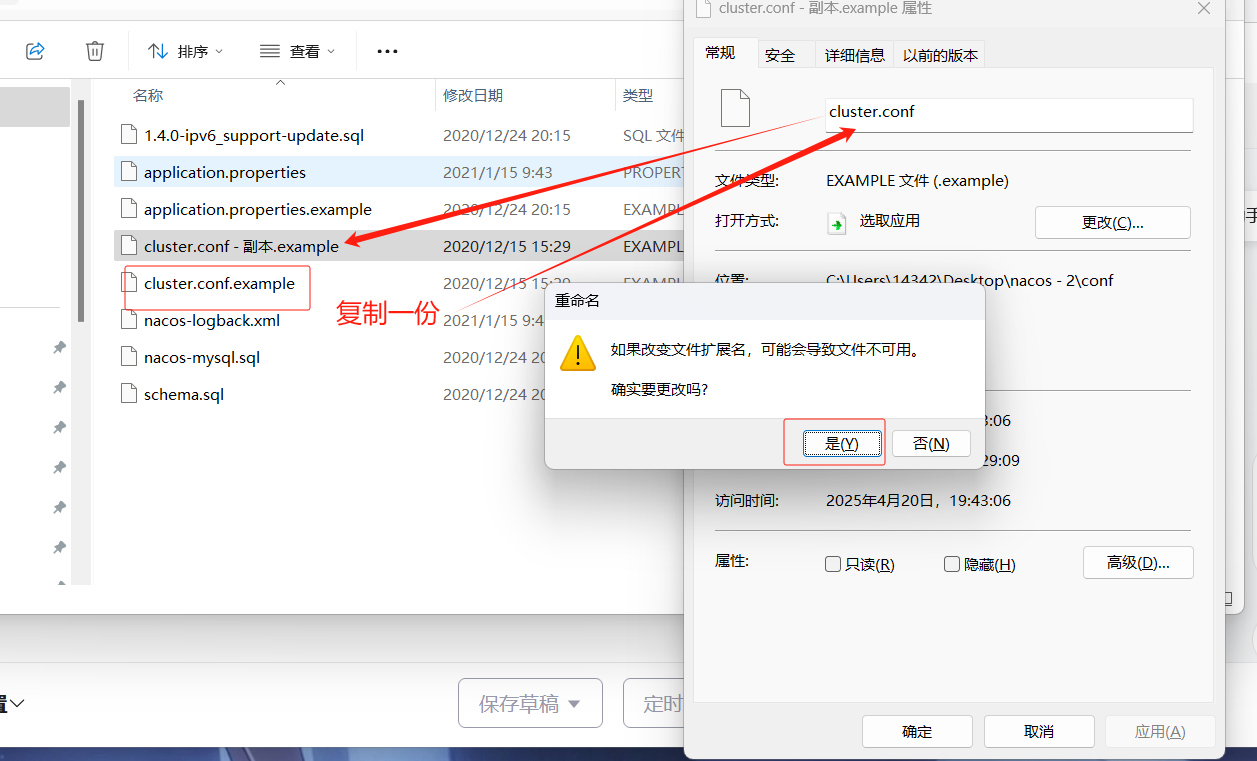

进入到nacos中的conf

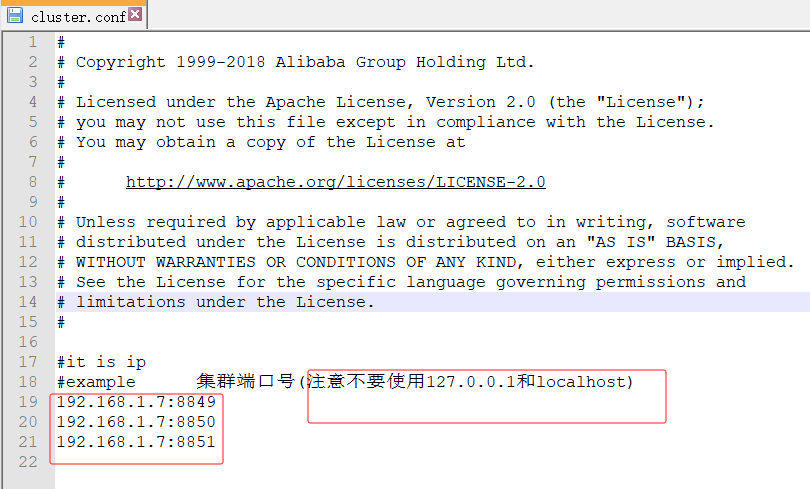

复制cluster.conf.example一份改为cluster.conf,然后用记事本打开或者其他打开

修改配置

注意不要使用127.0.0.1和localhost

#

# Copyright 1999-2018 Alibaba Group Holding Ltd.

#

# Licensed under the Apache License, Version 2.0 (the "License");

# you may not use this file except in compliance with the License.

# You may obtain a copy of the License at

#

# http://www.apache.org/licenses/LICENSE-2.0

#

# Unless required by applicable law or agreed to in writing, software

# distributed under the License is distributed on an "AS IS" BASIS,

# WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

# See the License for the specific language governing permissions and

# limitations under the License.

#

#it is ip

#example 集群端口号(注意不要使用127.0.0.1和localhost)

192.168.1.7:8849

192.168.1.7:8850

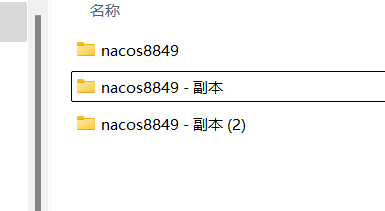

192.168.1.7:88514.复制nacos

直接复制一下写好的nacos,复制两份

5.修改端口号

需要改一下applicant.properties,修改剩下你上面集群配置的端口号就行了

6.集群启动

双击(没配置集群注意要用单例启动)

启动三台nacos此时可以任意访问其中一个端口

此时三个端口号任意一个都可以访问到

![]()

![]()

并且可以查看集群节点的信息并且可以查看节点状态,UP就是启动状态,DOWN就是未启动

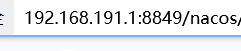

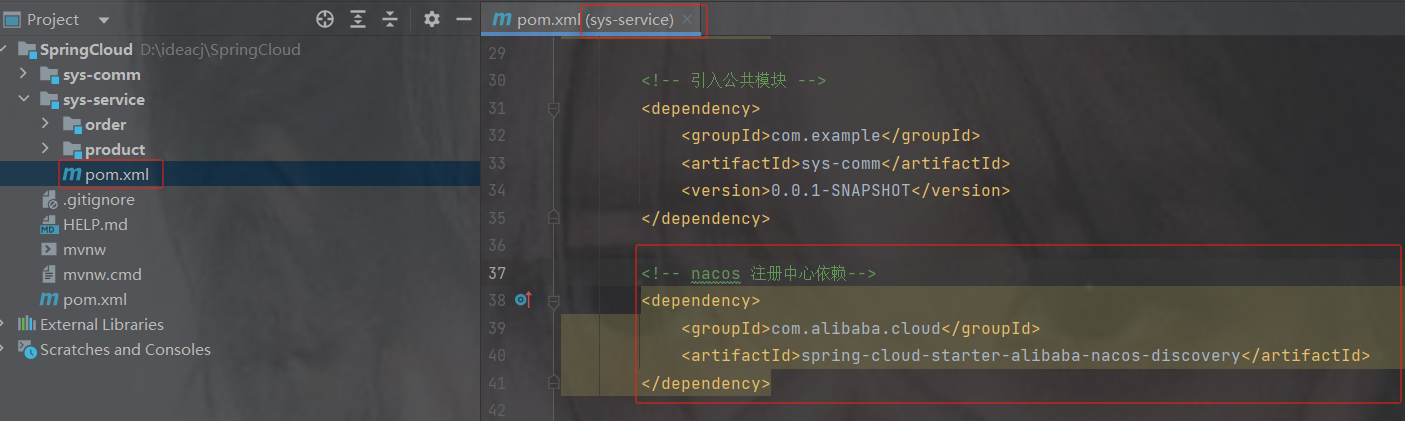

3.4 将服务注册到 nacos中:

1.在pom.xml中添加nacos的依赖

com.alibaba.cloud

spring-cloud-starter-alibaba-nacos-discovery

2. 在application.properties添加nacos的配置

#设置nacos的注册中心地址

spring.cloud.nacos.discovery.server-addr=localhost:8848

#设置nacos的命名空间

spring.application.name=product-service

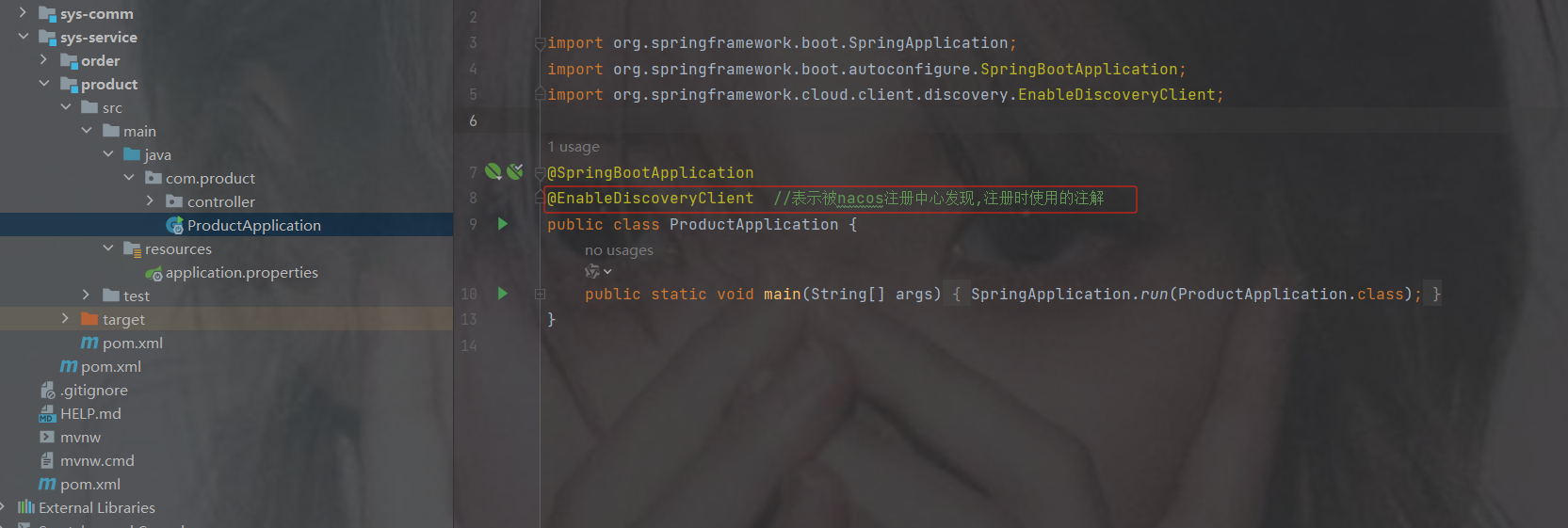

3. 在主启动类上添加nacos的开启注解

@EnableDiscoveryClient //表示被Nacos发现

4.观察注册中心的服务列表

重启两个服务后查看nacos

注意:也用相同的 2、3 的方法注册订单模块,properties只需要修改命名空间

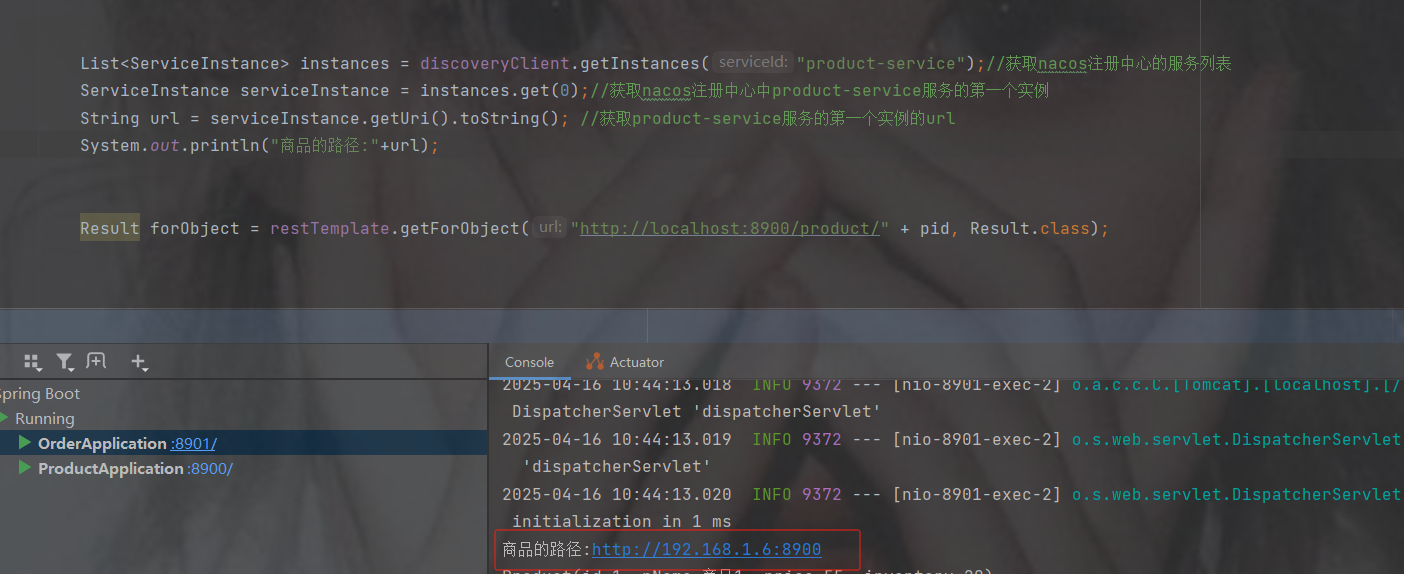

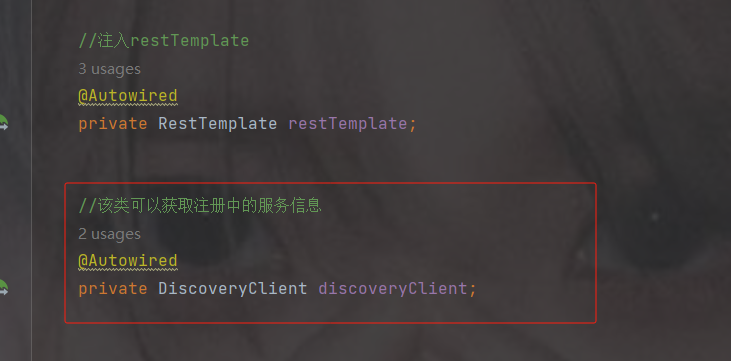

3.5 解决订单微服务和商品微服务的路径硬编码DiscoveryClient

这里的路径是硬编码,我们需要变成活的,万一端口号变了就没用了

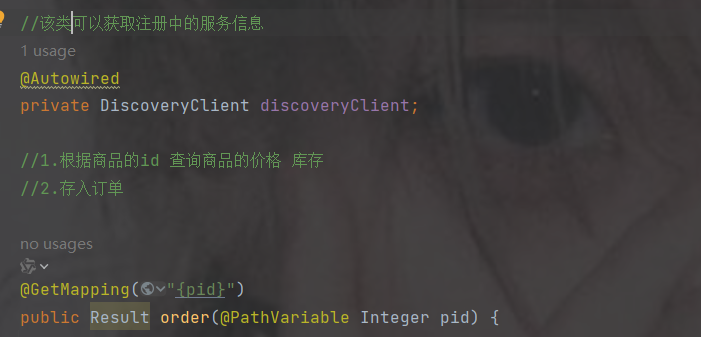

使用 DiscoveryClient:主要用于服务发现,可以获取某个服务的所有实例列表。它并不直接提供负载均衡能力,而是将选择具体实例的逻辑交给开发者实现

之前restTemplate的方式

1.注入DiscoveryClient,自带的不用配置

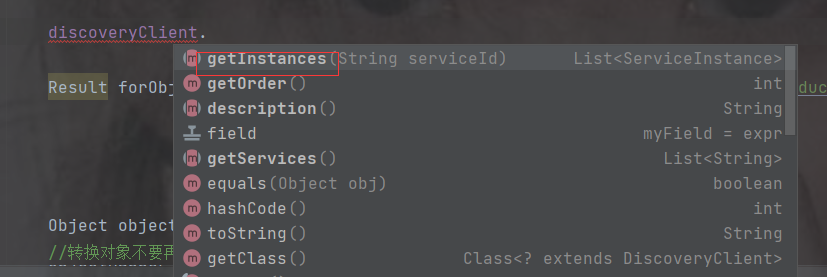

2.调用getInstances获取示例,传入的参数是注册中心的示例名

该返回的是个数组类型,因为可能有多个实例

![]()

获取第一个实例后再获取url,打印url

修改路径

代码

package com.order.controller;

import com.comm.entity.Product;

import com.comm.utlis.Result;

import com.fasterxml.jackson.databind.ObjectMapper;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.cloud.client.ServiceInstance;

import org.springframework.cloud.client.discovery.DiscoveryClient;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PathVariable;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RestController;

import org.springframework.web.client.RestTemplate;

import java.util.List;

import java.util.Map;

@RestController

@RequestMapping("/order")

public class OrderController {

//注入restTemplate

@Autowired

private RestTemplate restTemplate;

//该类可以获取注册中的服务信息

@Autowired

private DiscoveryClient discoveryClient;

//1.根据商品的id 查询商品的价格 库存

//2.存入订单

@GetMapping("{pid}")

public Result order(@PathVariable Integer pid) {

List instances = discoveryClient.getInstances("product-service");//获取nacos注册中心的服务列表

ServiceInstance serviceInstance = instances.get(0);//获取nacos注册中心中product-service服务的第一个实例

String url = serviceInstance.getUri().toString(); //获取product-service服务的第一个实例的url

System.out.println("商品的路径:" + url);

Result forObject = restTemplate.getForObject(url + "/product/" + pid, Result.class);

Object object = forObject.getData();

//转换对象不要再使用fastjson了

ObjectMapper objectMapper = new ObjectMapper();

Product product = objectMapper.convertValue(object, Product.class);

System.out.println(product);

//假装这里是存储订单的代码

return Result.ok(null);

}

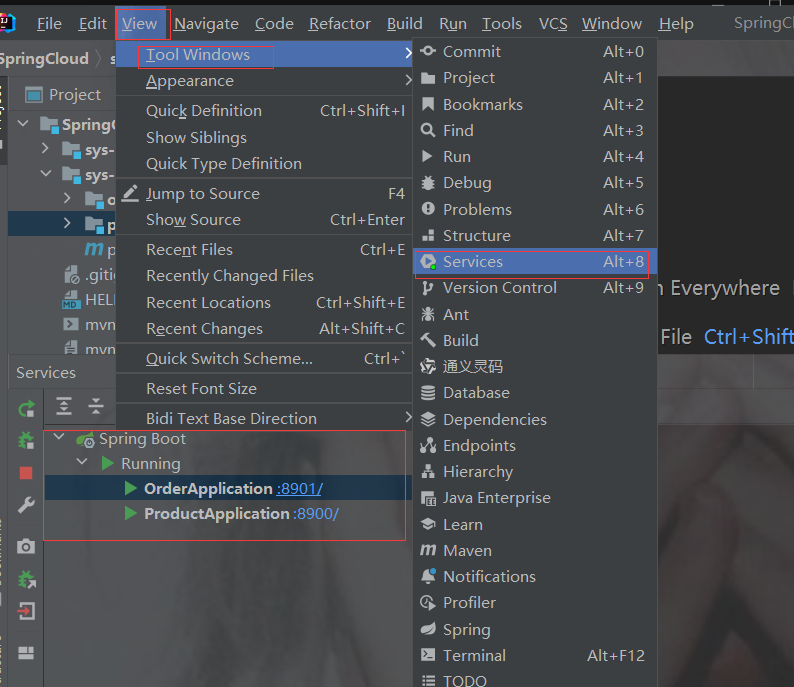

} 4. 负载均衡

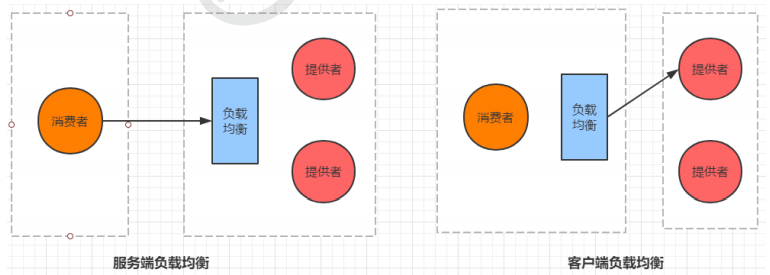

4.1 什么是负载均衡

通俗的讲, 负载均衡就是将负载(工作任务,访问请求)进行分摊到多个操作单元(服务器,组件)上 进行执行。

根据负载均衡发生位置的不同,一般分为服务端负载均衡和客户端负载均衡。

服务端负载均衡指的是发生在服务提供者一方,比如常见的nginx负载均衡

而客户端负载均衡指的是发生在服务请求的一方,也就是在发送请求之前已经选好了由哪个实例处理请 求

我们在微服务调用关系中一般会选择客户端负载均衡,也就是在服务调用的一方来决定服务由哪个提供 者执行。

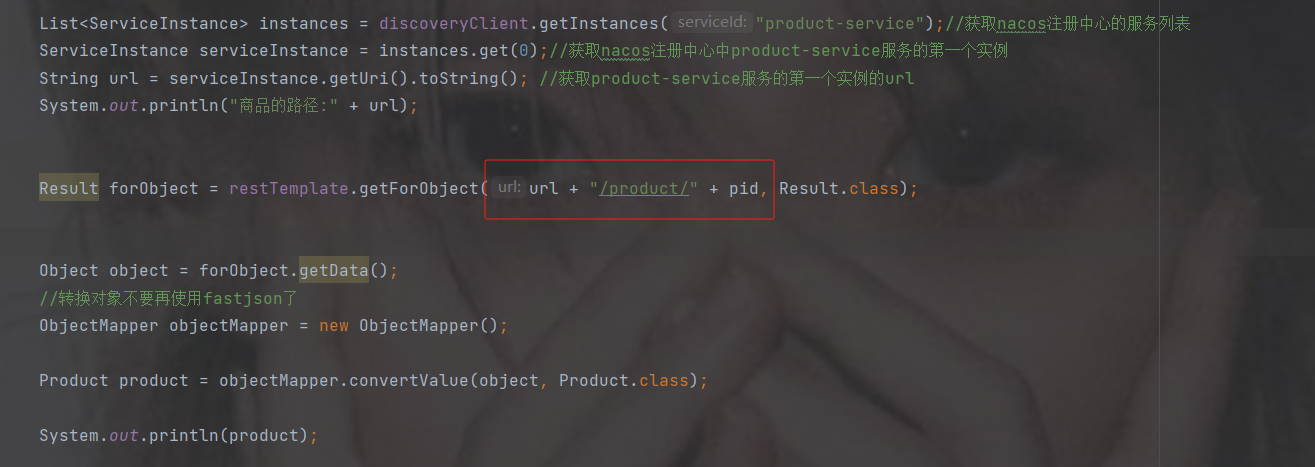

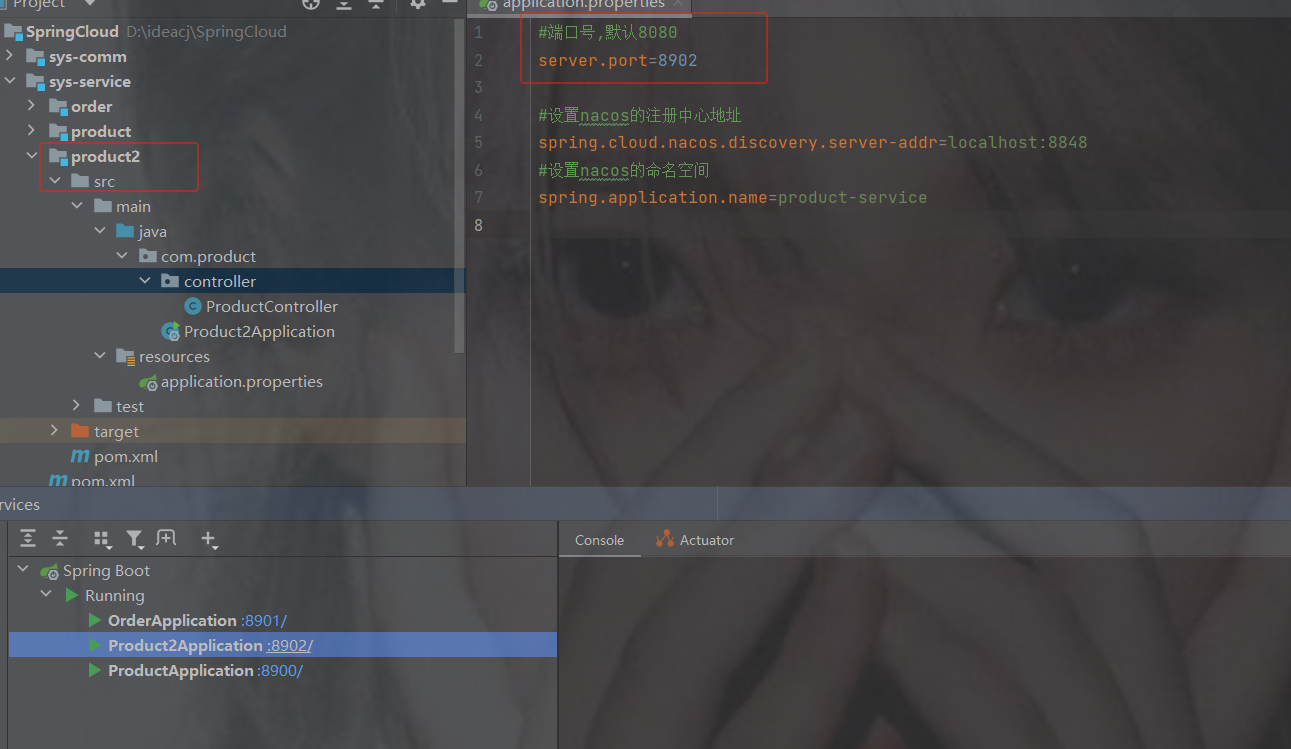

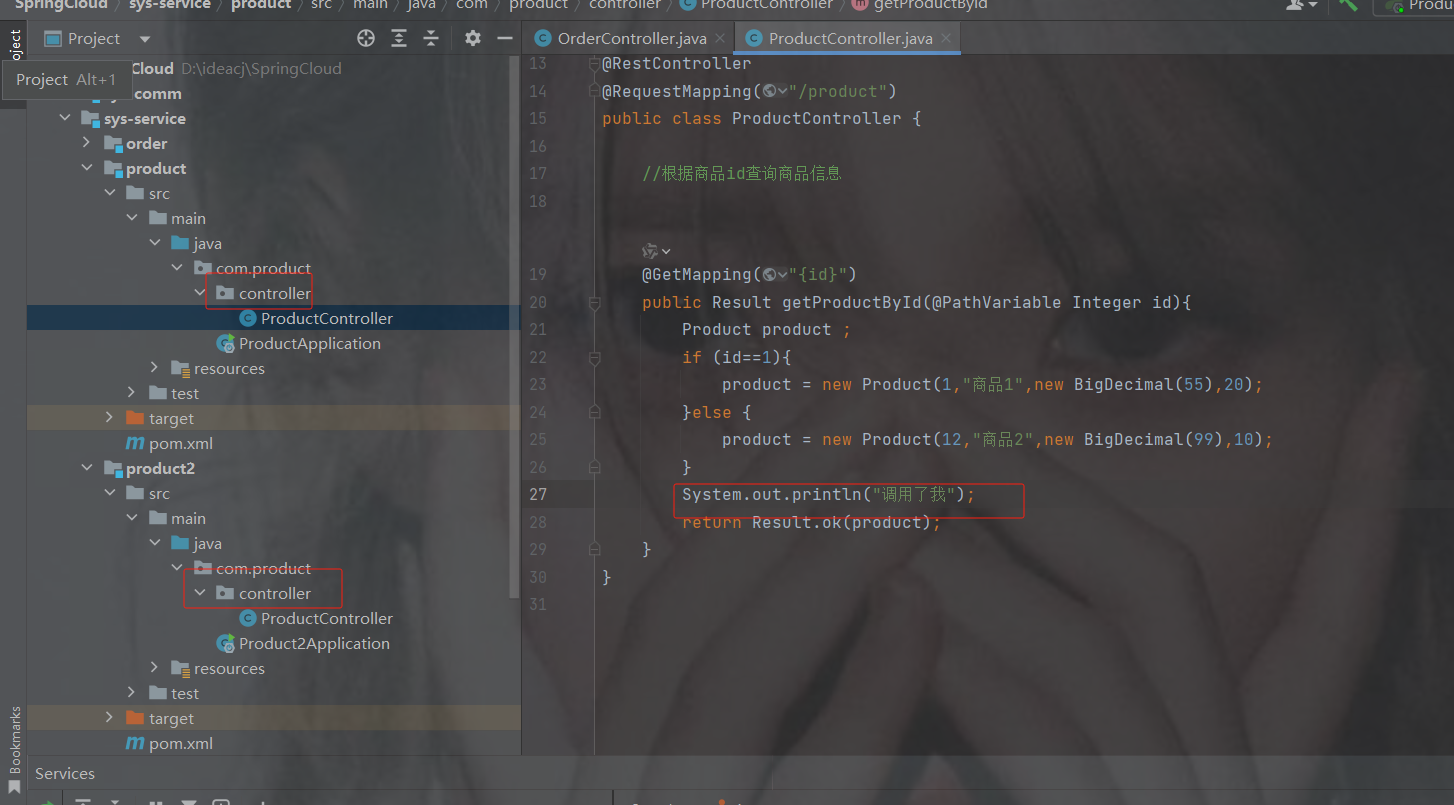

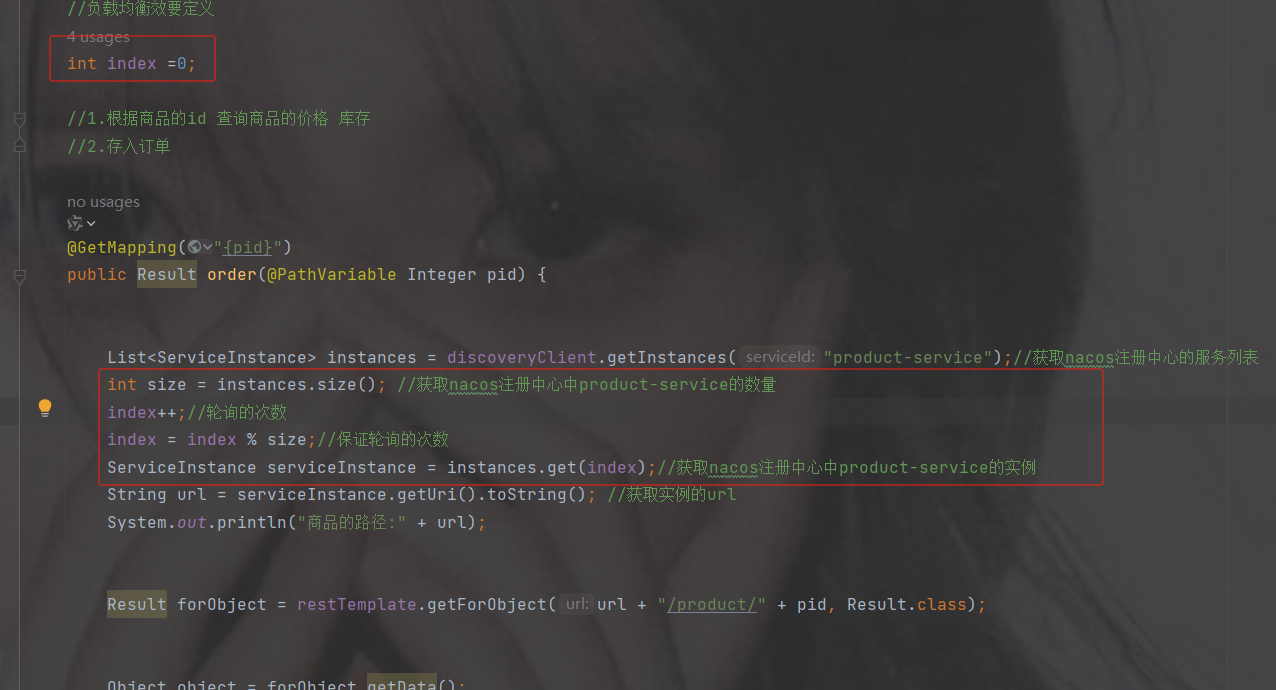

4.2 手动负载均衡

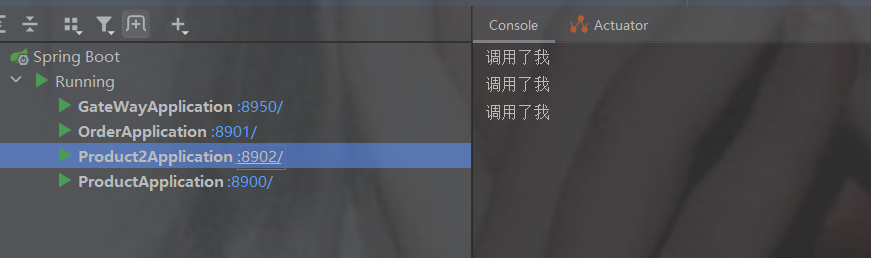

再创建一个商品的服务,和上面的商品的所有一致

注意: 除了端口号要修改和修改主启动类的名字,其他不动,注意命名空间要一样才能算两个实例

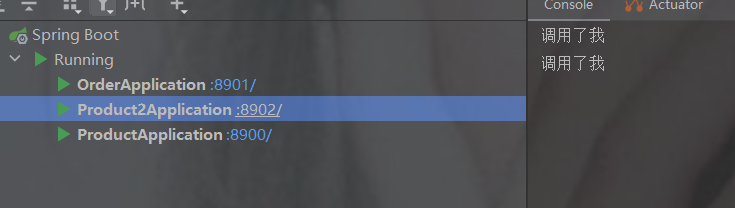

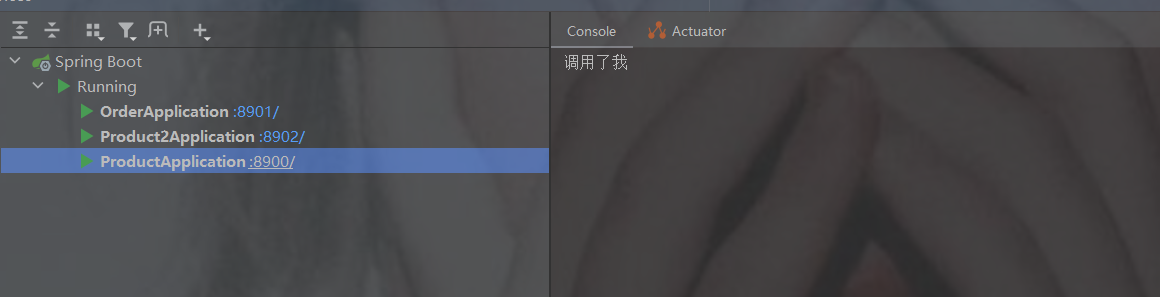

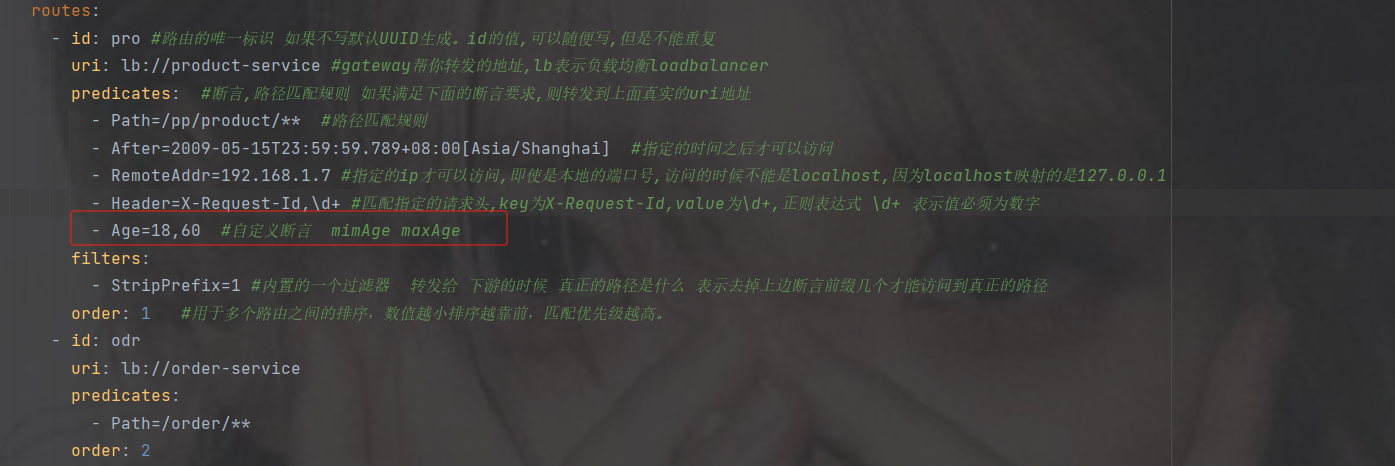

为了方便知道哪一个服务被调用,修改两个商品controller控制台打印如下图

此时重启两个商品服务后查看nacos列表就有两个实例数

点击nacos详情可以查看如下,下线就会停掉服务

默认是随机

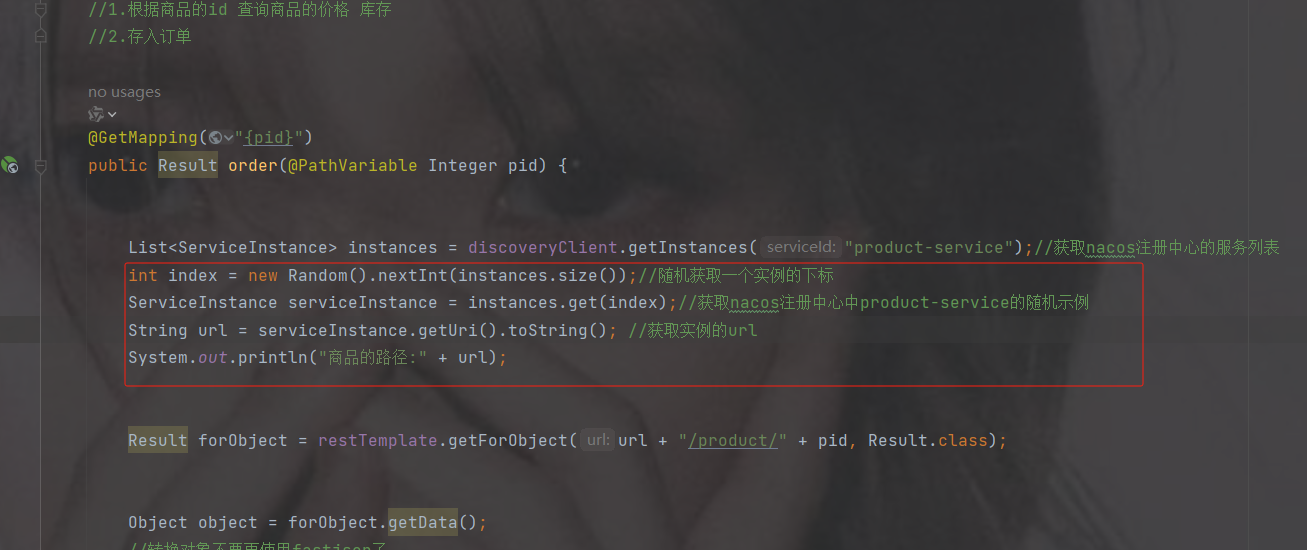

修改订单controller

使用DiscoveryClient

discovery根据服务名称调用服务列表

用随机数随机,大小是服务列表的长度

代码

package com.order.controller;

import com.comm.entity.Product;

import com.comm.utlis.Result;

import com.fasterxml.jackson.databind.ObjectMapper;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.cloud.client.ServiceInstance;

import org.springframework.cloud.client.discovery.DiscoveryClient;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PathVariable;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RestController;

import org.springframework.web.client.RestTemplate;

import java.util.List;

import java.util.Map;

import java.util.Random;

@RestController

@RequestMapping("/order")

public class OrderController {

//注入restTemplate

@Autowired

private RestTemplate restTemplate;

//该类可以获取注册中的服务信息

@Autowired

private DiscoveryClient discoveryClient;

//1.根据商品的id 查询商品的价格 库存

//2.存入订单

@GetMapping("{pid}")

public Result order(@PathVariable Integer pid) {

List instances = discoveryClient.getInstances("product-service");//获取nacos注册中心的服务列表

int index = new Random().nextInt(instances.size());//随机获取一个实例的下标

ServiceInstance serviceInstance = instances.get(index);//获取nacos注册中心中product-service的随机示例

String url = serviceInstance.getUri().toString(); //获取实例的url

System.out.println("商品的路径:" + url);

Result forObject = restTemplate.getForObject(url + "/product/" + pid, Result.class);

Object object = forObject.getData();

//转换对象不要再使用fastjson了

ObjectMapper objectMapper = new ObjectMapper();

Product product = objectMapper.convertValue(object, Product.class);

System.out.println(product);

//假装这里是存储订单的代码

return Result.ok(null);

}

} 两个服务调用情况

负载均衡

代码

package com.order.controller;

import com.comm.entity.Product;

import com.comm.utlis.Result;

import com.fasterxml.jackson.databind.ObjectMapper;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.cloud.client.ServiceInstance;

import org.springframework.cloud.client.discovery.DiscoveryClient;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PathVariable;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RestController;

import org.springframework.web.client.RestTemplate;

import java.util.List;

import java.util.Map;

import java.util.Random;

@RestController

@RequestMapping("/order")

public class OrderController {

//注入restTemplate

@Autowired

private RestTemplate restTemplate;

//该类可以获取注册中的服务信息

@Autowired

private DiscoveryClient discoveryClient;

//负载均衡效要定义

int index =0;

//1.根据商品的id 查询商品的价格 库存

//2.存入订单

@GetMapping("{pid}")

public Result order(@PathVariable Integer pid) {

List instances = discoveryClient.getInstances("product-service");//获取nacos注册中心的服务列表

int size = instances.size(); //获取nacos注册中心中product-service的数量

index++;//轮询的次数

index = index % size;//保证轮询的次数

ServiceInstance serviceInstance = instances.get(index);//获取nacos注册中心中product-service的实例

String url = serviceInstance.getUri().toString(); //获取实例的url

System.out.println("商品的路径:" + url);

Result forObject = restTemplate.getForObject(url + "/product/" + pid, Result.class);

Object object = forObject.getData();

//转换对象不要再使用fastjson了

ObjectMapper objectMapper = new ObjectMapper();

Product product = objectMapper.convertValue(object, Product.class);

System.out.println(product);

//假装这里是存储订单的代码

return Result.ok(null);

}

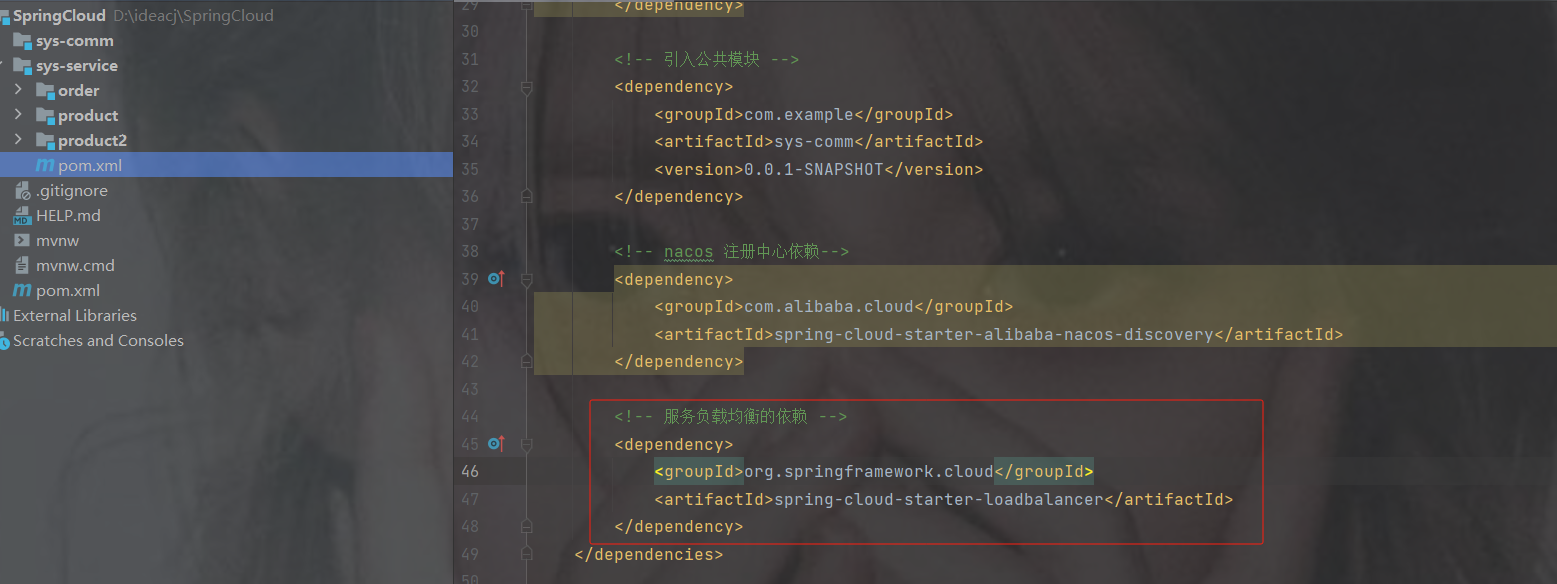

} 4.3 使用springcloud提供的负载均衡组件--LoadBalancer

我们自己可以手动完成负载均衡。那么springcloud也会提供一个负载均衡组件。

早期使用的为ribbon组件.属于netflix公司。但是 ribbon停止更新。

在 Spring Cloud 2020.0.0 版本之后已经被移除了,取而代之的是Spring Cloud

的 LoadBalancer,而且 Ribbon 也已经不再维护,所以它也是 Spring 官方推荐的负载均衡解决方案。

默认负载均衡

1.添加依赖

org.springframework.cloud

spring-cloud-starter-loadbalancer

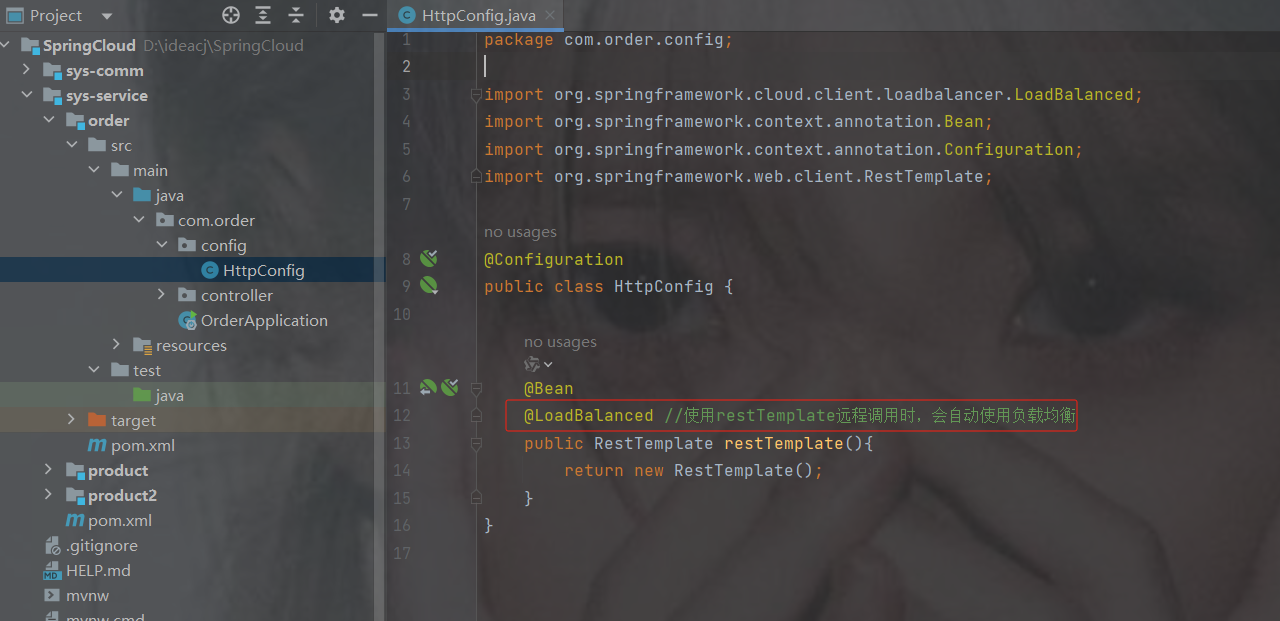

2.在RestTemplate类上使用@LoadBalanced

@LoadBalanced //使用restTemplate远程调用时,会自动使用负载均衡注意开启此注解,那么 restTemplate获取的是服务名而不再是url

3.修改OrderController代码

注意,开启负载均衡后,

restTemplate里url调用的是http://服务名称/接口路径,而不是url

package com.order.controller;

import com.comm.entity.Product;

import com.comm.utlis.Result;

import com.fasterxml.jackson.databind.ObjectMapper;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.cloud.client.ServiceInstance;

import org.springframework.cloud.client.discovery.DiscoveryClient;

import org.springframework.cloud.client.loadbalancer.LoadBalanced;

import org.springframework.cloud.client.loadbalancer.LoadBalancerClient;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PathVariable;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RestController;

import org.springframework.web.client.RestTemplate;

import java.net.URI;

import java.util.List;

import java.util.Map;

import java.util.Random;

@RestController

@RequestMapping("/order")

public class OrderController {

//注入restTemplate

@Autowired

private RestTemplate restTemplate;

/**

* 使用springcloud 提供 的负载均衡

*/

@GetMapping("/{pid}")

public Result order(@PathVariable Integer pid) {

//1.根据商品的id 查询商品的价格 库存

//2.存入订单

// http://product-service/product/1 注意http://服务的名称不是url/接口路径

Result forObject = restTemplate.getForObject("http://product-service/" + "/product/" + pid, Result.class);

Object object = forObject.getData();

//转换对象不要再使用fastjson了

ObjectMapper objectMapper = new ObjectMapper();

Product product = objectMapper.convertValue(object, Product.class);

System.out.println(product);

//假装这里是存储订单的代码

return Result.ok(null);

}

}随机

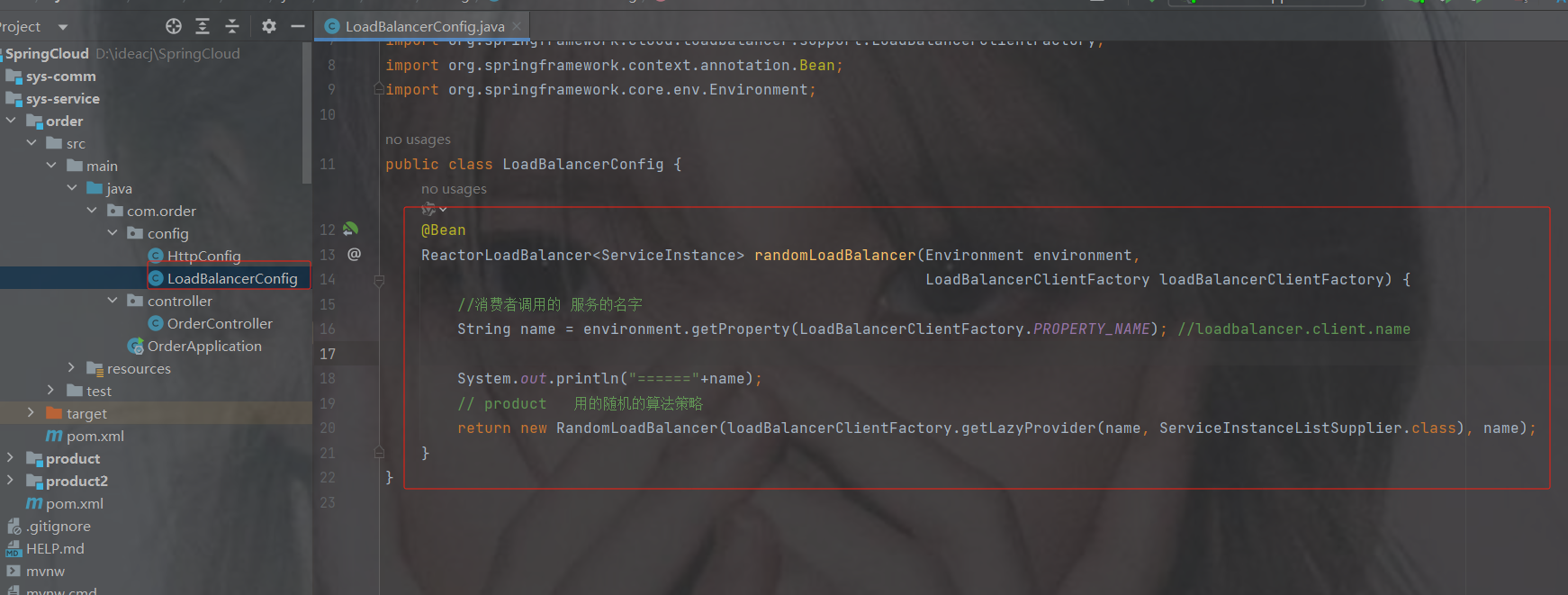

1.加配置策略

package com.order.config;

import org.springframework.cloud.client.ServiceInstance;

import org.springframework.cloud.loadbalancer.core.RandomLoadBalancer;

import org.springframework.cloud.loadbalancer.core.ReactorLoadBalancer;

import org.springframework.cloud.loadbalancer.core.ServiceInstanceListSupplier;

import org.springframework.cloud.loadbalancer.support.LoadBalancerClientFactory;

import org.springframework.context.annotation.Bean;

import org.springframework.core.env.Environment;

/* 随机算法的策略 */

public class LoadBalancerConfig {

@Bean

ReactorLoadBalancer randomLoadBalancer(Environment environment,

LoadBalancerClientFactory loadBalancerClientFactory) {

//消费者调用的 服务的名字

String name = environment.getProperty(LoadBalancerClientFactory.PROPERTY_NAME); //loadbalancer.client.name

System.out.println("======"+name);

// product 用的随机的算法策略

return new RandomLoadBalancer(loadBalancerClientFactory.getLazyProvider(name, ServiceInstanceListSupplier.class), name);

}

} 2.restTemplate加注解

@LoadBalanced,已加就不用加了

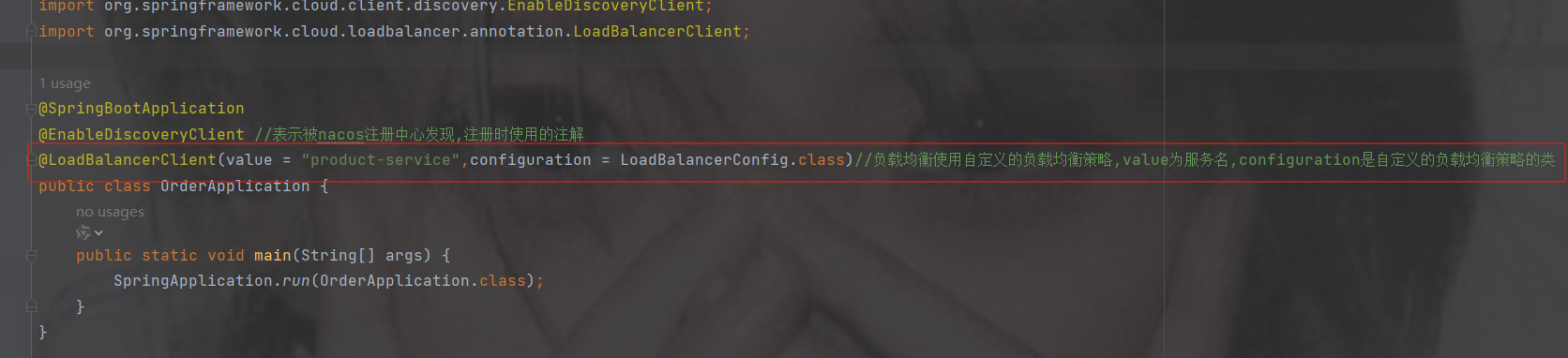

3.加注解@LoadBalancerClient

如果使用随机策略就加此注解,value是服务的名称,configuration是填写配置的类

如用不用随机策略就注掉此注解

package com.order;

import com.order.config.LoadBalancerConfig;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.cloud.client.discovery.EnableDiscoveryClient;

import org.springframework.cloud.loadbalancer.annotation.LoadBalancerClient;

import org.springframework.cloud.loadbalancer.annotation.LoadBalancerClients;

@SpringBootApplication

@EnableDiscoveryClient //表示被nacos注册中心发现,注册时使用的注解

@LoadBalancerClient(value = "product-service",configuration = LoadBalancerConfig.class)//负载均衡使用自定义的负载均衡策略,value为服务名,configuration是自定义的负载均衡策略的类

public class OrderApplication {

public static void main(String[] args) {

SpringApplication.run(OrderApplication.class);

}

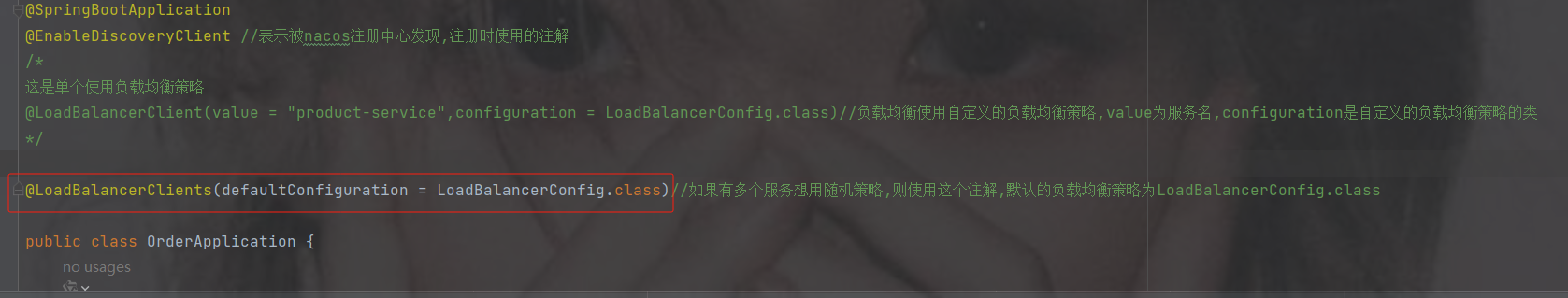

}4.4 LoadBalancerClients

单个的负载均衡策略配置查看上面随机里的4.3里的随机3

如果想让所有的服务使用随机策略使用@LoadBalancerClients

只需要指定配置类

package com.order;

import com.order.config.LoadBalancerConfig;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.cloud.client.discovery.EnableDiscoveryClient;

import org.springframework.cloud.loadbalancer.annotation.LoadBalancerClient;

import org.springframework.cloud.loadbalancer.annotation.LoadBalancerClients;

@SpringBootApplication

@EnableDiscoveryClient //表示被nacos注册中心发现,注册时使用的注解

@LoadBalancerClients(defaultConfiguration = LoadBalancerConfig.class)//如果有多个服务想用随机策略,则使用这个注解,默认的负载均衡策略为LoadBalancerConfig.class类

public class OrderApplication {

public static void main(String[] args) {

SpringApplication.run(OrderApplication.class);

}

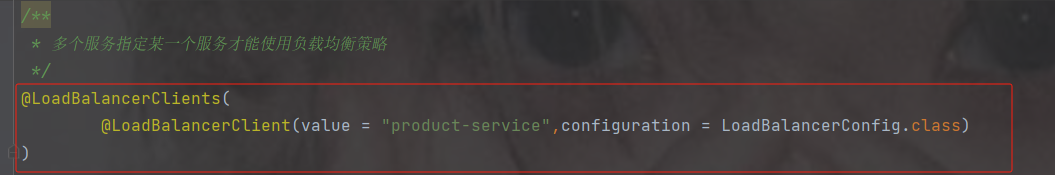

}多个服务指定某一个服务才能使用负载均衡策略

package com.order;

import com.order.config.LoadBalancerConfig;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.cloud.client.discovery.EnableDiscoveryClient;

import org.springframework.cloud.loadbalancer.annotation.LoadBalancerClient;

import org.springframework.cloud.loadbalancer.annotation.LoadBalancerClients;

@SpringBootApplication

@EnableDiscoveryClient //表示被nacos注册中心发现,注册时使用的注解

/**

* 多个服务指定某一个服务才能使用负载均衡策略

*/

@LoadBalancerClients(

@LoadBalancerClient(value = "product-service",configuration = LoadBalancerConfig.class)

)

public class OrderApplication {

public static void main(String[] args) {

SpringApplication.run(OrderApplication.class);

}

}5. openfeign完成服务调用

原来使用restTemplate完成服务之间的调用: 它不符合我们的编程习惯。

在某层需要另一层的对象时,直接通过@Autowire注入,并通过对象调用其他的方法,传入相关的参数,这才是我们的习惯。比如像下代码class UserController{

@Autowire

UserService userService;userSerice.show(15);

}

class UserService{

public void show(int a){}

}

openFeign适合调用本地服务,restTemplate适合调用第三方服务的接口.

5.1 什么是OpenFeign

OpenFeign是Spring Cloud提供的一个声明式的伪Http客户端,它使得调用远程服务就像调用本地服务一样简单,只需要创建一个接口并添加一个注解即可。

Nacos很好的兼容了OpenFeign,Feign负载均衡默认集成了 SpringCloudLoadBalanced,所以在Nacos下使用OpenFegin默认就实现了负载均衡的效果。

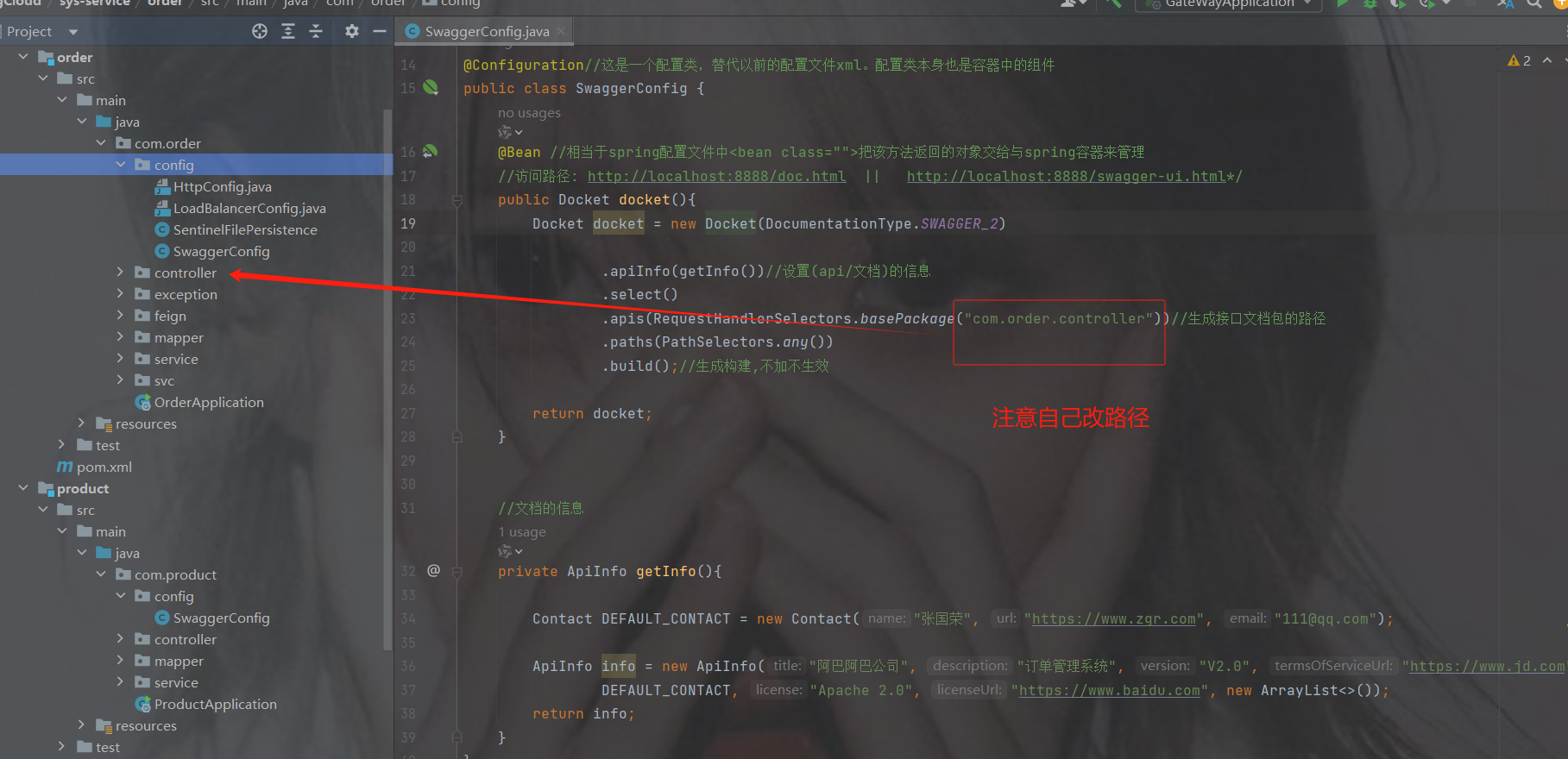

5.2 如何使用OpenFeign

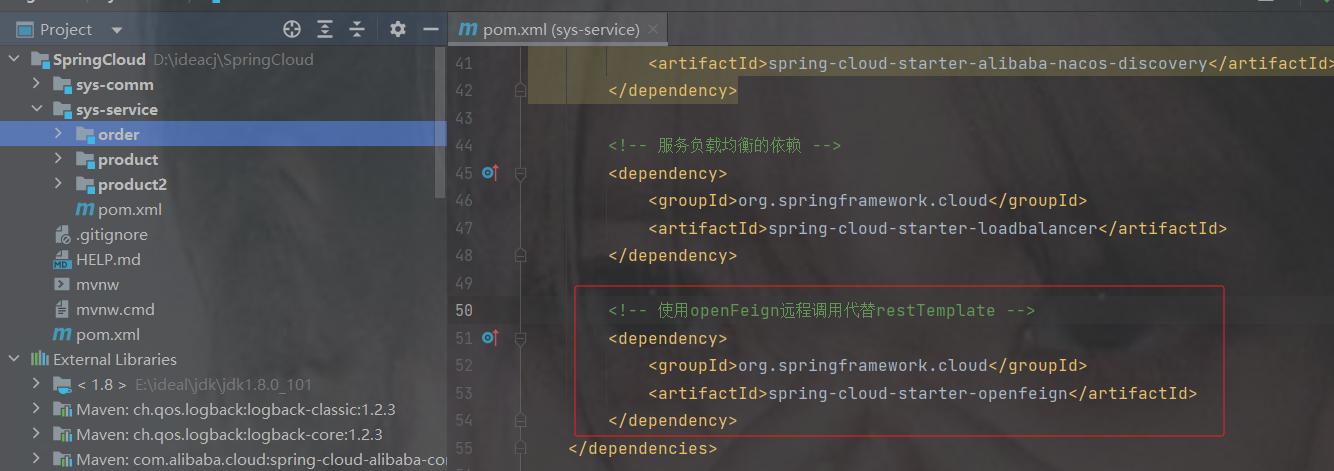

1.加依赖

org.springframework.cloud

spring-cloud-starter-openfeign

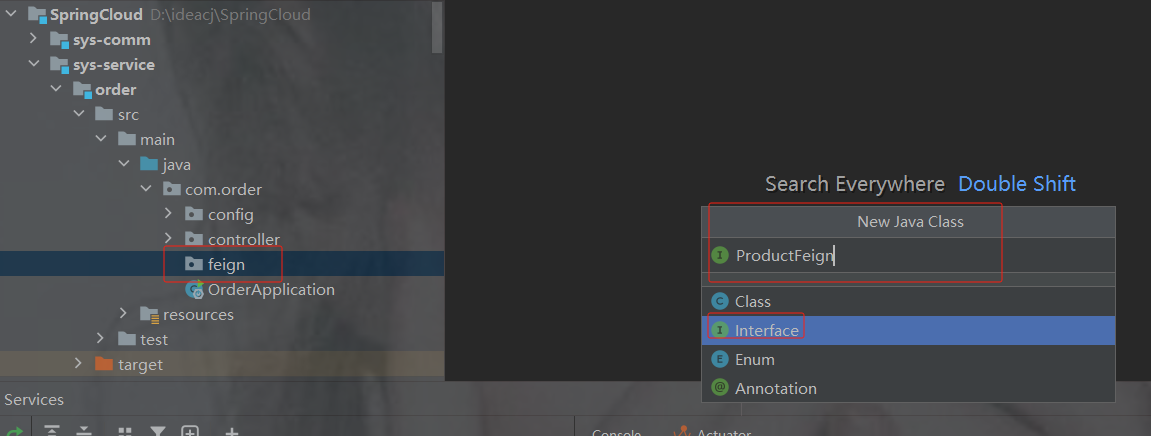

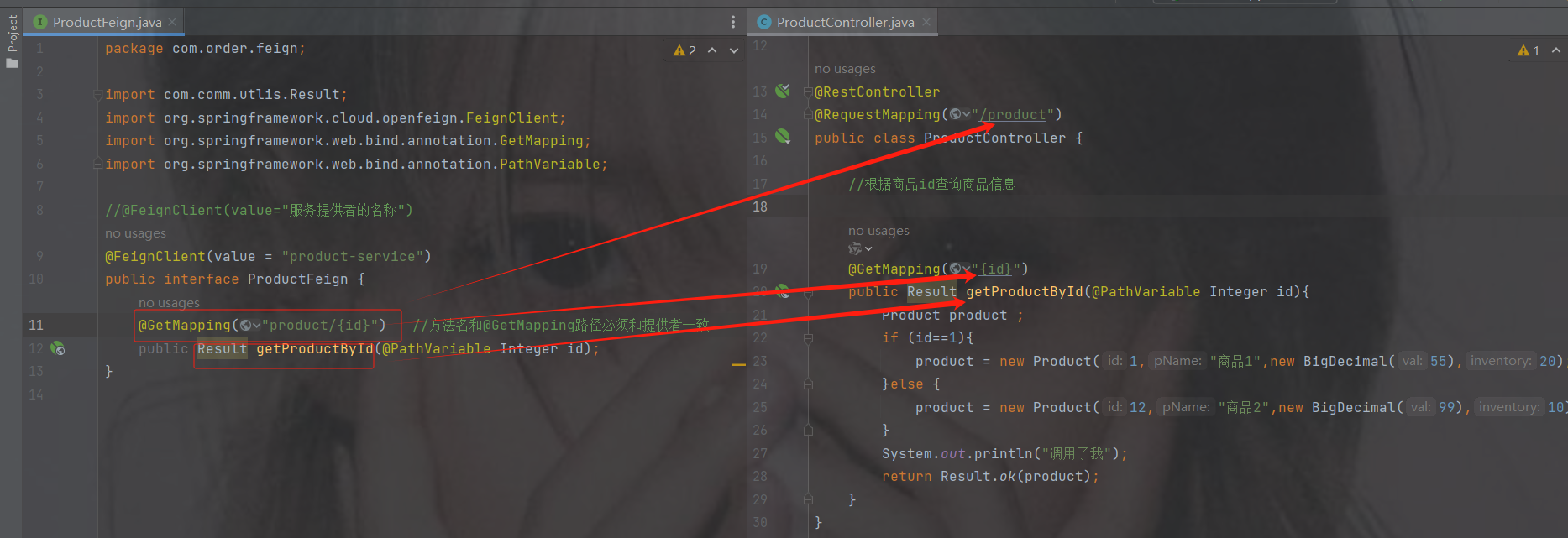

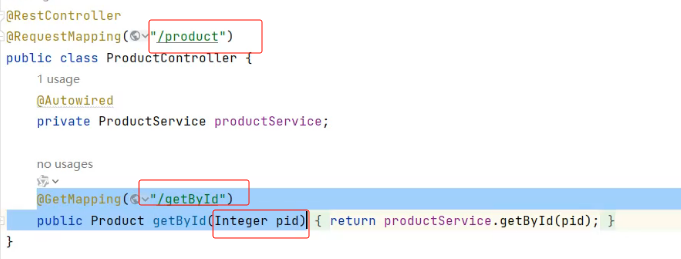

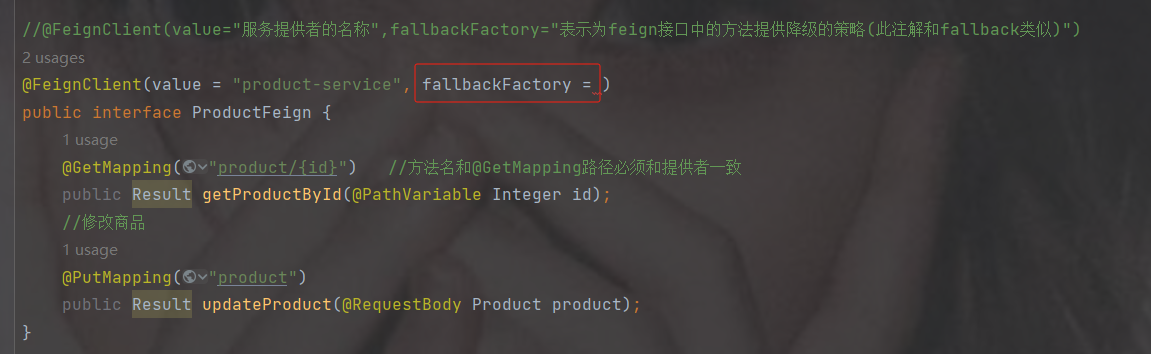

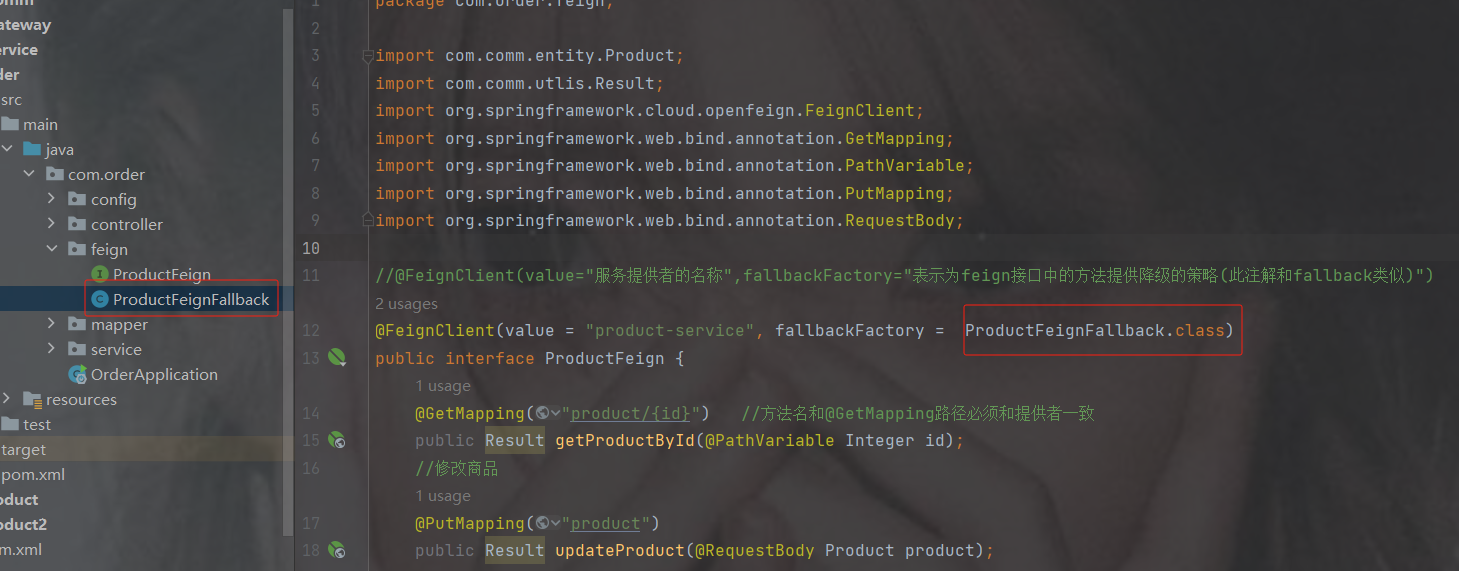

2.创建OpenFeign接口

在order创建feign的包,调用哪个服务就取哪个服务的名

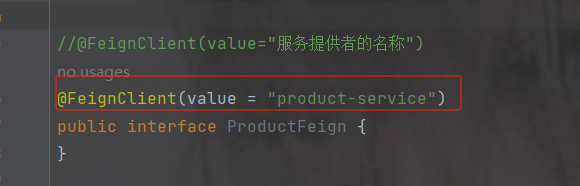

加注解@FeignClient(value="服务提供者的名称")

方法名 以及 请求类型返回值 都要一致,除了不写里面的方法

package com.order.feign;

import com.comm.utlis.Result;

import org.springframework.cloud.openfeign.FeignClient;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PathVariable;

//@FeignClient(value="服务提供者的名称")

@FeignClient(value = "product-service")

public interface ProductFeign {

@GetMapping("product/{id}") //方法名和@GetMapping路径必须和提供者一致

public Result getProductById(@PathVariable Integer id);

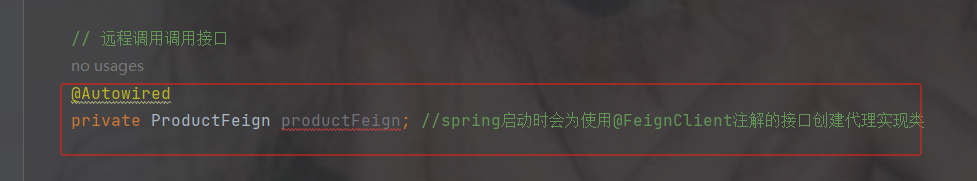

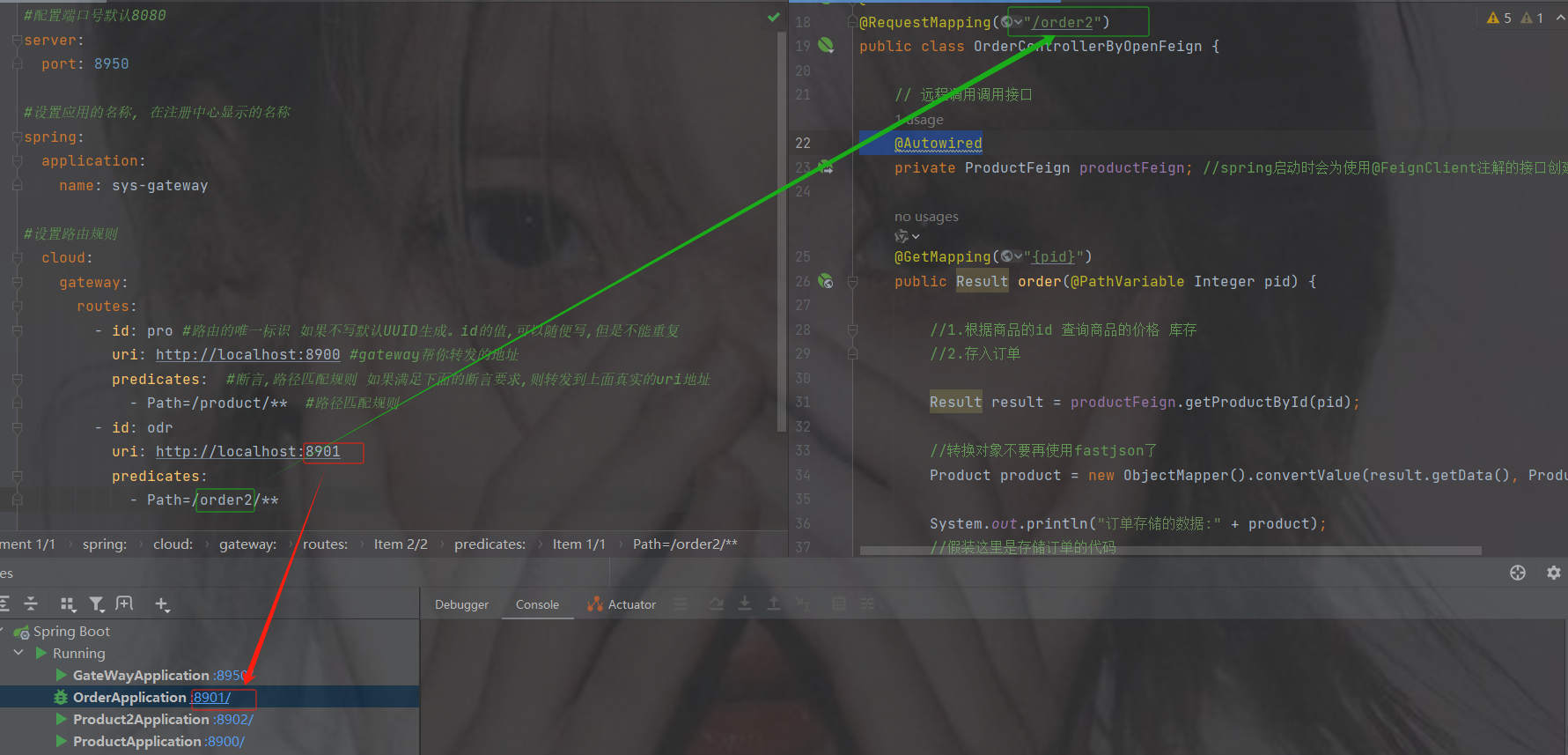

}3.修改OrderController代码

controller里调用刚才的接口

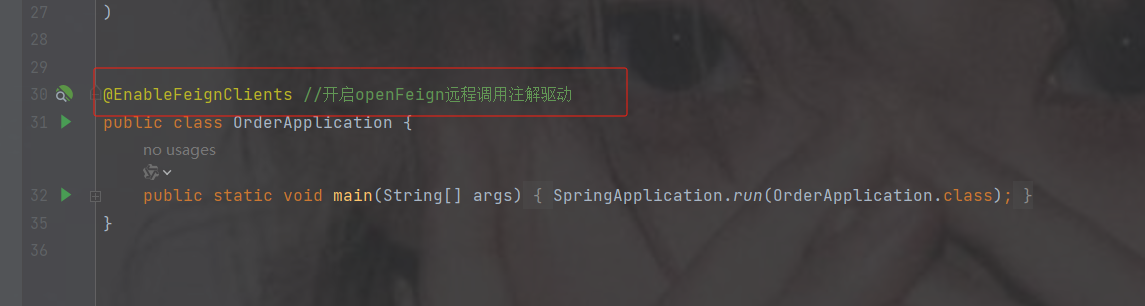

默认spring不认识@FeignClient注解

启动类加注解@EnableFeignClients----开启openFeign远程调用注解驱动

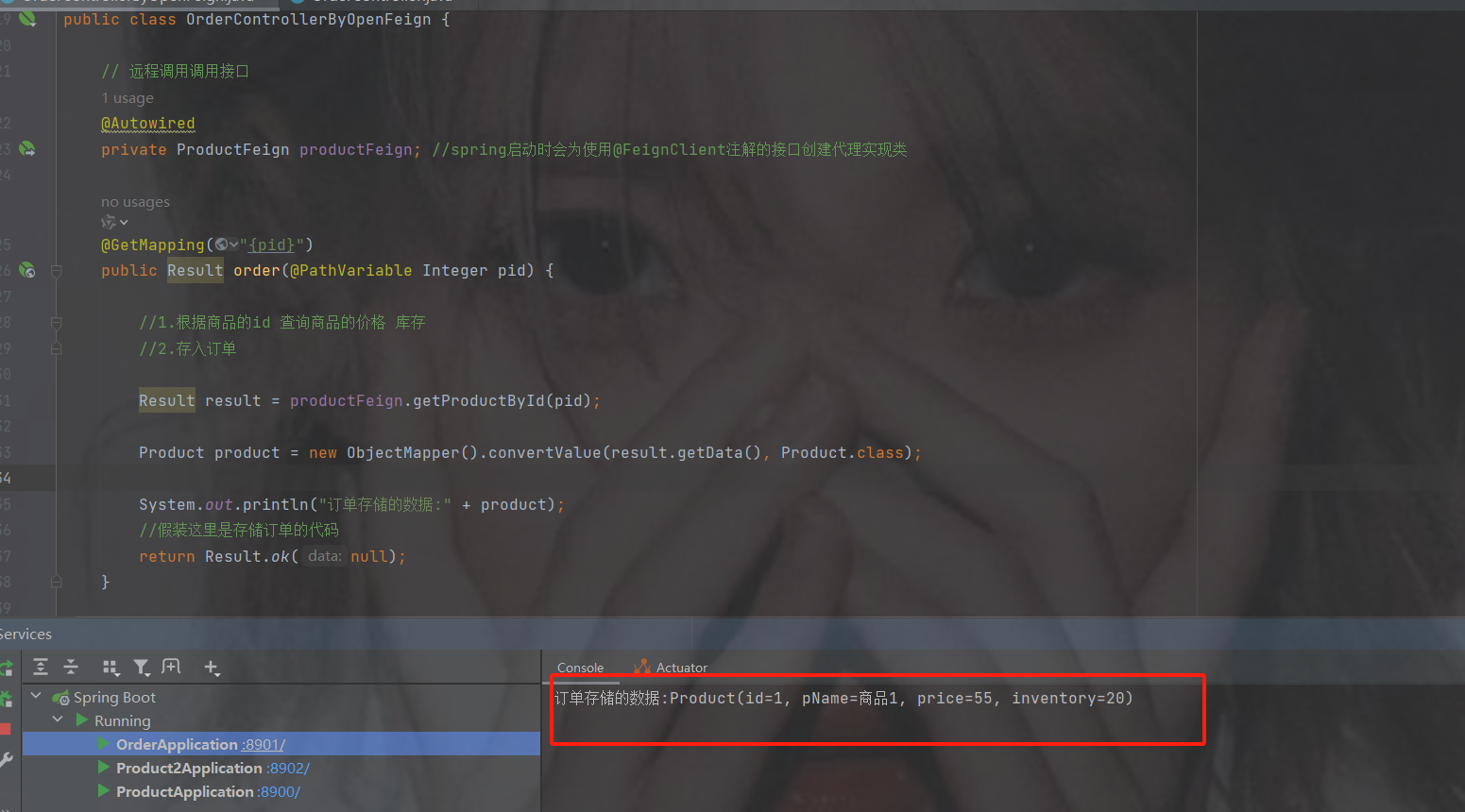

修改代码为openFeign调用

代码

package com.order.controller;

import com.comm.entity.Product;

import com.comm.utlis.Result;

import com.fasterxml.jackson.databind.ObjectMapper;

import com.order.feign.ProductFeign;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.cloud.client.ServiceInstance;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PathVariable;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RestController;

import java.util.List;

import java.util.Random;

@RestController

@RequestMapping("/order")

public class OrderControllerByOpenFeign {

// 远程调用调用接口

@Autowired

private ProductFeign productFeign; //spring启动时会为使用@FeignClient注解的接口创建代理实现类

@GetMapping("{pid}")

public Result order(@PathVariable Integer pid) {

//1.根据商品的id 查询商品的价格 库存

//2.存入订单

Result result = productFeign.getProductById(pid);

//转换对象不要再使用fastjson了

Product product = new ObjectMapper().convertValue(result.getData(), Product.class);

System.out.println("订单存储的数据:" + product);

//假装这里是存储订单的代码

return Result.ok(null);

}

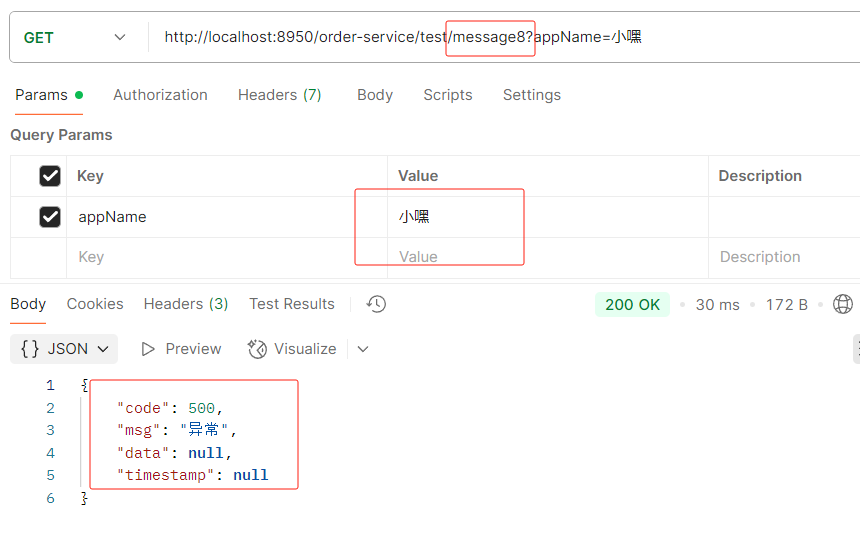

}如果你的接口路径以及参数是这样的然后报错了

那么openfeign里的参数要加@RequestParam

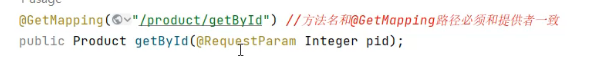

6.网关-gateway

6.1 不使用网关的问题

如果后台微服务有100台,前端需要调用时axios.get(ur1,params)记住每个微服务的ip。

如果后台某些微服务修改了ip或port号那么前端也需要修改

而且:如果后台某些微服务搭建的是集群,那么前端无法负载均衡调用解诀问题: 使用网关--->是所有微服务的入口

网关需要配置断言

6.2 网关的组件

Ngnix+lua

使用nginx的反向代理和负载均衡可实现对api服务器的负载均衡及高可用

lua是一种脚本语言,可以来编写一些简单的逻辑, nginx支持lua脚本

Kong

基于Nginx+Lua开发,性能高,稳定,有多个可用的插件(限流、鉴权等等)可以开箱即用。

问题:

只支持Http协议;二次开发,自由扩展困难;提供管理API,缺乏更易用的管控、配置方式。

Zuul

zuul 它是netfix公司提供的一款网关组件。基于servlet实现,效率慢。后期提成zuul2.0 但是没有出来。

问题:缺乏管控,无法动态配置;依赖组件较多;处理Http请求依赖的是Web容器,性能不如Nginx

Spring Cloud Gateway

Spring Cloud Gateway是Spring公司基于Spring 5.0,Spring Boot 2.0 和 Project Reactor 等术开发的网关,它旨在为微服务架构提供一种简单有效的统一的 API 路由管理方式。它的目标是替代 Netflflix Zuul,其不仅提供统一的路由方式,并且基于 Filter 链的方式提供了网关基本的功能,例如:安全,监控和限流。

优点:

性能强劲:是第一代网关Zuul的1.6倍

功能强大:内置了很多实用的功能,例如转发、监控、限流等

设计优雅,容易扩展

缺点:

其实现依赖Netty与WebFlux,不是传统的Servlet编程模型,学习成本高

不能将其部署在Tomcat、Jetty等Servlet容器里,只能打成jar包执行

需要Spring Boot 2.0及以上的版本,才支持

6.3 使用注意事项

1. gateway本身也是一个微服务

也要注册到 nacos 里面

2. Jar 包和 spring-boot-starter-web 有冲突

服务注册到 nacos,中的时候Ip地址 不能是虚拟机地址

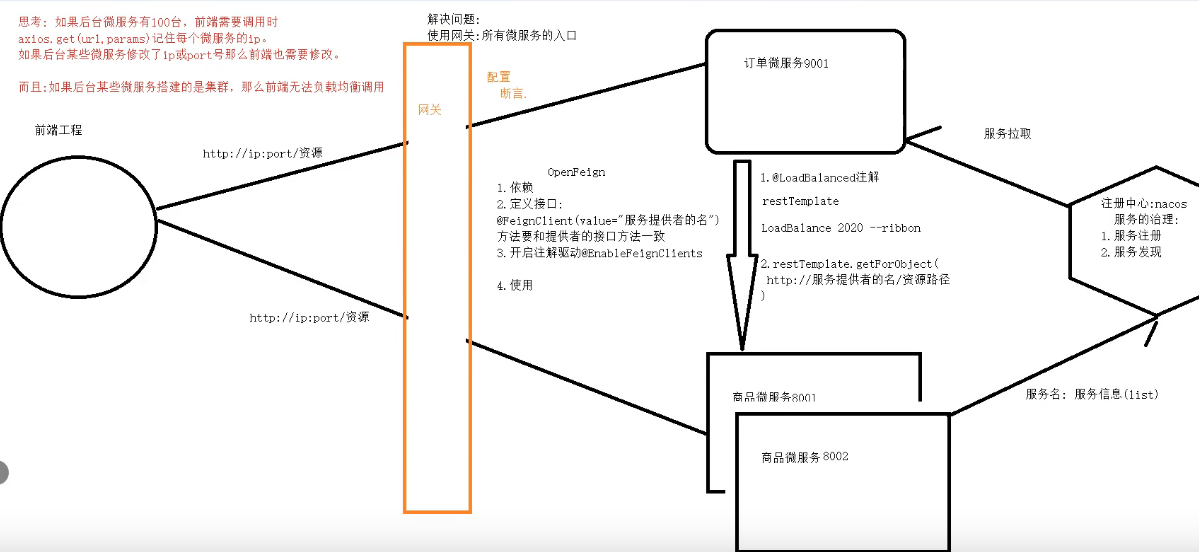

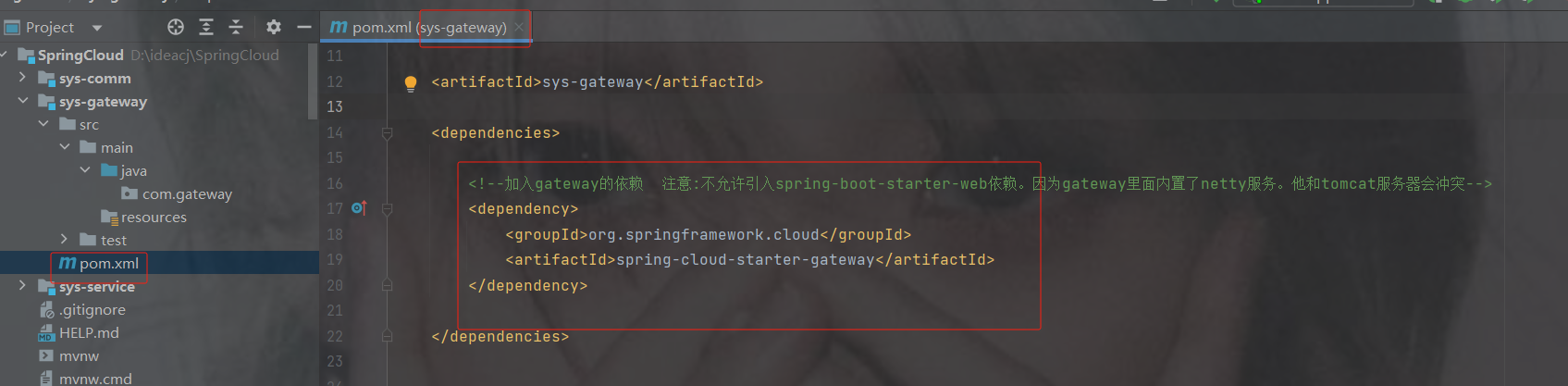

6.4 快速使用gateway

1.创建gateway模块

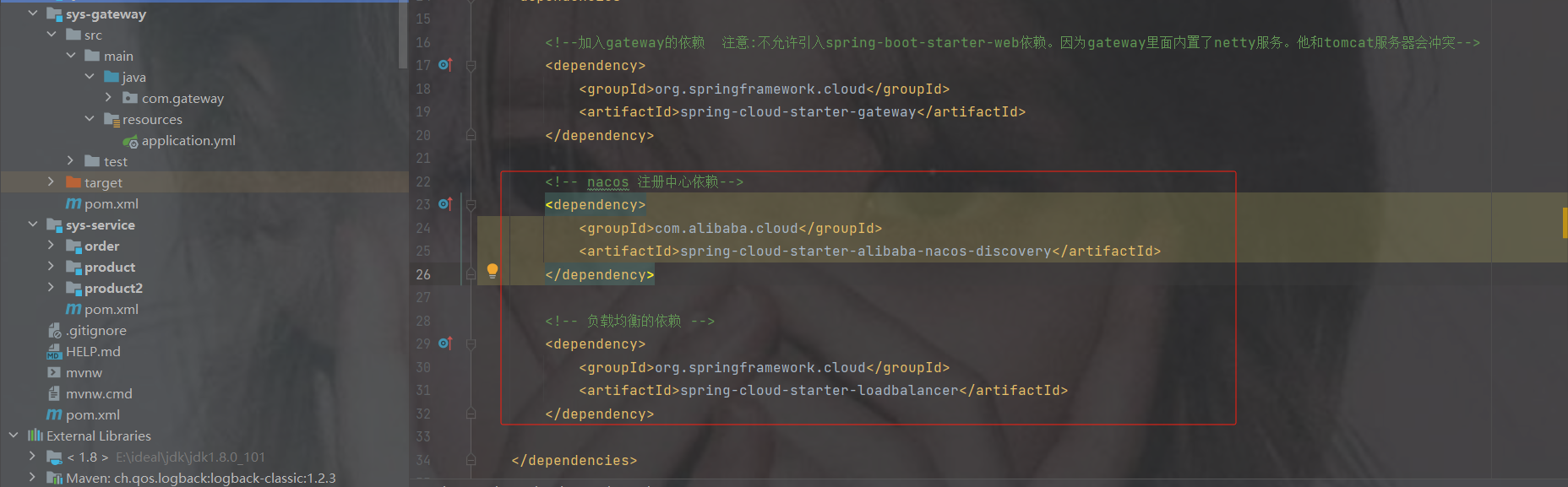

2.引入依赖

注意:不允许引入spring-boot-starter-web依赖,因为gateway里面内置了netty服务。他和tomcat服务器会冲突

org.springframework.cloud

spring-cloud-starter-gateway

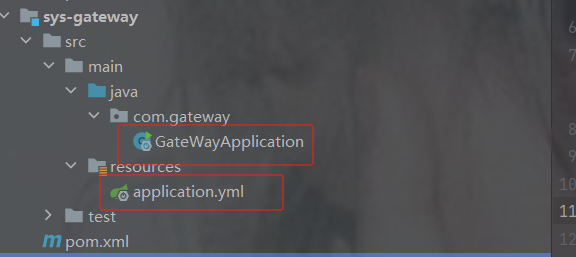

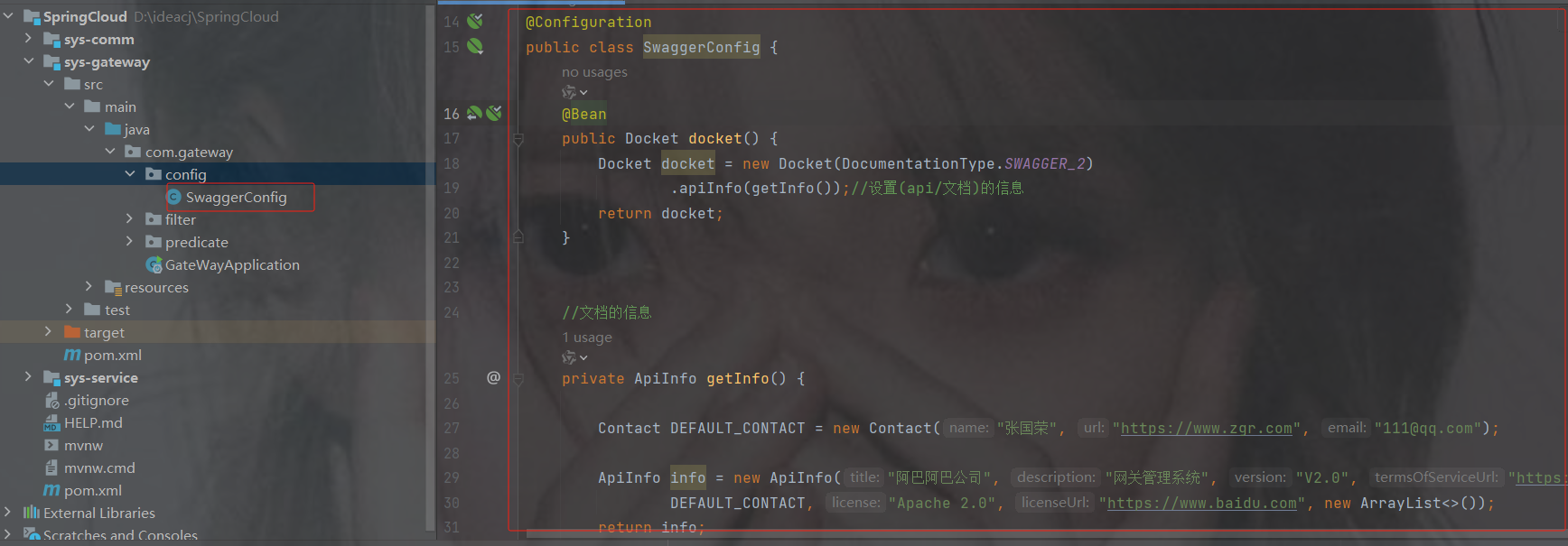

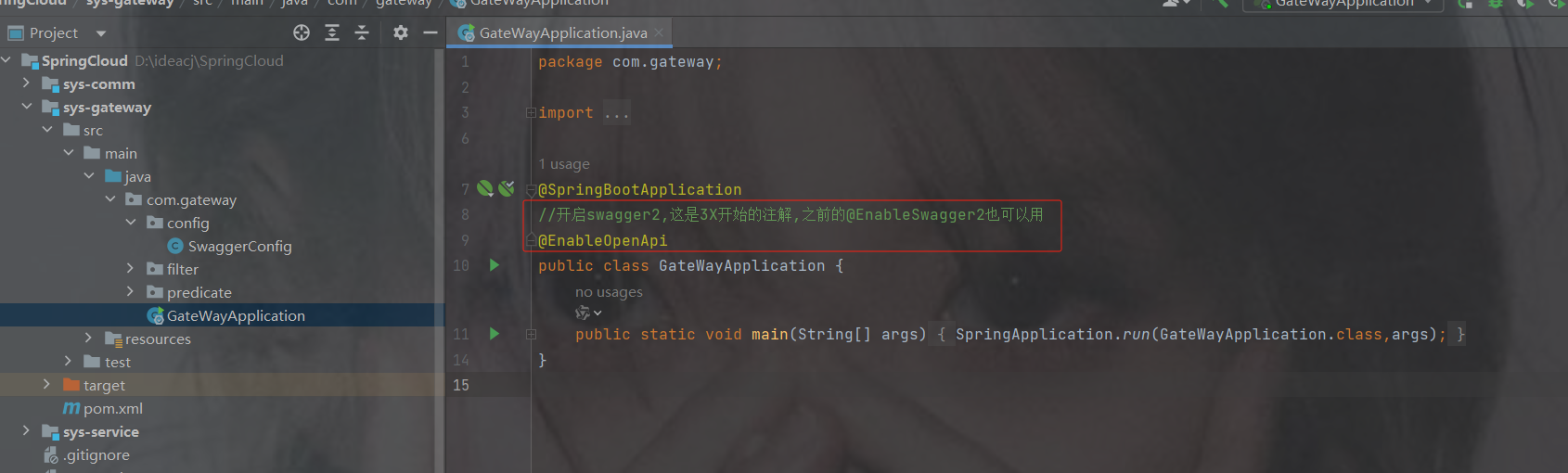

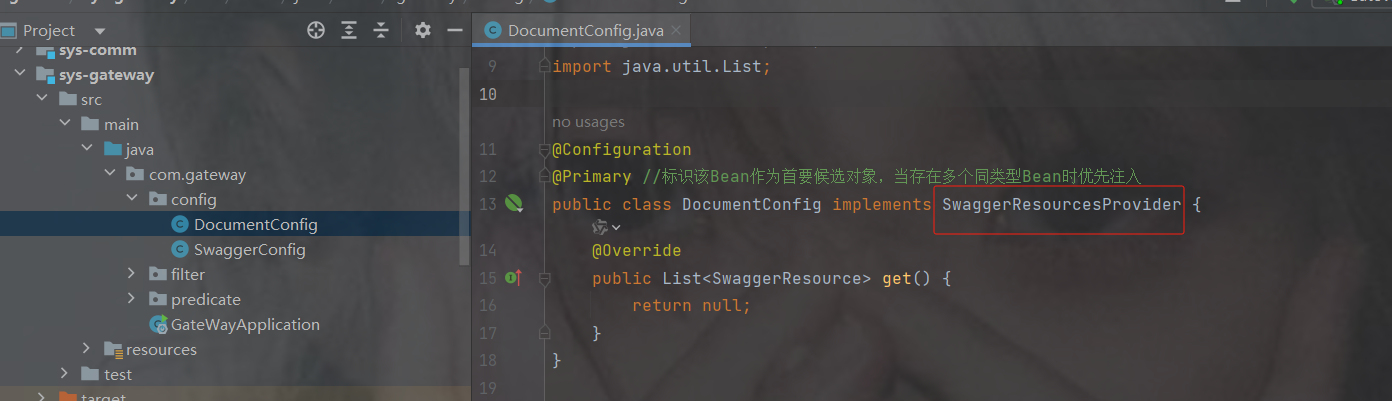

3. 创建配置类和启动类

这里用yml的配置展示

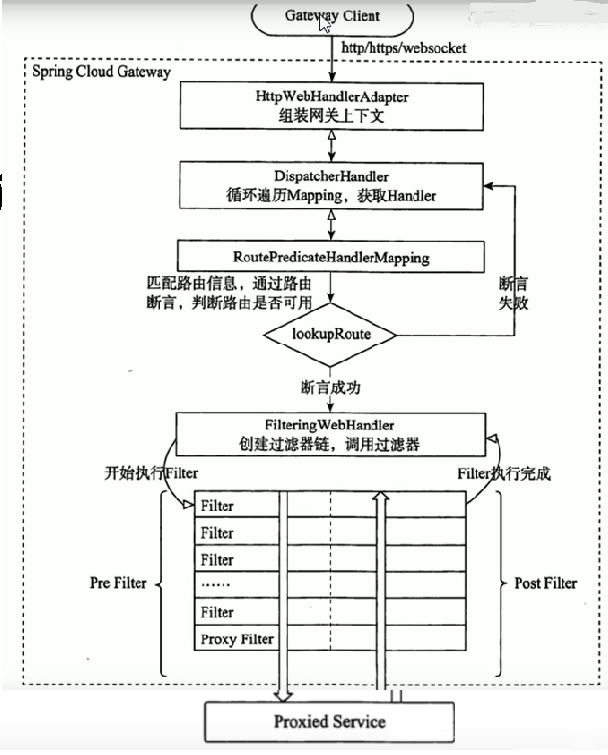

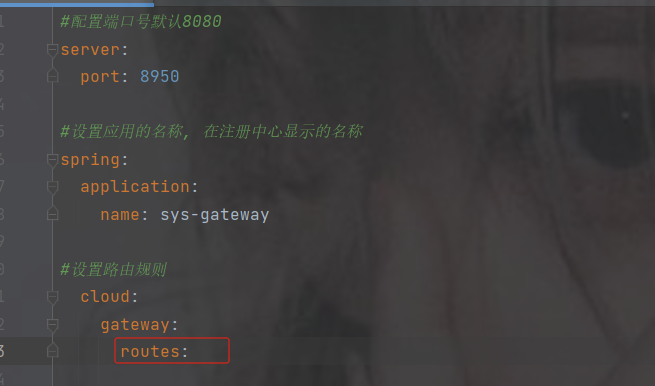

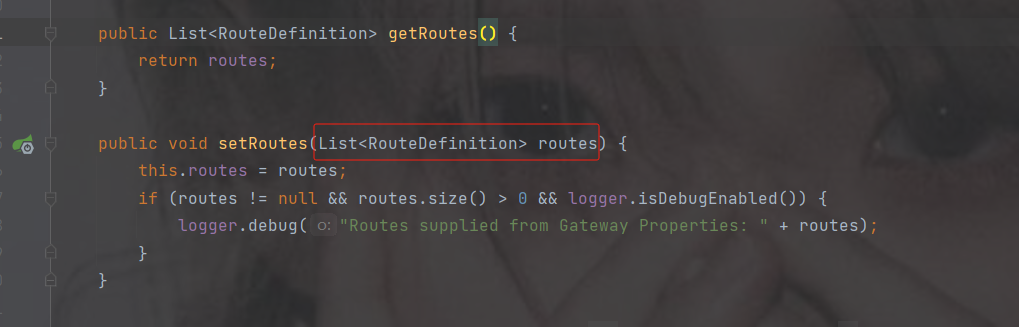

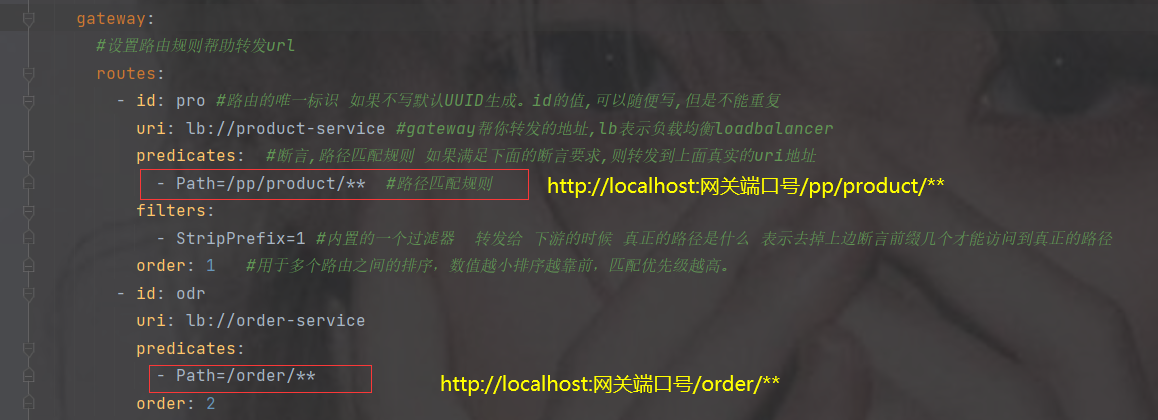

4.路由配置规则介绍

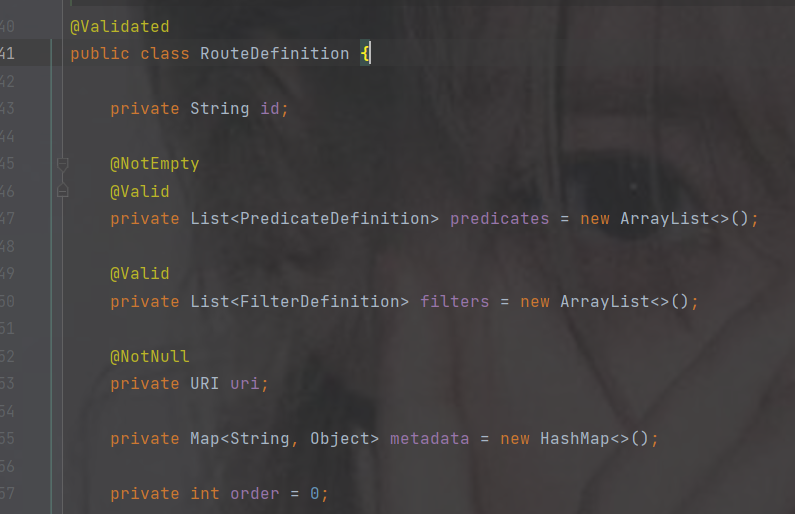

点击routes查看

传递的是list集合并且类型是RouteDefinition,点击RouteDefinition查看

这是集合中一个元素的属性,其中带@NotEmpty注解的表示不能为空必须配置

- 代表集合的一个元素

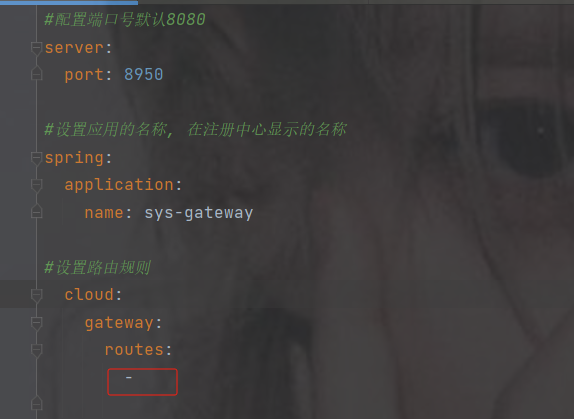

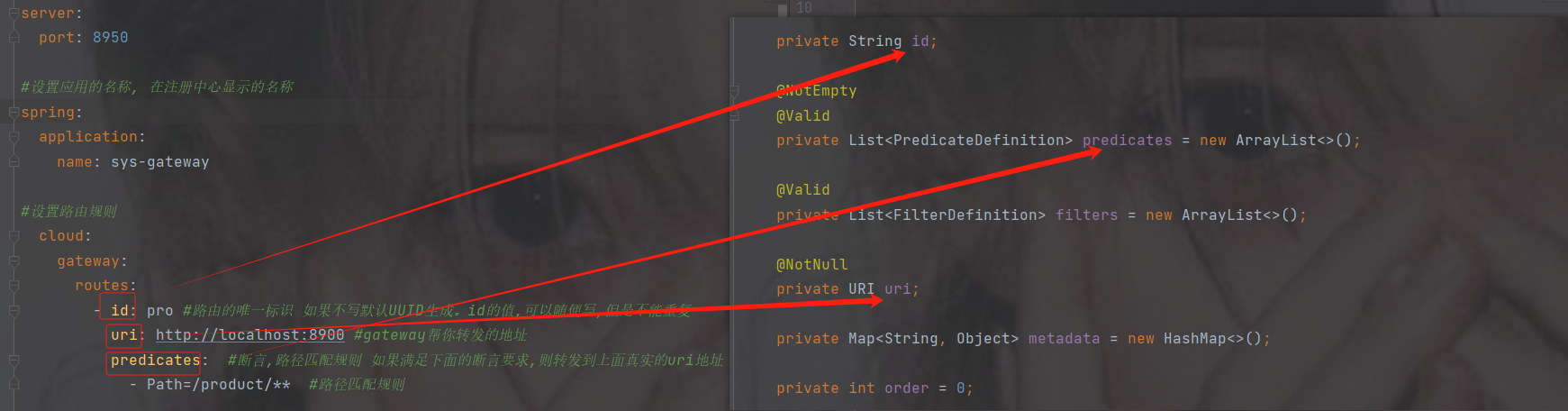

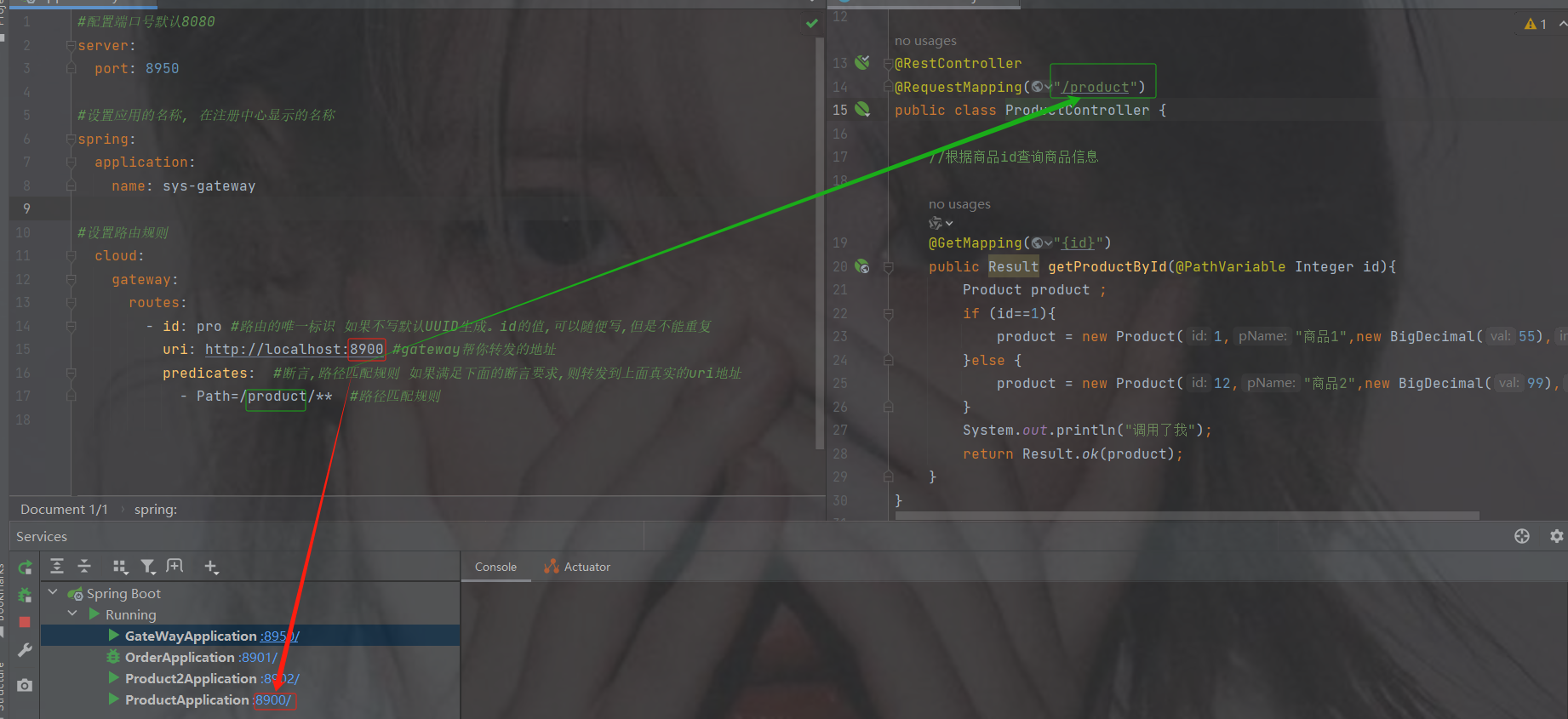

配置信息

配置信息

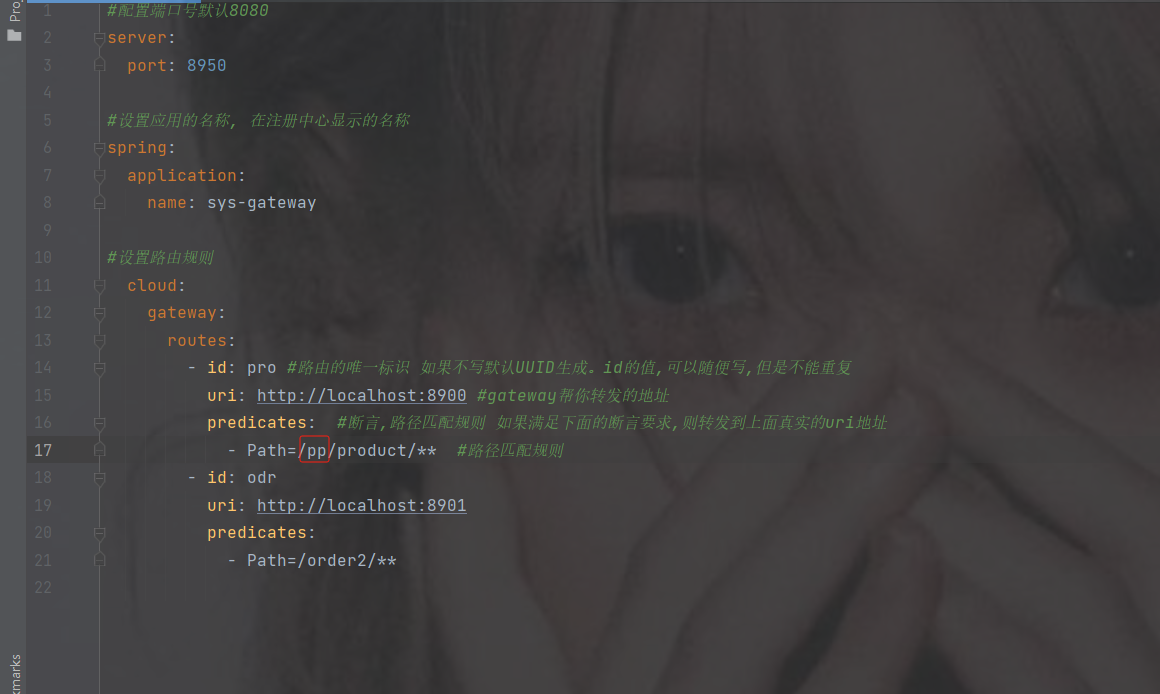

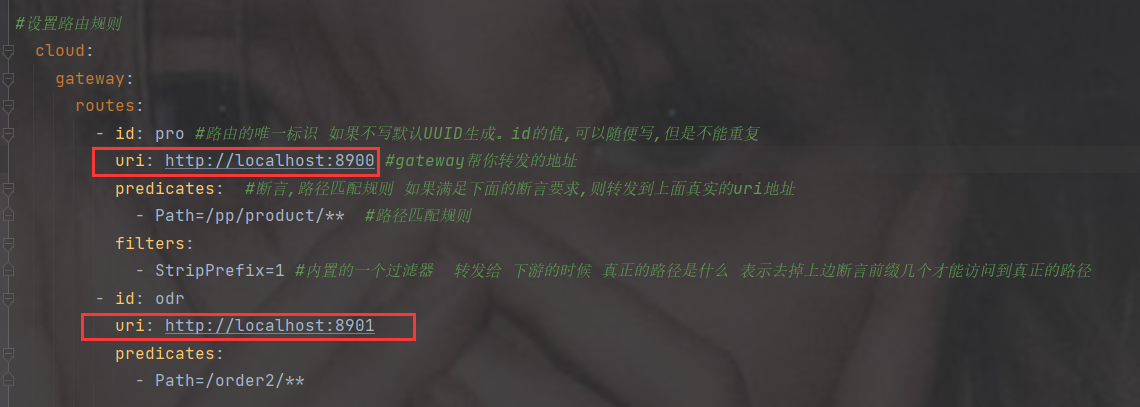

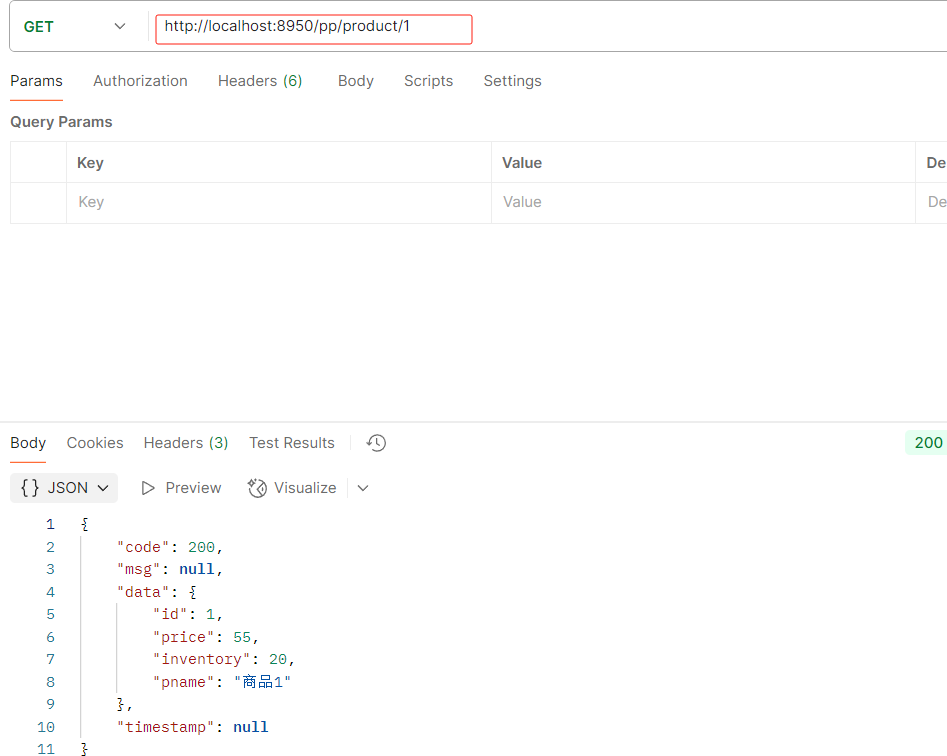

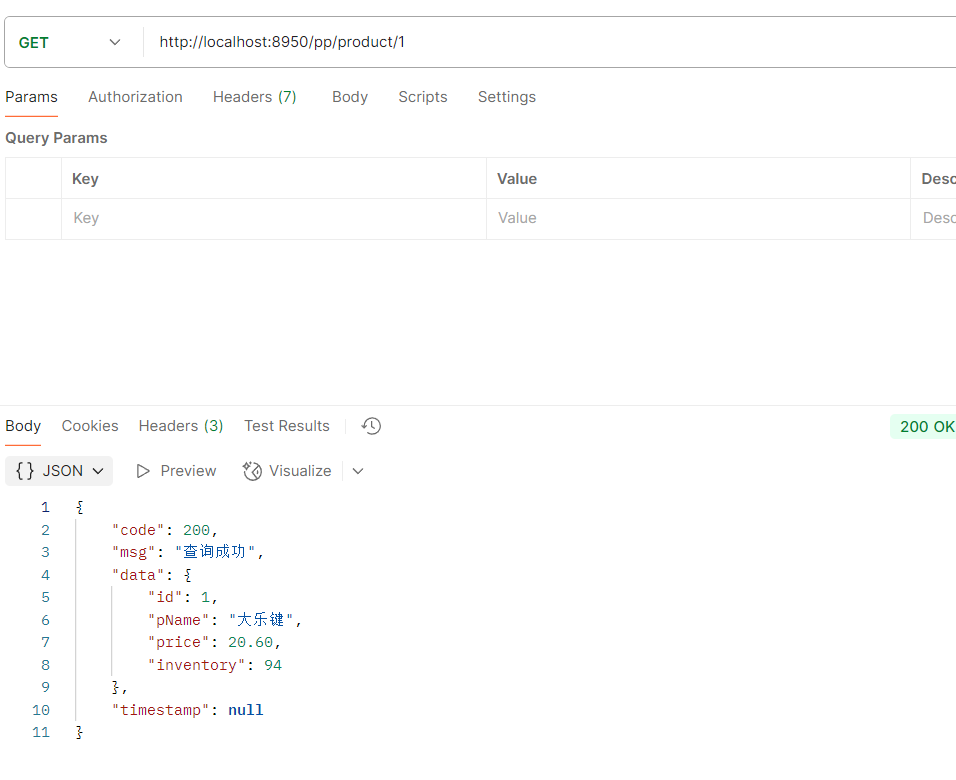

#配置端口号默认8080 server: port: 8950 #设置应用的名称, 在注册中心显示的名称 spring: application: name: sys-gateway #设置路由规则 cloud: gateway: routes: - id: pro #路由的唯一标识 如果不写默认UUID生成。id的值,可以随便写,但是不能重复 uri: http://localhost:8900 #gateway帮你转发的地址 predicates: #断言,路径匹配规则 如果满足下面的断言要求,则转发到上面真实的uri地址 - Path=/product/** #路径匹配规则

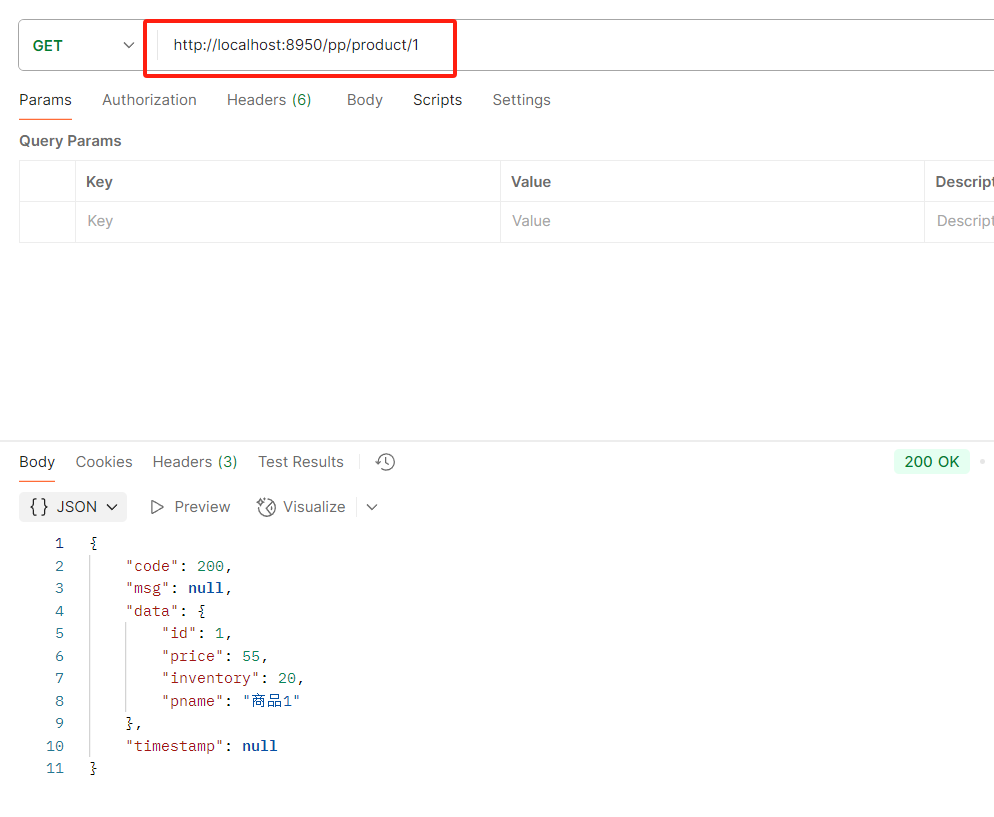

访问网关端口8950/product/1 --> 转发到 http://localhost:8900/product/1

要是多个服务就这么加就行了

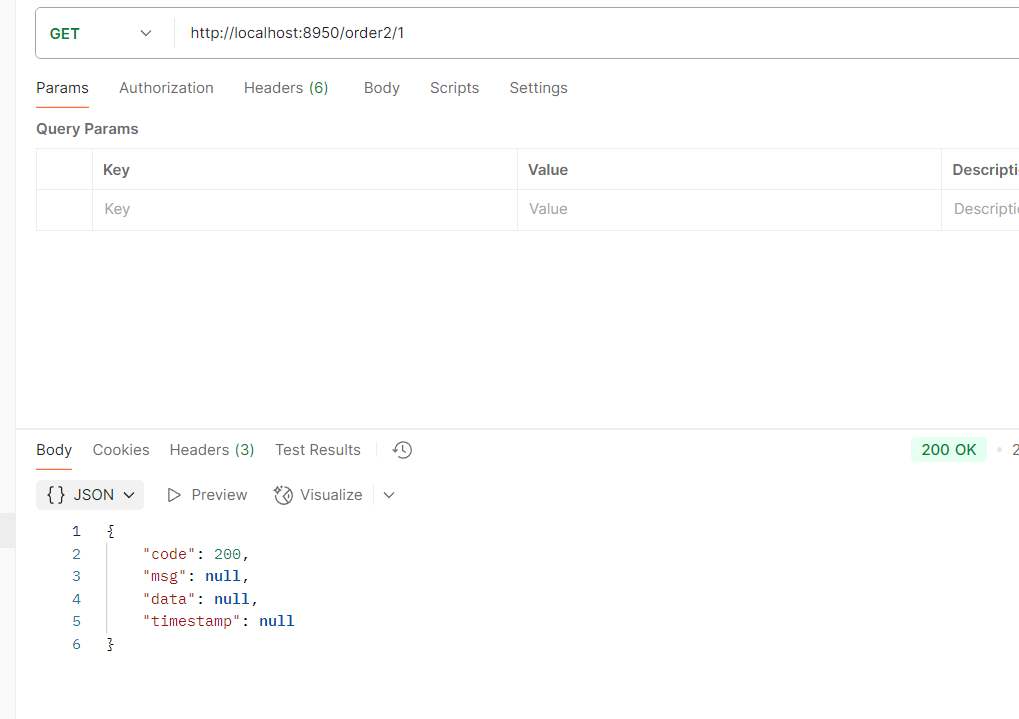

网关订单访问

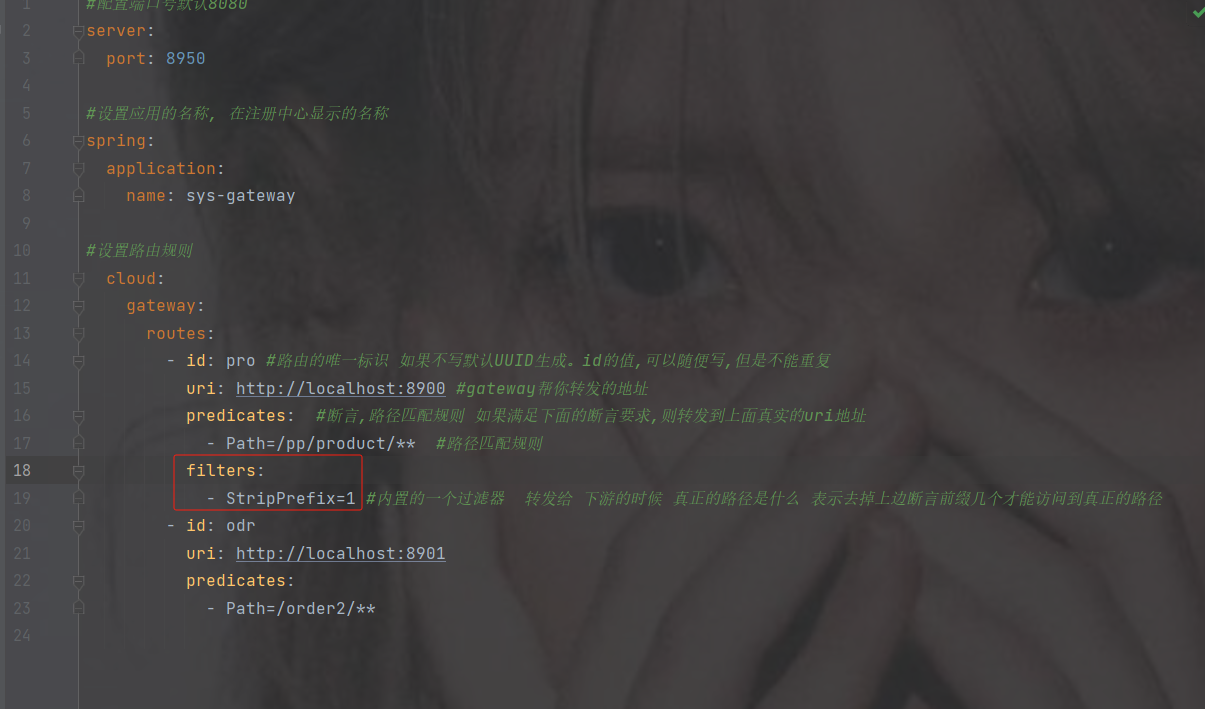

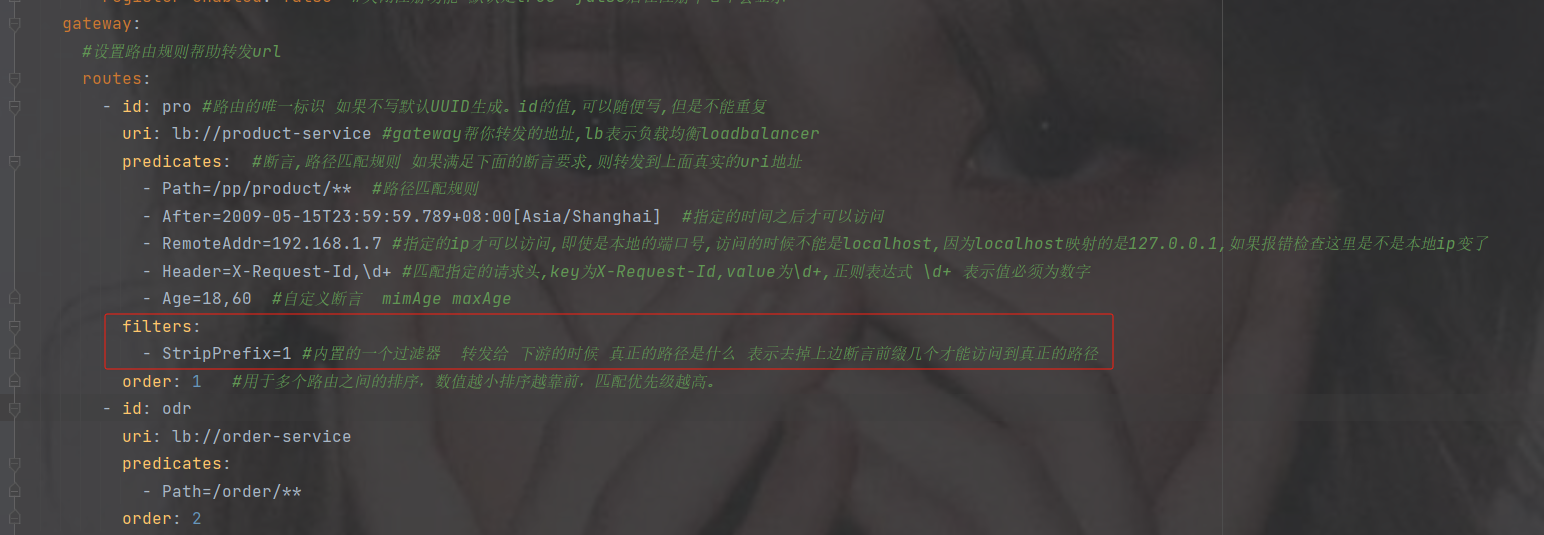

filters

如果路径前加了其他的路径那么就需要用到filters内置过滤器

StriPrefix = 1 表示截取1个前缀可以到达真实的路径,

= 表示去掉几个到达真实的路径

#配置端口号默认8080

server:

port: 8950

#设置应用的名称, 在注册中心显示的名称

spring:

application:

name: sys-gateway

#设置路由规则

cloud:

gateway:

routes:

- id: pro #路由的唯一标识 如果不写默认UUID生成。id的值,可以随便写,但是不能重复

uri: http://localhost:8900 #gateway帮你转发的地址

predicates: #断言,路径匹配规则 如果满足下面的断言要求,则转发到上面真实的uri地址

- Path=/pp/product/** #路径匹配规则

filters:

- StripPrefix=1 #内置的一个过滤器 转发给 下游的时候 真正的路径是什么 表示去掉上边断言前缀几个才能访问到真正的路径

- id: odr

uri: http://localhost:8901

predicates:

- Path=/order2/**注意路径还是要加上你上的路径比如下图路径pp

order

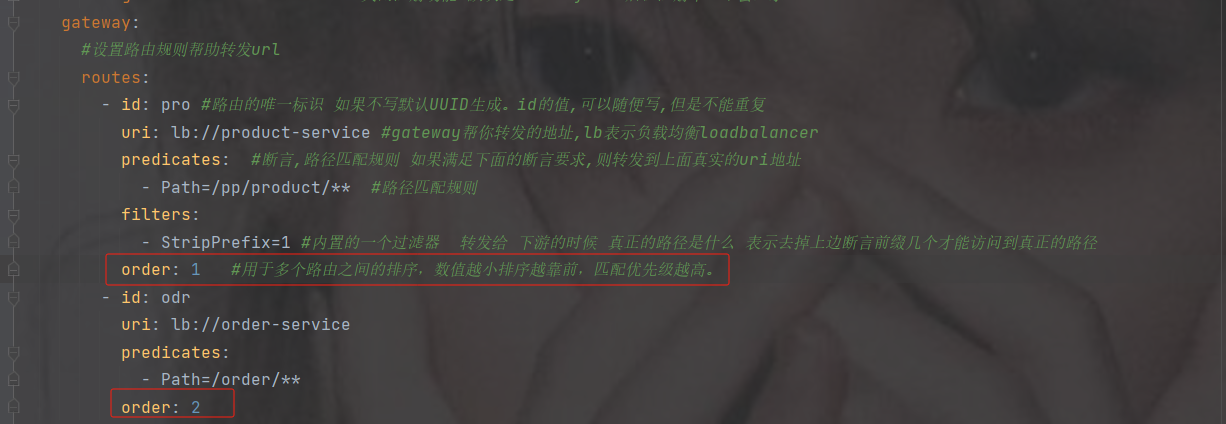

用于多个 Route 之间的排序,数值越小排序越靠前,匹配优先级越高,如果不写优先级则默认从上往下。

6.6 gateway完成负载均衡

1.为何gateway使用负载均衡

问题:

1.如果后期转发的服务器ip或端口号发生改变,则需要修改网关的配置

2.如果转发的服务是一个集群,他们的路径都一样只是端口号不一致,但是配置相同路径,会出错不知道转发给哪个端口号

----------------------------------------------------------------------------------------------------------

解决:

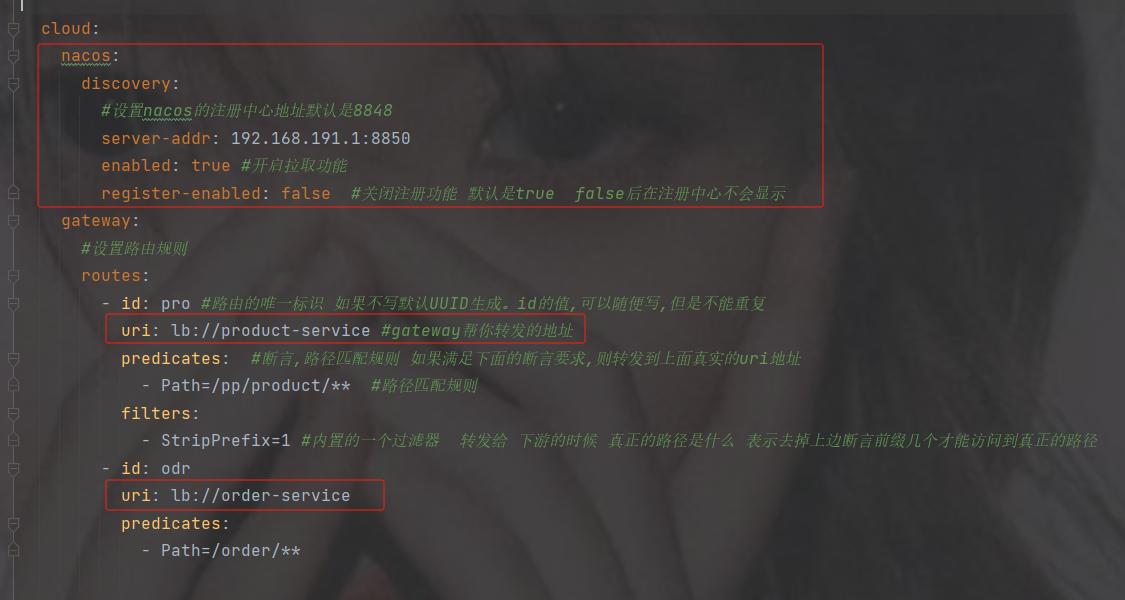

网关它也是一个独立的微服务,那么它也可以从注册中心按照服务名拉取相应的服务清单. ----- 而且它集成负载均衡的组件 --- 那么它也可以负载均衡的转发服务器

2.实现步骤

加注册中心以及负载均衡的依赖

com.alibaba.cloud spring-cloud-starter-alibaba-nacos-discovery org.springframework.cloud spring-cloud-starter-loadbalancer

修改配置

注意url, 用了负载均衡后 lb://跟的是服务的名称

#配置端口号默认8080

server:

port: 8950

#设置应用的名称, 在注册中心显示的名称

spring:

application:

name: sys-gateway

cloud:

nacos:

discovery:

#设置nacos的注册中心地址默认是8848

server-addr: 192.168.191.1:8850

enabled: true #开启拉取功能

register-enabled: false #关闭注册功能 默认是true false后在注册中心不会显示

gateway:

#设置路由规则

routes:

- id: pro #路由的唯一标识 如果不写默认UUID生成。id的值,可以随便写,但是不能重复

uri: lb://product-service #gateway帮你转发的地址

predicates: #断言,路径匹配规则 如果满足下面的断言要求,则转发到上面真实的uri地址

- Path=/pp/product/** #路径匹配规则

filters:

- StripPrefix=1 #内置的一个过滤器 转发给 下游的时候 真正的路径是什么 表示去掉上边断言前缀几个才能访问到真正的路径

- id: odr

uri: lb://order-service

predicates:

- Path=/order/**依然访问路径查看打印

轮询打印了

6.7 gateway核心架构以及断言规则(了解即可,如有使用到再来观看使用)

1. 基本概念

路由(Route) 是 gateway 中最基本的组件之一,表示一个具体的路由信息载体。主要定义了下面的几个信息:

id,路由标识符,区别于其他 Route。唯一 不写 默认的唯一的值

uri,路由指向的目的地 uri,即客户端请求最终被转发到的微服务。

order,用于多个 Route 之间的排序,数值越小排序越靠前,匹配优先级越高。

predicates,断言的作用是进行条件判断,只有断言都返回真,才会真正的执行路由。

fifilters,过滤器用于修改请求和响应信息。

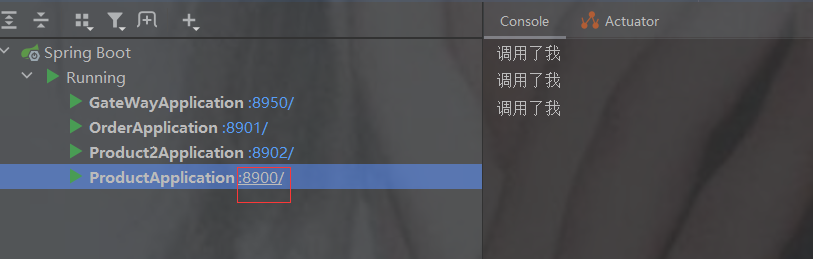

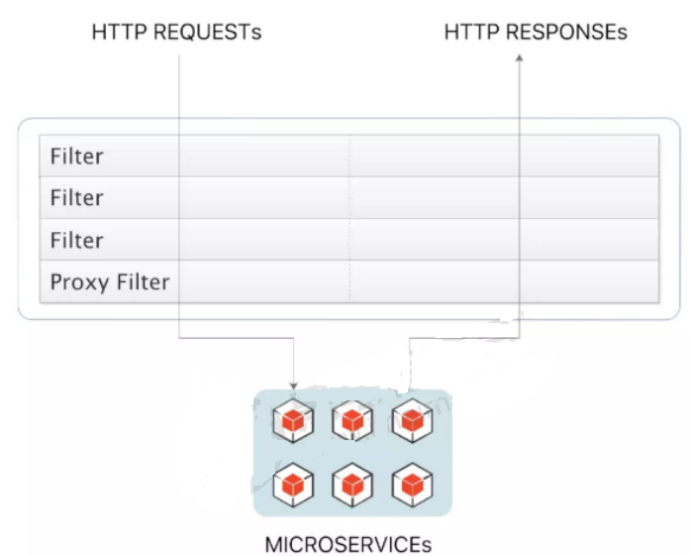

2. 执行流程

执行流程大体如下:

1. Gateway Client向Gateway Server发送请求

2. 请求首先会被HttpWebHandlerAdapter进行提取组装成网关上下文

3. 然后网关的上下文会传递到DispatcherHandler,它负责将请求分发给 RoutePredicateHandlerMapping

4. RoutePredicateHandlerMapping负责路由查找,并根据路由断言判断路由是否可用

5. 如果过断言成功,由FilteringWebHandler创建过滤器链并调用

6. 请求会一次经过PreFilter--微服务--PostFilter的方法,最终返回响应

3. 断言

Predicates(断言, 谓词) 用于进行条件判断,只有断言都返回真,才会真正的执行路由。

断言就是说: 在 什么条件下 才能进行路由转发

4. 内置路由断言工厂

SpringCloud Gateway包括许多内置的断言工厂,所有这些断言都与HTTP请求的不同属性匹配体如下:

基于Path请求路径的断言工厂

PathRoutePredicateFactory:接收一个参数,判断请求的URI部分是否满足路径规则。

- Path=/foo/{segment}基于Query请求参数的断言工厂

上面介绍过不多介绍path断言

QueryRoutePredicateFactory :接收两个参数,请求param和正则表达式, 判断请求参数是否具有给定名称且值与正则表达式匹配。

- Query=baz, ba.

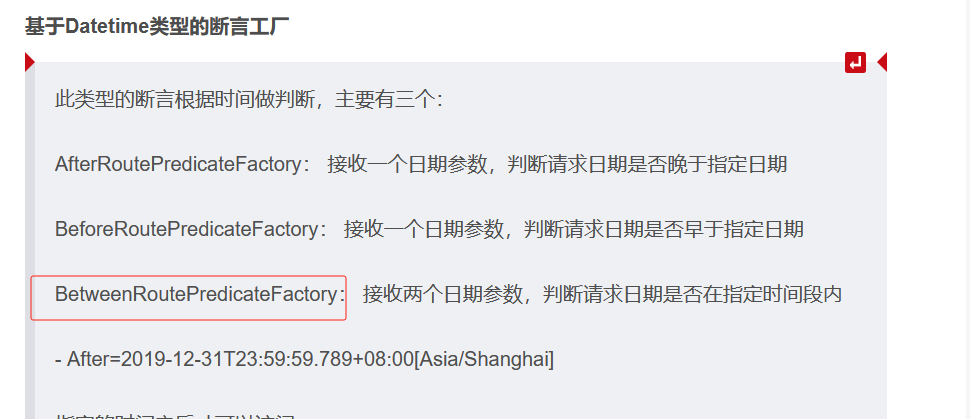

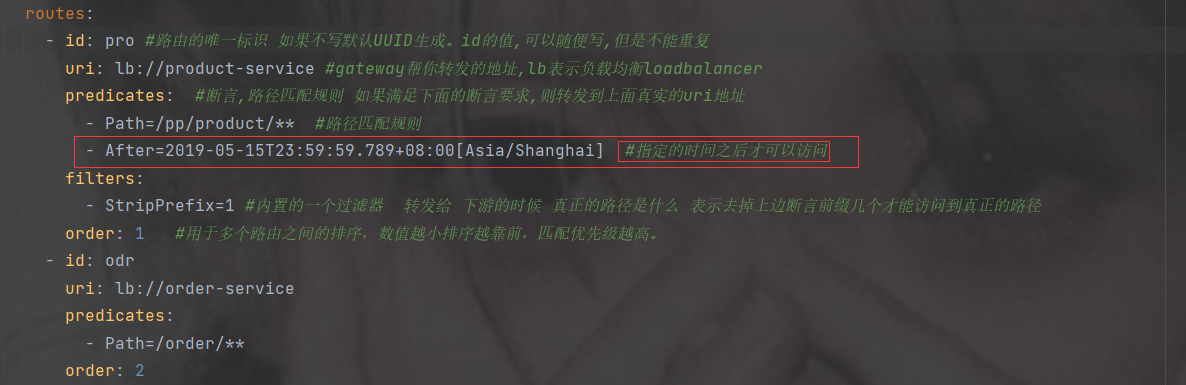

基于Datetime类型的断言工厂

此类型的断言根据时间做判断,主要有三个:

AfterRoutePredicateFactory: 接收一个日期参数,判断请求日期是否晚于指定日期

BeforeRoutePredicateFactory: 接收一个日期参数,判断请求日期是否早于指定日期

BetweenRoutePredicateFactory: 接收两个日期参数,判断请求日期是否在指定时间段内

- After=2019-12-31T23:59:59.789+08:00[Asia/Shanghai]

指定的时间之后才可以访问

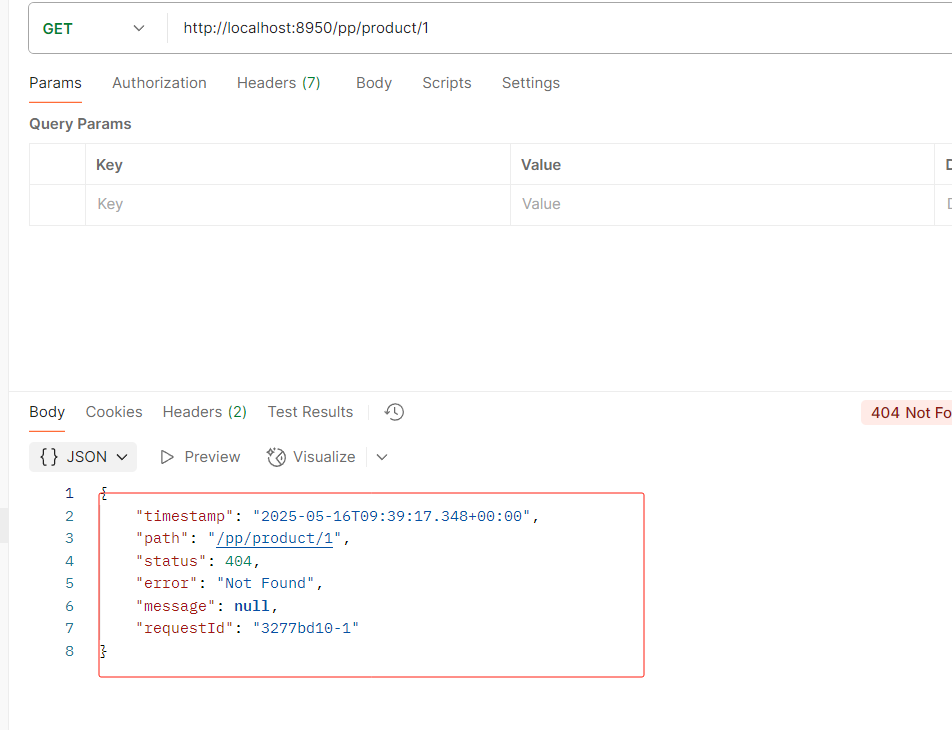

访问结果

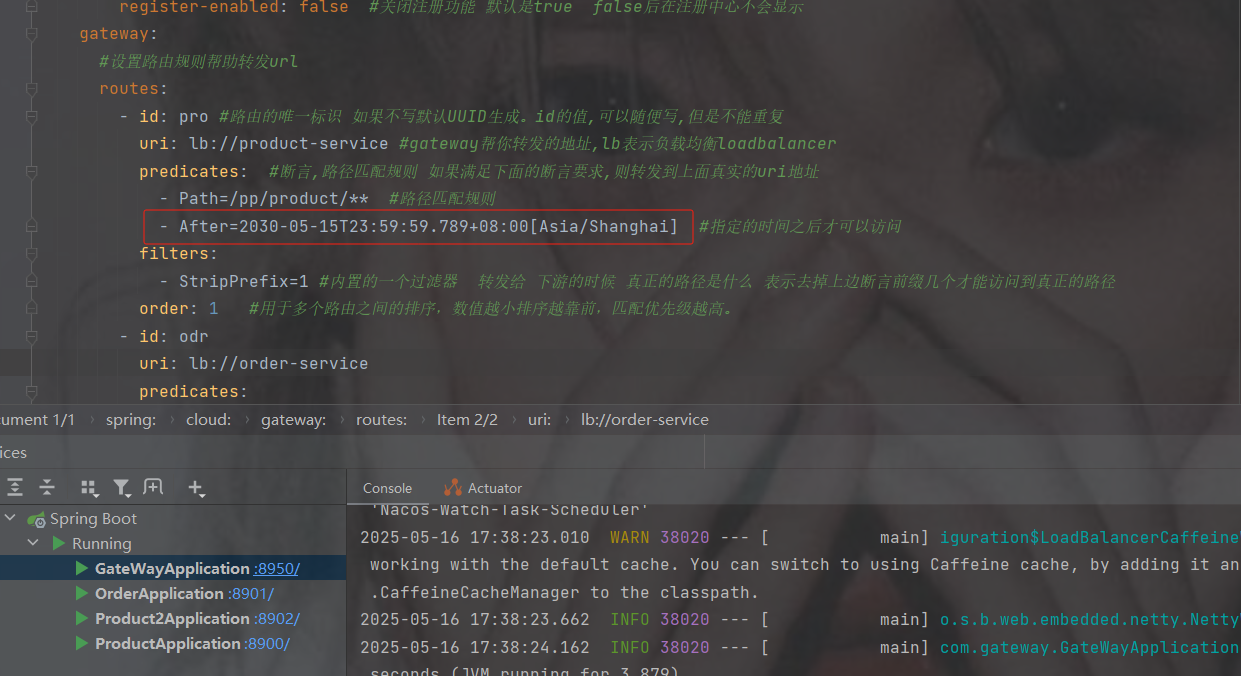

如果修改还没到的时间之后

就会访问不到

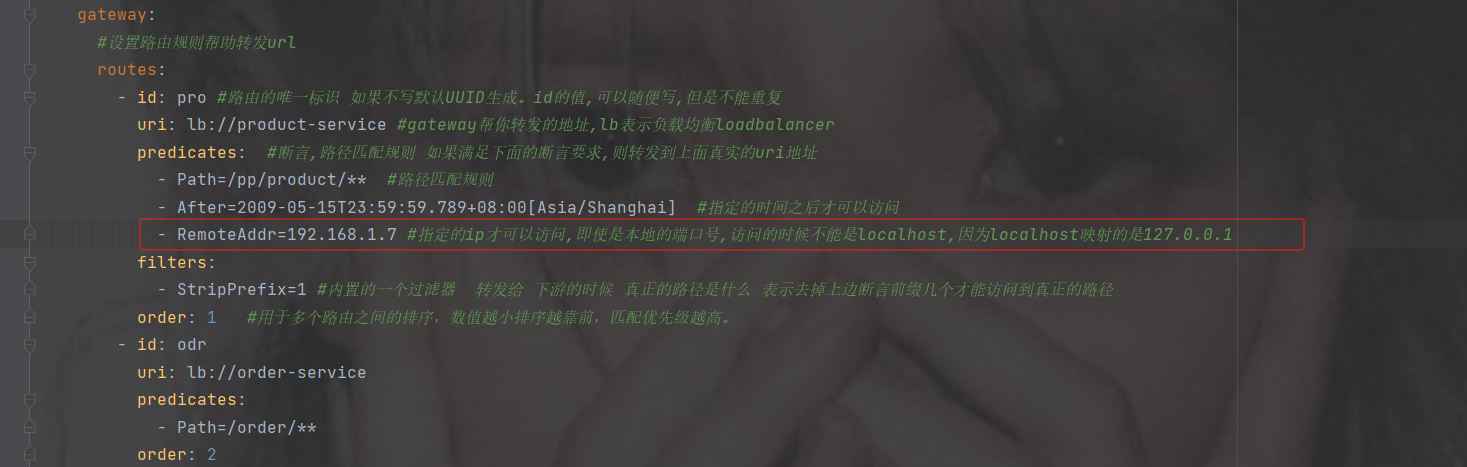

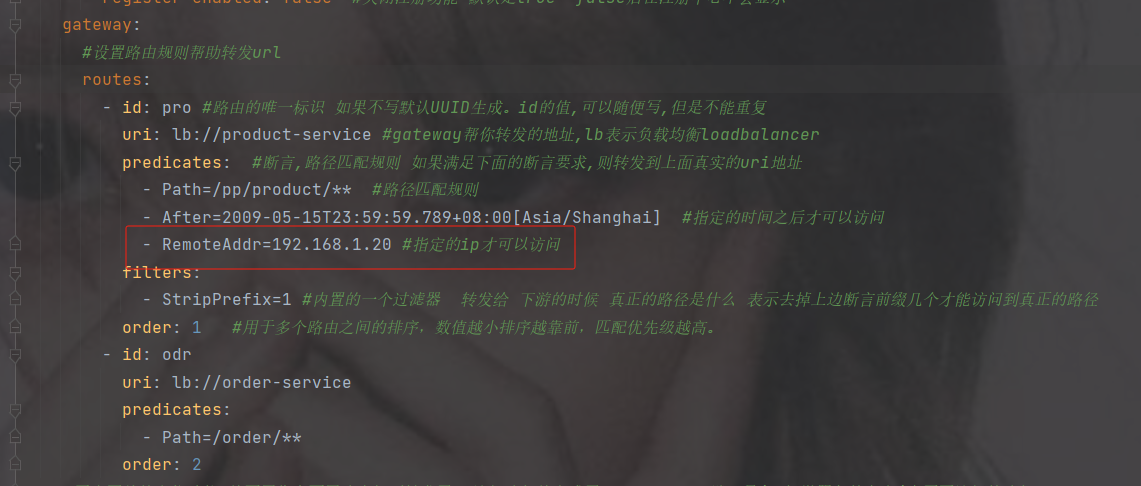

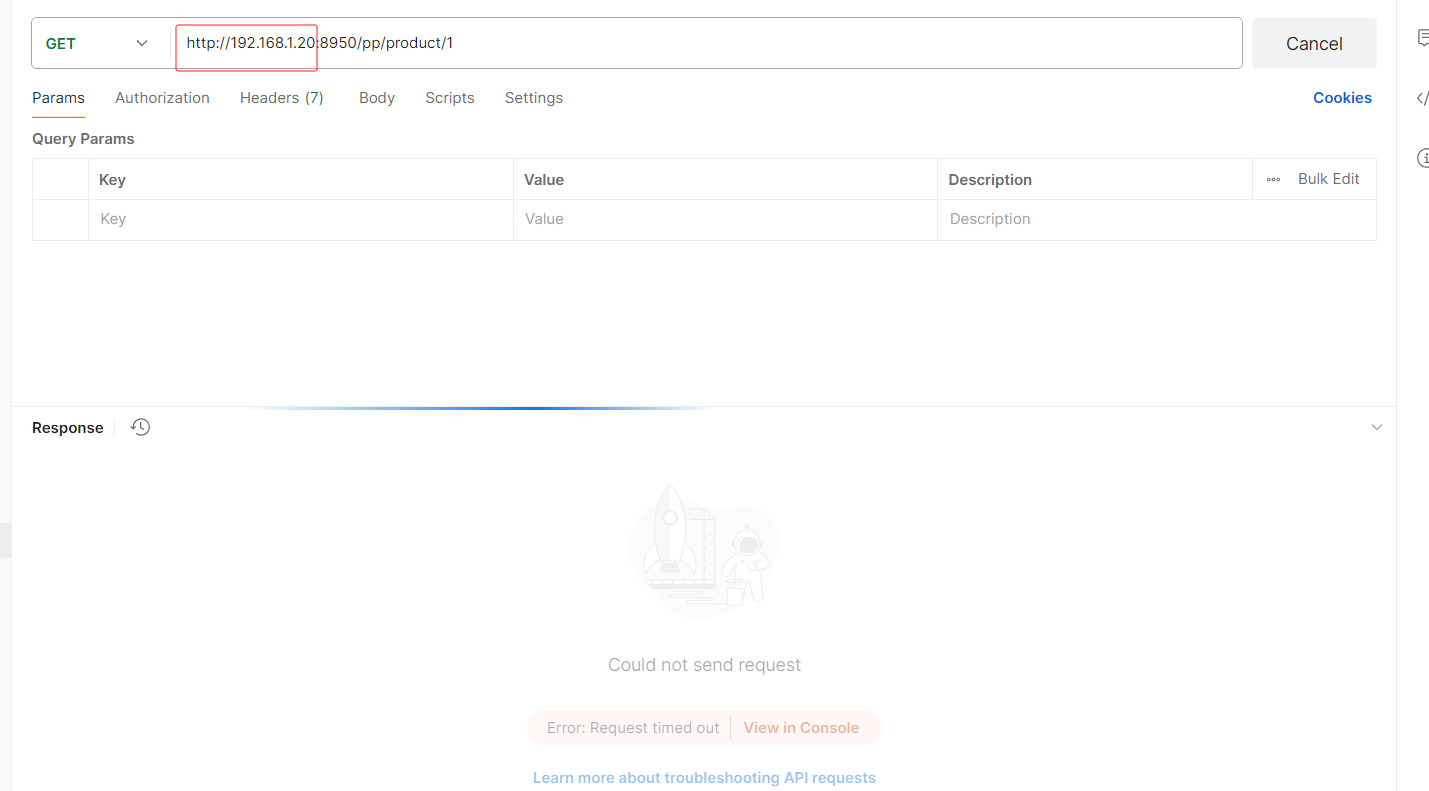

基于远程地址的断言工厂 RemoteAddrRoutePredicateFactory:

接收一个IP地址段,判断请求主机地址是否在地址段中

- RemoteAddr=xxx.xxx.xxx.xxx

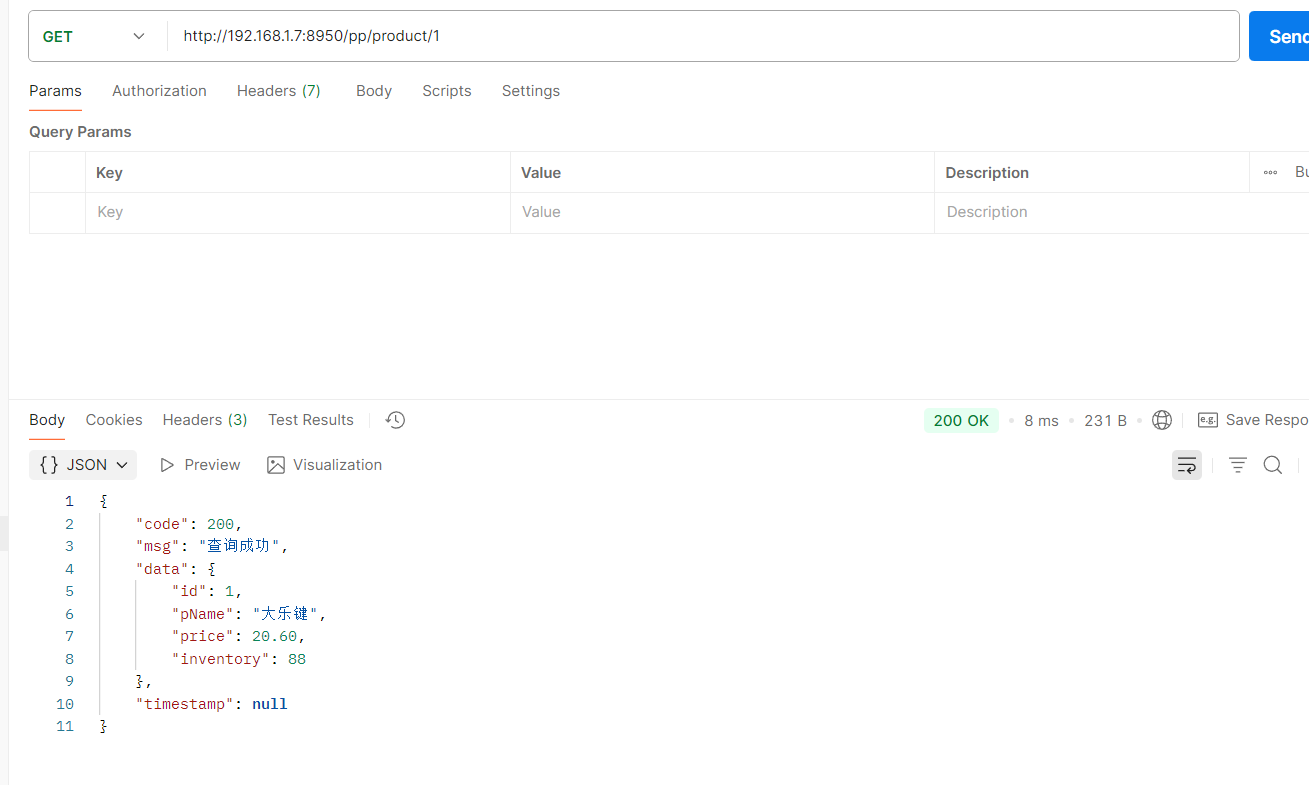

指定远程的ip为192.168.1.7才可以访问(这是我本地的ip)

注意不能用localhost,localhost会自动映射成127.0.0.1

如果修改了ip

即使你请求改为对应的ip地址也没用,因为你的ip不是,必须是192.168.1.20的ip才可以访问此接口

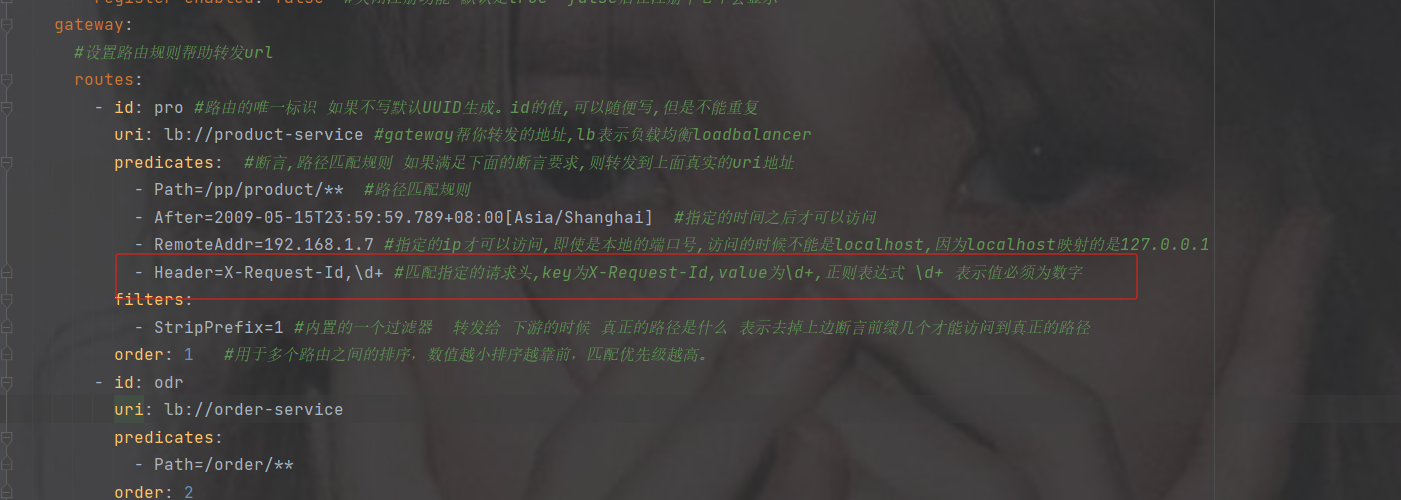

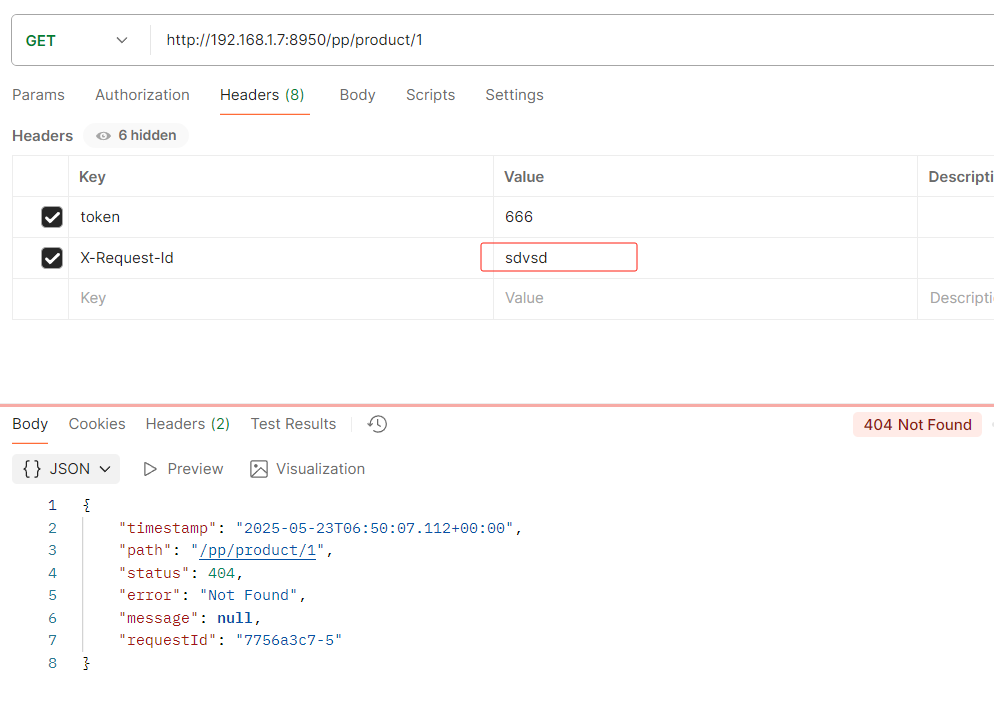

基于Header的断言工厂

HeaderRoutePredicateFactory:接收两个参数,标题名称和正则表达式。 判断请求Header是否具有给定名称且值与正则表达式匹配。 key,value

- Header=X-Request-Id, \d+

key为X-Request-Id,value为\d+,正则表达式 \d+ 表示值必须为数字,value也可指定固定自定义的值

不是数字就会不让访问

修改为数字才可以访问

基于Cookie的断言工厂

CookieRoutePredicateFactory:接收两个参数,cookie 名字和一个正则表达式。 判断请求

cookie是否具有给定名称且值与正则表达式匹配。

- Cookie=chocolate, ch.

基于Host的断言工厂

HostRoutePredicateFactory:接收一个参数,主机名模式。判断请求的Host是否满足匹配规则。

- Host=**.testhost.org

基于Method请求方法的断言工厂

MethodRoutePredicateFactory:接收一个参数,判断请求类型是否跟指定的类型匹配。

- Method=GET

基于路由权重的断言工厂

WeightRoutePredicateFactory:接收一个[组名,权重], 然后对于同一个组内的路由按照权重转发

routes:

-id: weight_route1

uri: host1

predicates:

-Path=/product/**

-Weight=group3, 1

-id: weight_route2

uri: host2

predicates:

-Path=/product/**

-Weight= group3, 95. 自定义路由断言工厂

我们来设定一个场景: 假设我们的应用仅仅让age在(min,max)之间的人来访问。

18-40

第1步:在配置文件中,添加一个Age的断言配置

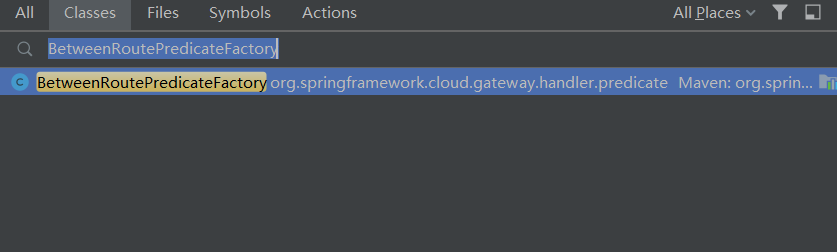

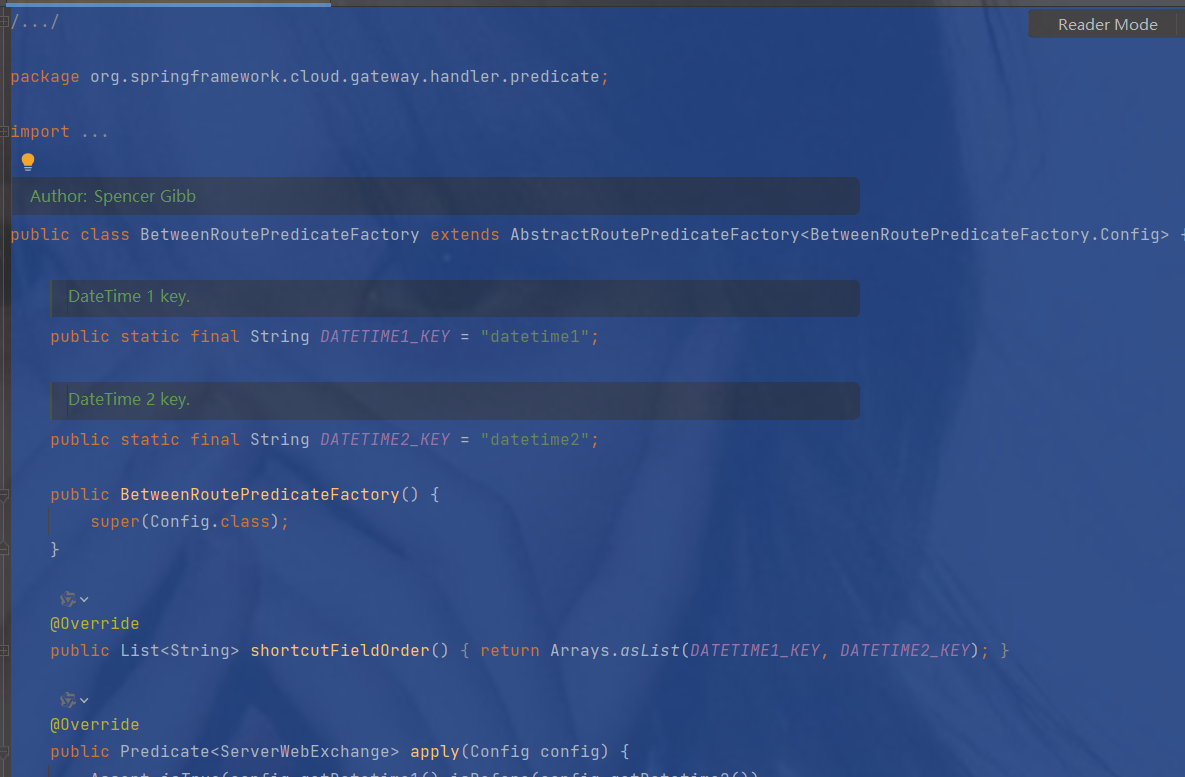

2.参考BetweenRoutePredicateFactory

创建一个包,并且先创建个类,一会儿修改

3.搜索复制粘贴修改

idea中Ctrl键+N搜索BetweenRoutePredicateFactory

把BetweenRoutePredicateFactory复制到刚刚创建的A类中

复制过来只做了简单修改,改造之前

package com.gateway.predicate;/*

* Copyright 2013-2020 the original author or authors.

*

* Licensed under the Apache License, Version 2.0 (the "License");

* you may not use this file except in compliance with the License.

* You may obtain a copy of the License at

*

* https://www.apache.org/licenses/LICENSE-2.0

*

* Unless required by applicable law or agreed to in writing, software

* distributed under the License is distributed on an "AS IS" BASIS,

* WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

* See the License for the specific language governing permissions and

* limitations under the License.

*/

import java.time.ZonedDateTime;

import java.util.Arrays;

import java.util.List;

import java.util.function.Predicate;

import javax.validation.constraints.NotNull;

import org.springframework.cloud.gateway.handler.predicate.AbstractRoutePredicateFactory;

import org.springframework.cloud.gateway.handler.predicate.GatewayPredicate;

import org.springframework.util.Assert;

import org.springframework.validation.annotation.Validated;

import org.springframework.web.server.ServerWebExchange;

/**

* @author Spencer Gibb

*/

//可以自定义断言,但是名字必须以 "xxx" RoutePredicateFactory结尾

public class AgeRoutePredicateFactory extends AbstractRoutePredicateFactory {

/**

* DateTime 1 key.

*/

public static final String DATETIME1_KEY = "datetime1";

/**

* DateTime 2 key.

*/

public static final String DATETIME2_KEY = "datetime2";

public AgeRoutePredicateFactory() {

super(Config.class);

}

@Override

public List shortcutFieldOrder() {

return Arrays.asList(DATETIME1_KEY, DATETIME2_KEY);

}

@Override

public Predicate apply(Config config) {

Assert.isTrue(config.getDatetime1().isBefore(config.getDatetime2()),

config.getDatetime1() + " must be before " + config.getDatetime2());

return new GatewayPredicate() {

@Override

public boolean test(ServerWebExchange serverWebExchange) {

final ZonedDateTime now = ZonedDateTime.now();

return now.isAfter(config.getDatetime1()) && now.isBefore(config.getDatetime2());

}

@Override

public String toString() {

return String.format("Between: %s and %s", config.getDatetime1(), config.getDatetime2());

}

};

}

@Validated

public static class Config {

@NotNull

private ZonedDateTime datetime1;

@NotNull

private ZonedDateTime datetime2;

public ZonedDateTime getDatetime1() {

return datetime1;

}

public Config setDatetime1(ZonedDateTime datetime1) {

this.datetime1 = datetime1;

return this;

}

public ZonedDateTime getDatetime2() {

return datetime2;

}

public Config setDatetime2(ZonedDateTime datetime2) {

this.datetime2 = datetime2;

return this;

}

}

} 修改后

package com.gateway.predicate;/*

* Copyright 2013-2020 the original author or authors.

*

* Licensed under the Apache License, Version 2.0 (the "License");

* you may not use this file except in compliance with the License.

* You may obtain a copy of the License at

*

* https://www.apache.org/licenses/LICENSE-2.0

*

* Unless required by applicable law or agreed to in writing, software

* distributed under the License is distributed on an "AS IS" BASIS,

* WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

* See the License for the specific language governing permissions and

* limitations under the License.

*/

import java.time.ZonedDateTime;

import java.util.Arrays;

import java.util.List;

import java.util.function.Predicate;

import javax.validation.constraints.NotNull;

import org.springframework.cloud.gateway.handler.predicate.AbstractRoutePredicateFactory;

import org.springframework.cloud.gateway.handler.predicate.GatewayPredicate;

import org.springframework.stereotype.Component;

import org.springframework.util.Assert;

import org.springframework.validation.annotation.Validated;

import org.springframework.web.server.ServerWebExchange;

/**

* @author Spencer Gibb

*/

//4.注意自定义断言要交给Spring管理

@Component

//可以自定义断言,但是名字必须以 "xxx" RoutePredicateFactory结尾

public class AgeRoutePredicateFactory extends AbstractRoutePredicateFactory {

/**

* Age 1 key.

*/

public static final String MIN_AGE_KEY = "minAge";

/**

* Age 2 key.

*/

public static final String MAX_AGE_KEY = "maxAge";

public AgeRoutePredicateFactory() {

super(Config.class);

}

//2.修改配置为自定义年龄

@Override

public List shortcutFieldOrder() {

//读取配置文件中的内容

return Arrays.asList(MIN_AGE_KEY, MAX_AGE_KEY);

}

@Override

public Predicate apply(Config config) {

return new GatewayPredicate() {

@Override

public boolean test(ServerWebExchange serverWebExchange) {

//3.获取输入的年龄age

String age = serverWebExchange.getRequest().getQueryParams().getFirst("age");

int i = Integer.parseInt(age);

return i >= config.getMinAge() && i <= config.getMaxAge();

}

@Override

public String toString() {

return String.format("Between: minAge and maxAge", config.getMinAge(), config.getMaxAge());

}

};

}

//1.先修改配置为自定义年龄

@Validated

public static class Config {

@NotNull

private Integer minAge;

@NotNull

private Integer maxAge;

public Config() {

}

public Integer getMinAge() {

return minAge;

}

public void setMinAge(Integer minAge) {

this.minAge = minAge;

}

public Integer getMaxAge() {

return maxAge;

}

public void setMaxAge(Integer maxAge) {

this.maxAge = maxAge;

}

}

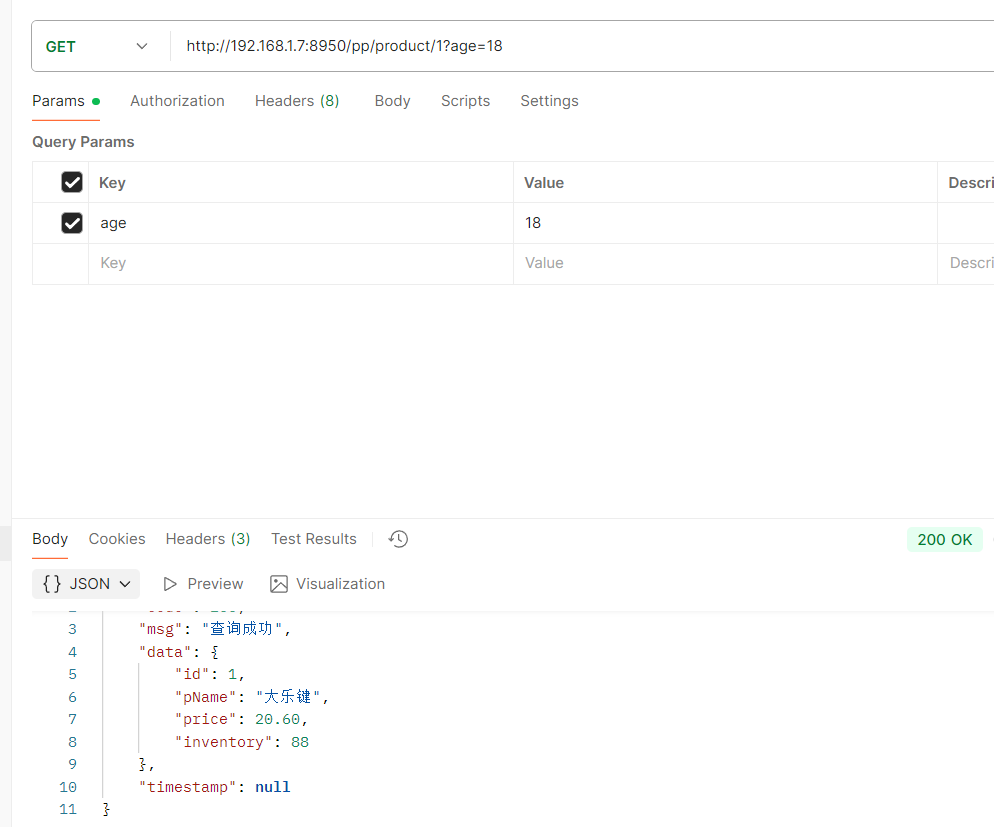

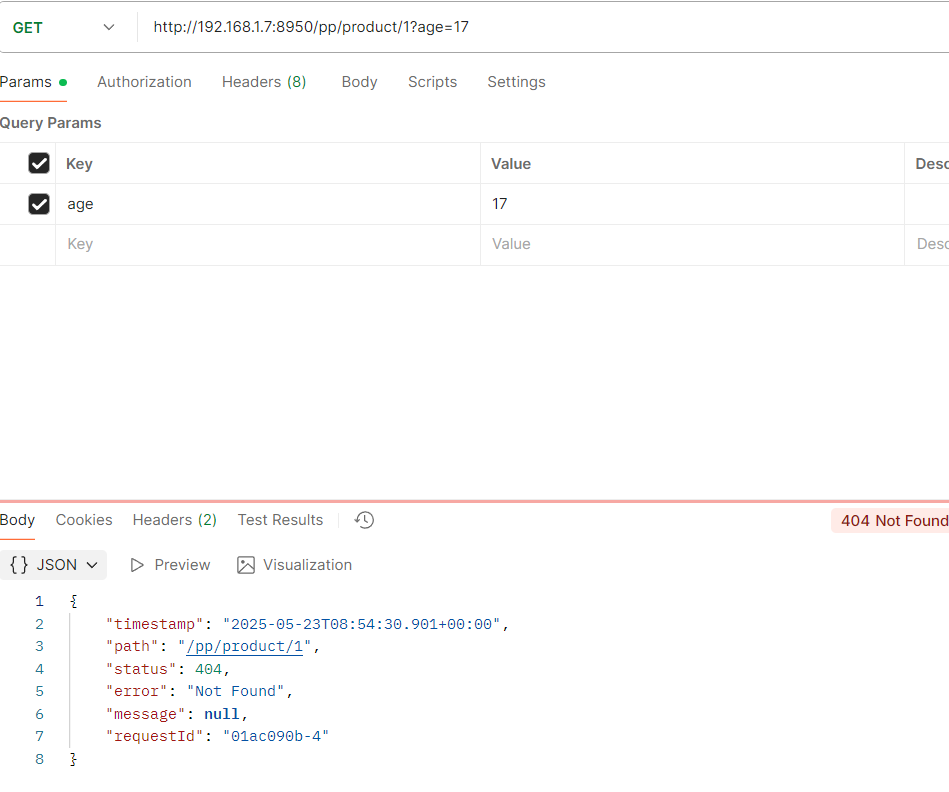

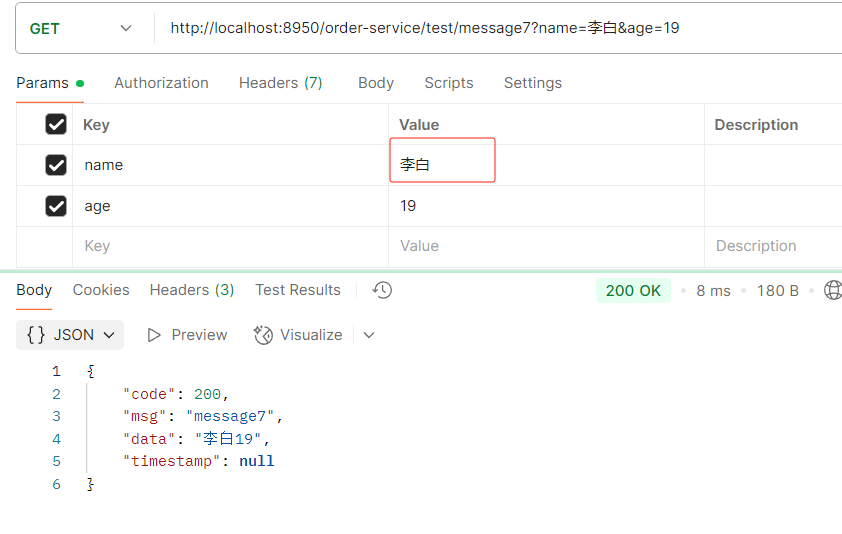

} 4.接口访问

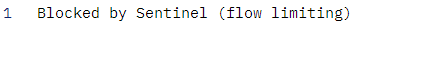

携带正常age并且年龄是18可以访问到

如果年龄不对就访问不到

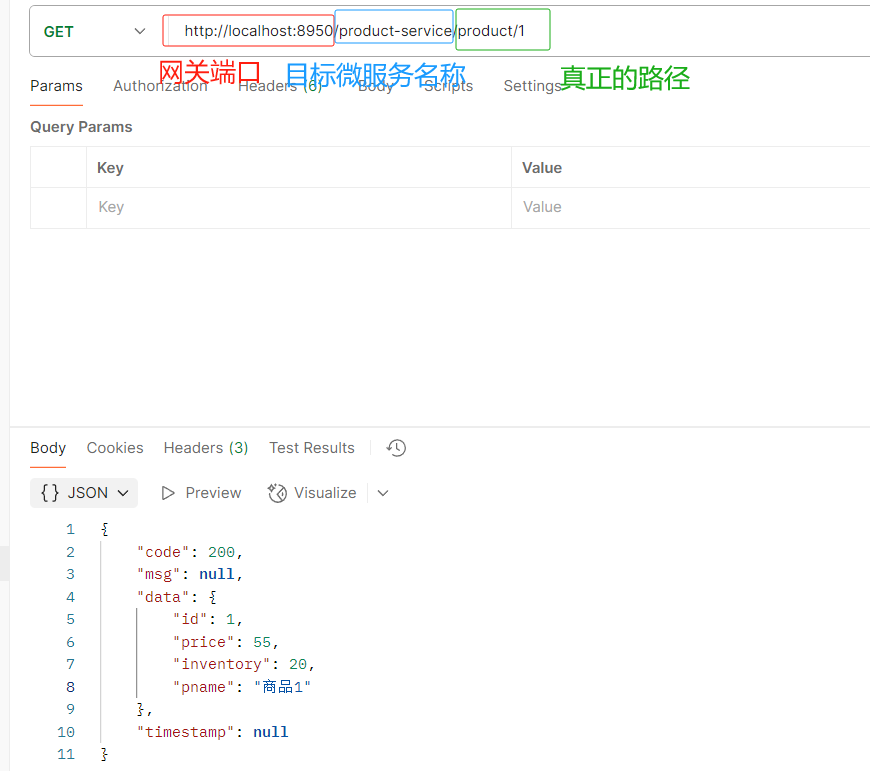

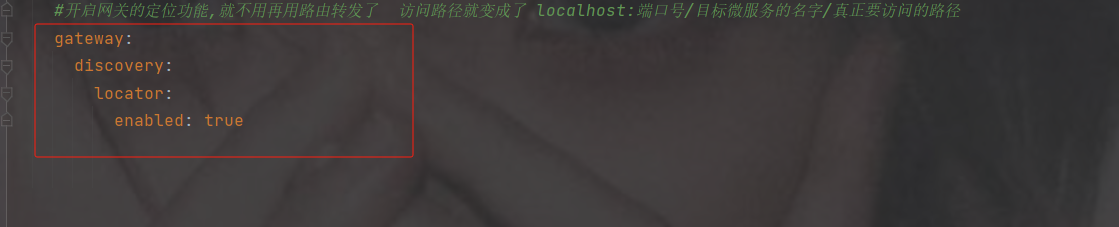

6.8 服务发现定位器

发现的问题:

1.如果增加一个新的微服务,那么需要在gateway配置新服务的路由规则,但是一旦多了就很麻烦

--------------------------------------------------------------------------------------------------------------------------

解决:

使用自动定位功能 , 需要配置开启,访问资源时要添加微服务的名称

该配置启用Spring Cloud Gateway的服务发现定位器,自动将服务发现中的服务注册为路由,允许通过服务名称访问服务实例。

#配置端口号默认8080

server:

port: 8950

#设置应用的名称, 在注册中心显示的名称

spring:

application:

name: sys-gateway

cloud:

nacos:

discovery:

#设置nacos的注册中心地址默认是8848

server-addr: 192.168.191.1:8850

enabled: true #开启拉取功能

register-enabled: false #关闭注册功能 默认是true false后在注册中心不会显示

#开启网关的定位功能 访问路径就变成了 localhost:端口号/目标微服务的名字/真正要访问的路径

gateway:

discovery:

locator:

enabled: true访问路径

http://localhost:8950/product-service/product/1

6.9 过滤器

- 作用: 过滤器就是在请求的传递过程中,对请求和响应做一些操作

- 生命周期: Pre Post

- 分类: 局部过滤器(作用在某一个路由上) 全局过滤器(作用全部路由上)

在Gateway中, Filter的生命周期只有两个:“pre” 和 “post”。

- PRE: 这种过滤器在请求被路由之前调用。我们可利用这种过滤器实现身份验证、在集群中选择请求的微服务、记录调试信息等。

- POST:这种过滤器在路由到微服务以后执行。这种过滤器可用来为响应添加标准的HTTP Header、收集统计信息和指标、将响应从微服务发送给客户端等。

Gateway 的Filter从作用范围可分为两种: GatewayFilter与GlobalFilter。

- GatewayFilter:应用到单个路由或者一个分组的路由上。

- GlobalFilter:应用到所有的路由上。

1. 内置局部过滤器

像上面之前讲的用这个filters截取前缀就是它(局部过滤器)

在SpringCloud Gateway中内置了很多不同类型的网关路由过滤器。

Spring Cloud Gateway 内置的过滤器工厂 - 小菜鸟攻城狮 - 博客园

过滤器工厂 | 作用 | 参数 |

AddRequestHeader | 为原始请求添加Header | Header的名称及值 |

AddRequestParameter | 为原始请求添加请求参数 | 参数名称及值 |

AddResponseHeader | 为原始响应添加Header | Header的名称及值 |

DedupeResponseHeader | 剔除响应头中重复的值 | 需要去重的Header名称及去重策略 |

Hystrix | 为路由引入Hystrix的断路器保护 | HystrixCommand的名称 |

FallbackHeaders | 为fallbackUri的请求头中添加具体的异常信息 | Header的名称 |

PrefixPath | 为原始请求路径添加前缀 | 前缀路径 |

PreserveHostHeader | 为请求添加一个preserveHostHeader=true的属性,路由过滤器会检查该属性以决定是否要发送原始的Host | 无 |

RequestRateLimiter | 用于对请求限流,限流算法为令牌桶 | keyResolver、rateLimiter、statusCode、denyEmptyKey、emptyKeyStatus |

RedirectTo | 将原始请求重定向到指定的URL | http状态码及重定向的url |

RemoveHopByHopHeadersFilter | 为原始请求删除IETF组织规定的一系列Header | 默认就会启用,可以通过配置指定仅删除哪些Header |

RemoveRequestHeader | 为原始请求删除某个Header | Header名称 |

RemoveResponseHeader | 为原始响应删除某个Header | Header名称 |

RewritePath | 重写原始的请求路径 | 原始路径正则表达式以及重写后路径的正则表达式 |

RewriteResponseHeader | 重写原始响应中的某个Header | Header名称,值的正则表达式,重写后的值 |

SaveSession | 在转发请求之前,强制执行WebSession::save操作 | 无 |

secureHeaders | 为原始响应添加一系列起安全作用的响应头 | 无,支持修改这些安全响应头的值 |

SetPath | 修改原始的请求路径 | 修改后的路径 |

SetResponseHeader | 修改原始响应中某个Header的值 | Header名称,修改后的值 |

SetStatus | 修改原始响应的状态码 | HTTP 状态码,可以是数字,也可以是字符串 |

StripPrefix | 用于截断原始请求的路径 | 使用数字表示要截断的路径的数量 |

Retry | 针对不同的响应进行重试 | retries、statuses、methods、series |

RequestSize | 设置允许接收最大请求包的大小。如果请求包大小超过设置的值,则返回 413 Payload Too Large | 请求包大小,单位为字节,默认值为5M |

ModifyRequestBody | 在转发请求之前修改原始请求体内容 | 修改后的请求体内容 |

ModifyResponseBody | 修改原始响应体的内容 | 修改后的响应体内容 |

Default | 为所有路由添加过滤器 | 过滤器工厂名称及值 |

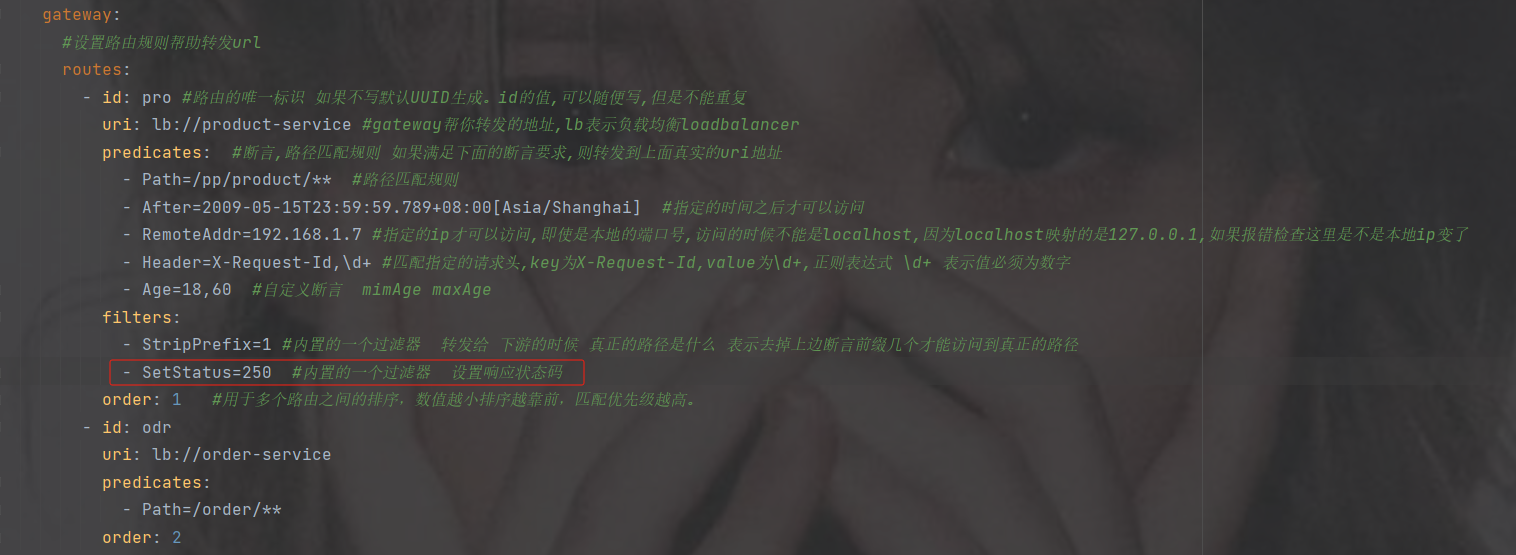

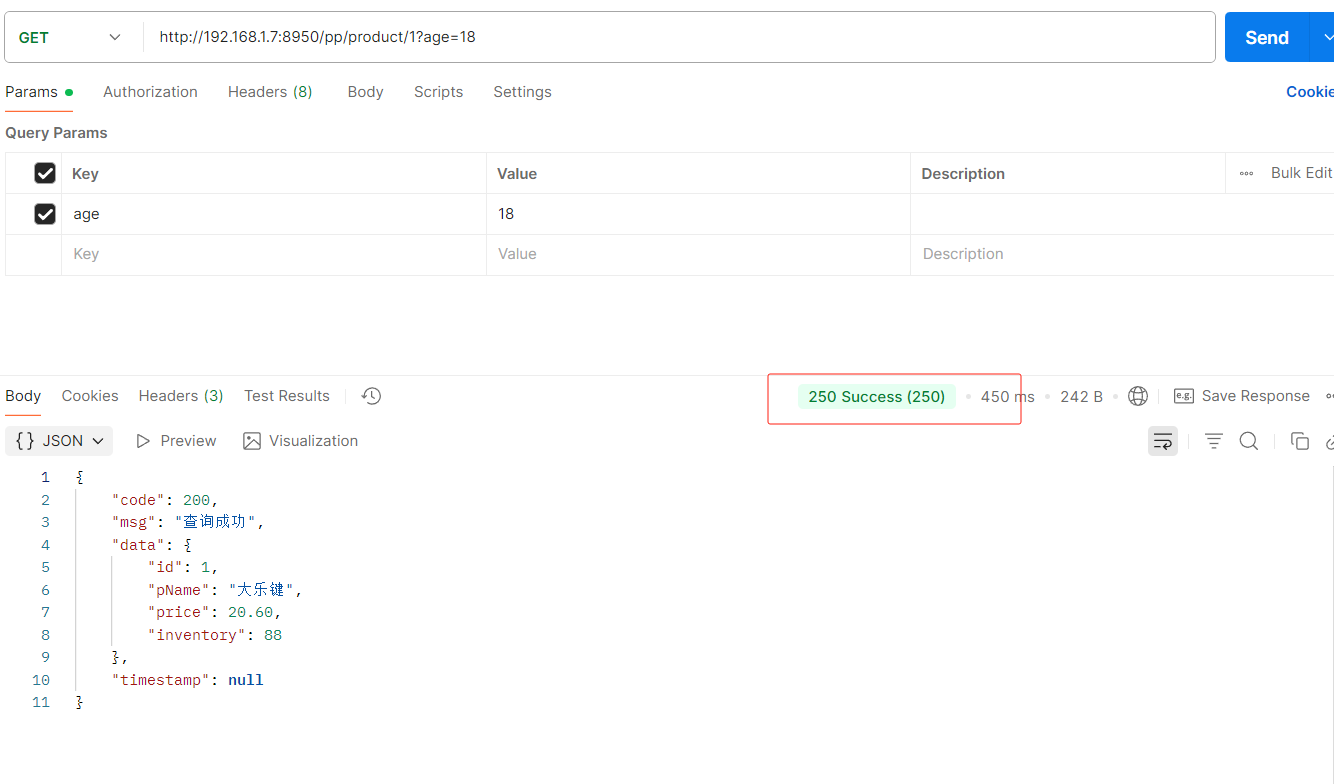

再添加一个设置成功响应的状态码

接口访问会发现状态200改为了250

2. 全局过滤器

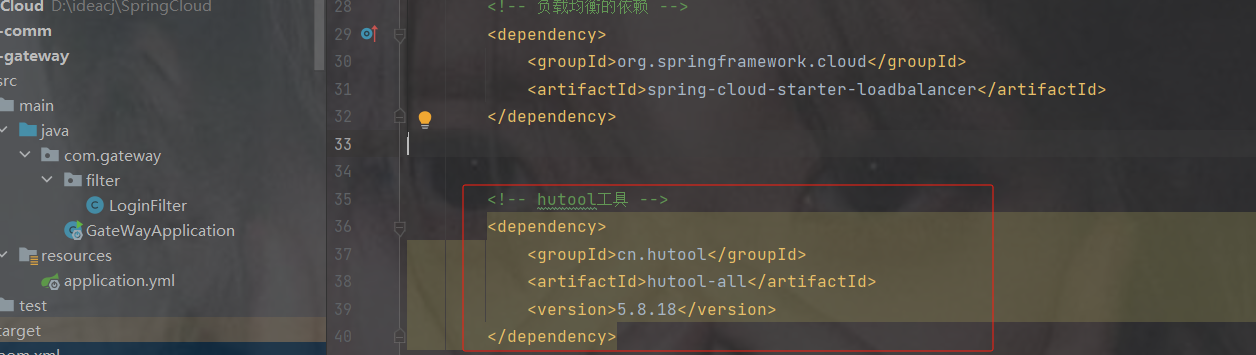

加一个hutool工具依赖

cn.hutool

hutool-all

5.8.18

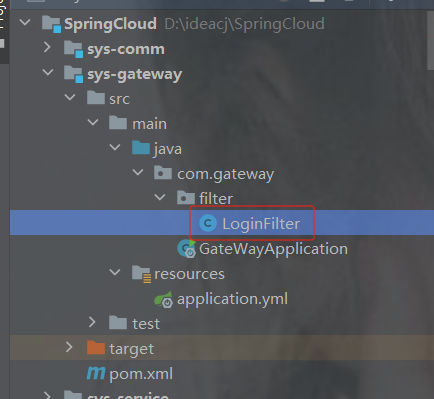

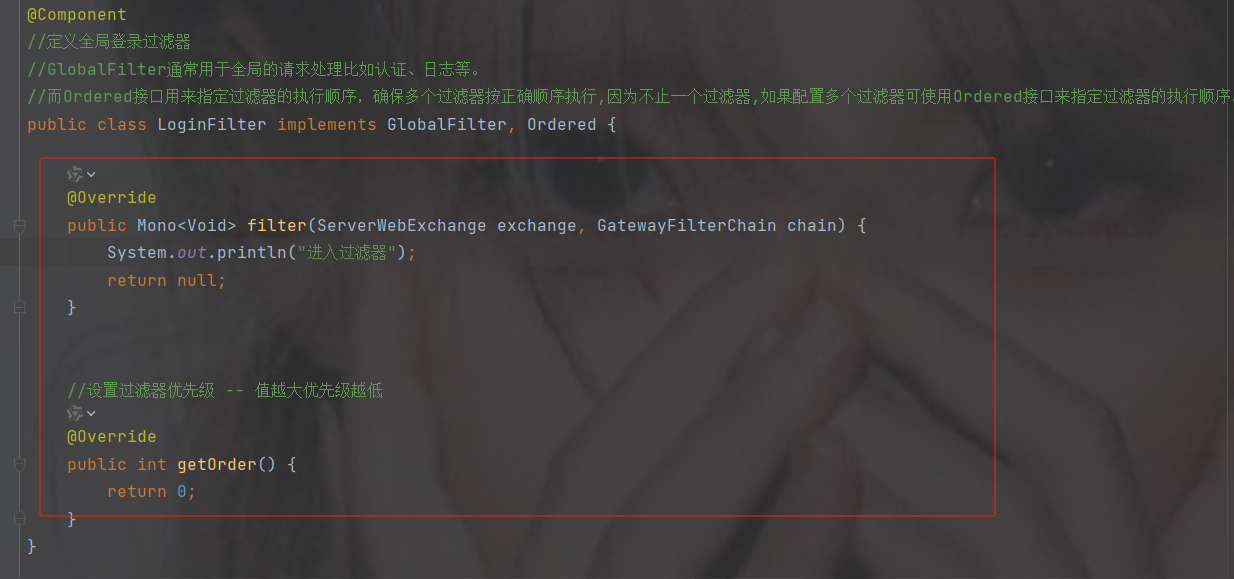

在gateway中创建filter包并且创建filter类

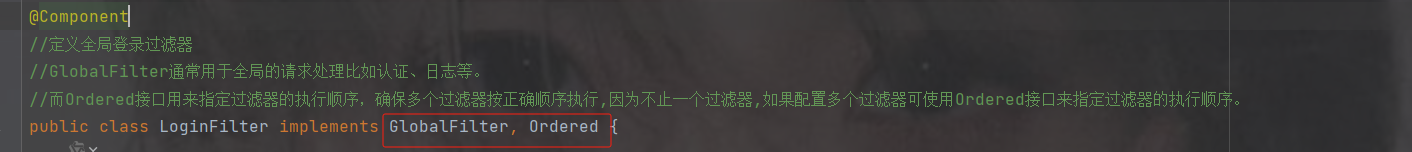

实现GlobalFilter,Ordered接口

filter是过滤器规则,getOrder是配置过滤器优先级

配置过滤规则

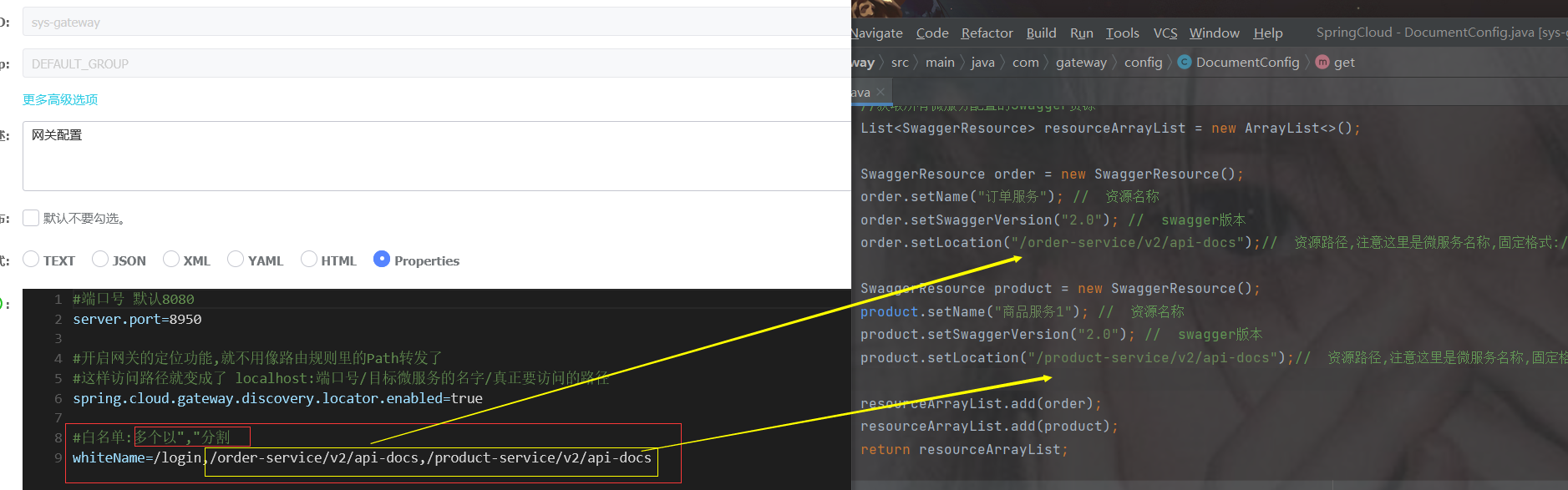

在配置中加一个白名单

#配置端口号默认8080

server:

port: 8950

#设置应用的名称, 在注册中心显示的名称

spring:

application:

name: sys-gateway

cloud:

nacos:

discovery:

#设置nacos的注册中心地址默认是8848

server-addr: 192.168.191.1:8850

enabled: true #开启拉取功能

register-enabled: false #关闭注册功能 默认是true false后在注册中心不会显示

#开启网关的定位功能,就不用再用路由转发了 访问路径就变成了 localhost:端口号/目标微服务的名字/真正要访问的路径

gateway:

discovery:

locator:

enabled: true

#放行白名单

whiteName: /loginpackage com.gateway.filter;

import cn.hutool.core.util.ArrayUtil;

import com.alibaba.cloud.commons.lang.StringUtils;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.cloud.gateway.filter.GatewayFilterChain;

import org.springframework.cloud.gateway.filter.GlobalFilter;

import org.springframework.core.Ordered;

import org.springframework.http.HttpStatus;

import org.springframework.http.server.RequestPath;

import org.springframework.http.server.reactive.ServerHttpRequest;

import org.springframework.http.server.reactive.ServerHttpResponse;

import org.springframework.stereotype.Component;

import org.springframework.web.server.ServerWebExchange;

import reactor.core.publisher.Mono;

@Component

//定义全局登录过滤器

//GlobalFilter通常用于全局的请求处理比如认证、日志等。

//而Ordered接口用来指定过滤器的执行顺序,确保多个过滤器按正确顺序执行,因为不止一个过滤器,如果配置多个过滤器可使用Ordered接口来指定过滤器的执行顺序。

public class LoginFilter implements GlobalFilter, Ordered {

@Value("${whiteName}") //白名单

private String whiteName;

@Override

public Mono filter(ServerWebExchange exchange, GatewayFilterChain chain) {

//字符string 用 "," 分割变为集合

System.out.println(whiteName);

String[] whiteNames = whiteName.split(",");

//获取请求对象

ServerHttpRequest request = exchange.getRequest();

//获取响应对象

ServerHttpResponse response = exchange.getResponse();

//1.获取前端请求路径

String path = request.getURI().getPath();

System.out.println("请求路径:" + path);

//2.判断该路径是否包含匿名访问的路径--->匿名路径:不用登录就可以访问的比如一些登录页面、发送短信的路径等

if (ArrayUtil.contains(whiteNames, path)) {//判断路径是否包含在白名单中

//放行

return chain.filter(exchange);

} else {

//3.路径不是匿名的就获取token,判断是否携带token,携带从redis中获取token,存在刷新token并且放行,不存在拦截,未携带token直接拦截

//获得请求参数中的第一个token,token可能有多个,但是一般token是在请求头

/*String token = request.getQueryParams().getFirst("token");*/

//获取请求头中第一个token

String token = request.getHeaders().getFirst("token");

//判断token不是空白的

if (StringUtils.isNotBlank(token)){

//TODO 4.从redis中获取token,有就刷新redis中的token过期时间并放行,没有就拦截

//放行

return chain.filter(exchange);

}else {

System.out.println("token为空");

response.setStatusCode(HttpStatus.UNAUTHORIZED);

return response.setComplete();

}

}

}

//设置过滤器优先级 -- 值越大优先级越低

@Override

public int getOrder() {

return 0;

}

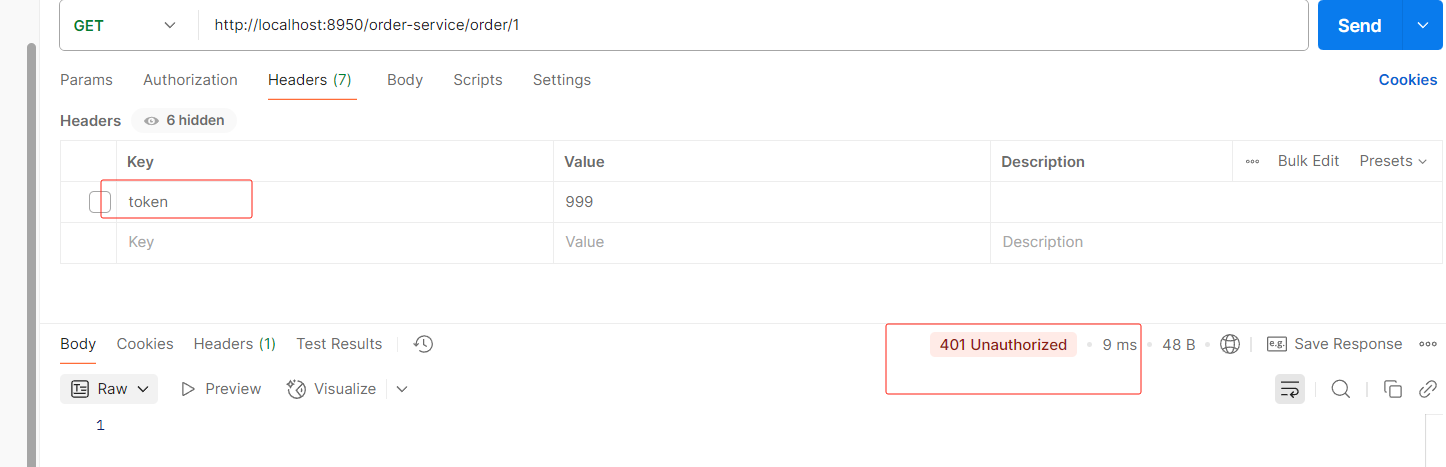

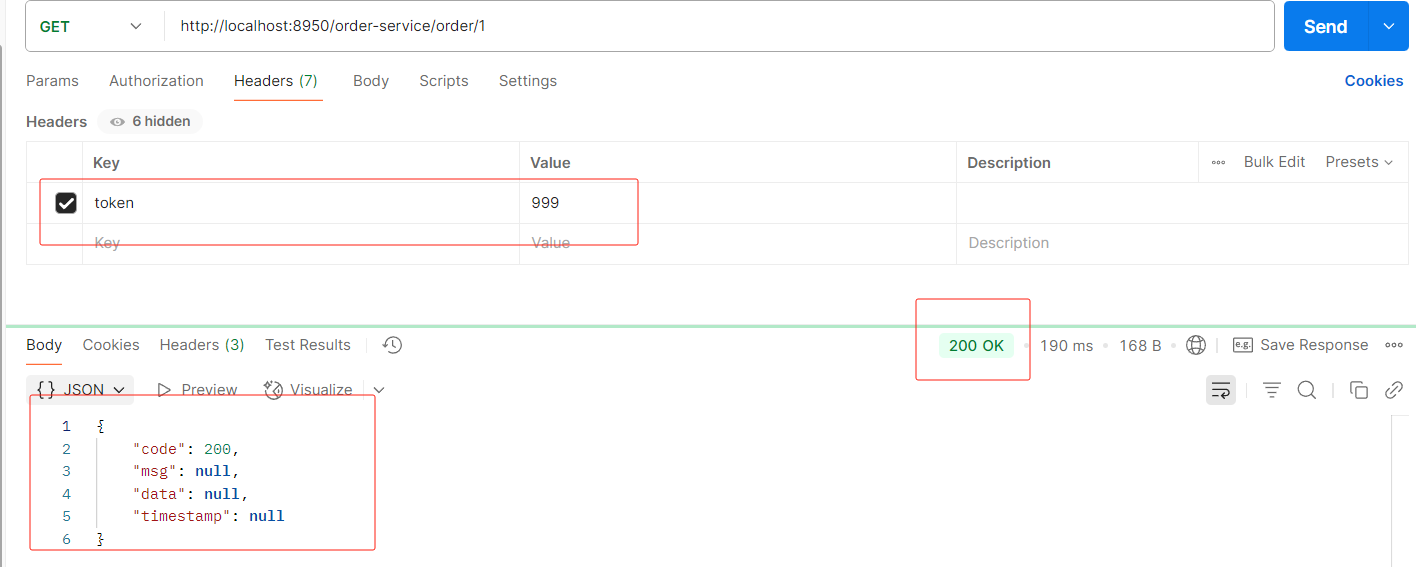

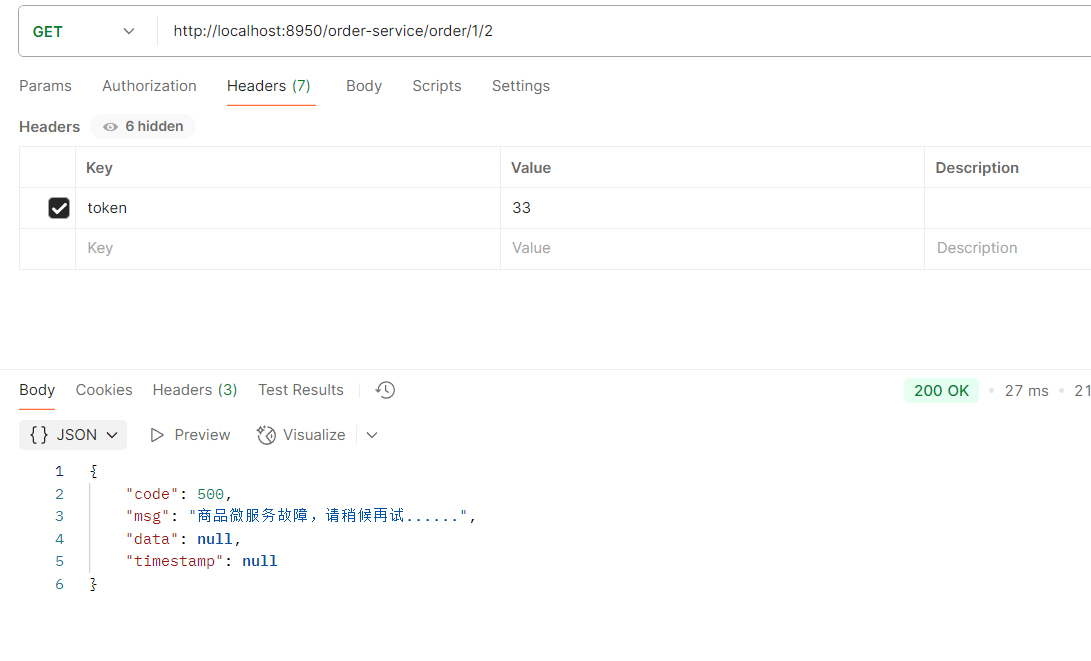

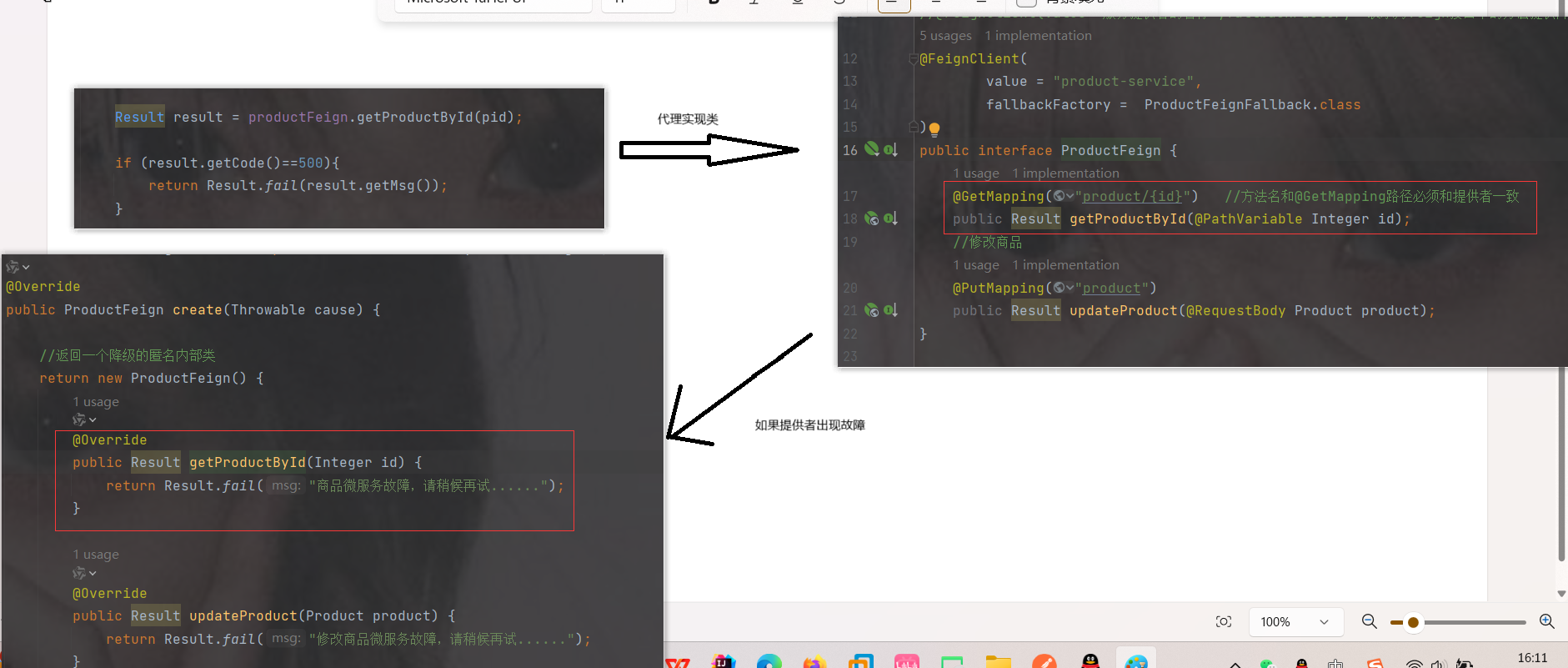

} 没携带token

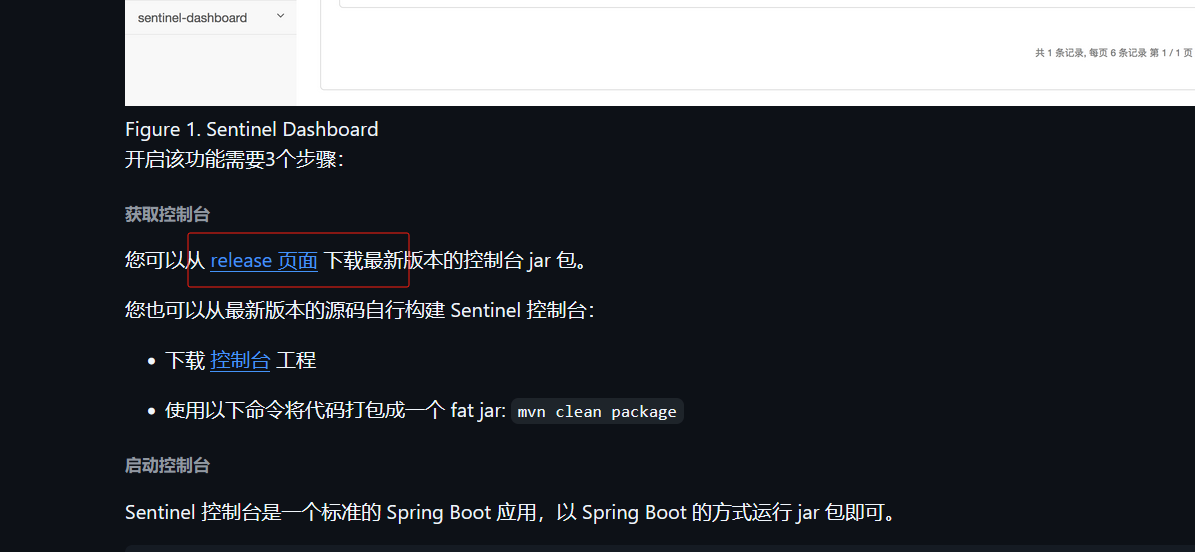

携带token

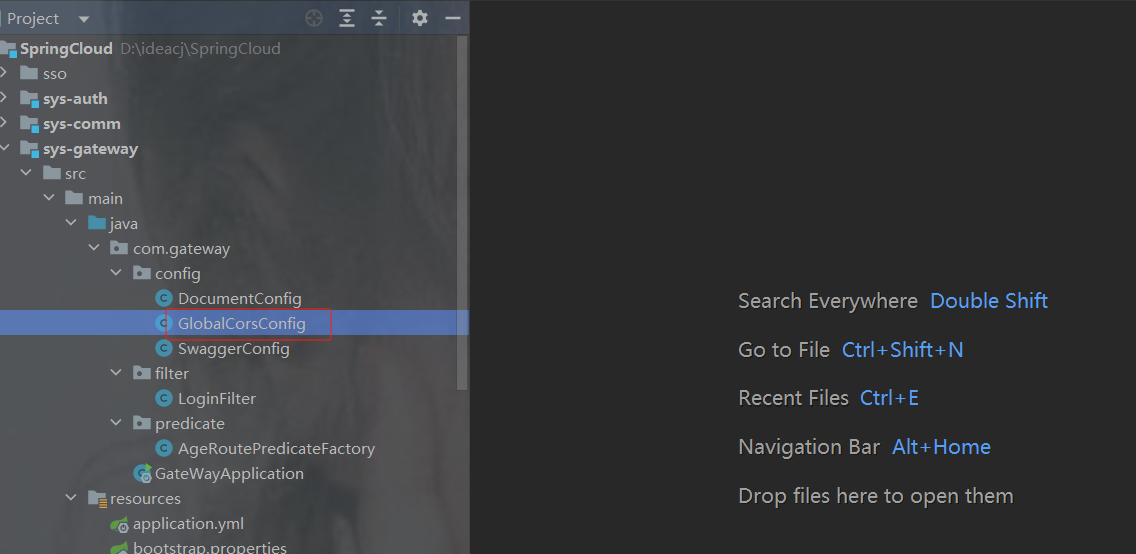

6.10 网关添加跨域配置

未来给前端提供的接口肯定只提供网关接口,这样走网关分发各个服务

http://网关ip:网关端口号/服务名/路径...

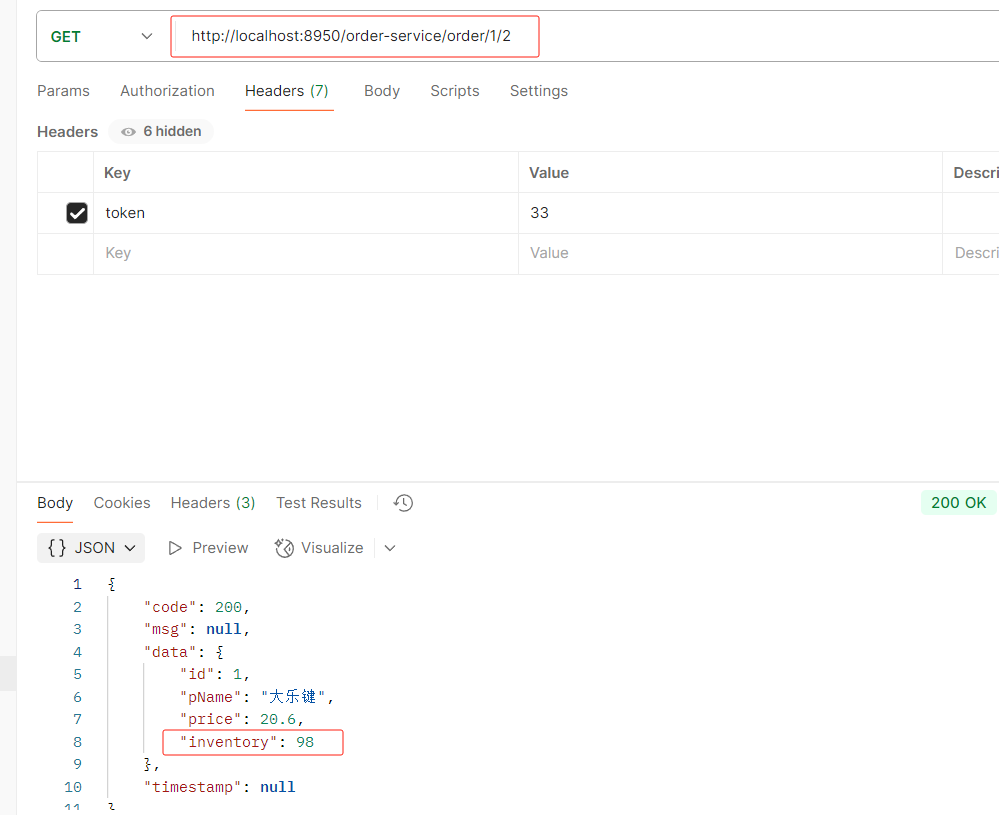

举例:http://localhost:8950/order-service/order/1/2

但是我们有可能会出现跨域的问题,那么问题来了,我们需要在各个服务都要加跨域吗?

---不需要,只需要在网关配置即可,

注意,跨域只能设置一次,如果写重了,前端会报错提示:允许跨域的头多了

package com.gateway.config;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import org.springframework.web.cors.CorsConfiguration;

import org.springframework.web.cors.reactive.CorsWebFilter;

import org.springframework.web.cors.reactive.UrlBasedCorsConfigurationSource;

/**

* 配置跨域的信息

* 所有的请求 都允许跨域

* 任意的来源

* 任意的请求方法都可以

* 跨域只能设置一次

*/

@Configuration

public class GlobalCorsConfig {

// 只能写一次 网关里面去写

// 如果写重了 前端提示 允许跨域的头多了

@Bean

public CorsWebFilter corsWebFilter(){

UrlBasedCorsConfigurationSource source = new UrlBasedCorsConfigurationSource();

CorsConfiguration configuration = new CorsConfiguration();

// 配置跨域的信息

configuration.addAllowedHeader("*");

configuration.addAllowedMethod("*");

// SpringBoot升级到2.4.0 之后需要使用该配置

configuration.addAllowedOriginPattern("*");

configuration.setAllowCredentials(true);

source.registerCorsConfiguration("/**",configuration);

return new CorsWebFilter(source);

}

}7.配置中心nacos

7.1为什么需要配置中心

首先我们来看一下,微服务架构下关于配置文件的一些问题:

1. 配置文件相对分散。

在一个微服务架构下,配置文件会随着微服务的增多变的越来越多,而且分散 在各个微服务中,不好统一配置和管理。

2. 配置文件无法区分环境。

微服务项目可能会有多个环境,例如:测试环境、预发布环境、生产环 境。每一个环境所使用的配置理论上都是不同的,一旦需要修改,就需要我们去各个微服务下手动 维护,这比较困难。

3. 配置文件无法实时更新。

我们修改了配置文件之后,必须重新启动微服务才能使配置生效,这对一 个正在运行的项目来说是非常不友好的。 基于上面这些问题,我们就需要配置中心的加入来解决这些问题。

配置中心的思路是:

首先把项目中各种配置全部都放到一个集中的地方进行统一管理,并提供一套标准的接口。

当各个服务需要获取配置的时候,就来配置中心的接口拉取自己的配置。

当配置中心中的各种参数有更新的时候,也能通知到各个服务实时的过来同步最新的信息,使之动 态更新。

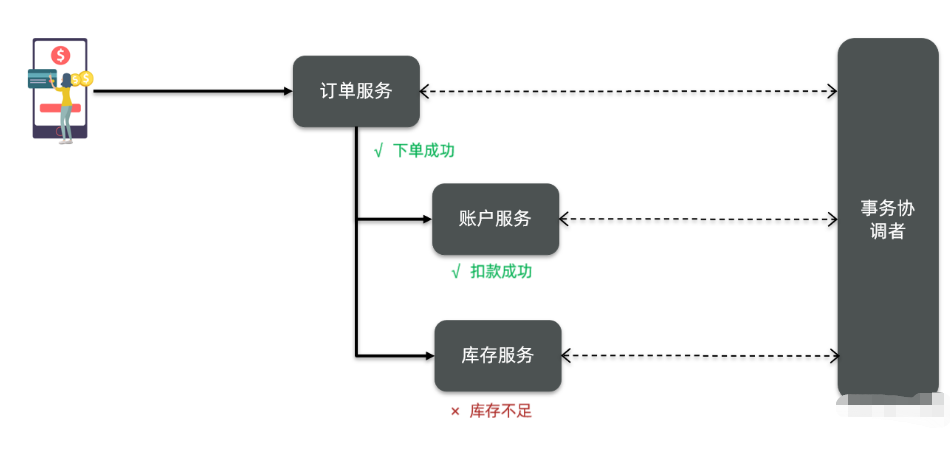

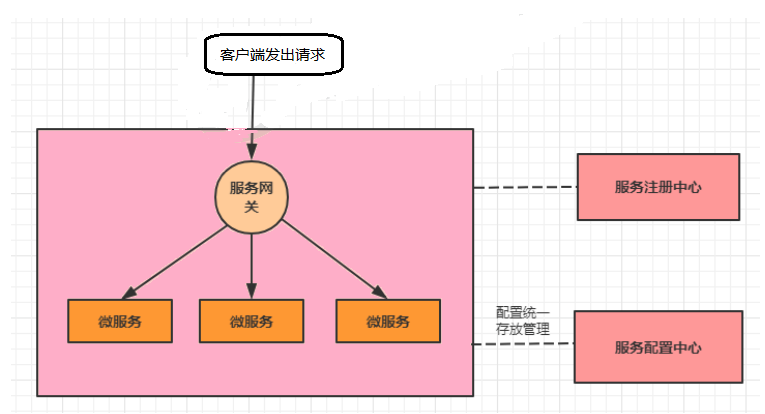

当加入了服务配置中心之后,我们的系统架构图会变成下面这样

------------------------------------------------------------------------------------------------------------------------

解决方法:需要一个微服务的配置管理器。用来管理微服务的配置文件,

7.2 配置中心组件有哪些

1.Apollo

Apollo是由携程开源的分布式配置中心。特点有很多,比如:配置更新之后可以实时生效,支持灰 度发布功能,并且能对所有的配置进行版本管理、操作审计等功能,提供开放平台API。并且资料 也写的很详细。

2.Disconf

Disconf是由百度开源的分布式配置中心。它是基于Zookeeper来实现配置变更后实时通知和生效 的。

3.SpringCloud Config--已过时

这是Spring Cloud中带的配置中心组件。它和Spring是无缝集成,使用起来非常方便,并且它的配 置存储支持Git。不过它没有可视化的操作界面,配置的生效也不是实时的,需要重启或去刷新。

4.Nacos

这是SpingCloud alibaba技术栈中的一个组件,前面我们已经使用它做过服务注册中心。其实它也 集成了服务配置的功能,我们可以直接使用它作为服务配置中心。

7.3 如何使用nacos配置中心

官网:

Nacos config · alibaba/spring-cloud-alibaba Wiki

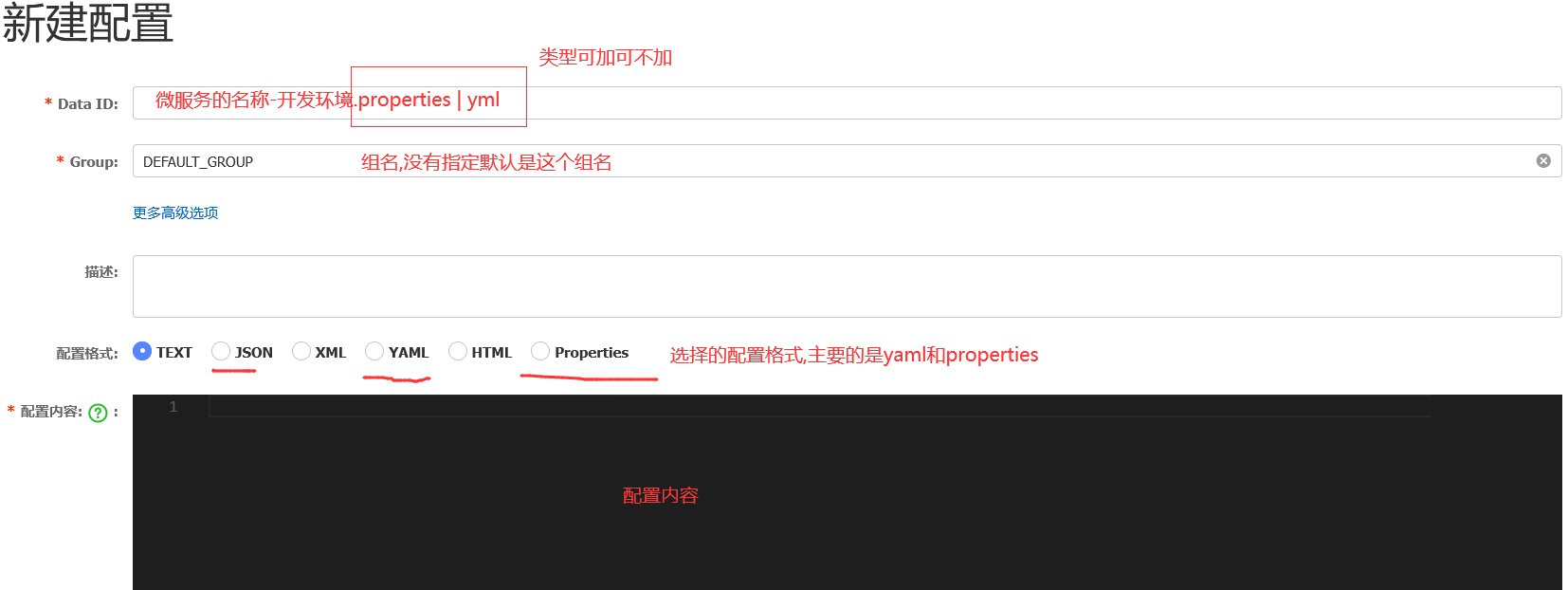

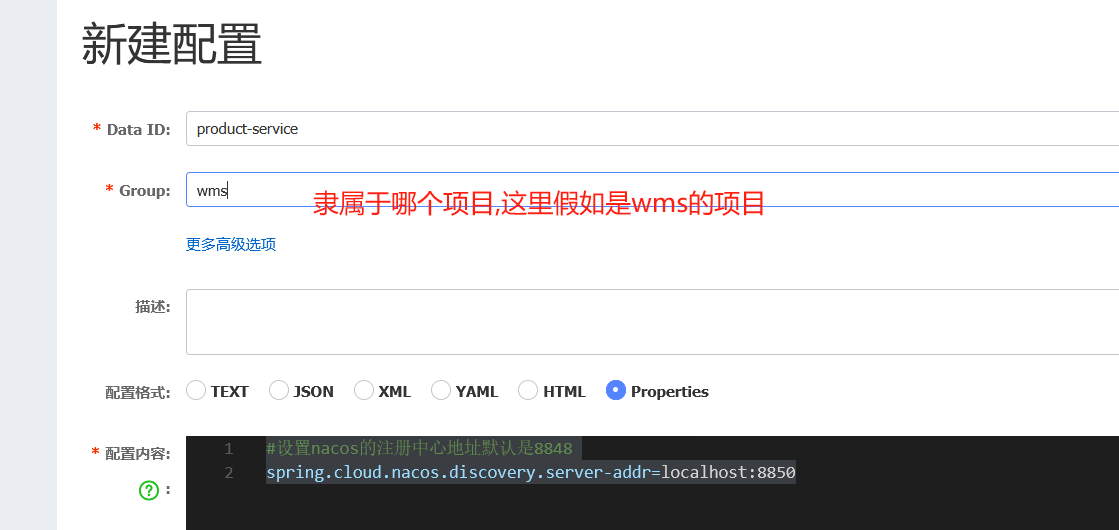

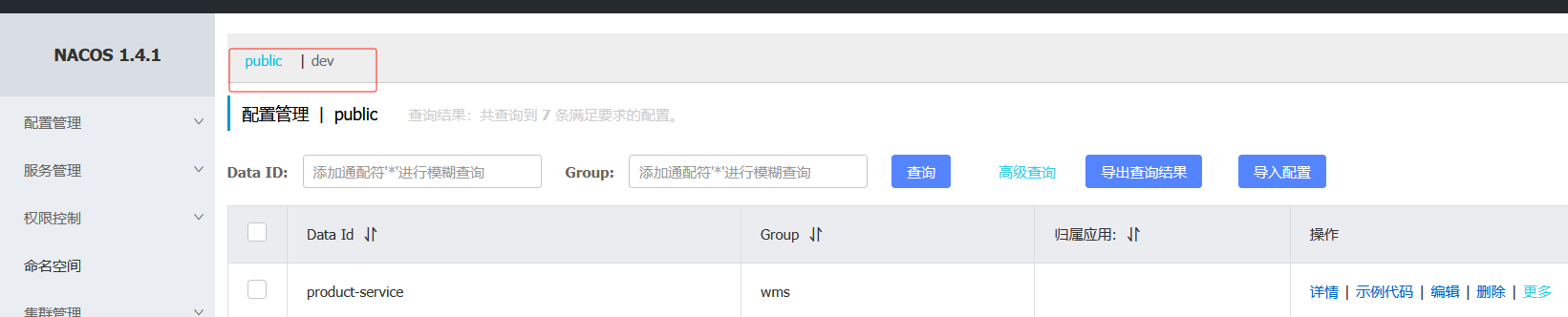

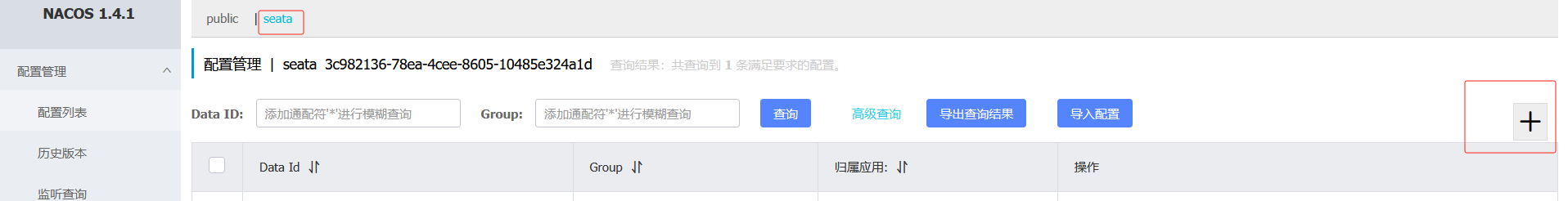

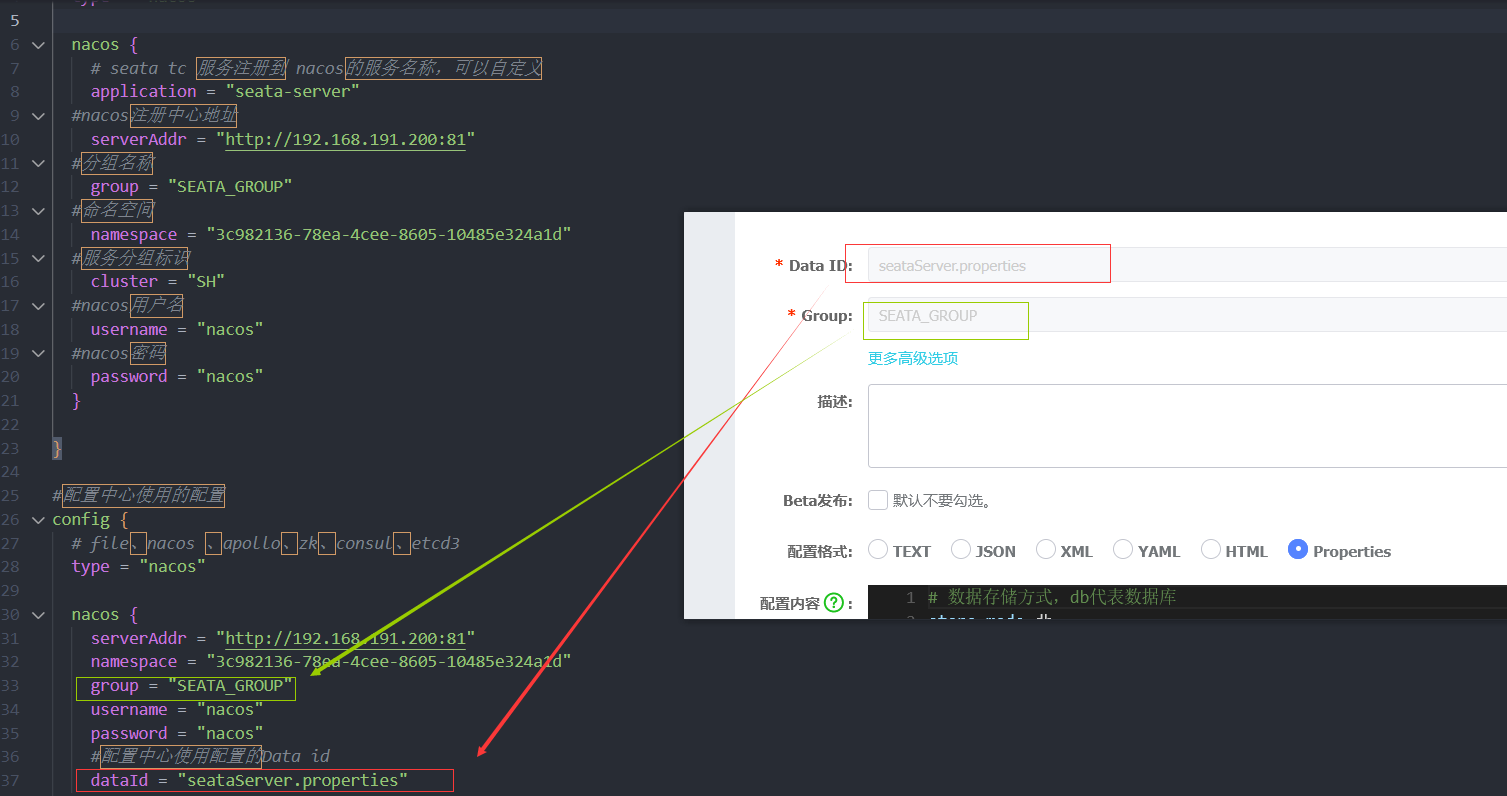

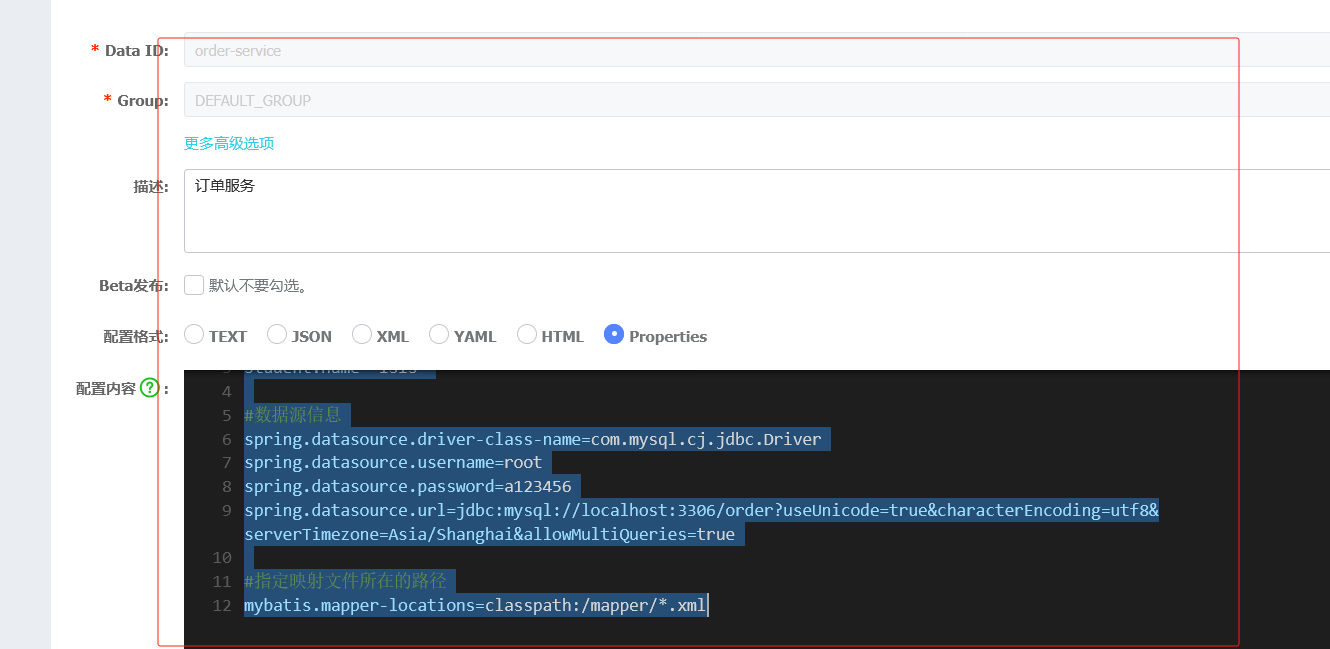

在配置中心找到创建配置,低版本如下图

注: 如果之前配置过了可以选择导入配置,只有加了配置后,才会有导出配置按钮

高版本会显示

说明

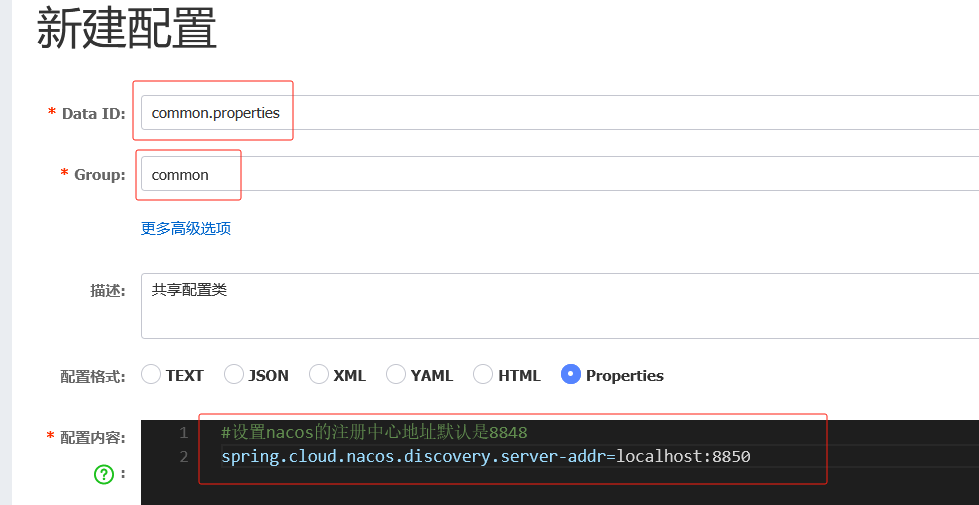

Data ID 一定要对应服务的名称

如果指定了开发环境就还需要 " -开发环境 "

类型properties和yml可加可不加

注意: 配置格式类型要和你项目中的格式类型保持一致,否则会找不到

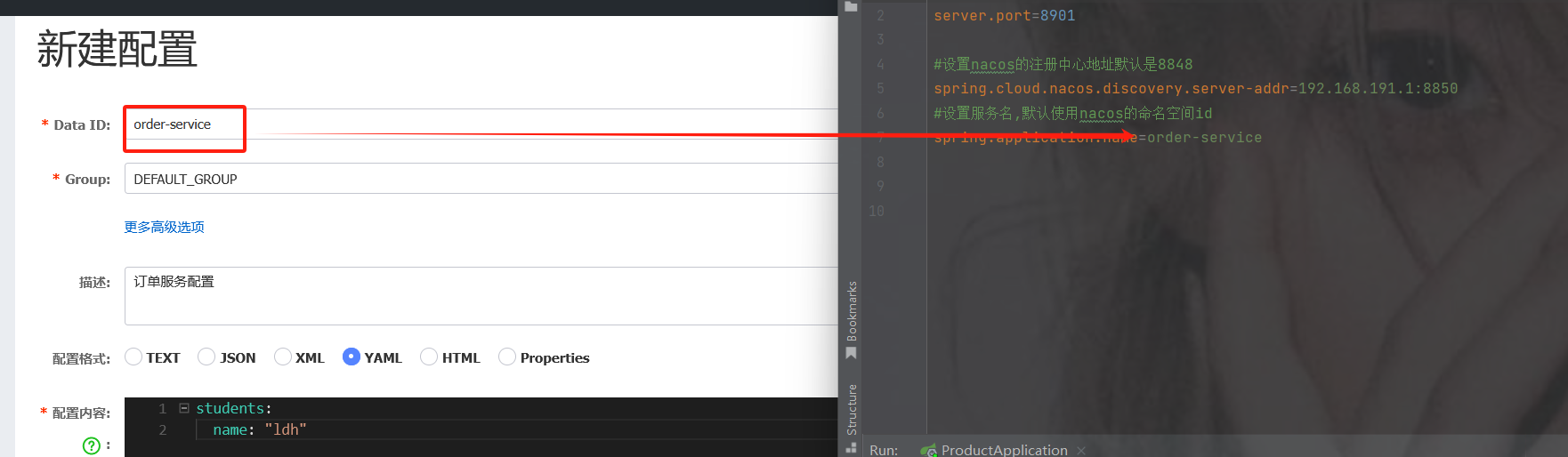

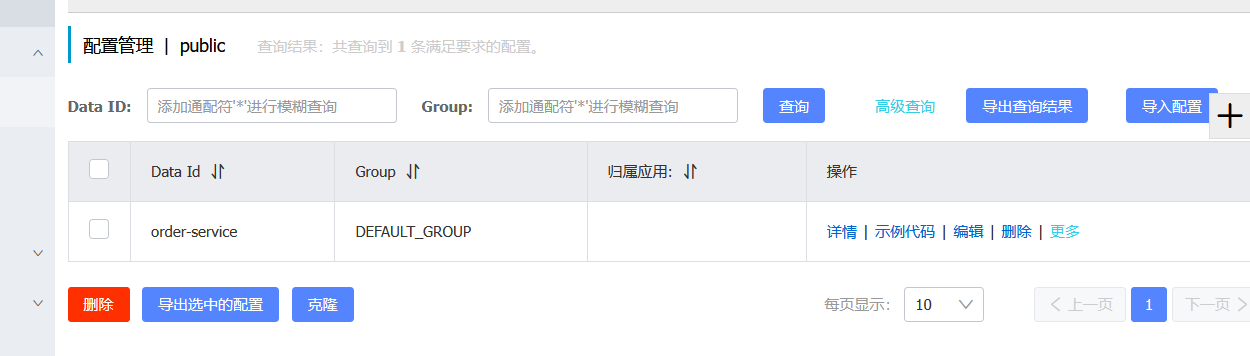

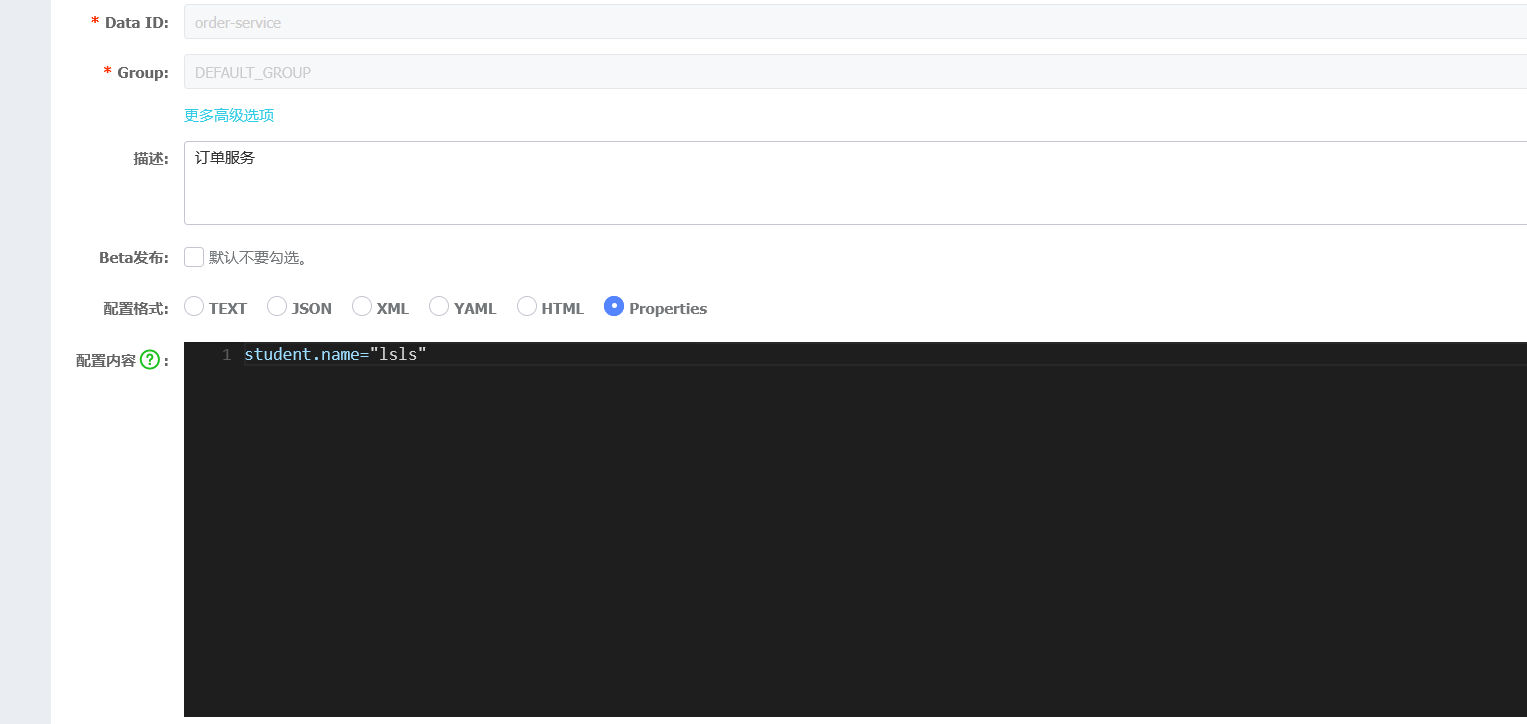

1. 创建配置

创建完成界面

2.项目使用该配置

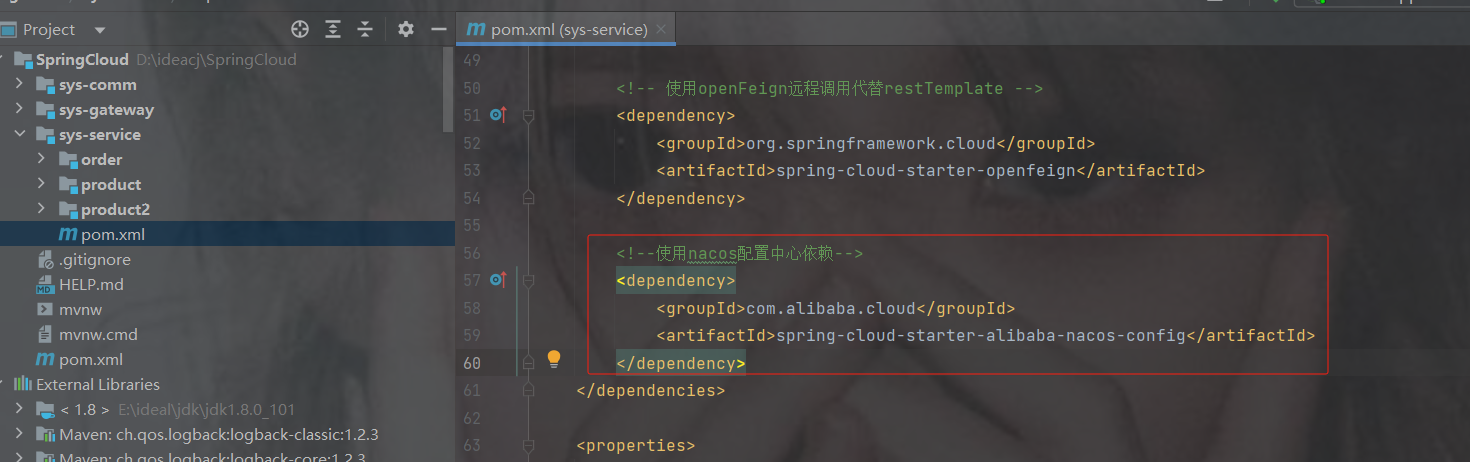

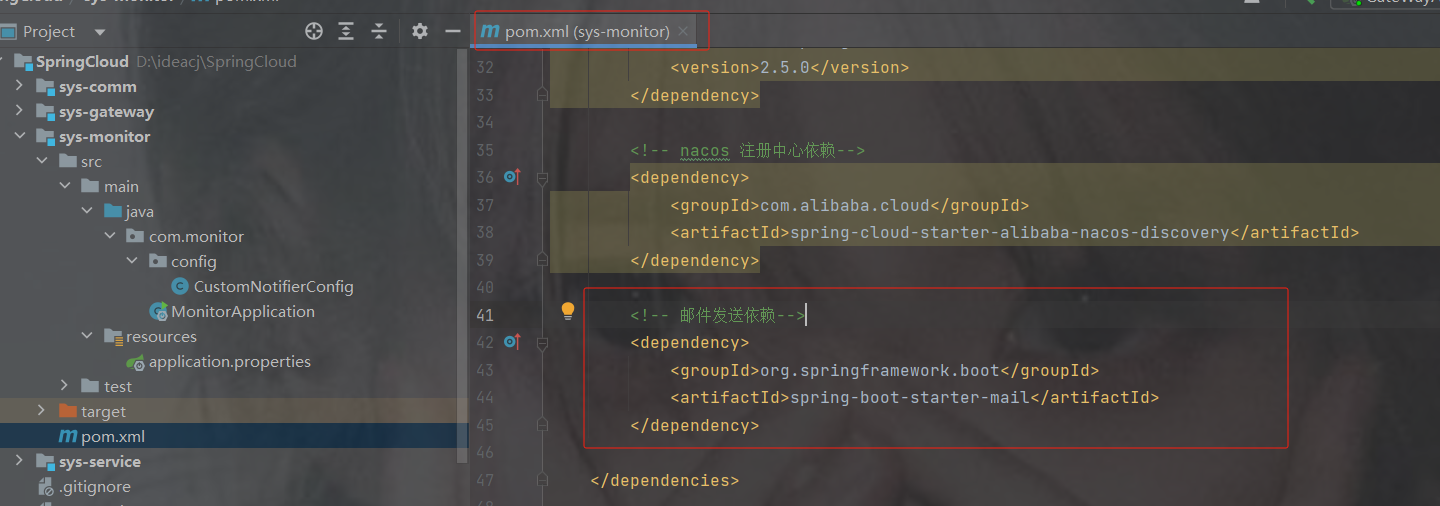

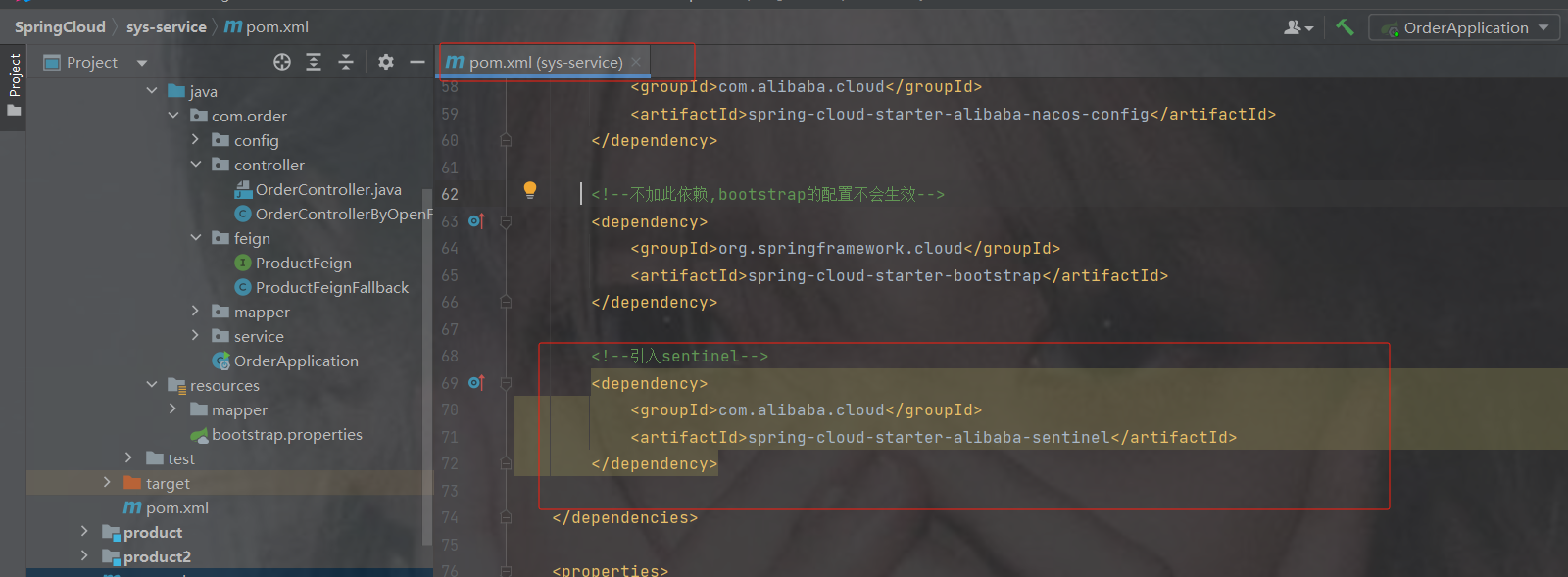

加配置中心依赖

com.alibaba.cloud

spring-cloud-starter-alibaba-nacos-config

org.springframework.cloud

spring-cloud-starter-bootstrap

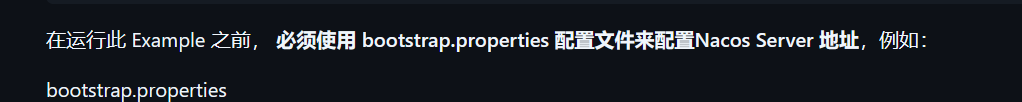

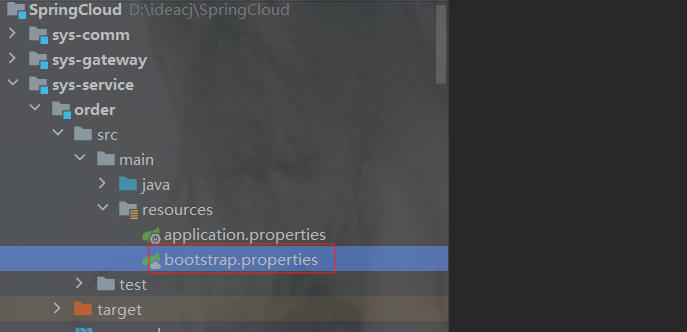

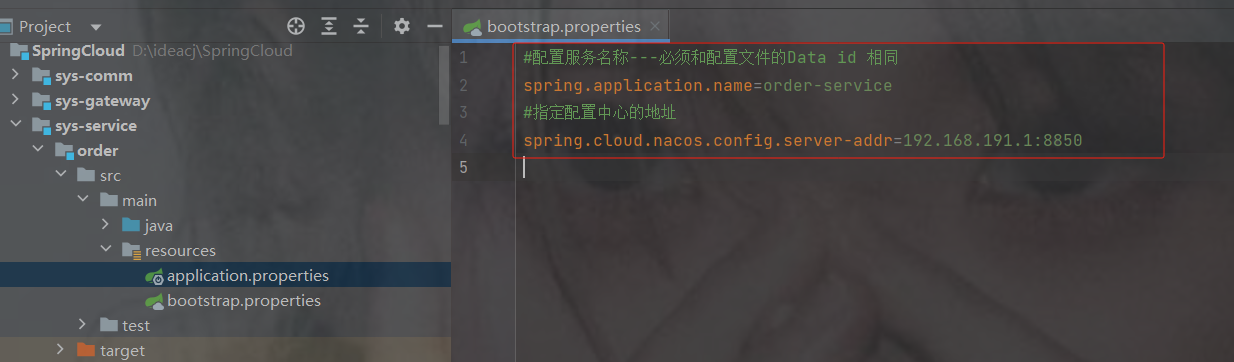

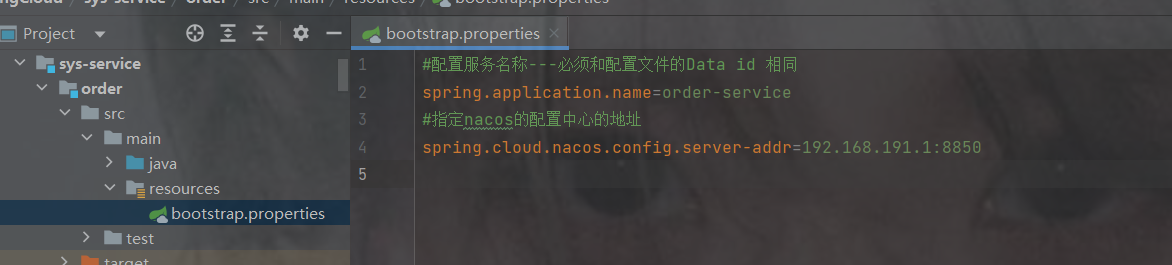

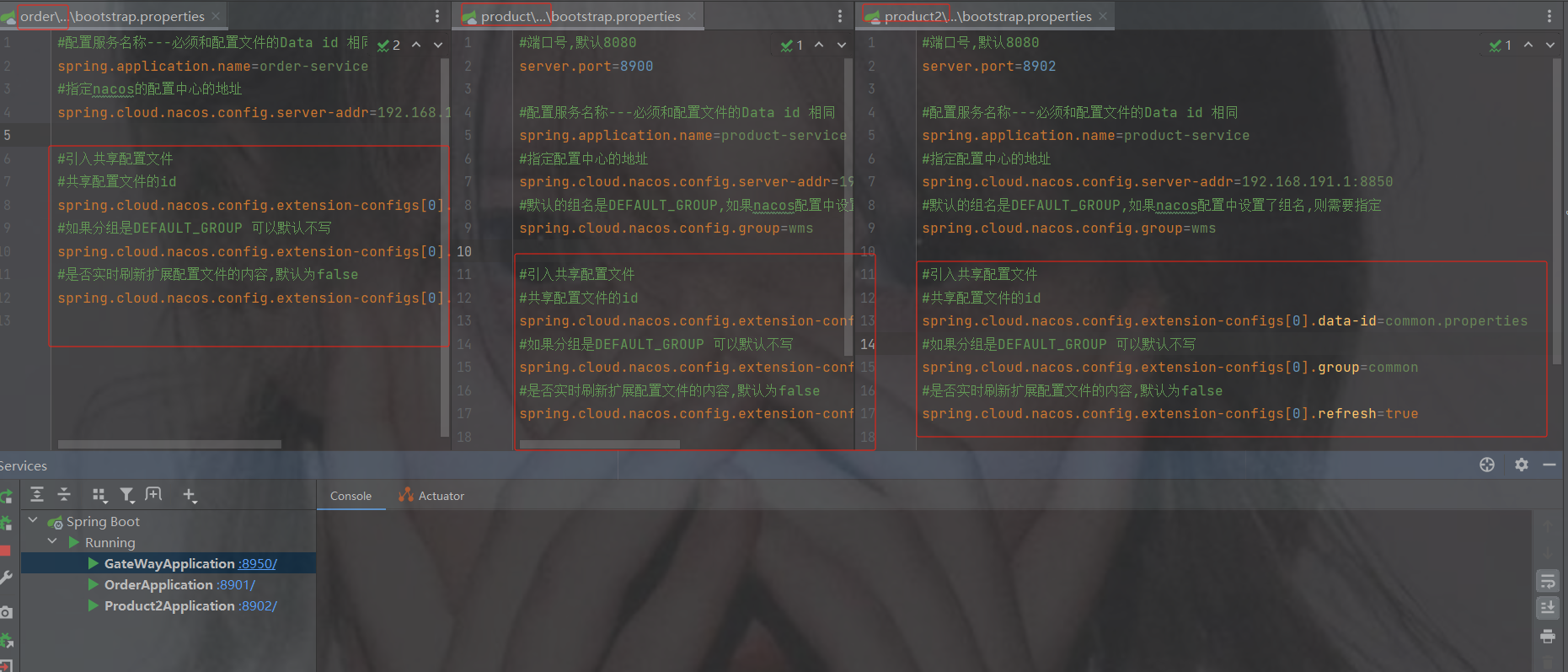

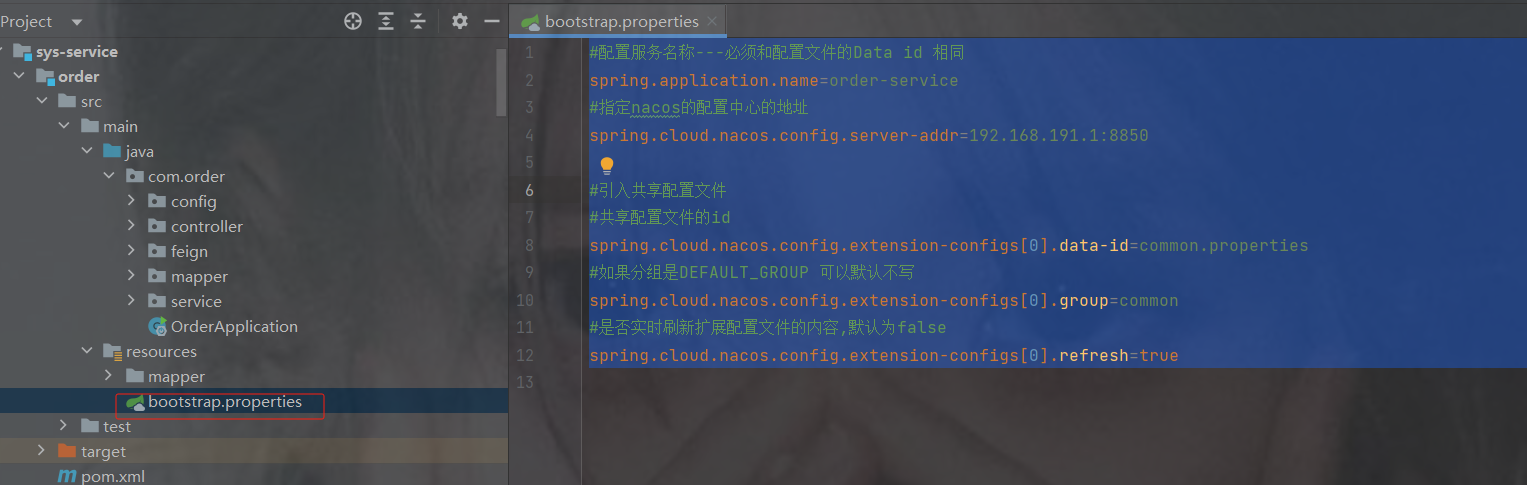

3.创建bootstrap配置文件以及配置内容

yml或者properties都可以

注意:

1.nacos配置的文件类型格式要跟项目bootstrap的格式保持一致, yml 和properties一致

2.如下示例配置在service里面,那么服务必须在所有的服务配置bootstrap,否则启动后会报错找不到nacos配置

#配置服务名称---必须和配置文件的Data id 相同

spring.application.name=order-service

#指定配置中心的地址

spring.cloud.nacos.config.server-addr=192.168.191.1:88504.测试配置文件中是否生效

package com.order.controller;

import com.comm.entity.Product;

import com.comm.utlis.Result;

import com.fasterxml.jackson.databind.ObjectMapper;

import com.order.feign.ProductFeign;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.cloud.client.ServiceInstance;

import org.springframework.cloud.context.config.annotation.RefreshScope;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PathVariable;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RestController;

import java.util.List;

import java.util.Random;

@RestController

@RequestMapping("/order")

public class OrderControllerByOpenFeign {

// 远程调用调用接口

@Autowired

private ProductFeign productFeign; //spring启动时会为使用@FeignClient注解的接口创建代理实现类

@GetMapping("{pid}")

public Result order(@PathVariable Integer pid) {

//1.根据商品的id 查询商品的价格 库存

//2.存入订单

Result result = productFeign.getProductById(pid);

//转换对象不要再使用fastjson了

Product product = new ObjectMapper().convertValue(result.getData(), Product.class);

System.out.println("订单存储的数据:" + product);

//假装这里是存储订单的代码

return Result.ok(null);

}

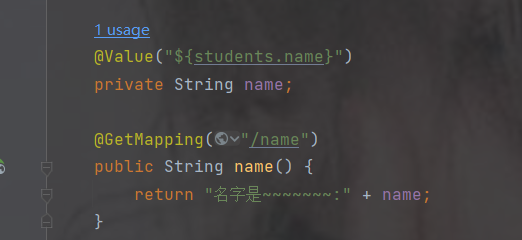

@Value("${student.name}")

private String name;

@GetMapping("/name")

public String name() {

return "名字是~~~~~~~:" + name;

}

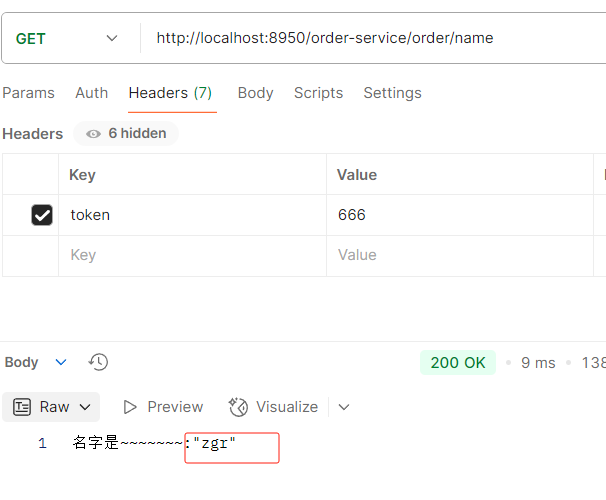

}发现已生效

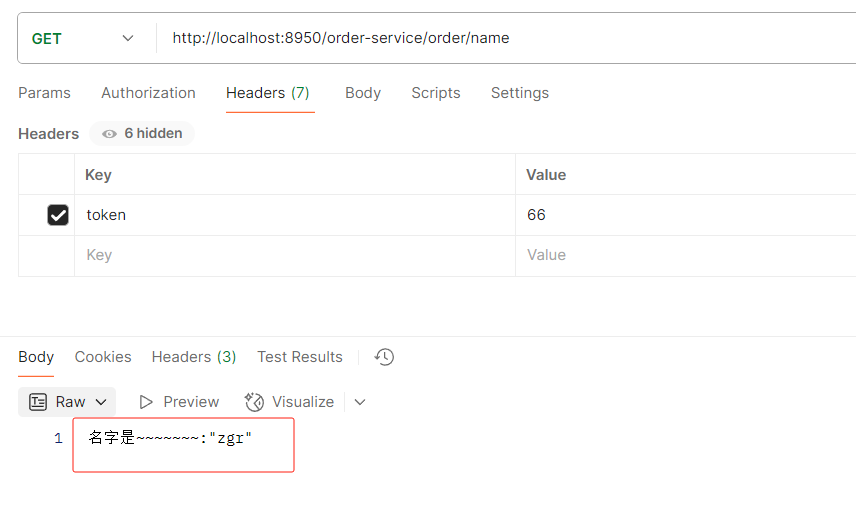

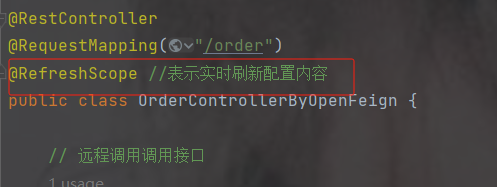

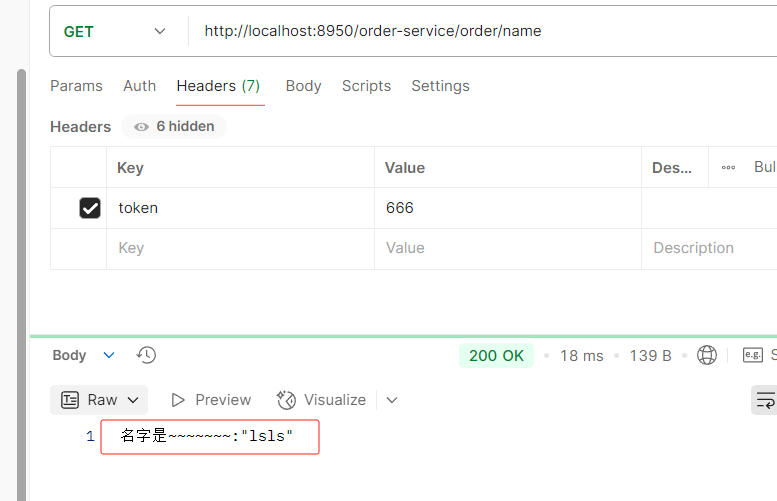

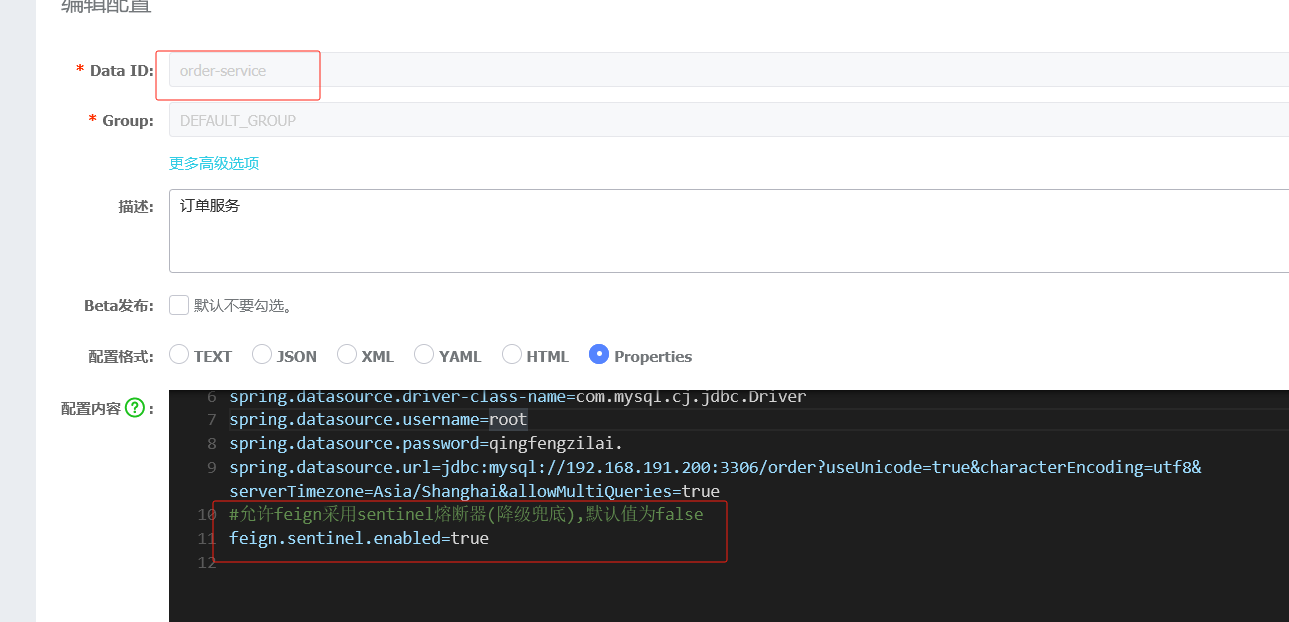

7.4 实时刷新配置

配置中心中配置文件修改后,无需重启服务,则自动更新内容

加注解@RefreshScope

加完后重启服务

访问一下路径查看name是之前的

在nacos修改name值

直接访问接口不要重启服务,验证实时刷新配置成功了

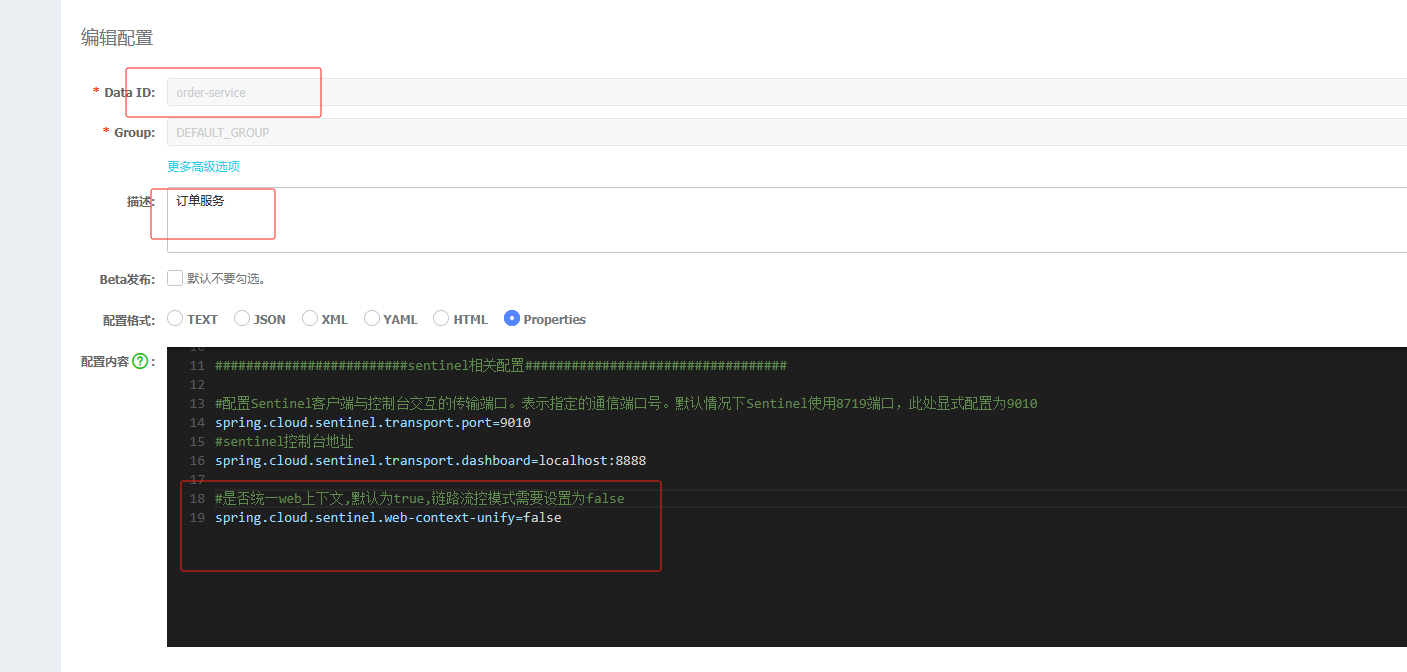

7.5 建议以后把微服务的配置信息通用写在配置中心

这里演示的是订单服务,注意商品是两个服务,所以不能在配置中心配置端口号,商品可看7.6配置

把applicanton.properties的配置放到nacos中

配置中心配置好,删掉applicanton.properties

只留nacos配置中心的地址以及服务名称

不用配置注册中心是因为上图已经配置在nacos配置中了

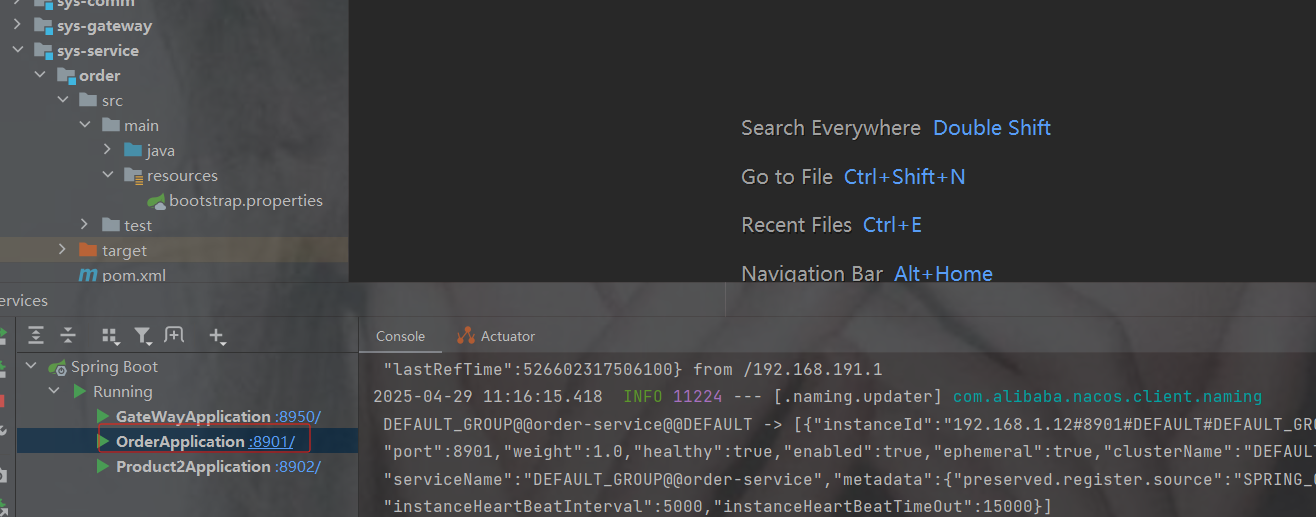

启动查看成功

并且服务列表也在

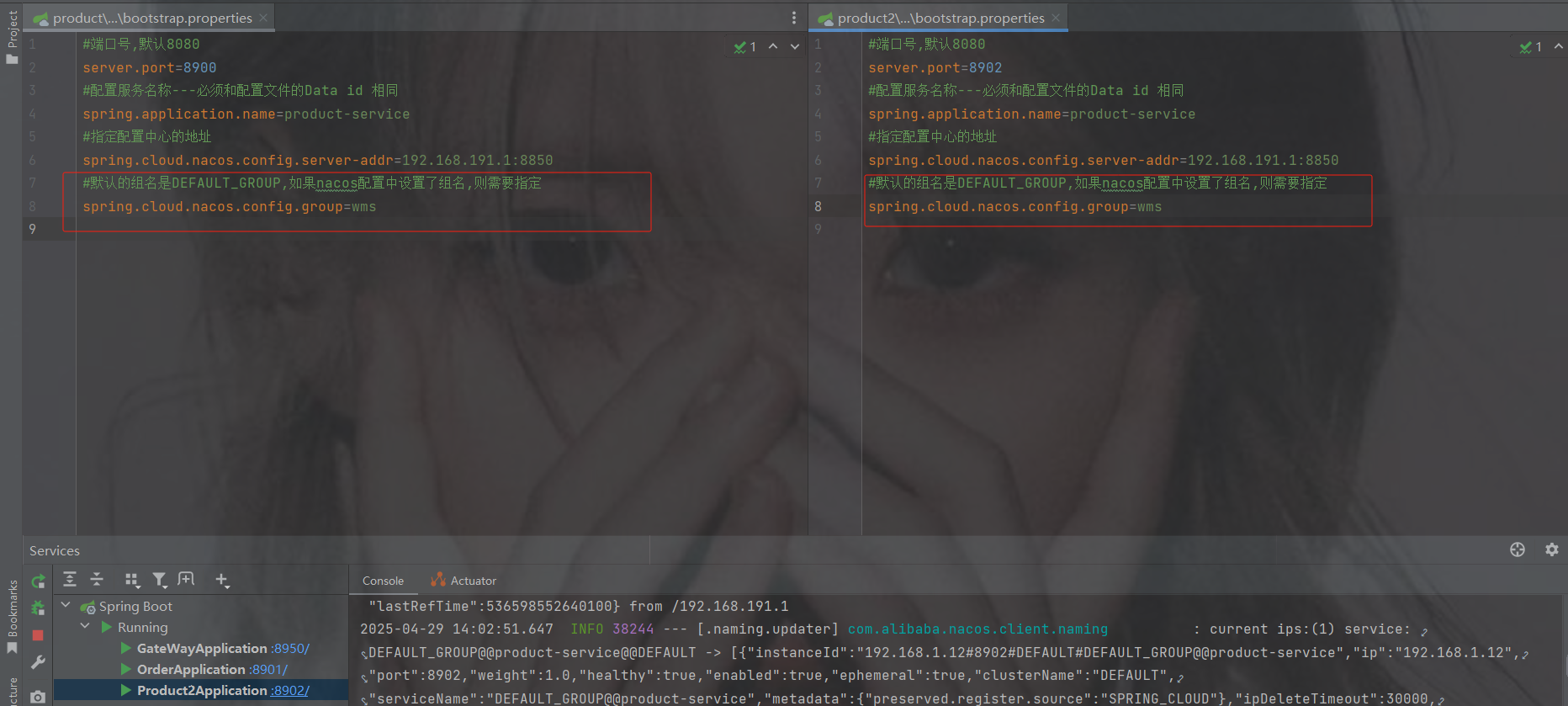

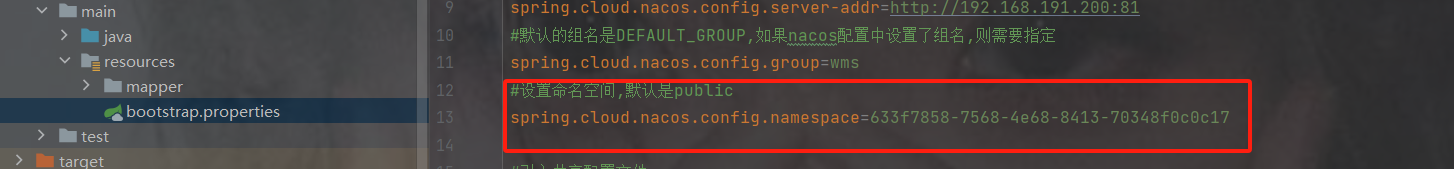

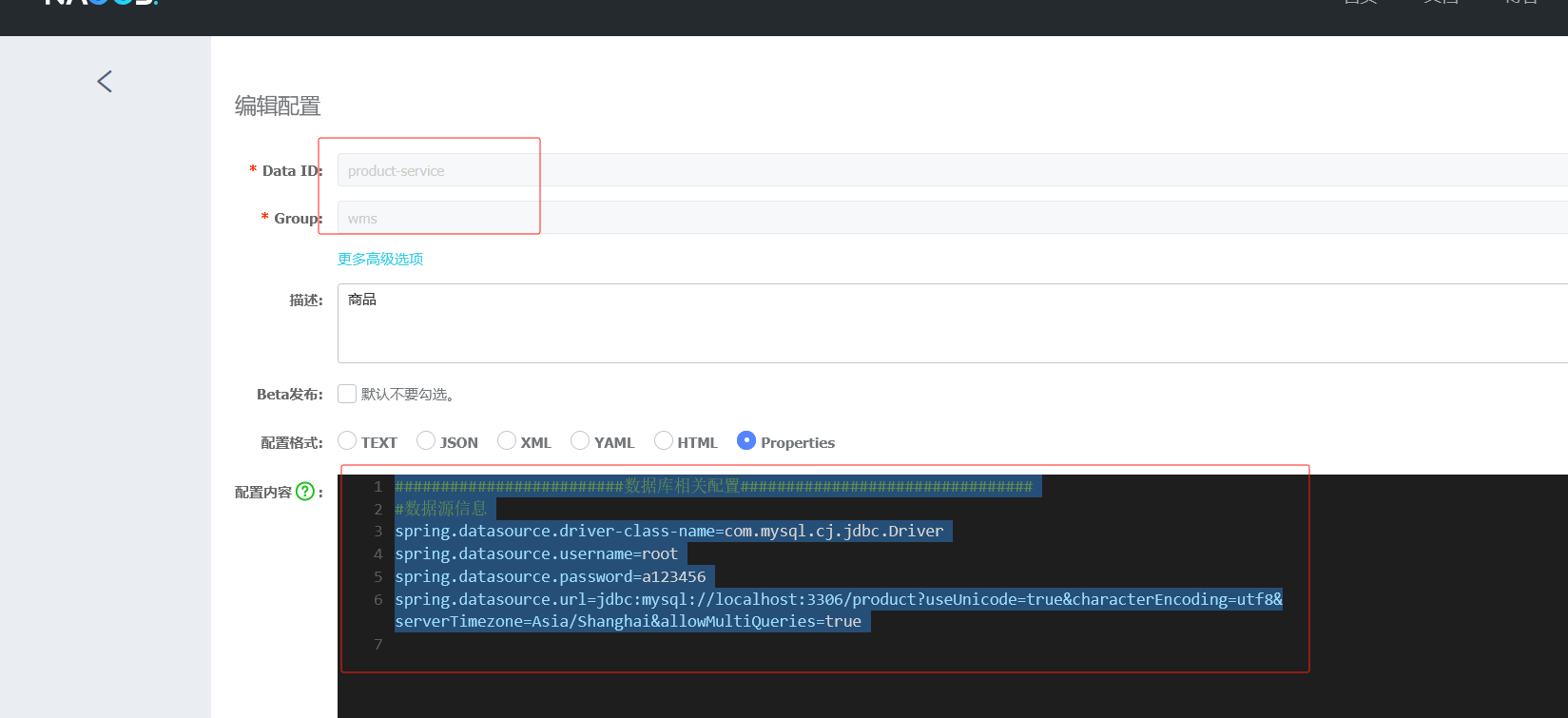

7.6 配置文件指定组名

未来在公司开发的项目很多,需要规范点分组

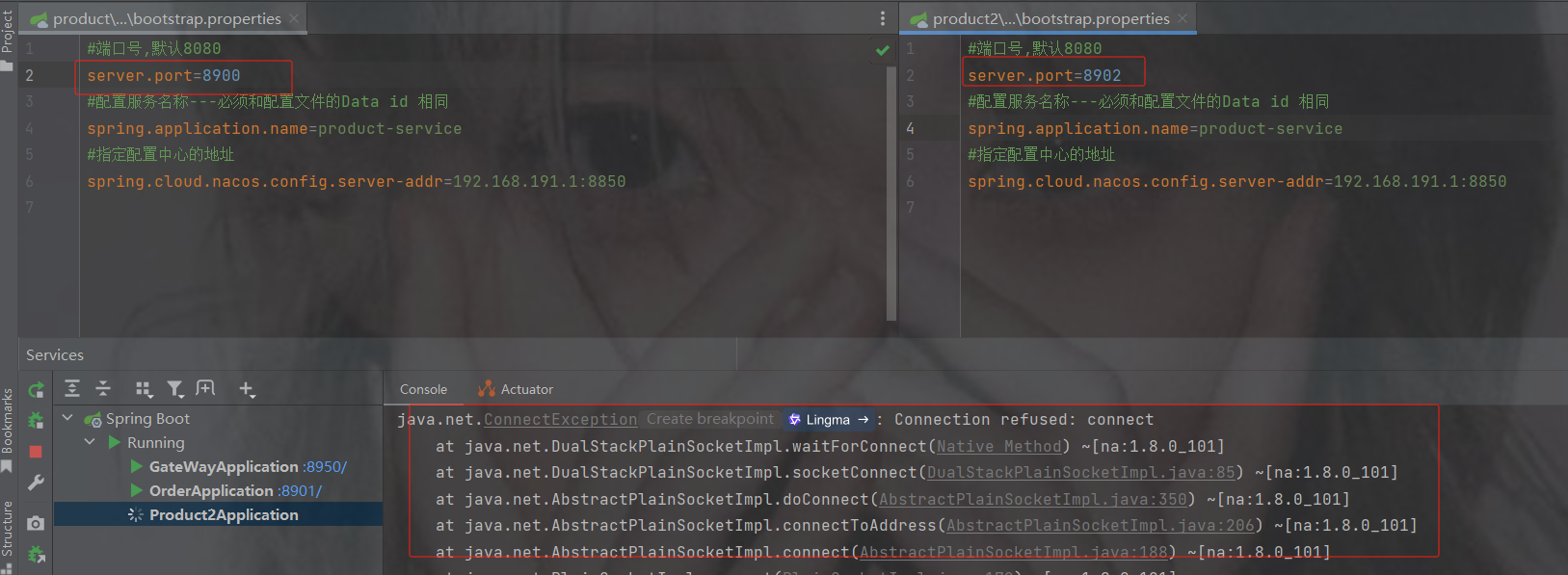

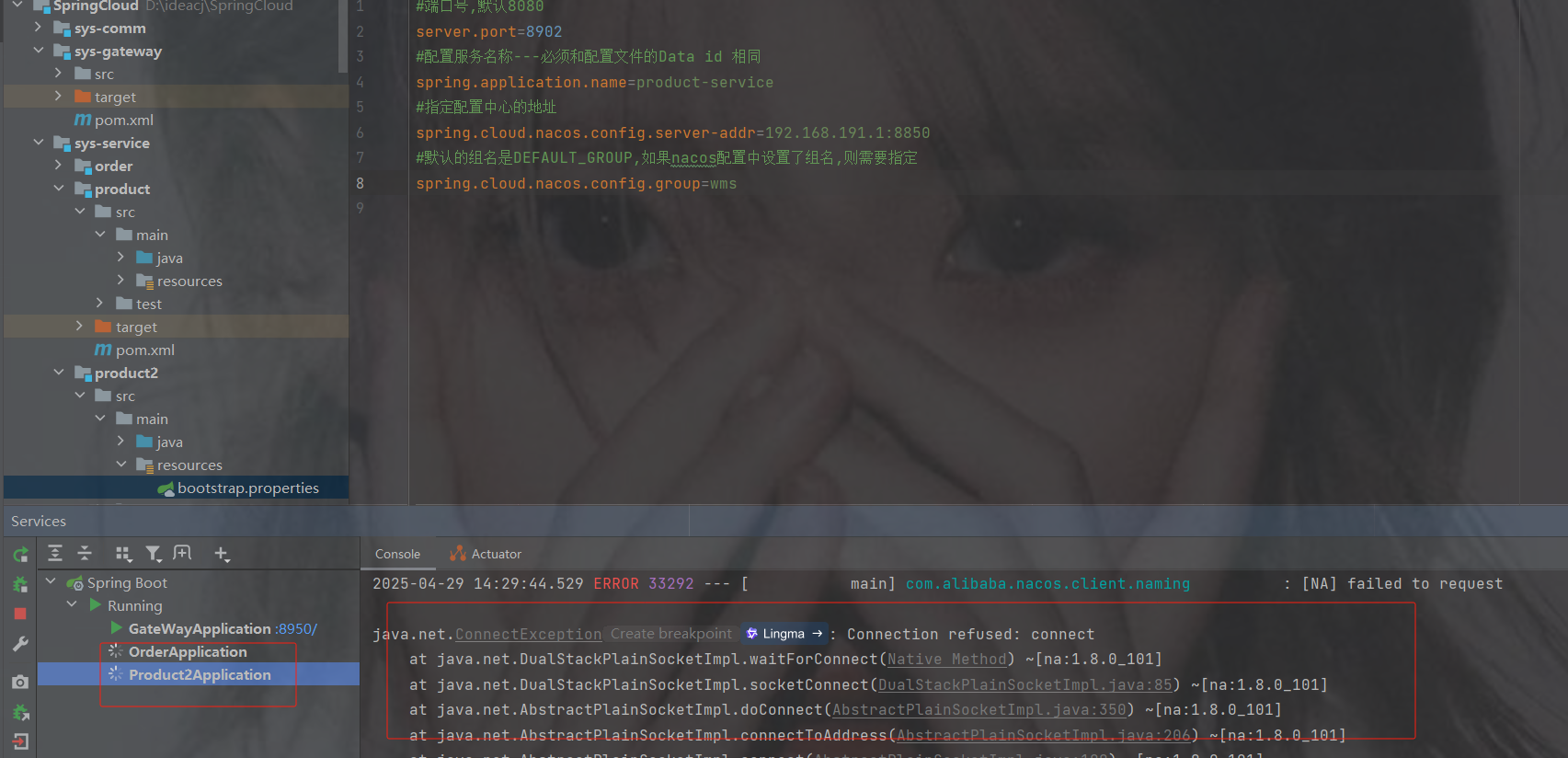

注意因为商品有两个服务所以不能设置端口号

端口号只需要在bootstrap里配置就好了,但是会发现下面会报错

因为默认读的组是DEFAULT_GROUP,而上面配置的是wms分组

spring.cloud.nacos.config.group=你起的组名配置分组名称重启就成功了

两个服务也在正常运行

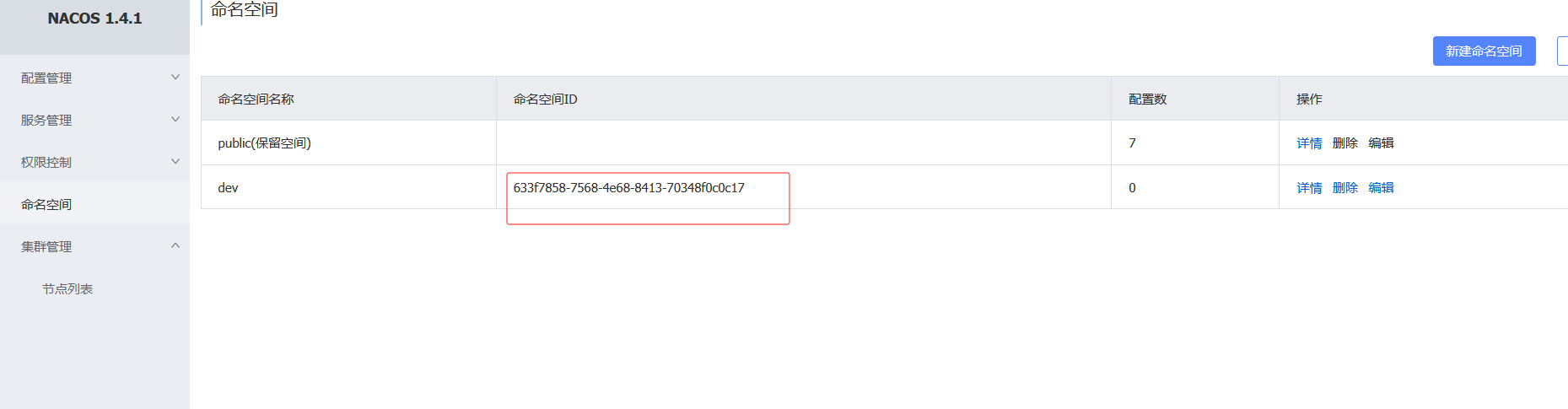

7.7 命名空间

命名空间可用于进行不同环境的配置隔离。一般一个环境划分到一个命名空间

如果不设置命名空间id自动生成

点击dev即可切换

同样的创建商品的配置

配置设置命名空间,默认是public,如果没设置命名空间可不加spring.cloud.nacos.config.namespace=命名空间id

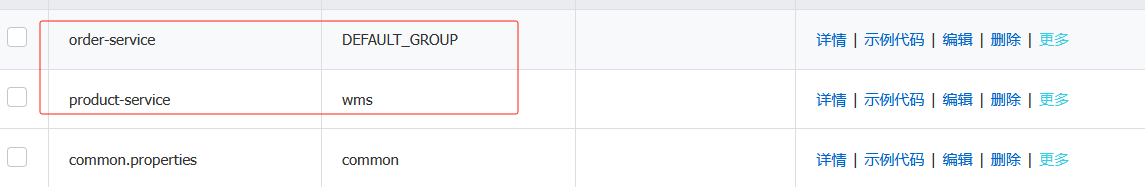

7.8 多个微服务共享一个配置

多个微服务可能存在相同的配置内容,那么我们就可以把这些相同配置的内容,独立提取到一个新的配置文件中,让这些微服务共享这个配置文件

创建共享配置,把公共的配置提取出来,以后一些一样的只需要修改共享配置即可,不用一个个修改了

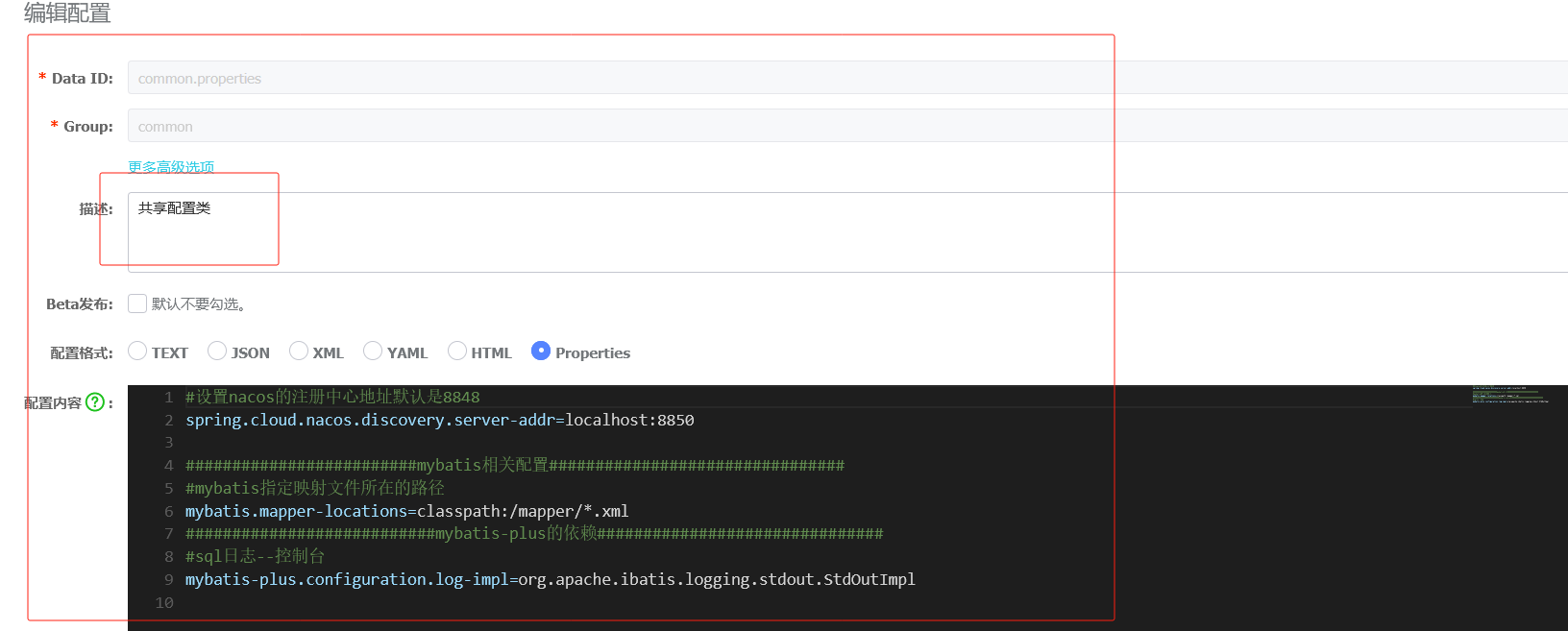

多个微服务共享的配置

删掉这两个配置里的nacos注册中心地址

此时重启服务是没有用的,因为注册中心被提取到共享配置里了

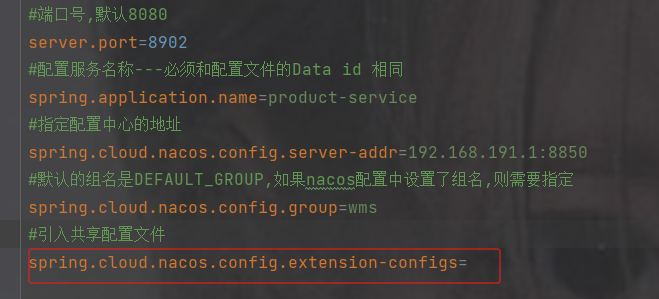

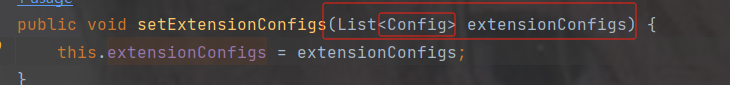

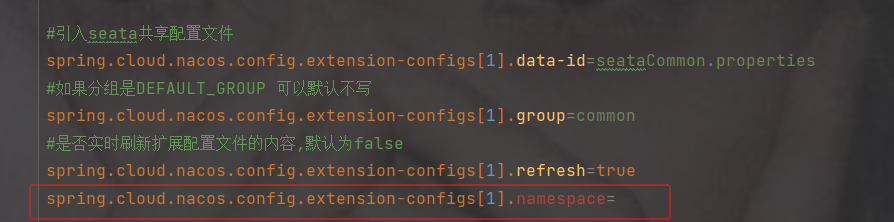

点击查看所需要的配置参数

spring.cloud.nacos.config.extension-configs

是一个数组并且需要的类型是Config类型,点击Config查看

dataId 共享配置的名字

group 共享配置的分组 ---如果分组是DEFAULT_GROUP 可以默认不写

refresh 是否实时刷新扩展配置文件的内容,默认为false

properties写法

#引入共享配置文件

#共享配置文件的id

spring.cloud.nacos.config.extension-configs[0].data-id=文件id

#如果分组是DEFAULT_GROUP 可以默认不写

spring.cloud.nacos.config.extension-configs[0].group=分组名

#是否实时刷新扩展配置文件的内容,默认为false

spring.cloud.nacos.config.extension-configs[0].refresh=trueyml写法

spring:

cloud:

nacos:

config:

# 共享配置

shared-configs:

- data-id: common.properties

group: common

refresh: true 配置完重启发现启动成功

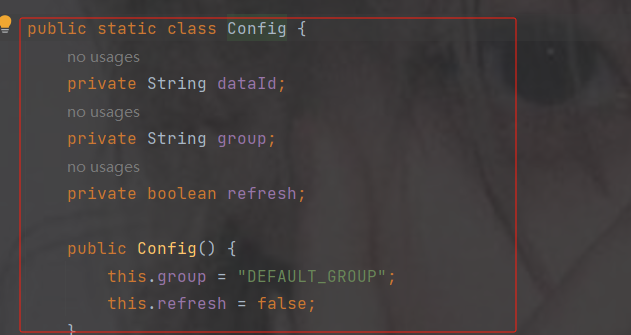

不要混乱了配置

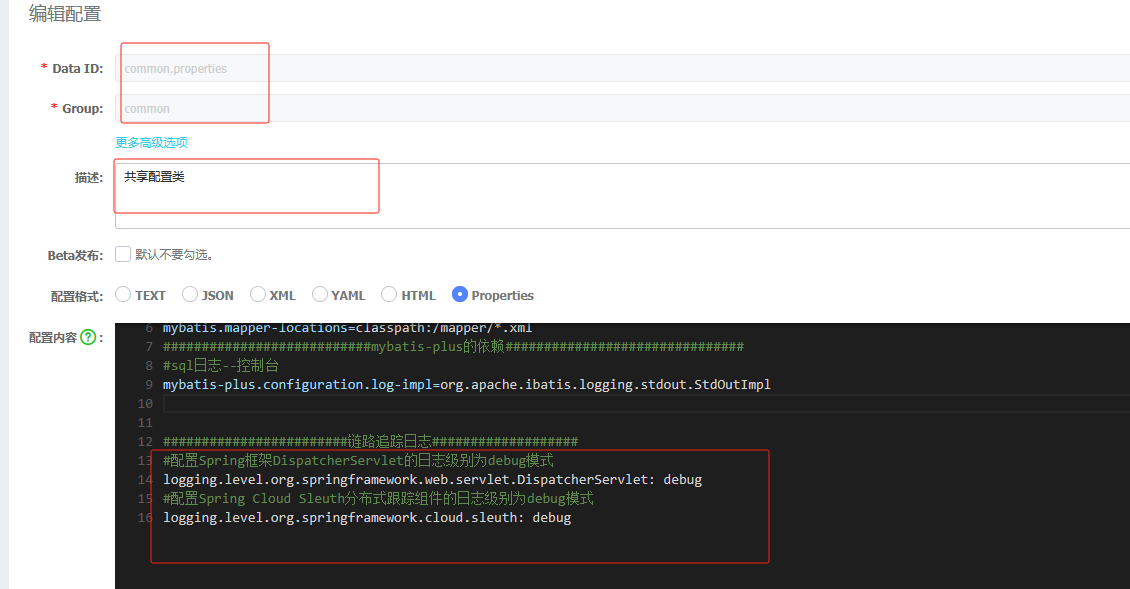

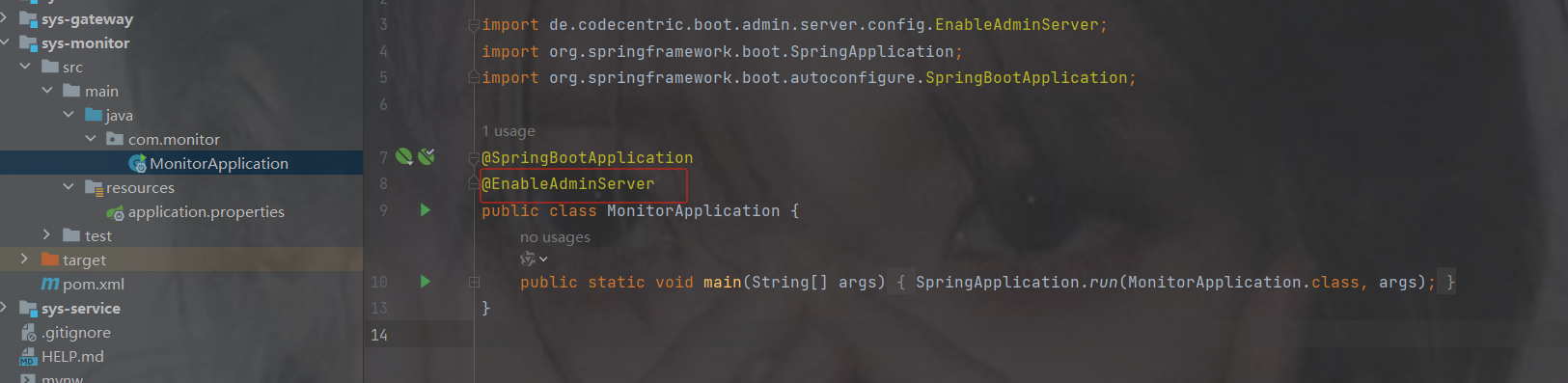

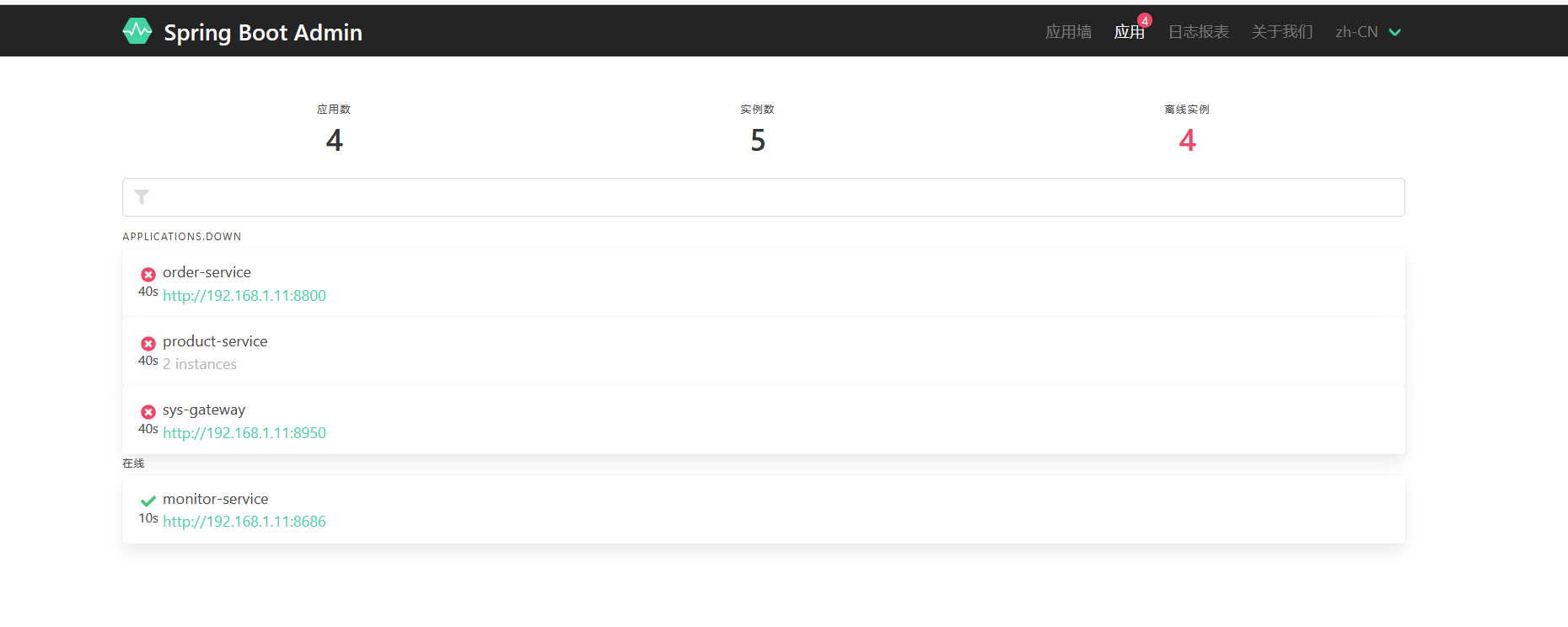

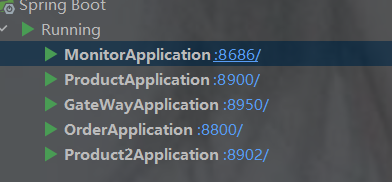

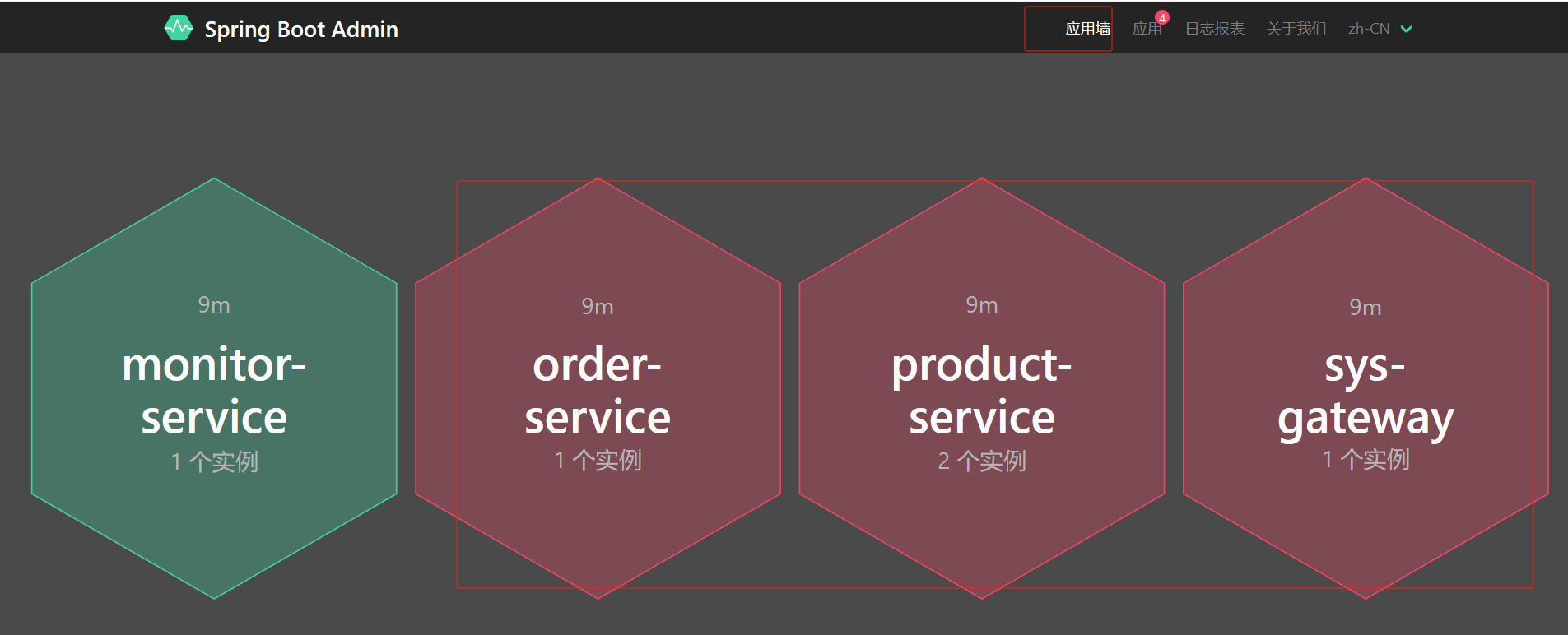

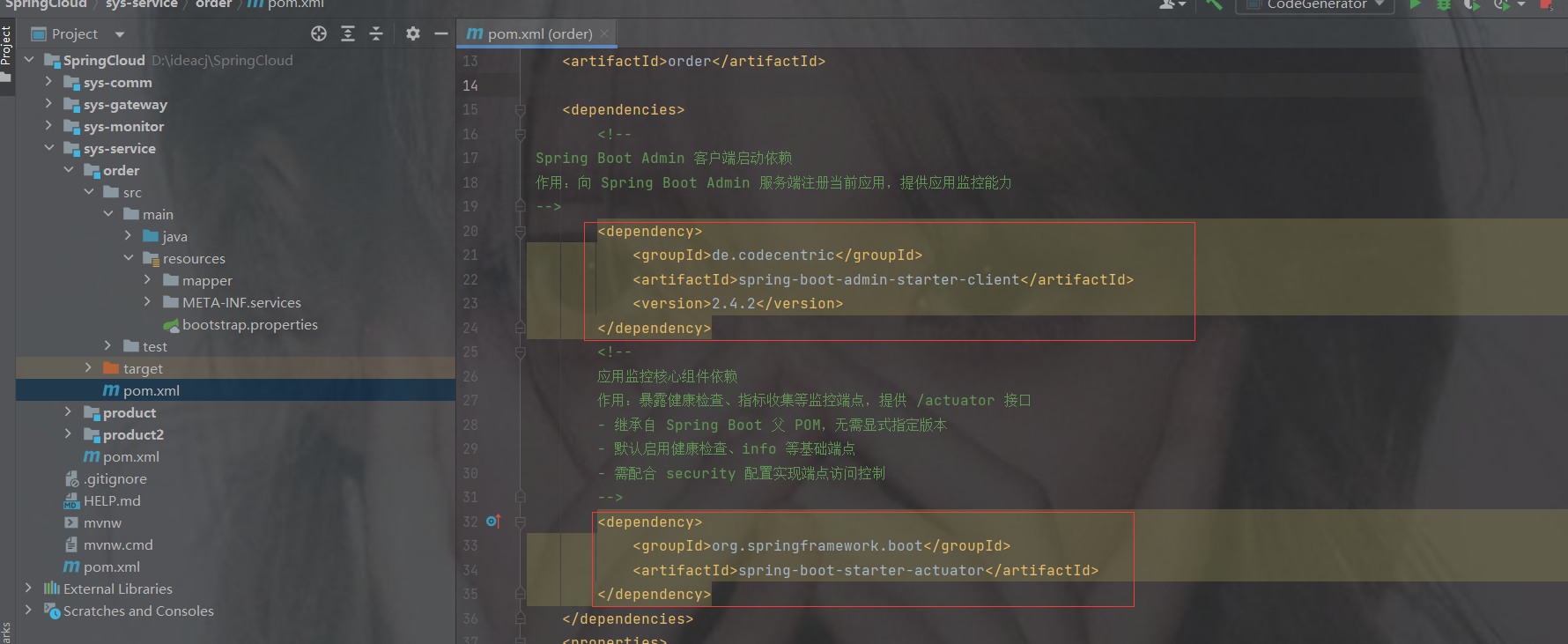

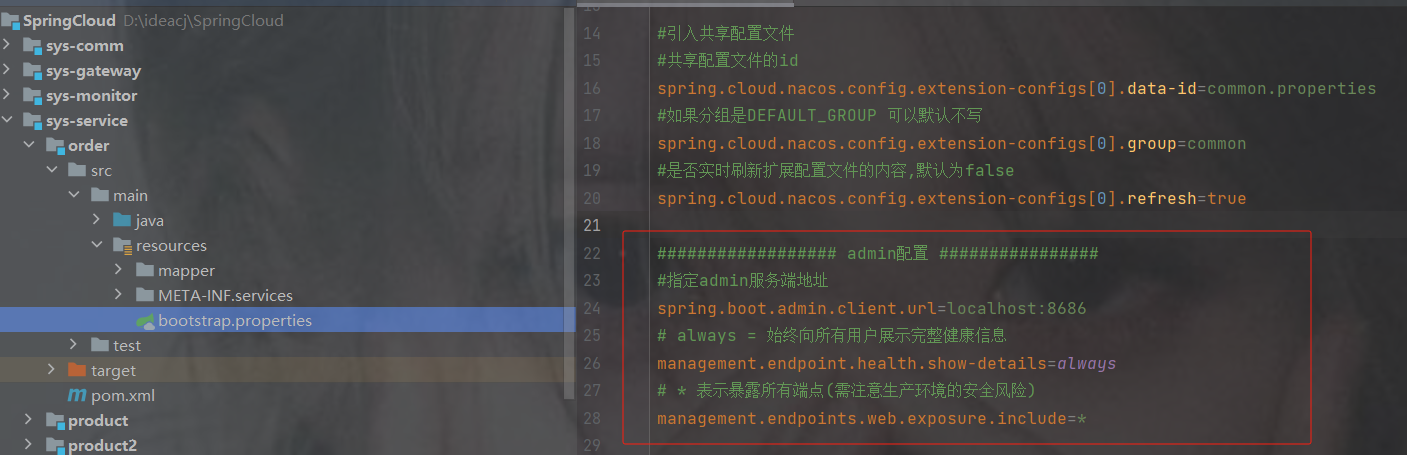

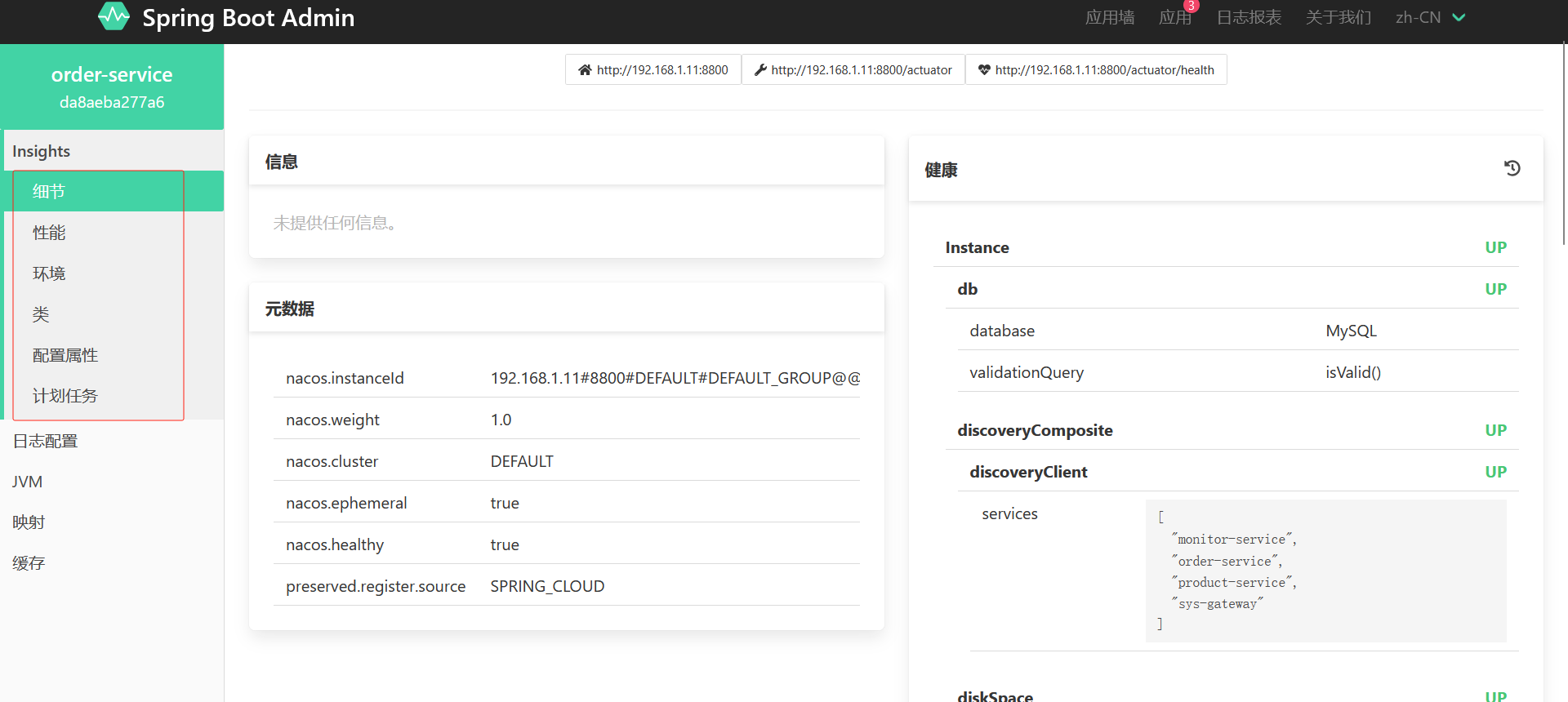

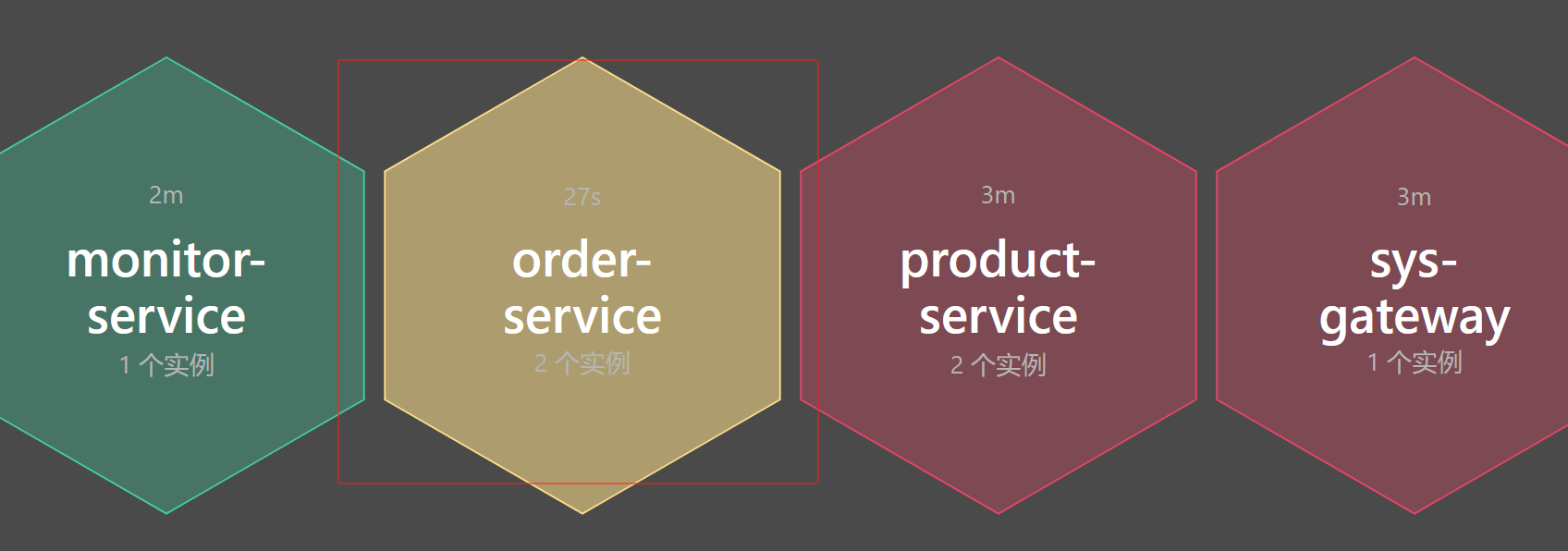

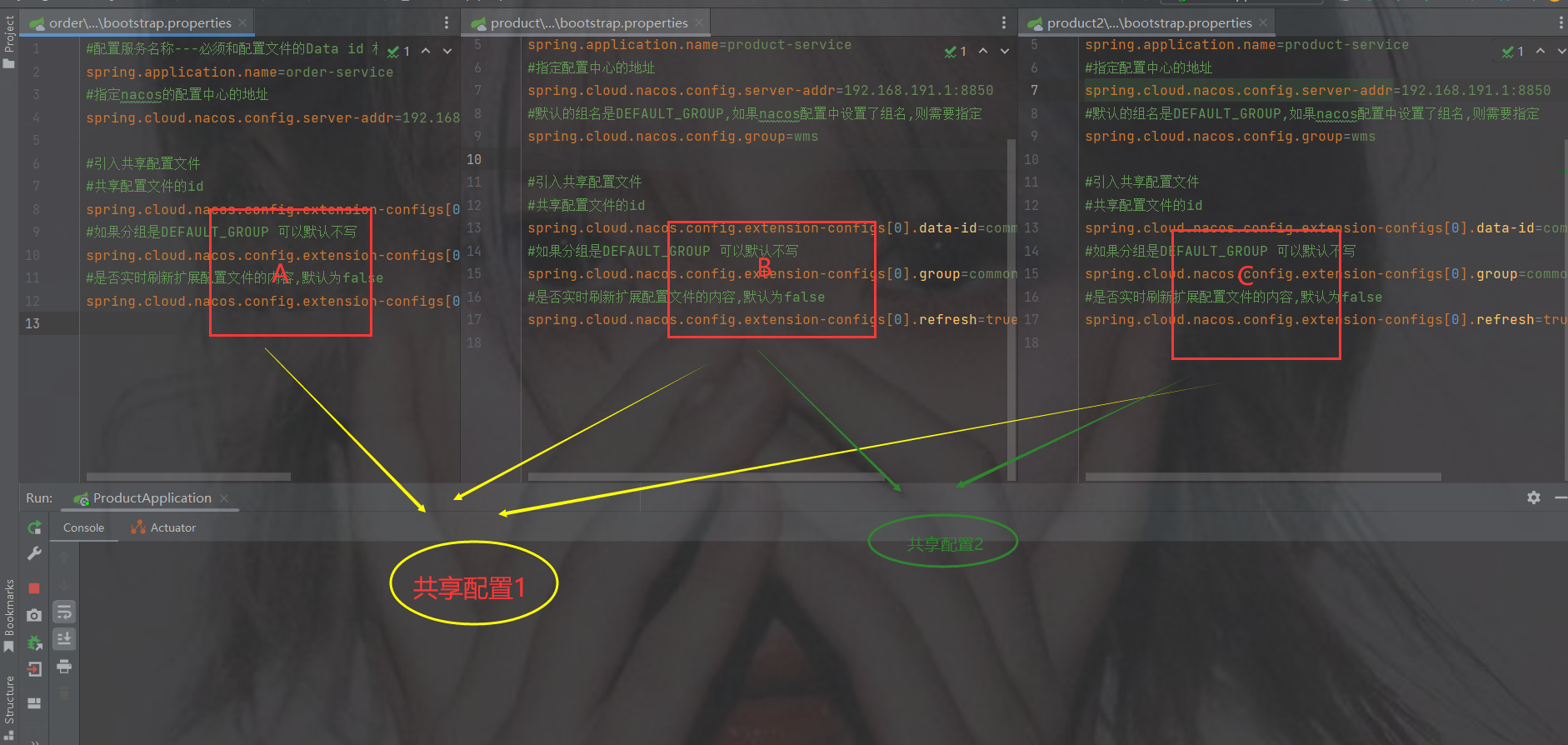

1.图1

红色框起来的是当前微服务自己特有的配置

黄色共享框起来的是共享的配置 ------- 并且是个数组

但是为什么共享配置是数组呢?

2.图2

像下图有可能服务ABC的配置有一样的,那么提取出来是共享配置1

而B和C是一样的配置,可以单独再提取出来为共享配置2

举例:

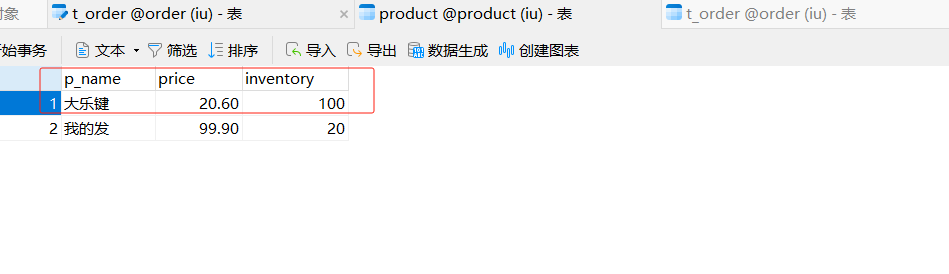

假如两个商品要连接数据库,那么商品的库和订单又不是一样库,此时可以单独把两个商品服务的数据库连接配置提取出来

假如要加入redis,那么服务都是一样的redis,可以共同提取出来reids的配置

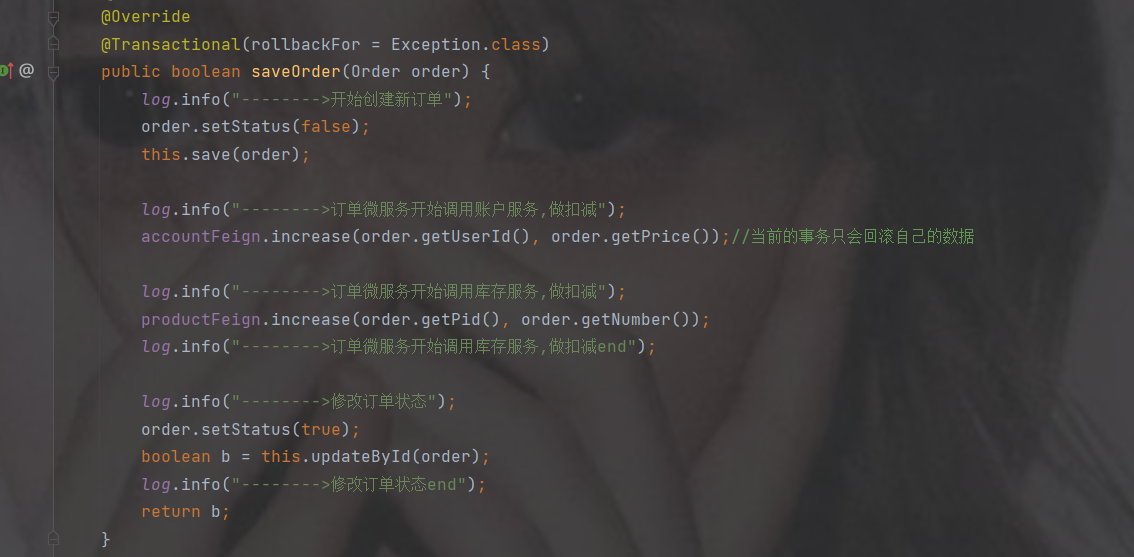

8. 加入其他配置修改代码以及mybatisplus使用

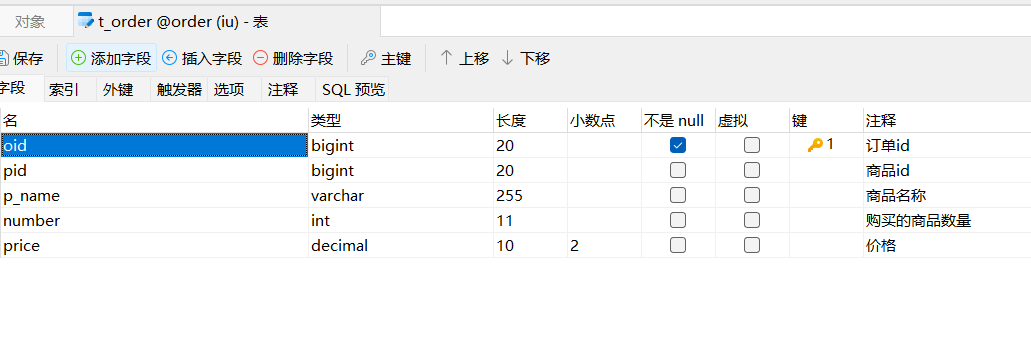

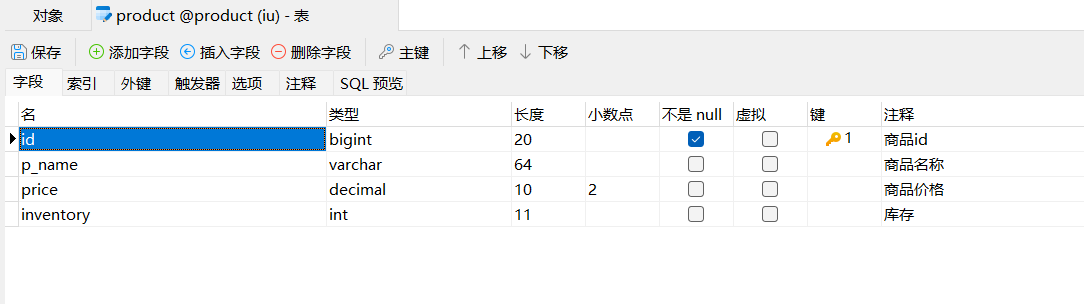

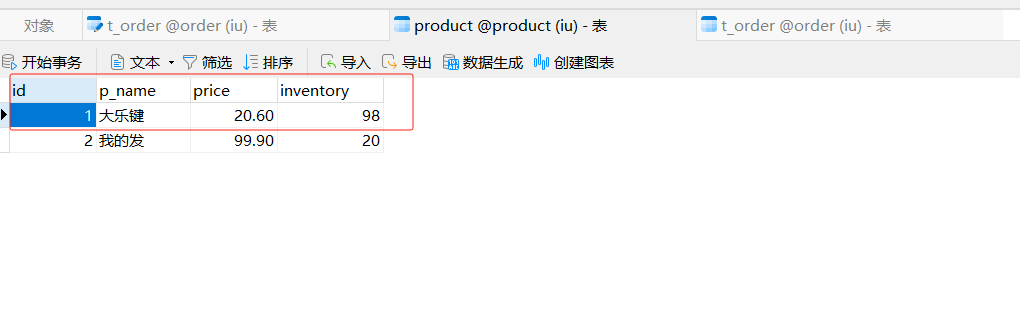

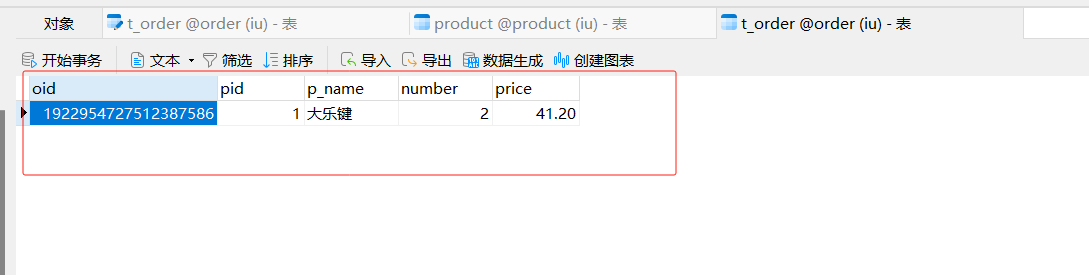

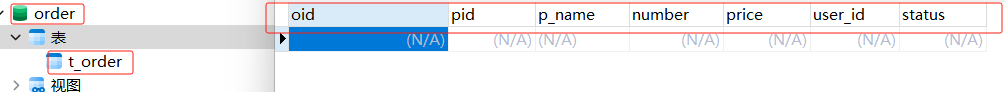

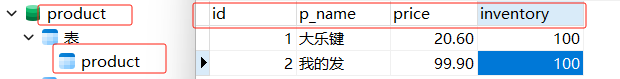

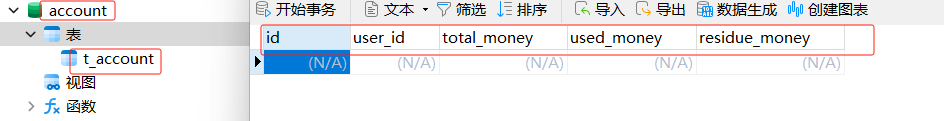

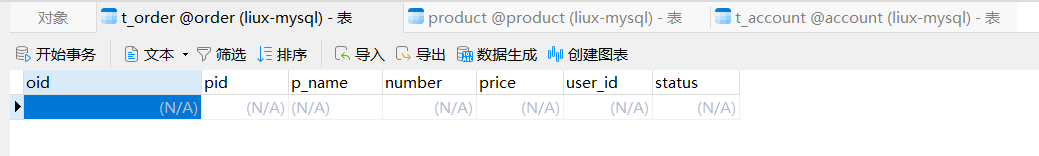

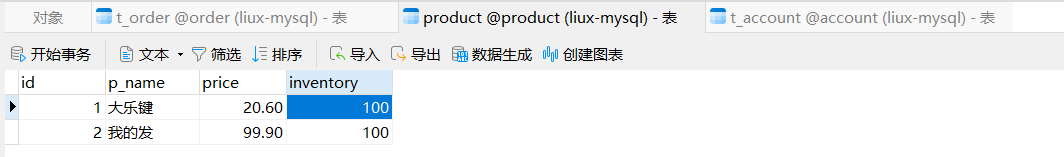

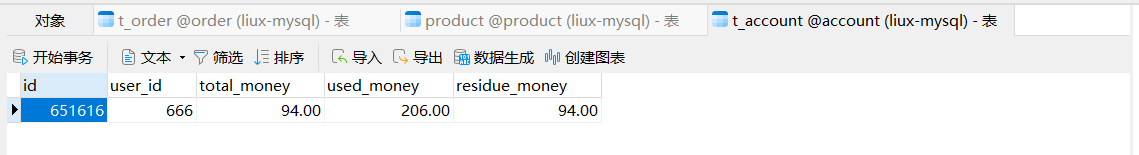

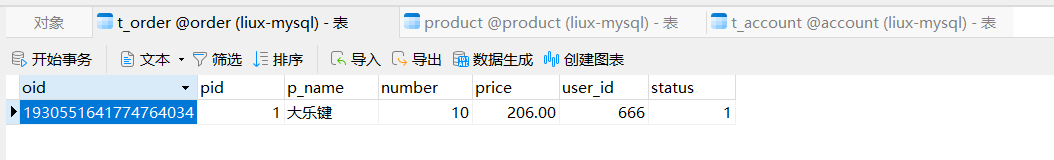

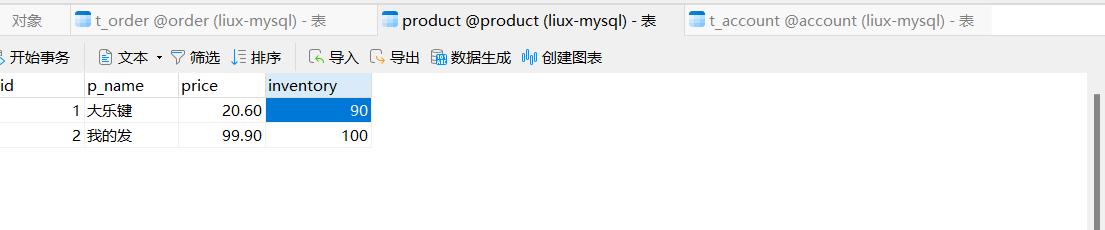

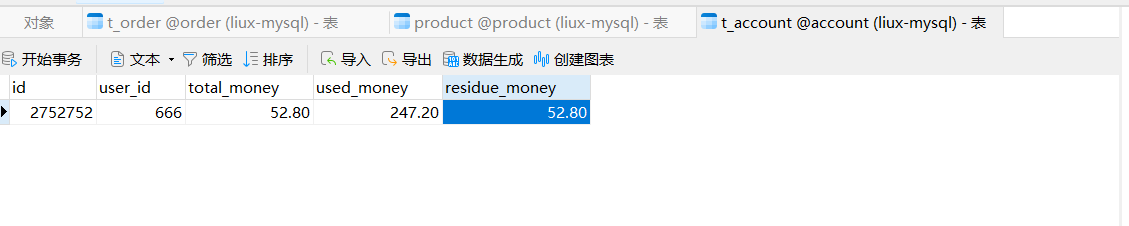

创建两个库,并且设计两张表,注意分库分表了

订单

商品

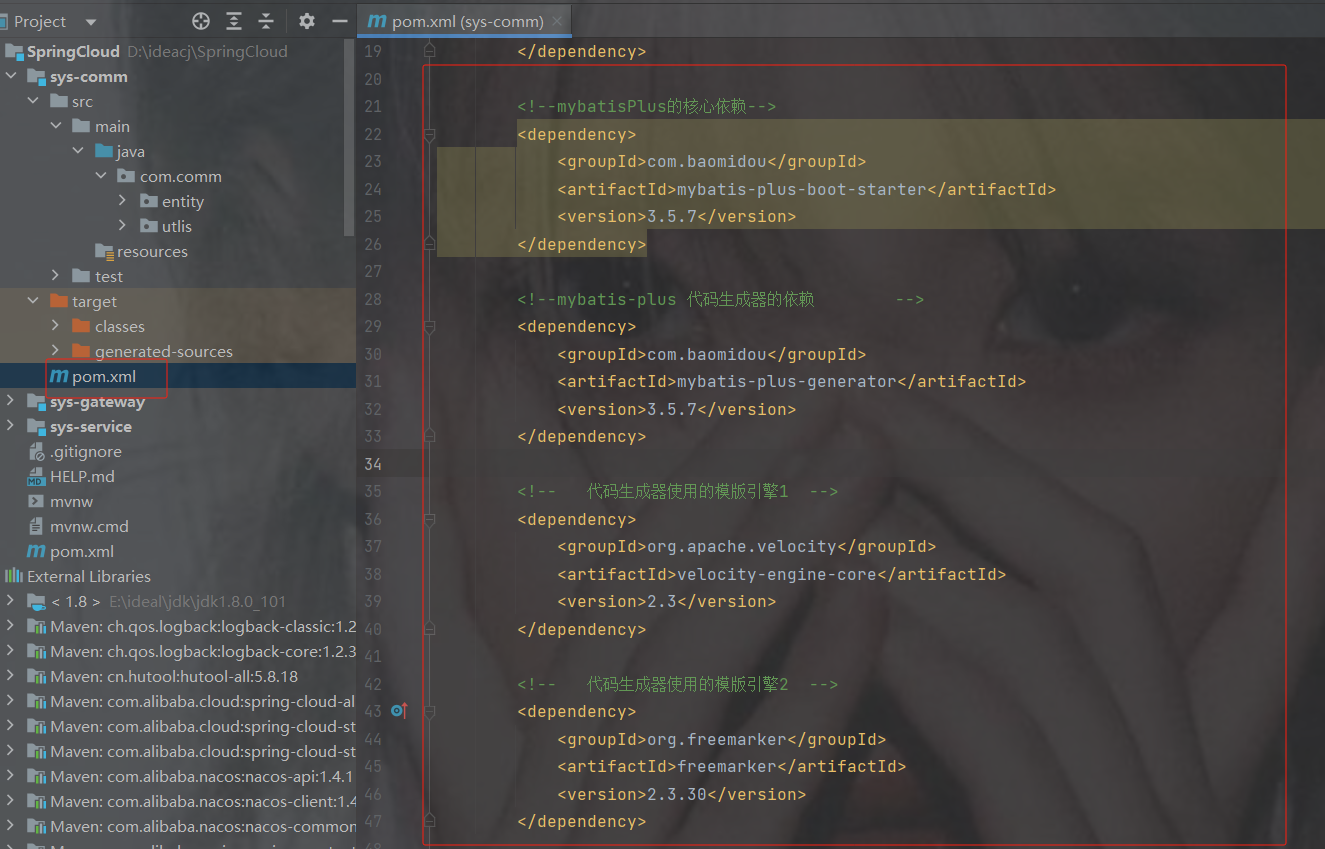

公共模块加依赖

公共模块所有依赖

4.0.0 com.example SpringCloud 0.0.1-SNAPSHOT sys-comm org.projectlombok lombok com.baomidou mybatis-plus-boot-starter 3.5.7 com.baomidou mybatis-plus-generator 3.5.7 org.apache.velocity velocity-engine-core 2.3 org.freemarker freemarker 2.3.30 mysql mysql-connector-java com.spring4all swagger-spring-boot-starter 1.9.1.RELEASE 8 8 UTF-8

使用代码生成器或手写实体类

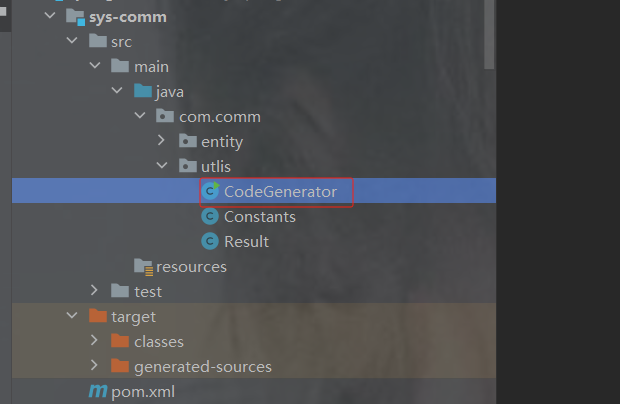

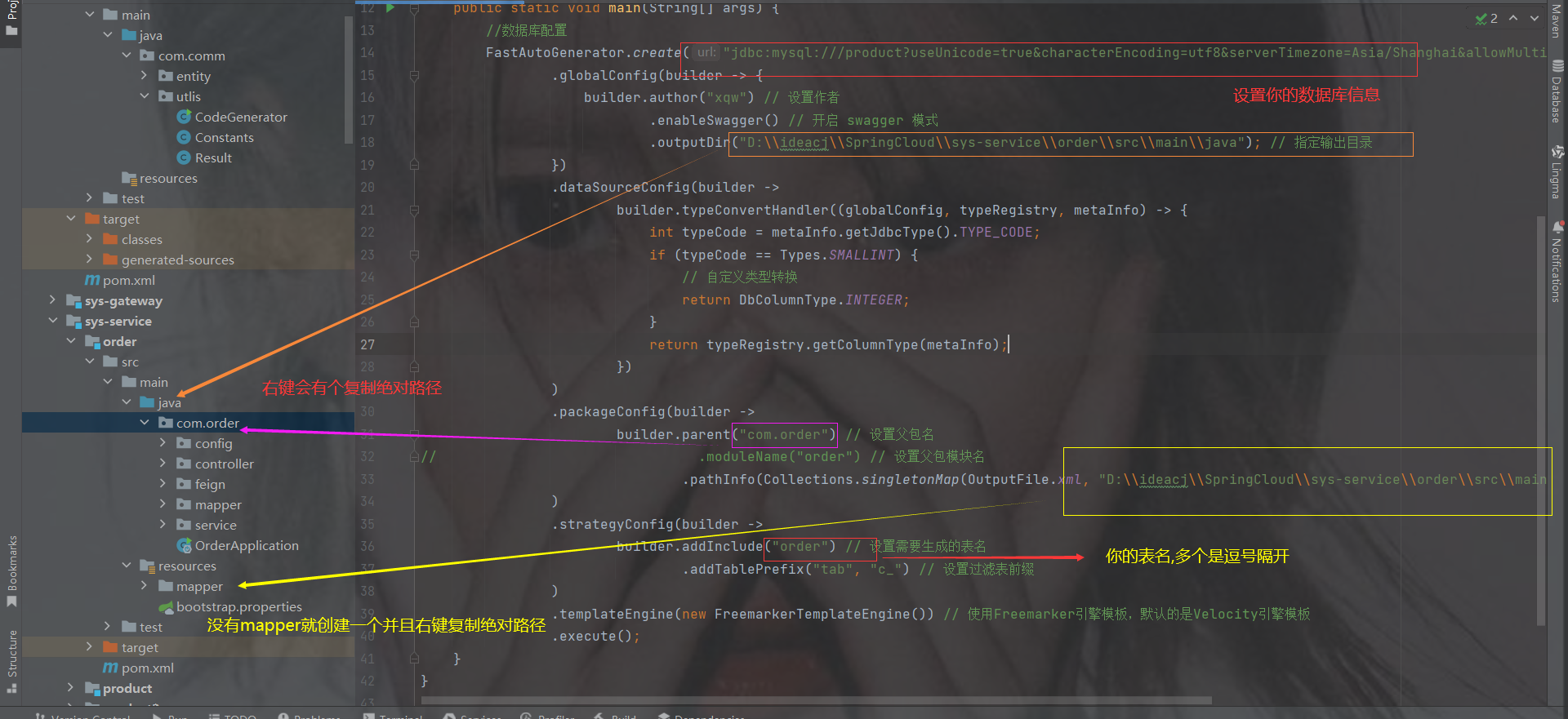

代码生成器

package com.comm.utlis; import com.baomidou.mybatisplus.generator.FastAutoGenerator; import com.baomidou.mybatisplus.generator.config.OutputFile; import com.baomidou.mybatisplus.generator.config.rules.DbColumnType; import com.baomidou.mybatisplus.generator.engine.FreemarkerTemplateEngine; import java.sql.Types; import java.util.Collections; public class CodeGenerator { public static void main(String[] args) { //数据库配置 FastAutoGenerator.create("jdbc:mysql:///product?useUnicode=true&characterEncoding=utf8&serverTimezone=Asia/Shanghai&allowMultiQueries=true","root","a123456") .globalConfig(builder -> { builder.author("xqw") // 设置作者 .enableSwagger() // 开启 swagger 模式 .outputDir("D:\\ideacj\\SpringCloud\\sys-service\\order\\src\\main\\java"); // 指定输出目录 }) .dataSourceConfig(builder -> builder.typeConvertHandler((globalConfig, typeRegistry, metaInfo) -> { int typeCode = metaInfo.getJdbcType().TYPE_CODE; if (typeCode == Types.SMALLINT) { // 自定义类型转换 return DbColumnType.INTEGER; } return typeRegistry.getColumnType(metaInfo); }) ) .packageConfig(builder -> builder.parent("com.order") // 设置父包名 // .moduleName("order") // 设置父包模块名 .pathInfo(Collections.singletonMap(OutputFile.xml, "D:\\ideacj\\SpringCloud\\sys-service\\order\\src\\main\\resources\\mapper")) // 设置mapperXml生成路径 ) .strategyConfig(builder -> builder.addInclude("t_order") // 设置需要生成的表名 .addTablePrefix("tab", "c_") // 设置过滤表前缀 ) .templateEngine(new FreemarkerTemplateEngine()) // 使用Freemarker引擎模板,默认的是Velocity引擎模板 .execute(); } }

实体也会生成在order模块直接拖到公共模块去

剩下两个工具类

package com.comm.utlis; import java.io.Serializable; public class Resultimplements Serializable { private static final long serialVersionUID = 1L; /** 成功 */ public static final int SUCCESS = Constants.SUCCESS; /** 失败 */ public static final int FAIL = Constants.FAIL; private int code; private String msg; private T data; private Long timestamp; public static Result ok() { return restResult(null, SUCCESS, null); } public static Result ok(T data) { return restResult(data, SUCCESS, null); } public static Result ok(T data,long timestamp) { Result r = restResult(data, SUCCESS, null); r.timestamp = timestamp; return r; } public static Result ok(T data, String msg) { return restResult(data, SUCCESS, msg); } public static Result fail() { return restResult(null, FAIL, null); } public static Result fail(String msg) { return restResult(null, FAIL, msg); } public static Result fail(T data) { return restResult(data, FAIL, null); } public static Result fail(T data, String msg) { return restResult(data, FAIL, msg); } public static Result fail(int code, String msg) { return restResult(null, code, msg); } public Long getTimestamp() { return timestamp; } public void setTimestamp(Long timestamp) { this.timestamp = timestamp; } private static Result restResult(T data, int code, String msg) { Result apiResult = new Result<>(); apiResult.setCode(code); apiResult.setData(data); apiResult.setMsg(msg); return apiResult; } public int getCode() { return code; } public void setCode(int code) { this.code = code; } public String getMsg() { return msg; } public void setMsg(String msg) { this.msg = msg; } public T getData() { return data; } public void setData(T data) { this.data = data; } public static Boolean isError(Result ret) { return !isSuccess(ret); } public static Boolean isSuccess(Result ret) { return Result.SUCCESS == ret.getCode(); } } package com.comm.utlis; public class Constants { /** * UTF-8 字符集 */ public static final String UTF8 = "UTF-8"; /** * GBK 字符集 */ public static final String GBK = "GBK"; /** * www主域 */ public static final String WWW = "www."; /** * RMI 远程方法调用 */ public static final String LOOKUP_RMI = "rmi:"; /** * LDAP 远程方法调用 */ public static final String LOOKUP_LDAP = "ldap:"; /** * LDAPS 远程方法调用 */ public static final String LOOKUP_LDAPS = "ldaps:"; /** * http请求 */ public static final String HTTP = "http://"; /** * https请求 */ public static final String HTTPS = "https://"; /** * 成功标记 */ public static final Integer SUCCESS = 200; /** * 失败标记 */ public static final Integer FAIL = 500; /** * 登录成功状态 */ public static final String LOGIN_SUCCESS_STATUS = "0"; /** * 登录失败状态 */ public static final String LOGIN_FAIL_STATUS = "1"; /** * 登录成功 */ public static final String LOGIN_SUCCESS = "Success"; /** * 注销 */ public static final String LOGOUT = "Logout"; /** * 注册 */ public static final String REGISTER = "Register"; /** * 注销 */ public static final String LOGOFF = "Logoff"; /** * 登录失败 */ public static final String LOGIN_FAIL = "Error"; /** * 当前记录起始索引 */ public static final String PAGE_NUM = "pageNum"; /** * 每页显示记录数 */ public static final String PAGE_SIZE = "pageSize"; /** * 排序列 */ public static final String ORDER_BY_COLUMN = "orderByColumn"; /** * 排序的方向 "desc" 或者 "asc". */ public static final String IS_ASC = "isAsc"; /** * 验证码有效期(分钟) */ public static final long CAPTCHA_EXPIRATION = 2; /** * 资源映射路径 前缀 */ public static final String RESOURCE_PREFIX = "/profile"; /** * 自动识别json对象白名单配置(仅允许解析的包名,范围越小越安全) */ public static final String[] JSON_WHITELIST_STR = { "org.springframework", "com.ruoyi" }; /** * 定时任务白名单配置(仅允许访问的包名,如其他需要可以自行添加) */ public static final String[] JOB_WHITELIST_STR = { "com.ruoyi" }; /** * 定时任务违规的字符 */ public static final String[] JOB_ERROR_STR = { "java.net.URL", "javax.naming.InitialContext", "org.yaml.snakeyaml", "org.springframework", "org.apache", "com.ruoyi.common.core.utils.file" }; }

订单和商品实体

package com.comm.entity; import com.baomidou.mybatisplus.annotation.TableId; import java.io.Serializable; import java.math.BigDecimal; import io.swagger.annotations.ApiModel; import io.swagger.annotations.ApiModelProperty; /** ** *

* * @author xqw * @since 2025-04-30 */ @ApiModel(value = "Order对象", description = "") @NoArgsConstructor @AllArgsConstructor //实体与表名不一致使用此注解 @TableName(value="t_order") public class Order implements Serializable { private static final long serialVersionUID = 1L; @ApiModelProperty("订单id") @TableId("oid") private Long oid; @ApiModelProperty("商品id") private Long pid; @ApiModelProperty("商品名称") private String pName; @ApiModelProperty("购买的商品数量") private Integer number; @ApiModelProperty("价格") private BigDecimal price; public Long getOid() { return oid; } public void setOid(Long oid) { this.oid = oid; } public Long getPid() { return pid; } public void setPid(Long pid) { this.pid = pid; } public String getpName() { return pName; } public void setpName(String pName) { this.pName = pName; } public Integer getNumber() { return number; } public void setNumber(Integer number) { this.number = number; } public BigDecimal getPrice() { return price; } public void setPrice(BigDecimal price) { this.price = price; } @Override public String toString() { return "Order{" + "oid = " + oid + ", pid = " + pid + ", pName = " + pName + ", number = " + number + ", price = " + price + "}"; } }package com.comm.entity; import java.io.Serializable; import java.math.BigDecimal; import io.swagger.annotations.ApiModel; import io.swagger.annotations.ApiModelProperty; /** ** *

* * @author xqw * @since 2025-04-30 */ @ApiModel(value = "Product对象", description = "") @NoArgsConstructor @AllArgsConstructor @TableName("product") // 确保注解值与实际表名一致 public class Product implements Serializable { private static final long serialVersionUID = 1L; @ApiModelProperty("商品id") private Long id; @ApiModelProperty("商品名称") private String pName; @ApiModelProperty("商品价格") private BigDecimal price; @ApiModelProperty("库存") private Integer inventory; public Long getId() { return id; } public void setId(Long id) { this.id = id; } public String getpName() { return pName; } public void setpName(String pName) { this.pName = pName; } public BigDecimal getPrice() { return price; } public void setPrice(BigDecimal price) { this.price = price; } public Integer getInventory() { return inventory; } public void setInventory(Integer inventory) { this.inventory = inventory; } @Override public String toString() { return "Product{" + "id = " + id + ", pName = " + pName + ", price = " + price + ", inventory = " + inventory + "}"; } }

但是先把父类的依赖发出来,因为两个模块都是用的service的,看看有没有缺少

完整依赖

4.0.0 com.example SpringCloud 0.0.1-SNAPSHOT sys-service pom order product product2 org.springframework.boot spring-boot-starter-web com.example sys-comm 0.0.1-SNAPSHOT com.alibaba.cloud spring-cloud-starter-alibaba-nacos-discovery org.springframework.cloud spring-cloud-starter-loadbalancer org.springframework.cloud spring-cloud-starter-openfeign com.alibaba.cloud spring-cloud-starter-alibaba-nacos-config org.springframework.cloud spring-cloud-starter-bootstrap 8 8 UTF-8

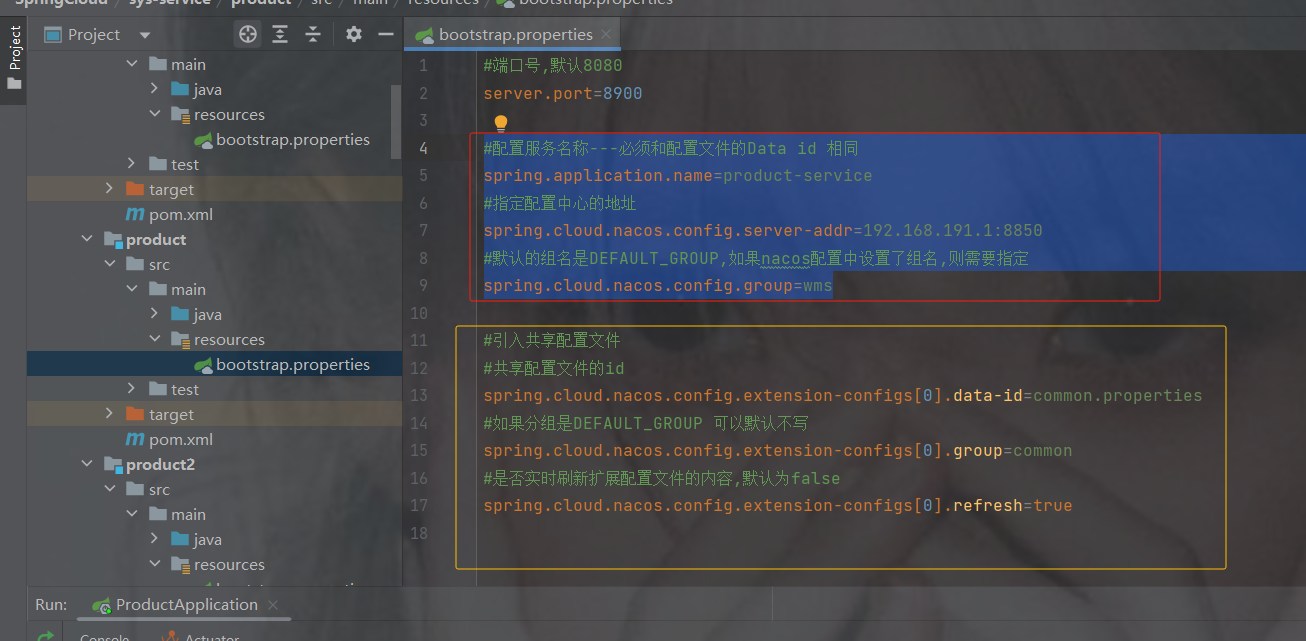

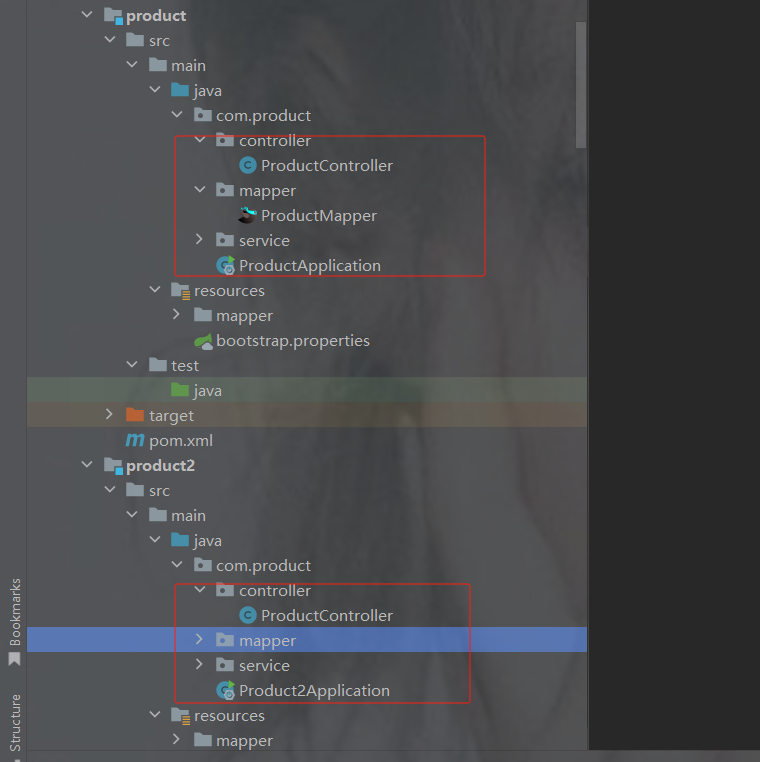

此时订单服务以及商品服务要加@MapperScan和数据库配置,因为公共模块引入了mysql依赖

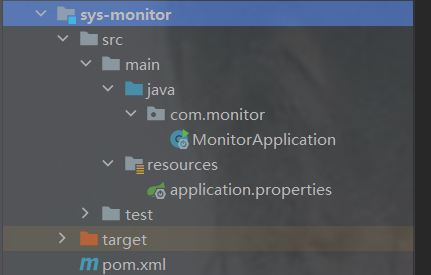

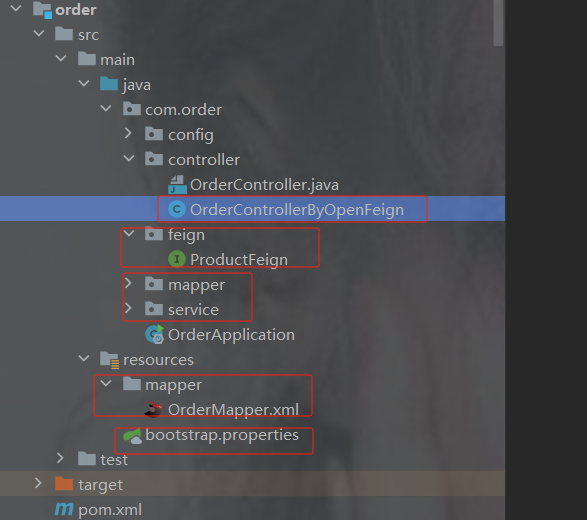

订单项目结构

service以及mapper就不发了,因为是mp生成的,config是之前restTemplate的但是被openfeign替代了

bootstrap配置

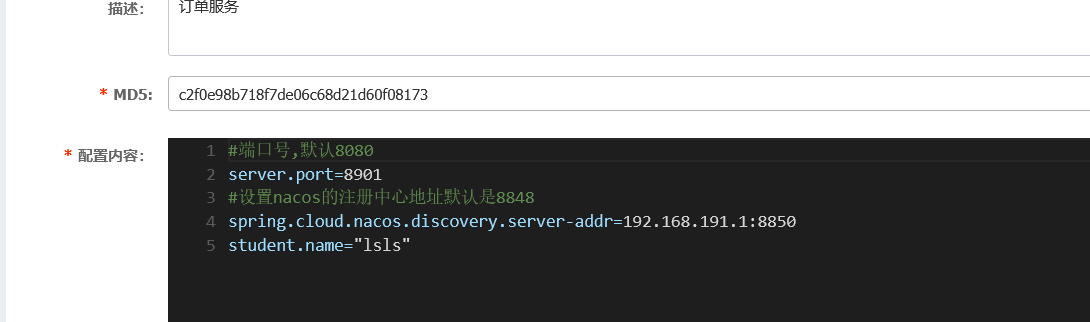

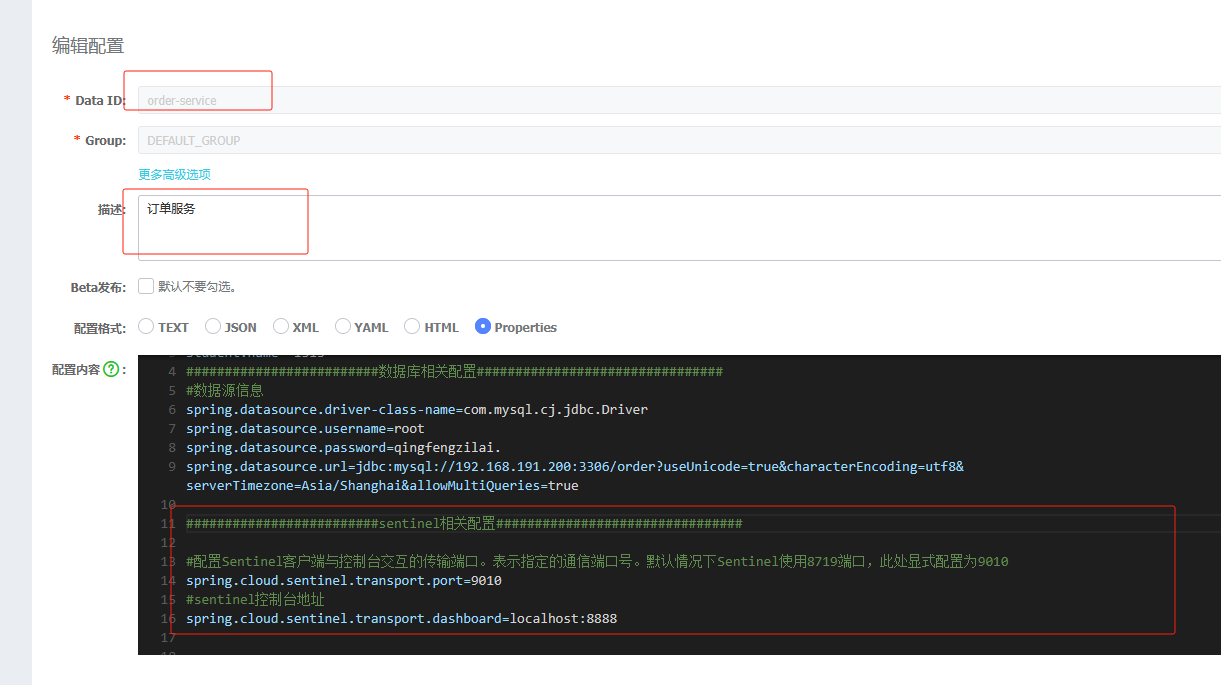

#配置服务名称---必须和配置文件的Data id 相同 spring.application.name=order-service #指定nacos的配置中心的地址 spring.cloud.nacos.config.server-addr=192.168.191.1:8850 #引入共享配置文件 #共享配置文件的id spring.cloud.nacos.config.extension-configs[0].data-id=common.properties #如果分组是DEFAULT_GROUP 可以默认不写 spring.cloud.nacos.config.extension-configs[0].group=common #是否实时刷新扩展配置文件的内容,默认为false spring.cloud.nacos.config.extension-configs[0].refresh=trueorder的专属nacos配置,注意是专属,商品的跟订单order的分库了

#端口号,默认8080 server.port=8901 student.name="lsls" #########################数据库相关配置################################ #数据源信息 spring.datasource.driver-class-name=com.mysql.cj.jdbc.Driver spring.datasource.username=root spring.datasource.password=a123456 spring.datasource.url=jdbc:mysql://localhost:3306/order?useUnicode=true&characterEncoding=utf8&serverTimezone=Asia/Shanghai&allowMultiQueries=true共享配置,只发一次,在商品里就不发了

#设置nacos的注册中心地址默认是8848 spring.cloud.nacos.discovery.server-addr=localhost:8850 #########################mybatis相关配置################################ #mybatis指定映射文件所在的路径 mybatis.mapper-locations=classpath:/mapper/*.xml ###########################mybatis-plus的依赖############################### #sql日志--控制台 mybatis-plus.configuration.log-impl=org.apache.ibatis.logging.stdout.StdOutImpl主启动类以及注解,注意加MapperScan

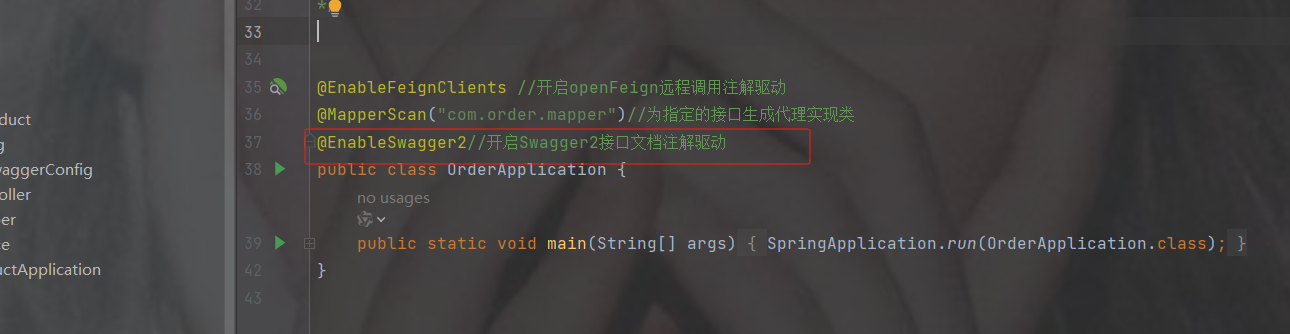

package com.order; //import com.order.config.LoadBalancerConfig; import org.mybatis.spring.annotation.MapperScan; import org.springframework.boot.SpringApplication; import org.springframework.boot.autoconfigure.SpringBootApplication; import org.springframework.cloud.client.discovery.EnableDiscoveryClient; import org.springframework.cloud.loadbalancer.annotation.LoadBalancerClient; import org.springframework.cloud.loadbalancer.annotation.LoadBalancerClients; import org.springframework.cloud.openfeign.EnableFeignClients; @SpringBootApplication @EnableDiscoveryClient //表示被nacos注册中心发现,注册时使用的注解 @EnableFeignClients //开启openFeign远程调用注解驱动 @MapperScan("com.order.mapper")//为指定的接口生成代理实现类 public class OrderApplication { public static void main(String[] args) { SpringApplication.run(OrderApplication.class); } }feign

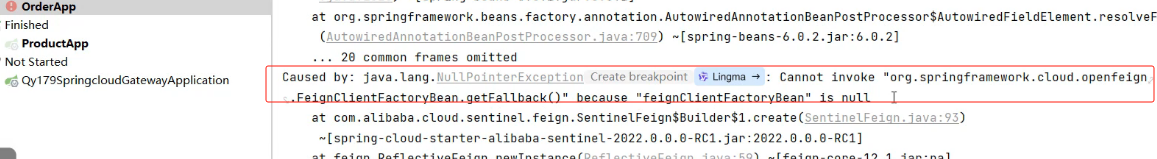

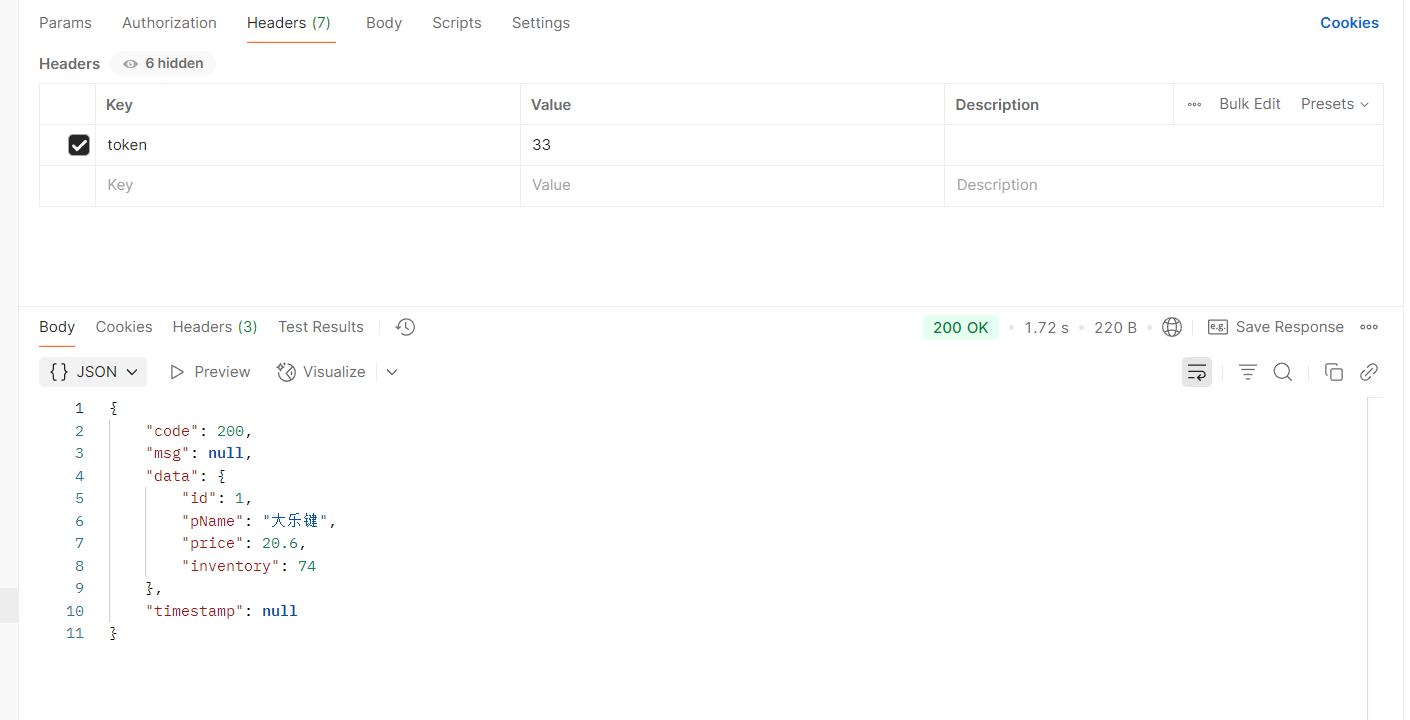

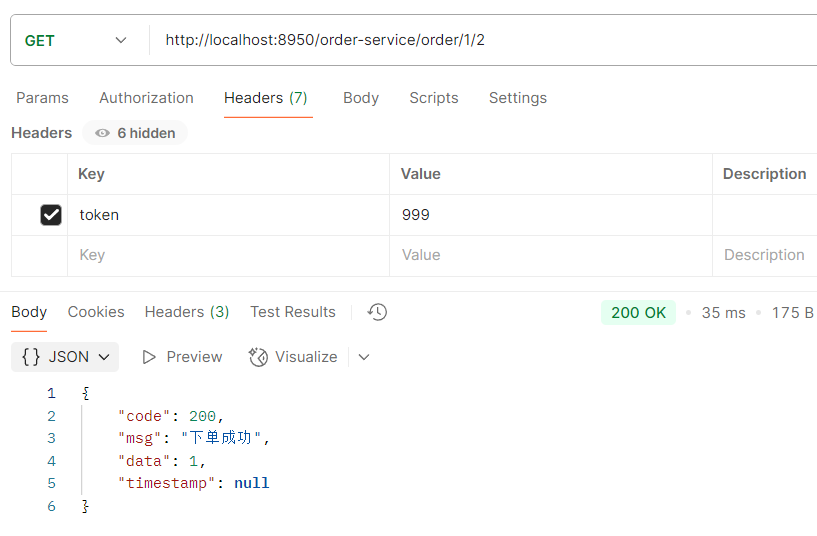

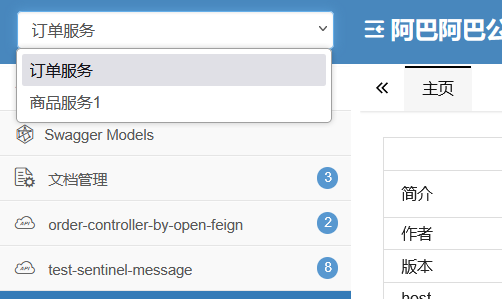

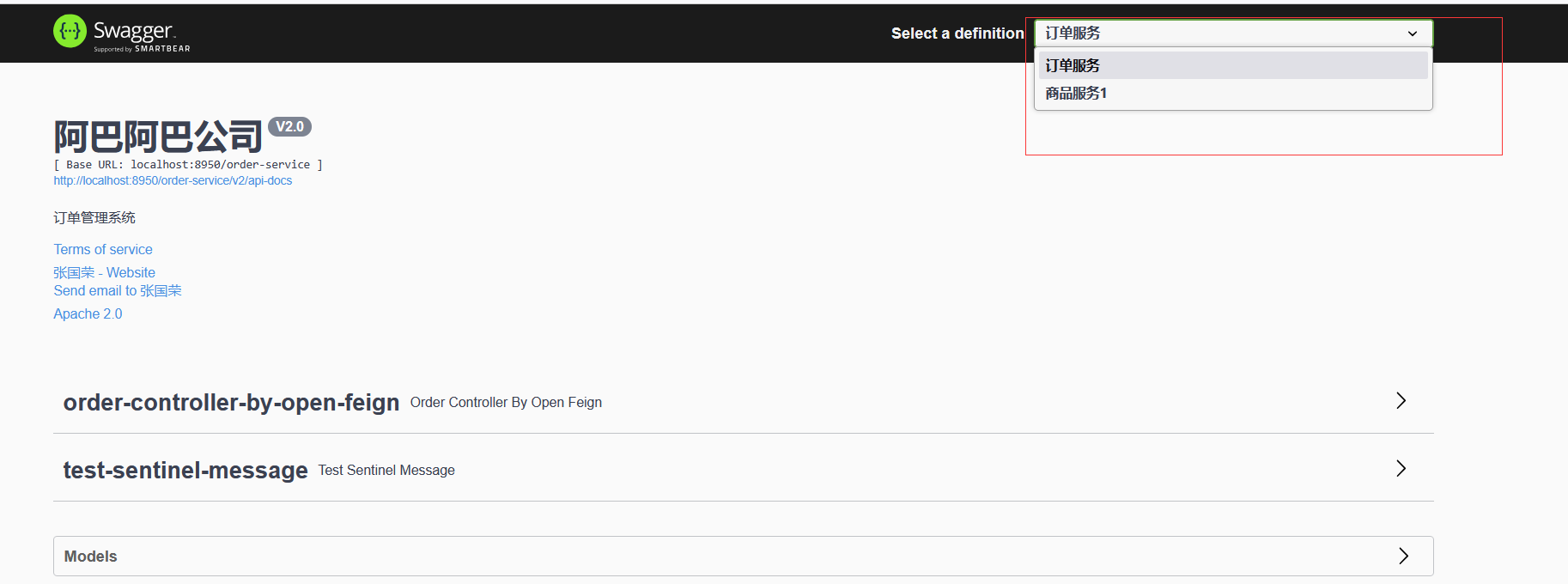

package com.order.feign; import com.comm.entity.Product; import com.comm.utlis.Result; import org.springframework.cloud.openfeign.FeignClient; import org.springframework.web.bind.annotation.GetMapping; import org.springframework.web.bind.annotation.PathVariable; import org.springframework.web.bind.annotation.PutMapping; import org.springframework.web.bind.annotation.RequestBody; //@FeignClient(value="服务提供者的名称") @FeignClient(value = "product-service") public interface ProductFeign { @GetMapping("product/{id}") //方法名和@GetMapping路径必须和提供者一致 public Result getProductById(@PathVariable Integer id); //修改商品 @PutMapping("product") public Result updateProduct(@RequestBody Product product); }controller

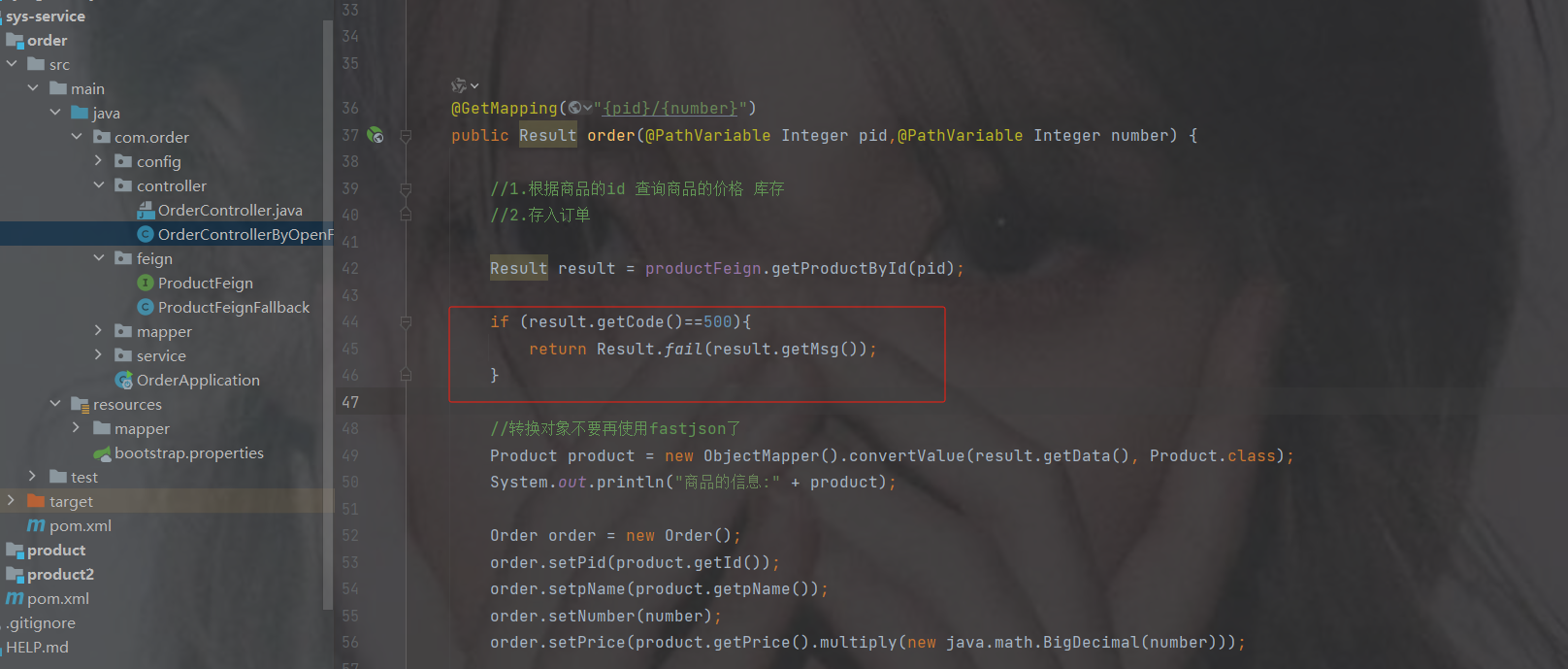

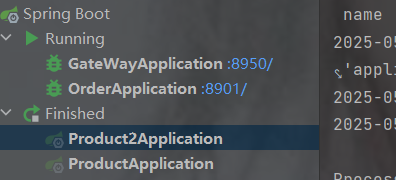

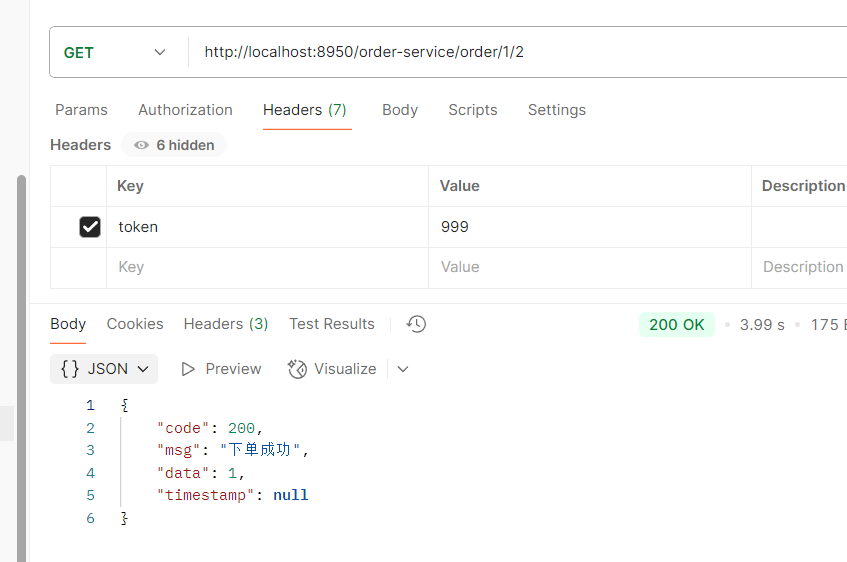

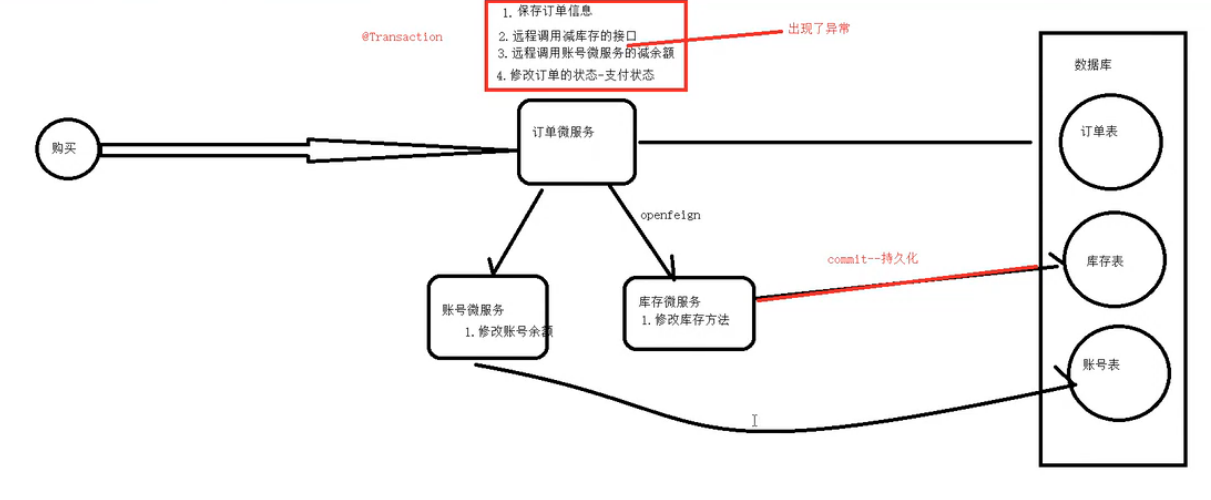

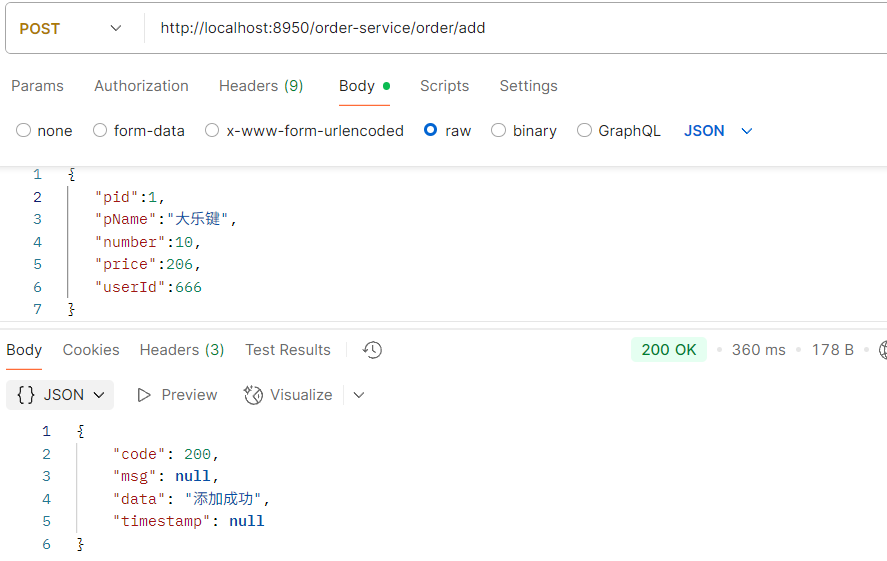

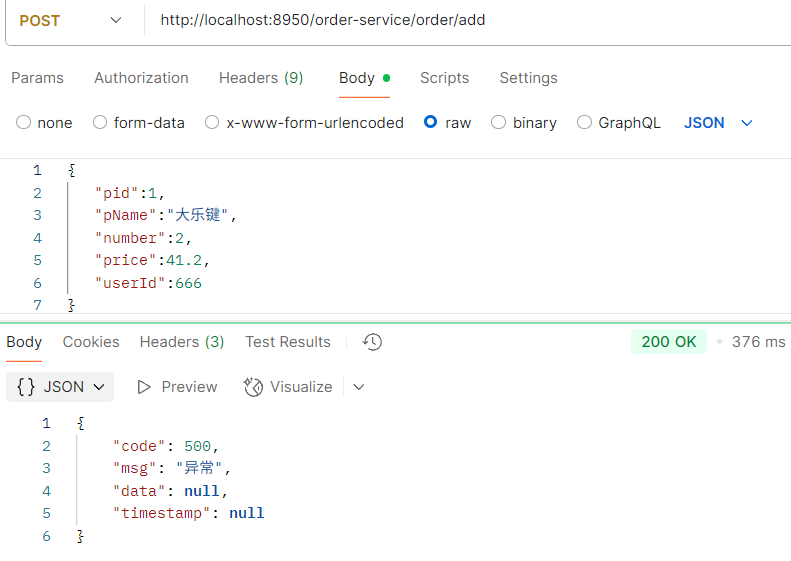

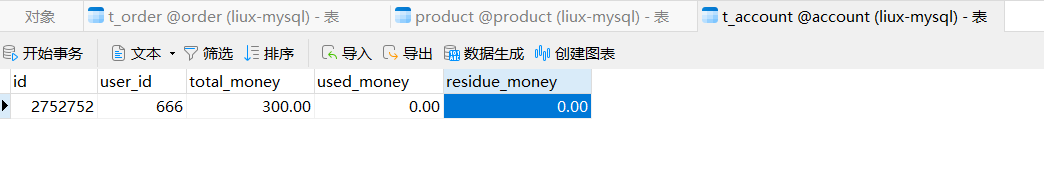

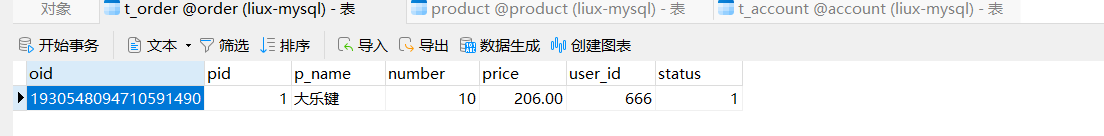

package com.order.controller; import com.comm.entity.Order; import com.comm.entity.Product; import com.comm.utlis.Result; import com.fasterxml.jackson.databind.ObjectMapper; import com.order.feign.ProductFeign; import com.order.service.IOrderService; import org.springframework.beans.factory.annotation.Autowired; import org.springframework.beans.factory.annotation.Value; import org.springframework.cloud.client.ServiceInstance; import org.springframework.cloud.context.config.annotation.RefreshScope; import org.springframework.web.bind.annotation.GetMapping; import org.springframework.web.bind.annotation.PathVariable; import org.springframework.web.bind.annotation.RequestMapping; import org.springframework.web.bind.annotation.RestController; import java.util.List; import java.util.Random; import java.util.UUID; @RestController @RequestMapping("/order") @RefreshScope //表示实时刷新配置内容 public class OrderControllerByOpenFeign { // 远程调用调用接口 @Autowired private ProductFeign productFeign; //spring启动时会为使用@FeignClient注解的接口创建代理实现类 @Autowired private IOrderService orderService; @GetMapping("{pid}/{number}") public Result order(@PathVariable Integer pid,@PathVariable Integer number) { //1.根据商品的id 查询商品的价格 库存 //2.存入订单 Result result = productFeign.getProductById(pid); //转换对象不要再使用fastjson了 Product product = new ObjectMapper().convertValue(result.getData(), Product.class); System.out.println("商品的信息:" + product); Order order = new Order(); order.setPid(product.getId()); order.setpName(product.getpName()); order.setNumber(number); order.setPrice(product.getPrice().multiply(new java.math.BigDecimal(number))); //存入订单 orderService.save(order); //更新库存 product.setInventory(product.getInventory() - number); productFeign.updateProduct(product); return Result.ok(product); } @Value("${student.name}") private String name; @GetMapping("/name") public String name() { return "名字是~~~~~~~:" + name; } }

商品目录结构

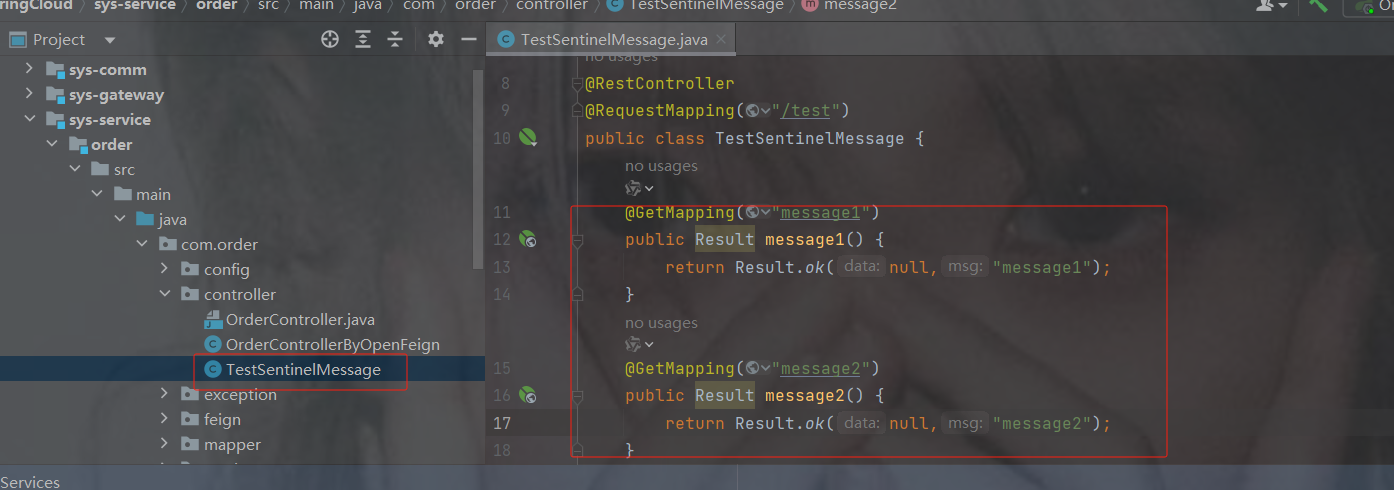

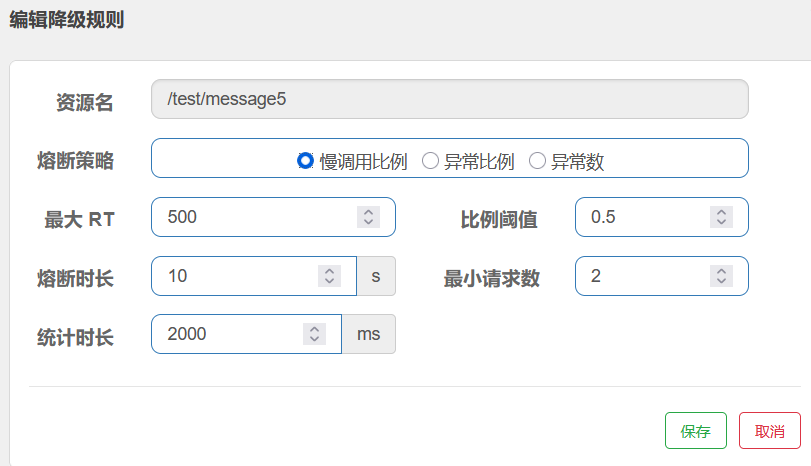

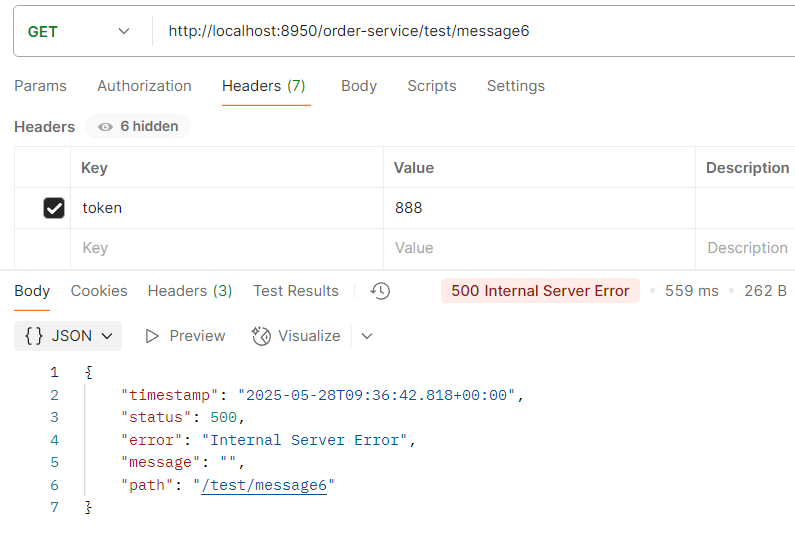

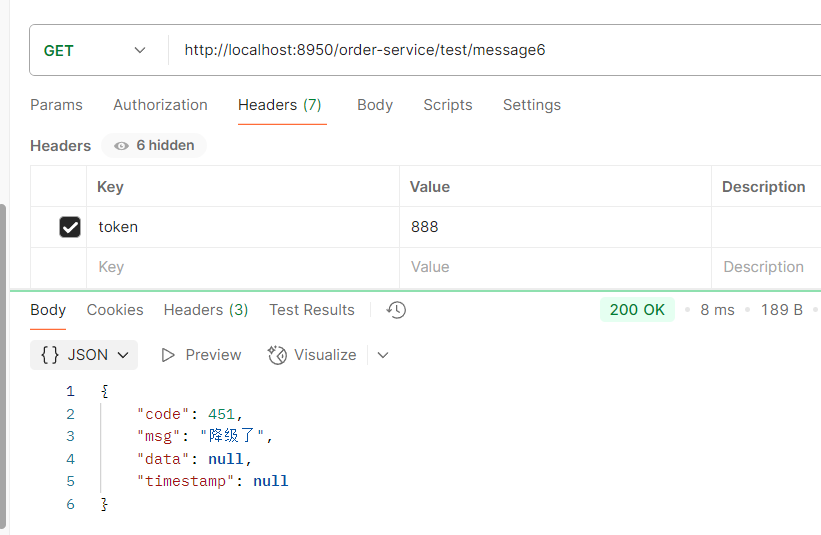

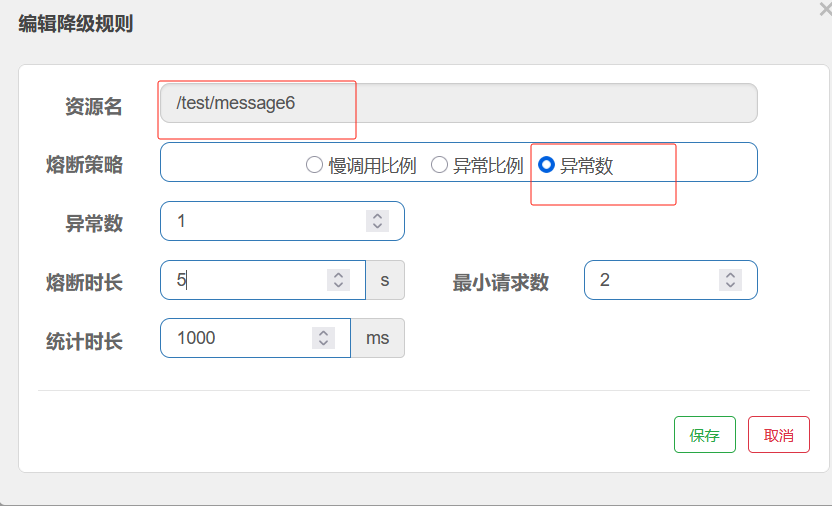

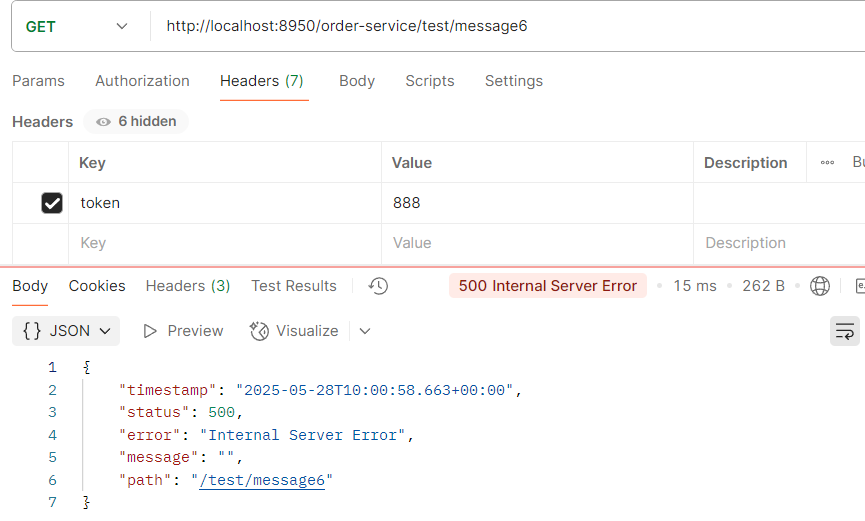

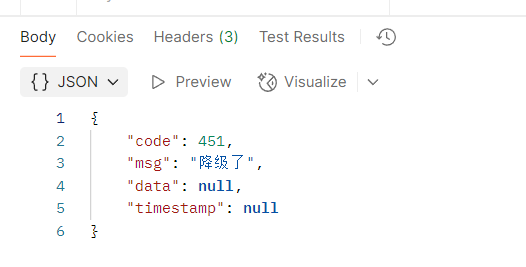

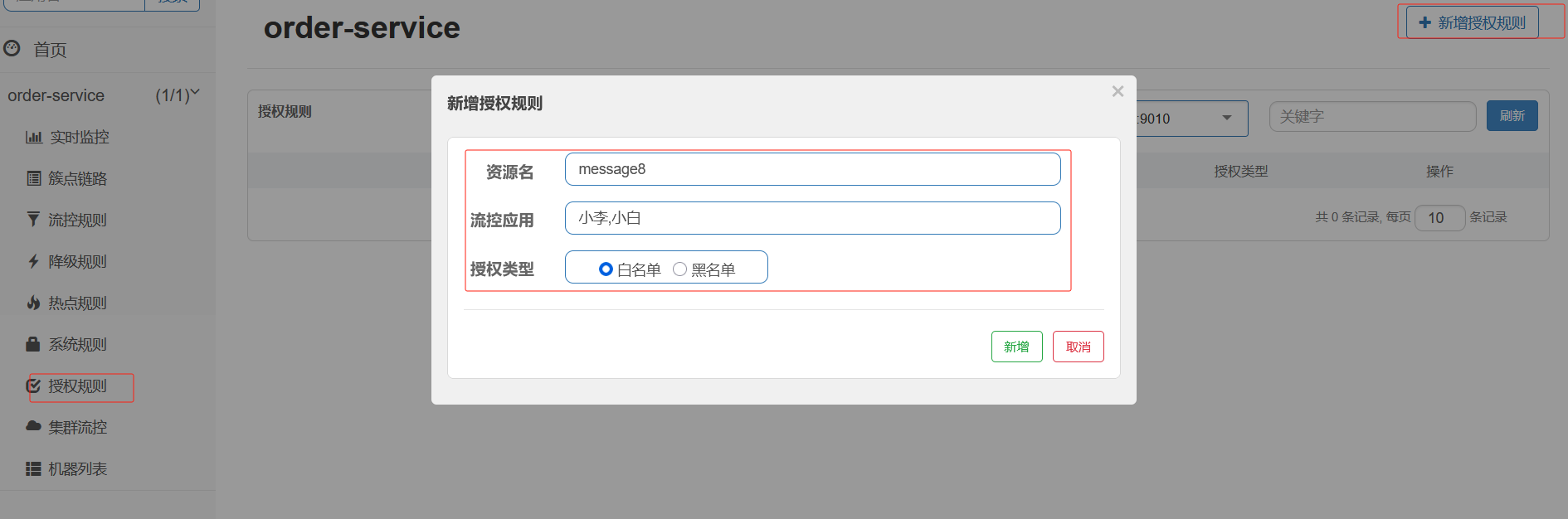

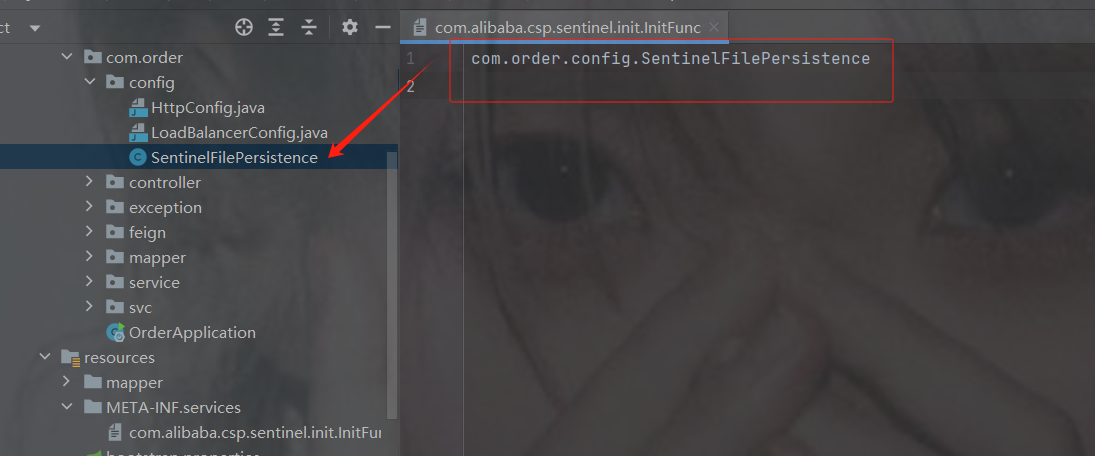

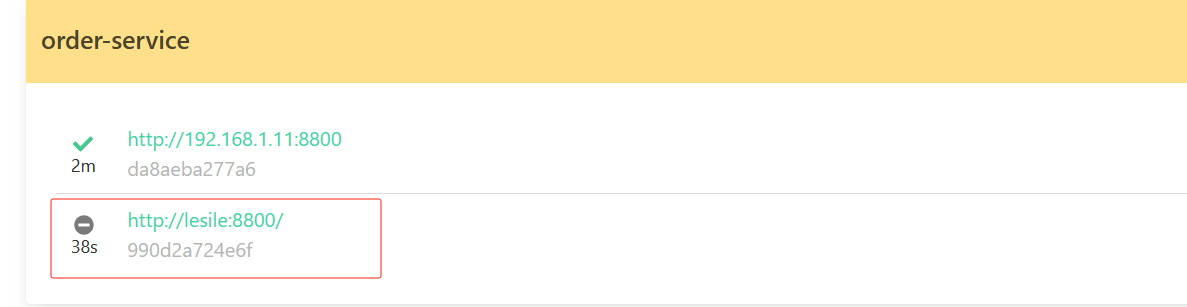

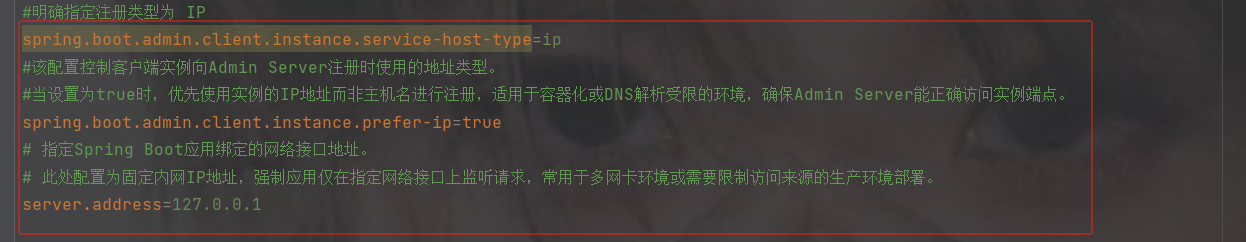

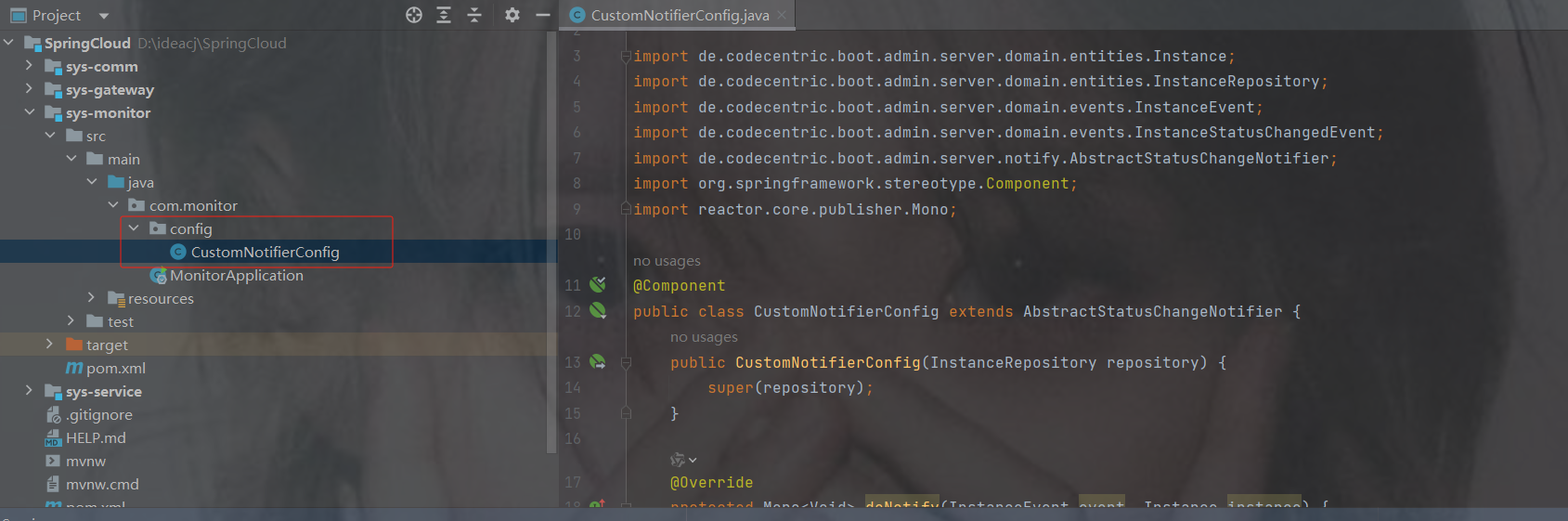

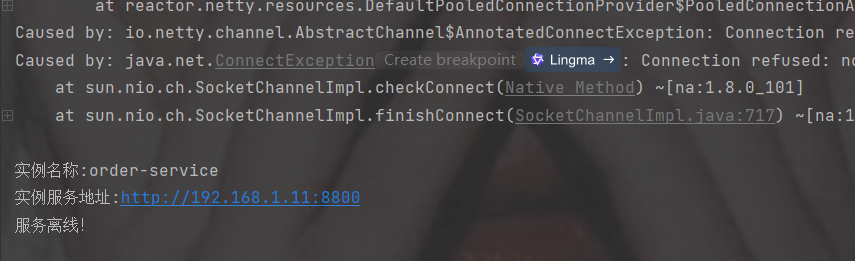

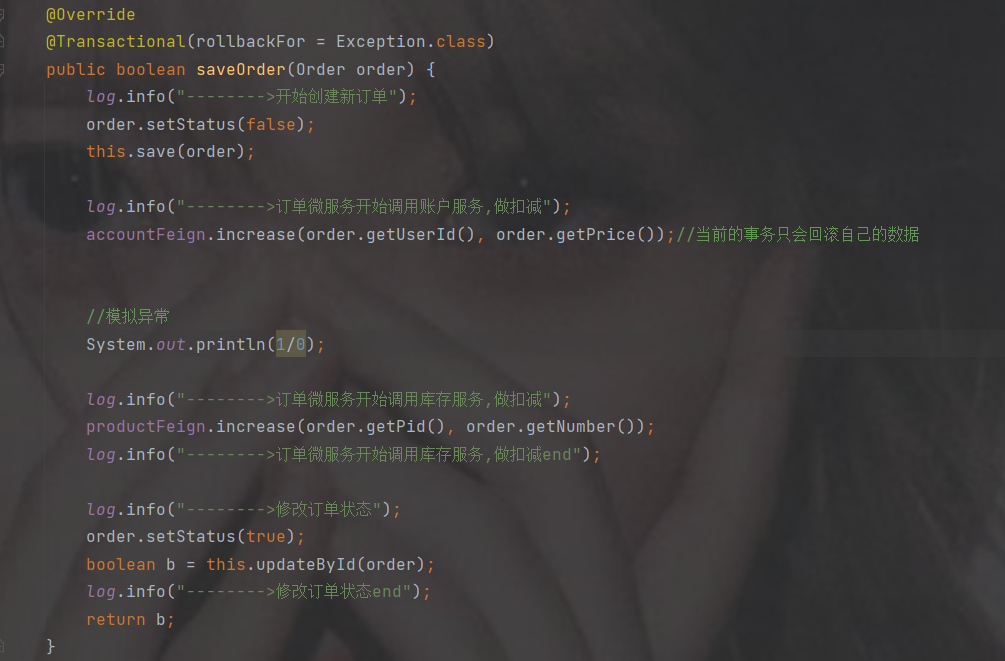

商品1bootstrap配置