RegressionTree(回归树)

1.概述

回归树就是用树模型做回归问题,每一片叶子都输出一个预测值。预测值一般是该片叶子所含训练集元素输出的均值,

即 𝑐𝑚=𝑎𝑣𝑒(𝑦𝑖|𝑥𝑖∈𝑙𝑒𝑎𝑓𝑚)cm=ave(yi|xi∈leafm)。

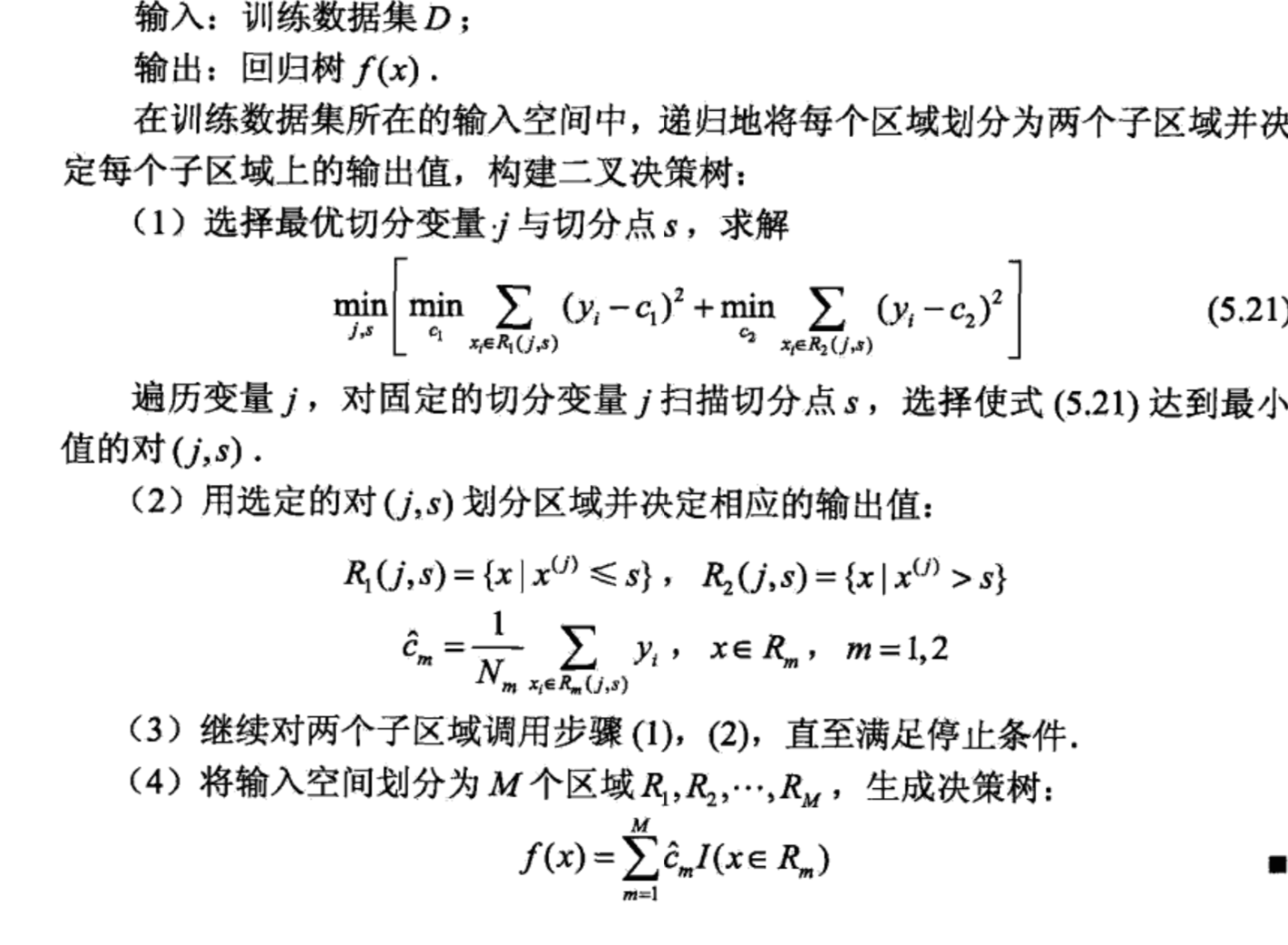

2.构建过程

回归树采用平方和损失函数

每次选择一个切分变量j和切分点s使得

其中

对于拆分的两个部分继续使用上述方式进行拆分,直至满足停止条件(达到指定深度),

cm是一个叶子节点的预测值,这个问题很明显如果不限制深度最终会达到一个叶子节点只有一条数据的过拟合现象。

GradientTreeBoost

回归树森林,可用于多分类和而分类,每次随机一部分数据,构建一个回归树,共同组成一个森林,预测结果是森林每个树的预测值求和去平均值的结果。

CART 在分类问题和回归问题中的相同和差异:

- 相同:

- 在分类问题和回归问题中,CART 都是一棵二叉树,除叶子节点外的所有节点都有且仅有两个子节点;

- 所有落在同一片叶子中的输入都有同样的输出。

- 差异:

- 在分类问题中,CART 使用基尼指数(Gini index)作为选择特征(feature)和划分(split)的依据;在回归问题中,CART 使用 mse(mean square error)或者 mae(mean absolute error)作为选择 feature 和 split 的 criteria。

- 在分类问题中,CART 的每一片叶子都代表的是一个 class;在回归问题中,CART 的每一片叶子表示的是一个预测值,取值是连续的。

浙公网安备 33010602011771号

浙公网安备 33010602011771号