Spark集群搭建

教程:http://dblab.xmu.edu.cn/blog/1714-2/#more-1714

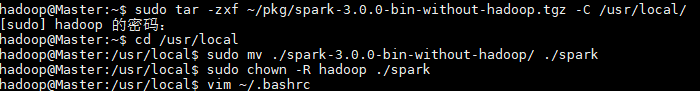

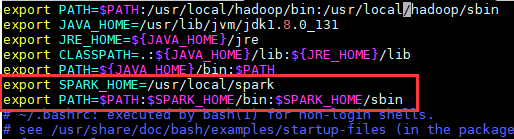

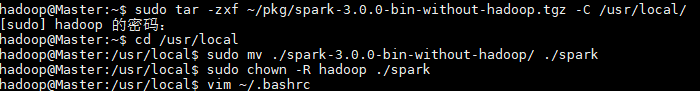

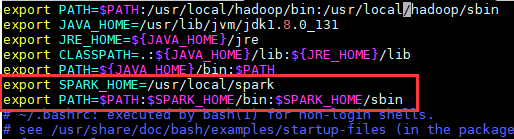

1.安装spark

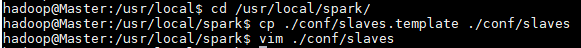

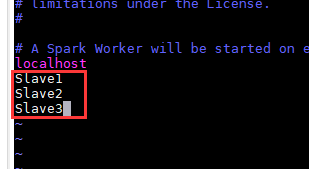

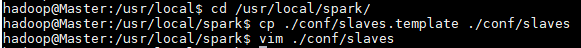

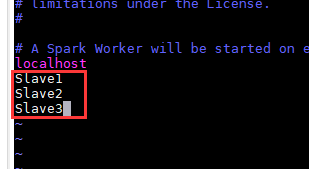

(1)修改slaves文件

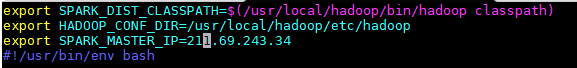

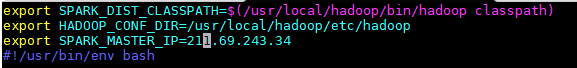

(2)修改spark-env.sh文件

2.将Master主机上的/usr/local/spark文件夹复制到各个节点上

在Slave节点上操作

3.启动spark集群(在此之前hadoop集群要先启动)

至于Slave节点jps

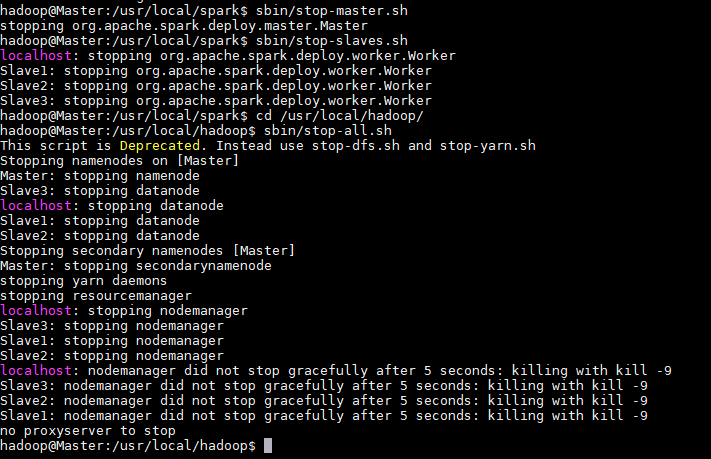

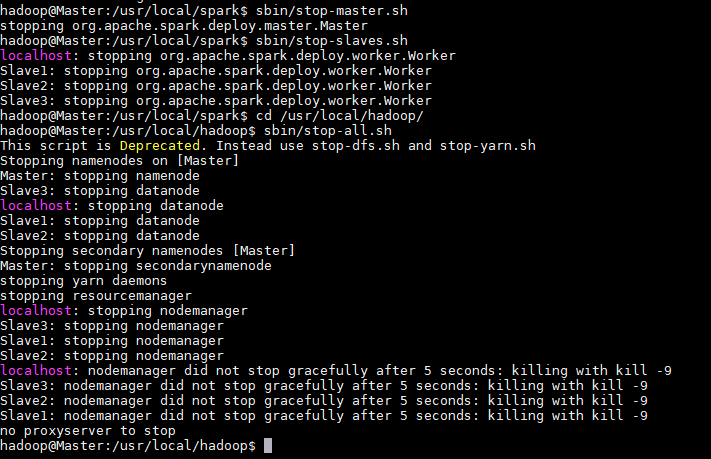

4.关闭spark集群

教程:http://dblab.xmu.edu.cn/blog/1714-2/#more-1714

1.安装spark

(1)修改slaves文件

(2)修改spark-env.sh文件

2.将Master主机上的/usr/local/spark文件夹复制到各个节点上

在Slave节点上操作

3.启动spark集群(在此之前hadoop集群要先启动)

至于Slave节点jps

4.关闭spark集群