spark 启动ClassNotFoundException

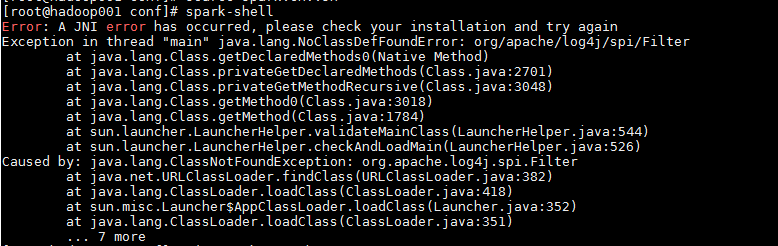

安装配置spark,但当spark-shell启动时,出现了问题,如下图

这里显示问题是找不到类,但是搜了好久都没有合适的解决方法,最后终于找到了一个经验(和我一模一样的问题)!

这个:https://blog.csdn.net/weixin_42194781/article/details/103673824

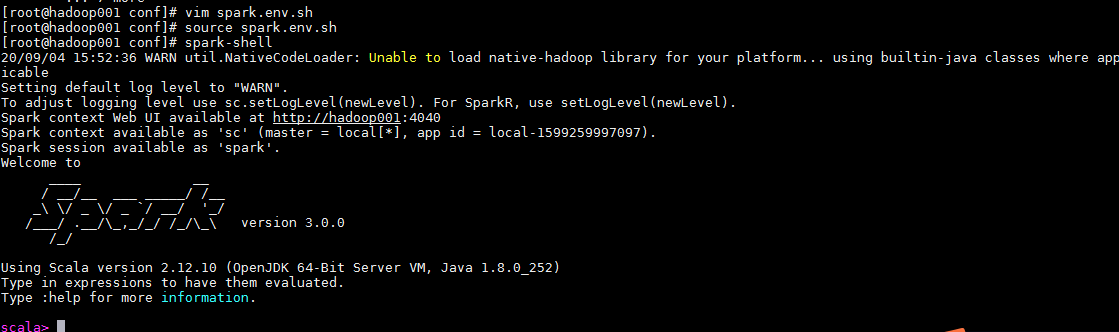

然后我按照此方法在spark-env.sh添加了这个,source spark-env.sh使之生效后,再次spark-shell终于成功了

舒服地看到了想看的界面:

。。。。可是这个为什么治标不治本啊,分析可能我下载安装的是不带Hadoop的Spark,还存在一些配置问题。

浙公网安备 33010602011771号

浙公网安备 33010602011771号