数值优化 —— 二次近似模型

数值优化 —— 二次近似模型数值优化

DeepSeek 思考过程:

嗯,用户问“二次近似模型是什么”,需要详细解释这个概念。首先,我需要确定用户可能的背景。他们可能在学习数值优化,或者在研究机器学习中的优化算法时遇到了这个概念。二次近似模型在优化算法中很常见,比如牛顿法、置信域方法等都会用到。用户可能已经了解梯度下降,但想进一步理解更高级的优化技术,所以需要从基础讲起,但又不能太冗长。

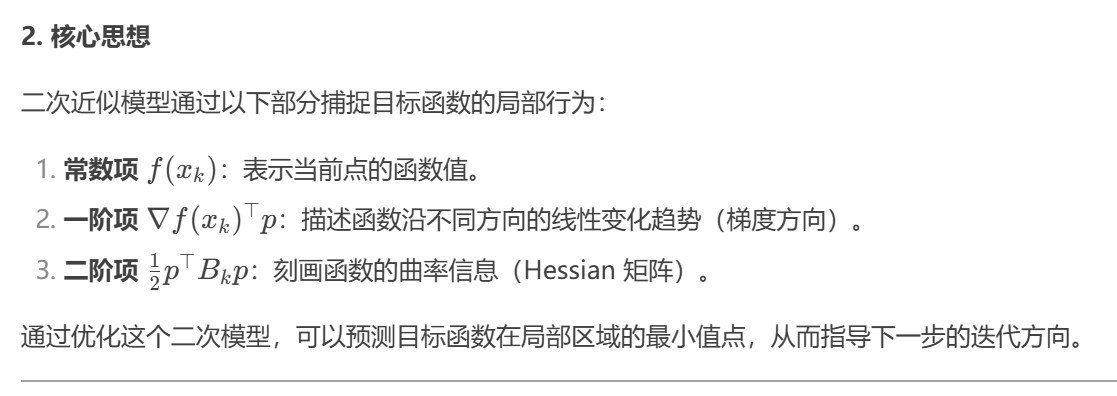

接下来,我应该解释什么是二次近似模型。简单来说,就是用二次函数来近似目标函数在某个点的局部行为。二次函数包括常数项、一阶项和二阶项,分别对应函数值、梯度和Hessian矩阵。需要强调,这个近似只在当前点附近有效,因此优化算法会在这个近似模型上寻找下一步的移动方向。

然后,可能需要举例说明,比如在牛顿法中,二次近似模型是如何用来找到极小值的。同时,要提到在置信域方法中,这个模型被限制在一个区域内,确保步长不会太大,从而保证近似的准确性。

用户可能还会想知道为什么使用二次近似,而不仅仅是一阶方法。这时候需要比较梯度下降和牛顿法的区别,指出二阶方法利用了曲率信息,能更快收敛,但计算Hessian矩阵可能成本高,因此有了拟牛顿法等改进方法。

另外,要注意区分精确的二次近似和近似的二次模型,比如在拟牛顿法中,Hessian矩阵是近似计算的,而不是精确的。这可能涉及到BFGS、L-BFGS等方法,用户之前的问题提到过L-BFGS,可能需要联系起来。

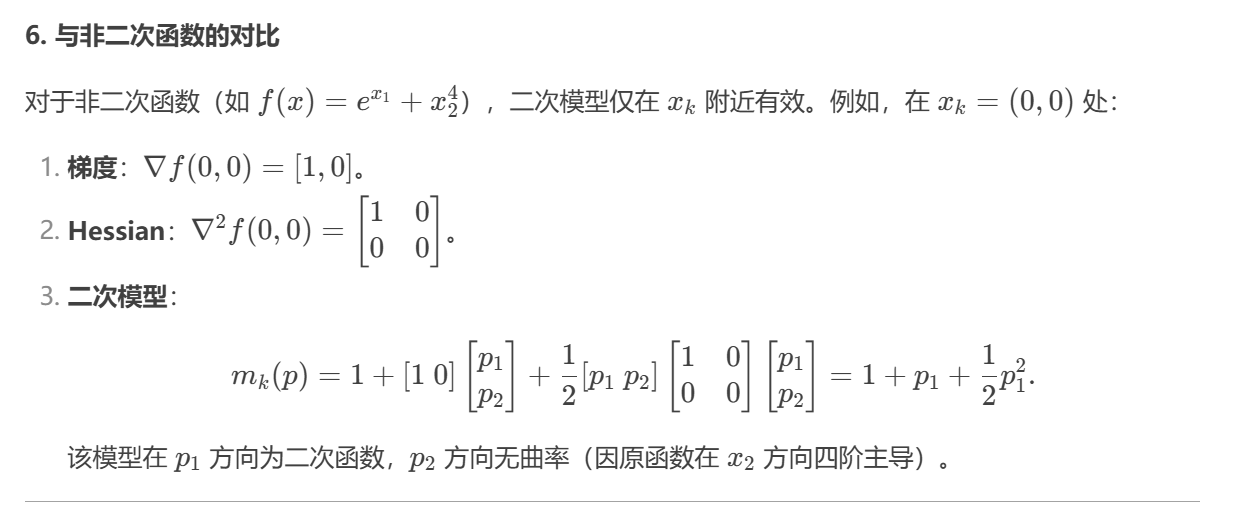

还要考虑用户可能的误区,比如二次近似的有效性区域,即置信域半径的重要性。如果用户对置信域算法感兴趣,这部分需要详细说明模型和实际函数之间的一致性如何通过比值来调整半径。

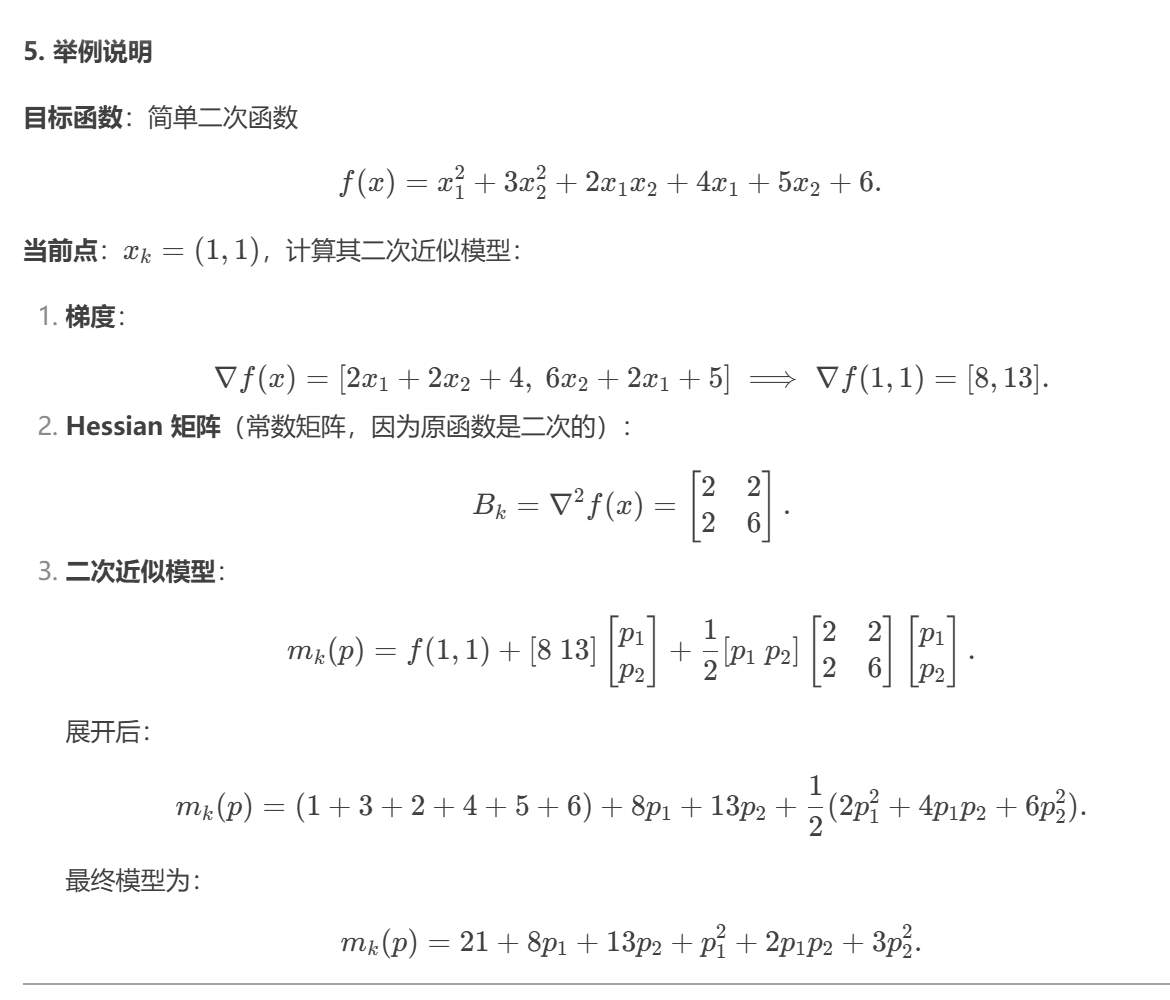

最后,可能需要给出一个简单的数学例子,比如用二次函数近似Rosenbrock函数在某个点的情况,帮助用户直观理解。或者用图像展示二次近似如何拟合原函数,但文字描述的话,需要用公式和步骤说明。

检查是否有遗漏的关键点,比如二次近似的构建方法、应用场景、优缺点,以及与其他方法的对比。确保解释清晰,避免使用过多专业术语,或在必要时进行定义。

总结结构:先定义二次近似模型,解释其数学形式,然后讨论其在优化算法中的应用,比如牛顿法、置信域方法,接着比较一阶和二阶方法,举例说明,最后提到相关的算法如拟牛顿法,确保覆盖用户可能的疑问点。

DeepSeek 回答:

8. 代码示例(Python)

import numpy as np

def quadratic_model(f, grad, hess, xk, p):

"""计算二次近似模型在步长 p 处的值"""

f_k = f(xk)

g_k = grad(xk)

B_k = hess(xk)

m = f_k + np.dot(g_k, p) + 0.5 * np.dot(p, B_k @ p)

return m

# 示例函数:f(x) = x1^2 + 3x2^2 + 2x1x2 + 4x1 + 5x2 + 6

def f(x):

return x[0]**2 + 3*x[1]**2 + 2*x[0]*x[1] + 4*x[0] + 5*x[1] + 6

def grad(x):

return np.array([2*x[0] + 2*x[1] + 4, 6*x[1] + 2*x[0] + 5])

def hess(x):

return np.array([[2, 2], [2, 6]])

xk = np.array([1.0, 1.0])

p = np.array([-0.5, -0.5]) # 假设的步长

print("二次模型预测值:", quadratic_model(f, grad, hess, xk, p))

print("实际函数值:", f(xk + p))

输出:

9. 总结

二次近似模型通过结合梯度与曲率信息,为优化算法提供了更精确的局部方向指导。尽管在高维或非凸问题中面临挑战,但其在牛顿法、置信域方法及拟牛顿法中的核心地位,使其成为数值优化不可或缺的工具。理解其构建与局限性,有助于在实际问题中合理选择优化策略。

posted on 2025-03-18 23:29 Angry_Panda 阅读(154) 评论(0) 收藏 举报

浙公网安备 33010602011771号

浙公网安备 33010602011771号