DeepSeek的线上面试 —— DPO为什么用KL散度,不用交叉熵? 机器学习中什么时候必须用KL散度,什么时候必须用交叉熵,什么时候二者可互换

"deepseek面试被问懵了: DPO为什么用KL散度,不用交叉熵? 机器学习中什么时候必须用KL散度,什么时候必须用交叉熵,什么时候二者可互换?"

一位专注于算法的面试者向极速财讯分享了自己的经验,他主要从事TensorFlow/PyTorch相关的工作,涉及各种模型结构、复杂度以及分布式训练。他提到,DeepSeek的面试流程包括三轮,而应聘的成功率则因岗位而异。对于HR或销售类岗位,面试相对容易,但是核心研发岗位一般人就别想了。

给出ChatGPT上的回答:

DeepSeek上的回答:

深度思考:

好的,我现在要回答用户关于DPO(可能是某个机器学习算法或框架)中使用KL散度而不是交叉熵的问题,以及何时必须使用KL散度、交叉熵,或者两者可以互换。这个问题看起来涉及信息论中的两个重要概念,以及它们在机器学习中的应用。我需要先理清楚KL散度和交叉熵的定义、它们之间的关系,以及在实际应用中的不同场景。

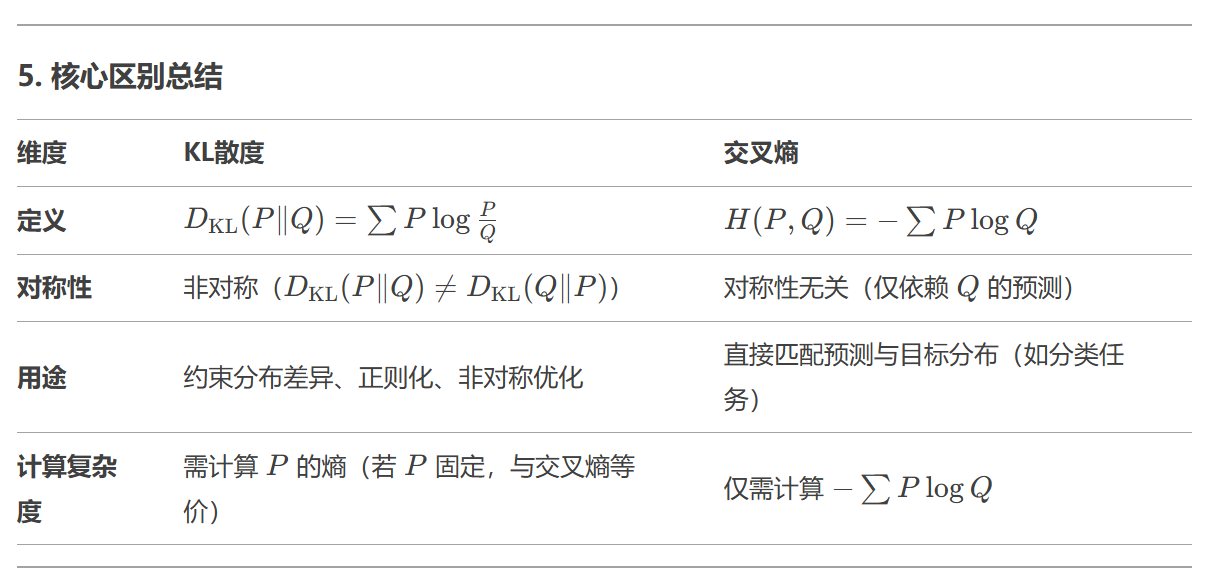

首先,回忆一下KL散度(Kullback-Leibler divergence)和交叉熵(Cross Entropy)的基本概念。KL散度是衡量两个概率分布之间的差异的非对称度量,而交叉熵则是用来衡量两个概率分布之间的相似性,通常用于分类任务中的损失函数。它们的数学表达式之间有什么关系呢?

我记得交叉熵H(P, Q)等于熵H(P)加上KL散度D_KL(P || Q),也就是H(P, Q) = H(P) + D_KL(P || Q)。所以,交叉熵和KL散度之间有直接的数学联系。当P是真实分布,Q是模型预测分布时,最小化交叉熵等价于最小化KL散度,因为H(P)是常数。这时候,使用交叉熵作为损失函数实际上是在最小化KL散度。

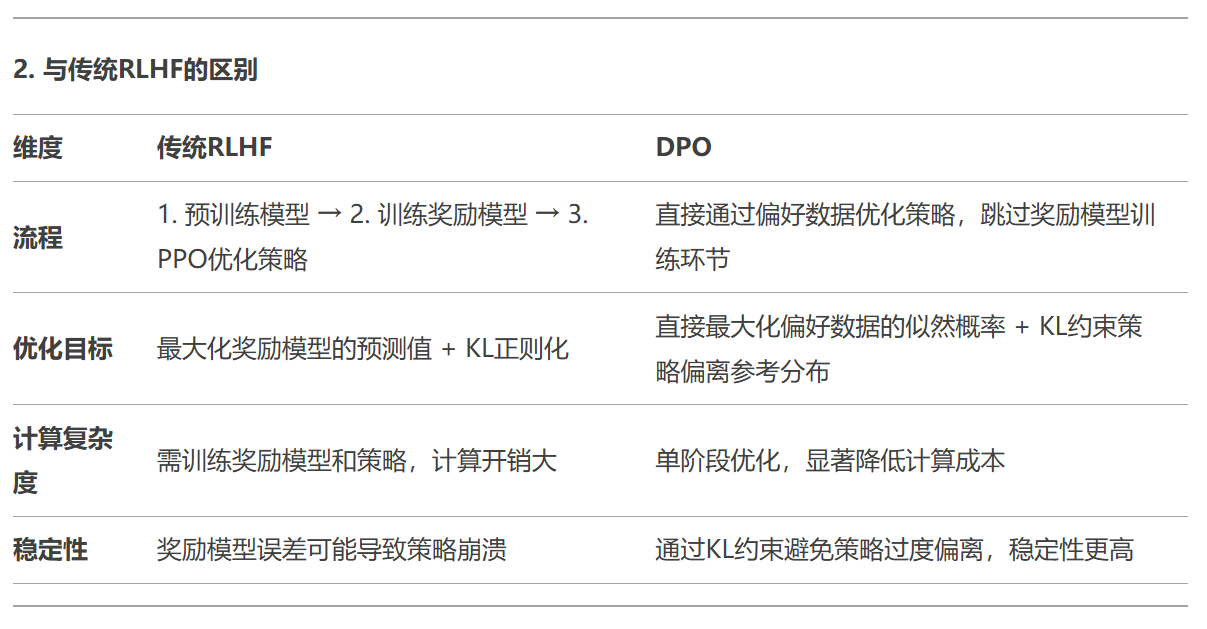

那为什么在DPO中会选择使用KL散度而不是交叉熵呢?可能的原因在于DPO需要显式地控制模型预测分布与某个参考分布之间的差异,而KL散度提供了一个明确的差异度量,可以作为一个正则化项,防止模型偏离参考分布太远。例如,在强化学习中的策略优化,或者在生成模型中使用KL散度来保持生成样本的多样性,避免模式崩溃。这种情况下,KL散度作为正则化项,直接约束模型分布与参考分布之间的距离,而交叉熵可能无法直接施加这种约束。

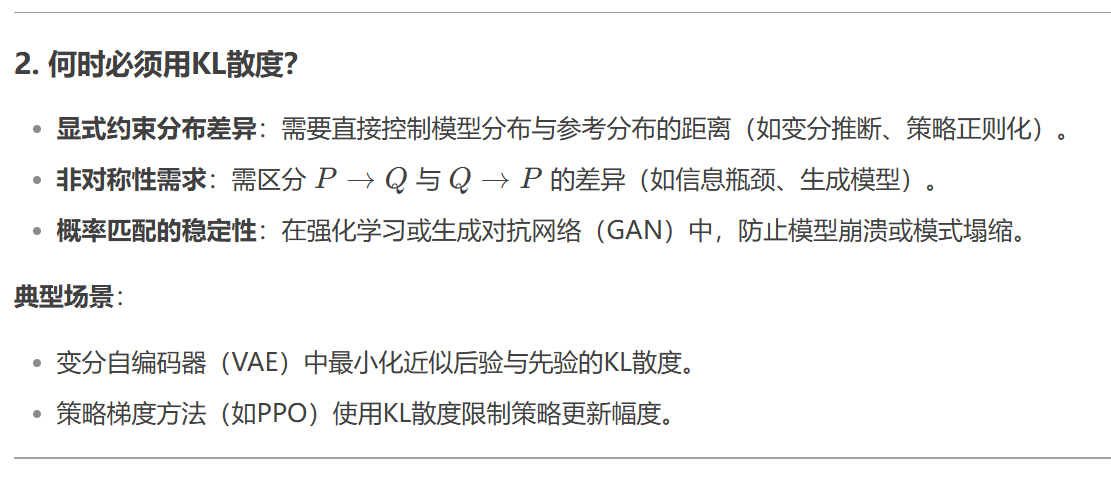

接下来,用户问到在机器学习中何时必须使用KL散度,何时必须用交叉熵,何时可以互换。这需要分情况讨论:

- 必须使用KL散度的情况:

-

当需要显式地度量或约束两个分布之间的差异,并且需要保持这种差异的非对称性时。例如,在变分推断中,优化变分下界(ELBO)时需要最小化近似后验与真实后验之间的KL散度。

-

在强化学习的策略梯度方法中,使用KL散度作为惩罚项,防止新策略偏离旧策略太远,保证训练的稳定性。

-

在生成对抗网络(GAN)或其他生成模型中,当需要明确控制生成分布与真实分布之间的差异时,可能会用到KL散度或其变体(如JS散度)。

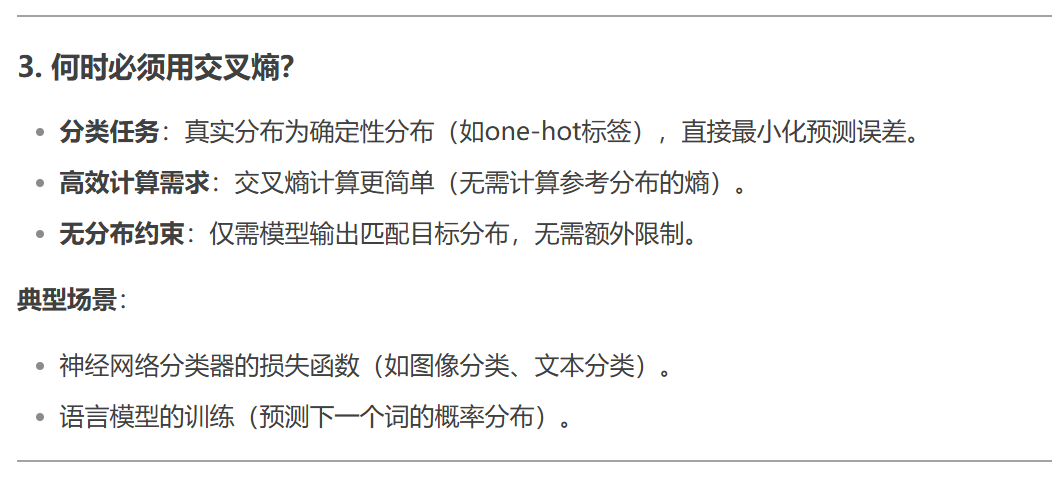

- 必须使用交叉熵的情况:

-

在分类任务中,当真实标签是one-hot编码(即确定性的分布),而模型输出是一个概率分布时,通常使用交叉熵作为损失函数。因为此时真实分布的熵H(P)为零,交叉熵直接等于KL散度,但计算上更简便。

-

当目标是最小化模型预测与真实标签之间的差异,且不需要考虑分布之间的其他约束时,交叉熵是自然的选择,比如在神经网络分类器中。

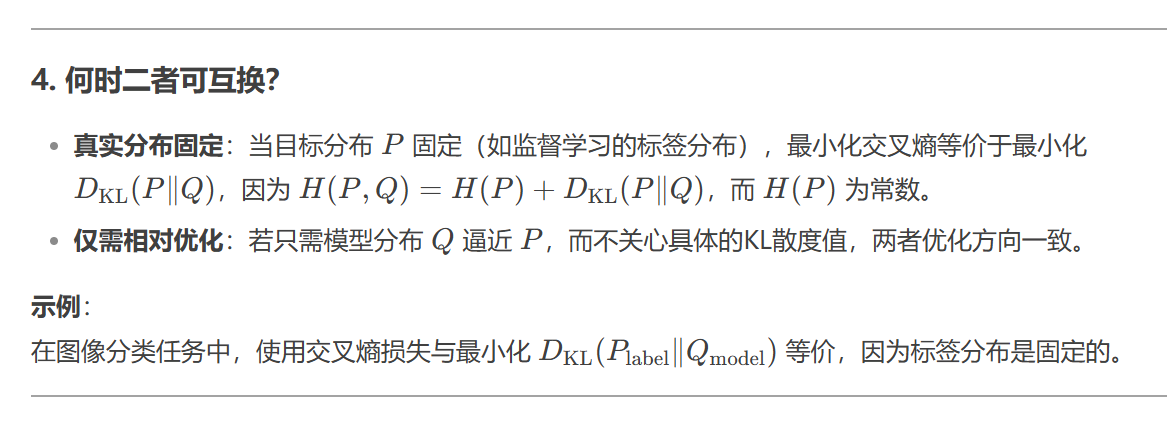

- 二者可互换的情况:

-

当真实分布P是固定的,且优化目标仅涉及调整Q使得Q接近P时,因为此时最小化交叉熵等价于最小化KL散度。例如,在监督学习的分类任务中,如果真实标签分布是固定的(如one-hot),那么使用交叉熵和KL散度在优化效果上是等价的,只是损失函数的数值不同(相差一个常数项H(P)),但梯度相同,因此可以互换。

-

在需要比较两个分布差异,但不需要保持非对称性的情况下,可能可以互换,不过需要注意KL散度的非对称性可能导致不同的结果。

回到DPO的问题,假设DPO中的KL散度用于约束模型分布不要偏离某个先验或参考分布太远,这时候必须使用KL散度来显式地施加这种约束。而如果只是简单地希望模型预测与真实分布一致,没有额外的约束,那么交叉熵可能更合适,因为计算上更高效。

但需要确认DPO具体指的是什么,比如是否是指某个特定的算法或框架。例如,在偏好优化(Preference Optimization)中,可能使用KL散度来平衡模型响应与人类偏好之间的差异,这时候KL散度作为正则项,确保模型在优化目标时不会过度偏离原始模型的行为,从而保持一定的稳定性或安全性。这种情况下,KL散度是必要的,因为它直接约束了分布的变化程度,而交叉熵无法直接起到这种正则化的作用。

总结来说,选择KL散度还是交叉熵取决于任务的需求:是否需要显式地度量分布差异并施加约束,或者是否仅需最小化预测误差。当两者在数学上等价时(如真实分布固定),可以互换;当需要额外的约束或考虑分布的非对称性时,必须使用KL散度。

正式回答:

相关论文:

《Direct Preference Optimization: Your Language Model is Secretly a Reward Model

》

地址:

https://arxiv.org/abs/2305.18290

deepseek深度思考:

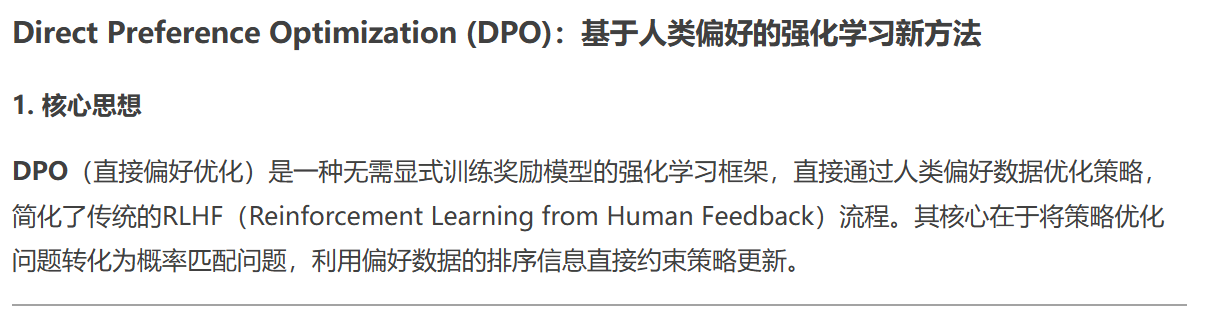

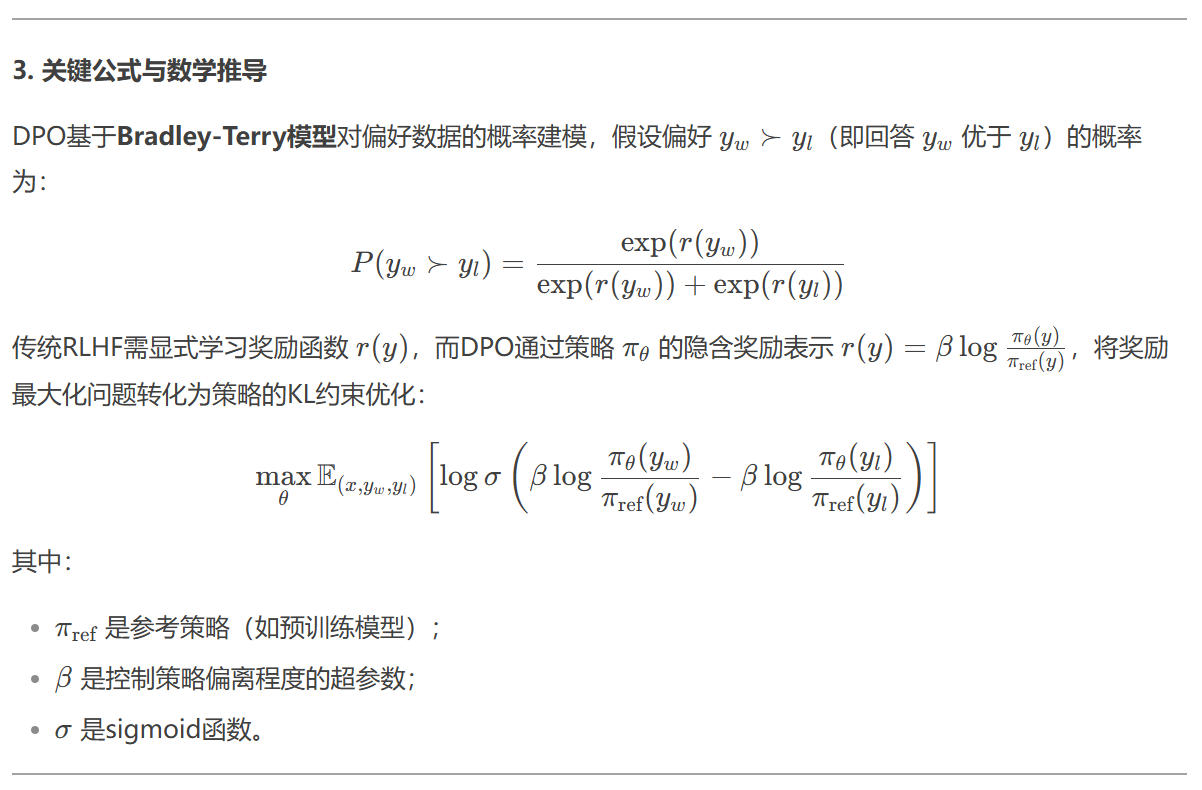

好的,我现在要仔细理解用户的问题,关于《Direct Preference Optimization: A New Approach to Reinforcement Learning from Human Preferences》这篇论文。用户可能希望了解DPO的基本思想、与传统方法的区别、以及它的优缺点和应用场景。首先,我需要回忆一下强化学习从人类偏好中学习的基本框架,比如传统的RLHF(Reinforcement Learning from Human Feedback)流程,通常分为三个步骤:预训练语言模型、收集人类偏好数据训练奖励模型,然后使用强化学习算法(如PPO)优化策略。而DPO作为一种新方法,可能简化了这个流程,直接优化策略而无需显式的奖励模型。接下来,我需要确认DPO的核心创新点,是否通过某种数学转换将奖励模型的学习和策略优化合并为一个步骤,从而避免训练不稳定的奖励模型。

然后,用户可能想知道DPO为什么有效,以及它与KL散度约束的关系。之前的对话中讨论过DPO使用KL散度而不是交叉熵,这可能是因为需要约束策略的更新幅度,防止偏离参考策略太远,确保生成的文本符合人类偏好同时保持一定的稳定性。这里需要详细解释DPO的目标函数是如何结合人类偏好数据和KL散度约束的,可能涉及到概率匹配和策略优化的对偶性。

另外,用户可能对DPO的实际应用和实验结果感兴趣,比如在哪些任务上表现优于传统方法,训练效率如何,是否容易实现。需要回顾论文中的实验部分,比较DPO与PPO等方法的性能指标,比如样本效率、最终策略的质量、计算资源消耗等。同时,可能存在的缺点,比如对偏好数据的依赖性,或者在某些复杂环境中的泛化能力不足,也需要提及。

最后,用户可能希望了解如何在自己的项目中应用DPO,或者是否需要特定的条件才能使用这种方法。这时候需要总结DPO的适用场景,比如当拥有高质量的人类偏好数据但缺乏可靠奖励模型时,或者当希望简化训练流程减少计算开销时,DPO可能是一个合适的选择。同时,指出可能的挑战,比如需要大量的偏好数据,或者如何处理动态变化的人类偏好。

在回答过程中,要注意结构清晰,分点阐述,使用例子帮助理解,避免过于技术化的术语,同时保持准确性。需要确保覆盖用户可能关心的各个方面,包括方法原理、优势、局限性、应用案例和实际应用建议。

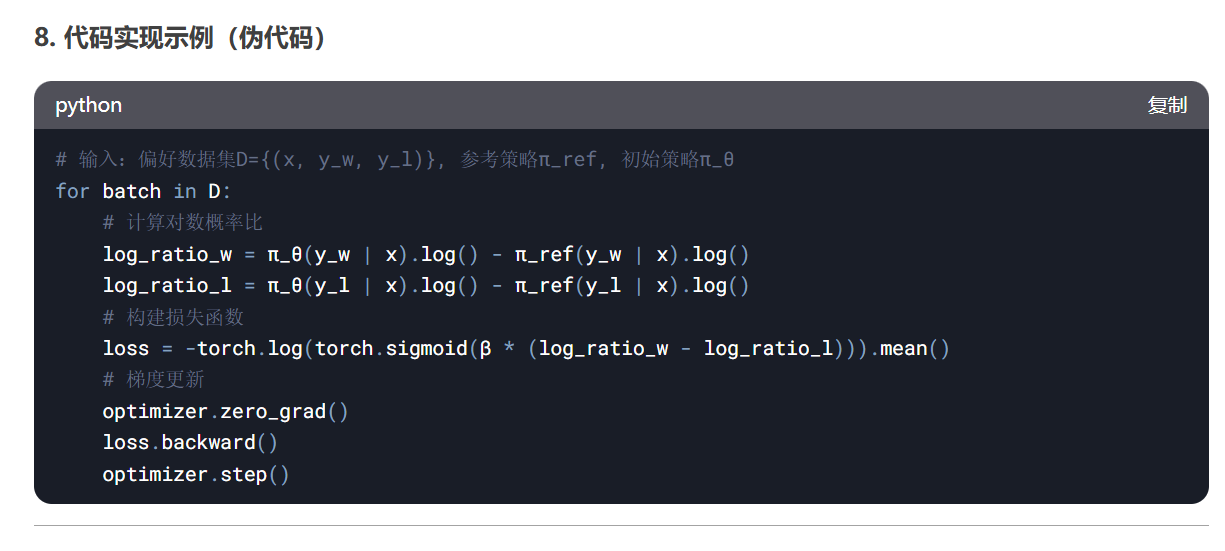

# 输入:偏好数据集D={(x, y_w, y_l)}, 参考策略π_ref, 初始策略π_θ

for batch in D:

# 计算对数概率比

log_ratio_w = π_θ(y_w | x).log() - π_ref(y_w | x).log()

log_ratio_l = π_θ(y_l | x).log() - π_ref(y_l | x).log()

# 构建损失函数

loss = -torch.log(torch.sigmoid(β * (log_ratio_w - log_ratio_l))).mean()

# 梯度更新

optimizer.zero_grad()

loss.backward()

optimizer.step()

论文地址

您可以通过以下链接访问:

https://arxiv.org/abs/2305.18290

其他资源

代码实现:

官方GitHub仓库(含PyTorch实现):

https://github.com/eric-mitchell/direct-preference-optimization

解读文章:

DPO论文解析(中文)

Hugging Face技术博客(英文)

如需正式发表的期刊/会议版本信息,可关注作者后续更新。

相关:

https://baijiahao.baidu.com/s?id=1823558407486179899&wfr=spider&for=pc

posted on 2025-02-10 15:03 Angry_Panda 阅读(874) 评论(0) 收藏 举报

浙公网安备 33010602011771号

浙公网安备 33010602011771号