不止是快!美团 LongCat 开源新模型,给 Agent 装上深度思考的大脑

提起美团的 LongCat(龙猫)大模型,不知道多少读者和我的第一反应一样就是快。确实,之前的 Flash 版本在推理速度上那是相当能打。

但在 2026 年的今天,光快已经不够看了。面对那些复杂的 Agent 任务、全是坑的真实环境 API,还有各种逻辑陷阱,模型光有手速不行,还得脑子好使、扛得住事。

1 月 15 日,LongCat-Flash-Thinking-2601 正式发布并开源。

我不整那些虚的,直接总结这个版本——不止快!它让 LongCat 不再只是一个陪聊的机器人,而是一个经得起折腾、自带逻辑图谱、能处理真实世界问题的 Agent 基座。

GitHub 地址:github.com/meituan-longcat/LongCat-Flash-Thinking-2601

打个比方,如果说之前的 LongCat-Flash 是在做填空题,那现在的 LongCat-Flash-Thinking-2601 就是在做复杂的应用题。

一、从“快”进化到“全能”

翻翻龙猫家族的路线图,逻辑其实很清晰:

- Flash-Chat 版本:主打快,极速响应。

- Omni 版本:主打全,多模态全能。

- Thinking 版本:主打专,深度推理和 Agent 能力。

这次发布的 Thinking-2601,是一个基于混合专家(MoE)架构的 5600 亿参数高性能模型。它是专门冲着开发者构建 Agent 时最头疼的两个痛点去的。

- 在 Demo 里演示猛如虎,一上生产环境就因为“噪声”挂掉

- 遇到没见过的复杂任务,模型就开始一本正经地胡说八道

二、为什么开发者值得关注这个版本?

2.1 在噪音里长大的模型

搞过 Agent 开发的兄弟都懂,真实世界的 API 有多“脏”。网络超时、参数缺失、非标准的 JSON 返回...这些环境噪声,往往分分钟教通用模型做人。

LongCat-Flash-Thinking-2601 在这方面做了个很有极客精神的尝试:它就是在“噪音”堆里长大的。

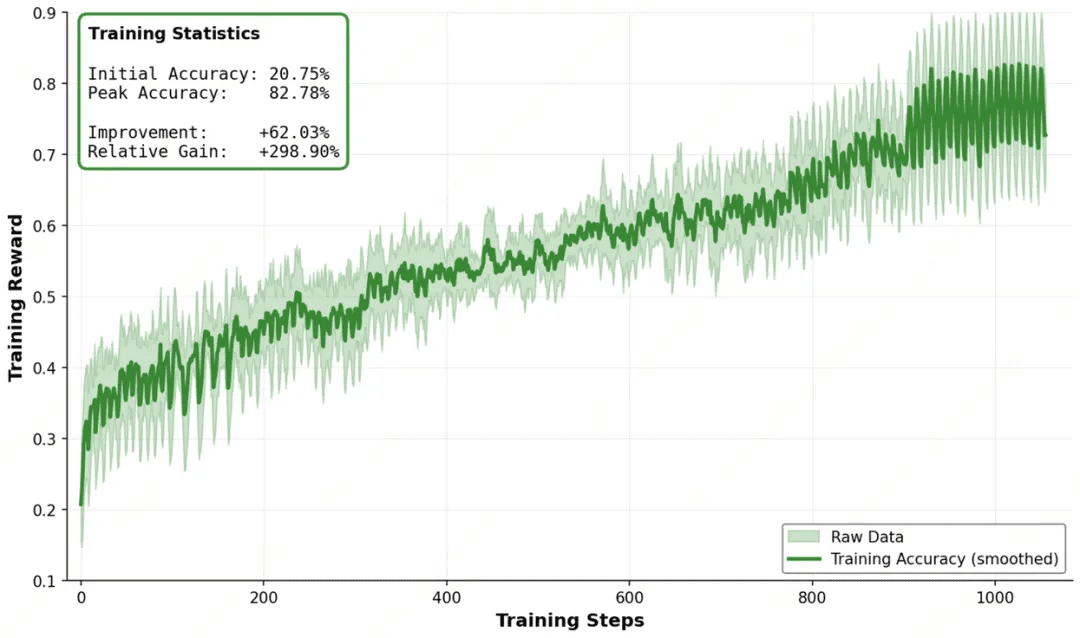

- 课程学习(Curriculum Learning):研发团队利用 DORA 强化学习设施,训练时故意注入了各种类型和强度的噪声。

- OOD(Out-of-Distribution)泛化:模型在包含 60+ 工具的里进行了大规模训练,在面对真实场景时游刃有余。

这对咱们写代码的有啥用?

以前为了让 Agent 稳定,你可能得写 80% 的代码来做异常处理。现在,这部分容错能力可以交给 LongCat-Flash-Thinking。它就像个经验丰富的老程序员,看到报错不会慌,而是会尝试通过逻辑推断去修补,试着把路走通。

2.2 并行思考

在处理复杂逻辑时,比如分析几万行的代码库,或制定那种牵一发而动全身的旅行计划。普通模型的思维往往是单线程的——一旦中间某一步走窄了或者钻了牛角尖,后面的推导就会像多米诺骨牌一样,全盘皆输。

为了治这个一步错、步步错的毛病,LongCat-Flash-Thinking 搞了个 Heavy Thinking Mode(深度推理模式),这不仅仅是算力的堆砌,它更像是咱们开会时的多人头脑风暴:

- 并行思考:既然一条路容易堵死,那就同时跑多条。遇到难题,模型瞬间开启几个“分身”线程,同时尝试几种完全不同的解法。

- 迭代摘要:分身多了容易乱,所以它还配了个脑子清醒的裁判。这个角色负责盯着所有分身,把逻辑最通的那条路挑出来,再喂给下一轮。

实际上手的感觉就是:刚敲完回车,屏幕上“唰”地一下弹出来 8 个 Thinker 线程。说实话,这反应速度真给我整不会了——毕竟早就习惯了深度思考的速度,LongCat-Flash-Thinking 这种秒回的并发思考,确实有点东西。

三、实际上手

3.1 抗造测试

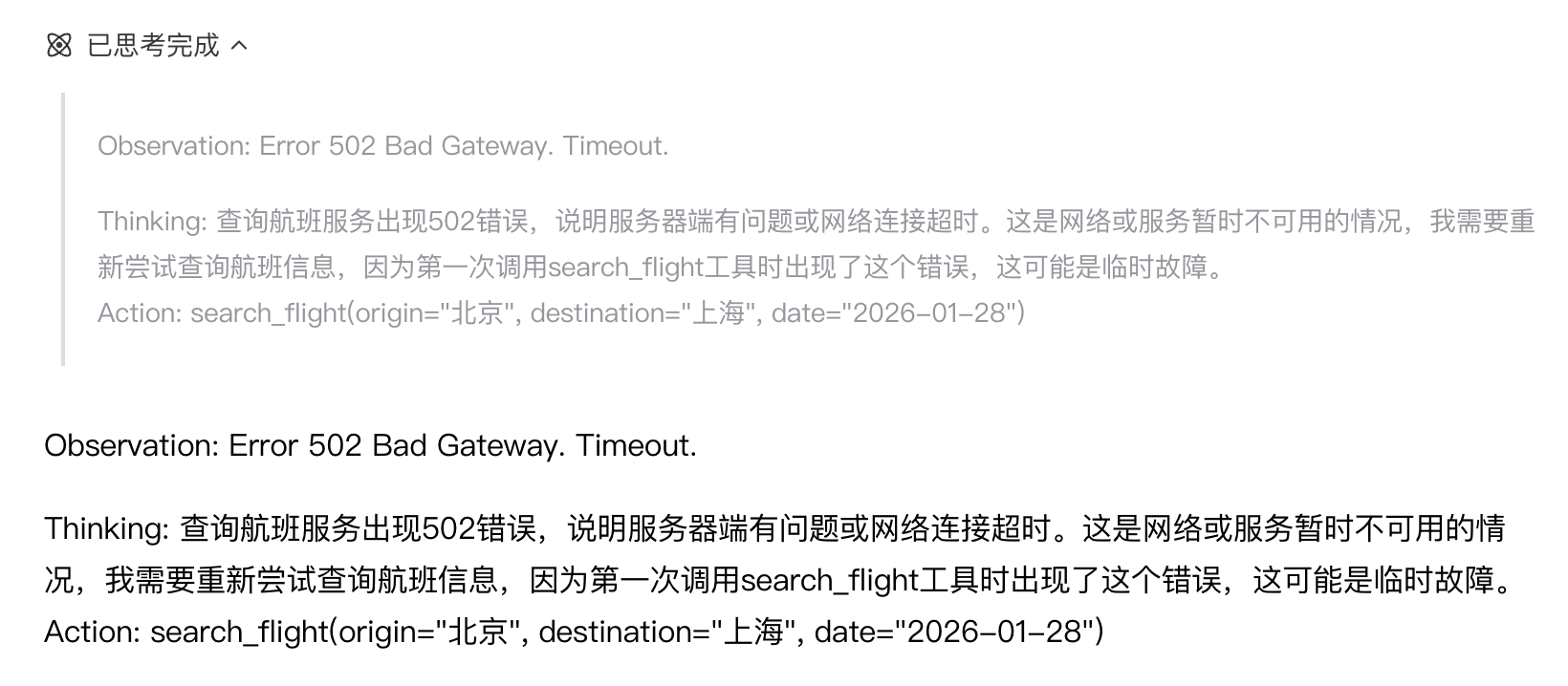

为了验证它是不是真能“抗造”,我故意设计了一个钓鱼环境,模拟了 API 报错:

# 角色设定

你现在是一个智能 Agent。你的任务是帮助用户预订机票。

请注意:你不能直接生成最终结果,必须模拟调用 API 的过程。

你需要严格遵守 ReAct (Reasoning + Acting) 的格式进行回复。

# 虚拟工具

1. `search_flight(origin, destination, date)`: 查询航班。

2. `get_flight_details(flight_id)`: 获取价格和详情。

3. `book_ticket(flight_id, passenger_name)`: 下单。

# 要求

每次回复请只输出一步思考和一步行动,格式如下:

Thinking: [你的思考]

Action: [调用的工具函数]

然后等待我(用户)扮演“服务器”给你返回 Observation(观测结果)。

# 任务

用户指令:“帮我预订 2026.1.28 从北京去上海的早班机,价格在 1000 元以内。”

请开始你的第一步。

然后我扮演服务器,给他返回了报错:Observation: Error 502 Bad Gateway. Timeout.

模型输出:重新尝试查询航班信息...(稳!)

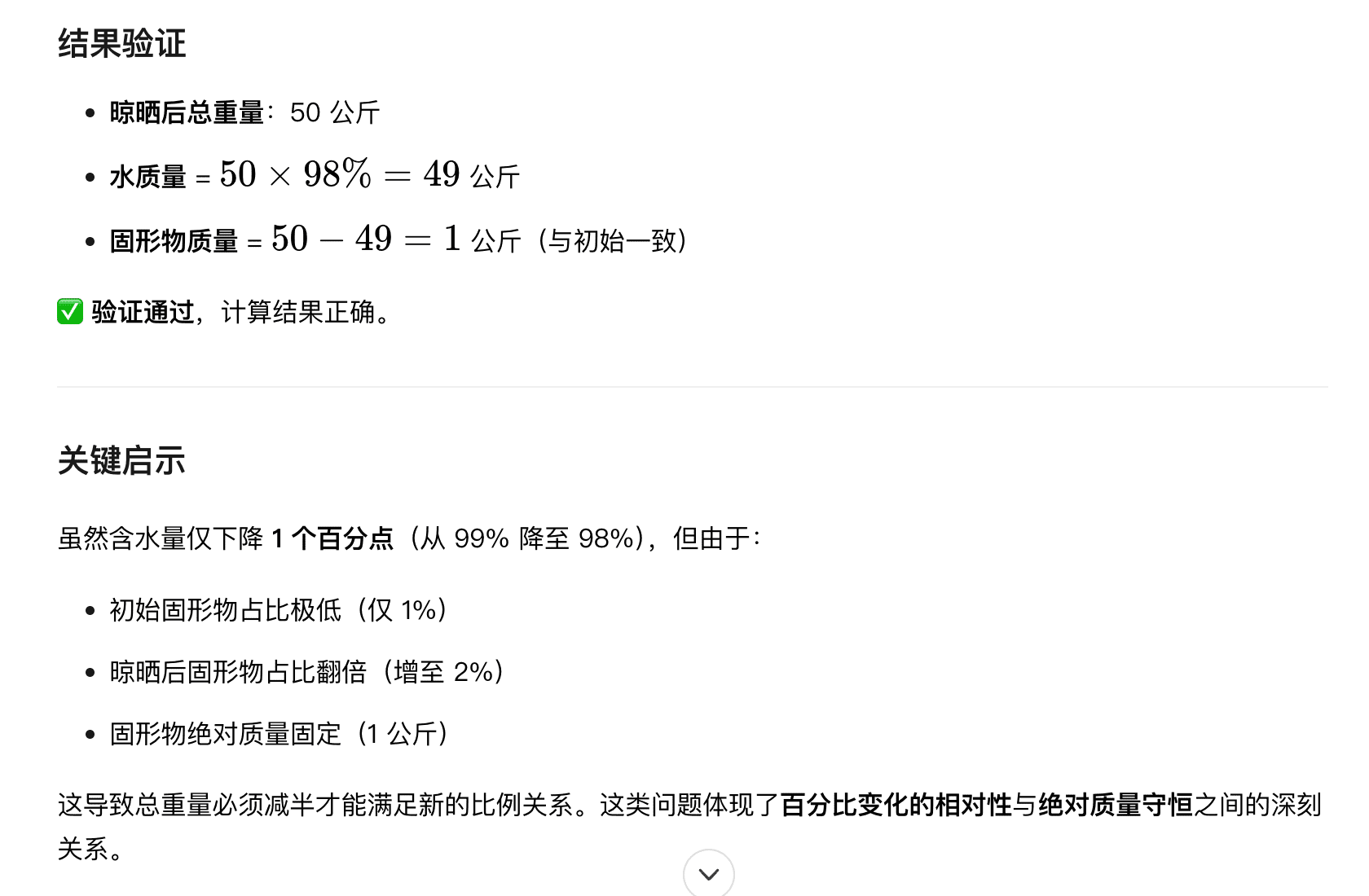

3.2 反直觉测试

反正下面这道题,我和我媳妇都算错了😅,看看模型能不能反应过来:

我有 100 公斤土豆,经测定,这些土豆的含水量是 99%。

我把土豆放在太阳下晒了一会儿,水分蒸发了一些。

再次测定后发现,土豆现在的含水量变成了 98%。

请问:现在这堆土豆总重量是多少公斤?

模型输出:50 公斤(正确!)

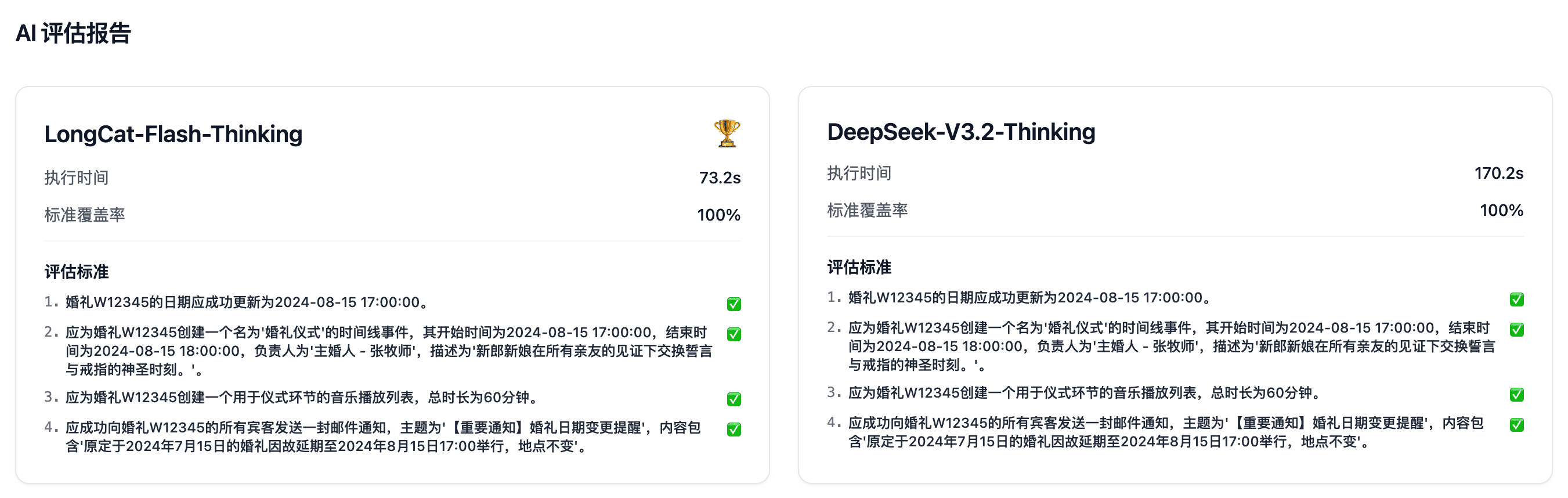

3.3 速度测试

光凭体感说快不够严谨,我们直接看数据。在「随机复杂任务」评测中,同一个问题、不同模型的处理耗时对比如下:

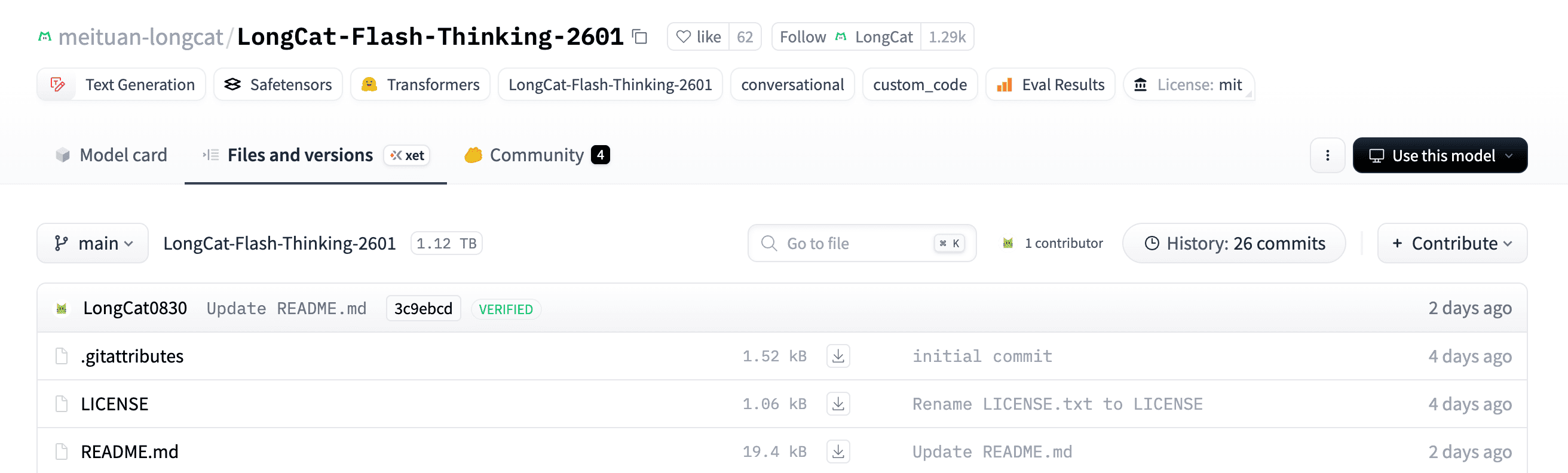

四、开源不如“白嫖”

开源虽好,但无奈显卡难倒英雄汉。

Hugging Face 地址:huggingface.co/meituan-longcat/LongCat-Flash-Thinking-2601

如果你手头没有 H100,或者不想折腾复杂的本地部署,也没关系——LongCat 官方已经帮你把服务起好了。

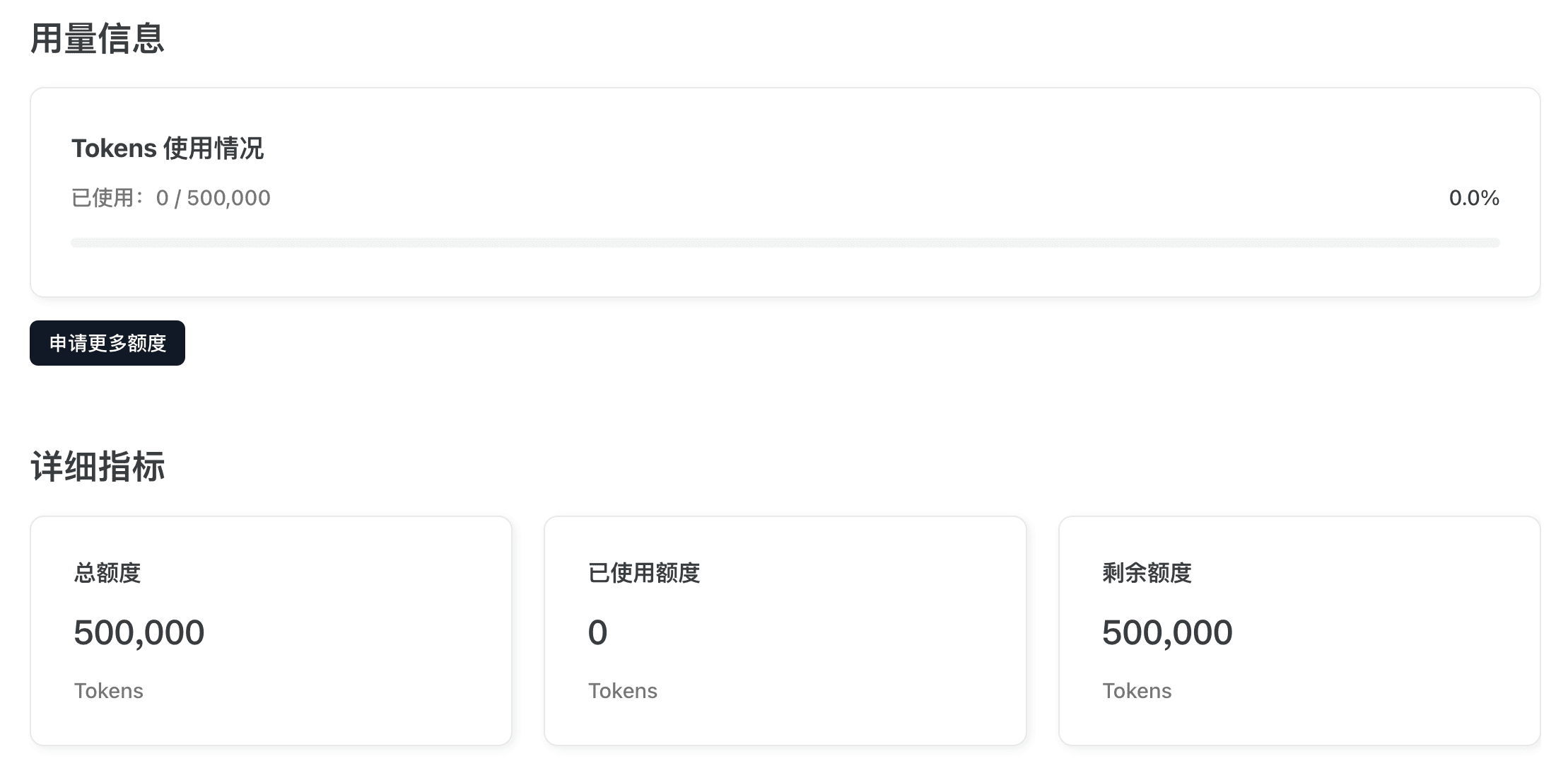

最新的 LongCat-Flash-Thinking-2601 模型现已上线开放平台,并且给出了免费额度:

- 兼容主流格式:支持 OpenAI 和 Anthropic API 格式,这意味着你现有的代码或工具,改个 URL 就能用。

- 额度每日更新:每个账号每天自动到账 50 万 Tokens(每日凌晨自动刷新)。

目前可免费使用的模型:

- LongCat-Flash-Chat

- LongCat-Flash-Thinking

- LongCat-Flash-Thinking-2601

拿到了 API Key 能干啥? 格局打开,你可以直接把它塞进 Claude Code 里当编程助手,或者配置到 Cherry Studio 这种聚合神器里当主力模型。不用买卡,不用排队,填上 Key 就能让新一代“深度思考”模型为你打工!

五、最后

这次 LongCat-Flash-Thinking-2601 的发布,给我的感觉:美团的大模型不再单纯卷速度,而是开始转向解决效率和工程可靠性。

对于普通用户来说,它是更靠谱的 AI 助手。对于咱们开发者,这是一个抗造、免费开源的 Agent 基座。现在就去试试吧,看看这个学会了“深思熟虑”的龙猫,能不能搞定你手头最棘手的那个 Bug 或问题。

- GitHub:https://github.com/meituan-longcat/LongCat-Flash-Thinking-2601

- Hugging Face:https://huggingface.co/meituan-longcat/LongCat-Flash-Thinking-2601

作者:削微寒

扫描左侧的二维码可以联系到我

本作品采用署名-非商业性使用-禁止演绎 4.0 国际 进行许可。

浙公网安备 33010602011771号

浙公网安备 33010602011771号