spark在windows环境下执行spark-shell失败 提示找不到路径

找不到路径一定是环境变量出现了问题,细心检查自己的java、scala以及spark的环境变量是否编辑正确

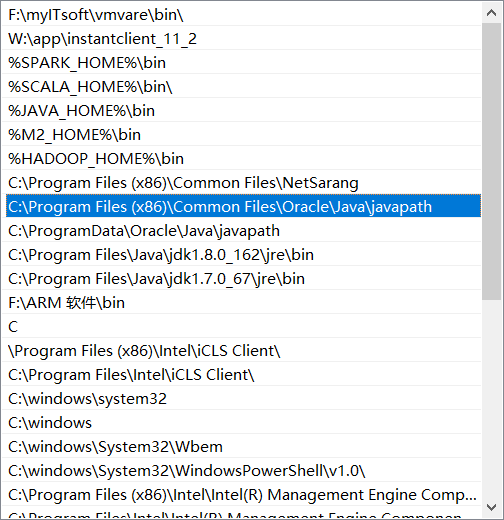

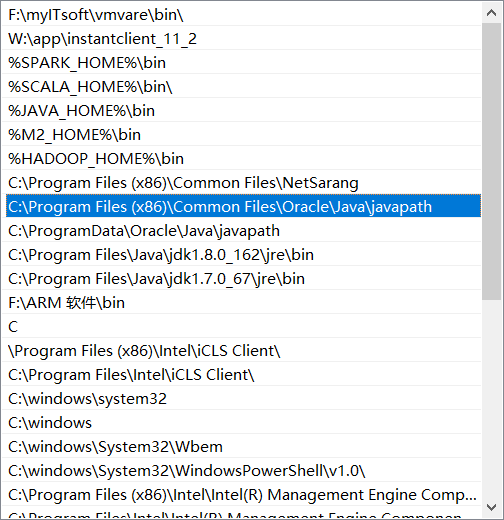

我的问题是因为,java_home 的环境变量后面多了一个分号";",所以不起作用,因为有一个自带的环境变量起作用了(下图)所以java -version是没问题的,在cmd命令下执行 javac看是否可以运行!!!!

再在cmd中运行scala,看是否安装成功

找不到路径一定是环境变量出现了问题,细心检查自己的java、scala以及spark的环境变量是否编辑正确

我的问题是因为,java_home 的环境变量后面多了一个分号";",所以不起作用,因为有一个自带的环境变量起作用了(下图)所以java -version是没问题的,在cmd命令下执行 javac看是否可以运行!!!!

再在cmd中运行scala,看是否安装成功