激活函数

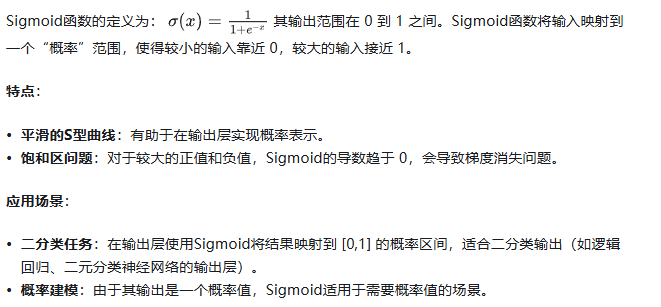

Sigmoid

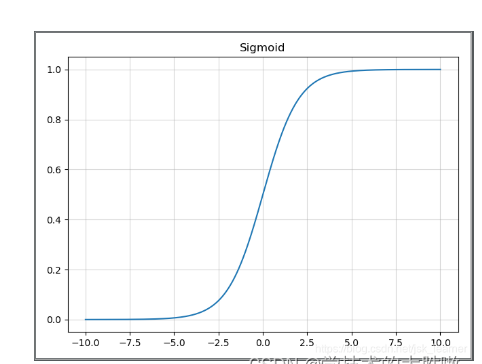

Tanh

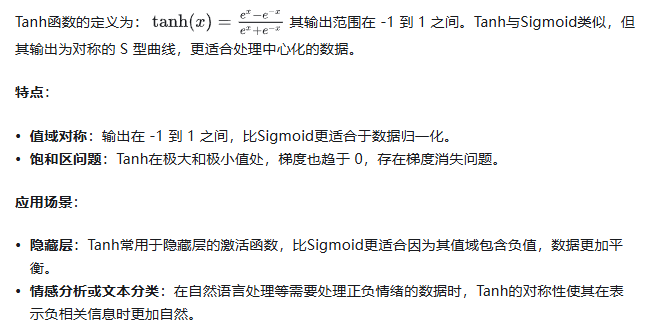

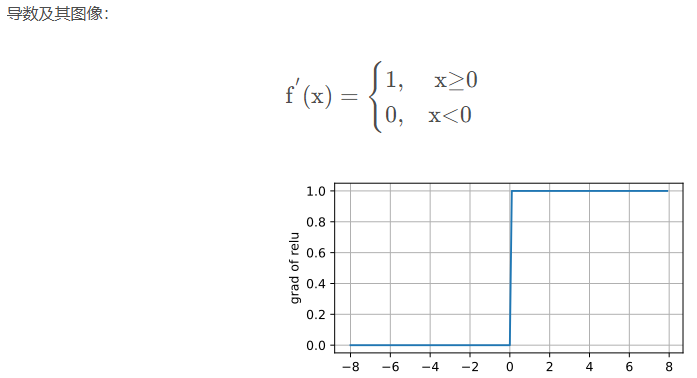

Relu

ReLU提供了一种非常简单的非线性变换。给定元素x,ReLU函数被定义为该元素与0的最大值。

ReLU优点:

- ReLU解决了梯度消失的问题,当输入值为正时,神经元不会饱和

*计算复杂度低,不需要进行指数运算

ReLU缺点:

- 与Sigmoid一样,其输出不是以0为中心的

- Dead ReLU 问题。当输入为负时,梯度为0。这个神经元及之后的神经元梯度永远为0,不再对任何数据有所响应,导致相应参数永远不会被更新

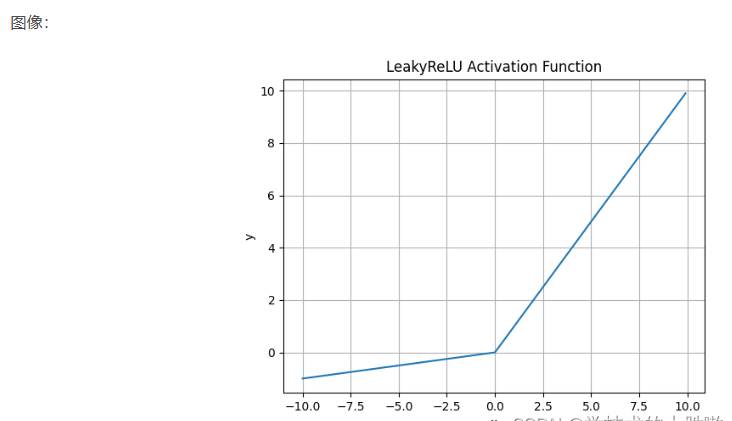

Leaky Relu

Leaky ReLU优点:

- 解决了ReLU输入值为负时神经元出现的死亡的问题

- 计算复杂度低,不需要进行指数运算

Leaky ReLU缺点:

- 函数中的α,需要通过先验知识人工赋值(一般设为0.01)

- 有些近似线性,导致在复杂分类中效果不好。

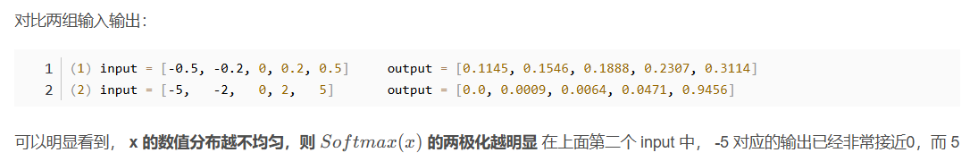

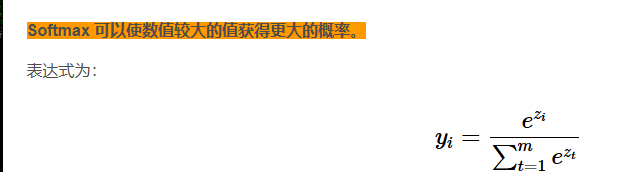

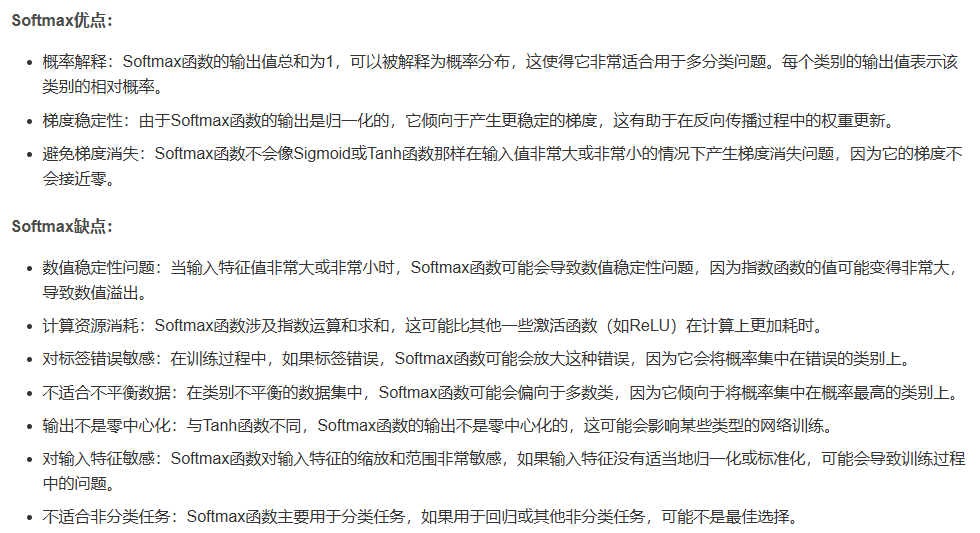

Softmax

Softmax 可以使正样本(正数)的结果趋近于 1,使负样本(负数)的结果趋近于 0;且样本的绝对值越大,两极化越明显。

参考文献:

https://zhuanlan.zhihu.com/p/5616880298

https://blog.csdn.net/weixin_44115575/article/details/139835864

浙公网安备 33010602011771号

浙公网安备 33010602011771号