丢弃法

一、前言

在深度学习里面,除了用权重衰退来应对过拟合外,还用丢弃法(dropout)来应对过拟合

二、概念

在现代神经网络中,我们所指的丢弃法,通常是对输入层或者隐含层进行的操作:

1、以丢失概率P随机丢掉该层的部分隐藏单元

2、丢带的隐藏单元会被清零

3、没有丢掉的隐藏单元会除以1-p做拉伸

三、原理

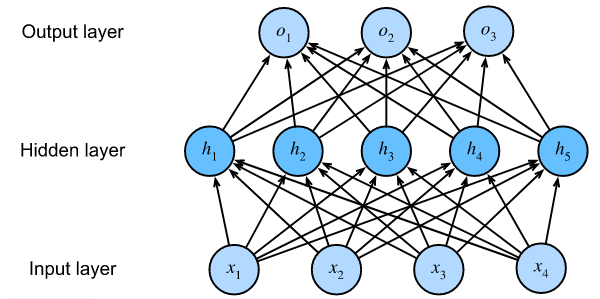

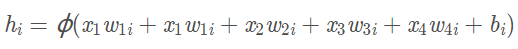

1、对与上图的单隐藏层感知机,其输入层节点数为4,隐藏层节点数为5,所以隐藏层节点hi(i=1,2,3,4,5)的输出值计算方法为:ϕ表示激活函数

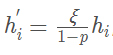

2、当我们对隐藏层使用丢弃法时,这一层的节点有一定的概率被丢弃,即其输出值被置0. 我们假设丢弃的概率为p,那么hi会有p的概率被置0,有1-p的概率会除以1-p做拉伸

即使用丢弃法不改变隐藏层节点的期望

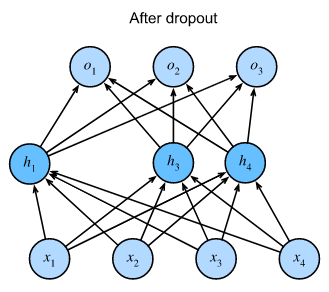

3、可以发现以P的概率删除了h2和h5后,输出的计算不再依赖于h2和h5。并且它们在各自的梯度在执行反向传播时也会消失,这样输出层的计算就不会过度依赖与和h1...h5中的任何一个元素

4、在训练时使用dropout。在测试时,为了取得确定性的结果,不使用丢弃法

浙公网安备 33010602011771号

浙公网安备 33010602011771号