40.8K star!让AI帮你读懂整个互联网:Crawl4AI开源爬虫工具深度解析

嗨,大家好,我是小华同学,关注我们获得“最新、最全、最优质”开源项目和高效工作学习方法

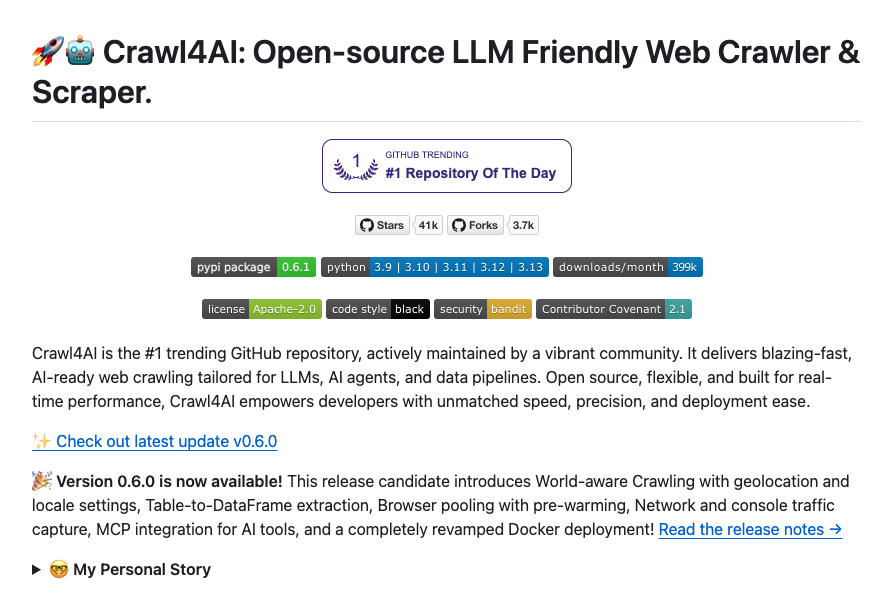

Crawl4AI是2025年GitHub上最受瞩目的开源网络爬虫工具,专为AI时代设计。它不仅能够像传统爬虫一样抓取网页内容,更能理解页面语义结构,自动生成适合大语言模型使用的训练数据格式。项目上线半年即获得4万+星标,被应用于1200+AI项目中。

核心功能亮点

智能内容提取引擎

-

PDF解析黑科技:直接提取PDF文档中的文字、图片和元数据 -

动态页面驯服术:通过Playwright自动执行JavaScript,抓取SPA应用数据 -

多语言支持:自动识别50+种语言并保留原始编码格式 -

智能分块策略:根据内容类型自动分割文本块(段落/表格/代码段)

# 示例:三行代码启动智能爬虫

from crawl4ai import WebCrawler

crawler = WebCrawler()

result = crawler.run(url="https://example.com", strategy="auto")

print(result.text)AI就绪数据管道

-

元数据自动标注:自动生成内容摘要、关键词、语义标签 -

多模态支持:同时抓取文本、图片、视频等多媒体资源 -

智能缓存系统:自动识别内容更新频率,优化抓取策略

企业级功能

-

反爬对抗模式:自动轮换User-Agent/IP地址池 -

法律合规助手:自动识别robots.txt和隐私政策 -

分布式部署:支持Docker一键部署到云平台

技术架构解析

| 模块 | 技术栈 | 性能指标 |

|---|---|---|

| 核心引擎 | Python 3.10 + Scrapy框架 | 单节点100req/s |

| 动态渲染 | Playwright + Chromium | 支持无头浏览器 |

| 文档处理 | PyPDF2 + pdfplumber | PDF解析速度提升3倍 |

| 语义理解 | Transformer + 预训练模型 | 支持20+种文档类型 |

| 分布式调度 | Redis + Celery | 横向扩展至100节点 |

五大应用场景

-

AI训练数据采集

自动构建符合LLM格式要求的训练数据集,支持Markdown/JSONL等多种输出格式 -

行业情报监控

配置关键词自动抓取竞品动态,生成每日市场简报 -

学术研究助手

批量抓取论文库,自动构建文献知识图谱 -

电商价格追踪

定时抓取商品页面,智能识别价格波动规律 -

内容聚合平台

自动采集多源资讯,生成统一格式的新闻流

同类项目对比

| 功能 | Crawl4AI | Scrapy | BeautifulSoup |

|---|---|---|---|

| 动态页面支持 | ✅ 无头浏览器 | ❌ | ❌ |

| PDF解析 | ✅ 原生支持 | ❌ | ❌ |

| 语义分块 | ✅ 自动 | ❌ | ❌ |

| 反爬机制 | ✅ 智能轮换 | 手动配置 | 无 |

| 数据格式 | AI就绪 | 原始HTML | 原始HTML |

| 学习曲线 | 低 | 中 | 高 |

项目总结

Crawl4AI重新定义了网络爬虫的边界,其三大创新点值得关注:

-

AI原生设计:从数据清洗到格式输出都为大模型优化 -

智能对抗系统:内置的反反爬策略降低运维成本 -

多模态支持:文本/图片/文档的一站式处理能力

延伸阅读:同类工具推荐

1. Scrapy-Splash

-

优势:成熟的分布式爬虫框架 -

局限:需要自行搭建渲染服务

2. Apify

-

优势:提供可视化操作界面 -

局限:云服务收费较高

3. Octoparse

-

优势:零代码可视化采集 -

局限:闭源商业软件

项目地址

https://github.com/unclecode/crawl4ai

浙公网安备 33010602011771号

浙公网安备 33010602011771号