ollama总结

简介:

Ollama 是一个开源的本地化大型语言模型(LLM)运行框架,它允许用户直接在个人电脑或本地服务器上下载、运行和管理多种开源大语言模型,而无需依赖云端服务或进行复杂配置。

核心功能与特性

-

模型支持与多样性

Ollama 支持超过 1700 种开源大语言模型,包括 Llama、Gemma、Qwen、DeepSeek 等热门模型。用户可通过官方模型库(ollama.com/library)一键下载并切换模型,满足文本生成、对话、摘要、翻译等多样化需求。 -

本地化运行与隐私保护

与云端服务不同,Ollama 在本地运行模型,所有数据处理均在用户设备上完成。这避免了数据上传至第三方服务器的风险,尤其适合对隐私敏感的场景,如医疗、金融等领域。 -

资源优化与硬件适配

Ollama 会自动检测本地计算资源,优先使用 GPU 加速推理;若无 GPU,则自动切换至 CPU。通过优化内存管理和并行计算,它能在消费级硬件上流畅运行大型模型,降低使用门槛。 -

微调与个性化定制

用户可通过少量数据对预训练模型进行微调,使其适应特定任务(如法律文书生成、医疗问答)。Ollama 支持自定义模型参数(如温度、Top-p),进一步调整生成风格与质量。 -

跨平台兼容性

Ollama 提供 Windows、macOS、Linux 的安装包,并支持 Docker 容器化部署。用户可通过简单命令(如ollama run)快速启动模型,无需复杂配置。

应用场景

-

开发者工具构建

开发者可利用 Ollama 快速集成大语言模型到应用中,如智能客服、代码生成工具或数据分析助手。例如,通过ollama serve启动本地 API 服务,供前端调用。 -

隐私敏感型应用

在医疗领域,Ollama 可用于生成临床决策支持文本或患者教育材料,确保数据不离开本地环境。 -

教育与研究

学生和研究人员可低成本实验不同模型,探索自然语言处理(NLP)技术,无需申请云端资源配额。 -

企业定制化解决方案

企业可基于 Ollama 微调模型,构建符合行业术语和业务流程的专属 AI 系统,如法律合同审查或金融报告生成。

使用示例

-

安装与运行

- 下载安装包(ollama.com),通过命令行启动服务:

ollama serve - 拉取并运行模型(如 DeepSeek-R1):

ollama pull deepseek-r1 ollama run deepseek-r1

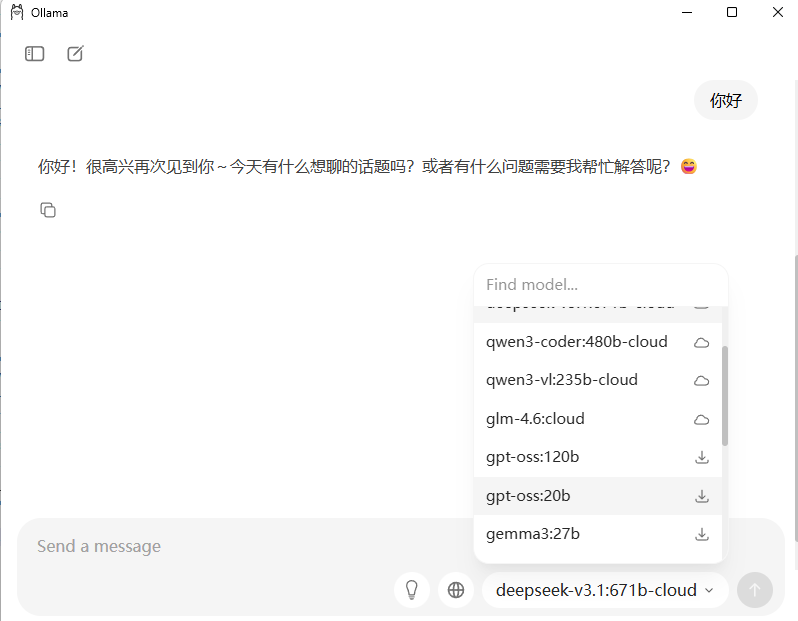

可以把模型下载到本地,也可以使用云端的模型,使用云端的模型需要登录ollama,没有账号使用邮箱就可以申请一个

- 下载安装包(ollama.com),通过命令行启动服务:

-

API 调用

通过curl发送请求,生成文本:curl http://localhost:11434/api/generate \ -d '{"model": "deepseek-r1", "prompt": "解释量子计算"}' -

微调模型

准备领域数据集后,通过 Modelfile 配置微调参数,运行训练命令生成定制模型。

浙公网安备 33010602011771号

浙公网安备 33010602011771号