摘要:

1 介绍

在计算机视觉、模式识别、数据挖掘很多应用问题中,我们经常会遇到很高维度的数据,高维度的数据会造成很多问题,例如导致算法运行性能以及准确性的降低。特征选取(Feature Selection)技术的目标是找到原始数据维度中的一个有用的子集,再运用一些有效的算法,实现数据的聚类、分类以及检索等任务。

特征选取的目标是选择那些在某一特定评价标准下的最重要的特征子集。这个问题本质上是一个综合的优化问题,具有较高的计算代价。传统的特征选取方法往往是独立计算每一个特征的某一得分,然后根据得分的高低选取前k个特征。这种得分一般用来评价某一特征区分不同聚类的能力。这样的方法在二分问题中一般有不错的结果,但是在多类问题中很有可能会失败。

基于是否知道数据的lebal信息,特征提取方法可以分为有监督和无监督的方法。有监督的的特征提取方法往往通过特征与label之间的相关性来评估特征的重要性。但是label的代价是高昂的,很难在大数据集上进行计算。因此无监督的特征提取方法就显得尤为重要。无监督的方法只利用数据本身所有的信息,而无法利用数据label的信息,因此要得到更好的结果往往 阅读全文

2012年11月27日

2012年11月26日

摘要:

我对论文打分(满分5分):4.5分

论文目标:

做high dimensional regression的问题,即

一般做回归的时候y的维度会比x低,甚至是一维的,比如一般用回归来做分类、预测。

但是y的维度如果比较高,而x可以是高维也可以是低维,回归问题可能需要有不一样的角度去思考。 阅读全文

2012年9月24日

摘要:

在做分类时常常需要估算不同样本之间的相似性度量(Similarity Measurement),这时通常采用的方法就是计算样本间的“距离”(Distance)。采用什么样的方法计算距离是很讲究,甚至关系到分类的正确与否。

本文的目的就是对常用的相似性度量作一个总结。

本文目录:

1. 欧氏距离

2. 曼哈顿距离

3. 切比雪夫距离

4. 闵可夫斯基距离

5. 标准化欧氏距离

6. 马氏距离

7. 夹角余弦

8. 汉明距离

9. 杰卡德距离 & 杰卡德相似系数

10. 相关系数 & 相关距离

11. 信息熵 阅读全文

2012年7月9日

摘要:

Locally linear embedding(LLE)[1] 是一种非线性降维算法,它能够使降维后的数据较好地保持原有流形结构。LLE可以说是流形学习方法最经典的工作之一。很多后续的流形学习、降维方法都与LLE有密切联系。

见图1,使用LLE将三维数据(b)映射到二维(c)之后,映射后的数据仍能保持原有的数据流形(红色的点互相接近,蓝色的也互相接近),说明LLE有效地保持了数据原有的流行结构。 阅读全文

2012年7月4日

摘要:

今年的美国人工智能大会AAAI2012 将在加拿大多伦多召开,时间是7月22日至26日。希望能够在那里学到一些新的东西,有一起去参加的也可以在那边交流下。我的论文《A Bregman Divergence Optimization Framework for Ranking on Data Mani... 阅读全文

摘要:

近日,同一个实验室的博士mm何占盈的的论文《Document Summarization Based on Data Reconstruction》荣获第26届AAAI人工智能国际会议最佳论文奖(Outstanding Paper Award),这是中国大陆首次获此殊荣。简介:论文提出了一种全新的从... 阅读全文

2012年3月15日

摘要:

自己的一个Recommender System的工作在WWW2012会议上发表:An Exploration of Improving Collaborative Recommender Systems via User-Item Subgroups.四月份打算去参加在法国里昂举行的WWW2012会议,如果国内也有要去参加的朋友可以联系一下,可以在那边交流一下。我的个人信息可以在我的主页找到:http://eagle.zju.edu.cn/~binxu/ 阅读全文

摘要:

今天把自己前面的工作介绍下,SIGIR 2011 Full paper:

Efficient Manifold Ranking for Image Retrieval

虽然这个工作在算法上并不算有突破性的创新,但是因为是我自己的第一个工作,很多地方都在学习,所以也算马马虎虎了。

文章的目标是去加速经典的流行排序算法(Ranking on Data Manifold, or Manifold Ranking, MR),最后取得的结果是在损失有限精度的情况下,有效提高了算法运行速度。特别的,对于新的样本点(out-of-sample),算法也可以处理。 阅读全文

2011年11月24日

摘要:

计算机科学的论文最大特点在于:

极度重视会议,而期刊则通常只用来做re-publication,也就是说很多期刊文章是会议论文的扩展版,而不是首发的工作。并且期刊的录用到发表中间的等待时间极长,有的甚至需要等上1-2年,因此即使投稿时是最新的工作,等发表的时候也不一定是最新了!也正因为如此,很多计算机期刊的影响因子都低的惊人,很多顶级刊物也只有1到2的印象因子!

因此,要讨论计算机科学的publication,那么请忽视影响因子。 阅读全文

摘要:

坐标图上有各种数字和文字,因为图的大小关系,经常会需要去调节字体的大小,这里简单列举一下,以后想到了再补充~ 阅读全文

摘要:

matlab绘图的时候只用plot函数出来的图不一定符合自己最想要的格式, 经常要对坐标的数字、范围、间隔做处理。

虽然不是什么很难的操作,但是确实常用,也容易忘记,所以就放在这里说明一下: 阅读全文

摘要:

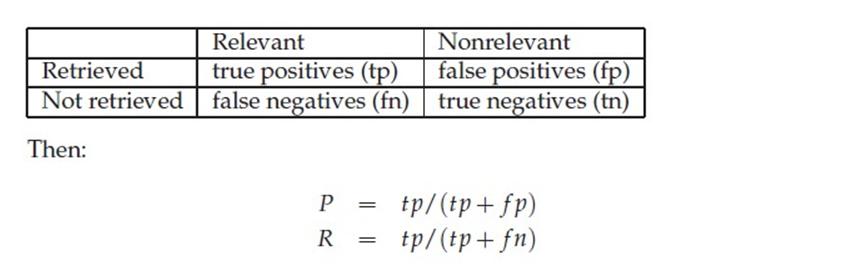

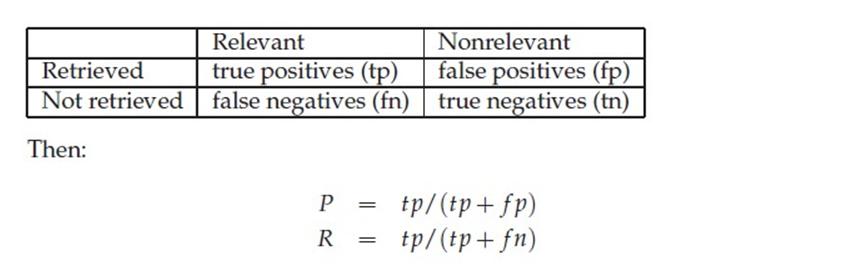

通俗的讲,Precision 就是检索出来的条目中(比如网页)有多少是准确的,Recall就是所有准确的条目有多少被检索出来了。

下面这张图介绍True Positive,False Negative等常见的概念,P和R也往往和它们联系起来。

阅读全文

通俗的讲,Precision 就是检索出来的条目中(比如网页)有多少是准确的,Recall就是所有准确的条目有多少被检索出来了。

下面这张图介绍True Positive,False Negative等常见的概念,P和R也往往和它们联系起来。

阅读全文

通俗的讲,Precision 就是检索出来的条目中(比如网页)有多少是准确的,Recall就是所有准确的条目有多少被检索出来了。

下面这张图介绍True Positive,False Negative等常见的概念,P和R也往往和它们联系起来。

阅读全文

通俗的讲,Precision 就是检索出来的条目中(比如网页)有多少是准确的,Recall就是所有准确的条目有多少被检索出来了。

下面这张图介绍True Positive,False Negative等常见的概念,P和R也往往和它们联系起来。

阅读全文

摘要:

Linear Discriminant Analysis (也有叫做Fisher Linear Discriminant)是一种有监督的(supervised)线性降维算法。与PCA保持数据信息不同,LDA是为了使得降维后的数据点尽可能地容易被区分!

假设原始数据表示为X,(m*n矩阵,m是维度,n是sample的数量)

既然是线性的,那么就是希望找到映射向量a, 使得 a‘X后的数据点能够保持以下两种性质:

1、同类的数据点尽可能的接近(within class)

2、不同类的数据点尽可能的分开(between class)

来看一个例子:两堆点会这样被降维 阅读全文

摘要:

机器学习领域中所谓的降维就是指采用某种映射方法,将原高维空间中的数据点映射到低维度的空间中。降维的本质是学习一个映射函数 f : x->y,其中x是原始数据点的表达,目前最多使用向量表达形式。 y是数据点映射后的低维向量表达,通常y的维度小于x的维度(当然提高维度也是可以的)。f可能是显式的或隐式的、线性的或非线性的。

Principal Component Analysis(PCA)是最常用的线性降维方法,它的目标是通过某种线性投影,将高维的数据映射到低维的空间中表示,并期望在所投影的维度上数据的方差最大,以此使用较少的数据维度,同时保留住较多的原数据点的特性。 阅读全文