完整教程:第四章:大模型(LLM)】07.Prompt工程-(9)prompt 优化

第四章:大模型(LLM)

第七部分:Prompt 工程

第九节:Prompt 优化

Prompt 优化(Prompt Optimization)是提升大模型性能与输出质量的关键环节。即便是同样的问题,不同的提示词设计也可能导致完全不同的回答效果。通过系统化的优化方法,许可让模型更稳定、更准确、更符合预期地完成任务。

一、Prompt 优化的目标

提升准确性:减少模型生成错误或偏离主题的内容。

增强稳定性:避免相同任务在多次调用时输出差异过大。

提高效率:减少模型试错次数,节省计算资源。

可控性:使输出更符合用户的风格、格式、语气等要求。

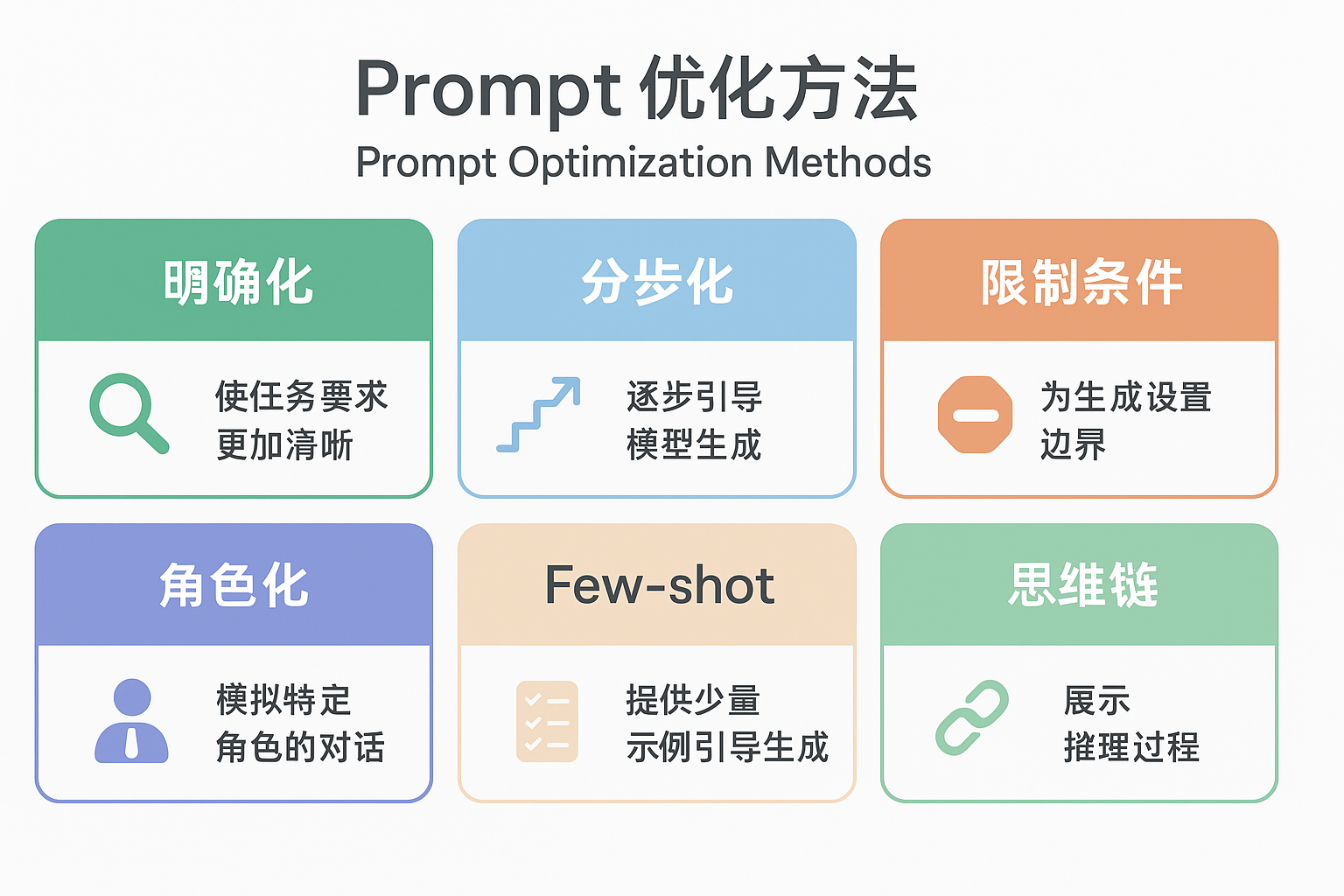

二、常见的 Prompt 优化方法

1. 明确化(Clarity)

将模糊的任务指令转化为清晰、具体的描述。

示例:

❌ “写一个故事。”

✅ “写一个 300 字的儿童故事,主角是一只勇敢的小狐狸,故事要有开头、发展和结尾。”

2. 分步化(Step-by-step)

引导模型逐步完成复杂任务,而不是一次性要求完整答案。

示例:

❌ “请给我一个商业计划书。”

✅ “第一步:请先输出商业计划书的目录结构。”

3. 限制条件(Constraints)

为模型输出增加边界条件,避免结果过于随意。

示例:

✅ “请用 5 个要点总结这篇文章,每个要点不超过 15 个字。”

4. 角色化(Role prompting)

通过指定身份来优化输出风格和质量。

示例:

✅ “假设你是一位专业医生,请用通俗的语言解释‘高血压’。”

5. Few-shot 示例优化

在 Prompt 中提供正反例子,让模型学习如何生成期望的输出。

示例:

示例 1: 输入:1+1 输出:2 示例 2: 输入:3+2 输出:5 现在请回答:5+7

6. 思维链 + 自洽性优化(CoT + Self-consistency)

先让模型展示推理过程,再通过多次生成对比结果取最优答案,提升可靠性。

三、Prompt 优化的迭代流程

初始设计:根据需求写出第一个版本 Prompt。

测试反馈:运行并观察模型输出。

问题诊断:找出输出中的偏差点(如逻辑错误、缺少细节等)。

优化改写:增加限制条件、分步描述或示例。

再次测试:循环迭代,直到结果符合预期。

四、应用与自动化优化

目前已有一些工具和途径帮助实现 Prompt 优化:

Prompt 自动搜索:利用算法尝试不同 Prompt 组合,找到最佳效果。

人机协作优化:由人工提供反馈,模型自动改写 Prompt。

RLHF(人类反馈强化学习):通过用户反馈不断优化模型响应。

五、小结

Prompt 优化是一个迭代与实验驱动的过程。经过明确化、分步化、限制条件、角色提示与示例引导等途径,可以显著提升大模型的回答质量和稳定性。在实际应用中,结合自动化应用与人类反馈,可以持续改进 Prompt,使其更贴合任务目标。

浙公网安备 33010602011771号

浙公网安备 33010602011771号