吴恩达-卷积神经网络

1、灰度图像,边缘检测, 使用核函数的缺点,图像的向量会不断的缩小,另外一个就是边缘的向量相比于中间的向量被覆盖的次数会少很多。解决这个的方法就是padding在图像的周围再添加一圈向量。

2、核函数通常是奇数维向量

3、卷积层,

池化层:选出某一区域的最大值,另外还有 平均池化,就是求一个小区域的均值

,全连接层:类似于普通的神经网络,将最后的比如120*1的列向量全连接映射到80*1的列向量上

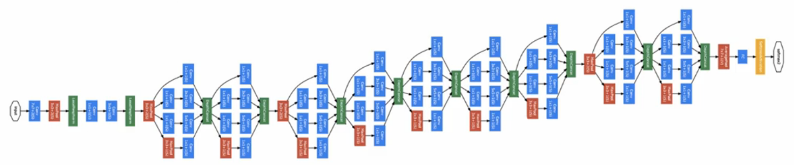

4、通常是一个卷积层后面跟一个池化层,然后有多个卷积层和池化层,也可以多个卷积层后跟一个池化层。最后加上几个全连接层,最后再加上softmax函数等。

5、卷积神经网络的作用,简而言之就是在保持图片特征的前提下,缩小图片所含的元素,这个可以从向量逐渐变小看出来。这样也能减少神经网络所需要的参数,以便整个网络的快速形成。

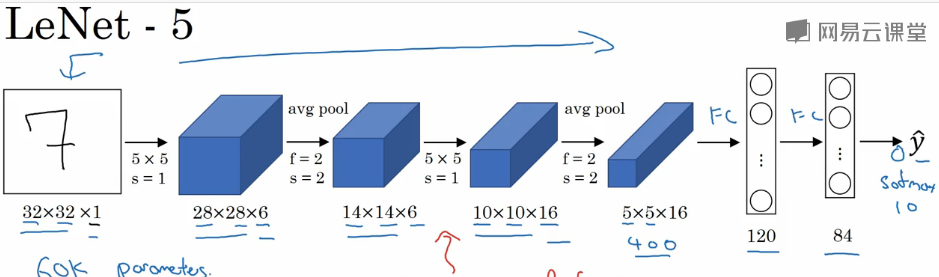

6、le NET-5:针对灰度图训练出来的:

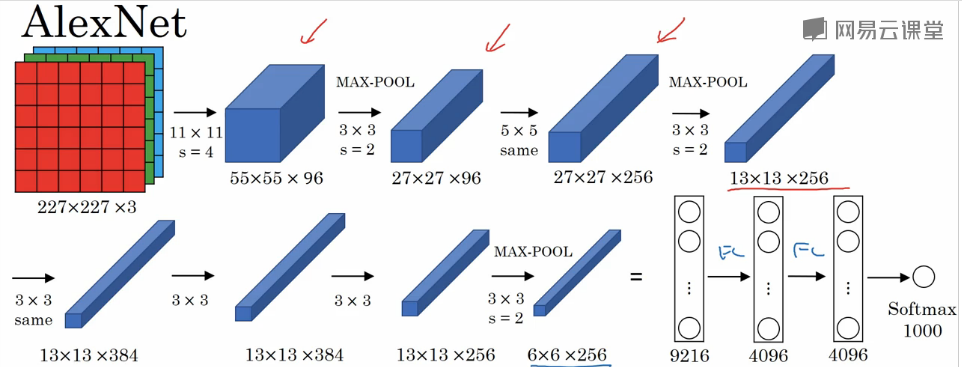

7、AlexNet:

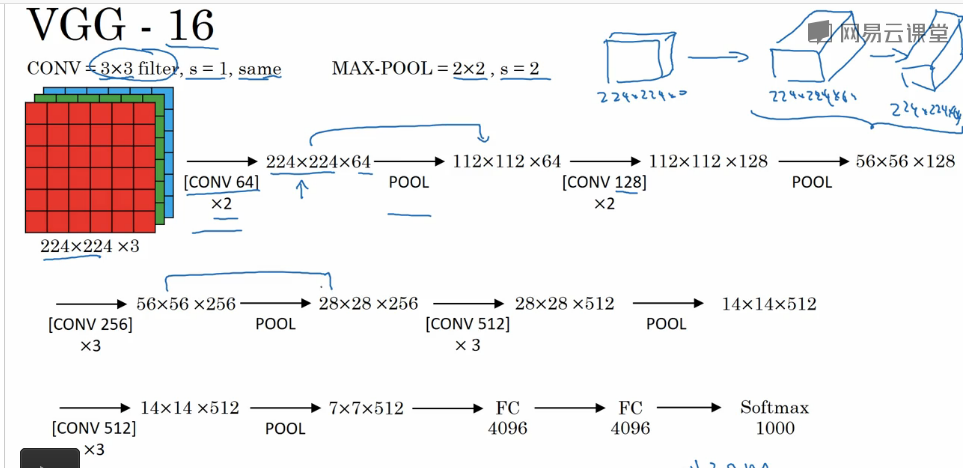

8、vgg-16:

9、ResNets:残差网络

在第二层进行激活函数之前加上第一层的输入,一起输入到激活函数里。来运算。普通的网络随着层数的增加,训练错误也会增加,因此误差刚开始随着层数的增加,逐渐降低,但是当达到一定层数之后,误差就会逐渐升高,但是残差网络有助于改善这一情况。并且会减弱梯度爆炸以及梯度消失的情况。

10、1*1的卷积核可以帮助压缩图像的信道,即厚度

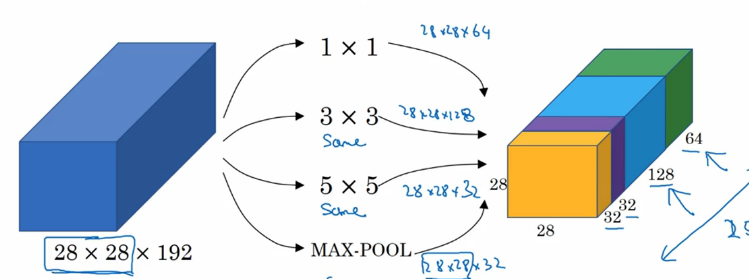

11、inception网络:

训练参数来决定使用哪一个卷积层,即给每个卷积层或者池化层加上权重,然后训练网络,让网络来决定使用哪一个卷积层,1*1可以减小计算规模,即在一般的卷积话层之间先加一个1*1的卷积层,过度一下(有时也称为瓶颈层,因为是利用1*1先缩小厚度,然后再使用卷积层增加到目标厚度,这样一层化为两层,原来的乘法运算被划为先分乘,再加在一起)。

12、inception网络:

13、迁移学习,当数据量非常小时,将前面的层冻结起来,只训练最后一层,或者冻结前面部分的层,训练后面一部分的层的参数,如果数据量大时,也可以使用别人训练好的参数作为初始化的参数,然后再来训练所有的层

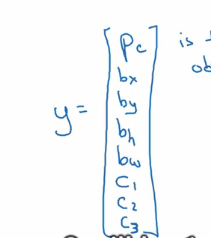

14、目标检测:目标检测中y被定义为一个含有坐标的标签:

15、yolo算法,

16、交并比:lou

17、anchor box

18、R-CNN:区域卷积神经网络,

浙公网安备 33010602011771号

浙公网安备 33010602011771号