《统计学习方法》笔记四 朴素贝叶斯法

本系列笔记内容参考来源为李航《统计学习方法》

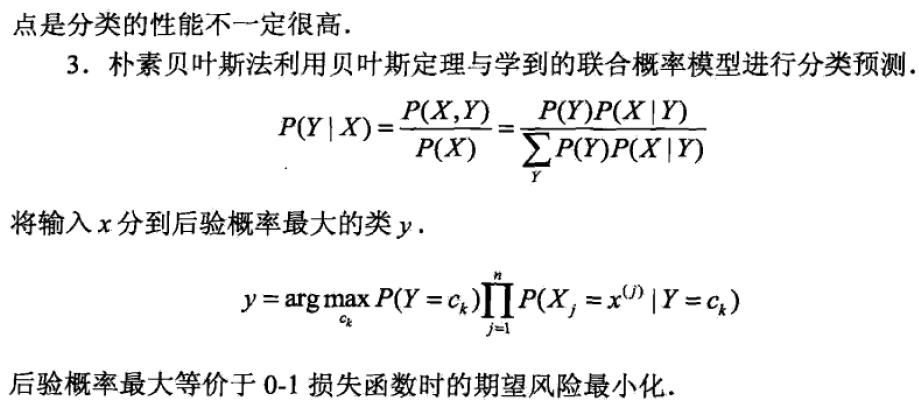

朴素贝叶斯(navie Bayes)法是基于贝叶斯定理与特征条件独立假设的分类方法。对于给定的训练数据集,首先基于特征条件独立假设学习输入/输出的联合概率分布;然后基于此模型,对给定的输入x,利用贝叶斯定理求出后验概率最大的输出y。

知识概要

公式推导

给定训练数据集,其中每个样本都包括n维特征,即,类标记集合yi∈Y={c1,c2,...ck},给定输出x,我们要判断它属于哪个类别的概率最大,也即要求最大后验概率P(Y|X)→采用贝叶斯定理

我们可知先验概率分布:

P(Y = ck) , k=1,2,...K

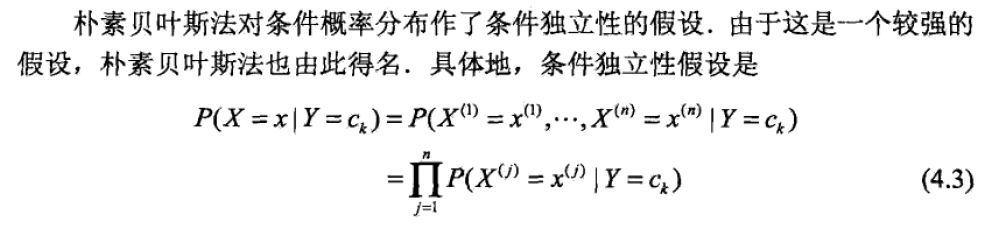

条件概率分布P(X = x | Y = ck) = P(X(1) = x(1),...X(n) = x(n) | Y = ck), k=1,2,...K

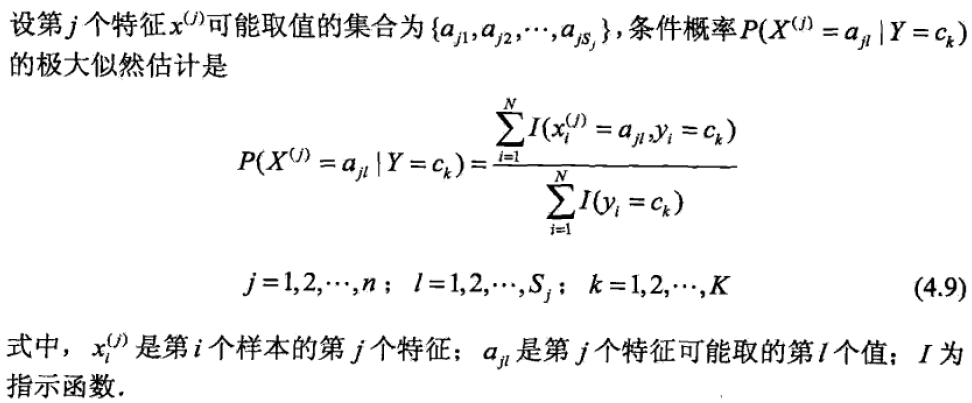

但条件概率分布有指数级数量的参数,假设x(j) 可取值有Sj个,j取值范围为1-n,共有K个类,则参数个数为![]()

这样,参数规模降维∑i=1nSiK

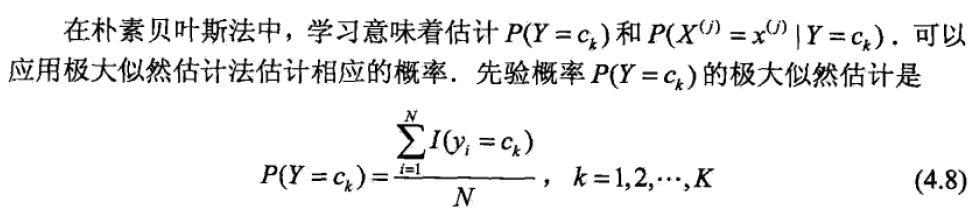

朴素贝叶斯法的参数估计

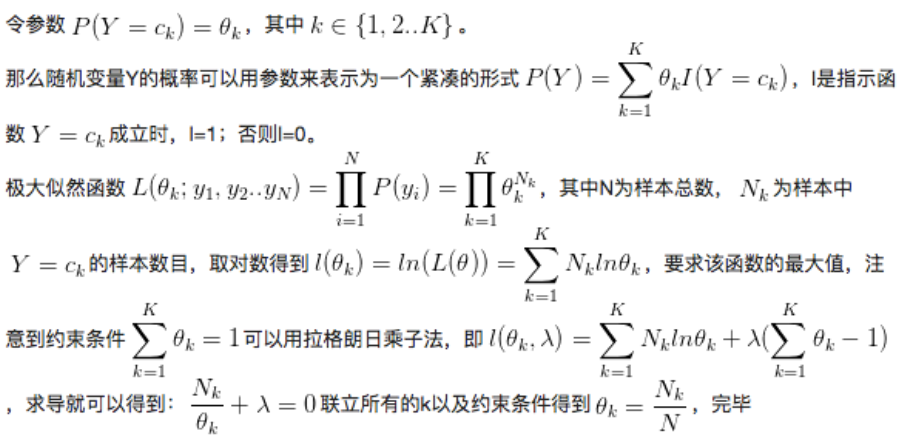

极大似然估计

证明如下

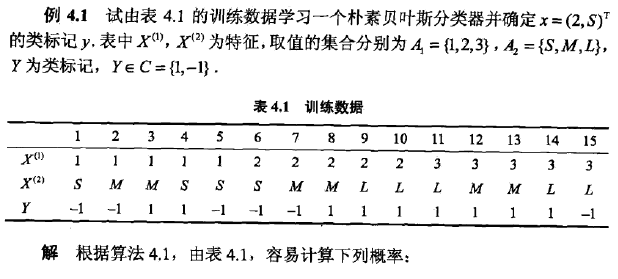

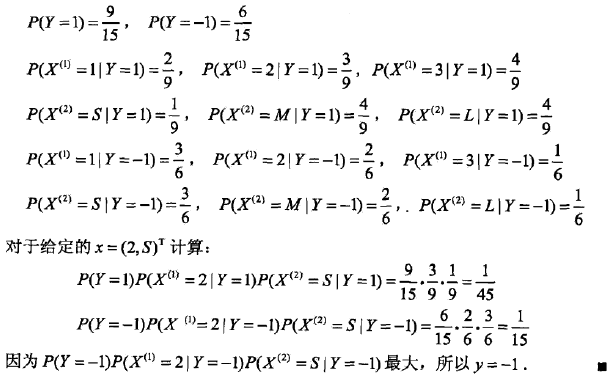

课本中的例子如下

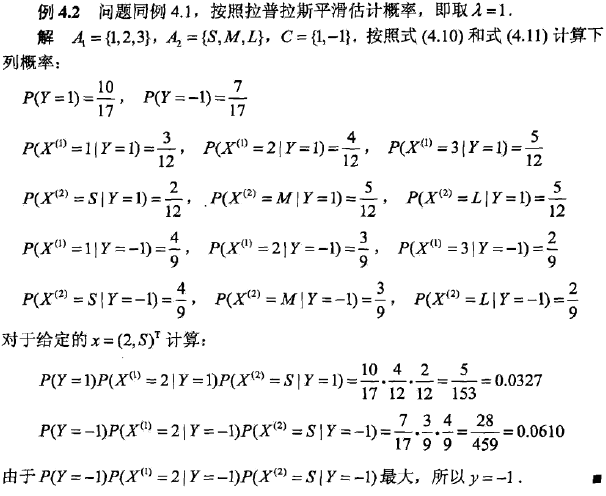

贝叶斯估计

极大似然估计可能会出现所要估计的概率值为0的情况,例如上述X1的取值为1,2,3,但不代表真实数据中就没有这样的组合,这会影响到后验概率的计算结果,使分类产生偏差。

条件概率的贝叶斯估计是:Sj表示xj可能取值的中数。

浙公网安备 33010602011771号

浙公网安备 33010602011771号