为什么大厂都在用 Dify?因为他们早就不自己造轮子了

大厂的秘密:把精力花在刀刃上

最近和几个在大厂做AI产品的朋友聊天,发现一个有意思的现象:他们团队里几乎没人从零搭建LLM应用框架了。

问起原因,答案出奇一致——"我们是来解决业务问题的,不是来写胶水代码的。"

造轮子的隐性成本,比你想象的高

很多团队在立项初期都有个执念:自己写才放心。

但算一笔账就清醒了:

-

Prompt管理要写吧?

-

多模型调度要做吧?

-

RAG流程要搭吧?

-

对话记忆要存吧?

-

调试工具要有吧?

一个能用的LLM应用框架,至少2个资深后端干3个月。这还没算后续维护、适配新模型的工时。

而Dify把这些全做了——开箱即用的工作流编排、可视化Prompt调试、原生支持DeepSeek等主流模型。大厂用它不是因为自己做不了,是因为没必要做。

DeepSeek + Dify:性价比组合拳

这里要提一下DeepSeek。

很多团队之前重度依赖海外API,成本和延迟都是痛点。DeepSeek的出现提供了一个性能不错、成本可控的国产选项。

Dify原生集成DeepSeek,意味着什么?

切换模型只需要改个配置,业务代码一行不动。

这种灵活性在模型迭代如此快的今天,是实打实的商业价值。

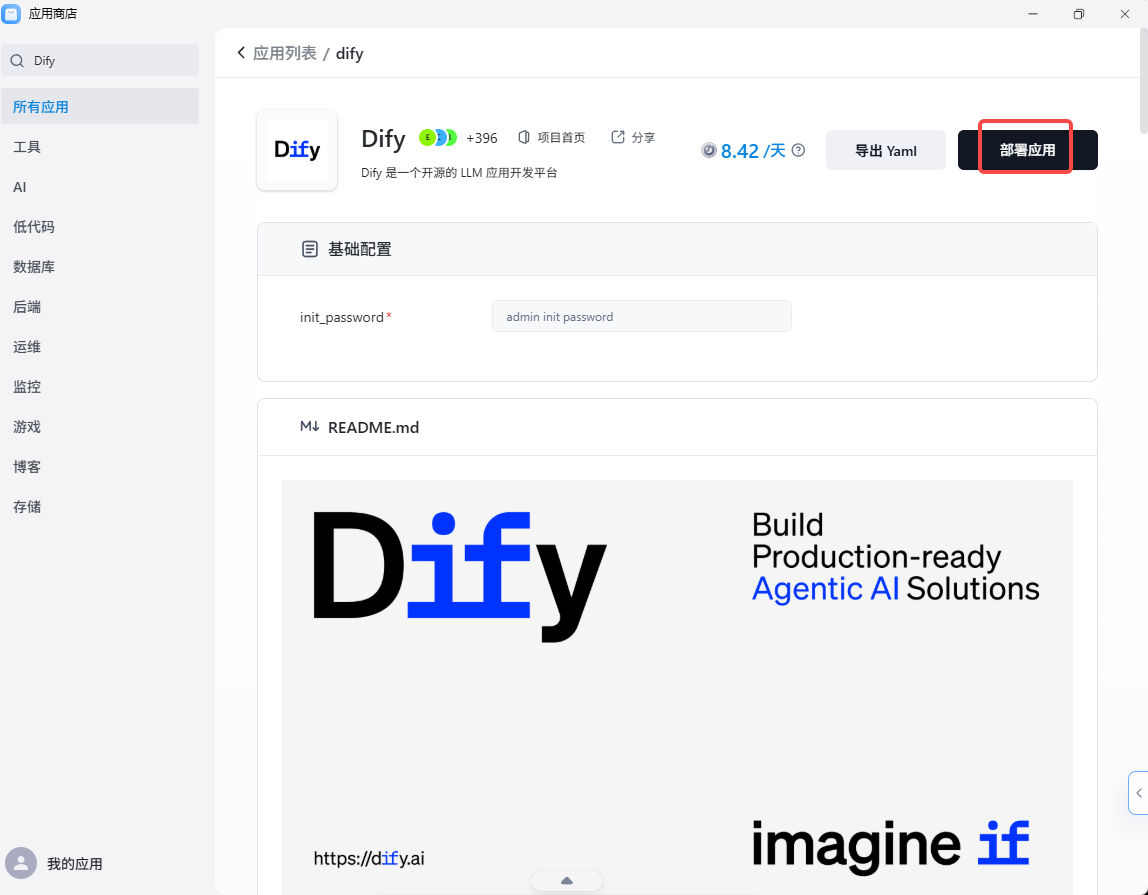

还有一个问题:Dify部署在哪?

很多人到这一步会卡住——Dify本身要部署、要运维、要弹性扩缩容。

这时候Sealos的价值就体现了。

在Sealos上部署Dify,几分钟搞定。底层是K8s,但你不用碰K8s。数据库、存储、网络,平台全托管。用多少付多少,没流量时成本趋近于零。

一句话总结这套组合:Dify管应用逻辑,DeepSeek管模型能力,Sealos管基础设施。

大厂的逻辑,值得小团队参考

大厂不自己造轮子,不是偷懒,是算得清账。

他们的核心竞争力在业务场景、数据积累、用户体验——而不是重复发明一个开源社区已经做得很好的框架。

小团队更应该想明白这件事。

你的时间,该花在用户愿意付费的地方。

浙公网安备 33010602011771号

浙公网安备 33010602011771号