Zookeeper实战整理

概念

zookeeper只是提供分布式协调服务。可以协调dubbo集群,也可以协调activeMQ集群。

服务提供者将服务注册到zookeeper上,消费者通过zookeeper找到提供者的地址,建立连接。

zookeeper与提供者和消费者建立长连接,一旦提供者上线或者下线,zookeeper会及时通知消费者变更服务列表。

消费者本地缓存提供者列表,然后根据自己的负载均衡策略进行调用。zookeeper本身没有内置负载均衡策略。

用zookeeper相对于nginx作负载均衡的好处在于:

1、当提供者节点数量众多的时候nginx的配置量会很大,zookeeper不用关心提供者的地址配置。

2、nginx服务器出现故障时,会导致服务不可用,而zookeeper的消费者本地缓存了提供者列表,可以暂时不影响使用。

zookeeper单节点配置

1、 /etc/hosts添加:

# zookeeper servers

192.168.128.128 edu-provider-01

其中edu-provider-01是一个名字,会跟后面zookeeper中的配置对应。

2、下载 zookeeper-3.4.6

wget http://apache.fayea.com/zookeeper/zookeeper-3.4.6/zookeeper-3.4.6.tar.gz

例如放到/root

3、 解压

tar -zxvf zookeeper-3.4.6.tar.gz

4、 在/root/zookeeper-3.4.6 目录下创建以下目录:

cd /root/zookeeper-3.4.6

mkdir data

mkdir logs

5、 将 zookeeper-3.4.6/conf 目录下的 zoo_sample.cfg 文件拷贝一份,命名为为 zoo.cfg

cp zoo_sample.cfg zoo.cfg

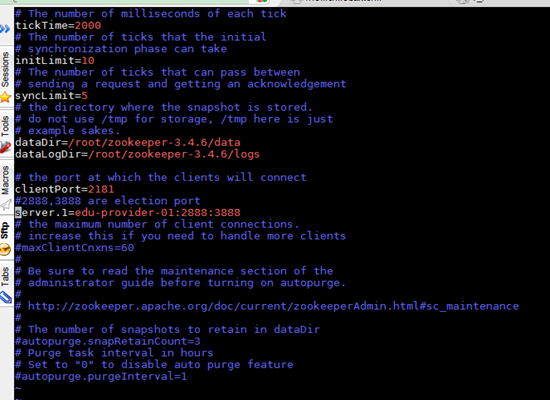

6、 修改 zoo.cfg 配置文件:

vi zoo.cfg

dataDir=/root/zookeeper-3.4.6/data

dataLogDir=/root/zookeeper-3.4.6/logs

# the port at which the clients will connect

clientPort=2181

#2888,3888 are election port

server.1=edu-provider-01:2888:3888

其中,

2888 端口号是 zookeeper 服务之间通信的端口。

3888 是 zookeeper 与其他应用程序通信的端口。

edu-provider-01 是在 hosts 中已映射了 IP 的主机名。

initLimit:这个配置项是用来配置 Zookeeper 接受客户端(这里所说的客户端不

是用户连接 Zookeeper 服务器的客户端,而是 Zookeeper 服务器集群中连接到

Leader 的 Follower 服务器)初始化连接时最长能忍受多少个心跳时间间隔数。

当已经超过 10 个心跳的时间(也就是 tickTime)长度后 Zookeeper 服务器还没

有收到客户端的返回信息,那么表明这个客户端连接失败。总的时间长度就是

5*2000=10 秒。

syncLimit:这个配置项标识 Leader 与 Follower 之间发送消息,请求和应答时

间长度,最长不能超过多少个 tickTime 的时间长度,总的时间长度就是 2*2000=4

秒。

server.A=B:C:D:其中 A 是一个数字,表示这个是第几号服务器;B 是这个服务

器的 IP 地址或/etc/hosts 文件中映射了 IP 的主机名;C 表示的是这个服务器与

集群中的 Leader 服务器交换信息的端口;D 表示的是万一集群中的 Leader 服务

器挂了,需要一个端口来重新进行选举,选出一个新的 Leader,而这个端口就是

用来执行选举时服务器相互通信的端口。如果是伪集群的配置方式,由于 B 都是

一样,所以不同的 Zookeeper 实例通信端口号不能一样,所以要给它们分配不同

的端口号。

7、 在 dataDir=/root/zookeeper-3.4.6/data 下创建 myid 文件

编辑 myid 文件,并在对应的 IP 的机器上输入对应的编号。如在 zookeeper 上,myid

文件内容就是 1。如果只在单点上进行安装配置,那么只有一个 server.1。

$ vi myid

1

8、 root 用户下修改 vi /root/.bash_profile,增加 zookeeper 配置:

# zookeeper env

export ZOOKEEPER_HOME=/root/zookeeper-3.4.6

export PATH=$ZOOKEEPER_HOME/bin:$PATH

使配置文件生效

$ source /root/.bash_profile

9、 在防火墙中打开要用到的端口 2181、2888、3888

切换到 root 用户权限,执行以下命令:

# chkconfig iptables on

# service iptables start

编辑/etc/sysconfig/iptables

# vi /etc/sysconfig/iptables

增加以下 3 行:

-A INPUT -m state --state NEW -m tcp -p tcp --dport 2181 -j ACCEPT

-A INPUT -m state --state NEW -m tcp -p tcp --dport 2888 -j ACCEPT

-A INPUT -m state --state NEW -m tcp -p tcp --dport 3888 -j ACCEPT

重启防火墙:

# service iptables restart

查看防火墙端口状态:

# service iptables status

Table: filter

Chain INPUT (policy ACCEPT)

num target prot opt source destination

1 ACCEPT all -- 0.0.0.0/0 0.0.0.0/0 state RELATED,ESTABLISHED

2 ACCEPT icmp -- 0.0.0.0/0 0.0.0.0/0

3 ACCEPT all -- 0.0.0.0/0 0.0.0.0/0

4 ACCEPT tcp -- 0.0.0.0/0 0.0.0.0/0 state NEW tcp dpt:22

5 ACCEPT tcp -- 0.0.0.0/0 0.0.0.0/0 state NEW tcp dpt:2181

6 ACCEPT tcp -- 0.0.0.0/0 0.0.0.0/0 state NEW tcp dpt:2888

7 ACCEPT tcp -- 0.0.0.0/0 0.0.0.0/0 state NEW tcp dpt:3888

8 REJECT all -- 0.0.0.0/0 0.0.0.0/0 reject-with icmp-host-prohibited

Chain FORWARD (policy ACCEPT)

num target prot opt source destination

1 REJECT all -- 0.0.0.0/0 0.0.0.0/0 reject-with icmp-host-prohibited

Chain OUTPUT (policy ACCEPT)

num target prot opt source destination

10、 启动并测试 zookeeper(要用 wusc 用户启动,不要用 root):

(1) 使用 root 用户到/root/zookeeper-3.4.6/bin 目录中执行:

$ zkServer.sh start

(2) 输入 jps 命令查看进程:

$ jps

1456 QuorumPeerMain

1475 Jps

其中,QuorumPeerMain 是 zookeeper 进程,启动正常

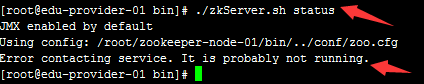

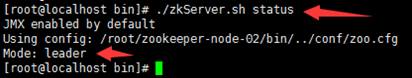

(3) 查看状态:

$ zkServer.sh status

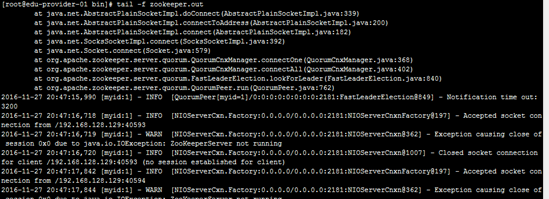

(4) 查看 zookeeper 服务输出信息:

由于服务信息输出文件在/root/zookeeper-3.4.6/bin/zookeeper.out

$ tail -500f zookeeper.out

11、 停止 zookeeper 进程:

$ zkServer.sh stop

12、 配置 zookeeper 开机使用 root 用户启动:

编辑/etc/rc.local 文件,加入:

su - root -c '/root/zookeeper-3.4.6/bin/zkServer.sh start'

服务端:

<?xml version="1.0" encoding="UTF-8"?>

<beans xmlns="http://www.springframework.org/schema/beans"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xmlns:dubbo="http://code.alibabatech.com/schema/dubbo"

xsi:schemaLocation="http://www.springframework.org/schema/beans

http://www.springframework.org/schema/beans/spring-beans.xsd

http://code.alibabatech.com/schema/dubbo

http://code.alibabatech.com/schema/dubbo/dubbo.xsd"

>

<bean id="testService" class="com.test.client.impl.TestServiceImpl" />

<dubbo:application name="test_server" />

<dubbo:registry protocol="zookeeper" address="192.168.128.128:2181" />

<dubbo:protocol name="dubbo" port="20880" />

<dubbo:service interface="com.test.client.TestService" ref="testService" />

</beans>

客户端:

<?xml version="1.0" encoding="UTF-8"?>

<beans xmlns="http://www.springframework.org/schema/beans"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xmlns:dubbo="http://code.alibabatech.com/schema/dubbo"

xsi:schemaLocation="http://www.springframework.org/schema/beans

http://www.springframework.org/schema/beans/spring-beans.xsd

http://code.alibabatech.com/schema/dubbo

http://code.alibabatech.com/schema/dubbo/dubbo.xsd

">

<dubbo:application name="hehe_consumer" />

<dubbo:registry protocol="zookeeper" address="192.168.128.128:2181" />

<dubbo:reference id="testServer" interface="com.test.client.TestService"/>

</beans>

服务端需要加入zkclient-0.3.jar、slf4j-api-1.7.12.jar

zookeeper集群

概念

zookeeper集群作用是高可用,在一些zookeeper节点挂掉以后,其他节点仍能使用。

zookeeper集群需要大于一半的节点可用,整个集群才可用,因此建议节点数为奇数。

节点在不同服务器上的集群才是真实的集群,节点在同一服务器上的是伪集群。

集群有一个节点是leader,其他都是follower,当leader挂掉后,会自动从其他follower中选举出一个作为leader。

安装:

这里用了3台服务器,129、130、131,端口分别是2181,2182,2183,其实目录端口可以一样,只是为了以后方便迁移(迁移到同一台服务器上的伪集群等)。伪集群迁移只需要将整个zookeeper目录拷贝过来启动即可。

1、在3台服务器上都配置host

vim /etc/hosts

192.168.128.129 edu-provider-01

192.168.128.130 edu-provider-02

192.168.128.131 edu-provider-03

与后面配置的zoo.cfg中server.A=B:C:D的B对应

2、将zookeeper-3.4.6.tar.gz分别放到3台服务器的用户~目录,解压

cd ~

tar -zxf zookeeper-3.4.6.tar.gz

分别重命名

129:

mv zookeeper-3.4.6 zookeeper-node-01

130:

mv zookeeper-3.4.6 zookeeper-node-02

131:

mv zookeeper-3.4.6 zookeeper-node-03

3、分别创建data和logs目录

129:

mkdir ~/zookeeper-node-01/data

mkdir ~/zookeeper-node-01/logs

130:

mkdir ~/zookeeper-node-02/data

mkdir ~/zookeeper-node-02/logs

131:

mkdir ~/zookeeper-node-03/data

mkdir ~/zookeeper-node-03/logs

4、将 zookeeper/node-0X/conf 目录下的 zoo_sample.cfg 文件拷贝一份,命名为 zoo.cfg

cp zoo_sample.cfg zoo.cfg

5、修改zoo.cfg

129:

tickTime=2000

initLimit=10

syncLimit=5

dataDir=/root/zookeeper-node-01/data

dataLogDir=/root/zookeeper-node-01/logs

clientPort=2181

server.1=edu-provider-01:2881:3881

server.2=edu-provider-02:2882:3882

server.3=edu-provider-03:2883:3883

130:

tickTime=2000

initLimit=10

syncLimit=5

dataDir=/root/zookeeper-node-02/data

dataLogDir=/root/zookeeper-node-02/logs

clientPort=2182

server.1=edu-provider-01:2881:3881

server.2=edu-provider-02:2882:3882

server.3=edu-provider-03:2883:3883

131:

tickTime=2000

initLimit=10

syncLimit=5

dataDir=/root/zookeeper-node-03/data

dataLogDir=/root/zookeeper-node-03/logs

clientPort=2183

server.1=edu-provider-01:2881:3881

server.2=edu-provider-02:2882:3882

server.3=edu-provider-03:2883:3883

参数说明:

tickTime=2000

tickTime 这个时间是作为 Zookeeper 服务器之间或客户端与服务器之间维持心跳的时间间隔,也就是每

个 tickTime 时间就会发送一个心跳。

initLimit=10

initLimit 这个配置项是用来配置 Zookeeper 接受客户端(这里所说的客户端不是用户连接 Zookeeper服务器的客户端,而是 Zookeeper 服务器集群中连接到 Leader 的 Follower 服务器)初始化连接时最长能忍受多少个心跳时间间隔数。当已经超过 10 个心跳的时间(也就是 tickTime)长度后 Zookeeper 服务器还没有收到客户端的返回信息,那么表明这个客户端连接失败。总的时间长度就是 10*2000=20 秒。

syncLimit=5

syncLimit 这个配置项标识 Leader 与 Follower 之间发送消息,请求和应答时间长度,最长不能超过多少个 tickTime 的时间长度,总的时间长度就是 5*2000=10 秒。

dataDir=/home/wusc/zookeeper/node-01/data

dataDir 顾名思义就是Zookeeper 保存数据的目录,默认情况下Zookeeper 将写数据的日志文件也保存在这个目录里。

clientPort=2181

clientPort 这个端口就是客户端(应用程序)连接 Zookeeper 服务器的端口,Zookeeper 会监听这个端口接受客户端的访问请求。

server.A=B:C:D

server.1=edu-zk-01:2881:3881

server.2=edu-zk-02:2882:3882

server.3=edu-zk-03:2883:3883

A 是一个数字,表示这个是第几号服务器;

B 是这个服务器的 IP 地址(或者是与 IP 地址做了映射的主机名);

C 第一个端口用来集群成员的信息交换,表示这个服务器与集群中的 Leader 服务器交换信息的端口;

D 是在 leader 挂掉时专门用来进行选举 leader 所用的端口。

注意:如果是伪集群的配置方式,不同的 Zookeeper 实例通信端口号不能一样,所以要给它们分配不同的端口号。

6、分别创建myid文件,写入数字

129 #值为1:

vim ~/zookeeper-node-01/data/myid

130 #值为2:

vim ~/zookeeper-node-02/data/myid

131 #值为3:

vim ~/zookeeper-node-03/data/myid

内容的数字对应了前面的server.A=B:C:D中的A

7、启动、测试

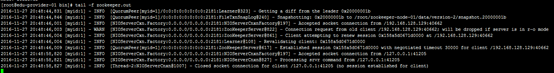

只启动129时:

./zkServer.sh start

此时可用节点少于一半,整个集群不可用,

tail -f zookeeper.out会看到每隔几秒就会打印尝试连接日志。

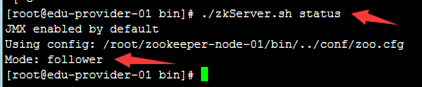

启动130后:

集群可用,且:

129成了follower

130成了leader

查看日志也不再一直重连了

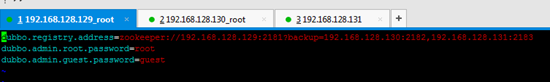

8、管理控制台调整

管理控制台连接zookeeper集群采用如下配置:

vim /usr/local/apache-tomcat-6.0.45_dubbo_manager/webapps/ROOT/WEB-INF/dubbo.properties

dubbo.registry.address=zookeeper://192.168.128.129:2181?backup=192.168.128.130:2182,192.168.128.131:2183

9、应用程序连zookeeper集群注册中心

用逗号分隔即可,如:

#zookeeper

zookeeper_server=192.168.128.129:2181,192.168.128.130:2182,192.168.128.131:2183

多套注册中心之间用|分隔,如:

zookeeper_server=192.168.128.128:2181|192.168.128.129:2181,192.168.128.130:2182,192.168.128.131:2183

10、zookeeper高可用概念

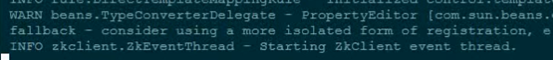

应用程序dubbo和zookeeper之间的连接是长连接,应用程序dubbo接口之间的连接也是长连接。

当zookeeper可用节点数不超过一半时,整个集群不可用,应用程序无法启动。但如果zookeeper集群是在应用程序启动之后才不可用,不影响应用程序之间的dubbo调用,但应用程序会一直尝试连接zookeeper注册中心。

管理控制台本身也是dubbo消费端,因此zookeeper集群不可用时,管理控制台无法启动,停留在这里

。

。

但如果zookeepter集群是在管理控制台启动后不可用的,管理控制台依然可以访问。

浙公网安备 33010602011771号

浙公网安备 33010602011771号