100个GPU基础技术(收藏版)杂谈

在当今数字化时代,GPU(图形处理单元)已成为推动众多前沿技术发展的关键力量。从最初专为加速图形渲染而设计,到如今广泛应用于深度学习、科学计算、加密货币挖掘等多个领域,GPU 凭借其强大的并行计算能力,为各类复杂任务提供了高效的解决方案。本文将系统地梳理 100 个 GPU 基础知识,涵盖其定义、架构、性能指标、应用领域、与其他技术的对比等多个方面,帮助读者全面深入地了解 GPU 这一重要的技术领域。

一、GPU 基础定义与概念

1.GPU 的全称:GPU 的全称是 Graphics Processing Unit,即图形处理单元,是一种专门用于处理图形和图像相关任务的微处理器。它最初设计目的是为了加速计算机图形渲染,使图像显示更加流畅和逼真。

2.GPU 的起源:上世纪90 年代,随着个人游戏和计算机辅助设计(CAD)的兴起,对图形处理速度和效率提出了更高要求。传统的中央处理单元(CPU)在图形处理方面逐渐力不从心,于是 GPU 应运而生。第一个现代意义上的 GPU 是由英伟达(NVIDIA)在 1999 年推出的 GeForce 256,它将多边形转换、光照处理等功能集成到硬件中,大大提高了图形处理速度。

3.GPU 在计算机系统中的位置:在个人电脑中,GPU 通常以独立显卡的形式安装在主板的 PCI - Express 插槽上。对于一些笔记本电脑或追求轻薄的设备,也有将 GPU 集成在主板芯片组或 CPU 中的情况,分别称为集成显卡和核心显卡。在数据中心等大型计算环境中,GPU 则以专门的加速卡形式存在,通过高速互联技术与服务器的 CPU 协同工作。

4.GPU 与显卡的关系:显卡是一个包含GPU、显存、散热模块、供电模块等组件的完整硬件设备。GPU 是显卡的核心部件,负责图形计算和处理;显存用于存储图形数据;散热模块保证 GPU 在高负载运行时的温度稳定;供电模块为整个显卡提供电力支持。可以说,GPU 是显卡实现图形处理功能的关键所在。

5.GPU 在不同设备中的应用:在个人电脑上,GPU 主要用于游戏、图形设计、视频编辑等场景,提供高质量的图形渲染效果。在游戏机中,GPU 是实现游戏画面流畅运行和精美画质的核心,例如索尼 PlayStation 和微软 Xbox 系列游戏机都配备了定制的高性能 GPU。在移动设备如平板电脑和智能手机中,GPU 负责处理屏幕显示内容、运行图形密集型应用(如 3D 游戏)以及加速视频解码等,提升用户的视觉体验。

6.GPU 的主要功能:除了图形渲染外,GPU 还具有通用计算能力。在图形渲染方面,它负责处理 3D 模型的顶点变换、光照计算、纹理映射、光栅化等操作,将虚拟的 3D 场景转换为屏幕上的 2D 图像。在通用计算领域,GPU 能够加速深度学习模型训练、科学计算(如分子模拟、流体力学计算)、数据加密和解密等任务,通过并行计算大量数据来提高计算效率。

7.GPU 的基本工作流程:当计算机需要进行图形处理时,CPU 首先将相关的图形数据和指令发送给 GPU。GPU 接收到数据和指令后,在其内部的多个核心中并行执行计算任务,例如对顶点数据进行变换、对像素进行着色等。计算完成后,GPU 将处理后的图形数据存储在显存中,最后通过显示接口将显存中的数据输出到显示器上,呈现出最终的图像。

8.GPU 与 CPU 的设计差异:CPU 的设计侧重于复杂指令的串行处理,拥有强大的控制单元和较少但高性能的核心,能够灵活地处理各种类型的任务,但在面对大规模并行计算时效率较低。而 GPU 则设计了大量的简单核心,专注于并行计算,通过同时处理大量数据来提高整体计算速度,适合处理高度并行化的任务,如图形渲染和深度学习中的矩阵运算,但在处理复杂逻辑控制和串行任务时不如 CPU。

9.GPU 的分类:从应用场景角度,GPU 可分为游戏 GPU、专业图形 GPU、计算 GPU。游戏 GPU 注重图形渲染性能和游戏特效支持,如 NVIDIA GeForce 系列;专业图形 GPU 针对 CAD、3D 建模、动画制作等专业领域,强调对专业软件的优化和高精度图形处理,像 NVIDIA Quadro 系列;计算 GPU 则主要用于科学计算、深度学习等领域,以强大的并行计算能力为核心,例如 NVIDIA Tesla 系列。从硬件形式上,有独立 GPU(dGPU)、集成 GPU(iGPU)和虚拟 GPU(vGPU)。独立 GPU 是独立于 CPU 的单独硬件设备,性能强劲;集成 GPU 集成在主板或 CPU 中,成本低但性能较弱;虚拟 GPU 是通过软件虚拟化技术在云环境中模拟出来的 GPU,可实现资源共享和灵活分配。

10.GPU 核心的含义:GPU 核心是 GPU 中负责执行计算任务的基本单元,也被称为流处理器(Stream Processor,SP)或 CUDA 核心(NVIDIA GPU 中对部分核心的称呼)。众多的 GPU 核心并行工作,使得 GPU 能够同时处理大量的数据,从而实现高效的并行计算。不同型号的 GPU,其核心数量差异很大,从几百个到数千个不等,核心数量通常是衡量 GPU 计算能力的重要指标之一。

二、GPU 架构相关知识

1.GPU 架构的定义:GPU 架构是指 GPU 的硬件设计和组织方式,它决定了 GPU 的计算能力、性能表现、功耗以及对不同类型任务的处理效率。一个良好的 GPU 架构能够充分发挥 GPU 的并行计算优势,高效地处理图形渲染、通用计算等各类任务。

2.NVIDIA 的主要 GPU 架构:NVIDIA 推出了一系列具有代表性的 GPU 架构,如 Fermi 架构开启了 GPU 通用计算的新时代,引入了统一的 CUDA 核心架构;Kepler 架构在性能和能效比上有显著提升,增强了对双精度计算的支持;Maxwell 架构进一步优化了能耗比,同时改进了内存子系统;Pascal 架构增加了对深度学习的硬件加速支持,引入了张量核心(Tensor Core);Volta 架构在深度学习训练性能上有重大突破,进一步提升了张量核心的性能;Turing 架构强化了光线追踪技术,为游戏和专业图形领域带来更逼真的光影效果;Ampere 架构在计算性能、显存带宽等方面继续提升,广泛应用于数据中心、AI 训练等领域;Ada Lovelace 架构则进一步提升了光线追踪和深度学习性能,为 4K 及以上分辨率的游戏和复杂 AI 任务提供强大支持。

3.AMD 的主要 GPU 架构:AMD 的 GPU 架构也在不断发展,如 GCN(Graphics Core Next)架构具有高度并行的计算单元,在通用计算和图形处理方面都有良好表现,被广泛应用于 AMD 的多个产品系列中。RDNA(Radeon DNA)架构是 AMD 针对游戏市场推出的全新架构,它通过优化计算单元、提升时钟频率和改进显存管理等方式,显著提高了 GPU 的性能和能效比。RDNA 2 架构在此基础上进一步升级,引入了硬件加速光线追踪技术和可变速率着色等先进特性,提升了游戏的视觉效果和性能表现。

4.GPU 架构中的计算单元:计算单元是GPU 架构的核心组成部分,不同架构的计算单元在设计和功能上有所差异。以 NVIDIA 的 GPU 为例,其计算单元通常由多个流处理器(CUDA 核心)组成,这些流处理器可以并行执行相同的指令,对数据进行计算。在 AMD 的 GPU 中,计算单元被称为计算单元(Compute Unit,CU),每个 CU 包含多个流处理器,负责执行图形和计算任务。计算单元的数量和性能直接影响 GPU 的整体计算能力。

5.纹理单元在GPU 架构中的作用:纹理单元是GPU 架构中专门用于处理纹理映射的组件。在图形渲染中,纹理是一种用于给物体表面添加细节和颜色的图像数据。纹理单元负责从显存中读取纹理数据,并根据物体的几何形状和光照条件对纹理进行采样、过滤和变换等操作,最终将处理后的纹理应用到物体表面,使物体看起来更加真实和细腻。纹理单元的性能和数量会影响 GPU 在处理复杂纹理时的效率和质量。

6.光栅化单元的功能:光栅化单元是GPU 架构中负责将几何图形(如三角形、多边形等)转换为屏幕上像素的组件。在图形渲染过程中,经过顶点变换和光照计算后的几何图形数据被发送到光栅化单元。光栅化单元根据图形的位置和大小,确定其在屏幕上覆盖的像素区域,并计算每个像素的颜色值。这个过程涉及到对图形的边缘检测、像素插值等操作,最终生成可供显示器显示的图像。光栅化单元的性能对于图形渲染的速度和质量起着关键作用。

7.GPU 架构中的缓存机制:为了提高数据访问速度,GPU 架构中通常包含多级缓存。常见的有 L1 缓存和 L2 缓存。L1 缓存位于 GPU 核心内部,速度非常快,但容量相对较小,用于存储核心近期可能频繁访问的数据和指令。L2 缓存则位于多个核心共享的区域,容量较大,但速度略慢于 L1 缓存,它作为 L1 缓存的补充,存储更广泛的数据。缓存机制的存在减少了 GPU 核心对显存的直接访问次数,提高了数据读取和写入的效率,从而提升了 GPU 的整体性能。

8.GPU 架构对显存的支持:不同的GPU 架构对显存的类型、容量和带宽有不同的支持能力。高端的 GPU 架构通常支持更快的显存类型,如 GDDR6X,以满足其对高数据传输速率的需求。同时,为了处理大规模的图形数据或深度学习模型,一些 GPU 架构能够支持大容量的显存。此外,GPU 架构还通过优化显存控制器和内存访问算法,提高显存带宽的利用率,确保数据能够快速地在显存和 GPU 核心之间传输,避免因显存瓶颈而影响 GPU 性能。

9.GPU 架构的发展趋势:随着技术的不断进步,GPU 架构呈现出以下发展趋势。一是不断提高计算密度,增加更多的计算核心,同时优化核心设计,在不显著增加功耗的前提下提升计算能力。二是持续改进内存子系统,支持更高带宽、更低延迟的显存,以满足日益增长的数据传输需求。三是加强对新兴技术的支持,如光线追踪、人工智能计算等,通过硬件加速来提升相关应用的性能。四是注重能效比的提升,在降低能耗的同时保持甚至提高 GPU 的性能,以适应数据中心等大规模计算场景对节能的要求。

10.统一渲染架构的特点:统一渲染架构是一种在GPU 架构设计中的理念,它将传统 GPU 中用于顶点处理和像素处理的不同硬件单元进行整合,采用统一的计算单元来处理所有类型的图形渲染任务。这种架构的优点在于提高了硬件资源的利用率,因为统一的计算单元可以根据任务需求灵活分配,避免了顶点处理单元和像素处理单元在某些情况下的闲置。同时,统一渲染架构简化了 GPU 的设计和编程模型,使得开发者能够更方便地利用 GPU 的计算能力,提升了 GPU 在图形渲染和通用计算方面的灵活性和效率。

三、GPU 性能指标解读

1.核心频率:核心频率是指GPU 核心的工作频率,单位通常为 MHz 或 GHz。它类似于 CPU 的主频,反映了 GPU 核心在单位时间内能够执行的指令周期数。一般来说,核心频率越高,GPU 在相同时间内完成的计算任务就越多,图形处理或计算性能也就越强。但核心频率并非越高越好,过高的频率可能导致 GPU 发热严重,稳定性下降,因此需要在频率和稳定性、功耗之间进行平衡。不同型号的 GPU,其核心频率会有所不同,例如 NVIDIA GeForce RTX 3060 的基础核心频率可能在 1320MHz 左右,而在 Boost 模式下可以提升到 1777MHz。

2.显存频率:显存频率是指显存工作的频率,单位同样为MHz 或 GHz。它决定了显存与 GPU 核心之间数据传输的速度。显存频率越高,显存能够在单位时间内读写的数据量就越大,这对于需要快速处理大量图形数据的应用(如高分辨率游戏、专业图形设计)非常重要。常见的显存类型如 GDDR6,其频率可以达到 14GHz 甚至更高。与核心频率类似,显存频率也受到散热和稳定性等因素的限制,过高的频率可能引发数据传输错误。

3.显存位宽:显存位宽是指显存在一个时钟周期内能够传输的数据位数,单位为bit。它就像数据传输的通道宽度,位宽越大,一次能够传输的数据量就越多。例如,128bit 位宽的显存一次可以传输 16 字节的数据(128÷8 = 16),而 256bit 位宽的显存一次能传输 32 字节的数据。显存位宽与显存频率共同决定了显存带宽,在显存频率相同的情况下,位宽越大,显存带宽越高,GPU 的性能也就越好。常见的显存位宽有 64bit、128bit、256bit、384bit 和 512bit 等,一般高端 GPU 会采用较高的显存位宽,以满足其对高数据传输速率的需求。

4.显存带宽:显存带宽是衡量显存与GPU 核心之间数据传输速率的指标,单位为 GB/s。其计算公式为:显存带宽 = 显存频率 × 显存位宽 ÷ 8。例如,一款显存频率为 14GHz、位宽为 256bit 的显卡,其显存带宽为 14 × 256 ÷ 8 = 448GB/s。高显存带宽能够确保 GPU 核心在进行图形计算或通用计算时,能够快速地获取和存储数据,避免因数据传输延迟而导致计算单元闲置,从而提高 GPU 的整体性能。在处理高分辨率图像、复杂 3D 场景或大规模深度学习数据集时,高显存带宽尤为重要。

5.流处理器数量:流处理器是GPU 中负责执行计算任务的基本单元,其数量是衡量 GPU 计算能力的重要指标之一。不同厂商对其称呼可能有所不同,如 NVIDIA 称为 CUDA 核心。流处理器数量越多,GPU 在并行计算方面的能力就越强,能够同时处理的数据量也就越大。例如,NVIDIA GeForce RTX 3090 拥有高达 10496 个 CUDA 核心,相比一些中低端 GPU,其在图形渲染、深度学习训练等任务中能够展现出更强大的计算性能。在图形渲染中,大量的流处理器可以加速顶点变换、光照计算、纹理采样等操作;在深度学习中,能够快速处理矩阵乘法、卷积等核心运算。

6.纹理填充率:纹理填充率是指GPU 在单位时间内能够处理的纹理像素数量,单位为 GPixel/s(GigaPixels per second)。它反映了 GPU 在处理纹理映射这一图形渲染关键环节的能力。在图形渲染过程中,纹理填充率越高,GPU 能够在单位时间内将更多的纹理数据应用到物体表面,使物体的细节更加丰富,图像更加逼真。纹理填充率与 GPU 的纹理单元性能、核心频率以及显存带宽等因素密切相关。对于一些需要大量纹理处理的游戏或专业图形应用,高纹理填充率能够显著提升图像质量和渲染速度。

7.像素填充率:像素填充率是指GPU 在单位时间内能够绘制到屏幕上的像素数量,单位为 MPixel/s(MegaPixels per second)或 GPixel/s。它是衡量 GPU 光栅化性能的重要指标。在图形渲染的最后阶段,GPU 需要将经过顶点变换、光照计算和纹理映射等处理后的几何图形转换为屏幕上的像素,像素填充率越高,GPU 能够在单位时间内生成并输出到显示器的像素数量就越多,从而使图像更加流畅、清晰。高分辨率显示对像素填充率的要求更高,例如在 4K 分辨率(3840×2160)下,一帧图像包含超过 800 万个像素,需要 GPU 具备较高的像素填充率才能实现流畅的画面显示。

8.计算能力:GPU 的计算能力是一个综合指标,它反映了 GPU 在执行通用计算任务(如深度学习、科学计算)时的性能表现。计算能力不仅仅取决于流处理器数量、核心频率等硬件参数,还与 GPU 的架构设计、指令集支持、内存访问效率以及软件优化等因素密切相关。例如,NVIDIA 通过其 CUDA 平台定义了计算能力版本,不同版本的计算能力代表了 GPU 在不同方面的性能提升,如对双精度计算的支持、张量核心的性能等。计算能力较高的 GPU 在处理大规模数据并行计算任务时,能够以更快的速度完成计算,为深度学习模型训练、复杂科学模拟等应用提供强大的算力支持。

9.浮点运算能力(FLOPS):浮点运算能力(Floating - Point Operations Per Second),即每秒浮点运算次数,是衡量 GPU 计算性能的重要指标之一,特别是在科学计算和深度学习等领域。GPU 能够高效地执行浮点运算,如在深度学习中的矩阵乘法、卷积运算等都涉及大量的浮点运算。浮点运算能力通常以 GFLOPS(GigaFLOPS,每秒十亿次浮点运算)、TFLOPS(TeraFLOPS,每秒一万亿次浮点运算)或 PFLOPS(PetaFLOPS,每秒一千万亿次浮点运算)为单位。高端的 GPU,如 NVIDIA A100,其单精度浮点运算能力可达 19.5 TFLOPS,双精度浮点运算能力也能达到 1.4 TFLOPS,强大的浮点运算能力使其在复杂的科学计算和大规模深度学习模型训练中表现出色。

10.光线追踪性能:随着光线追踪技术的发展,光线追踪性能成为衡量GPU 性能的重要方面,尤其在游戏和专业图形领域。光线追踪技术通过模拟光线的传播和反射,能够生成更加真实的光影效果,如逼真的阴影、反射和折射。GPU 的光线追踪性能取决于其硬件对光线追踪算法的加速能力,包括光线追踪核心的数量和性能、对光线与物体相交测试的计算速度等。例如,NVIDIA 的 RTX 系列 GPU 专门引入了光线追踪核心(RT Core),能够显著提升光线追踪的速度和效果,让游戏中的光影效果更加逼真,为用户带来沉浸式的视觉体验。在专业图形领域,光线追踪性能也有助于提高动画渲染、建筑设计可视化等工作的效率和质量。

四、GPU 硬件构成剖析

1.GPU 核心芯片:GPU 核心芯片是 GPU 的核心组件,它集成了大量的计算单元、控制逻辑、缓存等电路。不同厂商和型号的 GPU 核心芯片在设计和制造工艺上有所不同。制造工艺通常以纳米(nm)为单位,如目前先进的 GPU 采用 7nm 甚至 5nm 工艺。更先进的制造工艺能够在相同面积的芯片上集成更多的晶体管,提高芯片的性能和能效比。例如,NVIDIA 的一些高端 GPU 核心芯片集成了数十亿个晶体管,这些晶体管协同工作,实现了强大的图形处理和计算能力。

2.显存芯片:显存芯片用于存储GPU 处理图形和计算任务时所需的数据,包括纹理数据、顶点数据、中间计算结果等。常见的显存类型有 GDDR(Graphics Double Data Rate)系列,如 GDDR5、GDDR6、GDDR6X 等。不同类型的显存芯片在性能参数上存在差异,如频率、带宽、容量等。GDDR6X 相比 GDDR6 具有更高的频率和带宽,能够提供更快的数据传输速度。显存容量也是一个重要指标,从几 GB 到几十 GB 不等,大容量显存适用于处理高分辨率、复杂场景的图形数据或大规模深度学习模型的数据存储。

3.GPU 电路板:GPU 电路板是承载 GPU 核心芯片、显存芯片以及其他电子元件的物理载体。它通过电路线路实现各个元件之间的电气连接,确保数据和信号能够在不同组件之间准确传输。电路板的设计需要考虑电气性能、散热性能和机械强度等因素。良好的电路板设计能够减少信号干扰,提高数据传输的稳定性,同时有效地将 GPU 运行时产生的热量传导出去,保证 GPU 在稳定的温度范围内工作。

4.散热模块:由于GPU 在高负载运行时会产生大量的热量,如果不及时散热,会导致 GPU 性能下降甚至损坏。散热模块通常由散热器和风扇(或水冷装置)组成。散热器一般采用金属材质,如铜或铝,利用其良好的导热性能将 GPU 核心产生的热量吸收并传导到更大的散热面积上。风扇则通过强制对流的方式将散热器上的热量散发到周围环境中。对于一些高端或对散热要求极高的 GPU,还会采用水冷散热技术,通过循环流动的冷却液将热量带走,水冷散热具有更好的散热效率和更低的噪音。

5.供电模块:GPU 运行需要稳定且足够的电力供应,供电模块负责将计算机电源提供的电能转换为适合 GPU 各个组件使用的电压和电流。供电模块通常包括电源管理芯片、电感、电容、MOSFET 等元件。电源管理芯片负责控制和调节电能的分配,确保 GPU 核心、显存等组件在不同工作状态下都能获得稳定的电力。电感和电容用于滤波和稳压,减少电流波动对 GPU 工作的影响。强大的供电模块能够保证 GPU 在高负载运行时稳定工作,避免因供电不足而导致的性能波动或系统崩溃。

6.GPU 接口:GPU 接口主要包括与主板连接的接口和与显示器连接的接口。与主板连接的接口常见的是 PCI - Express(PCIe)接口,目前主流的是 PCIe 4.0 和 PCIe 5.0 接口。PCIe 接口的版本越高,数据传输速率就越快,能够为 GPU 提供更高的带宽,满足其大量数据传输的需求。例如,PCIe 4.0 的 x16 插槽带宽可达 64GB/s,而 PCIe 5.0 的 x16 插槽带宽更是翻倍至 128GB/s。与显示器连接的接口有 HDMI、DisplayPort 等,这些接口负责将 GPU 处理后的图像数据传输到显示器上进行显示。不同的接口在支持的分辨率、刷新率和色彩深度等方面有所不同,如 DisplayPort 接口通常能够支持更高的分辨率和刷新率,适合用于专业图形显示和高刷新率电竞显示器。

7.GPU 时钟发生器:GPU 时钟发生器负责产生 GPU 各个组件所需的时钟信号,时钟信号就像 “指挥家”,协调 GPU 核心、显存等组件的工作节奏。核心频率和显存频率等参数都由时钟发生器控制和调节。通过调整时钟发生器输出的时钟信号频率,可以实现 GPU 的超频或降频操作。超频时,提高时钟频率能够提升 GPU 的性能,但同时也会增加功耗和发热量,需要谨慎操作并确保散热良好。降频则可以在一些对性能要求不高的场景下降低功耗和噪音。

8.GPU 的硬件监控电路:为了确保GPU 稳定运行,GPU 内部通常集成了硬件监控电路。这些电路可以实时监测 GPU 的各项参数,如温度、电压、风扇转速、功率等。通过这些监控数据,用户可以了解 GPU 的工作状态,及时发现潜在的问题。例如,当 GPU 温度过高时,硬件监控电路会触发报警机制,提醒用户采取散热措施,或者自动降低 GPU 的运行频率以减少发热量,保护 GPU 免受过热损坏。在一些专业的显卡管理软件中,用户可以直观地查看这些监控数据,并根据需要进行相应的设置和调整。

9.GPU 硬件的可靠性设计:在设计GPU 硬件时,可靠性是一个重要考虑因素。为了提高可靠性,厂商会采用多种技术和措施。例如,在芯片制造过程中,采用冗余设计,即在芯片内部增加一些备用的电路模块,当某个主要模块出现故障时,备用模块可以自动切换并继续工作,保证 GPU 的基本功能不受影响。在电路板设计上,采用多层 PCB 设计,提高电路板的电气性能和抗干扰能力,减少因电磁干扰等因素导致的故障。此外,还会进行严格的测试,包括高温测试、低温测试、振动测试、老化测试等,确保 GPU 在各种恶劣环境下都能稳定可靠地工作。

10.GPU 硬件的发展趋势:未来,GPU 硬件将朝着更高性能、更低功耗、更小尺寸的方向发展。在性能方面,将继续增加计算核心数量,优化核心架构,提升内存带宽和浮点运算能力,以满足日益增长的人工智能、虚拟现实、高性能计算等领域的需求。在功耗方面,随着制造工艺的不断进步和电源管理技术的发展,GPU 将实现更高的能效比,减少能源消耗。在尺寸方面,通过先进的封装技术,如芯片堆叠、系统级封装(SiP)等,将使 GPU 体积更小,便于集成到更紧凑的设备中,同时也能提高硬件的集成度和可靠性。此外,GPU 硬件还将加强与其他硬件组件(如 CPU、内存等)的协同工作能力,进一步提升整个计算机系统的性能。

五、GPU 编程与开发

1.CUDA 编程模型:CUDA(Compute Unified Device Architecture)是 NVIDIA 推出的一种并行计算平台和编程模型,它允许开发者利用 NVIDIA GPU 的并行计算能力加速应用程序。CUDA 编程模型基于 C/C++ 语言进行扩展,引入了一些新的语法和函数库。在 CUDA 中,开发者将计算任务定义为内核函数(Kernel Function),这些内核函数在 GPU 的多个线程上并行执行。线程被组织成线程块(Thread Block),多个线程块构成网格(Grid)。通过这种层次化的线程组织方式,开发者可以方便地控制并行计算的粒度和规模。例如,在进行矩阵乘法运算时,可以利用 CUDA 将矩阵划分成多个小块,每个线程块负责计算一个小块的结果,从而实现高效的并行计算。

2.OpenCL 编程框架:OpenCL(Open Computing Language)是一个跨平台的开放标准,用于在不同类型的计算设备(包括 GPU、CPU、FPGA 等)上进行并行计算。它提供了一套统一的 API,使得开发者能够编写与硬件无关的并行计算代码。OpenCL 编程模型与 CUDA 类似,也采用内核函数、线程和内存对象等概念。但 OpenCL 的优势在于其跨平台性,开发者可以编写一次代码,在不同厂商的 GPU 甚至其他计算设备上运行。不过,由于需要兼顾不同硬件的特性,OpenCL 代码的性能优化可能相对复杂一些。在科学计算、多媒体处理等领域,OpenCL 被广泛应用,为开发者提供了一种灵活的并行计算解决方案。

3.DirectX Compute:DirectX Compute 是微软 DirectX 图形 API 的一部分,它允许开发者在 Windows 平台上利用 GPU 的计算能力执行通用计算任务。DirectX Compute 紧密集成在 Windows 操作系统和图形驱动程序中,对于熟悉 DirectX 图形编程的开发者来说,学习和使用 DirectX Compute 相对容易。它提供了一种基于 HLSL(High - Level Shading Language)的编程模型,开发者可以使用 HLSL 编写计算着色器(Compute Shader),在 GPU 上并行执行计算任务。DirectX Compute 在游戏开发中应用广泛,例如用于实现物理模拟、粒子效果、光照计算等复杂的计算任务,提升游戏的性能和视觉效果。

4.Vulkan 中的 GPU 计算:Vulkan 是新一代的跨平台图形和计算 API,它提供了对 GPU 计算的支持。与传统图形 API 相比,Vulkan 具有更低的开销和更高的性能,能够更充分地发挥 GPU 的潜力。在 Vulkan 中,开发者通过创建计算管道(Compute Pipeline)来定义计算任务,并使用命令缓冲区(Command Buffer)提交这些任务到 GPU 执行。Vulkan 的内存管理机制也非常灵活,开发者可以更精细地控制内存的分配和使用,提高内存访问效率。Vulkan 的 GPU 计算功能适用于对性能要求极高的图形应用、科学计算以及虚拟现实等领域,为开发者提供了高效的底层控制能力。

5.GPU 编程中的内存管理:在GPU 编程中,内存管理是一个关键环节。GPU 具有多种类型的内存,如全局内存、共享内存、纹理内存、常量内存等,每种内存都有其特点和适用场景。全局内存是最常用的内存类型,用于存储大规模的数据,但访问延迟较高。共享内存位于 GPU 核心内部,访问速度快,适合线程块内的线程之间共享数据。纹理内存针对图形纹理数据访问进行了优化,具有较高的带宽。常量内存用于存储在计算过程中不变的数据。开发者需要根据具体的计算任务,合理地选择和使用不同类型的内存,以提高计算性能。例如,在进行卷积运算时,将频繁访问的卷积核数据存储在常量内存中,可以减少内存访问延迟,提高计算效率。同时,还需要注意内存的分配和释放,避免内存泄漏和内存碎片等问题。

6.GPU 线程同步机制:由于GPU 计算涉及大量的并行线程,线程同步是确保计算结果正确性的重要手段。GPU 编程提供了多种线程同步机制,如栅栏(Barrier)、原子操作等。栅栏用于线程块内的线程同步,当所有线程执行到栅栏处时,会等待其他线程到达,然后再继续执行后续的代码。这在需要线程之间共享数据并确保数据一致性的场景中非常有用。原子操作则用于对共享内存中的数据进行原子性的读写操作,保证在多线程并发访问时数据的完整性。例如,在进行原子加法操作时,即使多个线程同时尝试对同一内存位置进行加法运算,也能确保最终结果的正确性。通过合理使用线程同步机制,开发者可以有效地避免数据竞争和不一致问题,提高 GPU 并行计算的可靠性。

7.GPU 编程的调试与优化工具:为了帮助开发者更好地进行GPU 编程,各大厂商和社区提供了一系列的调试与优化工具。例如,NVIDIA 提供了 Nsight Compute 和 Nsight Systems 等工具。Nsight Compute 主要用于分析 CUDA 内核函数的性能,它可以提供详细的性能指标,如指令执行次数、内存访问次数、线程执行时间等,帮助开发者找出性能瓶颈并进行优化。Nsight Systems 则可以对整个应用程序进行系统级的性能分析,包括 CPU - GPU 协同工作的情况,显示各个组件的时间线和资源利用率,以便开发者全面了解应用程序的性能状况并进行针对性的优化。此外,还有一些开源的调试工具,如 GDB 也支持对 GPU 代码的调试,方便开发者排查代码中的错误。

8.GPU 算法库与框架:为了降低开发者的编程难度,提高开发效率,出现了许多针对GPU 的算法库和框架。例如,cuBLAS(CUDA Basic Linear Algebra Subprograms)是 NVIDIA 提供的基于 CUDA 的线性代数库,它包含了大量经过优化的矩阵运算函数,如矩阵乘法、矩阵分解等,开发者可以直接调用这些函数,利用 GPU 的并行计算能力加速线性代数相关的计算任务。cuDNN(CUDA Deep Neural Network library)则是专门为深度学习设计的库,它对神经网络中的卷积、池化、激活函数等操作进行了高度优化,能够显著提升深度学习模型的训练和推理速度。此外,还有一些深度学习框架,如 TensorFlow、PyTorch 等,它们内部集成了对 GPU 的支持,通过自动将计算任务分配到 GPU 上执行,简化了深度学习开发过程中的 GPU 编程工作,使开发者能够更专注于模型的设计和训练。

9.GPU 编程的跨平台与兼容性考虑:在实际开发中,开发者可能需要考虑GPU 编程的跨平台和兼容性问题。不同厂商的 GPU 在硬件架构、指令集和驱动程序等方面存在差异,这可能导致同一 GPU 程序在不同 GPU 上的性能表现不同甚至无法运行。为了实现跨平台和兼容性,开发者可以选择使用跨平台的编程框架,如 OpenCL。同时,在代码编写过程中,要尽量遵循通用的编程规范和最佳实践,避免使用特定厂商的非标准扩展。对于一些性能敏感的代码段,可以根据不同的 GPU 硬件特性进行针对性的优化,但要通过条件编译等方式确保在其他 GPU 上也能正常运行。此外,及时关注 GPU 厂商发布的驱动程序更新和开发工具升级,以获取更好的兼容性和性能支持。

10.GPU 编程的未来发展趋势:随着GPU 应用领域的不断拓展,GPU 编程也将不断发展。未来,GPU 编程模型将更加简化和易用,降低开发者的学习门槛,使更多领域的开发者能够利用 GPU 的强大计算能力。同时,为了更好地支持新兴的技术,如人工智能、量子计算模拟等,GPU 编程将在算法库和框架方面不断创新,提供更高效、更智能的编程接口。此外,随着异构计算的发展,GPU 与其他计算设备(如 CPU、FPGA、ASIC 等)之间的协同编程将成为研究热点,开发者需要能够更方便地在不同类型的计算设备之间分配和调度计算任务,充分发挥整个计算系统的性能优势。

六、GPU 在深度学习中的应用

1.深度学习对GPU 计算能力的依赖:深度学习模型通常包含大量的参数和复杂的计算操作,如矩阵乘法、卷积运算等。这些运算需要处理海量的数据,计算量极其庞大。传统的CPU 由于其架构设计侧重于串行处理,在面对深度学习的大规模并行计算需求时,效率较低。而 GPU 具有大量的计算核心,能够同时处理多个数据,通过并行计算大大加速了深度学习模型的训练和推理过程。例如,在训练一个大型的图像识别神经网络时,使用 GPU 可以将训练时间从数周缩短到几天甚至更短,极大地提高了深度学习研究和应用的效率。

2.GPU 加速深度学习训练的原理:在深度学习训练过程中,模型参数的更新需要进行大量的梯度计算。这些计算本质上是矩阵运算,非常适合GPU 的并行计算架构。GPU 的多个计算核心可以同时对不同的矩阵块进行运算,实现数据并行。例如,在反向传播算法中,计算梯度时需要对多个样本的数据进行相同的运算,GPU 可以将这些样本数据分配到不同的核心上同时计算,从而大幅减少计算时间。此外,GPU 还通过优化内存访问模式、采用高速缓存等技术,提高了数据读取和写入的速度,进一步加速了深度学习训练过程。

3.GPU 在深度学习推理中的作用:深度学习推理是指使用训练好的模型对新数据进行预测的过程。在实际应用中,如智能安防中的实时目标检测、语音助手的语音识别等场景,对推理的实时性要求很高。GPU 凭借其强大的计算能力,能够快速处理输入数据,完成模型推理,输出预测结果。与训练相比,推理过程中的计算量相对较小,但对延迟要求更为严格。GPU 可以通过优化计算资源的分配和利用,实现高效的推理计算,满足实时性应用的需求。例如,在一个基于深度学习的自动驾驶汽车的视觉感知系统中,GPU 需要在极短的时间内对摄像头采集的图像进行推理,识别出道路上的障碍物、行人等目标,为车辆的决策和控制提供及时准确的信息。

4.适合GPU 加速的深度学习模型类型:几乎所有类型的深度学习模型都能从GPU 加速中受益,其中卷积神经网络(CNN)在图像和视频处理领域应用广泛,其大量的卷积层和池化层运算包含高度并行的操作,非常适合 GPU 并行计算,能够显著提升图像分类、目标检测、语义分割等任务的性能。循环神经网络(RNN)及其变体长短期记忆网络(LSTM)和门控循环单元(GRU)在自然语言处理、时间序列分析等领域有重要应用,虽然其结构存在顺序依赖,但通过合理的并行化策略,如将不同时间步的数据并行处理,GPU 也能有效加速这些模型的训练和推理。此外,生成对抗网络(GAN)、Transformer 架构等复杂的深度学习模型在训练和推理过程中同样需要大量的计算资源,GPU 的加速作用不可或缺。

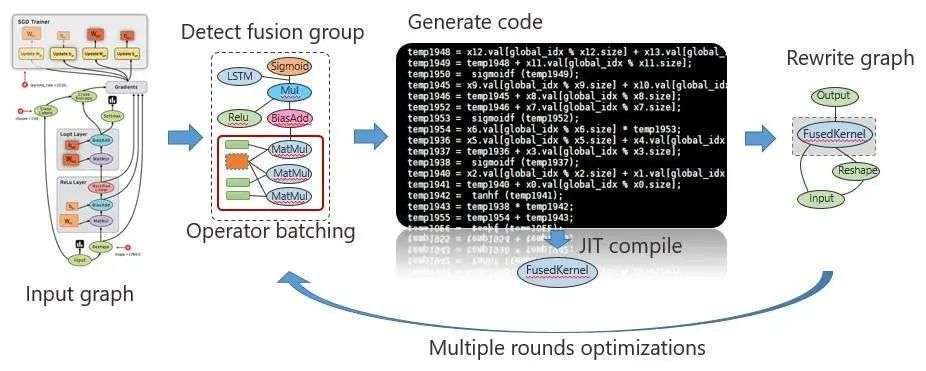

添加图片注释,不超过 140 字(可选)

6.深度学习框架对GPU 的支持:主流深度学习框架如TensorFlow、PyTorch、Keras 等均深度支持 GPU 加速。以 TensorFlow 为例,通过设置tf.config.set_visible_devices可指定使用的 GPU 设备,框架会自动将计算图中的可并行任务分配到 GPU 执行;PyTorch 则通过.to(device)方法,方便地将张量和模型移动到 GPU 显存,实现计算加速。这些框架还针对不同 GPU 架构优化底层计算库调用,提升训练与推理效率 。

7.GPU 显存与深度学习模型规模:深度学习模型参数和中间计算结果需占用大量显存。模型参数量越大、输入数据分辨率越高,所需显存容量越大。例如训练高分辨率图像的生成对抗网络(GAN),若显存不足,会出现 “Out of Memory” 错误。开发者常通过梯度累积、模型分片、混合精度训练等技术,在有限显存下训练大规模模型。

8.混合精度训练:混合精度训练是利用GPU 对 FP16(半精度)和 FP32(单精度)数据的处理能力,在训练过程中混合使用两种精度数据,以减少显存占用和计算时间。NVIDIA 的 Tensor Core 支持快速的 FP16 矩阵运算,结合自动混合精度技术(如 PyTorch 的torch.cuda.amp),可在几乎不损失模型精度的前提下,大幅加速训练过程,同时降低能耗。

9.分布式GPU 训练:为处理超大规模深度学习任务,分布式GPU 训练技术应运而生。通过多台服务器的多个 GPU 协同工作,将训练数据或模型参数进行切分,实现数据并行或模型并行训练。如 Horovod 框架可简化分布式训练流程,支持 TensorFlow、PyTorch 等多种框架,通过集合通信操作实现 GPU 间数据同步,加速训练收敛。

10.GPU 在强化学习中的应用:强化学习涉及大量的环境模拟和策略优化计算,GPU 的并行处理能力可显著加速训练过程。在 AlphaGo 等围棋 AI 训练中,GPU 集群并行模拟大量棋局,快速计算策略网络和价值网络,通过与环境不断交互优化策略,推动强化学习在游戏、机器人控制等领域的突破。

七、GPU 与其他技术对比

1.GPU vs CPU:CPU 擅长复杂逻辑控制和串行任务处理,具有丰富的指令集和多级缓存;GPU 专注大规模并行计算,核心数量多但结构简单。在图形渲染中,CPU 负责场景管理和指令调度,GPU 执行具体图形计算;在深度学习训练中,CPU 处理数据预处理,GPU 承担核心计算任务,二者协同提升系统效率。

2.GPU vs FPGA:FPGA(现场可编程门阵列)可通过编程重构硬件逻辑,灵活性高,但计算性能和并行度相对 GPU 较低。GPU 适用于通用并行计算场景,开发效率高;FPGA 在特定领域(如通信信号处理、定制加密算法)中,可根据需求定制硬件加速,功耗和延迟表现更优。

3.GPU vs ASIC:ASIC(专用集成电路)是为特定任务定制的芯片,如比特币挖矿 ASIC 矿机。与 GPU 相比,ASIC 在目标任务上计算效率极高、功耗低,但缺乏通用性,开发成本高且难以修改。GPU 可灵活应用于多种场景,适合快速迭代的算法研究和多样化计算需求。

八、GPU 应用场景拓展

1.科学计算:在气象预测、量子化学模拟、天体物理研究等领域,GPU 的并行计算能力加速复杂数值计算。例如,通过分子动力学模拟药物分子与靶点结合过程,GPU 可快速计算大量原子间相互作用,缩短药物研发周期。

2.虚拟现实(VR)与增强现实(AR):VR/AR 设备对实时图形渲染要求极高,GPU 需快速生成高分辨率、低延迟的 3D 场景,确保用户沉浸感。NVIDIA 的 VRWorks SDK 提供了一系列优化技术,如异步时间扭曲、单像素着色等,提升 VR 应用的性能和画面质量。

3.视频编解码:GPU 支持硬件加速视频编解码,如 NVIDIA 的 NVENC 和 AMD 的 VCE 技术。在 4K/8K 视频处理、直播推流场景中,GPU 可分担 CPU 压力,实现高效编码,同时支持 HEVC、VP9 等先进编码格式,降低视频存储和传输成本。

九、GPU 性能优化与调试

1.驱动程序优化:GPU 厂商定期更新驱动程序,优化硬件性能、修复漏洞并增加新功能支持。例如 NVIDIA 的 Game Ready 驱动针对热门游戏进行图形渲染优化,AMD 的肾上腺素驱动提升显卡稳定性和游戏帧率,用户需及时更新驱动以发挥 GPU 最佳性能。

2.超频与降压:超频通过提升GPU 核心频率和显存频率增加性能,但会提高功耗和温度;降压则在保证稳定运行前提下降低电压,减少功耗和发热。用户可通过 MSI Afterburner 等工具进行超频和降压操作,但需谨慎调整参数,避免硬件损坏。

3.性能监控工具:GPU-Z 可实时监控 GPU 核心频率、显存使用、温度等参数;NVIDIA 的 Nsight Monitor 和 AMD 的 Radeon Performance Monitor 提供更详细的性能分析,帮助开发者定位性能瓶颈,优化应用程序对 GPU 的利用效率。

十、GPU 未来发展趋势

1.异构计算融合:未来GPU 将与 CPU、FPGA、NPU(神经网络处理器)等深度融合,形成异构计算系统。通过统一编程模型和高速互联技术,实现不同计算单元间高效协同,满足复杂应用场景的多样化计算需求,如数据中心的 AI 推理与传统数据处理任务混合负载。

2.Chiplet 技术应用:Chiplet(芯粒)技术将不同功能芯片集成封装,可降低 GPU 芯片制造成本和设计难度。厂商可通过组合不同性能的芯粒,灵活定制 GPU 产品,同时提升芯片良率和生产效率,推动 GPU 向更大规模、更高性能发展。

3.量子计算协同:随着量子计算发展,GPU 可能作为经典计算部分与量子计算机协同工作。在量子模拟、量子机器学习等领域,GPU 负责经典数据预处理和后处理,量子计算机处理量子态计算,二者结合探索新的计算范式和应用场景。

参考文献链接

人工智能芯片与自动驾驶

浙公网安备 33010602011771号

浙公网安备 33010602011771号